أجرت خدمة توليد الصور بالذكاء الاصطناعي Nano Banana Pro التابعة لشركة جوجل تعديلات مهمة على سياساتها في نهاية يناير 2026 (حوالي 24 يناير). وقد أثار تغييرين رئيسيين اهتماماً واسعاً في مجتمع المطورين: تعزيز فلترة محتوى IMAGE_SAFETY بشكل ملحوظ، وفرض قيود صارمة على توليد شخصيات الـ IP (الملكية الفكرية) الشهيرة. في هذا المقال، سنقوم بتحليل هذه الديناميكيات بعمق لمساعدة المطورين على فهم خلفية التغييرات وإيجاد الحلول المناسبة.

القيمة المحورية: استغرق 3 دقائق لفهم جوهر تعديلات سياسة Nano Banana Pro، والأسباب الكامنة وراءها، وتأثيراتها الفعلية، مع التعرف على 5 استراتيجيات للتعامل معها.

معلومات أساسية حول تعديلات سياسة Nano Banana Pro

نظرة سريعة على الحدث

| البند | التفاصيل |

|---|---|

| وقت التعديل | حوالي 24 يناير 2026 |

| الجهة المعدلة | جوجل (Nano Banana Pro / سلسلة Imagen) |

| التغييرات الجوهرية | تعزيز فلترة IMAGE_SAFETY + قيود على توليد الـ IP الشهيرة |

| نطاق التأثير | جميع المطورين والتطبيقات التي تستخدم واجهة برمجة تطبيقات Nano Banana Pro |

| التوضيح الرسمي | انتهاك سياسة الاستخدام المحظور للذكاء الاصطناعي التوليدي من جوجل |

شرح مفصل للتغييرين الأساسيين

التغيير الأول: قيود على توليد شخصيات الـ IP الشهيرة

وصف الظاهرة:

عند محاولة توليد صور تحتوي على شخصيات من علامات تجارية مشهورة (مثل ديزني، مارفل، حرب النجوم، إلخ)، سيقوم النظام برفض الطلب. محتوى الـ IP الذي كان يمكن توليده بشكل طبيعي في السابق، يقوم الآن بتفعيل آلية حماية حقوق النشر.

نطاق الـ IP المتأثرة:

| فئة الـ IP | أمثلة على الأعمال | مستوى التقييد |

|---|---|---|

| كلاسيكيات ديزني | ملكة الثلج، الأسد الملك، الحورية الصغيرة | تقييد كامل |

| عالم مارفل | ديدبول، حراس المجرة، آيرون مان | تقييد كامل |

| حرب النجوم | جميع شخصيات السلسلة | تقييد كامل |

| رسوم بيكسار | حكاية لعبة، البحث عن نيمو | تقييد كامل |

| IP مشهورة أخرى | هاري بوتر، بوكيمون، إلخ | تقييد جزئي |

مثال على رسالة الخطأ:

{

"finishReason": "SAFETY",

"finishMessage": "The image was filtered because it may contain copyrighted characters or content."

}

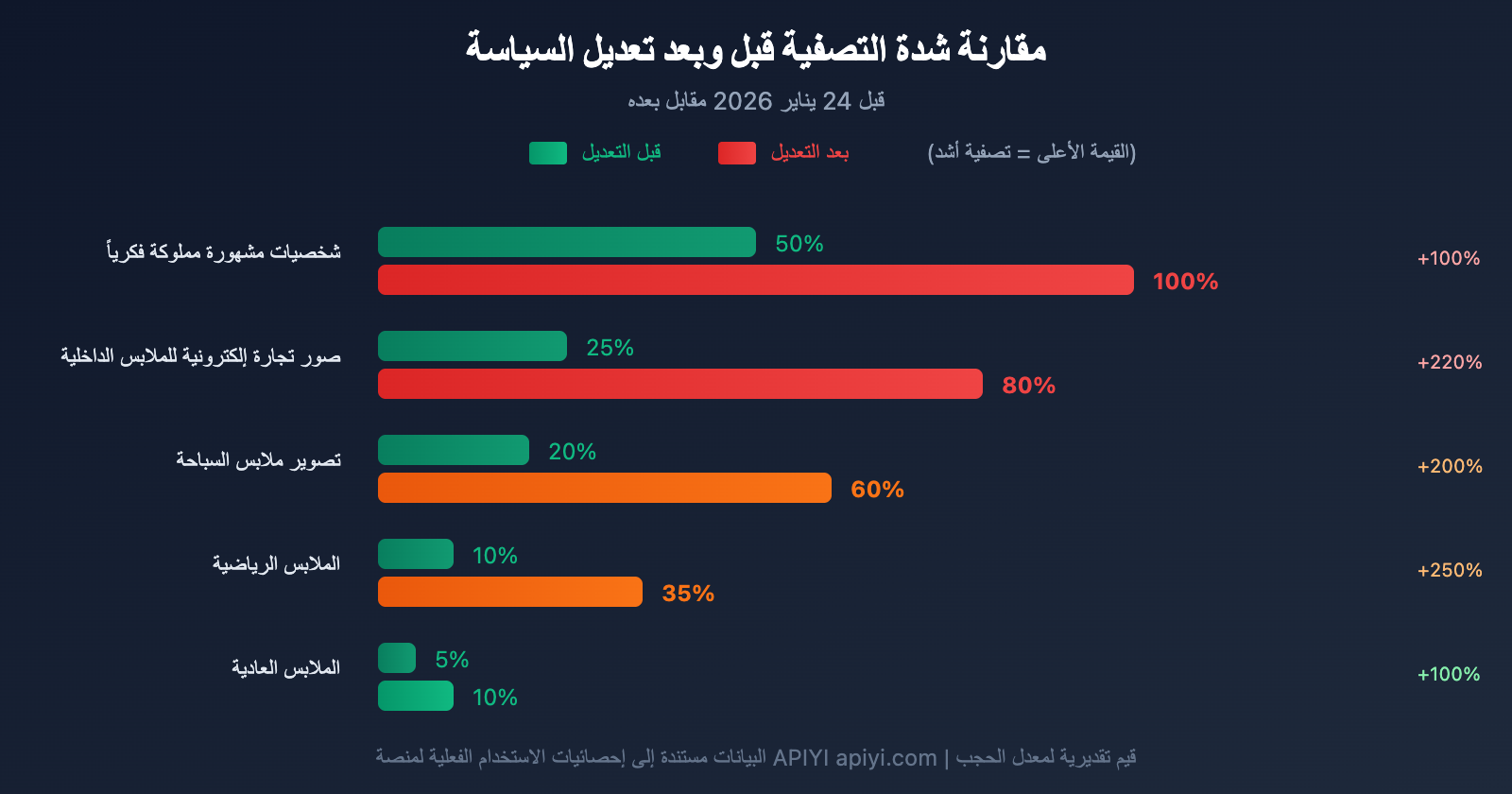

التغيير الثاني: تعزيز فلترة محتوى IMAGE_SAFETY

وصف الظاهرة:

أصبحت مراجعة سلامة المحتوى أكثر صرامة. المحتوى الذي كان متوافقاً ويمكن توليده سابقاً (مثل صور منتجات التجارة الإلكترونية، تصوير الأزياء، إلخ)، قد يؤدي الآن إلى تفعيل فلترة IMAGE_SAFETY.

مثال على رسالة الخطأ النموذجية:

{

"finishReason": "IMAGE_SAFETY",

"finishMessage": "Unable to show the generated image. The image was filtered out because it violated Google's Generative AI Prohibited Use policy. You will not be charged for blocked images. Try rephrasing the prompt. If you think this was an error, send feedback.",

"safetyInfo": {

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"blocked": true

}

}

السيناريوهات المتأثرة:

| السيناريو | الحالة السابقة | الحالة الحالية | درجة التأثير |

|---|---|---|---|

| صور منتجات اللانجري | توليد طبيعي | اعتراض متكرر | عالية |

| تصوير أزياء ملابس السباحة | توليد طبيعي | اعتراض جزئي | متوسطة – عالية |

| ملابس اللياقة البدنية | توليد طبيعي | اعتراض أحياناً | متوسطة |

| الملابس الرياضية الضيقة | توليد طبيعي | اعتراض أحياناً | متوسطة |

| عرض الملابس العادية | توليد طبيعي | طبيعي بشكل عام | منخفضة |

تحليل خلفية تعديل سياسة Nano Banana Pro

بدفع من دعوى ديزني لحماية حقوق الطبع والنشر

في ديسمبر 2025، أرسلت شركة ديزني (Disney) رسالة "التوقف والكف" (Cease and Desist Letter) إلى Google، تتهم فيها خدمة توليد الصور بالذكاء الاصطناعي من Google بارتكاب "انتهاكات واسعة النطاق لحقوق الطبع والنشر".

نقاط اتهام ديزني الأساسية:

| محتوى الاتهام | توضيح محدد |

|---|---|

| حجم الانتهاك | "نطاق واسع" (massive scale) |

| المنتجات المنتهكة | Veo، Imagen، Nano Banana، وغيرها |

| طريقة الانتهاك | توليد صور "عالية الدقة" (pristine) لشخصيات ديزني |

| الملكية الفكرية المعنية | Star Wars، Marvel، Frozen، The Lion King، وغيرها |

استشهدت ديزني في خطابها بأدلة تُظهر قدرة المستخدمين على توليد صور لشخصياتها عبر "موجه" نصي بسيط، معتبرة أن Google "تتعمد تضخيم نطاق انتهاكاتها" (intentionally amplifying the scope of its infringement).

🎯 معلومات خلفية: من المثير للاهتمام أنه في الوقت الذي اتهمت فيه ديزني Google بالانتهاك، أعلنت أيضاً عن تعاون بقيمة مليار دولار مع OpenAI لترخيص استخدام شخصياتها في منصة Sora للفيديو. وهذا يشير إلى أن ديزني لا تعارض التوليد بالذكاء الاصطناعي في حد ذاته، بل تطالب بالحصول على تراخيص رسمية وتقاسم للأرباح التجارية.

تزايد ضغوط الامتثال في الصناعة

بالإضافة إلى ديزني، رفعت مجموعات من الفنانين البصريين دعاوى قضائية ضد Google بتهمة استخدام أعمالهم لتدريب نموذج Imagen دون الحصول على إذن. دفعت هذه الضغوط القانونية شركة Google إلى تعزيز تصفية المحتوى بشكل استباقي.

تعديلات Google على مستوى السياسات

قامت Google في ديسمبر 2024 بتحديث "سياسة الاستخدام المحظور للذكاء الاصطناعي التوليدي"، حيث منعت صراحة:

- توليد محتوى ينتهك حقوق الملكية الفكرية لأطراف ثالثة.

- استخدام البيانات الشخصية أو السمات البيومترية دون موافقة.

- توليد محتوى التزييف العميق (Deepfake).

- توليد صور حميمية غير مرغوب فيها.

يُعد تعديل سياسة Nano Banana Pro الحالي تجسيداً ملموساً لتطبيق Google لهذه السياسات على مستوى المنتج.

تحليل آلية تصفية IMAGE_SAFETY في Nano Banana Pro

مبدأ عمل الفلتر

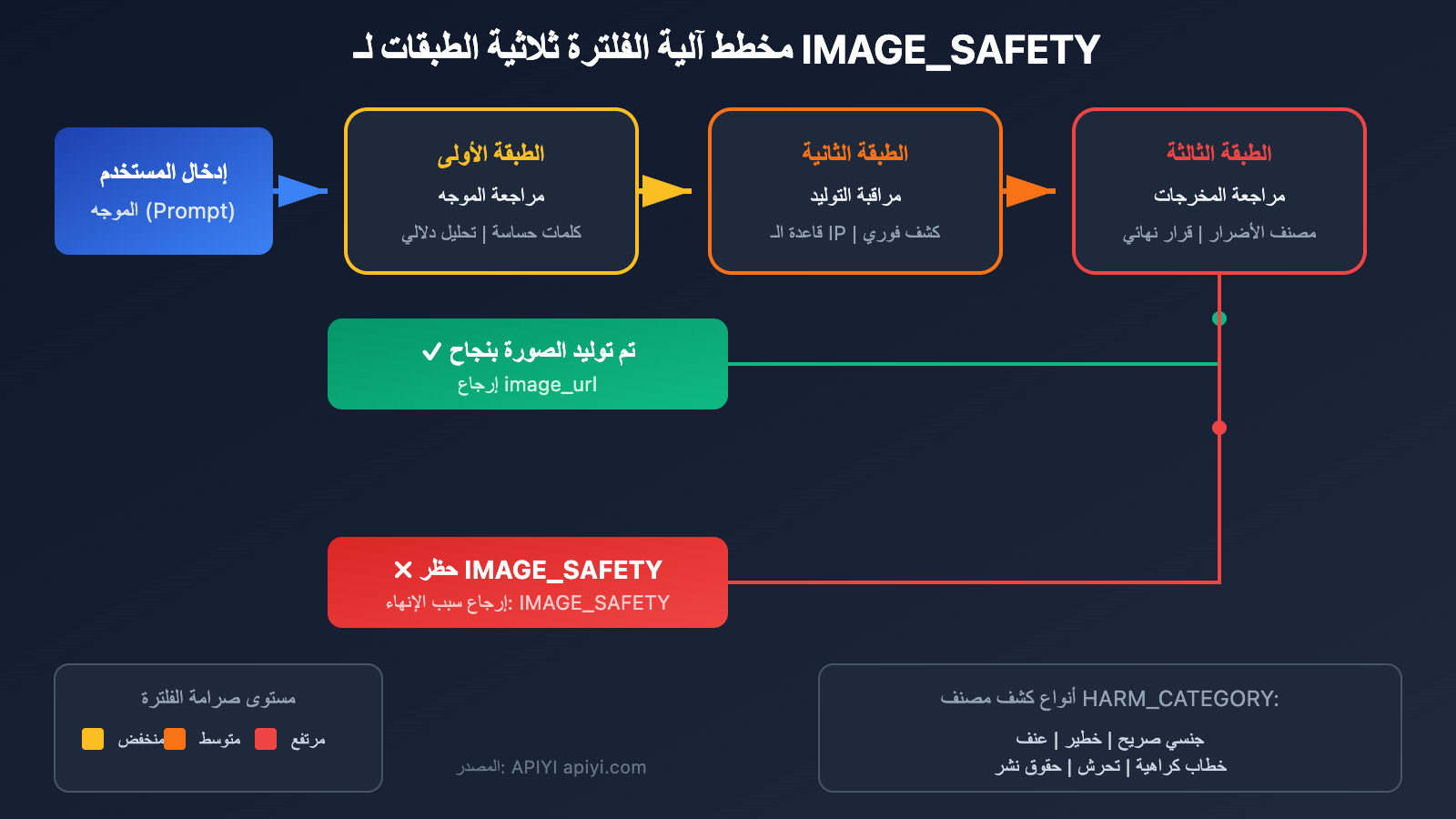

يعتمد نظام تصفية الأمان في Nano Banana Pro على آلية مراجعة متعددة الطبقات:

الطبقة الأولى: مراجعة الموجه (Prompt)

- تحليل الموجهات النصية التي يدخلها المستخدم.

- اكتشاف الكلمات المفتاحية الحساسة والنوايا الدلالية.

- تحديد الأوصاف المحتمل ارتباطها بحقوق الطبع والنشر.

الطبقة الثانية: مراقبة عملية التوليد

- اكتشاف خصائص الصورة أثناء توليدها في الوقت الفعلي.

- مقارنتها بقاعدة بيانات خصائص الملكية الفكرية المعروفة.

- تقييم درجات أمان المحتوى.

الطبقة الثالثة: مراجعة المخرجات

- إجراء فحص شامل للصورة النهائية.

- تطبيق مصنفات فئات الضرر (HARM_CATEGORY).

- اتخاذ قرار بالسماح بمرور الصورة أو حجبها.

تفاصيل فئات التصفية

| كود الفئة | اسم الفئة | سيناريو التحفيز | درجة الشدة |

|---|---|---|---|

HARM_CATEGORY_SEXUALLY_EXPLICIT |

محتوى إيحائي جنسياً | ملابس مكشوفة، وضعيات حميمية | صارم جداً |

HARM_CATEGORY_DANGEROUS_CONTENT |

محتوى خطير | أسلحة، مشاهد عنف | صارم |

HARM_CATEGORY_HATE_SPEECH |

خطاب كراهية | محتوى تمييزي | صارم |

HARM_CATEGORY_HARASSMENT |

محتوى مضايقة | هجمات مستهدفة | صارم |

HARM_CATEGORY_VIOLENCE |

محتوى عنيف | مشاهد دموية أو مؤذية | صارم |

COPYRIGHT_INFRINGEMENT |

انتهاك حقوق النشر | شخصيات مشهورة مملوكة فكرياً | صارم جداً |

لماذا يتم حجب المحتوى الممتثل أحياناً؟

هناك الكثير من التعليقات على منتديات المطورين: لماذا يتم حجب صور منتجات الملابس الداخلية العادية الخاصة بالمتاجر الإلكترونية بواسطة IMAGE_SAFETY؟

تحليل الأسباب:

- إفراط نماذج الأمان في التوافق (Overfitting): لضمان عدم تسريب أي محتوى مخالف، يميل نموذج الأمان إلى "الحظر الاحترازي" حتى في حالات الشك.

- نقص الحكم على السياق: يجد النظام صعوبة في التمييز بين "صورة منتج تجارة إلكترونية" و"المحتوى غير اللائق".

- تشديد السياسة العامة: تحت ضغط الدعاوى القضائية، اختارت Google رفع عتبة التصفية الإجمالية.

- قرارات الصندوق الأسود: لا يستطيع المستخدمون معرفة القاعدة المحددة التي تم تفعيلها.

💡 رؤية تقنية: من خلال ميزة تحليل سجلات الطلبات في منصة APIYI apiyi.com، يمكن للمطورين فهم الأسباب المحددة لرفض الطلبات بشكل أوضح، مما يساعد في تحسين استراتيجيات صياغة الموجهات.

تأثير تعديلات سياسة Nano Banana Pro على المطورين

التأثير المباشر

| مجال التأثير | المظاهر المحددة | مستوى الخطورة |

|---|---|---|

| التطبيقات المتعلقة بالملكية الفكرية (IP) | توقف أدوات إبداع المعجبين وخدمات توليد صور "الفان آرت" مباشرة | حرج |

| صور منتجات التجارة الإلكترونية | تعثر توليد صور فئات الملابس الداخلية وملابس السباحة | خطير |

| تصوير الأزياء | تصنيف خاطئ لبعض مشاهد عرض الملابس | متوسط |

| التصميم الإبداعي | قيود على الأعمال التي تستلهم أسلوب شخصيات شهيرة | متوسط |

| الاستخدامات العامة | التأثير طفيف نسبيًا | بسيط |

التأثير على مستوى الأعمال

لقطاع التجارة الإلكترونية:

- الحاجة إلى تعديل حلول توليد صور المنتجات بالذكاء الاصطناعي لشركات الملابس.

- التأثير الأبرز يظهر في فئتي الملابس الداخلية وملابس السباحة.

- قد يتطلب الأمر العودة إلى التصوير التقليدي أو الانتقال إلى خدمات أخرى.

لمنشئي المحتوى:

- فرض قيود على إنتاج الأعمال المشتقة وصور المعجبين.

- الحاجة إلى المزيد من التصاميم الأصلية بدلاً من الاقتباس من الملكية الفكرية (IP) القائمة.

- انخفاض مرونة وحرية الإبداع إلى حد ما.

لمطوري تطبيقات الذكاء الاصطناعي:

- الحاجة لإضافة المزيد من منطق معالجة الأخطاء في المنتجات.

- احتمال تراجع تجربة المستخدم بسبب عمليات الحظر المتكررة.

- قد يتطلب الأمر إدخال خدمات بديلة لتوليد الصور كاحتياطي.

5 استراتيجيات للتعامل مع تعديلات سياسة Nano Banana Pro

الاستراتيجية الأولى: تحسين صياغة الموجهات (Prompts)

للتعامل مع التصنيف الخاطئ لـ IMAGE_SAFETY، يمكن محاولة تعديل طريقة صياغة الموجه:

# قبل التحسين - عرضة للحظر

prompt_before = "model wearing lace bra, fashion photography"

# بعد التحسين - تقليل احتمالية التصنيف الخاطئ

prompt_after = "fashion catalog photo, model in elegant intimate apparel, professional studio lighting, clean background"

تقنيات التحسين:

| التقنية | الشرح | مثال |

|---|---|---|

| إضافة سياق مهني | التأكيد على الاستخدام التجاري أو المهني | "e-commerce product photo" |

| استخدام تعبيرات ملطفة | تجنب الوصف المباشر | "intimate apparel" بدلاً من "bra" |

| زيادة وصف البيئة | إضفاء طابع رسمي أكثر على المحتوى | "professional studio setting" |

| تحديد الغرض بوضوح | إظهار النية بالامتثال للسياسات | "for fashion catalog" |

الاستراتيجية الثانية: تعديل إعدادات فلترة الأمان

إذا كنت تستخدم نسخة Vertex AI من Imagen، يمكنك محاولة تعديل عتبة فلترة الأمان:

from google.cloud import aiplatform

from vertexai.preview.vision_models import ImageGenerationModel

# تعديل إعدادات الأمان

safety_settings = {

"HARM_CATEGORY_SEXUALLY_EXPLICIT": "BLOCK_ONLY_HIGH",

"HARM_CATEGORY_DANGEROUS_CONTENT": "BLOCK_ONLY_HIGH",

}

model = ImageGenerationModel.from_pretrained("imagen-3.0")

response = model.generate_images(

prompt="your prompt here",

safety_filter_level="block_only_high" # تقليل حساسية الفلترة

)

⚠️ ملاحظة: لا يمكن تعديل إعدادات الأمان عبر النسخة المجانية من AI Studio؛ يتطلب الأمر استخدام نسخة Vertex AI المدفوعة.

الاستراتيجية الثالثة: استخدام خدمات بديلة لتوليد الصور

عندما لا يكون Nano Banana Pro مناسبًا، يمكن النظر في خدمات توليد الصور الأخرى:

| الخدمة | المزايا | حالات الاستخدام المناسبة | دعم APIYI |

|---|---|---|---|

| DALL-E 3 | قدرة إبداعية قوية وامتثال عالٍ | التصميم الإبداعي، الرسوم التوضيحية | ✅ |

| Midjourney | أسلوب فني متميز | الأعمال الفنية، الصور المفاهيمية | ✅ |

| Stable Diffusion | مرونة عالية وتحكم كامل | الاحتياجات المخصصة | ✅ |

| Flux | سرعة عالية وفعالية في التكلفة | التوليد بكميات كبيرة | ✅ |

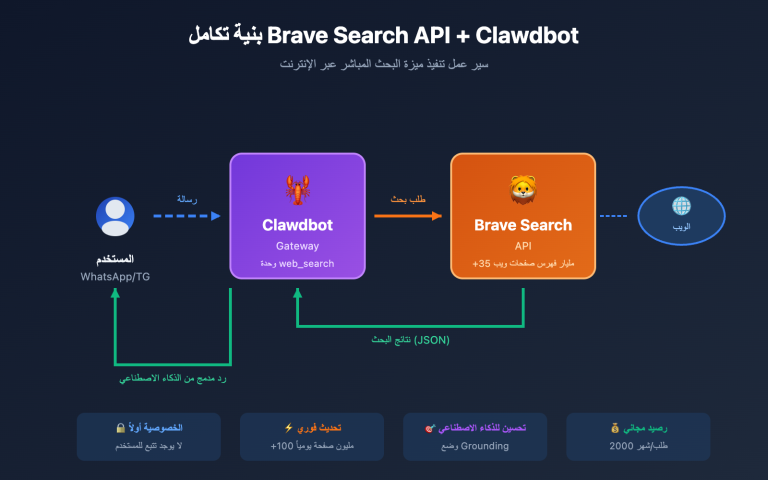

🚀 تبديل سريع: من خلال منصة APIYI apiyi.com، يمكن للمطورين استخدام واجهة برمجة تطبيقات موحدة لاستدعاء نماذج توليد صور متعددة، مما يتيح التبديل السريع دون الحاجة لتعديل الكود. عند تعثر إحدى الخدمات، يمكن الانتقال بسلاسة إلى الخدمة البديلة.

الاستراتيجية الرابعة: بناء آلية تحمل أخطاء متعددة النماذج

تنفيذ منطق "التراجع التلقائي" (fallback) في تطبيقك:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # استخدام واجهة APIYI الموحدة

)

def generate_image_with_fallback(prompt, models=None):

"""دالة توليد الصور مع خاصية تحمل الأخطاء"""

if models is None:

models = ["nano-banana-pro", "dall-e-3", "flux-schnell"]

for model in models:

try:

response = client.images.generate(

model=model,

prompt=prompt,

size="1024x1024"

)

return {

"success": True,

"model_used": model,

"image_url": response.data[0].url

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "SAFETY" in error_msg:

print(f"تم حظر {model} بواسطة فلتر الأمان، جاري تجربة النموذج التالي...")

continue

else:

print(f"فشل استدعاء {model}: {error_msg}")

continue

return {"success": False, "error": "لم تتمكن جميع النماذج من توليد هذا المحتوى"}

# مثال على الاستخدام

result = generate_image_with_fallback("fashion product photography, elegant dress")

عرض الكود الكامل لتحمل الأخطاء (يشمل إعادة المحاولة والسجلات)

import openai

import time

import logging

from typing import Optional, List, Dict, Any

# إعداد السجلات (Logging)

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # استخدام واجهة APIYI الموحدة

)

class ImageGenerationService:

"""خدمة توليد الصور مع خاصية تحمل الأخطاء وإعادة المحاولة"""

DEFAULT_MODELS = ["nano-banana-pro", "dall-e-3", "flux-schnell", "sd-xl"]

def __init__(self, models: Optional[List[str]] = None, max_retries: int = 2):

self.models = models or self.DEFAULT_MODELS

self.max_retries = max_retries

self.stats = {"success": 0, "safety_blocked": 0, "errors": 0}

def generate(self, prompt: str, size: str = "1024x1024") -> Dict[str, Any]:

"""توليد الصور مع تبديل النماذج تلقائيًا عند حدوث خطأ"""

for model in self.models:

for attempt in range(self.max_retries):

try:

logger.info(f"محاولة استخدام {model} لتوليد الصورة (المحاولة {attempt + 1})")

response = client.images.generate(

model=model,

prompt=prompt,

size=size

)

self.stats["success"] += 1

logger.info(f"✅ تم توليد الصورة بنجاح باستخدام {model}")

return {

"success": True,

"model_used": model,

"image_url": response.data[0].url,

"attempts": attempt + 1

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "SAFETY" in error_msg:

self.stats["safety_blocked"] += 1

logger.warning(f"⚠️ تم حظر {model} بواسطة فلتر الأمان")

break # لا يتم إعادة المحاولة عند الحظر الأمني، يتم الانتقال للنموذج التالي مباشرة

elif "rate_limit" in error_msg.lower():

logger.warning(f"⏳ تجاوز معدل الطلبات لـ {model}، جاري الانتظار ثم إعادة المحاولة...")

time.sleep(2 ** attempt) # تراجع أسي (exponential backoff)

continue

else:

self.stats["errors"] += 1

logger.error(f"❌ فشل استدعاء {model}: {error_msg}")

break

return {

"success": False,

"error": "لم تتمكن جميع النماذج من توليد هذا المحتوى",

"stats": self.stats

}

def get_stats(self) -> Dict[str, int]:

"""الحصول على الإحصائيات"""

return self.stats

# مثال على الاستخدام

service = ImageGenerationService()

result = service.generate("professional fashion photography, model in elegant evening dress")

if result["success"]:

print(f"تم التوليد بنجاح! النموذج المستخدم: {result['model_used']}")

print(f"رابط الصورة: {result['image_url']}")

else:

print(f"فشل التوليد: {result['error']}")

الاستراتيجية الخامسة: تعديل استراتيجية العمل

بالنسبة للتطبيقات التي تعتمد بشكل كبير على ملكية فكرية (IP) شهيرة، قد يتطلب الأمر تعديل توجه العمل من الأساس:

| العمل الأصلي | اتجاه التعديل | الجدوى |

|---|---|---|

| توليد صور شخصيات ديزني | ابتكار شخصيات أصلية وتطوير ملكية فكرية خاصة | متوسطة إلى طويلة المدى |

| أدوات الإبداع المشتق لـ IP | التحول إلى محاكاة الأنماط الفنية الأصلية (بدون شخصيات محددة) | ممكنة على المدى القصير |

| توليد صور المعجبين (Fan Art) | انتظار قنوات الترخيص الرسمية (مثل تعاون OpenAI مع ديزني) | ترقب ومانعة |

الأسئلة الشائعة

س1: لماذا توقف المحتوى الذي كان يُنشأ سابقًا عن العمل فجأة الآن؟

قامت Google في نهاية يناير 2026 بتعديل سياسات نموذج Nano Banana Pro، متأثرة بشكل أساسي بالضغوط القانونية مثل دعاوى حقوق النشر من ديزني. تم رفع عتبة تصفية IMAGE_SAFETY بشكل ملحوظ، مما أدى إلى احتمال الخطأ في تصنيف بعض المحتويات التي كانت متوافقة سابقًا. ننصحك باختبار نماذج متنوعة عبر منصة APIYI (apiyi.com) للعثور على البديل الأنسب لسيناريو عملك.

س2: ماذا أفعل إذا تم حظر صور منتجات الملابس الداخلية للتجارة الإلكترونية؟

حاول أولاً تحسين الموجه (Prompt) من خلال إضافة أوصاف احترافية للمشهد مثل "e-commerce product photo" أو "professional catalog". إذا استمر الحظر، فنحن نقترح الانتقال إلى خدمات توليد صور أخرى مثل DALL-E 3 أو Flux. تدعم منصة APIYI (apiyi.com) استدعاء نماذج متعددة عبر واجهة برمجية موحدة، مما يتيح لك التبديل والاختبار بسرعة.

س3: هل يمكن إنشاء محتوى “بأسلوب مشابه لشخصية معينة”؟

عادةً ما يكون وصف "أسلوب مشابه" أقل عرضة لتفعيل فلاتر حقوق النشر من ذكر اسم الشخصية مباشرة، لكن لا تزال هناك مخاطر. يُفضل استخدام أوصاف أكثر تجريداً، مثل "colorful cartoon princess style" بدلاً من "Elsa from Frozen style". الممارسة الأكثر أماناً هي الابتكار بناءً على مفاهيم أصلية تماماً.

س4: هل هذا التعديل في السياسة دائم؟

في الوقت الحالي، من المرجح أن تستمر قيود حماية حقوق النشر للملكيات الفكرية الشهيرة، فهذا من متطلبات الامتثال القانوني. ومع ذلك، قد تتحسن مشكلة الأخطاء في تصنيف IMAGE_SAFETY في الإصدارات القادمة. هناك بالفعل تعليقات ذات صلة في منتدى مطوري Google، وصرح المسؤولون أنهم يجمعون الملاحظات (Feedback). نوصي بمتابعة سجل التحديثات الرسمي.

س5: كيف أعرف ما إذا كانت المشكلة تتعلق بحقوق النشر أم بسلامة المحتوى؟

راقب معلومات الخطأ المرتجعة: إذا كانت قيمة finishReason هي SAFETY ويتضمن الموجه كلمات مثل "copyrighted" أو "trademarked"، فالمشكلة تتعلق بحقوق النشر. أما إذا كانت قيمة finishReason هي IMAGE_SAFETY وكانت فئة safetyInfo.category هي HARM_CATEGORY_SEXUALLY_EXPLICIT أو ما شابه، فالمشكلة تتعلق بسلامة المحتوى. استراتيجيات التعامل مع الحالتين تختلف.

تأثير تعديلات سياسة Nano Banana Pro على الصناعة

التأثير على صناعة توليد الصور بالذكاء الاصطناعي

تعكس تعديلات السياسة هذه نقطة تحول مهمة في صناعة توليد الصور بالذكاء الاصطناعي:

| الاتجاه | التوضيح |

|---|---|

| الامتثال لحقوق الطبع والنشر كمعيار أساسي | ستعمل جميع خدمات الذكاء الاصطناعي الكبرى على تعزيز حماية حقوق الطبع والنشر، وهو ما تفرضه البيئة القانونية |

| تشديد مستمر لرقابة المحتوى | لتجنب المخاطر القانونية، يميل مقدمو الخدمات إلى رفع عتبات التصفية |

| التعاون المرخص يصبح هو السائد | قد يصبح نموذج التعاون بين ديزني وOpenAI نموذجاً يحتذى به في الصناعة |

| المحتوى الأصلي يحظى بتقدير أكبر | التطبيقات التي تعتمد على استعارة الملكية الفكرية (IP) ستواجه تحديات أكبر |

التأثير على منظومة المطورين

- استراتيجية النماذج المتعددة أصبحت ضرورة: لم يعد من الممكن الاعتماد على خدمة توليد صور واحدة فقط.

- الحاجة لتعزيز آليات تحمل الأخطاء: يجب أن تكون التطبيقات قادرة على التعامل مع حالات فشل التوليد بسلاسة.

- الحاجة لرفع الوعي بالامتثال: يجب على المطورين أن يكونوا أكثر دراية بحدود حقوق الطبع والنشر وأمن المحتوى.

💡 نصيحة للتطوير: ننصح المطورين بالوصول إلى خدمات توليد صور متعددة عبر منصة واجهة موحدة مثل APIYI (apiyi.com). هذا لا يقلل فقط من مخاطر الاعتماد على خدمة واحدة، بل يتيح أيضاً التبديل المرن بين أفضل النماذج وفقاً لمختلف السيناريوهات.

ملخص

أدت تعديلات سياسة Nano Banana Pro في يناير 2026 إلى تغييرين جوهريين: تقييد توليد الملكيات الفكرية (IP) الشهيرة وتعزيز تصفية IMAGE_SAFETY. ويقف وراء ذلك الضغط القانوني من أصحاب الحقوق مثل ديزني، بالإضافة إلى مبادرة Google لرفع معايير الامتثال.

مراجعة النقاط الرئيسية:

| النقطة الرئيسية | المحتوى |

|---|---|

| التغيير الأول | عدم القدرة على توليد شخصيات IP الشهيرة (مثل ديزني) |

| التغيير الثاني | تشديد ملحوظ في تصفية أمان المحتوى، مع حدوث أخطاء في تصنيف بعض المحتوى الممتثل |

| السبب والخلفية | دعاوى حقوق الطبع والنشر من ديزني + ضغوط الامتثال في الصناعة |

| استراتيجية التعامل | تحسين الموجه، تعديل إعدادات الأمان، استخدام خدمات بديلة، بناء آليات تحمل الأخطاء، تعديل اتجاه الأعمال |

بالنسبة للمطورين، فإن النهج الأكثر واقعية هو قبول التغييرات والتكيف معها بنشاط. نوصي باختبار نماذج توليد صور متعددة بسرعة عبر APIYI (apiyi.com) للعثور على الحل الأنسب لسيناريو عملك. توفر المنصة واجهة API موحدة تدعم التبديل بين النماذج المختلفة بنقرة واحدة، مما يعد ضماناً فعالاً لمواجهة تغييرات سياسات مزودي الخدمة.

المراجع:

-

Google Generative AI Prohibited Use Policy: وثيقة سياسة الاستخدام الرسمية

- الرابط:

policies.google.com/terms/generative-ai/use-policy

- الرابط:

-

Vertex AI Imagen safety filters documentation: دليل تكوين إعدادات الأمان

- الرابط:

docs.cloud.google.com/vertex-ai/generative-ai/docs/image/responsible-ai-imagen

- الرابط:

-

Google AI Developers Forum: موضوع نقاش حول IMAGE_SAFETY في Nano Banana Pro

- الرابط:

discuss.ai.google.dev/t/nano-banana-pro-suddenly-blocking-non-nsfw-ecommerce-underwear-images-with-image-safety-error/113109

- الرابط:

-

Disney vs Google report: تقارير حول إرسال ديزني إخطاراً بالتوقف عن الانتهاك إلى Google

- المصدر: Hollywood Reporter, The Wrap (ديسمبر 2025)

📝 المؤلف: فريق APIYI

📅 تاريخ النشر: 26 يناير 2026

🔗 الدعم الفني: APIYI (apiyi.com) – منصة خدمات API شاملة لنماذج الذكاء الاصطناعي