想一次性分析整个代码仓库或处理数百页技术文档,却总被上下文窗口限制卡住?Claude Opus 4.6 带来了 100 万 Token 的超大上下文窗口,这是 Opus 系列模型的首次突破——相当于一次性处理约 75 万字的文本内容。

核心价值: 读完本文,你将学会如何开启 Claude 4.6 的 1M Token 上下文窗口、理解长上下文定价策略,并掌握 5 大高价值实战应用场景。

Claude 4.6 上下文窗口核心参数一览

Claude Opus 4.6 于 2026 年 2 月 5 日发布,最引人注目的升级就是上下文窗口的大幅扩展。以下是核心参数:

| 参数项 | Claude Opus 4.6 | 上一代 Opus 4.5 | 提升幅度 |

|---|---|---|---|

| 默认上下文窗口 | 200K Token | 200K Token | 持平 |

| Beta 扩展窗口 | 1,000K (1M) Token | 不支持 | 首次支持 |

| 最大输出 Token | 128K Token | 64K Token | 2 倍提升 |

| MRCR v2 基准 (1M) | 76.0% | 18.5% | 约 4 倍提升 |

| MRCR v2 基准 (256K) | 93.0% | — | 极高准确率 |

| 推荐思维模式 | Adaptive Thinking | — | 新增特性 |

🎯 关键信息: Claude Opus 4.6 的 1M 上下文窗口目前处于 Beta 阶段,需要通过特定 API Header 开启。默认情况下仍使用 200K 上下文窗口。通过 API易 apiyi.com 平台可以快速测试不同上下文长度下的模型表现。

Claude 4.6 上下文窗口的 3 个关键突破

突破一:Opus 系列首次支持 1M 上下文

在 Claude Opus 4.6 之前,100 万 Token 上下文窗口仅对 Sonnet 系列模型(Sonnet 4 和 Sonnet 4.5)开放。Opus 4.6 是首个支持 1M 上下文的 Opus 旗舰模型,这意味着你可以将 Opus 的强大推理能力与超大上下文结合使用。

具体来说,1M Token 大约等于:

| 内容类型 | 可容纳量 | 典型场景 |

|---|---|---|

| 纯文本 | 约 75 万字 | 完整技术文档库 |

| 代码 | 约 75,000+ 行 | 完整代码仓库 |

| PDF 文档 | 数十份研究论文 | 批量文献综述 |

| 对话记录 | 数百轮对话 | 超长会话保持 |

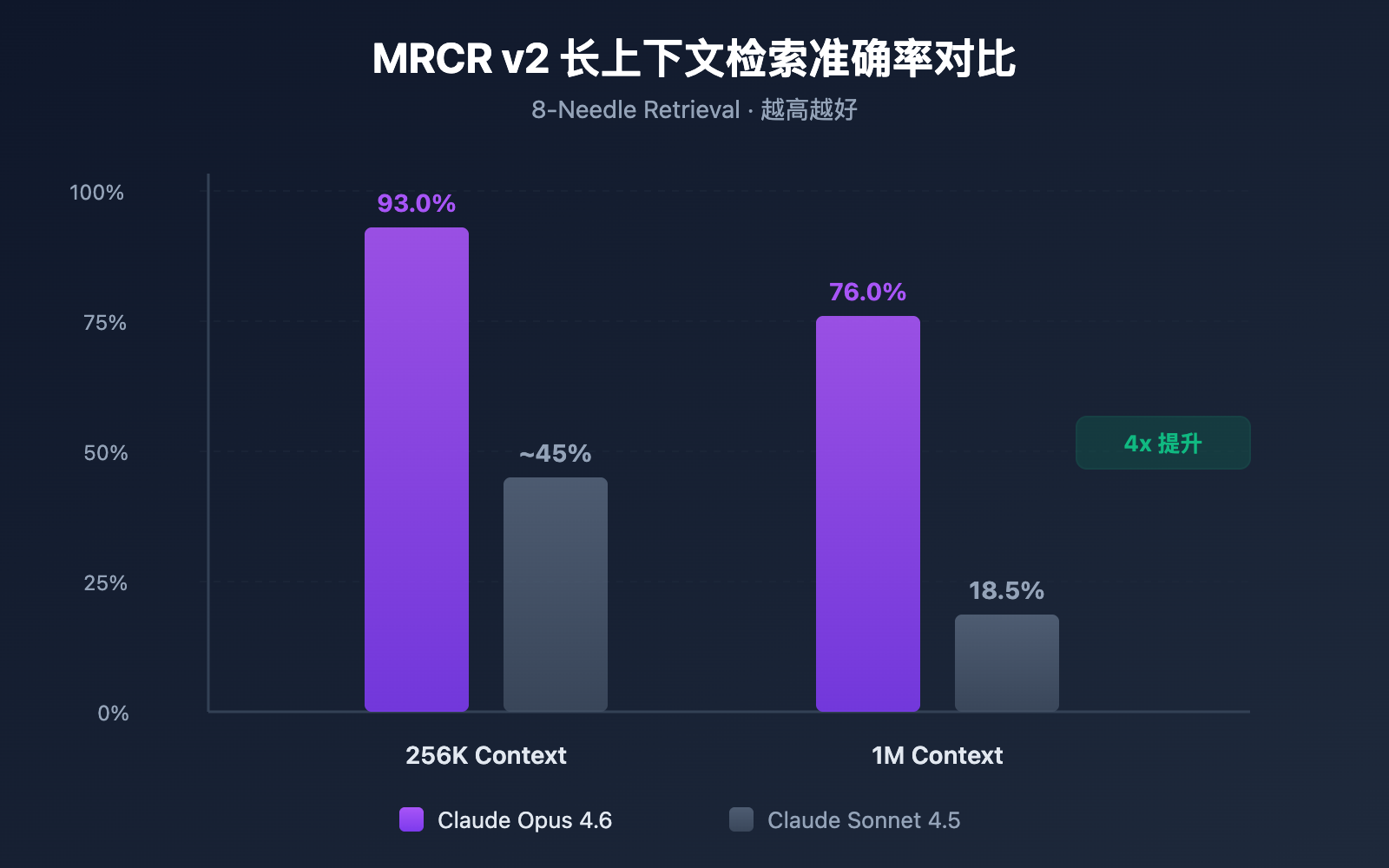

突破二:长上下文检索准确率飙升

上下文窗口大是一回事,能不能在大窗口中准确找到信息是另一回事。Claude Opus 4.6 在 MRCR v2(Multi-needle Retrieval with Contextual Reasoning)基准测试中表现惊人:

- 256K Token 上下文: 准确率达到 93.0%

- 1M Token 上下文 (8 针): 准确率达到 76.0%

MRCR v2 是一个"大海捞针"式测试——将 8 条关键信息藏在 100 万 Token 的文本中,要求模型全部找出。Claude Opus 4.6 的 76% 准确率相比 Sonnet 4.5 的 18.5% 有质的飞跃,可靠性提升约 4-9 倍。

突破三:Compaction 机制实现无限对话

Claude Opus 4.6 引入了 Compaction(上下文压缩)机制,这是一项服务端自动上下文摘要功能:

- 当对话接近上下文窗口上限时,API 自动总结较早的对话内容

- 无需手动管理上下文、不需要滑动窗口或截断策略

- 理论上支持无限长度的对话

这对 Agent 工作流特别有价值——涉及大量工具调用和长推理链的场景中,Compaction 可以显著降低维护对话状态的开销。

Claude 4.6 上下文窗口开启方法

第一步:确认账户资格

1M Token 上下文窗口目前为 Beta 功能,仅对以下用户开放:

- Usage Tier 4 及以上的组织

- 拥有自定义速率限制的组织

你可以在 Anthropic Console 中查看当前的 Usage Tier 等级。

第二步:添加 Beta Header

要启用 1M 上下文窗口,需要在 API 请求中添加特定的 Beta Header:

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 通过 API易 统一接口调用

)

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{"role": "user", "content": "分析以下完整代码仓库..."}

],

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(response.choices[0].message.content)

如果你直接使用 Anthropic SDK,对应的 curl 请求如下:

curl https://api.apiyi.com/v1/messages \

-H "x-api-key: $API_KEY" \

-H "anthropic-version: 2023-06-01" \

-H "anthropic-beta: context-1m-2025-08-07" \

-H "content-type: application/json" \

-d '{

"model": "claude-opus-4-6-20250205",

"max_tokens": 8192,

"messages": [

{"role": "user", "content": "你的超长文本内容..."}

]

}'

🚀 快速开始: 推荐使用 API易 apiyi.com 平台快速测试 Claude Opus 4.6 的长上下文能力。平台提供统一的 API 接口,无需分别对接多家服务商,5 分钟即可完成集成。

第三步:验证上下文窗口

发送请求后,可以通过返回的 usage 字段确认实际使用的 Token 数量:

{

"usage": {

"input_tokens": 450000,

"output_tokens": 2048

}

}

如果 input_tokens 超过 200,000 而请求成功,说明 1M 上下文窗口已正确启用。

查看完整 Python 代码示例(含 Token 统计)

import openai

import tiktoken

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # API易 统一接口

)

# 读取大型代码仓库文件

with open("full_codebase.txt", "r") as f:

codebase_content = f.read()

print(f"输入内容长度: {len(codebase_content)} 字符")

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=[

{

"role": "system",

"content": "你是一个资深代码审查专家,请分析整个代码仓库。"

},

{

"role": "user",

"content": f"请分析以下代码仓库的架构设计和潜在问题:\n\n{codebase_content}"

}

],

max_tokens=16384,

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

print(f"输入 Token: {response.usage.prompt_tokens}")

print(f"输出 Token: {response.usage.completion_tokens}")

print(f"\n分析结果:\n{response.choices[0].message.content}")

Claude 4.6 上下文窗口定价详解

使用 1M 上下文窗口涉及分层定价机制。当请求 Token 超过 200K 时,自动切换到长上下文定价:

| 定价层级 | 输入价格 (每百万 Token) | 输出价格 (每百万 Token) | 适用范围 |

|---|---|---|---|

| 标准定价 | $5.00 | $25.00 | ≤ 200K Token |

| 长上下文定价 | $10.00 | $37.50 | > 200K Token |

| 价格倍率 | 2x | 1.5x | 自动应用 |

定价计算示例

假设你发送了一个 500K Token 的长文本分析请求,输出 4,000 Token:

- 输入费用: 500K × ($10.00 / 1M) = $5.00

- 输出费用: 4K × ($37.50 / 1M) = $0.15

- 单次请求总费用: $5.15

💰 成本优化建议: 对于需要频繁使用长上下文的项目,可以通过 API易 apiyi.com 平台调用 Claude Opus 4.6 API。平台提供灵活的计费方式和更优惠的价格,帮助中小团队有效控制成本。

善用 Context Caching 降低成本

如果你的应用场景涉及重复查询同一批文档(如"与文档对话"类应用),可以利用 Context Caching 功能:

- 首次上传文档按标准价格计费

- 后续基于缓存内容的查询享受折扣价

- 适合批量文档分析、知识库问答等高频场景

Claude 4.6 上下文窗口成本控制最佳实践

| 优化策略 | 说明 | 预计节省 |

|---|---|---|

| 按需使用 1M | 仅在确实需要超长上下文时启用 Beta Header | 避免 2x 输入溢价 |

| Context Caching | 对重复查询的文档使用缓存 | 40-60% 输入成本 |

| 预过滤输入 | 上传前去除无关内容(注释、空行等) | 10-30% Token 消耗 |

| 分层策略 | 简单任务用 Sonnet,复杂任务用 Opus | 整体成本降低 50%+ |

| 输出长度控制 | 设置合理的 max_tokens 避免冗余输出 | 减少输出费用 |

Claude 4.6 上下文窗口 5 大实战场景

场景一:全代码仓库分析

输入规模: 5-7.5 万行代码 (约 400K-600K Token)

这是 1M 上下文窗口最直接的受益场景。将整个项目的源代码一次性提交给 Claude Opus 4.6,可以实现:

- 全局架构审查:识别跨模块的设计问题

- 依赖关系分析:找出循环依赖和过度耦合

- 安全漏洞扫描:在完整上下文中发现跨文件的安全风险

- 重构建议:基于全局理解给出重构方案

过去处理大型代码仓库时,开发者不得不将代码分成多个片段逐步分析,导致模型无法理解跨文件的依赖关系。现在,你可以直接将整个 monorepo 的核心代码一次性提交,让 Claude 像一个真正理解全局的架构师一样给出建议。

场景二:批量文献综述

输入规模: 20-30 篇论文 (约 500K-800K Token)

研究人员可以一次性输入数十篇相关论文,让 Claude 进行:

- 交叉引用分析:识别论文间的引用关系和观点冲突

- 研究趋势总结:从大量文献中提取方法论演进

- Gap 分析:发现现有研究的空白领域

- 元分析辅助:横向对比不同研究的实验设计和结果

对于科研工作者来说,手动阅读 30 篇论文可能需要数周时间。借助 1M 上下文窗口,可以在几分钟内完成初步筛选和关键信息提取,极大加速文献调研效率。

场景三:企业知识库问答

输入规模: 完整产品文档库 (约 300K-500K Token)

将企业内部文档全量载入上下文,实现:

- 精确回答:基于完整文档库给出准确答案

- 跨文档关联:发现不同文档间的信息关联

- 实时更新:无需预处理向量化,直接使用最新文档

- 多文档推理:综合多份技术文档回答复杂问题

相比传统的 RAG(检索增强生成)方案,全量上下文方案省去了向量化、索引构建和检索调优的工程开销。对于文档量在 1M Token 以内的中小型知识库,直接使用长上下文是更简单高效的方案。

场景四:长篇内容创作与编辑

输入规模: 完整书稿或系列文章 (约 200K-400K Token)

- 一致性审查:确保长篇内容前后逻辑一致

- 风格统一:在完整上下文中保持语言风格一致

- 结构优化:基于全文理解提出章节调整建议

- 术语规范:在全书范围内统一专业术语的使用

例如,一本 20 万字的技术书籍约占 300K Token,完全可以在一次请求中让 Claude 审阅全稿并指出前后矛盾的地方。

场景五:复杂 Agent 工作流

输入规模: 多轮工具调用记录 (累积 300K-700K Token)

配合 Claude 4.6 的 Agent Teams 功能:

- 长链推理:在复杂多步任务中保持完整推理链

- 工具调用记忆:记住所有历史工具调用结果

- 结合 Compaction:超长工作流自动压缩上下文

- 多 Agent 协作:在 Agent Teams 中共享上下文信息

Agent 工作流是 Claude Opus 4.6 的核心使用场景之一。在执行复杂任务时(如自动化代码审查、数据分析流水线),Agent 可能需要调用数十次工具,每次调用的输入和输出都会累积在上下文中。1M 窗口确保了即使在长时间运行的任务中,Agent 也不会"遗忘"早期的关键信息。

🎯 实战建议: 以上 5 大场景均可通过 API易 apiyi.com 平台快速验证效果。平台支持 Claude Opus 4.6 在内的多种主流模型,提供统一的接口调用体验,便于在不同场景间灵活切换。

Claude 4.6 上下文窗口与竞品对比

了解 Claude Opus 4.6 在长上下文领域的竞争力,有助于你做出更合理的技术选型:

| 模型 | 上下文窗口 | 最大输出 | 长上下文检索表现 | 定价 (输入/输出) |

|---|---|---|---|---|

| Claude Opus 4.6 | 1M (Beta) | 128K | MRCR 76.0% (1M) | $5-10 / $25-37.5 |

| Claude Sonnet 4.5 | 1M (Beta) | 64K | MRCR 18.5% (1M) | $3 / $15 |

| GPT-4.1 | 1M | 32K | — | $2 / $8 |

| Gemini 2.5 Pro | 1M | 65K | — | $1.25-2.5 / $10-15 |

| Gemini 2.5 Flash | 1M | 65K | — | $0.15-0.3 / $0.6-2.4 |

可以看出,Claude Opus 4.6 在长上下文检索准确率方面具有明显优势。虽然定价较高,但在需要精确检索和复杂推理的场景中,其可靠性远超竞品。

💡 选择建议: 选择哪个模型主要取决于您的具体场景需求。如果优先考虑长上下文下的推理质量,Claude Opus 4.6 是目前的最优选择。我们建议通过 API易 apiyi.com 平台进行实际测试对比,该平台支持以上多种主流模型的统一接口调用,便于快速切换和评估。

Claude 4.6 上下文窗口 Compaction 配置

Compaction 是 Claude Opus 4.6 新增的服务端上下文压缩功能,可以让对话理论上无限延续。

工作原理

- API 监测每轮对话的 Token 使用量

- 当输入 Token 超过设定阈值时,自动触发摘要

- 模型生成

<summary>标签包裹的对话摘要 - 摘要替换早期对话内容,释放上下文空间

配置方法

在 API 请求中添加 compaction_control 参数:

response = client.chat.completions.create(

model="claude-opus-4-6-20250205",

messages=conversation_history,

extra_body={

"compaction_control": {

"enabled": True,

"trigger_tokens": 150000 # 触发阈值

}

},

extra_headers={

"anthropic-beta": "context-1m-2025-08-07"

}

)

Compaction 与 1M 上下文的配合策略

| 策略 | 上下文窗口 | Compaction | 适用场景 |

|---|---|---|---|

| 超大单次分析 | 1M (全开) | 关闭 | 代码审查、文献综述 |

| 长期对话 | 200K (默认) | 开启 | 客服、助手、Agent |

| 混合模式 | 1M + Compaction | 开启 | 超复杂 Agent 工作流 |

常见问题

Q1: Claude 4.6 的上下文窗口默认就是 1M 吗?

不是。Claude Opus 4.6 的默认上下文窗口仍然是 200K Token,与上一代 Opus 4.5 相同。要使用 1M Token 上下文窗口,需要在 API 请求中添加 anthropic-beta: context-1m-2025-08-07 Header。此外,你的组织需要达到 Usage Tier 4 或拥有自定义速率限制。通过 API易 apiyi.com 平台调用时,可以方便地在请求中添加此 Header。

Q2: 使用 1M 上下文窗口会额外收费吗?

是的,存在分层定价。当请求超过 200K Token 时,输入价格从 $5/M 升至 $10/M(2 倍),输出价格从 $25/M 升至 $37.50/M(1.5 倍)。对于预算敏感的项目,建议通过 API易 apiyi.com 平台获取更优惠的价格方案。

Q3: 1M 上下文中能准确找到特定信息吗?

Claude Opus 4.6 在 MRCR v2 基准测试中表现优异。在 1M Token 上下文中隐藏 8 条关键信息的测试场景下,准确率达到 76%,是 Sonnet 4.5(18.5%)的约 4 倍。在 256K 上下文中,准确率更是高达 93%。这意味着 Claude Opus 4.6 是目前长上下文检索最可靠的模型之一。

Q4: Compaction 会影响回答质量吗?

Compaction 通过智能摘要来压缩早期对话内容,在大多数场景下不会显著影响回答质量。但对于需要精确引用早期对话细节的场景,建议关闭 Compaction 并直接使用 1M 上下文窗口。在 Agent 工作流中,Compaction 可以显著提升效率,推荐开启。

Q5: 哪些 Claude 模型支持 1M 上下文?

目前支持 1M Token 上下文窗口的 Claude 模型有 3 个:Claude Opus 4.6、Claude Sonnet 4.5 和 Claude Sonnet 4。其中 Opus 4.6 的长上下文检索准确率远高于 Sonnet 系列。其他模型如 Claude Haiku 系列目前不支持 1M 上下文。

总结

Claude Opus 4.6 的 1M Token 上下文窗口是一次重要的能力升级,将 Opus 旗舰模型的强大推理能力与超大上下文结合,开启了全代码仓库分析、批量文献综述、企业知识库问答等高价值应用场景。

核心要点回顾:

- 默认 200K,Beta 扩展至 1M: 需要添加

anthropic-beta: context-1m-2025-08-07Header - 长上下文检索准确率行业领先: MRCR v2 基准 76%(1M)/ 93%(256K)

- 分层定价: 超过 200K 部分输入价格 2x、输出价格 1.5x

- Compaction 支持无限对话: 服务端自动上下文压缩,适合 Agent 工作流

- 3 款模型支持: Opus 4.6、Sonnet 4.5、Sonnet 4

推荐通过 API易 apiyi.com 快速体验 Claude Opus 4.6 的长上下文能力,平台支持统一接口调用多种主流 AI 模型,助力开发者高效完成技术验证和产品集成。

本文由 APIYI Team 撰写,专注 AI 大模型技术分享。更多教程和 API 使用指南,请访问 API易帮助中心: help.apiyi.com

参考资料

-

Anthropic 官方博客 – Introducing Claude Opus 4.6

- 链接:

anthropic.com/news/claude-opus-4-6 - 说明: Claude Opus 4.6 发布公告和核心特性介绍

- 链接:

-

Claude API 文档 – Context Windows

- 链接:

platform.claude.com/docs/en/build-with-claude/context-windows - 说明: 上下文窗口配置和使用指南

- 链接:

-

Claude API 文档 – Compaction

- 链接:

platform.claude.com/docs/en/build-with-claude/compaction - 说明: Compaction 上下文压缩功能详解

- 链接:

-

Claude API 文档 – Pricing

- 链接:

platform.claude.com/docs/en/about-claude/pricing - 说明: 模型定价和长上下文定价说明

- 链接: