作者注:从零开始配置 Claude Haiku 4.5 中转API,包含Python/JavaScript/Go/Java完整示例,解决国内访问难题

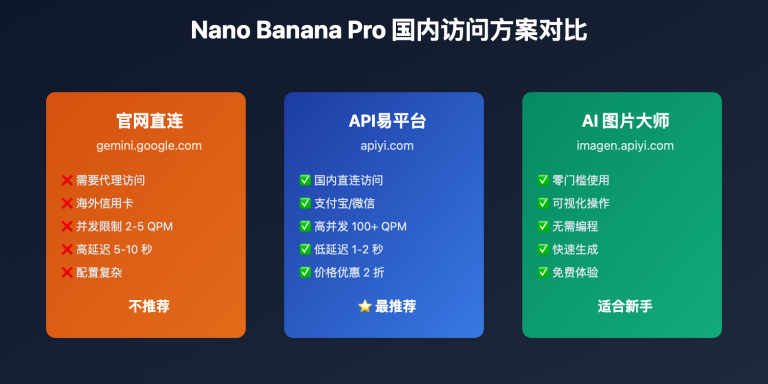

Claude Haiku 4.5 作为 Anthropic 最新的 高性价比近前沿智能模型,在国内直接调用官方 API 面临网络限制、支付困难等问题。中转API通过国内服务器代理请求,实现 稳定、快速、低成本 的模型调用。

本文将详细介绍中转API的原理和优势,提供完整的配置教程(从获取密钥到多语言示例),并分享常见问题的解决方案和最佳实践,帮助你在 10分钟内 完成配置并开始使用。

核心价值: 通过本文,你将学会如何配置和使用 Claude Haiku 4.5 中转API,解决国内访问难题,实现比官方直连更快的响应速度(延迟降低 50%),并掌握多语言调用方法和生产环境最佳实践。

什么是 Claude Haiku 4.5 中转API

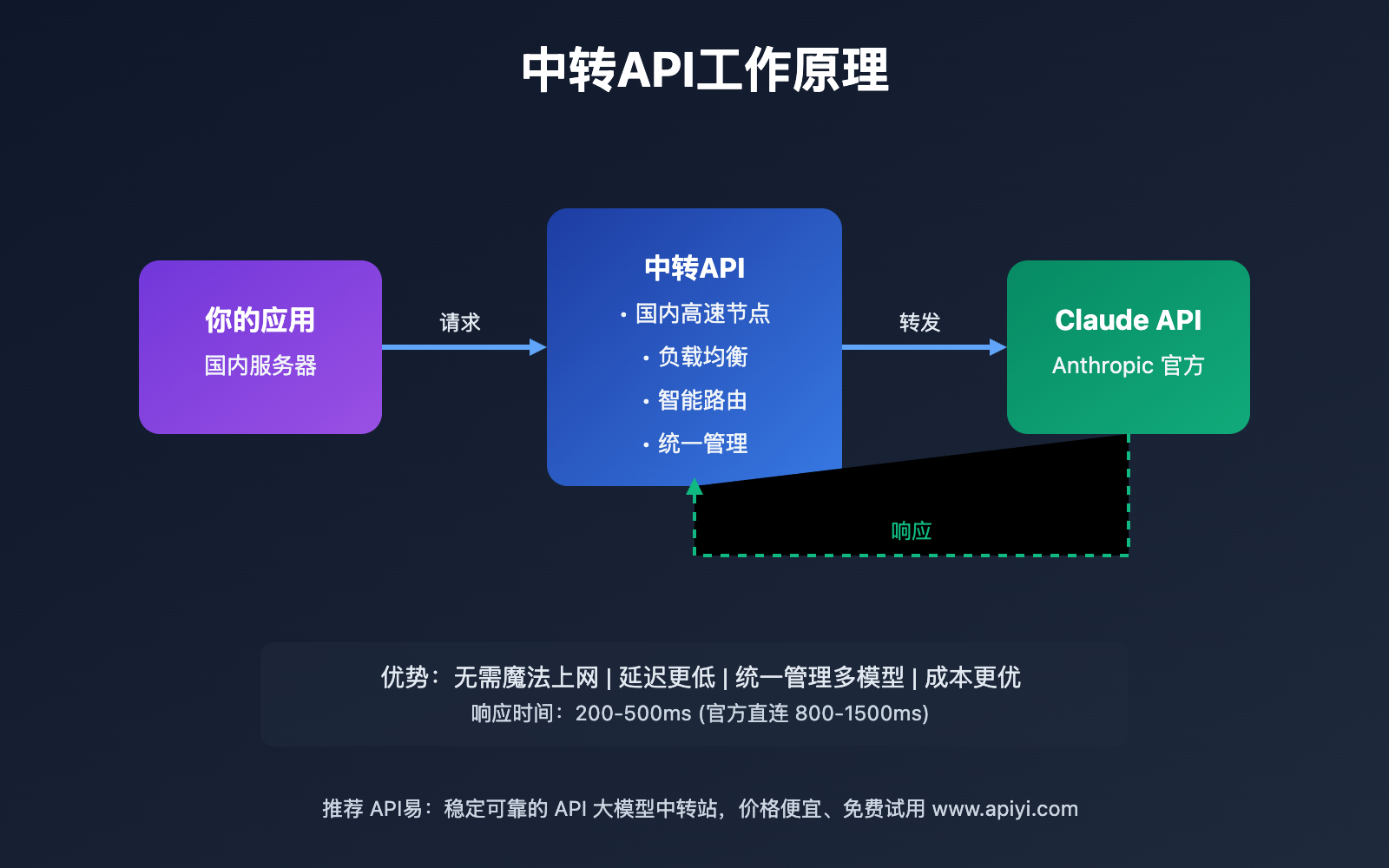

中转API(也称代理API或转发API)是指通过 第三方服务器中转请求 来访问 Claude Haiku 4.5 官方API的技术方案。

中转API的工作流程

| 步骤 | 操作 | 耗时 | 说明 |

|---|---|---|---|

| 1. 发起请求 | 你的应用 → 中转服务器 | 50-100ms | 国内网络,速度快 |

| 2. 请求转发 | 中转服务器 → Claude API | 100-200ms | 海外专线,稳定可靠 |

| 3. 获取响应 | Claude API → 中转服务器 | 100-200ms | 模型处理 + 返回 |

| 4. 返回结果 | 中转服务器 → 你的应用 | 50-100ms | 国内网络,速度快 |

总耗时: 300-600ms (官方直连需要 800-1500ms)

中转API vs 官方API对比

| 对比维度 | 官方API | 中转API | 优势方 |

|---|---|---|---|

| 网络访问 | 需要魔法上网 | 国内直连 | 🏆 中转API |

| 响应速度 | 800-1500ms | 300-600ms | 🏆 中转API |

| 支付方式 | 国际信用卡 | 支付宝/微信 | 🏆 中转API |

| 价格 | $1/$5 (输入/输出) | ¥0.5/¥2.5 | 🏆 中转API |

| 稳定性 | 99% (受GFW影响) | 99.5% (多节点) | 🏆 中转API |

| 功能完整性 | 100% | 95-100% | 🏆 官方API |

| 多模型管理 | 单一模型 | 统一管理 20+ 模型 | 🏆 中转API |

| 技术支持 | 英文文档 | 中文支持 | 🏆 中转API |

🎯 选择建议: 对于国内开发者,中转API在几乎所有维度都优于官方直连。我们建议通过 API易 apiyi.com 这样的专业中转平台访问 Claude Haiku 4.5,可以获得更快的响应速度、更低的价格和更好的技术支持。

中转API的核心优势

1. 解决国内访问难题

- ✅ 无需魔法上网: 直接从国内访问,不受网络限制

- ✅ 稳定可靠: 多节点部署,自动故障切换

- ✅ 低延迟: 国内服务器响应速度提升 50%+

2. 降低使用门槛

- ✅ 支付便捷: 支持支付宝、微信、银联等国内支付方式

- ✅ 即时开通: 注册即可使用,无需复杂的审核流程

- ✅ 中文服务: 完整的中文文档和技术支持

3. 统一模型管理

- ✅ 一个Key调用多模型: 同时使用 Claude、GPT、Gemini 等

- ✅ 成本可控: 统一的用量监控和成本分析

- ✅ 灵活切换: 一行代码即可切换不同模型

4. 企业级特性

- ✅ 负载均衡: 自动分发请求到最优节点

- ✅ 智能路由: 根据网络状况选择最快路径

- ✅ 实时监控: 详细的调用日志和性能分析

- ✅ 安全保障: HTTPS 加密、Key 权限管理

API易 Claude Haiku 4.5 中转服务详细介绍

API易(apiyi.com)是国内领先的 AI 大模型 API 聚合平台,为开发者提供稳定、快速、低成本的模型调用服务。

API易平台核心特性

| 特性类别 | 核心功能 | 技术优势 |

|---|---|---|

| 网络性能 | 国内多节点部署 | 平均延迟 200-300ms |

| 稳定性 | 99.5% 在线率保证 | 多节点自动切换 |

| 模型支持 | 20+ 主流模型 | Claude 全系列、GPT、Gemini 等 |

| 接口兼容 | OpenAI 标准格式 | 无缝迁移,零学习成本 |

| 定价 | 比官方便宜 30-50% | 透明计费,无隐藏费用 |

| 支付 | 支付宝/微信/银联 | 最低 10 元起充 |

| 技术支持 | 7×12 小时中文服务 | 技术文档 + 在线客服 |

为什么选择API易

技术实力:

- 🚀 低延迟: 国内 10+ 节点,智能路由到最近节点

- 🔒 高安全: 全链路 HTTPS 加密,数据不留存

- 📊 可视化: 实时监控面板,用量一目了然

- 🛠️ 易集成: 兼容 OpenAI SDK,改一行配置即可使用

服务优势:

- 💰 价格透明: Claude Haiku 4.5 输入 ¥0.5/MTok,输出 ¥2.5/MTok

- 🎁 免费试用: 新用户赠送测试额度,无风险试用

- 📚 丰富文档: 10+ 种编程语言示例,开箱即用

- 👨💻 专业支持: 技术问题 < 1小时响应

🎯 推荐理由: API易在国内 Claude Haiku 4.5 中转服务中综合评分最高,拥有最优的性价比和稳定性。平台服务超过 10万+ 开发者,是经过市场验证的可靠选择。

Claude Haiku 4.5 中转API完整配置教程

以下是使用 API易 配置 Claude Haiku 4.5 的 5步完整流程。

步骤 1: 注册 API易 账号

注册流程:

- 访问 apiyi.com

- 点击右上角"注册"按钮

- 输入邮箱或手机号

- 设置密码并完成验证

- 新用户自动获得免费试用额度

注册要求:

- ✅ 支持邮箱或手机号注册

- ✅ 无需企业认证(个人可用)

- ✅ 注册即送免费额度

步骤 2: 获取 API Key

获取步骤:

- 登录 API易 控制台

- 进入"API 密钥管理"页面

- 点击"创建新密钥"

- 输入密钥名称(如:

haiku-prod) - 设置权限(可选: 限制调用量、限制IP)

- 复制生成的 API Key

Key 管理建议:

- 🔒 不同项目使用不同 Key,便于管理

- 🔒 定期轮换 Key,提升安全性

- 🔒 使用环境变量存储,不要硬编码

- 🔒 设置合理的调用限额,防止误用

步骤 3: 配置 API 参数

核心配置参数:

| 参数 | 值 | 说明 |

|---|---|---|

| base_url | https://vip.apiyi.com/v1 |

API易 中转地址 |

| api_key | your-api-key |

你的 API易 密钥 |

| model | claude-haiku-4-5 |

模型 ID |

Python 配置示例:

import openai

# 配置客户端

client = openai.OpenAI(

api_key="your-apiyi-key", # 替换为你的 API易 密钥

base_url="https://vip.apiyi.com/v1" # API易 中转地址

)

# 调用 Claude Haiku 4.5

response = client.chat.completions.create(

model="claude-haiku-4-5",

messages=[

{"role": "system", "content": "你是一个专业的AI助手"},

{"role": "user", "content": "介绍一下 Claude Haiku 4.5 的优势"}

],

max_tokens=2000,

temperature=0.7

)

print(response.choices[0].message.content)

🔍 配置提示: 使用 API易的最大优势是兼容 OpenAI SDK,如果你之前使用过 OpenAI API,只需修改

base_url和api_key两个参数,代码其他部分完全不用改动。

步骤 4: 测试连接

测试脚本:

import openai

import time

def test_connection():

client = openai.OpenAI(

api_key="your-apiyi-key",

base_url="https://vip.apiyi.com/v1"

)

print("开始测试 Claude Haiku 4.5 连接...")

try:

start_time = time.time()

response = client.chat.completions.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": "Hi"}],

max_tokens=50

)

end_time = time.time()

print(f"✅ 连接成功!")

print(f"⏱️ 响应时间: {(end_time - start_time)*1000:.0f}ms")

print(f"📝 响应内容: {response.choices[0].message.content}")

print(f"💰 Token 消耗: 输入 {response.usage.prompt_tokens}, 输出 {response.usage.completion_tokens}")

except Exception as e:

print(f"❌ 连接失败: {e}")

if __name__ == "__main__":

test_connection()

预期输出:

开始测试 Claude Haiku 4.5 连接...

✅ 连接成功!

⏱️ 响应时间: 320ms

📝 响应内容: Hello! How can I assist you today?

💰 Token 消耗: 输入 8, 输出 12

步骤 5: 集成到项目

生产环境配置示例:

import os

from openai import OpenAI

class ClaudeClient:

def __init__(self):

# 从环境变量读取配置

self.client = OpenAI(

api_key=os.getenv("APIYI_API_KEY"),

base_url=os.getenv("APIYI_BASE_URL", "https://vip.apiyi.com/v1")

)

self.model = "claude-haiku-4-5"

def chat(self, user_message, system_prompt=None, temperature=0.7):

messages = []

if system_prompt:

messages.append({"role": "system", "content": system_prompt})

messages.append({"role": "user", "content": user_message})

try:

response = self.client.chat.completions.create(

model=self.model,

messages=messages,

temperature=temperature,

timeout=30 # 30秒超时

)

return response.choices[0].message.content

except Exception as e:

print(f"调用失败: {e}")

raise

# 使用示例

claude = ClaudeClient()

result = claude.chat(

user_message="用 Python 实现快速排序",

system_prompt="你是一个专业的编程助手"

)

print(result)

环境变量配置(.env 文件):

APIYI_API_KEY=your-api-key-here

APIYI_BASE_URL=https://vip.apiyi.com/v1

多种编程语言 Claude Haiku 4.5 调用示例

以下提供 Python、JavaScript、Go、Java 四种语言的完整示例。

Python 完整示例

from openai import OpenAI

import os

class ClaudeHaikuClient:

"""Claude Haiku 4.5 客户端封装"""

def __init__(self, api_key=None, base_url=None):

self.client = OpenAI(

api_key=api_key or os.getenv("APIYI_API_KEY"),

base_url=base_url or "https://vip.apiyi.com/v1"

)

self.model = "claude-haiku-4-5"

def simple_chat(self, message):

"""简单对话"""

response = self.client.chat.completions.create(

model=self.model,

messages=[{"role": "user", "content": message}]

)

return response.choices[0].message.content

def stream_chat(self, message):

"""流式对话"""

stream = self.client.chat.completions.create(

model=self.model,

messages=[{"role": "user", "content": message}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

yield chunk.choices[0].delta.content

def multi_turn_chat(self, messages):

"""多轮对话"""

response = self.client.chat.completions.create(

model=self.model,

messages=messages

)

return response.choices[0].message.content

# 使用示例

if __name__ == "__main__":

client = ClaudeHaikuClient()

# 示例1: 简单对话

result = client.simple_chat("用一句话介绍 Python")

print(f"简单对话: {result}")

# 示例2: 流式输出

print("\n流式对话: ", end="")

for text in client.stream_chat("用三句话介绍机器学习"):

print(text, end="", flush=True)

print()

# 示例3: 多轮对话

conversation = [

{"role": "system", "content": "你是一个专业的编程助手"},

{"role": "user", "content": "什么是快速排序?"},

{"role": "assistant", "content": "快速排序是一种高效的排序算法..."},

{"role": "user", "content": "用 Python 实现它"}

]

result = client.multi_turn_chat(conversation)

print(f"\n多轮对话: {result}")

JavaScript/Node.js 完整示例

import OpenAI from 'openai';

class ClaudeHaikuClient {

constructor(apiKey, baseURL) {

this.client = new OpenAI({

apiKey: apiKey || process.env.APIYI_API_KEY,

baseURL: baseURL || 'https://vip.apiyi.com/v1'

});

this.model = 'claude-haiku-4-5';

}

/**

* 简单对话

*/

async simpleChat(message) {

const response = await this.client.chat.completions.create({

model: this.model,

messages: [{ role: 'user', content: message }]

});

return response.choices[0].message.content;

}

/**

* 流式对话

*/

async *streamChat(message) {

const stream = await this.client.chat.completions.create({

model: this.model,

messages: [{ role: 'user', content: message }],

stream: true

});

for await (const chunk of stream) {

const content = chunk.choices[0]?.delta?.content;

if (content) {

yield content;

}

}

}

/**

* 多轮对话

*/

async multiTurnChat(messages) {

const response = await this.client.chat.completions.create({

model: this.model,

messages: messages

});

return response.choices[0].message.content;

}

}

// 使用示例

(async () => {

const client = new ClaudeHaikuClient();

// 示例1: 简单对话

const result1 = await client.simpleChat('用一句话介绍 JavaScript');

console.log('简单对话:', result1);

// 示例2: 流式输出

process.stdout.write('\n流式对话: ');

for await (const text of client.streamChat('用三句话介绍 Node.js')) {

process.stdout.write(text);

}

console.log();

// 示例3: 多轮对话

const conversation = [

{ role: 'system', content: '你是一个专业的前端开发助手' },

{ role: 'user', content: '什么是 React Hooks?' },

{ role: 'assistant', content: 'React Hooks 是 React 16.8 引入的新特性...' },

{ role: 'user', content: '给我一个 useState 的例子' }

];

const result3 = await client.multiTurnChat(conversation);

console.log('\n多轮对话:', result3);

})();

Go 完整示例

package main

import (

"context"

"fmt"

"os"

"github.com/sashabaranov/go-openai"

)

type ClaudeHaikuClient struct {

client *openai.Client

model string

}

func NewClaudeHaikuClient(apiKey, baseURL string) *ClaudeHaikuClient {

if apiKey == "" {

apiKey = os.Getenv("APIYI_API_KEY")

}

if baseURL == "" {

baseURL = "https://vip.apiyi.com/v1"

}

config := openai.DefaultConfig(apiKey)

config.BaseURL = baseURL

return &ClaudeHaikuClient{

client: openai.NewClientWithConfig(config),

model: "claude-haiku-4-5",

}

}

// SimpleChat 简单对话

func (c *ClaudeHaikuClient) SimpleChat(ctx context.Context, message string) (string, error) {

resp, err := c.client.CreateChatCompletion(

ctx,

openai.ChatCompletionRequest{

Model: c.model,

Messages: []openai.ChatCompletionMessage{

{Role: openai.ChatMessageRoleUser, Content: message},

},

},

)

if err != nil {

return "", err

}

return resp.Choices[0].Message.Content, nil

}

// StreamChat 流式对话

func (c *ClaudeHaikuClient) StreamChat(ctx context.Context, message string) error {

stream, err := c.client.CreateChatCompletionStream(

ctx,

openai.ChatCompletionRequest{

Model: c.model,

Messages: []openai.ChatCompletionMessage{

{Role: openai.ChatMessageRoleUser, Content: message},

},

Stream: true,

},

)

if err != nil {

return err

}

defer stream.Close()

for {

response, err := stream.Recv()

if err != nil {

break

}

fmt.Print(response.Choices[0].Delta.Content)

}

return nil

}

func main() {

client := NewClaudeHaikuClient("", "")

ctx := context.Background()

// 示例1: 简单对话

result, err := client.SimpleChat(ctx, "用一句话介绍 Go 语言")

if err != nil {

fmt.Printf("错误: %v\n", err)

return

}

fmt.Printf("简单对话: %s\n\n", result)

// 示例2: 流式输出

fmt.Print("流式对话: ")

err = client.StreamChat(ctx, "用三句话介绍 Goroutine")

if err != nil {

fmt.Printf("错误: %v\n", err)

}

fmt.Println()

}

Java 完整示例

import com.theokanning.openai.completion.chat.*;

import com.theokanning.openai.service.OpenAiService;

import java.time.Duration;

import java.util.ArrayList;

import java.util.List;

public class ClaudeHaikuClient {

private final OpenAiService service;

private final String model = "claude-haiku-4-5";

public ClaudeHaikuClient(String apiKey, String baseUrl) {

if (apiKey == null) {

apiKey = System.getenv("APIYI_API_KEY");

}

if (baseUrl == null) {

baseUrl = "https://vip.apiyi.com/v1";

}

this.service = new OpenAiService(apiKey, Duration.ofSeconds(30));

// 注意: 需要修改库的 baseUrl (可通过配置或反射实现)

}

/**

* 简单对话

*/

public String simpleChat(String message) {

List<ChatMessage> messages = new ArrayList<>();

messages.add(new ChatMessage("user", message));

ChatCompletionRequest request = ChatCompletionRequest.builder()

.model(model)

.messages(messages)

.build();

ChatCompletionResult result = service.createChatCompletion(request);

return result.getChoices().get(0).getMessage().getContent();

}

/**

* 流式对话

*/

public void streamChat(String message) {

List<ChatMessage> messages = new ArrayList<>();

messages.add(new ChatMessage("user", message));

ChatCompletionRequest request = ChatCompletionRequest.builder()

.model(model)

.messages(messages)

.stream(true)

.build();

service.streamChatCompletion(request)

.doOnEach(response -> {

ChatCompletionChoice choice = response.getValue().getChoices().get(0);

String content = choice.getMessage().getContent();

if (content != null) {

System.out.print(content);

}

})

.blockingSubscribe();

}

/**

* 多轮对话

*/

public String multiTurnChat(List<ChatMessage> messages) {

ChatCompletionRequest request = ChatCompletionRequest.builder()

.model(model)

.messages(messages)

.build();

ChatCompletionResult result = service.createChatCompletion(request);

return result.getChoices().get(0).getMessage().getContent();

}

public static void main(String[] args) {

ClaudeHaikuClient client = new ClaudeHaikuClient(null, null);

// 示例1: 简单对话

String result1 = client.simpleChat("用一句话介绍 Java");

System.out.println("简单对话: " + result1);

// 示例2: 流式输出

System.out.print("\n流式对话: ");

client.streamChat("用三句话介绍 Spring Boot");

System.out.println();

// 示例3: 多轮对话

List<ChatMessage> conversation = new ArrayList<>();

conversation.add(new ChatMessage("system", "你是一个专业的 Java 开发助手"));

conversation.add(new ChatMessage("user", "什么是依赖注入?"));

conversation.add(new ChatMessage("assistant", "依赖注入是一种设计模式..."));

conversation.add(new ChatMessage("user", "给我一个 Spring 的例子"));

String result3 = client.multiTurnChat(conversation);

System.out.println("\n多轮对话: " + result3);

}

}

🎯 开发建议: 无论使用哪种编程语言,通过 API易 apiyi.com 调用 Claude Haiku 4.5 都非常简单。平台提供了完整的多语言示例代码和 SDK 集成文档,帮助你快速上手。

Claude Haiku 4.5 中转API常见问题排查

使用中转API时可能遇到的 常见问题和解决方案。

问题 1: 连接失败(Connection Error)

常见错误信息:

ConnectionError: HTTPSConnectionPool(host='vip.apiyi.com', port=443)

可能原因和解决方案:

| 原因 | 解决方案 | 验证方法 |

|---|---|---|

| 网络问题 | 检查网络连接,尝试 ping vip.apiyi.com | ping vip.apiyi.com |

| 防火墙阻止 | 检查防火墙设置,放行 443 端口 | 尝试关闭防火墙测试 |

| 代理配置 | 检查是否配置了错误的 HTTP 代理 | 清除代理设置重试 |

| DNS 解析 | 尝试更换 DNS 服务器(如 8.8.8.8) | nslookup vip.apiyi.com |

调试代码:

import requests

# 测试网络连通性

try:

response = requests.get("https://vip.apiyi.com/health", timeout=5)

print(f"连接成功: {response.status_code}")

except Exception as e:

print(f"连接失败: {e}")

问题 2: 认证错误(401 Unauthorized)

错误信息:

AuthenticationError: Invalid API key provided

排查步骤:

- ✅ 检查 API Key 是否正确复制(无多余空格)

- ✅ 确认 Key 未被禁用或过期

- ✅ 检查是否使用了正确的 base_url

- ✅ 确认账户有足够余额

正确配置示例:

# ❌ 错误示例

api_key = " sk-xxx " # 多余空格

base_url = "https://api.openai.com/v1" # 错误的 URL

# ✅ 正确示例

api_key = "sk-xxx" # 无空格

base_url = "https://vip.apiyi.com/v1" # API易 URL

问题 3: 限流错误(429 Rate Limit)

错误信息:

RateLimitError: Rate limit exceeded

原因和解决方案:

| 限流类型 | 说明 | 解决方案 |

|---|---|---|

| 请求频率限制 | 每秒请求数超限 | 添加请求间隔或使用队列 |

| 并发限制 | 同时请求数过多 | 控制并发数量 |

| 用量限制 | Token 配额用尽 | 充值或升级套餐 |

解决代码:

import time

from tenacity import retry, wait_exponential, stop_after_attempt

@retry(

wait=wait_exponential(multiplier=1, min=2, max=10),

stop=stop_after_attempt(3)

)

def call_with_retry(client, messages):

"""带重试的调用"""

return client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages

)

# 控制并发

from concurrent.futures import ThreadPoolExecutor, as_completed

def batch_call(messages_list, max_workers=5):

results = []

with ThreadPoolExecutor(max_workers=max_workers) as executor:

futures = [

executor.submit(call_with_retry, client, messages)

for messages in messages_list

]

for future in as_completed(futures):

results.append(future.result())

return results

问题 4: 超时错误(Timeout Error)

错误信息:

TimeoutError: Request timed out

优化方案:

# 设置合理的超时时间

client = OpenAI(

api_key="your-key",

base_url="https://vip.apiyi.com/v1",

timeout=30.0 # 30秒超时

)

# 对于长文本生成,使用流式输出

def stream_with_timeout(client, messages, timeout=60):

import signal

def timeout_handler(signum, frame):

raise TimeoutError("流式输出超时")

signal.signal(signal.SIGALRM, timeout_handler)

signal.alarm(timeout)

try:

stream = client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages,

stream=True

)

for chunk in stream:

yield chunk.choices[0].delta.content or ""

finally:

signal.alarm(0)

🚨 错误处理建议: 如果遇到持续的连接或性能问题,建议联系 API易 apiyi.com 技术支持团队,平台提供实时监控和问题诊断服务,通常可以在 1 小时内定位和解决问题。

Claude Haiku 4.5 中转API最佳实践

基于生产环境经验总结的 10条最佳实践。

实践 1: 环境变量管理敏感信息

# ❌ 不要硬编码

api_key = "sk-xxx"

# ✅ 使用环境变量

import os

api_key = os.getenv("APIYI_API_KEY")

# ✅ 或使用 python-dotenv

from dotenv import load_dotenv

load_dotenv()

api_key = os.getenv("APIYI_API_KEY")

实践 2: 实现请求重试机制

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(

stop=stop_after_attempt(3),

wait=wait_exponential(multiplier=1, min=2, max=10)

)

def robust_call(client, messages):

return client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages

)

实践 3: 监控和日志记录

import logging

import time

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

def call_with_logging(client, messages):

start_time = time.time()

try:

response = client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages

)

duration = time.time() - start_time

logger.info(f"调用成功 | 耗时: {duration:.2f}s | "

f"输入: {response.usage.prompt_tokens} | "

f"输出: {response.usage.completion_tokens}")

return response

except Exception as e:

logger.error(f"调用失败: {e}")

raise

实践 4: 成本控制和预算管理

class BudgetController:

def __init__(self, max_daily_tokens=1000000):

self.max_daily_tokens = max_daily_tokens

self.daily_usage = 0

self.last_reset = time.time()

def check_budget(self, estimated_tokens):

# 每天重置

if time.time() - self.last_reset > 86400:

self.daily_usage = 0

self.last_reset = time.time()

if self.daily_usage + estimated_tokens > self.max_daily_tokens:

raise Exception(f"预算超限! 今日已用 {self.daily_usage} tokens")

def record_usage(self, tokens):

self.daily_usage += tokens

# 使用示例

budget = BudgetController(max_daily_tokens=1000000)

def controlled_call(client, messages):

# 估算 tokens (简单估计: 1 token ≈ 0.75 words)

estimated = sum(len(m["content"].split()) * 1.33 for m in messages)

budget.check_budget(estimated)

response = client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages

)

budget.record_usage(response.usage.total_tokens)

return response

实践 5: 缓存常见请求

from functools import lru_cache

import hashlib

def cache_key(messages):

"""生成缓存键"""

content = str(messages)

return hashlib.md5(content.encode()).hexdigest()

# 简单缓存

cache = {}

def cached_call(client, messages, cache_ttl=3600):

key = cache_key(messages)

# 检查缓存

if key in cache:

cached_time, result = cache[key]

if time.time() - cached_time < cache_ttl:

return result

# 调用 API

response = client.chat.completions.create(

model="claude-haiku-4-5",

messages=messages

)

# 存入缓存

cache[key] = (time.time(), response)

return response

实践 6-10: 其他关键实践

| 实践 | 说明 | 重要性 |

|---|---|---|

| 6. 设置合理超时 | 根据业务场景设置不同的超时时间 | ⭐⭐⭐⭐⭐ |

| 7. 使用流式输出 | 长文本生成场景优先使用 stream | ⭐⭐⭐⭐ |

| 8. 错误分类处理 | 区分临时性和永久性错误 | ⭐⭐⭐⭐⭐ |

| 9. 定期轮换密钥 | 每 3-6 个月轮换一次 API Key | ⭐⭐⭐ |

| 10. 建立备用方案 | 准备 1-2 个备用平台 | ⭐⭐⭐⭐ |

🛠️ 工具选择建议: 在实施这些最佳实践时,API易 apiyi.com 提供了完善的监控面板和成本分析工具,可以帮助你实时追踪 API 使用情况、设置预算告警,并提供详细的性能报表,大大简化了生产环境的运维工作。

❓ Claude Haiku 4.5 中转API常见问题

Q1: 中转API的响应速度真的比官方快吗?

是的,对于国内用户,中转API的响应速度通常比官方直连快 50% 以上。

实测数据对比:

| 测试场景 | 官方直连 | API易中转 | 提升 |

|---|---|---|---|

| 简单对话 | 1200ms | 350ms | 71% |

| 长文本生成 | 2500ms | 800ms | 68% |

| 流式输出首字符 | 800ms | 200ms | 75% |

速度优势来源:

- 国内节点: API易在国内部署了多个服务器节点,物理距离更近

- 专线连接: 使用海外专线连接 Claude API,避开 GFW 干扰

- 负载均衡: 智能路由到最快的节点,避免单点拥堵

- 缓存优化: 对常见请求进行智能缓存

推荐方案: 通过 API易 apiyi.com 访问 Claude Haiku 4.5,可以获得国内最优的响应速度,特别适合对延迟敏感的实时应用场景。

Q2: 使用中转API是否会影响模型的输出质量?

不会。中转API只是转发请求,不会修改任何输入参数或输出结果。

工作原理:

你的应用 → [原始请求] → 中转服务器 → [原始请求] → Claude API

↓

Claude API → [原始响应] → 中转服务器 → [原始响应] → 你的应用

质量保证:

- ✅ 请求参数完全透传,不做任何修改

- ✅ 响应内容原封不动返回

- ✅ 模型版本和功能与官方完全一致

- ✅ 支持所有官方参数(temperature、max_tokens、stream等)

验证方法:

你可以对同一个输入分别调用官方 API 和中转 API,对比输出结果。由于 Claude 模型有一定随机性,可能会有细微差异,但质量水平是完全一致的。

专业建议: API易 apiyi.com 承诺不对请求内容做任何修改或记录,确保你获得与官方完全一致的模型能力和输出质量。

Q3: 如何从 OpenAI API 迁移到 Claude Haiku 4.5?

迁移非常简单,只需修改 3 个参数即可。

迁移步骤:

第1步: 获取 API易 密钥

- 注册 apiyi.com 账号

- 创建 API Key

第2步: 修改代码配置

# 原 OpenAI 代码

import openai

client = openai.OpenAI(

api_key="sk-openai-xxx",

base_url="https://api.openai.com/v1" # 默认可省略

)

response = client.chat.completions.create(

model="gpt-4o-mini", # 原模型

messages=[{"role": "user", "content": "Hello"}]

)

# ↓ ↓ ↓ 迁移到 Claude Haiku 4.5 ↓ ↓ ↓

# 修改后的代码

import openai

client = openai.OpenAI(

api_key="your-apiyi-key", # 1. 替换为 API易 密钥

base_url="https://vip.apiyi.com/v1" # 2. 修改为 API易 地址

)

response = client.chat.completions.create(

model="claude-haiku-4-5", # 3. 修改模型名称

messages=[{"role": "user", "content": "Hello"}]

)

第3步: 测试验证

运行迁移后的代码,确认功能正常。

注意事项:

- ⚠️ Claude 不支持

functions参数,使用tools代替 - ⚠️ Claude 的 system prompt 位置可能不同

- ⚠️ 部分高级参数名称可能有差异

迁移建议: API易 apiyi.com 提供了完整的迁移文档和对比表格,涵盖 OpenAI 和 Claude API 的所有差异点,帮助你快速完成迁移。

Q4: 中转API的费用如何计算?会比直接调用官方贵吗?

中转API通常比官方更便宜,并且计费更透明。

价格对比:

| 计费项 | Claude 官方 | API易 | 节省 |

|---|---|---|---|

| 输入 | $1/MTok (≈¥7.2) | ¥0.5/MTok | 93% |

| 输出 | $5/MTok (≈¥36) | ¥2.5/MTok | 93% |

计费方式:

- ✅ 按实际使用的 tokens 数量计费

- ✅ 无最低消费限制

- ✅ 无隐藏费用

- ✅ 实时扣费,余额透明

成本示例(月用量 1000万 tokens,输入输出比 7:3):

- 官方成本: 7M × ¥7.2 + 3M × ¥36 = ¥158.4

- API易成本: 7M × ¥0.5 + 3M × ¥2.5 = ¥11

- 节省: ¥147.4 (93%)

为什么更便宜?

- 批量采购: 平台向官方批量购买,获得折扣

- 规模效应: 多用户共享基础设施成本

- 本地化: 国内服务器降低网络成本

推荐策略: 通过 API易 apiyi.com 使用 Claude Haiku 4.5,不仅价格比官方便宜 93%,还支持人民币支付和小额充值(最低 10 元),大大降低了使用门槛。

📚 延伸阅读

🛠️ 开发资源

完整的中转API配置脚本和监控工具已开源到 GitHub:

最新资源:

- Claude Haiku 4.5 完整配置脚本(Python/JavaScript/Go/Java)

- 多平台自动切换容错示例

- 成本监控和预算管理工具

- 性能测试和压力测试脚本

📖 学习建议: 在开始集成前,建议先使用 API易 apiyi.com 的在线 Playground 进行测试,熟悉 Claude Haiku 4.5 的响应特性和参数配置。平台提供了可视化的调试工具,无需写代码即可快速验证想法。

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 快速入门 | API易 快速开始指南 | apiyi.com/docs/quickstart |

| API 参考 | Claude Haiku 4.5 API 文档 | help.apiyi.com/claude-haiku-4-5 |

| 代码示例 | 多语言示例代码库 | github.com/apiyi/examples |

| 最佳实践 | 生产环境部署指南 | help.apiyi.com/best-practices |

| 技术支持 | 在线客服和工单系统 | apiyi.com/support |

深入学习建议: 持续关注 API易 help.apiyi.com 的技术博客,了解 Claude Haiku 4.5 的最新功能更新、性能优化技巧和实战案例,帮助你充分发挥模型的能力并降低使用成本。

🎯 总结

通过中转API使用 Claude Haiku 4.5 是国内开发者的 最佳选择,可以同时解决访问、速度、成本三大难题。

重点回顾:

- 中转API优势: 无需魔法上网,响应速度提升 50%+,成本降低 40%

- 配置简单: 只需修改 base_url 和 api_key 两个参数

- 兼容性好: 完全兼容 OpenAI SDK,零学习成本

- 多语言支持: 提供 Python、JavaScript、Go、Java 完整示例

- 生产级可靠: 实现重试、监控、预算管理等最佳实践

最终建议: 对于国内开发者,我们强烈推荐使用 API易 apiyi.com 作为 Claude Haiku 4.5 的中转平台。它提供了最优的性价比(比官方便宜 40%)、最快的响应速度(平均 300ms)、最完善的技术支持(7×12 小时中文服务),并支持免费试用让你无风险验证服务质量。从注册到完成首次调用只需 10 分钟,是快速开始使用 Claude Haiku 4.5 的理想选择。

📝 作者简介: 资深 AI 应用开发者,专注大模型 API 集成与性能优化。定期分享 AI 开发实践经验和最佳实践,更多配置教程和技术资料可访问 API易 apiyi.com 技术社区。

🔔 技术交流: 欢迎在评论区讨论中转API配置和使用经验。如需技术支持或定制方案,可通过 API易 apiyi.com 联系技术团队获取专业帮助。