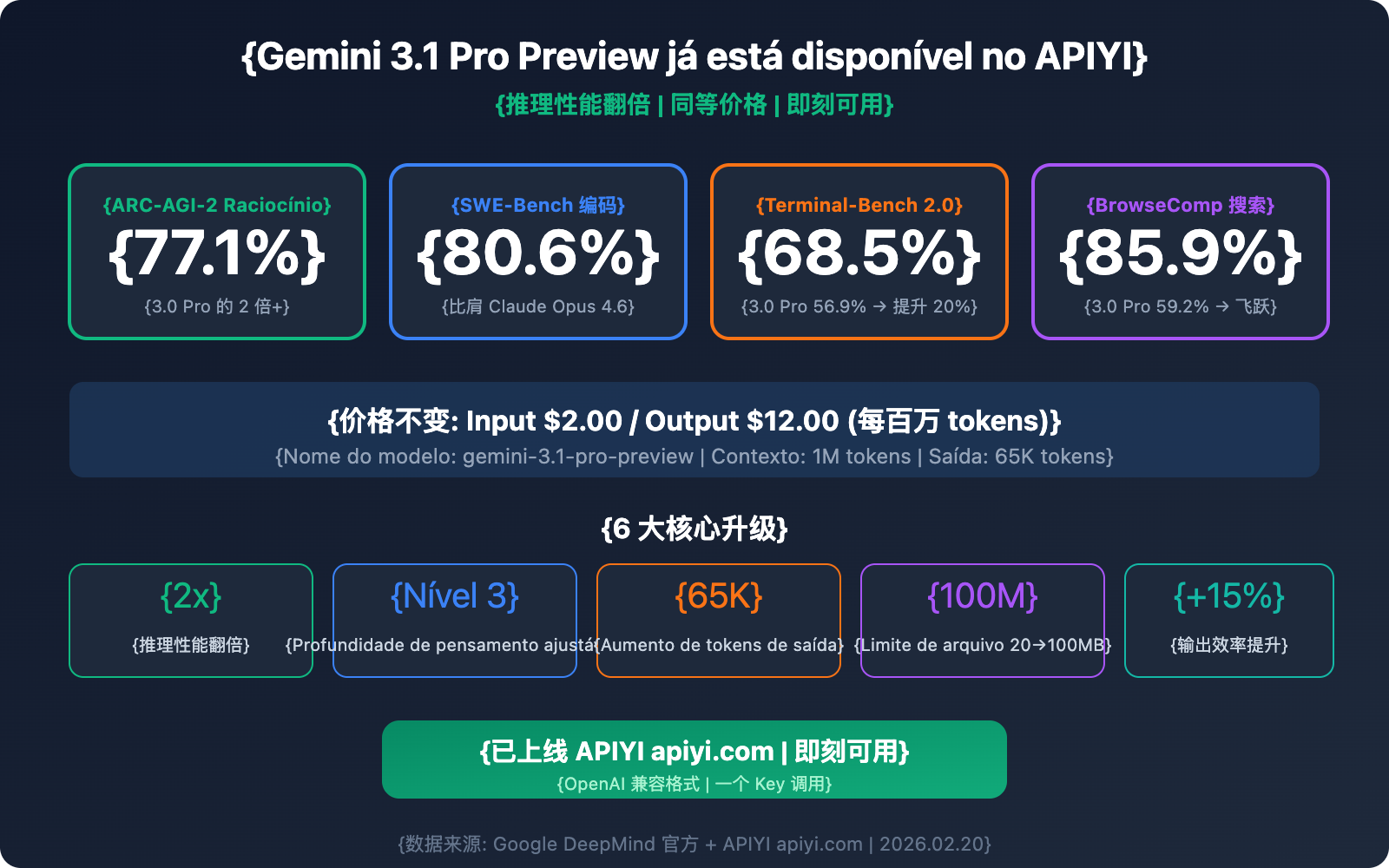

Ótimas notícias — o Gemini 3.1 Pro Preview já está disponível no APIYI e pode ser acessado agora mesmo via API. O nome do modelo é gemini-3.1-pro-preview, com preço de prompt de $2,00/1M de tokens e completamento de $12,00/1M de tokens, mantendo exatamente os mesmos valores do Gemini 3.0 Pro Preview.

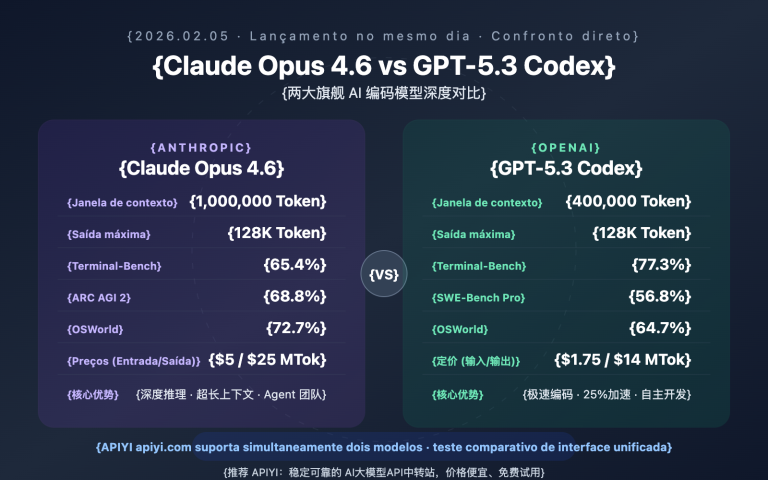

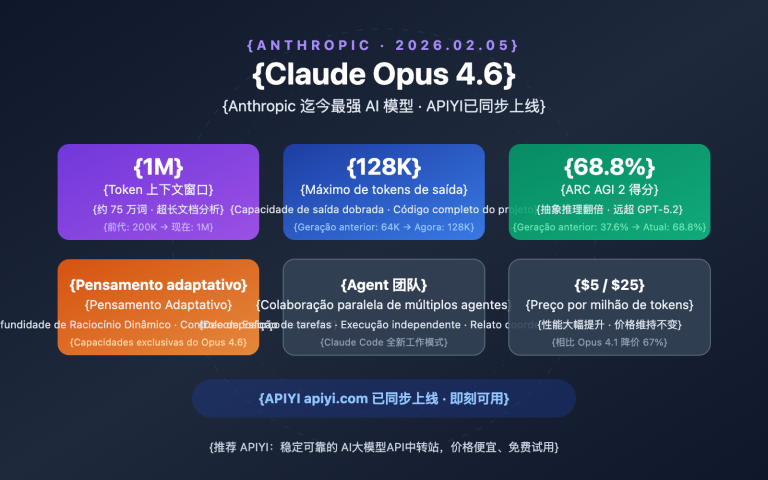

No entanto, o desempenho está em outro patamar: o Gemini 3.1 Pro atingiu 77,1% no benchmark de raciocínio ARC-AGI-2, mais que o dobro do 3.0 Pro; na pontuação de codificação SWE-Bench Verified, alcançou 80,6%, superando pela primeira vez os 80,9% do Claude Opus 4.6 e entrando em competição direta; a eficiência de saída melhorou em 15%, obtendo resultados mais confiáveis com menos tokens.

Valor principal: Este artigo detalhará as 6 principais atualizações do Gemini 3.1 Pro Preview, como chamá-lo via API, uma comparação detalhada com concorrentes e as melhores práticas para diferentes cenários.

Visão Geral dos Parâmetros do Gemini 3.1 Pro Preview

| Parâmetro | Detalhes |

|---|---|

| Nome do Modelo | gemini-3.1-pro-preview |

| Data de Lançamento | 19 de fevereiro de 2026 |

| Preço de Prompt (≤200K tokens) | $2,00 / milhão de tokens |

| Preço de Completamento (≤200K tokens) | $12,00 / milhão de tokens |

| Preço de Prompt (>200K tokens) | $4,00 / milhão de tokens |

| Preço de Completamento (>200K tokens) | $18,00 / milhão de tokens |

| Janela de Contexto | 1.000.000 tokens (1M) |

| Saída Máxima | 65.000 tokens (65K) |

| Limite de Upload de Arquivo | 100MB (antes 20MB) |

| Data de Corte do Conhecimento | Janeiro de 2025 |

| Status no APIYI | ✅ Já disponível |

🚀 Experimente agora: O Gemini 3.1 Pro Preview já está disponível no APIYI (apiyi.com). Ele pode ser chamado através do formato compatível com OpenAI, sem necessidade de registrar uma conta no Google, com integração concluída em apenas 5 minutos.

As 6 principais atualizações do Gemini 3.1 Pro Preview

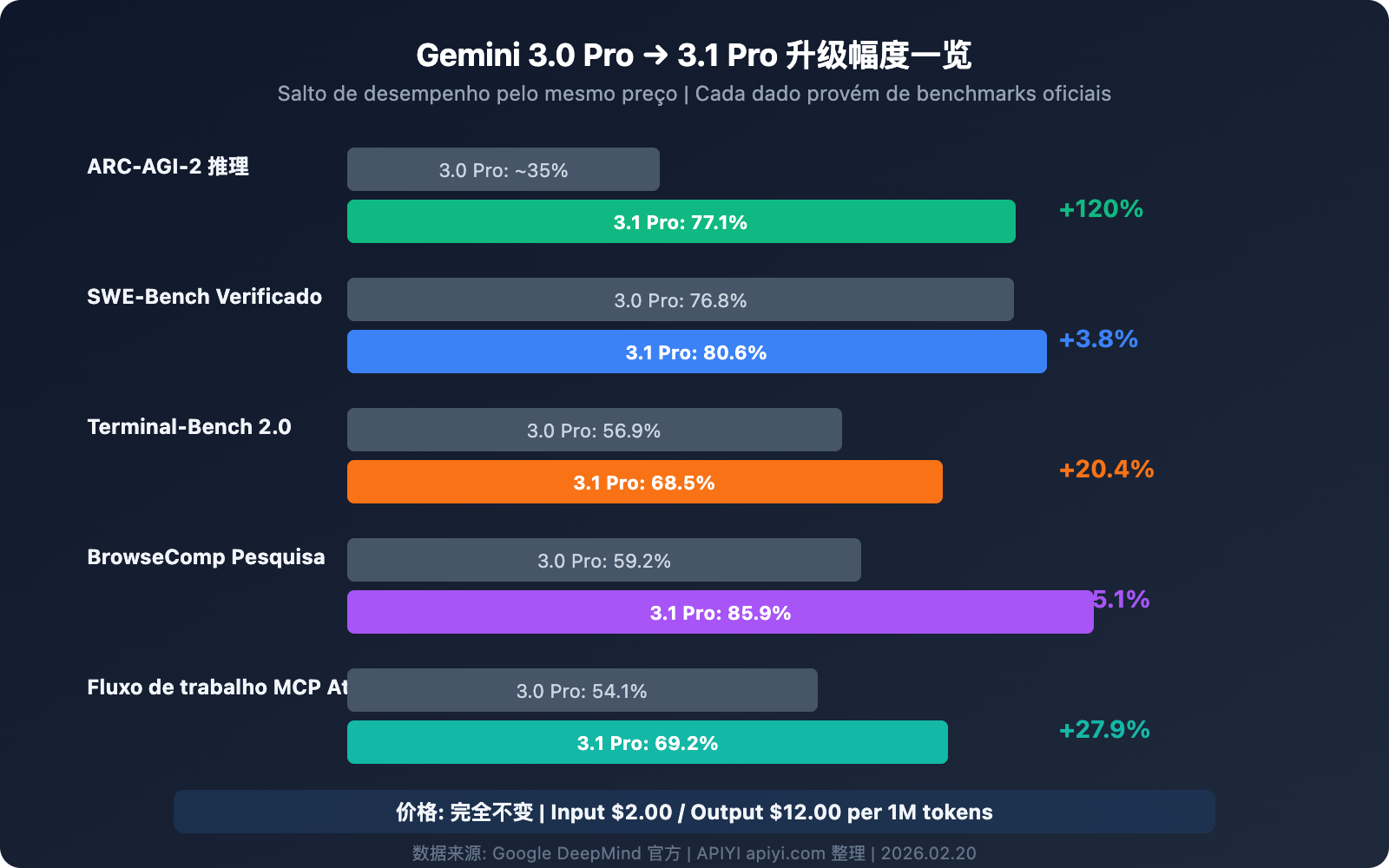

Atualização 1: Desempenho de raciocínio dobrado — ARC-AGI-2 atinge 77,1%

Esta é a atualização mais impressionante. No benchmark ARC-AGI-2 (que avalia a capacidade do modelo de resolver novos padrões lógicos), o Gemini 3.1 Pro atingiu 77,1%, o que é mais do que o dobro do Gemini 3.0 Pro.

Ao mesmo tempo, no benchmark MCP Atlas (que mede a capacidade de fluxos de trabalho multietapas usando o Model Context Protocol), o 3.1 Pro alcançou 69,2%, um aumento de 15 pontos percentuais em relação aos 54,1% do 3.0 Pro.

Isso significa que em cenários de raciocínio complexo, cadeias lógicas de várias etapas e fluxos de trabalho de Agentes, o Gemini 3.1 Pro deu um salto qualitativo.

Atualização 2: Sistema de três níveis de profundidade de pensamento — Deep Think Mini

O Gemini 3.1 Pro introduz um novo sistema de três níveis de profundidade de pensamento, permitindo que os desenvolvedores ajustem o "orçamento de raciocínio" de acordo com a complexidade da tarefa:

| Nível de pensamento | Características de comportamento | Cenários de uso | Impacto na latência |

|---|---|---|---|

| high | Versão mini similar ao Gemini Deep Think, raciocínio profundo | Provas matemáticas, depuração complexa, planejamento estratégico | Mais alta |

| medium | Equivalente ao nível "high" do 3.0 Pro | Revisão de código, análise técnica, design de arquitetura | Moderada |

| low | Resposta rápida, custo mínimo de raciocínio | Extração de dados, conversão de formato, perguntas e respostas simples | Mínima |

Ponto chave: o nível high do 3.1 Pro redefine o significado — agora ele é uma "versão mini" do Gemini Deep Think, com uma profundidade de raciocínio que supera em muito o "high" do 3.0 Pro. Já o medium do 3.1 é aproximadamente igual ao "high" do 3.0, o que significa que mesmo usando o nível médio, você obtém a qualidade de raciocínio que antes era o nível máximo.

Atualização 3: Capacidade de codificação entre as melhores — SWE-Bench 80,6%

O desempenho do Gemini 3.1 Pro na área de codificação é um verdadeiro salto:

| Benchmark de codificação | Gemini 3.0 Pro | Gemini 3.1 Pro | Aumento |

|---|---|---|---|

| SWE-Bench Verified | 76,8% | 80,6% | +3,8% |

| Terminal-Bench 2.0 | 56,9% | 68,5% | +11,6% |

| LiveCodeBench Pro | — | Elo 2887 | Novo benchmark |

O resultado de 80,6% no SWE-Bench Verified significa que o Gemini 3.1 Pro está praticamente empatado com o Claude Opus 4.6 (80,9%) em tarefas de engenharia de software, com uma diferença de apenas 0,3 ponto percentual.

O Terminal-Bench 2.0 avalia a capacidade de codificação em terminal para Agentes — o aumento de 56,9% para 68,5% mostra que a confiabilidade do 3.1 Pro em cenários Agentic foi significativamente reforçada.

Atualização 4: Melhoria total na capacidade de saída e eficiência

| Recurso | Gemini 3.0 Pro | Gemini 3.1 Pro | Melhoria |

|---|---|---|---|

| Máximo de tokens de saída | Desconhecido | 65.000 (65K) | Aumento significativo |

| Limite de upload de arquivos | 20MB | 100MB | 5 vezes |

| Suporte para URL do YouTube | ❌ | ✅ | Novo |

| Eficiência de saída | Base | +15% | Menos tokens, resultados mais confiáveis |

O limite de saída de 65K significa que o modelo pode gerar documentos longos completos, grandes blocos de código ou relatórios de análise detalhados de uma só vez, sem a necessidade de várias solicitações e colagens.

A expansão do upload de arquivos de 20MB para 100MB, combinada com o contexto de 1M de tokens, permite analisar diretamente grandes repositórios de código, vídeos longos ou volumes massivos de documentos.

A passagem direta de URL do YouTube é uma nova função muito prática — os desenvolvedores podem inserir links do YouTube diretamente no comando, e o modelo analisará automaticamente o conteúdo do vídeo, sem necessidade de download e upload manual.

Atualização 5: Endpoint dedicado customtools — Ferramenta poderosa para desenvolvimento de Agentes

O Google também lançou simultaneamente o endpoint dedicado gemini-3.1-pro-preview-customtools, uma versão profundamente otimizada para cenários de desenvolvimento de Agentes:

- Otimização da prioridade de chamada de ferramentas: Ajuste fino na prioridade de chamada de ferramentas comuns para desenvolvedores, como

view_fileesearch_code. - Mistura de Bash + funções personalizadas: Especialmente adequado para fluxos de trabalho de Agentes que precisam alternar entre comandos bash e funções personalizadas.

- Estabilidade em cenários Agentic: Maior confiabilidade em tarefas de Agentes multietapas em comparação com a versão genérica.

Isso significa que, se você estiver construindo assistentes de programação de IA, bots de revisão de código ou Agentes de automação de operações (AIOps), o endpoint customtools é a melhor escolha.

Atualização 6: Salto na capacidade de busca na web — BrowseComp 85,9%

O benchmark BrowseComp avalia a capacidade de busca na web de Agentes do modelo. O Gemini 3.1 Pro atingiu 85,9%, enquanto o 3.0 Pro marcou apenas 59,2% — um aumento de 26,7 pontos percentuais.

Essa capacidade é de grande importância para aplicações que exigem recuperação de informações em tempo real (como assistentes de pesquisa, análise competitiva e resumos de notícias).

💡 Insight Técnico: O Gemini 3.1 Pro também lançou o endpoint especializado

gemini-3.1-pro-preview-customtools, otimizado para desenvolvedores que misturam comandos bash e funções personalizadas, com ajuste fino na prioridade de ferramentas comoview_fileesearch_code. Você pode chamar este endpoint dedicado diretamente através do APIYI (apiyi.com).

Prática de chamada de API do Gemini 3.1 Pro Preview

Exemplo de chamada minimalista (Python)

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interface unificada APIYI

)

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "user", "content": "Analise a complexidade de tempo deste código e dê sugestões de otimização:\n\ndef two_sum(nums, target):\n for i in range(len(nums)):\n for j in range(i+1, len(nums)):\n if nums[i] + nums[j] == target:\n return [i, j]"}

]

)

print(response.choices[0].message.content)

Ver exemplo completo (incluindo controle de profundidade e multimodalidade)

import openai

import base64

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # Interface unificada APIYI

)

# Exemplo 1: Alta profundidade de raciocínio - Raciocínio matemático complexo

response_math = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": "Prove: Para todo inteiro positivo n, n^3 - n é necessariamente divisível por 6. Por favor, forneça uma prova matemática rigorosa."

}],

temperature=0.2,

max_tokens=4096

)

# Exemplo 2: Análise multimodal - Compreensão de imagem

with open("architecture.png", "rb") as f:

img_data = base64.b64encode(f.read()).decode()

response_vision = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "Analise detalhadamente este diagrama de arquitetura de sistema, aponte potenciais gargalos de desempenho e sugestões de melhoria"},

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{img_data}"}}

]

}],

max_tokens=8192

)

# Exemplo 3: Análise de código com contexto longo

with open("large_codebase.txt", "r") as f:

code_content = f.read() # Pode chegar a centenas de milhares de tokens

response_code = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "system", "content": "Você é um arquiteto de software sênior, por favor, analise cuidadosamente todo o repositório de código."},

{"role": "user", "content": f"Aqui está o repositório de código completo:\n\n{code_content}\n\nPor favor, analise:\n1. O design da arquitetura geral\n2. Bugs potenciais\n3. Sugestões de otimização de desempenho\n4. Plano de refatoração de código"}

],

max_tokens=16384 # Aproveitando a capacidade de saída de 65K

)

print(f"Raciocínio matemático: {response_math.choices[0].message.content[:200]}...")

print(f"Análise visual: {response_vision.choices[0].message.content[:200]}...")

print(f"Análise de código: {response_code.choices[0].message.content[:200]}...")

🎯 Dica de integração: Ao chamar o Gemini 3.1 Pro Preview através do APIYI (apiyi.com), você pode usar o SDK padrão da OpenAI, sem necessidade de instalar dependências extras. Projetos que já utilizam o formato OpenAI só precisam alterar os parâmetros

base_urlemodelpara fazer a troca.

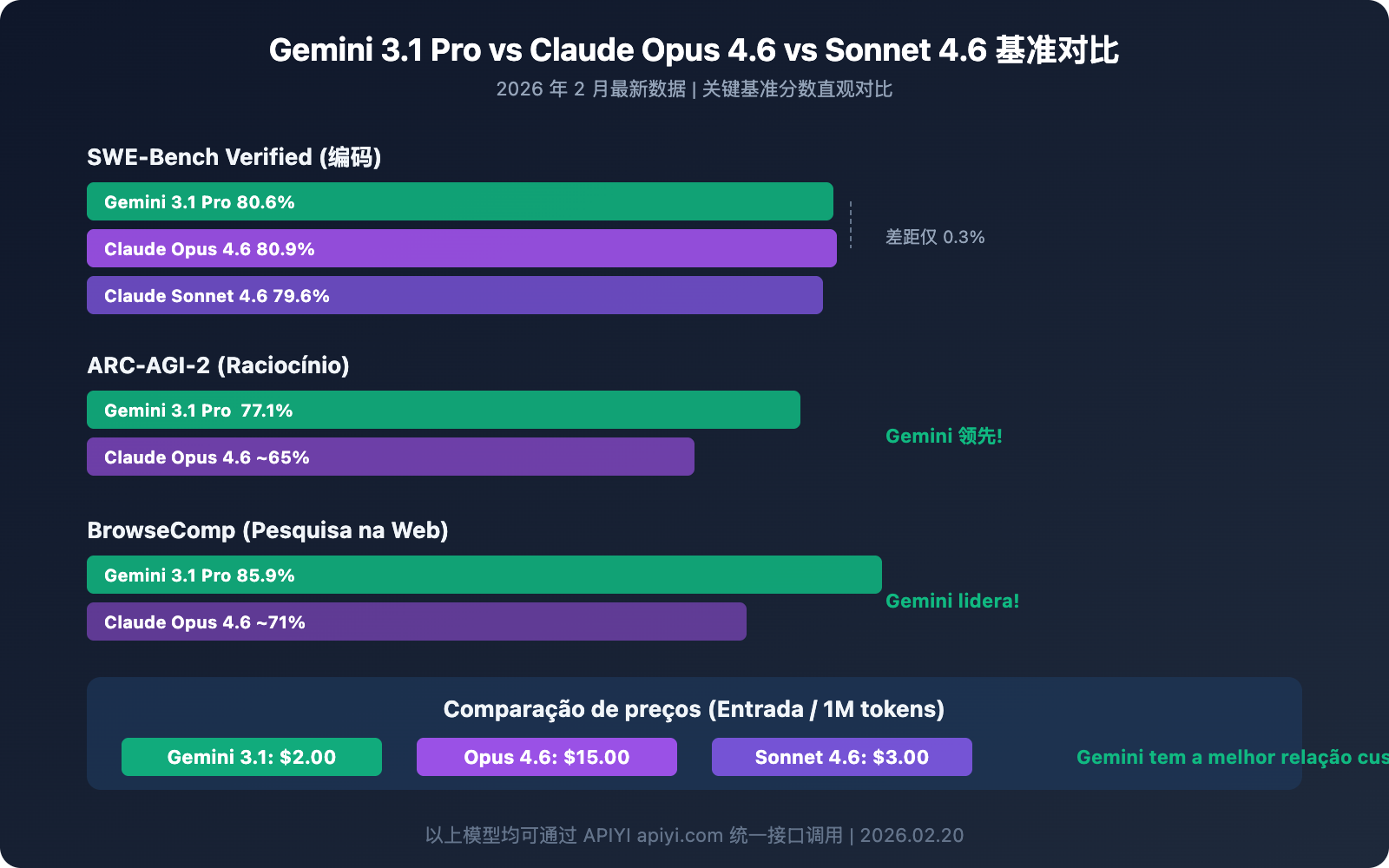

Gemini 3.1 Pro Preview vs. Concorrência: Comparativo Detalhado

Tabela Comparativa de Benchmarks Principais

| Benchmark | Gemini 3.1 Pro | Claude Opus 4.6 | Claude Sonnet 4.6 | Vencedor |

|---|---|---|---|---|

| SWE-Bench Verified | 80.6% | 80.9% | 79.6% | Claude Opus (mínimo) |

| ARC-AGI-2 | 77.1% | ~65% | — | Gemini 3.1 Pro |

| Terminal-Bench 2.0 | 68.5% | — | — | Gemini 3.1 Pro |

| BrowseComp | 85.9% | ~71% | — | Gemini 3.1 Pro |

| MCP Atlas | 69.2% | — | — | Gemini 3.1 Pro |

| Janela de Contexto | 1M tokens | 200K | 200K | Gemini 3.1 Pro |

| Saída Máxima | 65K | — | — | Gemini 3.1 Pro |

| Preço de Input | $2.00 | $15.00 | $3.00 | Gemini 3.1 Pro |

| Plataformas | APIYI apiyi.com etc. | APIYI apiyi.com etc. | APIYI apiyi.com etc. | — |

Sugestões de Uso para cada Modelo

| Cenário de Uso | Modelo Recomendado | Motivo Principal |

|---|---|---|

| Raciocínio Complexo e Matemática | Gemini 3.1 Pro Preview | ARC-AGI-2 77.1%, raciocínio dobrado |

| Análise de Documentos Longos/Código | Gemini 3.1 Pro Preview | Janela de 1M tokens, único no mercado |

| Programação Agêntica | Claude Opus 4.6 / Gemini 3.1 Pro | SWE-Bench quase idêntico |

| Workflows de Busca com Agentes | Gemini 3.1 Pro Preview | BrowseComp 85.9%, liderança absoluta |

| Codificação Diária de Média Complexidade | Claude Sonnet 4.6 | Ótimo custo-benefício, 79.6% em coding |

| Necessidades Flagship com Orçamento Limitado | Gemini 3.1 Pro Preview | $2/$12, o menor preço para um flagship |

| Análise Multimodal de Vídeo/Áudio | Gemini 3.1 Pro Preview | Multimodal nativo, suporte a URL do YouTube |

💰 Comparação de Custos: Com capacidades de nível flagship equivalentes, o preço de Input do Gemini 3.1 Pro ($2.00) é apenas 13% do valor do Claude Opus 4.6 ($15.00). Para cenários de raciocínio e multimodais, a vantagem de custo-benefício é gritante. Através da plataforma APIYI (apiyi.com), você pode alternar e testar rapidamente usando a mesma interface.

Melhores Práticas para o Gemini 3.1 Pro Preview

Use os Três Níveis de Profundidade de Pensamento

# Use 'high' para raciocínio complexo (Modo Deep Think Mini)

# Use 'medium' para tarefas diárias (equivalente ao antigo 'high')

# Use 'low' para tarefas simples (resposta mais rápida)

# Ao chamar via APIYI, passe o nível de pensamento pelo extra_body

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{"role": "user", "content": "Sua pergunta aqui"}],

extra_body={"thinking_level": "high"} # high/medium/low

)

Aproveite ao Máximo a Janela de Contexto de 1M Token

A janela de contexto de 1M de tokens do Gemini 3.1 Pro Preview é a maior entre todos os modelos flagship atuais. Aqui estão alguns cenários de alto valor:

Análise Global de Repositórios de Código: Envie dezenas de arquivos de uma só vez para que o modelo entenda a arquitetura completa antes de sugerir refatorações. Isso é muito mais eficaz para encontrar problemas de acoplamento entre módulos do que a análise arquivo por arquivo.

Compreensão Profunda de Documentos Longos: Contratos jurídicos, especificações técnicas, coletâneas de artigos acadêmicos — 1M de tokens pode conter um livro inteiro. Combinado com a profundidade de raciocínio aprimorada do 3.1 Pro, até conexões implícitas em documentos extensos podem ser identificadas.

Análise de Vídeos do YouTube (Novo Recurso): Passe a URL do YouTube diretamente no comando, sem precisar baixar e fazer upload do arquivo de vídeo. O modelo analisará o conteúdo automaticamente, ideal para auditoria de conteúdo, análise de concorrência e resumos de tutoriais.

Memória de Longo Prazo em Diálogos: Uma janela de 1M de tokens significa que o modelo pode "lembrar" de históricos de conversa extremamente longos, o que é uma vantagem óbvia em cenários de atendimento ao cliente, consultoria e ensino que exigem muito contexto.

Atenção ao Limite de 200K: Quando o input excede 200K tokens, o preço dobra de $2/$12 para $4/$18. Recomenda-se avaliar o número real de tokens ao usar contextos longos; para cenários entre 200K e 300K, considere enxugar o input para ficar abaixo de 200K e economizar metade do custo.

Como usar o endpoint customtools

Se você está construindo aplicações com Agentes, o endpoint gemini-3.1-pro-preview-customtools deve ser sua prioridade:

# Endpoint especializado para desenvolvimento de Agentes

response = client.chat.completions.create(

model="gemini-3.1-pro-preview-customtools", # Versão otimizada para Agentes

messages=[{"role": "user", "content": "Encontre todas as exceções não tratadas no projeto e sugira correções"}],

tools=[

{"type": "function", "function": {"name": "search_code", "description": "Pesquisar código"}},

{"type": "function", "function": {"name": "view_file", "description": "Visualizar arquivo"}},

]

)

Este endpoint supera a versão genérica na precisão e confiabilidade das chamadas de ferramentas, sendo especialmente adequado para cenários que misturam comandos bash com funções personalizadas.

Estratégias de Otimização de Custos

| Estratégia | Método | Economia Esperada |

|---|---|---|

| Alternar Nível de Pensamento | Use 'low' para tarefas simples e 'high' apenas para as complexas | 30-50% |

| Reduzir Requisições com Contexto Longo | Agrupe várias perguntas relacionadas em uma única requisição | 20-40% |

| Cuidado com o Limite de 200K | O preço dobra após 200K; controle o comprimento do input | Evita sobretaxa de 2x |

| Controle de Tokens de Saída | Defina um max_tokens razoável para evitar saídas redundantes | 10-20% |

| Escolha o Modelo Gemini Adequado | Use o Flash para tarefas simples e o 3.1 Pro apenas para as complexas | 60-80% |

Passos para Migrar do Gemini 3.0 Pro para o 3.1 Pro

O processo de migração é extremamente simples:

Passo 1: Altere o parâmetro model

# Versão antiga

model="gemini-3-pro-preview"

# Versão nova

model="gemini-3.1-pro-preview"

Passo 2: Teste as funções principais — execute alguns casos típicos do seu cenário de uso principal para confirmar se a qualidade da saída atende às expectativas.

Passo 3: Explore novas capacidades — experimente o raciocínio profundo com o nível 'high', upload de arquivos de 100MB, análise de URLs do YouTube e outras novidades do 3.1.

Passo 4: Otimize custos — configure o nível de pensamento adequado para diferentes tarefas; usar 'medium' em vez de 'high' para tarefas rotineiras pode reduzir a latência e o consumo de tokens mantendo a qualidade.

🎯 Dica de Migração: Na plataforma APIYI (apiyi.com), a migração requer apenas a mudança de um parâmetro. Sugerimos manter a chamada ao modelo antigo como fallback inicialmente e fazer a transição total após confirmar a estabilidade do 3.1.

Perguntas Frequentes

Q1: A forma de chamar o Gemini 3.1 Pro Preview na APIYI é a mesma dos modelos Gemini anteriores?

Exatamente a mesma. Na plataforma APIYI (apiyi.com), o Gemini 3.1 Pro Preview utiliza o formato padrão compatível com OpenAI. Basta preencher o parâmetro model com gemini-3.1-pro-preview. Se você já está usando o Gemini 3.0 Pro, só precisa alterar o nome do modelo; o restante do código não precisa de nenhuma mudança.

Q2: O preço do 3.1 Pro e do 3.0 Pro é o mesmo. Vale a pena mudar?

Recomendamos fortemente a mudança. O preço é idêntico ($2/$12), mas a capacidade de raciocínio dobrou, a performance em codificação subiu de 76,8% para 80,6% e a eficiência de saída melhorou em 15%. É um upgrade totalmente gratuito, não há motivo para não mudar. Pela APIYI (apiyi.com), basta alterar um parâmetro para concluir a transição.

Q3: Como escolher entre os três níveis de profundidade de pensamento? Isso afeta o preço?

A profundidade de pensamento afeta principalmente a latência e o consumo de tokens. O nível high (alto) oferece um raciocínio mais profundo, mas consome mais tokens de saída e tempo. O nível low (baixo) é o mais rápido, porém com raciocínio mais superficial. Sugerimos usar o medium (médio) para o dia a dia (equivalente à qualidade do antigo high) e reservar o high apenas para cenários de raciocínio complexo. O preço é cobrado pelo consumo real de tokens; o nível de pensamento em si não tem custo adicional.

Q4: Gemini 3.1 Pro Preview ou Claude Opus 4.6: qual escolher?

Depende do cenário e do orçamento: se você precisa de um contexto ultra longo (1M vs 200K), análise multimodal (vídeo/YouTube) ou é sensível ao preço ($2 vs $15), escolha o Gemini 3.1 Pro. Se você busca o máximo em codificação (80,9% vs 80,6%) e um ecossistema de Agents mais maduro, vá de Claude Opus 4.6. Ambos podem ser chamados pela mesma interface na APIYI (apiyi.com), facilitando os testes A/B.

Guia de Seleção da Família de Modelos Gemini 3

A série Gemini 3 conta atualmente com vários modelos disponíveis, e cada cenário exige uma versão diferente:

| Modelo | Posicionamento | Principais Vantagens | Cenários de Uso | Preço na APIYI |

|---|---|---|---|---|

| gemini-3.1-pro-preview | Raciocínio Flagship (NOVO) | Raciocínio dobrado, codificação de ponta | Raciocínio complexo, geração de código, Agents | $2/$12 |

| gemini-3-pro-preview | Flagship Geral | Programação Agentic, multimodal | Tarefas gerais (recomenda-se atualizar para o 3.1) | $2/$12 |

| gemini-3-flash-preview | Veloz e Leve | Resposta ultrarrápida, custo mínimo | Chat em tempo real, processamento em lote, chamadas de alta frequência | Ainda mais baixo |

| gemini-3-pro-image-preview | Geração de Imagens | IA de texto para imagem, edição de imagem | Design criativo, produção de conteúdo | Cobrança por imagem |

Árvore de Decisão:

- Precisa do melhor raciocínio e codificação? →

gemini-3.1-pro-preview - Precisa de velocidade máxima e menor custo? →

gemini-3-flash-preview - Precisa gerar imagens? →

gemini-3-pro-image-preview - Já usa o 3.0 Pro? → Atualize direto para o

gemini-3.1-pro-preview

Em quais cenários o Gemini 3.1 Pro Preview NÃO é o ideal?

Embora o 3.1 Pro se destaque na maioria das situações, os seguintes casos podem ter opções melhores:

- Necessidade de precisão extrema em codificação: O 80,9% do Claude Opus 4.6 no SWE-Bench ainda é ligeiramente superior aos 80,6% do 3.1 Pro. A diferença é pequena, mas pode ser relevante em requisitos de precisão extrema.

- Aplicações em tempo real que exigem latência baixíssima: O modo de pensamento

highdo 3.1 Pro tem uma latência elevada. Nesses casos, o Gemini 3 Flash ou o Claude Sonnet 4.6 são escolhas melhores. - Necessidade de garantia de SLA estável: Modelos Preview não oferecem compromissos formais de SLA. Ambientes de produção com exigências altíssimas de disponibilidade devem avaliar os riscos.

- Uso excessivo para tarefas simples: Se a complexidade da tarefa for baixa, usar o 3.1 Pro pode ser um desperdício de recursos. A série Flash é mais vantajosa financeiramente.

Resumo das Vantagens Competitivas do Gemini 3.1 Pro Preview

No cenário dos modelos de IA de fevereiro de 2026, as vantagens competitivas centrais do Gemini 3.1 Pro Preview podem ser resumidas em 3 "mais":

- Maior Contexto: 1M de tokens, o que é 5 vezes mais que o Claude Opus 4.6 (200K).

- Menor Preço Flagship: Entrada a $2.00, apenas 13% do valor do Claude Opus 4.6 ($15.00).

- Maior Salto em Raciocínio: Dobrou a pontuação no ARC-AGI-2 para 77,1%, liderando a dimensão de raciocínio entre os concorrentes.

As desvantagens relativas ficam por conta de cenários de codificação pura (80,6% vs 80,9% do Claude Opus, uma diferença mínima) e na maturidade do ecossistema de Agents.

💡 Sugestão Geral: Para a maioria dos desenvolvedores, o custo-benefício do Gemini 3.1 Pro Preview é o melhor entre os modelos flagship atuais. Através da APIYI (apiyi.com), você pode realizar testes comparativos entre Gemini, Claude, GPT e todos os outros modelos principais em uma única plataforma, encontrando a melhor escolha para o seu caso específico.

Resumo: Upgrade com o dobro de capacidade pelo mesmo preço, vale a pena mudar para o Gemini 3.1 Pro Preview agora mesmo

O Gemini 3.1 Pro Preview é uma atualização importante com preço mantido e capacidade dobrada:

- Raciocínio dobrado: ARC-AGI-2 saltou de ~35% para 77,1%, mais de 2 vezes o desempenho do 3.0.

- Codificação no nível dos melhores: SWE-Bench de 80,6%, apenas 0,3% de diferença em relação ao Claude Opus 4.6.

- Salto nas capacidades de Agente: Terminal-Bench +20%, BrowseComp +45%, MCP Atlas +28%.

- Melhoria total na eficiência: Saída de 65K tokens, limite de arquivo de 100MB, eficiência +15%.

- Sistema de pensamento em três níveis: O modo "high" equivale ao Deep Think Mini, permitindo ajustar o orçamento de raciocínio conforme a necessidade.

Experimente agora o Gemini 3.1 Pro Preview através da APIYI (apiyi.com) — interface unificada, disponível imediatamente. Basta alterar o parâmetro model para gemini-3.1-pro-preview para concluir o upgrade.

Referências

-

Blog oficial do Google: Anúncio de lançamento do Gemini 3.1 Pro

- Link:

blog.google/innovation-and-ai/models-and-research/gemini-models/gemini-3-1-pro - Descrição: Introdução oficial de recursos e resultados de benchmarks.

- Link:

-

Model Card do Google DeepMind: Detalhes técnicos do Gemini 3.1 Pro

- Link:

deepmind.google/models/model-cards/gemini-3-1-pro - Descrição: Avaliações de segurança e parâmetros detalhados.

- Link:

-

Documentação oficial da API do Gemini: Lista de modelos e métodos de chamada

- Link:

ai.google.dev/gemini-api/docs/models/gemini-3.1-pro-preview - Descrição: Parâmetros da API, preços e guia de uso.

- Link:

-

Reportagem da VentureBeat: Primeiras impressões do Gemini 3.1 Pro

- Link:

venturebeat.com/technology/google-gemini-3-1-pro-first-impressions - Descrição: Recursos do Deep Think Mini e experiência real.

- Link:

-

Análise do MarkTechPost: Interpretação técnica do Gemini 3.1 Pro

- Link:

marktechpost.com/2026/02/19/google-ai-releases-gemini-3-1-pro - Descrição: Dados de testes de benchmark e impacto no setor.

- Link:

📝 Autor: Equipe APIYI | Para troca de conhecimentos técnicos, visite APIYI (apiyi.com)

📅 Data de atualização: 20 de fevereiro de 2026

🏷️ Palavras-chave: Gemini 3.1 Pro Preview API, Lançamento na APIYI, Raciocínio dobrado, SWE-Bench 80.6%, ARC-AGI-2 77.1%