Nano Banana Pro 出图慢是开发者经常反馈的问题。客户问"为什么生成时间有时 20 秒,有时要 50 多秒?是随机的吗?"——答案是: 出图时间由分辨率、思考级别和网络传输三大因素共同决定。本文将分享 6 个经过实战验证的优化技巧,帮你将 Nano Banana Pro 的 2K 图像生成时间稳定控制在 50 秒内。

核心价值: 读完本文,你将掌握 Nano Banana Pro 出图速度优化的完整方法论,能够根据业务场景灵活调整参数,在质量和速度之间取得最佳平衡。

Nano Banana Pro 出图速度核心影响因素

在优化之前,需要先理解影响 Nano Banana Pro 生成速度的核心因素。根据实测数据,总耗时可分解为三个阶段:

| 阶段 | 耗时占比 | 主要影响因素 | 可优化空间 |

|---|---|---|---|

| API 接口处理 | 60-70% | 分辨率、思考级别、模型负载 | 高 |

| 图像传输下载 | 20-30% | 带宽、base64 数据量、地理位置 | 中 |

| 请求建立 | 5-10% | 连接复用、TLS 握手 | 中 |

Nano Banana Pro 出图时间实测数据

基于 API易平台 imagen.apiyi.com 的测速数据:

| 分辨率 | 思考级别 | 平均耗时 | P95 耗时 | 推荐场景 |

|---|---|---|---|---|

| 1K | low | 15-20s | 25s | 预览、批量生成 |

| 2K | low | 30-40s | 50s | 常规生产、Web 展示 |

| 2K | high | 45-60s | 75s | 复杂构图、精细文本 |

| 4K | low | 50-70s | 90s | 印刷、高端设计 |

| 4K | high | 80-120s | 150s | 专业级输出 |

🎯 关键结论: 2K 分辨率 + low 思考级别是性价比最高的组合,50 秒出一张 2K 图绝对稳定。如果你的业务场景不需要 4K,强烈建议使用 2K。

Nano Banana Pro 速度优化技巧一: 选择合适的分辨率

分辨率是影响 Nano Banana Pro 生成速度最直接的因素。从技术原理看:

- 4K 图像 (4096×4096): 约 1600 万像素,需要约 2000 个输出 token

- 2K 图像 (2048×2048): 约 400 万像素,需要约 1120 个输出 token

- 1K 图像 (1024×1024): 约 100 万像素,需要约 560 个输出 token

Nano Banana Pro 分辨率与速度对照表

| 分辨率 | 像素数 | Token 消耗 | 相对速度 | 适用场景 |

|---|---|---|---|---|

| 1K | 1M | ~560 | 基准 (1x) | 预览、快速迭代 |

| 2K | 4M | ~1120 | 约 1.8x | 常规生产 |

| 4K | 16M | ~2000 | 约 3.5x | 印刷级品质 |

分辨率选择建议

# Nano Banana Pro 分辨率选择示例

def choose_resolution(use_case: str) -> str:

"""根据使用场景选择最优分辨率"""

resolution_map = {

"preview": "1024x1024", # 快速预览,最快

"web_display": "2048x2048", # Web 展示,平衡

"social_media": "2048x2048", # 社交媒体,2K 足够

"print_design": "4096x4096", # 印刷设计,需要 4K

"batch_process": "1024x1024" # 批量处理,速度优先

}

return resolution_map.get(use_case, "2048x2048")

💡 优化建议: 大多数 Web 应用场景,2K 分辨率已经绰绰有余。只有印刷或超大屏展示才需要 4K。选择 2K 可以节省约 45% 的生成时间,且价格完全相同 ($0.134/张官方价,$0.05/张 API易平台价)。

Nano Banana Pro 速度优化技巧二: 调整思考级别参数

Nano Banana Pro 内置了基于 Gemini 3 Pro 的"思考"(Thinking) 机制。对于简单的提示词,这个推理过程会增加不必要的延迟。

Nano Banana Pro thinking_level 参数详解

| 思考级别 | 推理深度 | 额外耗时 | 适用场景 |

|---|---|---|---|

| low | 基础推理 | +0s | 简单提示词、明确指令 |

| medium | 标准推理 | +5-10s | 常规创意生成 |

| high | 深度推理 | +15-25s | 复杂构图、精确文本渲染 |

代码示例: 设置思考级别

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # 使用 API易 统一接口

)

# 简单场景: 使用 low 思考级别

response = client.images.generate(

model="nano-banana-pro",

prompt="一只橙色的猫坐在窗台上",

size="2048x2048",

extra_body={

"thinking_level": "low" # 简单提示词,低思考级别

}

)

# 复杂场景: 使用 high 思考级别

response = client.images.generate(

model="nano-banana-pro",

prompt="一张专业的产品信息图,包含标题'2025新品发布'、三个产品特性、价格标签$99.99,采用科技蓝配色",

size="2048x2048",

extra_body={

"thinking_level": "high" # 复杂文本渲染,需要高思考级别

}

)

🚀 实战技巧: 对于"一只猫"、"一片森林"这类简单场景,将 thinking_level 设为 low 可节省 20-30% 的生成时间。只有涉及精确文本渲染、复杂空间关系时才需要 high。

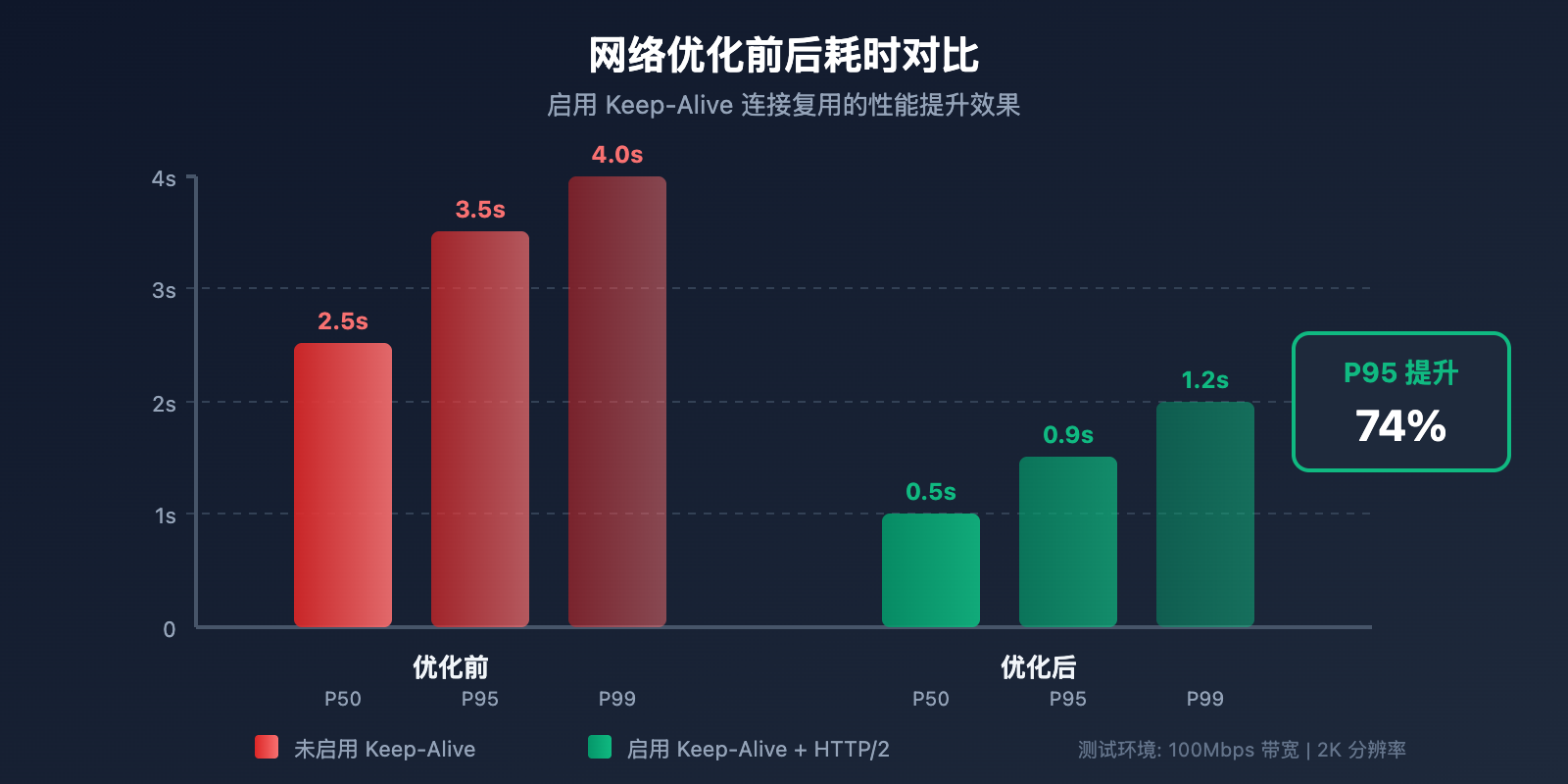

Nano Banana Pro 速度优化技巧三: 网络传输优化

很多开发者忽略了一个事实: API 接口返回速度快,不代表总耗时短。实测数据显示,网络传输可能占据总耗时的 20-30%。

Nano Banana Pro 网络耗时分解

以 2K 图像为例,一张 base64 编码的 2K PNG 图像约 4-6MB:

| 环节 | 数据量 | 10Mbps 带宽 | 100Mbps 带宽 | 1Gbps 带宽 |

|---|---|---|---|---|

| 请求上传 | ~1KB | <0.1s | <0.1s | <0.1s |

| 响应下载 | ~5MB | 4s | 0.4s | 0.04s |

| TLS 握手 | – | 0.1-0.3s | 0.1-0.3s | 0.1-0.3s |

网络优化实践

import httpx

import time

# 优化1: 启用连接复用 (Keep-Alive)

# 某团队通过启用 Keep-Alive 将 P95 延迟从 3.5s 降到 0.9s

client = httpx.Client(

base_url="https://api.apiyi.com/v1",

http2=True, # 启用 HTTP/2

timeout=60.0,

limits=httpx.Limits(

max_keepalive_connections=10, # 保持连接池

keepalive_expiry=30.0 # 连接存活时间

)

)

# 优化2: 添加详细的耗时日志

def generate_with_timing(prompt: str, size: str = "2048x2048"):

"""带耗时统计的图像生成"""

timings = {}

start = time.time()

# 发送请求

response = client.post(

"/images/generations",

json={

"model": "nano-banana-pro",

"prompt": prompt,

"size": size,

"response_format": "b64_json"

},

headers={"Authorization": f"Bearer {api_key}"}

)

timings["api_total"] = time.time() - start

# 解析响应

parse_start = time.time()

result = response.json()

timings["parse_time"] = time.time() - parse_start

print(f"API 耗时: {timings['api_total']:.2f}s")

print(f"解析耗时: {timings['parse_time']:.2f}s")

return result

📊 实测数据: 在 API易平台 imagen.apiyi.com 测速显示,国内用户通过优化节点访问,2K 图像 API 响应时间约 20-30 秒,加上下载时间,总耗时可稳定在 50 秒以内。

Nano Banana Pro 速度优化技巧四: 使用网格生成批量出图

如果你需要快速探索创意方向或生成多个变体,网格生成是一个被低估的加速技巧。

网格生成 vs 单图生成对比

| 生成方式 | 生成 4 张图耗时 | 单张成本 | 适用场景 |

|---|---|---|---|

| 单图×4 | 4×30s = 120s | $0.05 | 需要独立控制每张 |

| 2×2 网格 | 约 40s | ~$0.034 | 快速探索、创意迭代 |

网格生成代码示例

# 使用网格生成快速产出多个变体

response = client.images.generate(

model="nano-banana-pro",

prompt="现代简约风格的客厅设计",

size="2048x2048",

extra_body={

"grid": "2x2", # 生成 2x2 网格

"thinking_level": "low" # 探索阶段用低思考级别

}

)

# 约 40 秒产出 4 张不同变体,单张约 $0.034

🎯 使用建议: 创意探索阶段使用网格生成快速迭代,确定方向后再用单图高质量生成。通过 API易 apiyi.com 平台调用时,网格生成同样支持且计费方式更灵活。

Nano Banana Pro 速度优化技巧五: 合理设置超时和重试

生产环境中,合理的超时和重试策略能避免因偶发延迟导致的请求失败。

推荐的超时配置

| 分辨率 | 推荐超时 | 重试次数 | 重试间隔 |

|---|---|---|---|

| 1K | 45s | 2 | 5s |

| 2K | 90s | 2 | 10s |

| 4K | 180s | 3 | 15s |

生产环境代码示例

import openai

from tenacity import retry, stop_after_attempt, wait_exponential

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1", # API易 统一接口

timeout=90.0 # 2K 图像推荐 90 秒超时

)

@retry(

stop=stop_after_attempt(3),

wait=wait_exponential(multiplier=1, min=5, max=30)

)

def generate_image_with_retry(prompt: str, size: str = "2048x2048"):

"""带指数退避重试的图像生成"""

return client.images.generate(

model="nano-banana-pro",

prompt=prompt,

size=size,

extra_body={"thinking_level": "low"}

)

# 使用

try:

result = generate_image_with_retry("一片金色的麦田,夕阳西下")

print("生成成功!")

except Exception as e:

print(f"生成失败: {e}")

Nano Banana Pro 速度优化技巧六: 选择合适的 API 服务商

不同 API 服务商的基础设施差异会直接影响响应速度。

Nano Banana Pro API 服务商对比

| 服务商 | 国内访问延迟 | 2K 生成速度 | 单价 | 特点 |

|---|---|---|---|---|

| Google 官方 | 3-8s 额外延迟 | 30-50s | $0.134 | 需海外信用卡 |

| API易 | 优化节点 | 30-40s | $0.05 | 支持支付宝/微信 |

| 其他中转 | 不稳定 | 40-60s | $0.08-0.15 | 质量参差不齐 |

💰 成本优化: 通过 API易 apiyi.com 调用 Nano Banana Pro,单价仅 $0.05/张,相比官方 $0.134 节省约 63%。同时国内访问延迟更低,综合体验更佳。大客户充值还有额外加赠,最低可达 $0.04/张。

完整的优化配置示例

点击展开完整代码

"""

Nano Banana Pro 速度优化完整示例

通过 API易平台调用,集成所有优化技巧

"""

import openai

import time

import base64

from pathlib import Path

from tenacity import retry, stop_after_attempt, wait_exponential

class NanoBananaProClient:

"""优化后的 Nano Banana Pro 客户端"""

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1", # API易 统一接口

timeout=90.0,

max_retries=0 # 使用自定义重试逻辑

)

def choose_params(self, use_case: str, quality: str = "balanced"):

"""根据场景智能选择参数"""

configs = {

"preview": {

"size": "1024x1024",

"thinking_level": "low"

},

"production": {

"size": "2048x2048",

"thinking_level": "low" if quality == "fast" else "medium"

},

"premium": {

"size": "4096x4096",

"thinking_level": "high"

}

}

return configs.get(use_case, configs["production"])

@retry(

stop=stop_after_attempt(3),

wait=wait_exponential(multiplier=1, min=5, max=30)

)

def generate(

self,

prompt: str,

use_case: str = "production",

quality: str = "balanced"

) -> dict:

"""生成图像,带自动参数优化"""

params = self.choose_params(use_case, quality)

start_time = time.time()

response = self.client.images.generate(

model="nano-banana-pro",

prompt=prompt,

size=params["size"],

response_format="b64_json",

extra_body={

"thinking_level": params["thinking_level"]

}

)

elapsed = time.time() - start_time

return {

"image_data": response.data[0].b64_json,

"elapsed_seconds": elapsed,

"size": params["size"],

"thinking_level": params["thinking_level"]

}

def generate_batch(

self,

prompts: list[str],

use_case: str = "preview"

) -> list[dict]:

"""批量生成,自动使用低配置加速"""

results = []

for prompt in prompts:

result = self.generate(prompt, use_case=use_case, quality="fast")

results.append(result)

return results

def save_image(self, b64_data: str, output_path: str):

"""保存 base64 图像到文件"""

image_bytes = base64.b64decode(b64_data)

Path(output_path).write_bytes(image_bytes)

# 使用示例

if __name__ == "__main__":

client = NanoBananaProClient(api_key="your-api-key")

# 场景1: 快速预览

preview = client.generate(

prompt="一只橙色的猫",

use_case="preview"

)

print(f"预览生成耗时: {preview['elapsed_seconds']:.2f}s")

# 场景2: 生产环境

production = client.generate(

prompt="专业的电商产品展示图,白色背景,侧面 45 度角",

use_case="production"

)

print(f"生产生成耗时: {production['elapsed_seconds']:.2f}s")

# 场景3: 高端设计

premium = client.generate(

prompt="4K 超高清,现代简约客厅,大落地窗,阳光洒落",

use_case="premium"

)

print(f"高端生成耗时: {premium['elapsed_seconds']:.2f}s")

Nano Banana Pro 速度优化常见问题

Q1: 为什么同样的提示词,每次生成时间都不一样?

Nano Banana Pro 的生成时间受多因素影响:

- 模型负载波动: 高峰期 (如美国工作时间) 服务器负载更高,响应时间会增加 10-30%

- 提示词复杂度: 即使是相似的提示词,模型内部推理路径也可能不同

- 网络状况: 跨境传输存在波动

优化建议: 通过 API易 apiyi.com 平台调用,其优化节点可以部分缓解网络波动问题。同时建议错峰调用 (避开北京时间 21:00-02:00 的美国高峰期)。

Q2: 2K 和 4K 价格一样,为什么不直接用 4K?

价格相同不代表效率相同:

| 维度 | 2K | 4K | 差异 |

|---|---|---|---|

| 生成时间 | 30-40s | 50-70s | 4K 慢约 60% |

| 数据传输 | ~3MB | ~10MB | 4K 传输量大 |

| 存储成本 | 基准 | 约 3.3x | 长期存储成本高 |

结论: 除非业务明确需要 4K (如印刷品、超大屏展示),否则 2K 是更明智的选择。通过 API易平台批量调用时,2K 的效率优势会进一步放大。

Q3: 如何判断耗时瓶颈在 API 还是网络?

添加详细的耗时日志是诊断的关键:

import time

# 记录请求发起时间

t1 = time.time()

response = client.images.generate(...)

t2 = time.time()

# 记录数据解析时间

data = response.data[0].b64_json

t3 = time.time()

print(f"API 响应耗时: {t2-t1:.2f}s")

print(f"数据解析耗时: {t3-t2:.2f}s")

如果 API 响应快但总耗时长,说明瓶颈在网络传输。可以通过 imagen.apiyi.com 在线测速工具验证 API 侧性能。

Q4: 批量生成时如何最大化吞吐量?

批量生成的优化策略:

- 并发请求: 根据 API 限流策略,合理设置并发数 (通常 5-10 并发)

- 使用网格生成: 2×2 网格一次产出 4 张,效率提升约 3 倍

- 降低配置: 批量场景优先使用 1K + low thinking

- 异步处理: 使用 asyncio 或线程池并行处理

通过 API易平台调用时,支持更高的并发限额,适合大批量生成需求。

Nano Banana Pro 速度优化总结

本文介绍了 6 个 Nano Banana Pro 出图速度优化技巧:

| 技巧 | 优化效果 | 实施难度 | 推荐优先级 |

|---|---|---|---|

| 选择 2K 分辨率 | 节省 45% 时间 | 低 | ⭐⭐⭐⭐⭐ |

| 调整思考级别 | 节省 20-30% | 低 | ⭐⭐⭐⭐⭐ |

| 网络传输优化 | 节省 10-20% | 中 | ⭐⭐⭐⭐ |

| 网格批量生成 | 效率提升 3x | 低 | ⭐⭐⭐⭐ |

| 超时重试策略 | 提升稳定性 | 中 | ⭐⭐⭐ |

| 选择优质服务商 | 综合提升 | 低 | ⭐⭐⭐⭐⭐ |

核心结论: 2K 分辨率 + low 思考级别 + 连接复用,50 秒出一张 2K 图完全可以稳定达成。

🎯 最终建议: 推荐通过 API易 apiyi.com 快速验证优化效果。该平台提供在线测速工具 imagen.apiyi.com,方便实时监控各环节耗时。同时 $0.05/张的价格 (官方 $0.134 的 37%) 能有效控制调试成本。

本文由 API易技术团队撰写。如需了解更多 AI 图像生成 API 的使用技巧,欢迎访问 apiyi.com 获取技术支持。