"Hola, tengo una cuenta en Google AI Studio, pero me aparece que el cupo gratuito se ha agotado. Quiero seguir usando AI Studio para crear modelos, pero mi cuenta gratuita no se recarga. ¿Cómo puedo recargar mi cuenta de Google o qué otras formas hay para seguir usándolo?"

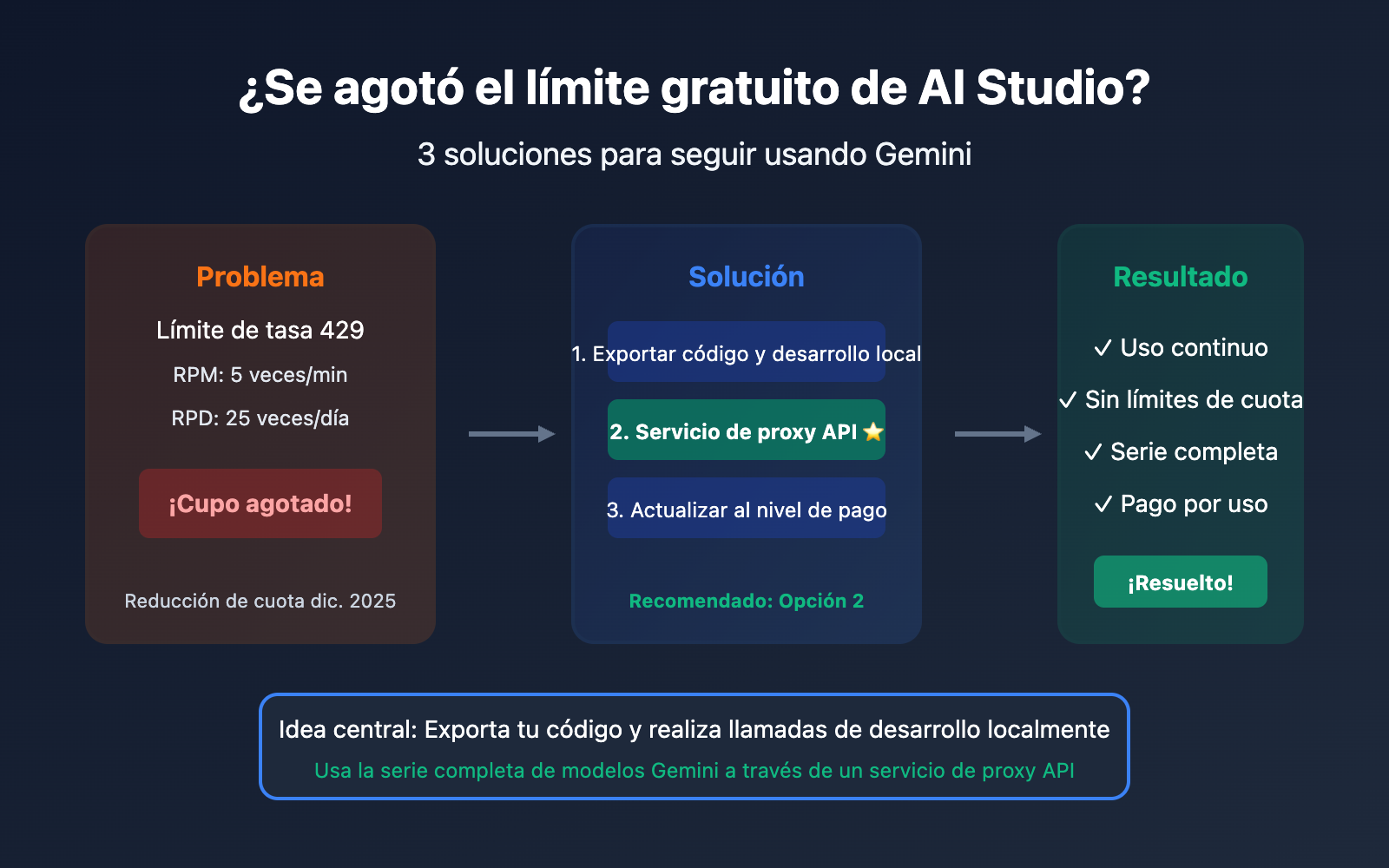

Esta es una consulta que recibimos a diario. El cupo gratuito de Google AI Studio es limitado y, en diciembre de 2025, Google redujo drásticamente las cuotas del nivel gratuito.

La buena noticia es: no necesitas recargar tu cuenta de Google para seguir usando la serie completa de modelos Gemini.

La idea central es simple: exporta tu código y realiza las llamadas de desarrollo de forma local.

En este artículo, detallaremos 3 soluciones para ayudarte a seguir usando Gemini después de que se agote tu cupo gratuito.

Entendiendo las limitaciones de cuota de AI Studio

Cuotas actuales del nivel gratuito (2026)

El 7 de diciembre de 2025, Google realizó ajustes importantes en las cuotas de la API para desarrolladores de Gemini, lo que provocó que muchas aplicaciones empezaran a mostrar errores 429 de repente:

| Modelo | RPM nivel gratuito | RPD nivel gratuito | RPM nivel de pago |

|---|---|---|---|

| Gemini 2.5 Pro | 5 | 25 | 1,000 |

| Gemini 2.5 Flash | 15 | 500 | 2,000 |

| Gemini 2.0 Flash | 15 | 1,500 | 4,000 |

Nota: RPM = solicitudes por minuto, RPD = solicitudes diarias

Por qué se agota el cupo repentinamente

| Motivo | Explicación |

|---|---|

| Exceso de RPM | Demasiadas solicitudes en poco tiempo |

| Exceso de RPD | El total de solicitudes diarias alcanzó el límite |

| Exceso de TPM | El contexto largo consume una gran cantidad de tokens |

| Reducción de cuota | Restricciones más estrictas tras el ajuste de Google en dic. 2025 |

Recordatorio importante: Varios API Keys no multiplican la cuota

Muchos usuarios piensan que crear varios API Keys les dará más cuota, pero en realidad:

La cuota se calcula por proyecto (Project), no por API Key. Crear varios API Keys en el mismo proyecto no aumentará la cuota.

Opción 1: Exportar el código al desarrollo local (Recomendado)

Concepto clave

La esencia de AI Studio es ser una herramienta de depuración visual de indicaciones. Los modelos que creas y las indicaciones que ajustas en AI Studio pueden exportarse como código para usarlos en tu entorno local mediante tu propia API Key.

Pasos a seguir

Paso 1: Finalizar la depuración de la indicación en AI Studio

Utiliza la cuota gratuita de AI Studio para ajustar tu indicación, la configuración de parámetros, etc.

Paso 2: Exportar el código

AI Studio ofrece varias formas de exportación:

- Descargar ZIP: Exporta el paquete de código completo a tu equipo.

- Push a GitHub: Envíalo directamente a tu repositorio de código.

- Copiar fragmentos de código: Copia fragmentos en Python, JavaScript o curl.

Paso 3: Configurar la API Key localmente

# Configurar variable de entorno (Recomendado)

export GEMINI_API_KEY="your-api-key-here"

# O también

export GOOGLE_API_KEY="your-api-key-here"

Paso 4: Ejecución local

import google.generativeai as genai

import os

# 自动读取环境变量中的 API Key

genai.configure(api_key=os.environ.get("GEMINI_API_KEY"))

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("你好,请介绍一下自己")

print(response.text)

Consideraciones

| Asunto | Descripción |

|---|---|

| Seguridad de la API Key | No escribas la API Key directamente en el código del cliente (hardcoding). |

| Variables de entorno | Utiliza GEMINI_API_KEY o GOOGLE_API_KEY. |

| Cuotas limitadas | Las llamadas locales siguen sujetas a los límites de la capa gratuita. |

🎯 Sugerencia técnica: Si tras exportar el código la cuota gratuita sigue siendo insuficiente, puedes considerar proveedores de API de terceros como APIYI (apiyi.com). Estas plataformas ofrecen cuotas más altas y métodos de facturación más flexibles.

Opción 2: Usar servicios de proxy de API de terceros (La mejor opción)

¿Qué es un servicio de proxy de API?

Los proveedores de proxy de API agrupan múltiples API Keys y recursos de cuentas para ofrecer una interfaz de API unificada. Solo necesitas:

- Registrarte en la plataforma de proxy para obtener una API Key.

- Cambiar la dirección de la API en tu código por la del proxy.

- Seguir usándolo sin preocuparte por las cuotas.

¿Por qué elegir un proxy de API?

| Ventaja | Descripción |

|---|---|

| Sin ansiedad por las cuotas | El proveedor gestiona las cuotas, tú solo las usas. |

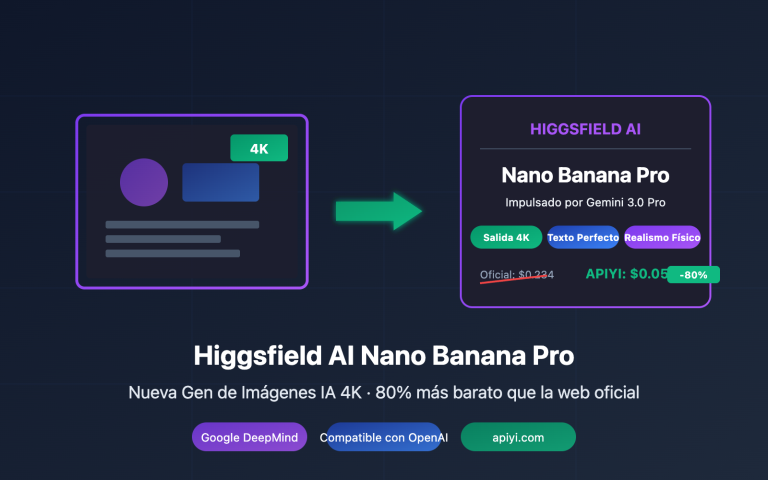

| Soporte para toda la serie de modelos | Cobertura total de Gemini Pro, Flash, Nano Banana, etc. |

| Formato compatible con OpenAI | No es necesario modificar la estructura de tu código actual. |

| Pago por uso | Pagas solo por lo que consumes, sin cuotas mensuales. |

| Mayor estabilidad | Equilibrio de carga entre múltiples nodos para evitar limitaciones de tráfico. |

Ejemplo de migración de código

Antes de la migración (Llamada directa a la API de Google):

import google.generativeai as genai

genai.configure(api_key="YOUR_GOOGLE_API_KEY")

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Hello")

Después de la migración (Usando el proxy de API):

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 统一接口

)

response = client.chat.completions.create(

model="gemini-2.0-flash",

messages=[{"role": "user", "content": "Hello"}]

)

print(response.choices[0].message.content)

Lista de modelos compatibles

| Serie de modelos | Modelo específico | Descripción |

|---|---|---|

| Gemini 2.5 | gemini-2.5-pro, gemini-2.5-flash | Últimos modelos multimodales. |

| Gemini 2.0 | gemini-2.0-flash, gemini-2.0-flash-thinking | Modelos de razonamiento rápido. |

| Gemini 3 | gemini-3-pro-image-preview | Modelo de generación de imágenes. |

| Nano Banana | nano-banana-pro | Generación de imágenes nativa. |

💡 Inicio rápido: Recomendamos usar la plataforma APIYI (apiyi.com) para una integración rápida. Esta plataforma es compatible con toda la serie de modelos Gemini, ofrece un formato compatible con OpenAI y permite completar la migración en solo 5 minutos.

Opción 3: Subir al nivel de pago de Google

Comparativa de cuotas del nivel de pago

Si prefieres seguir usando los servicios oficiales de Google, puedes considerar pasarte a un nivel de pago:

| Nivel | Condición de activación | Gemini 2.5 Pro RPM | Gemini 2.5 Flash RPM |

|---|---|---|---|

| Free (Gratis) | Por defecto | 5 | 15 |

| Tier 1 | Habilitar facturación | 150 | 1,000 |

| Tier 2 | Gasto de $50+ | 500 | 2,000 |

| Tier 3 | Gasto de $500+ | 1,000 | 4,000 |

Pasos para actualizar

- Inicia sesión en Google Cloud Console.

- Crea o selecciona un proyecto.

- Habilita la facturación (vincular una tarjeta de crédito).

- Verifica el cambio de cuota en AI Studio.

Inconvenientes del nivel de pago

| Problema | Descripción |

|---|---|

| Requiere tarjeta internacional | Dificultad para algunos usuarios para obtenerla. |

| Requiere cuenta de Google Cloud | La configuración es relativamente compleja. |

| Umbral de gasto mínimo | Para subir a niveles superiores, es necesario alcanzar ciertos objetivos de gasto. |

| Sigue habiendo límites | Solo se eleva el límite máximo, no es ilimitado. |

Comparativa de las tres opciones

| Criterio | Desarrollo local | Servicio de Proxy API | Nivel de pago oficial |

|---|---|---|---|

| Dificultad | Media | Fácil | Compleja |

| Cuota | Sigue limitada | Sin límites | Límite ampliado |

| Coste | Gratis (Limitado) | Pago por uso | Pago por uso |

| Requiere tarjeta | No | No | Sí (Internacional) |

| Estabilidad | Normal | Alta | Alta |

| Caso de uso | Uso ligero | Recomendado para la mayoría | Necesidades corporativas |

Tutorial detallado: Cómo migrar de AI Studio a un proxy de API

Paso 1: Registra una cuenta en la plataforma de proxy de API

Visita APIYI en apiyi.com, regístrate y obtén tu API Key.

Paso 2: Instala el SDK de OpenAI

# Python

pip install openai

# Node.js

npm install openai

Paso 3: Modifica la configuración del código

Ejemplo en Python:

import openai

# 配置 API 代理

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # APIYI统一接口

)

# 调用 Gemini 模型

def chat_with_gemini(prompt):

response = client.chat.completions.create(

model="gemini-2.5-flash", # 可选其他 Gemini 模型

messages=[

{"role": "user", "content": prompt}

],

temperature=0.7,

max_tokens=2048

)

return response.choices[0].message.content

# 使用示例

result = chat_with_gemini("用 Python 写一个快速排序算法")

print(result)

Ejemplo en Node.js:

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: 'YOUR_APIYI_KEY',

baseURL: 'https://api.apiyi.com/v1'

});

async function chatWithGemini(prompt) {

const response = await client.chat.completions.create({

model: 'gemini-2.5-flash',

messages: [

{ role: 'user', content: prompt }

]

});

return response.choices[0].message.content;

}

// 使用示例

const result = await chatWithGemini('解释什么是机器学习');

console.log(result);

Paso 4: Prueba y validación

# 测试连接

try:

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": "Hello, 测试连接"}],

max_tokens=50

)

print("连接成功:", response.choices[0].message.content)

except Exception as e:

print("连接失败:", e)

Migración de modelos de generación de imágenes

Generación de imágenes en AI Studio

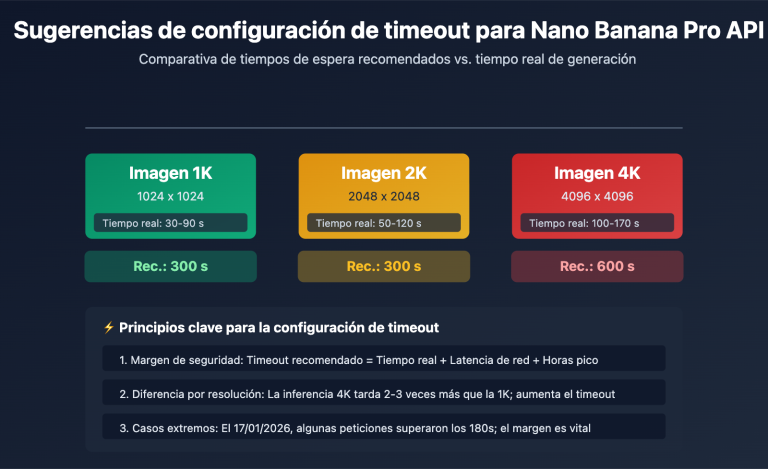

Si usas las funciones de generación de imágenes de Gemini en AI Studio (Nano Banana Pro), también puedes seguir usándolas a través del proxy de API:

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1"

)

# 图像生成

response = client.images.generate(

model="nano-banana-pro",

prompt="一只可爱的橘猫在阳光下打盹,写实摄影风格",

size="1024x1024",

quality="hd"

)

image_url = response.data[0].url

print(f"生成的图像: {image_url}")

Chat multimodal (mezcla de imagen y texto)

import base64

def encode_image(image_path):

with open(image_path, "rb") as f:

return base64.b64encode(f.read()).decode()

image_base64 = encode_image("example.jpg")

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "描述这张图片的内容"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{image_base64}"

}

}

]

}

]

)

print(response.choices[0].message.content)

💰 Optimización de costos: Para necesidades de generación de imágenes, la plataforma APIYI (apiyi.com) ofrece métodos de facturación flexibles y soporta diversos modelos como Nano Banana Pro, DALL-E y Stable Diffusion, permitiéndote elegir la mejor opción según tus necesidades.

Manejo de errores comunes

Error 1: 429 Too Many Requests

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10))

def call_api_with_retry(prompt):

return client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": prompt}]

)

Error 2: API Key no válida

# Verificar configuración de la API Key

import os

api_key = os.environ.get("APIYI_KEY")

if not api_key:

raise ValueError("Por favor, configure la variable de entorno APIYI_KEY")

client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

Error 3: El modelo no existe

# Confirmar que el nombre del modelo es correcto

SUPPORTED_MODELS = [

"gemini-2.5-pro",

"gemini-2.5-flash",

"gemini-2.0-flash",

"nano-banana-pro"

]

model_name = "gemini-2.5-flash"

if model_name not in SUPPORTED_MODELS:

print(f"Advertencia: {model_name} podría no estar en la lista de soporte")

Preguntas frecuentes (FAQ)

Q1: ¿Cuándo se restablece la cuota gratuita de AI Studio?

- RPM (Solicitudes por minuto): Ventana deslizante, se restablece cada minuto.

- RPD (Solicitudes por día): Se restablece a medianoche, hora del Pacífico.

- TPM (Tokens por minuto): Ventana deslizante, se restablece cada minuto.

Si lo necesitas con urgencia, te recomendamos usar la plataforma APIYI (apiyi.com), ya que no requiere esperar a que se restablezcan las cuotas.

Q2: ¿Es seguro usar un proxy de API?

Es seguro siempre que elijas un proveedor de servicios de proxy de API legítimo. Ten en cuenta lo siguiente:

- Elige proveedores con buena reputación.

- No incluyas la API Key directamente en el código (hardcoding).

- Usa variables de entorno para gestionar tus claves.

Q3: ¿Cuál es el precio de un proxy de API?

La mayoría de los servicios de proxy de API utilizan un modelo de pago por uso y, por lo general, suelen ser más económicos que los precios oficiales. La plataforma APIYI (apiyi.com) ofrece un sistema de precios transparente que puedes consultar directamente en su sitio web.

Q4: ¿Es necesario realizar grandes cambios en el código después de la migración?

Si utilizas un proxy de API compatible con el formato de OpenAI, los cambios en el código son mínimos:

- Solo necesitas modificar la

api_keyy labase_url. - Es posible que debas ajustar el nombre del modelo.

- El resto de la lógica del código no requiere cambios.

Q5: ¿Puedo usar varios servicios de API al mismo tiempo?

¡Claro que sí! Puedes elegir diferentes servicios según el escenario:

- Usa la cuota gratuita de AI Studio para pruebas ligeras.

- Usa servicios de proxy de API para el desarrollo diario.

- Usa servicios oficiales de pago para necesidades especiales.

Resumen

Cuando se agote el límite gratuito de Google AI Studio, tienes 3 opciones:

| Solución | Ideal para | Acción clave |

|---|---|---|

| Exportar para desarrollo local | Usuarios ligeros | Exportar código, llamar localmente |

| Servicio de proxy API | La mayoría de los desarrolladores | Modificar base_url, seguir usando |

| Subir al nivel de pago | Necesidades empresariales | Vincular tarjeta de crédito, aumentar cuota |

Recomendaciones clave:

- No recargues saldo en tu cuenta de Google (a menos que tengas una tarjeta de crédito internacional y necesites servicios empresariales).

- Exporta tu código a tu entorno local.

- Usa un servicio de proxy API para seguir llamando a los modelos de Gemini.

- Resumen en una frase: Exporta tu código y realiza las llamadas de desarrollo localmente.

Recomendamos usar APIYI (apiyi.com) para recuperar rápidamente el acceso a Gemini. Esta plataforma soporta toda la serie de modelos Gemini, ofrece un formato compatible con OpenAI y el costo de migración es extremadamente bajo.

Lectura adicional:

- Límites de velocidad de la API de Gemini: ai.google.dev/gemini-api/docs/rate-limits

- Modo de construcción de AI Studio: ai.google.dev/gemini-api/docs/aistudio-build-mode

- Guía de uso de la API Key: ai.google.dev/gemini-api/docs/api-key

📝 Autor: Equipo técnico de APIYI | Especialistas en integración y optimización de APIs para Modelos de Lenguaje Grande

🔗 Intercambio técnico: Visita APIYI apiyi.com para obtener soporte en las llamadas a toda la serie de modelos Gemini