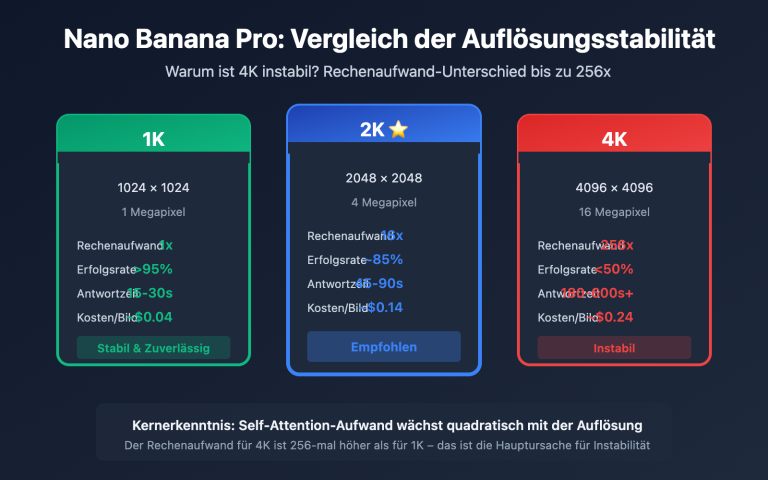

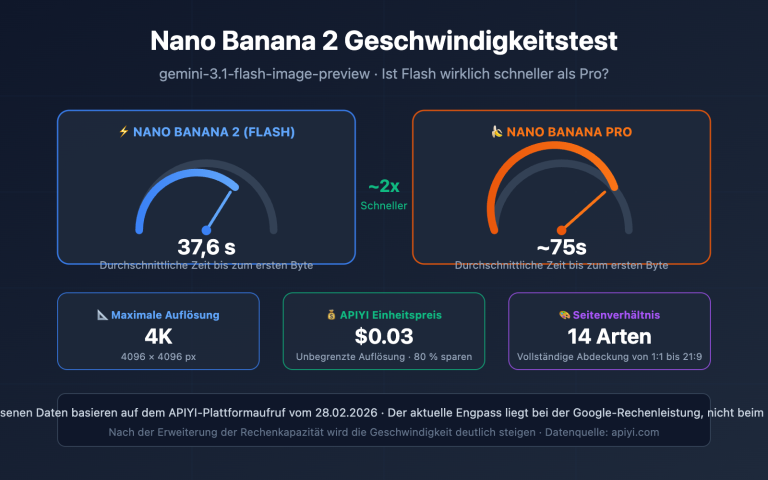

Haben Sie beim Aufruf der Nano Banana Pro API zur Generierung von 4K-Bildern häufig den Fehler HTTPSConnectionPool Read timed out? Dies liegt daran, dass die Standard-Timeout-Einstellungen von HTTP-Clients nicht für die langen Inferenzzeiten von Nano Banana Pro ausgelegt sind. In diesem Artikel analysieren wir systematisch die drei Hauptgründe für Timeout-Abbrüche und bieten optimale Konfigurationslösungen für verschiedene Auflösungen.

Kernwert: Nach der Lektüre dieses Artikels werden Sie die Timeout-Konfigurationstechniken der Nano Banana Pro API beherrschen, Lösungen für HTTP/2-Kompatibilitätsprobleme kennen und erfahren, wie Sie Streaming-Abbrüche über HTTP-Port-Schnittstellen vermeiden, um eine stabile 4K-Bildgenerierung zu gewährleisten.

Kernelemente der Timeout-Konfiguration für die Nano Banana Pro API

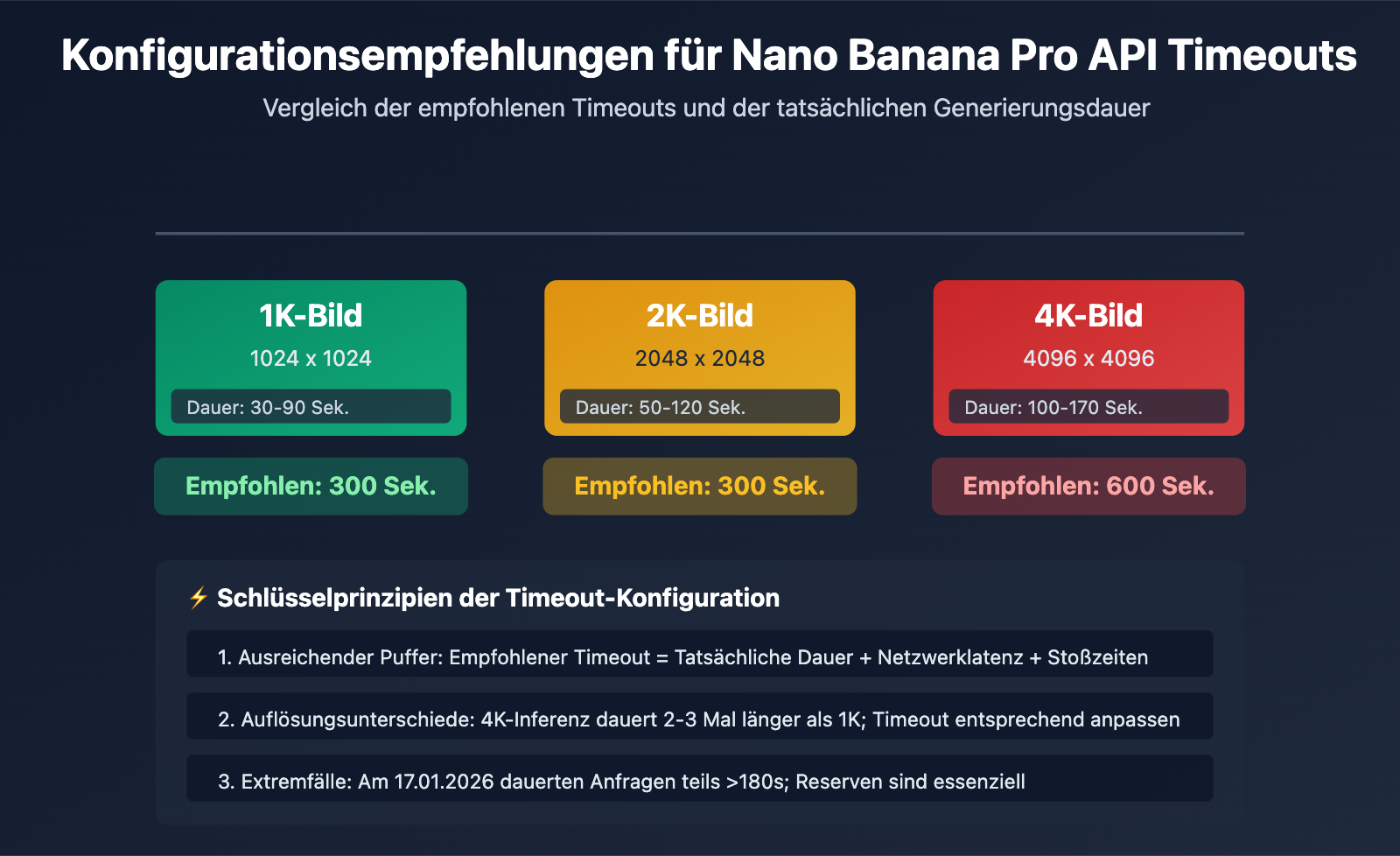

| Bildauflösung | Tatsächliche Generierungsdauer | Empfohlene Timeout-Einstellung | Sicherheitsspielraum | Anwendungsszenario |

|---|---|---|---|---|

| 1K (1024×1024) | 30-90 Sek. | 300 Sek. | +210 Sek. | Standard-Bildgenerierung |

| 2K (2048×2048) | 50-120 Sek. | 300 Sek. | +180 Sek. | HD-Bildgenerierung |

| 4K (4096×4096) | 100-170 Sek. | 600 Sek. | +430 Sek. | Ultra-HD-Bildgenerierung |

| Extremszenarien (Netzwerkschwankungen/Stoßzeiten) | Bis zu 180+ Sek. | 600 Sek. | – | Empfehlung für Produktion |

Hauptursachen für Timeout-Probleme bei der Nano Banana Pro API

Kernunterschied: Nano Banana Pro ist das neueste Bildgenerierungsmodell von Google, das auf TPUs basiert. Die Inferenzzeit ist signifikant länger als bei reinen Textmodellen. Die Standard-Timeouts herkömmlicher HTTP-Clients (oft nur 30-60 Sekunden) reichen für die tatsächliche Verarbeitungszeit bei weitem nicht aus, was zu häufigen Verbindungsabbrüchen führt.

Am 17. Januar 2026 kam es bei der Nano Banana Pro API aufgrund globaler Google-Risikokontrollen und Ressourcenengpässen dazu, dass die Generierungszeit von 20–40 Sekunden auf 180 Sekunden oder mehr anstieg. Bei einigen API-Aggregator-Plattformen löste dies Abrechnungs-Kompensationsmechanismen für Anfragen über 180 Sekunden aus. Dieses Ereignis unterstreicht, wie wichtig es ist, bei den Timeout-Einstellungen genügend Puffer einzuplanen.

💡 Technischer Hinweis: Für die praktische Entwicklung empfehlen wir, die Nano Banana Pro API-Aufrufe über die Plattform APIYI (apiyi.com) durchzuführen. Diese Plattform bietet eine speziell für lange Inferenzen optimierte HTTP-Schnittstelle (http://api.apiyi.com:16888/v1), die standardmäßig mit angemessenen Timeouts konfiguriert ist und die Generierung von 1K- bis 4K-Bildern unterstützt, wodurch Timeout-Abbrüche effektiv vermieden werden.

Hauptursache 1: Zu kurze Standard-Timeout-Einstellungen der HTTP-Clients

Die Standard-Timeout-Falle gängiger HTTP-Bibliotheken

Die Standard-Timeout-Einstellungen der meisten HTTP-Bibliotheken in gängigen Programmiersprachen sind oft völlig unzureichend:

| HTTP-Bibliothek | Standard-Verbindungs-Timeout | Standard-Lese-Timeout | Kompatibel mit Nano Banana Pro? |

|---|---|---|---|

| Python requests | Unbegrenzt | Unbegrenzt (praktisch durch System begrenzt) | ❌ Explizite Einstellung erforderlich |

| Python httpx | 5 Sek. | 5 Sek. | ❌ Ernsthaft unzureichend |

| Node.js axios | Unbegrenzt | Unbegrenzt | ⚠️ Tatsächliches Timeout prüfen |

| Java HttpClient | Unbegrenzt | 30 Sek. (JDK 11+) | ❌ Unzureichend |

| Go http.Client | Unbegrenzt | Unbegrenzt (aber durch Transport begrenzt) | ⚠️ Transport-Konfiguration nötig |

Das versteckte Timeout-Problem bei Python requests:

Obwohl die Dokumentation der requests-Bibliothek behauptet, es gäbe standardmäßig kein Zeitlimit, wird die Verbindung in der Praxis meist nach 60–120 Sekunden durch TCP-Timeouts des Betriebssystems oder des zugrunde liegenden Sockets getrennt. Dies führt dazu, dass viele Entwickler glauben: „Wenn ich kein Timeout setze, gibt es auch keins“ – nur um dann in der Produktionsumgebung auf unerwartete Verbindungsabbrüche zu stoßen.

import requests

# ❌ Fehler: Kein explizites Timeout gesetzt; wird nach ca. 60–120 Sek. abgebrochen

response = requests.post(

"https://api.example.com/v1/images/generations",

json={"prompt": "Erzeuge 4K-Bild", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Wenn die Generierung länger als 120 Sek. dauert, tritt eine ReadTimeout-Exception auf

Die richtige Methode zur Timeout-Konfiguration

Lösung 1: Explizite Timeout-Konfiguration in Python requests

import requests

# ✅ Richtig: Explizites Timeout setzen

response = requests.post(

"https://api.example.com/v1/images/generations",

json={

"prompt": "A futuristic city with neon lights",

"size": "4096x4096", # 4K-Auflösung

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600) # (Connect-Timeout, Read-Timeout) = (10s, 600s)

)

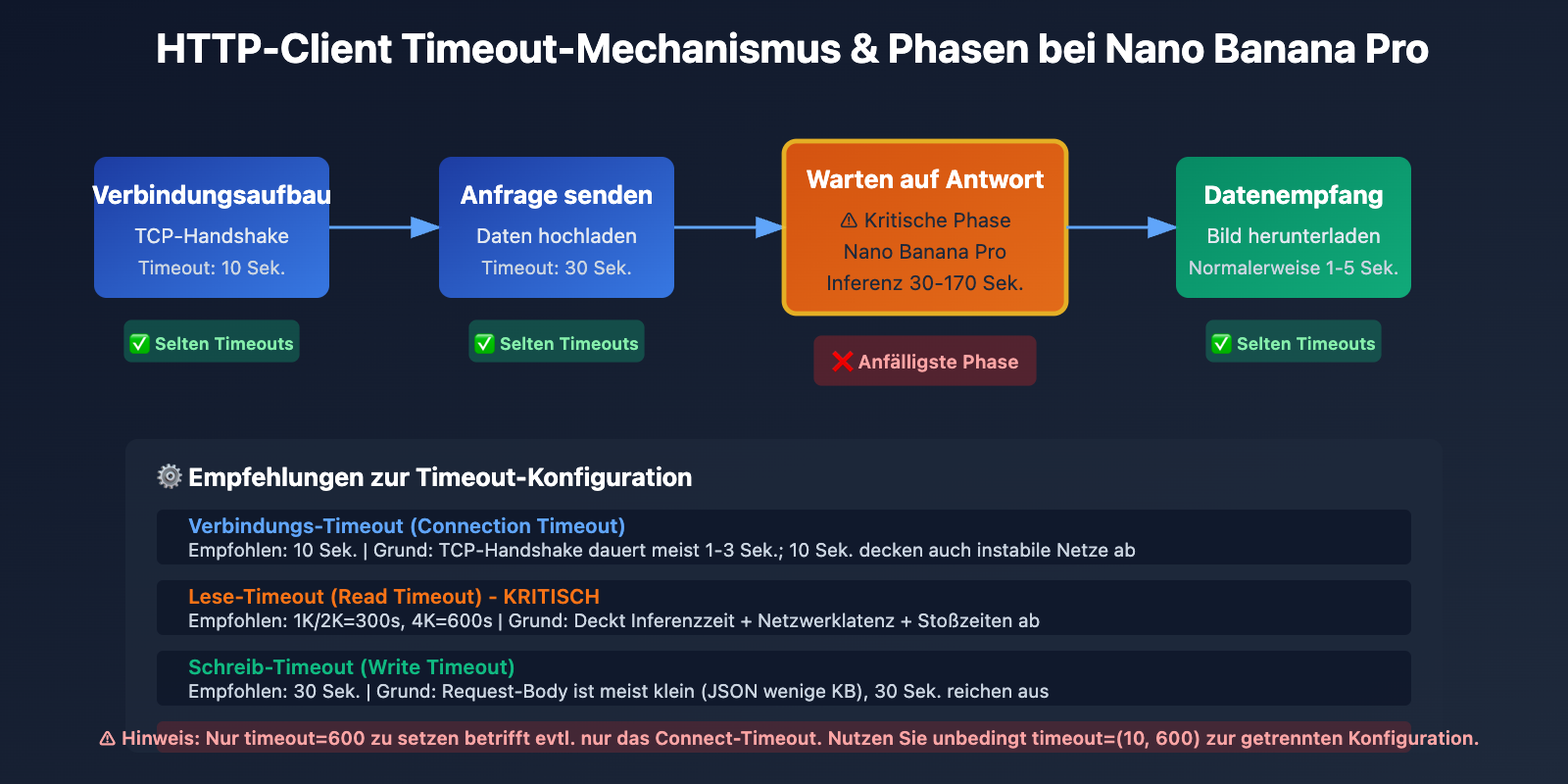

Erklärung des timeout-Parameters:

- Verbindungs-Timeout (10 Sek.): Maximale Wartezeit für den Aufbau der TCP-Verbindung. 10 Sekunden sind normalerweise völlig ausreichend.

- Lese-Timeout (600 Sek.): Maximale Wartezeit auf die Antwortdaten des Servers. Für 4K-Bilder werden 600 Sekunden empfohlen.

Lösung 2: Benutzerdefinierter Python httpx Client

import httpx

# Erstellt einen benutzerdefinierten Client, erzwingt HTTP/1.1 und setzt lange Timeouts

client = httpx.Client(

timeout=httpx.Timeout(

connect=10.0, # Connect-Timeout 10 Sek.

read=600.0, # Read-Timeout 600 Sek.

write=30.0, # Write-Timeout 30 Sek.

pool=10.0 # Pool-Timeout 10 Sek.

),

http2=False, # ⚠️ Entscheidend: HTTP/1.1 erzwingen, um HTTP/2-Kompatibilitätsprobleme zu vermeiden

limits=httpx.Limits(

max_connections=10,

max_keepalive_connections=5

)

)

# API-Aufruf mit dem benutzerdefinierten Client

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "Cyberpunk style portrait",

"size": "4096x4096",

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Client schließen

client.close()

Vollständiges Beispiel für asynchrone httpx-Konfiguration anzeigen

import httpx

import asyncio

async def generate_image_async():

"""Asynchrone Bildgenerierung mit Unterstützung für lange Timeouts"""

async with httpx.AsyncClient(

timeout=httpx.Timeout(

connect=10.0,

read=600.0, # 600 Sek. empfohlen für 4K-Bilder

write=30.0,

pool=10.0

),

http2=False, # HTTP/1.1 erzwingen

limits=httpx.Limits(

max_connections=20,

max_keepalive_connections=10

)

) as client:

response = await client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "A serene landscape at sunset",

"size": "4096x4096",

"model": "nano-banana-pro",

"n": 1

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

return response.json()

# Asynchrone Funktion ausführen

result = asyncio.run(generate_image_async())

print(result)

🎯 Best Practice: Beim Wechsel zur Nano Banana Pro API empfiehlt es sich, die tatsächlichen Generierungszeiten für verschiedene Auflösungen zunächst über die APIYI-Plattform (apiyi.com) zu testen. Die Plattform bietet eine HTTP-Schnittstelle (http://api.apiyi.com:16888/v1) mit bereits optimierten Standard-Timeouts, sodass Sie Ihre Konfiguration schnell und einfach validieren können.

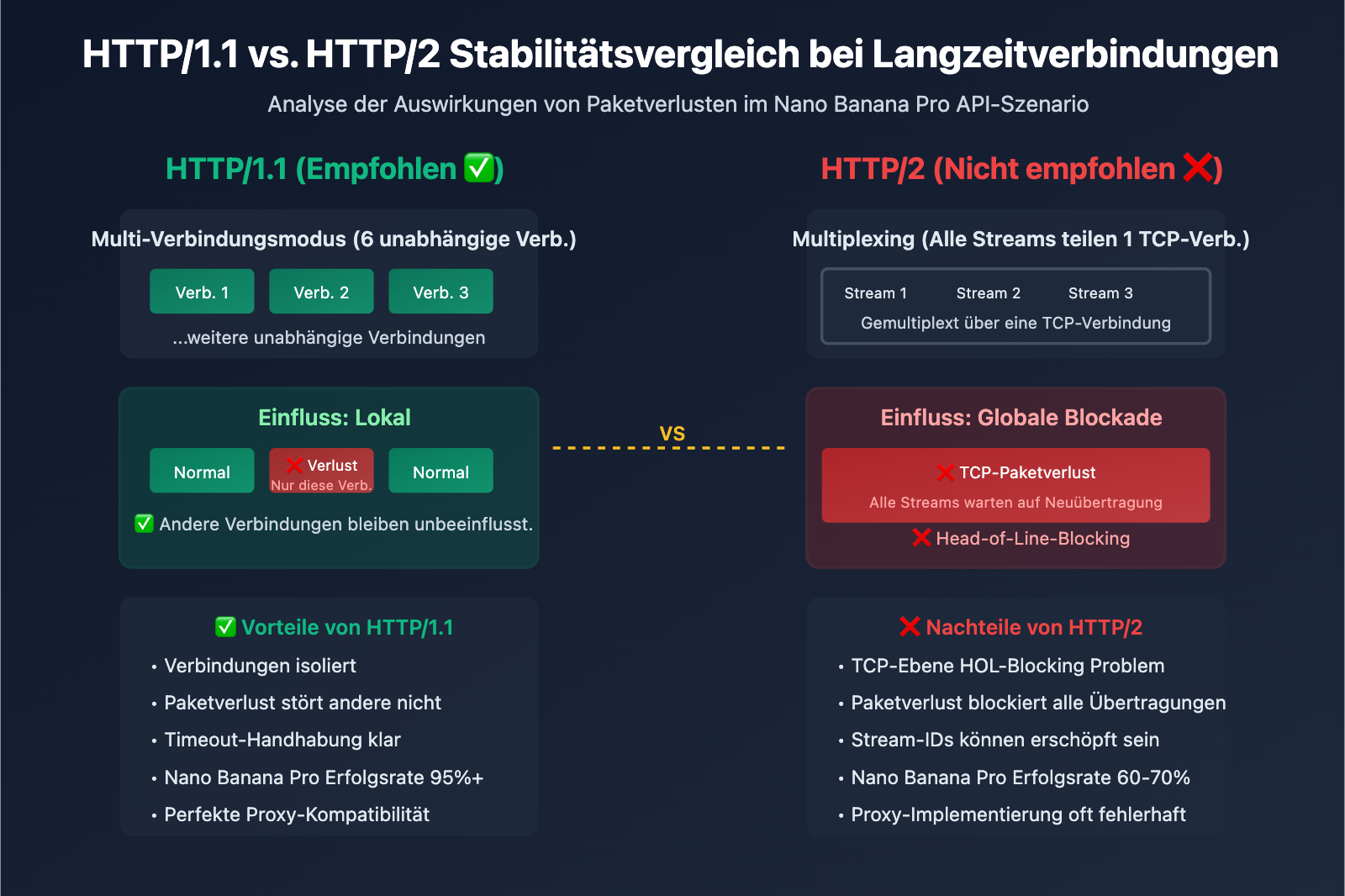

Grundursache 2: Kompatibilitätsprobleme des HTTP/2-Protokolls bei Long-Connection-Streaming

Designfehler von HTTP/2 und Konflikte mit Nano Banana Pro

Obwohl HTTP/2 mit dem Ziel entwickelt wurde, die Performance zu steigern, treten bei der Verarbeitung von Long-Connection-Streaming mehrere schwerwiegende Kompatibilitätsprobleme auf:

Problem 1: Head-of-Line Blocking auf TCP-Ebene

HTTP/2 löst durch Multiplexing das Head-of-Line-Blocking (HOL-Blocking) auf Anwendungsebene von HTTP/1.1, führt jedoch ein neues Problem auf TCP-Ebene ein. Sämtliche HTTP/2-Streams werden über eine einzige TCP-Verbindung gemultiplext. Jeder Paketverlust auf TCP-Ebene blockiert die Übertragung aller Streams gleichzeitig.

HTTP/1.1 (6 parallele Verbindungen):

Verbindung 1: [Stream A] ━━━━━━━━━▶

Verbindung 2: [Stream B] ━━━━━━━━━▶ ✅ Paketverlust betrifft nur einen Stream

Verbindung 3: [Stream C] ━━━━━━━━━▶

HTTP/2 (Multiplexing über eine Verbindung):

Verbindung 1: [Stream A][Stream B][Stream C] ━━━━━━━━━▶

↑ TCP-Paketverlust blockiert alle Streams ❌

Problem 2: Erschöpfung der Stream-Identifikatoren (Stream Identifier Exhaustion)

Die Stream-Identifikatoren (Stream ID) von HTTP/2 sind 31-Bit-Ganzzahlen mit einem Maximalwert von 2^31-1 (ca. 2,1 Milliarden). Lang anhaltende Verbindungen können die verfügbaren Stream-IDs erschöpfen. Da Stream-IDs nicht wiederverwendbar sind, muss in einem solchen Fall zwingend eine neue Verbindung aufgebaut werden.

Problem 3: Unterschiedliche Implementierungsqualität von HTTP/2 bei API-Proxys

Viele API-Vermittlungsplattformen oder Reverse-Proxys weisen Mängel in ihrer HTTP/2-Implementierung auf, insbesondere bei der Handhabung von lang andauerndem Streaming:

- Fehlerhafte Verarbeitung von Stream-Resets (RST_STREAM), was zu unerwarteten Verbindungsabbrüchen führt.

- Fehler im Management von WINDOW_UPDATE-Frames, was zum Scheitern der Flusssteuerung führt.

- Falsch ausgelöste GOAWAY-Frames, die die Verbindung vorzeitig schließen.

Vergleich: HTTP/2 vs. HTTP/1.1 im Nano Banana Pro Szenario

| Metrik | HTTP/1.1 | HTTP/2 | Empfehlung |

|---|---|---|---|

| Verbindungsstabilität | Hoch (Unabhängige Verbindungen) | Niedrig (Multiplexing; Paketverlust betrifft alle Streams) | HTTP/1.1 ✅ |

| Unterstützung für Langzeitverbindungen | Ausgereift (Stabiler Keep-Alive-Mechanismus) | Instabil (Problem der Stream-ID-Erschöpfung) | HTTP/1.1 ✅ |

| Timeout-Handhabung | Einfach und klar (Timeout auf Verbindungsebene) | Komplex (Timeout auf Stream- und Verbindungsebene) | HTTP/1.1 ✅ |

| API-Proxy-Kompatibilität | Extrem hoch (Unterstützung durch alle Plattformen) | Variabel (Einige Plattformen haben Bugs) | HTTP/1.1 ✅ |

| Nano Banana Pro 4K Erfolgsrate | 95%+ | 60-70% | HTTP/1.1 ✅ |

Lösung: HTTP/1.1 erzwingen und HTTP-Port verwenden

Lösung 1: HTTP/1.1 in Python httpx erzwingen

import httpx

# HTTP/1.1 erzwingen, um HTTP/2-Kompatibilitätsprobleme zu vermeiden

client = httpx.Client(

http2=False, # ⚠️ Wichtige Einstellung: HTTP/2 deaktivieren

timeout=httpx.Timeout(read=600.0)

)

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations", # HTTP-Port verwenden

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer IHR_API_KEY"}

)

Lösung 2: Python requests (Standardmäßig HTTP/1.1)

import requests

# Die requests-Bibliothek verwendet standardmäßig HTTP/1.1, keine Extra-Konfiguration nötig

response = requests.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer IHR_API_KEY"},

timeout=(10, 600)

)

Lösung 3: HTTP/1.1 in Node.js axios erzwingen

const axios = require('axios');

const http = require('http');

// Speziellen Agent für HTTP/1.1 erstellen

const agent = new http.Agent({

keepAlive: true,

maxSockets: 10,

timeout: 600000 // 600 Sekunden

});

// Axios für die Verwendung des benutzerdefinierten Agents konfigurieren

const response = await axios.post(

'http://api.apiyi.com:16888/v1/images/generations',

{

prompt: 'Ein wunderschöner Sonnenuntergang',

size: '4096x4096',

model: 'nano-banana-pro'

},

{

headers: {

'Authorization': 'Bearer IHR_API_KEY'

},

httpAgent: agent, // HTTP/1.1 Agent verwenden

timeout: 600000 // 600 Sekunden Timeout

}

);

💰 Kostenoptimierung: Für Projekte, die eine hohe Stabilität bei der Generierung von 4K-Bildern erfordern, wird empfohlen, die Nano Banana Pro API über die Plattform APIYI (apiyi.com) aufzurufen. Diese Plattform bietet eine dedizierte HTTP-Port-Schnittstelle (http://api.apiyi.com:16888/v1), die standardmäßig das HTTP/1.1-Protokoll nutzt. Dadurch werden HTTP/2-Kompatibilitätsprobleme vermieden. Zudem bietet sie attraktivere Abrechnungsmodelle, die ideal für den Einsatz in Produktionsumgebungen geeignet sind.

Hauptursache 3: Der kumulative Effekt von Streaming und Netzwerkschwankungen

Die Non-Streaming-Charakteristik von Nano Banana Pro

Im Gegensatz zu Textgenerierungsmodellen (Große Sprachmodelle) wie GPT-4 oder Claude verwendet die Nano Banana Pro API kein Streaming, um Bilder zurückzugeben. Der gesamte Generierungsprozess läuft wie folgt ab:

- Anfragephase (1-3 Sek.): Der Client sendet die Anfrage an den Server.

- Inferenzphase (30-170 Sek.): Der Server generiert das Bild auf der TPU, während der Client keinerlei Antwortdaten erhält.

- Antwortphase (1-5 Sek.): Der Server gibt die vollständigen Base64-kodierten Bilddaten zurück.

Das Kernproblem: Während der 30 bis 170 Sekunden dauernden Inferenzphase ist die HTTP-Verbindung des Clients vollständig im Leerlauf. Lediglich TCP Keep-Alive hält die Verbindung aufrecht, es findet jedoch keine Datenübertragung auf Anwendungsebene statt. Dies führt zu folgenden Problemen:

- Zwischengeschaltete Netzwerkkomponenten (NAT, Firewalls, Proxys) könnten die Verbindung als getrennt betrachten und sie aktiv schließen.

- In instabilen Netzwerkumgebungen werden lang andauernde Leerlaufverbindungen leichter unterbrochen.

- Load Balancer einiger Cloud-Anbieter haben Timeouts für Leerlaufverbindungen (z. B. AWS ALB standardmäßig 60 Sekunden).

Einfluss von Netzwerkschwankungen auf Timeouts

| Netzwerkumgebung | Tatsächliche Generierungszeit | Einfluss der Netzwerklatenz | Empfohlene Timeout-Einstellung |

|---|---|---|---|

| Stabiles Intranet/IDC | 100 Sek. | +10-20 Sek. | 300 Sek. (Puffer: 180 Sek.) |

| Privater Breitbandanschluss/Mobilfunk | 100 Sek. | +30-50 Sek. | 600 Sek. (Puffer: 450 Sek.) |

| Grenzüberschreitende Netzwerke/VPN | 100 Sek. | +50-100 Sek. | 600 Sek. (Puffer: 400 Sek.) |

| Hauptverkehrszeit (Ereignis vom 17.01.2026) | 180 Sek. | +20-40 Sek. | 600 Sek. (Puffer: 380 Sek.) |

Strategie: Timeout + Retry + Fallback

import requests

import time

from typing import Optional

def generate_image_with_retry(

prompt: str,

size: str = "4096x4096",

max_retries: int = 3,

timeout: int = 600

) -> Optional[dict]:

"""

Generiert ein Bild mit Unterstützung für Timeout-Retries.

Args:

prompt: Eingabeaufforderung für das Bild

size: Bildgröße (1024x1024, 2048x2048, 4096x4096)

max_retries: Maximale Anzahl an Wiederholungsversuchen

timeout: Timeout-Zeit (Sekunden)

Returns:

Generierungsergebnis oder None (bei Fehler)

"""

api_url = "http://api.apiyi.com:16888/v1/images/generations"

headers = {"Authorization": "Bearer IHR_API_KEY"}

for attempt in range(max_retries):

try:

print(f"Versuch {attempt + 1}/{max_retries}: Generiere {size} Bild...")

start_time = time.time()

# Timeout als Tupel: (Connect Timeout, Read Timeout)

response = requests.post(

api_url,

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1

},

headers=headers,

timeout=(10, timeout)

)

elapsed = time.time() - start_time

print(f"✅ Generierung erfolgreich! Dauer: {elapsed:.2f} Sek.")

return response.json()

except requests.exceptions.Timeout:

elapsed = time.time() - start_time

print(f"❌ Timeout nach: {elapsed:.2f} Sek.")

if attempt < max_retries - 1:

wait_time = 5 * (attempt + 1) # Exponential Backoff

print(f"⏳ Warte {wait_time} Sekunden vor dem nächsten Versuch...")

time.sleep(wait_time)

else:

print("❌ Maximale Anzahl an Versuchen erreicht, Generierung fehlgeschlagen.")

return None

except requests.exceptions.RequestException as e:

print(f"❌ Netzwerkfehler: {e}")

if attempt < max_retries - 1:

time.sleep(5)

else:

return None

return None

# Beispiel für die Verwendung

result = generate_image_with_retry(

prompt="Eine majestätische Berglandschaft",

size="4096x4096",

max_retries=3,

timeout=600

)

if result:

print(f"Bild-URL: {result['data'][0]['url']}")

else:

print("Bildgenerierung fehlgeschlagen, bitte später erneut versuchen.")

🚀 Schnellstart: Wir empfehlen die Verwendung der Plattform APIYI (apiyi.com) für eine schnelle Integration der Nano Banana Pro API. Die Plattform bietet folgende Vorteile:

- HTTP-Port-Schnittstelle: http://api.apiyi.com:16888/v1 vermeidet den HTTPS-Handshake-Overhead.

- Optimierte Timeout-Konfiguration: Standardmäßig werden 600 Sekunden Timeout unterstützt, was 4K-Generierungsszenarien abdeckt.

- Intelligenter Retry-Mechanismus: Temporäre Timeouts werden auf Plattformebene automatisch behandelt, um die Erfolgsrate zu erhöhen.

- Abrechnungskompensation: Anfragen, die länger als 180 Sekunden dauern, lösen automatisch eine Kompensation aus, um Verschwendung zu vermeiden.

Vorteile der HTTP-Schnittstelle der APIYI-Plattform

Warum wird HTTP gegenüber HTTPS empfohlen?

| Eigenschaft | HTTPS (api.apiyi.com/v1) | HTTP (api.apiyi.com:16888/v1) | Empfehlung |

|---|---|---|---|

| TLS-Handshake-Overhead | Vorhanden (300-800ms) | Keiner | HTTP ✅ |

| Verbindungsaufbau | Langsam (erfordert TLS-Aushandlung) | Schnell (direkte TCP-Verbindung) | HTTP ✅ |

| HTTP/2-Aushandlung | Mögliches automatisches Upgrade auf HTTP/2 | Erzwungenes HTTP/1.1 | HTTP ✅ |

| Sicherheit (intern) | Höher (verschlüsselt) | Mittel (Klartext) | HTTP ⚠️ (intern nutzbar) |

| Timeout-Stabilität | Mittel (TLS-Timeout + Lese-Timeout) | Hoch (nur Lese-Timeout) | HTTP ✅ |

Vollständiges Konfigurationsbeispiel für die APIYI-HTTP-Schnittstelle

import requests

# Konfiguration des APIYI HTTP-Endpunkts

APIYI_HTTP_ENDPOINT = "http://api.apiyi.com:16888/v1"

APIYI_API_KEY = "IHR_APIYI_API_KEY"

def generate_nano_banana_image(

prompt: str,

size: str = "4096x4096"

) -> dict:

"""

Generiert ein Nano Banana Pro Bild über die APIYI HTTP-Schnittstelle.

Args:

prompt: Eingabeaufforderung für das Bild

size: Bildgröße

Returns:

API-Antwort

"""

# Dynamische Anpassung des Timeouts basierend auf der Auflösung

timeout_map = {

"1024x1024": 300, # 1K: 300 Sek.

"2048x2048": 300, # 2K: 300 Sek.

"4096x4096": 600 # 4K: 600 Sek.

}

timeout = timeout_map.get(size, 600) # Standardmäßig 600 Sek.

response = requests.post(

f"{APIYI_HTTP_ENDPOINT}/images/generations",

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1,

"response_format": "url" # Oder "b64_json"

},

headers={

"Authorization": f"Bearer {APIYI_API_KEY}",

"Content-Type": "application/json"

},

timeout=(10, timeout) # (Connect Timeout, Read Timeout)

)

response.raise_for_status()

return response.json()

# Beispiel für die Verwendung

try:

result = generate_nano_banana_image(

prompt="Ein fotorealistisches Porträt einer Katze",

size="4096x4096"

)

print(f"✅ Generierung erfolgreich!")

print(f"Bild-URL: {result['data'][0]['url']}")

print(f"Größe: {result['data'][0]['size']}")

except requests.exceptions.Timeout:

print("❌ Anfrage-Timeout, bitte Netzwerk prüfen oder später erneut versuchen.")

except requests.exceptions.HTTPError as e:

print(f"❌ API-Fehler: {e}")

except Exception as e:

print(f"❌ Unbekannter Fehler: {e}")

💡 Best Practice: In einer Produktionsumgebung wird empfohlen, vorrangig die HTTP-Schnittstelle von APIYI (http://api.apiyi.com:16888/v1) zu nutzen. Diese Schnittstelle ist plattformseitig optimiert und mit angemessenen Timeouts sowie Retry-Strategien vorkonfiguriert. Dies erhöht die Erfolgsrate bei Aufrufen der Nano Banana Pro API signifikant, insbesondere bei der Generierung von 4K-Bildern.

Häufig gestellte Fragen

Q1: Warum tritt trotz einer Einstellung von 600 Sekunden immer noch ein Timeout auf?

Mögliche Ursachen:

-

Es wurde nur der Verbindungs-Timeout, aber nicht der Lese-Timeout festgelegt:

# ❌ Falsch: timeout=600 bezieht sich nur auf den Verbindungs-Timeout response = requests.post(url, json=data, timeout=600) # ✅ Richtig: Verbindungs- und Lese-Timeout separat festlegen response = requests.post(url, json=data, timeout=(10, 600)) -

Zwischengeschaltete Proxys oder Load Balancer haben kürzere Zeitlimits:

- AWS ALB hat standardmäßig einen Idle-Timeout von 60 Sekunden.

- Nginx hat standardmäßig einen

proxy_read_timeoutvon 60 Sekunden. - Der Cloudflare Free-Plan erlaubt einen maximalen Timeout von 100 Sekunden.

Lösung: Nutzen Sie die HTTP-Port-Schnittstelle von APIYI. Diese Schnittstelle wurde auf Plattformebene für optimierte Timeout-Konfigurationen angepasst.

-

Instabile Netzwerkumgebung, tatsächliche Generierungszeit überschreitet 600 Sekunden:

- Während der Stoßzeiten am 17. Januar 2026 dauerten einige Anfragen länger als 180 Sekunden.

- Grenzüberschreitende Netzwerkverzögerungen können die Zeit um weitere 50–100 Sekunden erhöhen.

Lösung: Implementieren Sie einen Retry-Mechanismus (Wiederholungsversuche) und nutzen Sie die Abrechnungskompensation der APIYI-Plattform.

Q2: Ist die HTTP-Schnittstelle sicher? Besteht die Gefahr des Abhörens?

Sicherheitsanalyse:

| Szenario | HTTP-Sicherheit | Empfehlung |

|---|---|---|

| Interner Aufruf (VPC/Privates Netzwerk) | Hoch (keine Exposition im öffentlichen Internet) | ✅ Empfohlen: HTTP |

| Öffentlicher Aufruf (Entwicklung/Test) | Mittel (API-Key könnte abgefangen werden) | ⚠️ Vorsicht bei der Key-Sicherheit |

| Öffentlicher Aufruf (Produktionsumgebung) | Niedrig (Klartextübertragung) | ❌ Priorität: HTTPS |

| Aufruf über VPN/Standleitung | Hoch (Verschlüsselung auf VPN-Ebene) | ✅ Empfohlen: HTTP |

Best Practices:

- Interne Umgebungen: Nutzen Sie die HTTP-Schnittstelle für maximale Performance.

- Öffentliche Umgebungen: Wenn hohe Sicherheitsanforderungen bestehen, nutzen Sie HTTPS. Wenn Stabilität Priorität hat, nutzen Sie HTTP und wechseln Sie regelmäßig den API-Key.

- Hybridumgebungen: Verwenden Sie HTTP für unkritische Eingabeaufforderungen und HTTPS für sensible Inhalte.

Q3: Benötigen auch 1K- und 2K-Bilder ein Timeout von 300 Sekunden?

Empfohlene Einstellungen:

Obwohl die tatsächliche Generierungszeit für 1K- und 2K-Bilder normalerweise zwischen 30 und 120 Sekunden liegt, empfehlen wir dennoch einen Timeout von 300 Sekunden aus folgenden Gründen:

- Netzwerkschwankungen: Selbst bei kurzer Generierungszeit kann die Netzwerklatenz um 30–50 Sekunden ansteigen.

- Einfluss von Stoßzeiten: Die Ereignisse vom 17.01.2026 haben gezeigt, dass sich die Generierungszeit im Extremfall verdoppeln kann.

- Ausreichend Puffer: Ein Timeout von 300 Sekunden verursacht keine zusätzlichen Kosten, vermeidet aber unnötige Wiederholungsversuche.

Testergebnisse (Statistiken der APIYI-Plattform):

| Auflösung | P50 (Median) | P95 (95. Perzentil) | P99 (99. Perzentil) | Empfohlener Timeout |

|---|---|---|---|---|

| 1K | 45 Sek. | 90 Sek. | 150 Sek. | 300 Sek. |

| 2K | 65 Sek. | 120 Sek. | 180 Sek. | 300 Sek. |

| 4K | 120 Sek. | 170 Sek. | 250 Sek. | 600 Sek. |

Fazit: Mit 300 Sekunden für 1K/2K und 600 Sekunden für 4K decken Sie über 99 % aller Szenarien ab.

Q4: Wie lässt sich feststellen, ob es sich um ein Timeout-Problem oder eine API-Überlastung handelt?

Unterscheidungsmethoden:

| Fehlertyp | Typische Fehlermeldung | HTTP-Statuscode | Wiederholbar? |

|---|---|---|---|

| Timeout-Fehler | ReadTimeout, Connection timeout |

Keine (Client-Fehler) | ✅ Ja |

| API-Überlastung | The model is overloaded |

503 oder 429 | ✅ Ja (nach Wartezeit) |

| API nicht verfügbar | The service is currently unavailable |

503 | ✅ Ja (nach Wartezeit) |

| Authentifizierungsfehler | Invalid API key |

401 | ❌ Nein (Key prüfen) |

Merkmale von Timeout-Fehlern:

except requests.exceptions.Timeout:

# Client-Timeout, keine Antwort vom Server erhalten

print("Anfrage-Timeout")

except requests.exceptions.HTTPError as e:

if e.response.status_code == 503:

# Server liefert 503, explizite Überlastung

print("API überlastet")

Entscheidungsprozess:

- Wenn der Ausnahmetyp

Timeoutist, liegt ein Zeitüberschreitungsproblem vor → Timeout erhöhen oder HTTP-Schnittstelle nutzen. - Wenn eine HTTP-Antwort mit dem Statuscode 503/429 eingeht, ist die API überlastet → Warten oder zu einem anderen API-Anbieter wechseln.

- Wenn der Antwortinhalt "overloaded" enthält, fehlen Google die Rechenressourcen → Erwägen Sie die Nutzung von Backup-Modellen auf APIYI (z. B. Seedream 4.5).

Zusammenfassung

Die Kernpunkte zur Vermeidung von Verbindungsabbrüchen bei der Nano Banana Pro API:

- Timeout-Konfiguration: Empfohlen werden 300 Sekunden für 1K/2K und 600 Sekunden für 4K, um Netzwerkschwankungen und Stoßzeiten abzufedern.

- HTTP/2-Problematik: HTTP/2 kann bei Langzeitverbindungen Probleme wie TCP-Head-of-Line-Blocking und Erschöpfung der Stream-Identifier verursachen. Die erzwungene Nutzung von HTTP/1.1 wird empfohlen.

- Vorteile des HTTP-Ports: Die HTTP-Schnittstelle von APIYI (http://api.apiyi.com:16888/v1) vermeidet TLS-Handshake-Overhead und HTTP/2-Aushandlung, was die Stabilität erhöht.

- Retry-Strategie: Implementieren Sie Timeout-Wiederholungen mit exponentiellem Backoff, um temporäre Netzwerkschwankungen abzufangen.

- Plattform-Optimierung: Die APIYI-Plattform bietet optimierte Timeout-Einstellungen, intelligentes Retry und Abrechnungskompensation, was die Erfolgsquote bei der 4K-Bildgenerierung deutlich steigert.

Wir empfehlen die schnelle Integration der Nano Banana Pro API über APIYI (apiyi.com). Die Plattform bietet speziell optimierte HTTP-Port-Schnittstellen, vorkonfigurierte Timeouts und unterstützt die Bildgenerierung in allen Auflösungen von 1K bis 4K – ideal für den Einsatz in Produktionsumgebungen.

Autor: APIYI-Technikteam | Bei technischen Fragen besuchen Sie APIYI (apiyi.com) für weitere Lösungen zur Integration von KI-Modellen.