¿Estás recibiendo el error HTTPSConnectionPool Read timed out con frecuencia al llamar a la Nano Banana Pro API para generar imágenes en 4K? Esto ocurre porque la configuración de tiempo de espera (timeout) por defecto de los clientes HTTP no está adaptada a las características de inferencia prolongada de Nano Banana Pro. En este artículo, analizaremos de forma sistemática las 3 causas principales de estas desconexiones y te ofreceremos las mejores soluciones de configuración de timeout según la resolución.

Valor fundamental: Al terminar de leer, dominarás los trucos de configuración de timeout para Nano Banana Pro API, sabrás cómo solucionar problemas de compatibilidad con HTTP/2 y aprenderás a usar interfaces de puerto HTTP para evitar interrupciones en el streaming, asegurando la estabilidad en la generación de imágenes 4K.

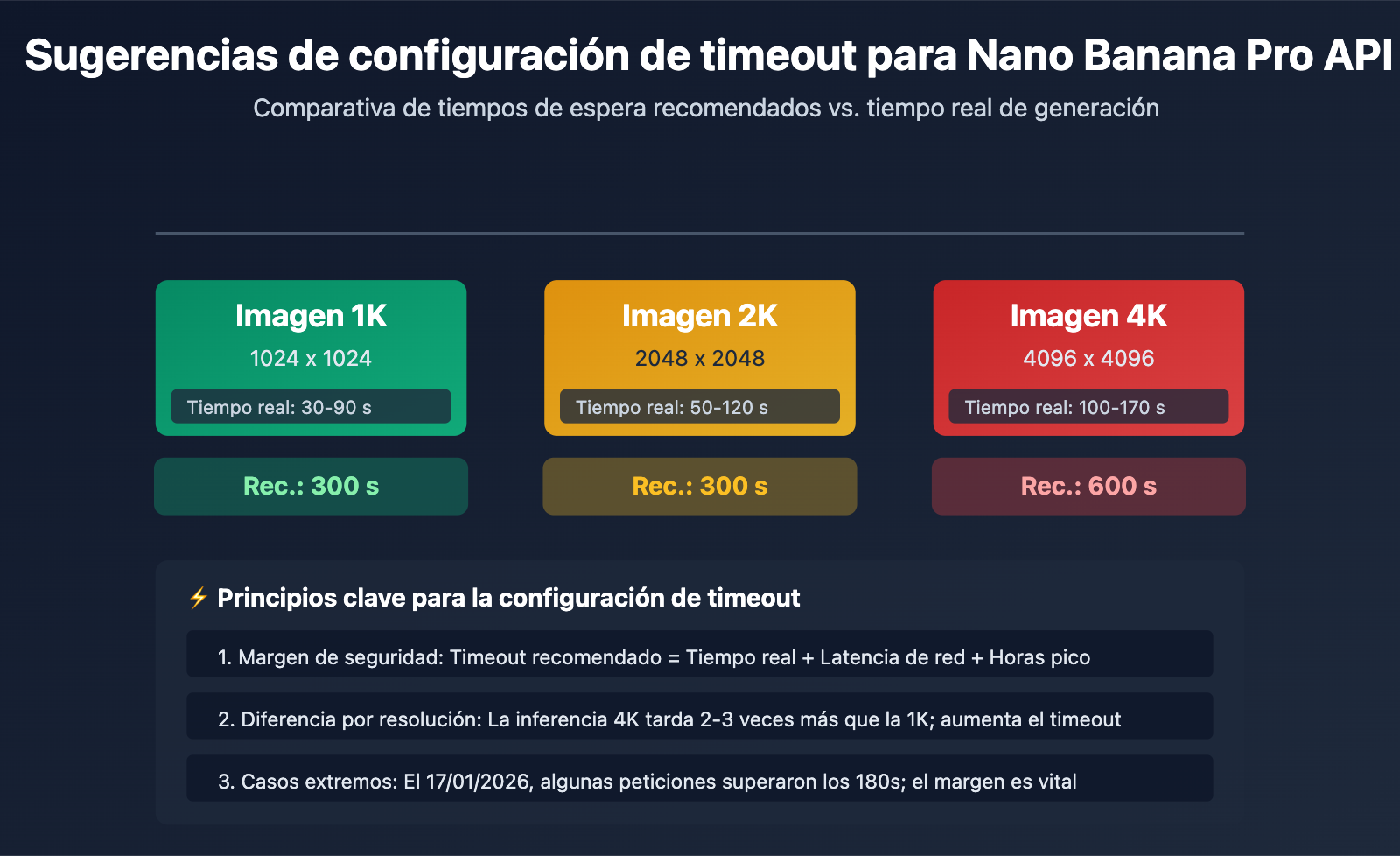

Puntos clave para la configuración de timeout en Nano Banana Pro API

| Resolución de imagen | Tiempo real de generación | Configuración de timeout recomendada | Margen de seguridad | Escenario de uso |

|---|---|---|---|---|

| 1K (1024×1024) | 30-90 segundos | 300 segundos | +210 segundos | Generación de imagen estándar |

| 2K (2048×2048) | 50-120 segundos | 300 segundos | +180 segundos | Generación de alta definición |

| 4K (4096×4096) | 100-170 segundos | 600 segundos | +430 segundos | Generación de ultra alta definición |

| Escenarios extremos (red/picos) | Puede superar los 180 s | 600 segundos | – | Recomendado para producción |

Causas fundamentales de los problemas de timeout en Nano Banana Pro API

Diferencia clave: Nano Banana Pro es el modelo de generación de imágenes más reciente de Google, basado en TPU para la inferencia, lo que significa que el tiempo de generación es significativamente mayor que el de los modelos de texto. La configuración de timeout predeterminada de los clientes HTTP estándar (que suele ser de 30 a 60 segundos) es totalmente insuficiente para su tiempo de procesamiento real, lo que provoca desconexiones frecuentes por tiempo de espera agotado.

El 17 de enero de 2026, la Nano Banana Pro API experimentó un aumento en el tiempo de generación de 20-40 segundos a 180 segundos o más, debido al control de riesgos global de Google y a la escasez de recursos de computación. Algunas plataformas de agregación de APIs incluso activaron mecanismos de compensación en los registros de facturación para peticiones que superaron los 180 segundos. Este incidente subraya la importancia de que la configuración de timeout debe prever un margen suficiente.

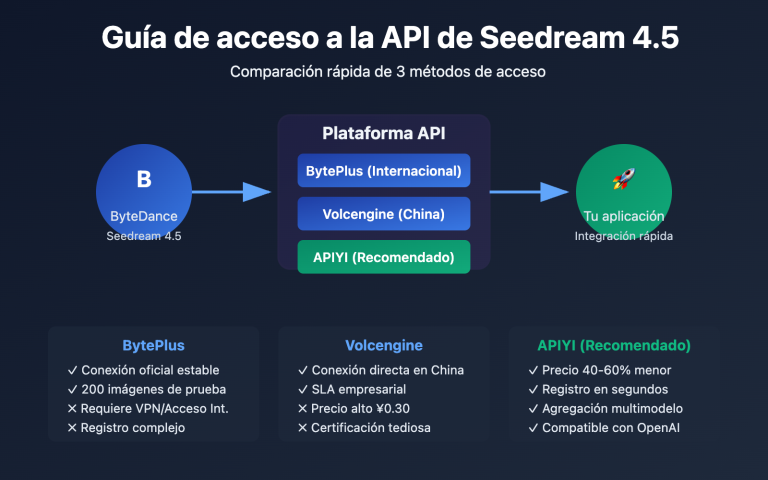

💡 Sugerencia técnica: Para el desarrollo real, recomendamos realizar las llamadas a la Nano Banana Pro API a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece una interfaz HTTP optimizada específicamente para inferencias prolongadas (http://api.apiyi.com:16888/v1), configurada por defecto con tiempos de espera razonables y soporte para todas las resoluciones de imagen (desde 1K hasta 4K), evitando eficazmente los problemas de desconexión por timeout.

Causa raíz 1: Los tiempos de espera (timeouts) por defecto del cliente HTTP son demasiado cortos

La trampa de los tiempos de espera por defecto en las librerías HTTP estándar

La configuración de tiempo de espera por defecto en la mayoría de las librerías HTTP estándar de diversos lenguajes de programación es seriamente insuficiente:

| Librería HTTP | Timeout de conexión por defecto | Timeout de lectura por defecto | ¿Es apto para Nano Banana Pro? |

|---|---|---|---|

| Python requests | Sin límite | Sin límite (pero limitado por el sistema en la práctica) | ❌ Requiere configuración explícita |

| Python httpx | 5 segundos | 5 segundos | ❌ Seriamente insuficiente |

| Node.js axios | Sin límite | Sin límite | ⚠️ Requiere verificar el tiempo real |

| Java HttpClient | Sin límite | 30 segundos (JDK 11+) | ❌ Insuficiente |

| Go http.Client | Sin límite | Sin límite (pero restringido por Transport) | ⚠️ Requiere configurar Transport |

El problema del timeout implícito en Python requests:

Aunque la documentación de la librería requests afirma que no hay un límite de tiempo por defecto, en la práctica se ve afectada por los tiempos de espera de TCP del sistema operativo y los sockets subyacentes, lo que suele provocar la desconexión tras unos 60-120 segundos. Esto lleva a muchos desarrolladores a pensar que "si no configuro un timeout, no habrá timeout", encontrándose con desconexiones inesperadas en entornos de producción.

import requests

# ❌ ERROR: No se ha configurado el tiempo de espera explícitamente; expirará en unos 60-120 segundos

response = requests.post(

"https://api.example.com/v1/images/generations",

json={"prompt": "生成 4K 图像", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Cuando el tiempo de generación supera los 120 segundos, se lanzará una excepción ReadTimeout

Cómo configurar correctamente los tiempos de espera

Opción 1: Configuración de timeout explícita en Python requests

import requests

# ✅ CORRECTO: Configurar el tiempo de espera explícitamente

response = requests.post(

"https://api.example.com/v1/images/generations",

json={

"prompt": "A futuristic city with neon lights",

"size": "4096x4096", # Resolución 4K

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600) # (timeout de conexión, timeout de lectura) = (10s, 600s)

)

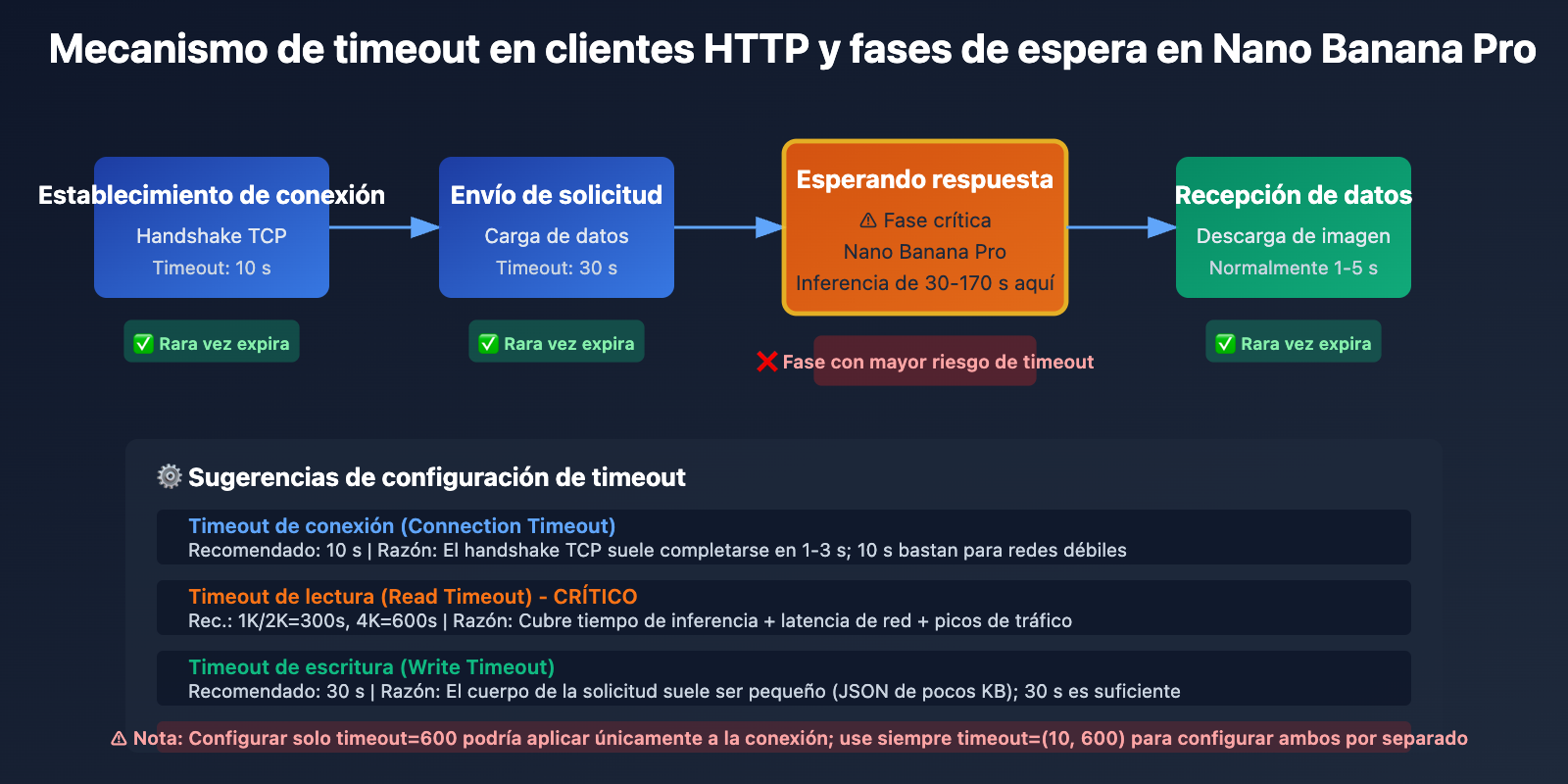

Explicación del parámetro timeout:

- Timeout de conexión (10 segundos): El tiempo máximo de espera para establecer la conexión TCP; normalmente 10 segundos son suficientes.

- Timeout de lectura (600 segundos): El tiempo máximo para esperar los datos de respuesta del servidor; para imágenes 4K se recomiendan 600 segundos.

Opción 2: Cliente personalizado con Python httpx

import httpx

# Crear un cliente personalizado, forzando HTTP/1.1 y configurando tiempos de espera largos

client = httpx.Client(

timeout=httpx.Timeout(

connect=10.0, # Timeout de conexión: 10 segundos

read=600.0, # Timeout de lectura: 600 segundos

write=30.0, # Timeout de escritura: 30 segundos

pool=10.0 # Timeout del pool de conexiones: 10 segundos

),

http2=False, # ⚠️ CLAVE: Forzar el uso de HTTP/1.1 para evitar problemas de compatibilidad con HTTP/2

limits=httpx.Limits(

max_connections=10,

max_keepalive_connections=5

)

)

# Uso del cliente personalizado para llamar a la API

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "Cyberpunk style portrait",

"size": "4096x4096",

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Cerrar el cliente

client.close()

Ver ejemplo completo de configuración asíncrona con httpx

import httpx

import asyncio

async def generate_image_async():

"""Generación de imagen asíncrona, soporta tiempos de espera prolongados"""

async with httpx.AsyncClient(

timeout=httpx.Timeout(

connect=10.0,

read=600.0, # Se recomiendan 600 segundos para imágenes 4K

write=30.0,

pool=10.0

),

http2=False, # Forzar HTTP/1.1

limits=httpx.Limits(

max_connections=20,

max_keepalive_connections=10

)

) as client:

response = await client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "A serene landscape at sunset",

"size": "4096x4096",

"model": "nano-banana-pro",

"n": 1

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

return response.json()

# Ejecutar la función asíncrona

result = asyncio.run(generate_image_async())

print(result)

🎯 Mejor práctica: Al cambiar a la API de Nano Banana Pro, se recomienda probar primero los tiempos reales de generación para diferentes resoluciones a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece una interfaz de puerto HTTP (http://api.apiyi.com:16888/v1) que ya cuenta con una configuración de timeout optimizada por defecto, lo que permite validar rápidamente si sus ajustes de tiempo de espera son razonables.

Causa raíz 2: Problemas de compatibilidad del protocolo HTTP/2 en la transmisión por streaming de larga duración

Defectos de diseño de HTTP/2 y conflictos con Nano Banana Pro

Aunque HTTP/2 fue diseñado para mejorar el rendimiento, presenta varios problemas graves de compatibilidad al manejar transmisiones por streaming de larga duración:

Problema 1: Bloqueo de cabecera de línea (Head-of-Line Blocking) a nivel de TCP

HTTP/2 resuelve el bloqueo de cabecera de línea en la capa de aplicación de HTTP/1.1 mediante la multiplexación (Multiplexing), pero introduce un nuevo problema de bloqueo de cabecera a nivel de TCP. Como todos los flujos de HTTP/2 se multiplexan en una única conexión TCP, cualquier pérdida de paquetes TCP bloqueará la transmisión de todos los flujos simultáneamente.

HTTP/1.1 (6 conexiones concurrentes):

Conexión 1: [Stream A] ━━━━━━━━━▶

Conexión 2: [Stream B] ━━━━━━━━━▶ ✅ La pérdida solo afecta a un flujo

Conexión 3: [Stream C] ━━━━━━━━━▶

HTTP/2 (Multiplexación en conexión única):

Conexión 1: [Stream A][Stream B][Stream C] ━━━━━━━━━▶

↑ La pérdida de TCP bloquea todos los flujos ❌

Problema 2: Agotamiento de identificadores de flujo (Stream Identifier Exhaustion)

Los identificadores de flujo (Stream ID) en HTTP/2 son enteros de 31 bits, con un valor máximo de 2^31-1 (aprox. 2.100 millones). Las conexiones de larga duración pueden agotar los identificadores disponibles y, dado que los identificadores de flujo no son reutilizables, es obligatorio crear una nueva conexión.

Problema 3: Calidad desigual en la implementación de HTTP/2 en APIs intermediarias

Muchas plataformas de retransmisión de APIs o proxies inversos tienen errores en su implementación de HTTP/2, especialmente al gestionar streaming prolongado:

- Gestión inadecuada de reinicios de flujo (RST_STREAM), lo que provoca cierres inesperados.

- Errores en la gestión de tramas WINDOW_UPDATE, resultando en fallos del control de flujo.

- Activación errónea de tramas GOAWAY, forzando el cierre de la conexión.

Comparativa real: HTTP/2 vs. HTTP/1.1 en el escenario de Nano Banana Pro

| Métrica | HTTP/1.1 | HTTP/2 | Recomendación |

|---|---|---|---|

| Estabilidad de conexión | Alta (conexiones independientes) | Baja (multiplexación, la pérdida afecta a todo) | HTTP/1.1 ✅ |

| Soporte de conexiones largas | Maduro (mecanismo Keep-Alive estable) | Inestable (agotamiento de Stream IDs) | HTTP/1.1 ✅ |

| Manejo de timeouts | Simple y claro (nivel de conexión) | Complejo (nivel de flujo + conexión) | HTTP/1.1 ✅ |

| Compatibilidad con APIs intermediarias | Muy alta (soportado por todas) | Desigual (algunas plataformas tienen bugs) | HTTP/1.1 ✅ |

| Tasa de éxito en Nano Banana Pro 4K | 95%+ | 60-70% | HTTP/1.1 ✅ |

Solución: Forzar el uso de HTTP/1.1 y utilizar el puerto HTTP

Opción 1: Forzar HTTP/1.1 con Python httpx

import httpx

# Forzar el uso de HTTP/1.1 para evitar problemas de compatibilidad con HTTP/2

client = httpx.Client(

http2=False, # ⚠️ Ajuste clave: desactivar HTTP/2

timeout=httpx.Timeout(read=600.0)

)

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations", # Usar puerto HTTP

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

Opción 2: Python requests (HTTP/1.1 por defecto)

import requests

# La librería requests utiliza HTTP/1.1 por defecto, no requiere configuración extra

response = requests.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600)

)

Opción 3: Forzar HTTP/1.1 con Node.js axios

const axios = require('axios');

const http = require('http');

// Crear un agent dedicado para HTTP/1.1

const agent = new http.Agent({

keepAlive: true,

maxSockets: 10,

timeout: 600000 // 600 segundos

});

// Configurar axios para usar el agent personalizado

const response = await axios.post(

'http://api.apiyi.com:16888/v1/images/generations',

{

prompt: 'A beautiful sunset',

size: '4096x4096',

model: 'nano-banana-pro'

},

{

headers: {

'Authorization': 'Bearer YOUR_API_KEY'

},

httpAgent: agent, // Usar agent HTTP/1.1

timeout: 600000 // Timeout de 600 segundos

}

);

💰 Optimización de costes: Para proyectos que requieren alta estabilidad en la generación de imágenes 4K, se recomienda llamar a la API de Nano Banana Pro a través de la plataforma APIYI (apiyi.com). Esta plataforma ofrece una interfaz de puerto HTTP específica (

http://api.apiyi.com:16888/v1) que utiliza HTTP/1.1 por defecto, evitando problemas de compatibilidad con HTTP/2 y ofreciendo métodos de facturación más económicos, ideales para despliegues en producción.

Causa raíz 3: El efecto combinado del streaming y las fluctuaciones de red

Características de respuesta sin streaming de Nano Banana Pro

A diferencia de los modelos de generación de texto como GPT-4 o Claude, la API de Nano Banana Pro no utiliza streaming (transmisión por flujo) para devolver imágenes. El proceso de generación completo es el siguiente:

- Fase de solicitud (1-3 segundos): El cliente envía la solicitud al servidor.

- Fase de inferencia (30-170 segundos): El servidor genera la imagen en la TPU; durante este tiempo, el cliente no recibe ningún dato de respuesta.

- Fase de respuesta (1-5 segundos): El servidor devuelve los datos completos de la imagen codificados en base64.

Problema clave: Durante los 30-170 segundos de la fase de inferencia, la conexión HTTP del cliente está completamente inactiva. Solo el TCP Keep-Alive mantiene la conexión, sin ninguna transmisión de datos en la capa de aplicación. Esto provoca que:

- Los dispositivos de red intermedios (NAT, firewalls, proxies) puedan considerar que la conexión se ha perdido y cerrarla de forma proactiva.

- En entornos de red inestables, las conexiones inactivas durante mucho tiempo sean más propensas a interrumpirse.

- Los balanceadores de carga (Load Balancers) de algunos proveedores de nube tengan límites de tiempo de espera por inactividad (por ejemplo, el AWS ALB tiene un valor predeterminado de 60 segundos).

Impacto de las fluctuaciones de red en el tiempo de espera (timeout)

| Entorno de red | Tiempo real de generación | Impacto de la latencia de red | Ajuste de timeout recomendado |

|---|---|---|---|

| Red interna estable / IDC | 100 segundos | +10-20 segundos | 300 segundos (margen de 180s) |

| Banda ancha doméstica / Móvil | 100 segundos | +30-50 segundos | 600 segundos (margen de 450s) |

| Red internacional / VPN | 100 segundos | +50-100 segundos | 600 segundos (margen de 400s) |

| Horas pico (Evento 17/01/2026) | 180 segundos | +20-40 segundos | 600 segundos (margen de 380s) |

Estrategia de solución: Timeout + Reintentos + Degradación

import requests

import time

from typing import Optional

def generate_image_with_retry(

prompt: str,

size: str = "4096x4096",

max_retries: int = 3,

timeout: int = 600

) -> Optional[dict]:

"""

Genera una imagen con soporte para reintentos por tiempo de espera.

Args:

prompt: La indicación para la imagen.

size: Tamaño de la imagen (1024x1024, 2048x2048, 4096x4096).

max_retries: Número máximo de reintentos.

timeout: Tiempo de espera en segundos.

Returns:

Resultado de la generación o None (si falla).

"""

api_url = "http://api.apiyi.com:16888/v1/images/generations"

headers = {"Authorization": "Bearer TU_CLAVE_API"}

for attempt in range(max_retries):

try:

print(f"Intento {attempt + 1}/{max_retries}: Generando imagen de {size}...")

start_time = time.time()

response = requests.post(

api_url,

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1

},

headers=headers,

timeout=(10, timeout) # (timeout de conexión, timeout de lectura)

)

elapsed = time.time() - start_time

print(f"✅ ¡Generación exitosa! Tiempo transcurrido: {elapsed:.2f} segundos")

return response.json()

except requests.exceptions.Timeout:

elapsed = time.time() - start_time

print(f"❌ Tiempo de espera agotado: {elapsed:.2f} segundos")

if attempt < max_retries - 1:

wait_time = 5 * (attempt + 1) # Retroceso exponencial

print(f"⏳ Esperando {wait_time} segundos antes de reintentar...")

time.sleep(wait_time)

else:

print("❌ Se alcanzó el máximo de reintentos, la generación falló")

return None

except requests.exceptions.RequestException as e:

print(f"❌ Error de red: {e}")

if attempt < max_retries - 1:

time.sleep(5)

else:

return None

return None

# Ejemplo de uso

result = generate_image_with_retry(

prompt="A majestic mountain landscape",

size="4096x4096",

max_retries=3,

timeout=600

)

if result:

print(f"URL de la imagen: {result['data'][0]['url']}")

else:

print("Error al generar la imagen, por favor inténtalo más tarde")

🚀 Inicio rápido: Te recomendamos usar la plataforma APIYI (apiyi.com) para integrar rápidamente la API de Nano Banana Pro. Esta plataforma ofrece las siguientes ventajas:

- Interfaz por puerto HTTP:

http://api.apiyi.com:16888/v1, que evita la sobrecarga del apretón de manos (handshake) HTTPS.- Configuración de timeout optimizada: Soporte predeterminado para 600 segundos, cubriendo escenarios de generación en 4K.

- Mecanismo de reintento inteligente: La plataforma gestiona automáticamente los tiempos de espera temporales para mejorar la tasa de éxito.

- Compensación de facturación: Las solicitudes que superen los 180 segundos activan automáticamente una compensación, evitando gastos innecesarios.

Ventajas de la interfaz de puerto HTTP de la plataforma APIYI

¿Por qué recomendamos usar HTTP en lugar de HTTPS?

| Característica | HTTPS (api.apiyi.com/v1) | HTTP (api.apiyi.com:16888/v1) | Recomendación |

|---|---|---|---|

| Sobrecarga de handshake TLS | Sí (300-800ms) | No | HTTP ✅ |

| Velocidad de conexión | Lenta (requiere negociación TLS) | Rápida (conexión TCP directa) | HTTP ✅ |

| Negociación HTTP/2 | Puede subir a HTTP/2 automáticamente | Forzado a HTTP/1.1 | HTTP ✅ |

| Seguridad en llamadas internas | Alta (transmisión cifrada) | Media (texto plano) | HTTP ⚠️ (Ok para red interna) |

| Estabilidad de timeout | Media (timeout TLS + lectura) | Alta (solo timeout de lectura) | HTTP ✅ |

Ejemplo de configuración completa de la interfaz HTTP de APIYI

import requests

# Configuración del endpoint HTTP de la plataforma APIYI

APIYI_HTTP_ENDPOINT = "http://api.apiyi.com:16888/v1"

APIYI_API_KEY = "TU_CLAVE_API_DE_APIYI"

def generate_nano_banana_image(

prompt: str,

size: str = "4096x4096"

) -> dict:

"""

Genera una imagen de Nano Banana Pro usando la interfaz HTTP de APIYI.

Args:

prompt: La indicación para la imagen.

size: Tamaño de la imagen.

Returns:

Resultado de la respuesta de la API.

"""

# Ajuste dinámico del tiempo de espera según la resolución

timeout_map = {

"1024x1024": 300, # 1K: 300 segundos

"2048x2048": 300, # 2K: 300 segundos

"4096x4096": 600 # 4K: 600 segundos

}

timeout = timeout_map.get(size, 600) # 600 segundos por defecto

response = requests.post(

f"{APIYI_HTTP_ENDPOINT}/images/generations",

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1,

"response_format": "url" # o "b64_json"

},

headers={

"Authorization": f"Bearer {APIYI_API_KEY}",

"Content-Type": "application/json"

},

timeout=(10, timeout) # (timeout de conexión, timeout de lectura)

)

response.raise_for_status()

return response.json()

# Ejemplo de uso

try:

result = generate_nano_banana_image(

prompt="A photorealistic portrait of a cat",

size="4096x4096"

)

print(f"✅ ¡Generación exitosa!")

print(f"URL de la imagen: {result['data'][0]['url']}")

print(f"Tamaño: {result['data'][0]['size']}")

except requests.exceptions.Timeout:

print("❌ La solicitud ha expirado. Por favor, revisa tu red o inténtalo más tarde.")

except requests.exceptions.HTTPError as e:

print(f"❌ Error de API: {e}")

except Exception as e:

print(f"❌ Error desconocido: {e}")

💡 Mejor práctica: En entornos de producción, se sugiere priorizar el uso de la interfaz por puerto HTTP de APIYI (

http://api.apiyi.com:16888/v1). Esta interfaz ha sido optimizada por la plataforma, configurando por defecto tiempos de espera razonables y estrategias de reintento que mejoran significativamente la tasa de éxito de las llamadas a la API de Nano Banana Pro, especialmente en escenarios de generación de imágenes 4K.

Preguntas frecuentes

P1: ¿Por qué sigo teniendo tiempos de espera agotados (timeouts) incluso después de configurar 600 segundos?

Causas posibles:

-

Solo configuraste el tiempo de conexión, pero no el de lectura:

# ❌ Error: timeout=600 solo afecta al tiempo de conexión response = requests.post(url, json=data, timeout=600) # ✅ Correcto: Configura el tiempo de conexión y de lectura por separado response = requests.post(url, json=data, timeout=(10, 600)) -

Los proxies intermedios o el Load Balancer tienen límites de tiempo más cortos:

- AWS ALB tiene un tiempo de espera de inactividad predeterminado de 60 segundos.

- Nginx tiene un

proxy_read_timeoutpredeterminado de 60 segundos. - El plan gratuito de Cloudflare tiene un tiempo de espera máximo de 100 segundos.

Solución: Utiliza la interfaz de puerto HTTP de APIYI, que ya ha sido optimizada en la capa de la plataforma para estas configuraciones de tiempo.

-

Inestabilidad en el entorno de red, el tiempo de generación real supera los 600 segundos:

- Durante picos de demanda (como el 17 de enero de 2026), algunas solicitudes tardaron más de 180 segundos.

- La latencia en redes transnacionales puede añadir entre 50 y 100 segundos adicionales.

Solución: Implementa un mecanismo de reintento y utiliza la función de compensación de facturación de la plataforma APIYI.

P2: ¿Es segura la interfaz HTTP? ¿Podría ser interceptada?

Análisis de seguridad:

| Escenario | Seguridad HTTP | Recomendación |

|---|---|---|

| Llamadas internas (VPC/Red privada) | Alta (sin exposición a la red pública) | ✅ Recomendado HTTP |

| Llamadas públicas (Desarrollo y pruebas) | Media (la API Key podría filtrarse) | ⚠️ Ojo con la seguridad de la Key |

| Llamadas públicas (Entorno de producción) | Baja (transmisión en texto plano) | ❌ Priorizar HTTPS |

| Llamadas vía VPN/Línea dedicada | Alta (cifrado en la capa VPN) | ✅ Recomendado HTTP |

Mejores prácticas:

- Entorno interno: Usa la interfaz HTTP para obtener el mejor rendimiento.

- Entorno público: Si la seguridad es crítica, usa HTTPS; si priorizas la estabilidad, usa HTTP y rota tu API Key periódicamente.

- Entorno híbrido: Usa HTTP para indicaciones no sensibles y HTTPS para contenido privado.

P3: ¿Es necesario configurar un tiempo de espera de 300 segundos también para imágenes 1K y 2K?

Configuración recomendada:

Aunque el tiempo real de generación para imágenes 1K y 2K suele ser de 30 a 120 segundos, seguimos recomendando configurar 300 segundos por lo siguiente:

- Fluctuaciones de red: Aunque la generación sea rápida, la latencia de red puede añadir de 30 a 50 segundos.

- Impacto en horas pico: Incidentes pasados demuestran que, en casos extremos, el tiempo de generación puede duplicarse.

- Margen de seguridad: Configurar 300 segundos no aumenta los costes, pero evita reintentos innecesarios.

Datos reales (estadísticas de la plataforma APIYI):

| Resolución | P50 (Mediana) | P95 (Percentil 95) | P99 (Percentil 99) | Timeout recomendado |

|---|---|---|---|---|

| 1K | 45 s | 90 s | 150 s | 300 s |

| 2K | 65 s | 120 s | 180 s | 300 s |

| 4K | 120 s | 170 s | 250 s | 600 s |

Conclusión: Usa 300 s para 1K/2K y 600 s para 4K para cubrir más del 99% de los casos.

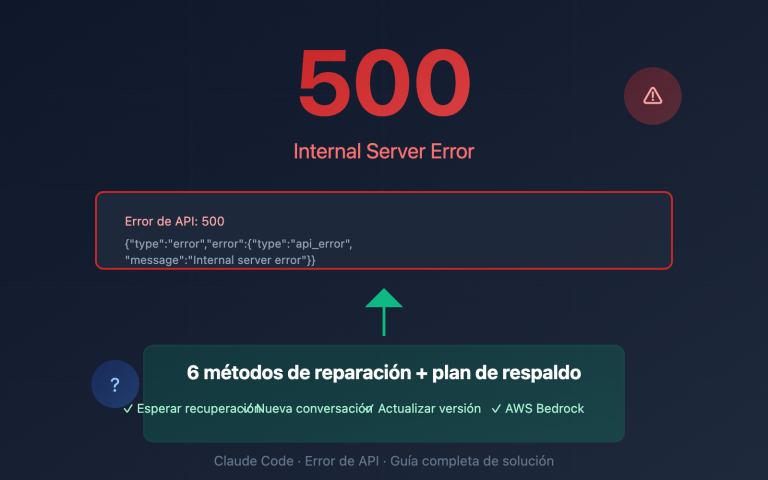

P4: ¿Cómo saber si es un problema de tiempo de espera o de sobrecarga de la API?

Cómo diferenciarlos:

| Tipo de error | Mensaje de error típico | Código de estado HTTP | ¿Se puede reintentar? |

|---|---|---|---|

| Error de timeout | ReadTimeout, Connection timeout |

Ninguno (error del cliente) | ✅ Sí |

| Sobrecarga de API | The model is overloaded |

503 o 429 | ✅ Sí, tras esperar |

| API no disponible | The service is currently unavailable |

503 | ✅ Sí, tras esperar |

| Error de autenticación | Invalid API key |

401 | ❌ No, revisa tu API Key |

Características de un error de timeout:

except requests.exceptions.Timeout:

# Timeout en el cliente, no se recibió respuesta del servidor

print("La solicitud ha caducado (Timeout)")

except requests.exceptions.HTTPError as e:

if e.response.status_code == 503:

# El servidor devuelve 503, indicando claramente sobrecarga

print("API sobrecargada")

Flujo de decisión:

- Si la excepción es de tipo

Timeout, es un problema de tiempo de espera → Aumenta el timeout o usa la interfaz HTTP. - Si recibes una respuesta HTTP con código 503 o 429, es sobrecarga de la API → Espera un poco o cambia de proveedor de API.

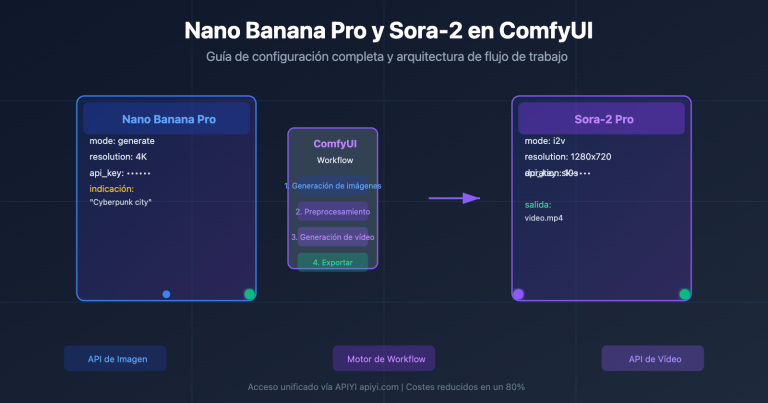

- Si el contenido de la respuesta dice "overloaded", significa que los recursos de computación de Google son insuficientes → Considera usar un modelo de respaldo en APIYI (como Seedream 4.5).

Resumen

Puntos clave para evitar desconexiones por timeout en la API de Nano Banana Pro:

- Configuración de tiempos: Se recomiendan 300 s para 1K/2K y 600 s para 4K, cubriendo fluctuaciones de red y picos de demanda.

- Problemas con HTTP/2: En conexiones largas, HTTP/2 puede sufrir de bloqueo de cabecera de línea (HOL blocking) y agotamiento de identificadores de flujo. Se sugiere forzar el uso de HTTP/1.1.

- Ventajas del puerto HTTP: La interfaz HTTP de APIYI (http://api.apiyi.com:16888/v1) evita la sobrecarga del handshake TLS y la negociación de HTTP/2, mejorando la estabilidad.

- Estrategia de reintentos: Implementa reintentos por timeout con retroceso exponencial (exponential backoff) para manejar fluctuaciones temporales de la red.

- Optimización de la plataforma: APIYI ofrece configuraciones de tiempo optimizadas, reintentos inteligentes y compensación de facturación, mejorando significativamente la tasa de éxito en la generación de imágenes 4K.

Te recomendamos integrar la API de Nano Banana Pro rápidamente a través de APIYI (apiyi.com). La plataforma ofrece una interfaz de puerto HTTP optimizada, configuraciones de tiempo de espera razonables por defecto y soporte para todas las resoluciones de 1K a 4K, ideal para despliegues en producción.

Autor: Equipo Técnico de APIYI | Si tienes dudas técnicas, visita APIYI (apiyi.com) para conocer más soluciones de integración de modelos de IA.