Vous rencontrez fréquemment l'erreur HTTPSConnectionPool Read timed out lors de l'appel à l'API Nano Banana Pro pour générer des images 4K ? C'est parce que les paramètres de délai d'expiration (timeout) par défaut des clients HTTP ne sont pas adaptés aux caractéristiques d'inférence prolongée de Nano Banana Pro. Cet article analyse de manière systématique les 3 causes profondes de ces déconnexions et propose des configurations de timeout optimales pour différentes résolutions.

Valeur ajoutée : En lisant cet article, vous maîtriserez les astuces de configuration du timeout pour l'API Nano Banana Pro, les solutions aux problèmes de compatibilité HTTP/2, et comment éviter les interruptions de streaming via l'interface du port HTTP pour garantir la stabilité de vos générations d'images 4K.

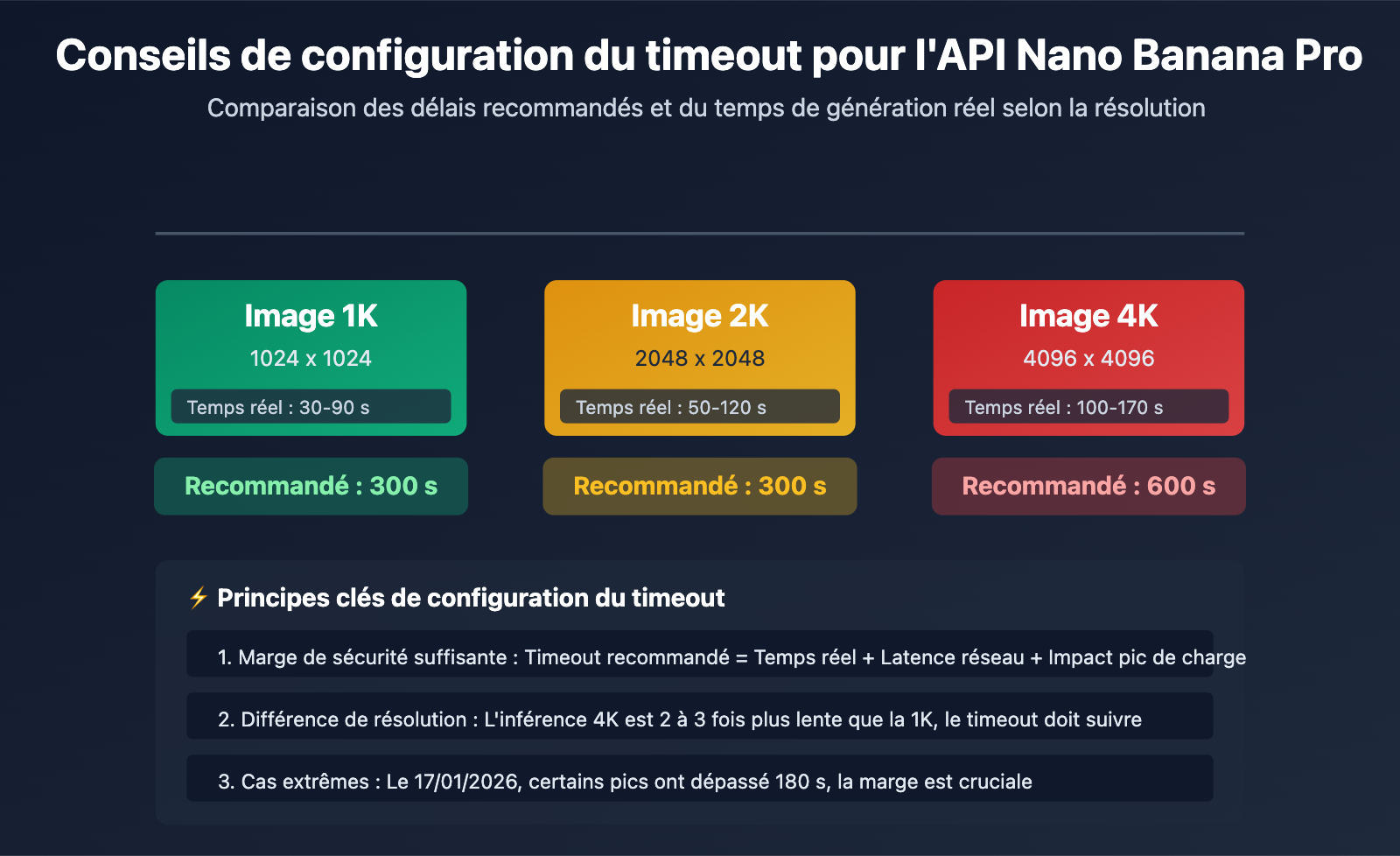

Points clés de la configuration du timeout pour l'API Nano Banana Pro

| Résolution de l'image | Temps de génération réel | Configuration du timeout recommandée | Marge de sécurité | Scénario d'utilisation |

|---|---|---|---|---|

| 1K (1024×1024) | 30-90 s | 300 s | +210 s | Génération d'image standard |

| 2K (2048×2048) | 50-120 s | 300 s | +180 s | Génération d'image HD |

| 4K (4096×4096) | 100-170 s | 600 s | +430 s | Génération d'image Ultra HD |

| Scénarios extrêmes (instabilité réseau/pics) | Peut dépasser 180 s | 600 s | – | Recommandé pour la production |

Les causes profondes des problèmes de timeout de l'API Nano Banana Pro

Différence fondamentale : Nano Banana Pro est le dernier modèle de génération d'images de Google, basé sur l'inférence TPU. Son temps de génération est nettement plus long que celui des modèles de texte. Les paramètres de timeout par défaut des clients HTTP standards (généralement 30 à 60 secondes) sont totalement inadaptés à son temps de traitement réel, ce qui entraîne des déconnexions fréquentes.

Le 17 janvier 2026, l'API Nano Banana Pro a connu une augmentation des temps de génération, passant de 20-40 secondes à 180 secondes ou plus, en raison du contrôle des risques mondial de Google et d'une pénurie de ressources de calcul. Certaines plateformes d'agrégation d'API ont même dû déclencher des mécanismes de compensation de logs de facturation pour les requêtes dépassant 180 secondes. Cet événement souligne l'importance de prévoir une marge suffisante dans vos paramètres de timeout.

💡 Conseil technique : Pour vos développements, nous vous suggérons d'appeler l'API Nano Banana Pro via la plateforme APIYI (apiyi.com). Cette plateforme propose une interface HTTP spécifiquement optimisée pour les inférences longues (http://api.apiyi.com:16888/v1), avec des timeouts configurés par défaut pour supporter les résolutions de 1K à 4K, évitant ainsi efficacement les interruptions.

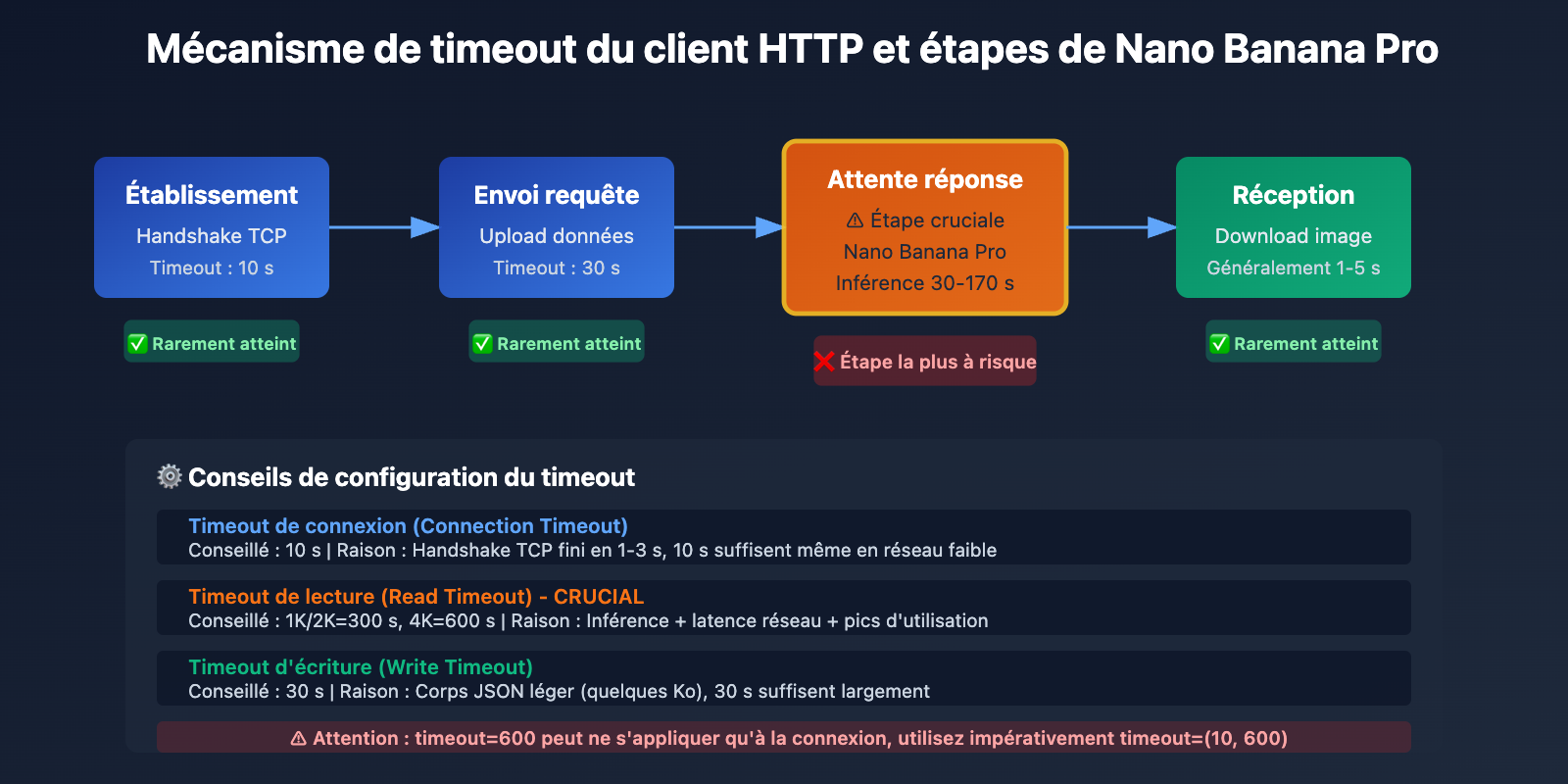

Cause racine 1 : Le délai d'attente (timeout) du client HTTP par défaut est trop court

Le piège des délais par défaut des bibliothèques HTTP standards

Le délai d'attente par défaut des bibliothèques HTTP standards de la plupart des langages de programmation est largement insuffisant :

| Bibliothèque HTTP | Timeout de connexion par défaut | Timeout de lecture par défaut | Adapté à Nano Banana Pro ? |

|---|---|---|---|

| Python requests | Illimité | Illimité (mais limité par le système en pratique) | ❌ Configuration explicite requise |

| Python httpx | 5 secondes | 5 secondes | ❌ Sérieusement insuffisant |

| Node.js axios | Illimité | Illimité | ⚠️ Vérifier le délai réel |

| Java HttpClient | Illimité | 30 secondes (JDK 11+) | ❌ Insuffisant |

| Go http.Client | Illimité | Illimité (mais limité par le Transport) | ⚠️ Configuration du Transport requise |

Le problème du timeout implicite de Python requests :

Bien que la documentation de requests affirme qu'il n'y a pas de limite par défaut, la connexion est en réalité souvent interrompue après 60 à 120 secondes à cause des paramètres TCP du système d'exploitation et des sockets sous-jacents. Cela amène beaucoup de développeurs à penser que "sans configuration, il n'y a pas de timeout", pour finalement subir des déconnexions imprévues en production.

import requests

# ❌ ERREUR : Aucun délai d'attente explicite défini, la connexion sera coupée vers 60-120s par le système

response = requests.post(

"https://api.example.com/v1/images/generations",

json={"prompt": "Générer une image 4K", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Lorsque le temps de génération dépasse 120 s, une exception ReadTimeout est levée

Méthodes de configuration correctes du délai d'attente

Solution 1 : Configuration explicite avec Python requests

import requests

# ✅ CORRECT : Définition explicite du timeout

response = requests.post(

"https://api.example.com/v1/images/generations",

json={

"prompt": "A futuristic city with neon lights",

"size": "4096x4096", # Résolution 4K

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600) # (Timeout de connexion, Timeout de lecture) = (10s, 600s)

)

Explication des paramètres de timeout :

- Timeout de connexion (10 s) : Le temps maximum d'attente pour établir la connexion TCP. Généralement, 10 secondes suffisent largement.

- Timeout de lecture (600 s) : Le temps maximum d'attente pour recevoir les données de réponse du serveur. Pour des images 4K, 600 secondes sont recommandées.

Solution 2 : Client personnalisé avec Python httpx

import httpx

# Créer un client personnalisé, forcer HTTP/1.1 et définir un délai long

client = httpx.Client(

timeout=httpx.Timeout(

connect=10.0, # Timeout de connexion 10 s

read=600.0, # Timeout de lecture 600 s

write=30.0, # Timeout d'écriture 30 s

pool=10.0 # Timeout du pool de connexion 10 s

),

http2=False, # ⚠️ CRUCIAL : Forcer HTTP/1.1 pour éviter les problèmes de compatibilité HTTP/2

limits=httpx.Limits(

max_connections=10,

max_keepalive_connections=5

)

)

# Utiliser le client personnalisé pour appeler l'API

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "Cyberpunk style portrait",

"size": "4096x4096",

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Fermer le client

client.close()

Voir l’exemple complet de configuration httpx asynchrone

import httpx

import asyncio

async def generate_image_async():

"""Génération d'image asynchrone, supporte les longs délais"""

async with httpx.AsyncClient(

timeout=httpx.Timeout(

connect=10.0,

read=600.0, # 600 s recommandées pour les images 4K

write=30.0,

pool=10.0

),

http2=False, # Forcer HTTP/1.1

limits=httpx.Limits(

max_connections=20,

max_keepalive_connections=10

)

) as client:

response = await client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "A serene landscape at sunset",

"size": "4096x4096",

"model": "nano-banana-pro",

"n": 1

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

return response.json()

# Exécuter la fonction asynchrone

result = asyncio.run(generate_image_async())

print(result)

🎯 Meilleure pratique : Lors du passage à l'API Nano Banana Pro, il est conseillé de tester d'abord le temps de génération réel pour différentes résolutions via la plateforme APIYI (apiyi.com). Cette plateforme propose une interface HTTP (http://api.apiyi.com:16888/v1) avec des configurations de timeout optimisées par défaut, permettant de valider rapidement vos propres paramètres.

Cause fondamentale 2 : Problèmes de compatibilité du protocole HTTP/2 dans les transmissions en continu (streaming) de longue durée

Conflits entre les défauts de conception de HTTP/2 et Nano Banana Pro

Bien que l'objectif de conception de HTTP/2 soit d'améliorer les performances, il présente plusieurs problèmes de compatibilité sérieux lors du traitement de flux sur des connexions de longue durée :

Problème 1 : Blocage de tête de ligne (Head-of-Line Blocking) au niveau TCP

HTTP/2 résout le blocage de tête de ligne de la couche application de HTTP/1.1 grâce au multiplexage (Multiplexing), mais il introduit un nouveau problème de blocage au niveau TCP. Tous les flux HTTP/2 sont multiplexés sur une seule connexion TCP ; ainsi, toute perte de paquet TCP bloquera la transmission de tous les flux.

HTTP/1.1 (6 connexions simultanées) :

Connexion 1 : [Flux A] ━━━━━━━━━▶

Connexion 2 : [Flux B] ━━━━━━━━━▶ ✅ La perte de paquets n'affecte qu'un seul flux

Connexion 3 : [Flux C] ━━━━━━━━━▶

HTTP/2 (Multiplexage sur une seule connexion) :

Connexion 1 : [Flux A][Flux B][Flux C] ━━━━━━━━━▶

↑ La perte de paquets TCP bloque tous les flux ❌

Problème 2 : Épuisement des identifiants de flux (Stream Identifier Exhaustion)

L'identifiant de flux (Stream ID) de HTTP/2 est un entier de 31 bits, avec une valeur maximale de 2^31-1 (environ 2,1 milliards). Une connexion de très longue durée peut épuiser les identifiants disponibles, et comme les identifiants de flux ne sont pas réutilisables, il est impératif de créer une nouvelle connexion.

Problème 3 : Qualité inégale des implémentations HTTP/2 des API intermédiaires

De nombreuses plateformes de relais API ou proxys inverses présentent des bugs dans leur implémentation de HTTP/2, particulièrement lors de la gestion de transmissions en continu prolongées :

- Mauvaise gestion de la réinitialisation de flux (RST_STREAM), entraînant des fermetures de connexion inattendues.

- Erreurs de gestion des trames WINDOW_UPDATE, causant l'échec du contrôle de flux.

- Déclenchement erroné des trames GOAWAY, forçant la fermeture de la connexion.

Comparaison réelle : HTTP/2 vs HTTP/1.1 dans le scénario Nano Banana Pro

| Indicateur | HTTP/1.1 | HTTP/2 | Recommandation |

|---|---|---|---|

| Stabilité de la connexion | Haute (connexions indépendantes) | Basse (multiplexage unique, la perte de paquets affecte tout) | HTTP/1.1 ✅ |

| Support des connexions longues | Mature (mécanisme Keep-Alive stable) | Instable (épuisement des identifiants de flux) | HTTP/1.1 ✅ |

| Gestion des délais (Timeout) | Simple et claire (niveau connexion) | Complexe (niveau flux + niveau connexion) | HTTP/1.1 ✅ |

| Compatibilité API intermédiaire | Très haute (toutes plateformes) | Inégale (bugs sur certaines plateformes) | HTTP/1.1 ✅ |

| Taux de réussite Nano Banana Pro 4K | 95%+ | 60-70% | HTTP/1.1 ✅ |

Solution : Forcer l'utilisation de HTTP/1.1 via le port HTTP

Option 1 : Forcer HTTP/1.1 avec Python httpx

import httpx

# Forcer l'utilisation de HTTP/1.1 pour éviter les problèmes de compatibilité HTTP/2

client = httpx.Client(

http2=False, # ⚠️ Paramètre critique : désactiver HTTP/2

timeout=httpx.Timeout(read=600.0)

)

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations", # Utilisation du port HTTP

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer VOTRE_CLE_API"}

)

Option 2 : Python requests (HTTP/1.1 par défaut)

import requests

# La bibliothèque requests utilise HTTP/1.1 par défaut, aucune configuration supplémentaire n'est requise

response = requests.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer VOTRE_CLE_API"},

timeout=(10, 600)

)

Option 3 : Forcer HTTP/1.1 avec Node.js axios

const axios = require('axios');

const http = require('http');

// Création d'un agent dédié à HTTP/1.1

const agent = new http.Agent({

keepAlive: true,

maxSockets: 10,

timeout: 600000 // 600 secondes

});

// Configuration d'axios pour utiliser l'agent personnalisé

const response = await axios.post(

'http://api.apiyi.com:16888/v1/images/generations',

{

prompt: 'Un magnifique coucher de soleil',

size: '4096x4096',

model: 'nano-banana-pro'

},

{

headers: {

'Authorization': 'Bearer VOTRE_CLE_API'

},

httpAgent: agent, // Utilisation de l'agent HTTP/1.1

timeout: 600000 // Timeout de 600 secondes

}

);

💰 Optimisation des coûts : Pour les projets nécessitant une haute stabilité dans la génération d'images 4K, il est recommandé d'appeler l'API Nano Banana Pro via la plateforme APIYI (apiyi.com). Cette plateforme propose une interface dédiée sur port HTTP (

http://api.apiyi.com:16888/v1) qui utilise par défaut le protocole HTTP/1.1 pour éviter les soucis de compatibilité HTTP/2, tout en offrant une tarification plus avantageuse adaptée aux déploiements en production.

Cause profonde n°3 : L'effet cumulatif du streaming et des fluctuations réseau

Caractéristiques des réponses non-streaming de Nano Banana Pro

Contrairement aux modèles de génération de texte comme GPT-4 ou Claude, l'API Nano Banana Pro n'utilise pas le streaming (flux continu) pour renvoyer les images. Le processus complet de génération se déroule ainsi :

- Phase de requête (1-3 s) : Le client envoie la requête au serveur.

- Phase d'inférence (30-170 s) : Le serveur génère l'image sur TPU, le client ne reçoit aucune donnée de réponse pendant ce temps.

- Phase de réponse (1-5 s) : Le serveur renvoie les données complètes de l'image encodées en base64.

Le problème crucial : Pendant la phase d'inférence (30 à 170 secondes), la connexion HTTP du client est totalement inactive. Seul le "TCP Keep-Alive" maintient la connexion, sans aucun transfert de données au niveau applicatif. Cela entraîne les conséquences suivantes :

- Les équipements réseau intermédiaires (NAT, pare-feu, proxies) peuvent considérer que la connexion est interrompue et la fermer proactivement.

- Dans un environnement réseau instable, les connexions inactives prolongées sont plus susceptibles d'être coupées.

- Les Load Balancers de certains fournisseurs cloud imposent des limites de délai d'attente (timeout) pour les connexions inactives (par exemple, 60 secondes par défaut pour l'AWS ALB).

Impact des fluctuations réseau sur le timeout

| Environnement réseau | Temps de génération réel | Impact de la latence réseau | Configuration de timeout recommandée |

|---|---|---|---|

| Intranet stable / IDC | 100 s | +10-20 s | 300 s (marge de 180 s) |

| ADSL domestique / Réseau mobile | 100 s | +30-50 s | 600 s (marge de 450 s) |

| Réseau international / VPN | 100 s | +50-100 s | 600 s (marge de 400 s) |

| Période de pointe (Événement du 17/01/2026) | 180 s | +20-40 s | 600 s (marge de 380 s) |

Stratégies de réponse : Timeout + Tentatives (Retry) + Dégradation

import requests

import time

from typing import Optional

def generate_image_with_retry(

prompt: str,

size: str = "4096x4096",

max_retries: int = 3,

timeout: int = 600

) -> Optional[dict]:

"""

生成图像,支持超时重试

Args:

prompt: 图像提示词

size: 图像尺寸 (1024x1024, 2048x2048, 4096x4096)

max_retries: 最大重试次数

timeout: 超时时间 (秒)

Returns:

生成结果或 None (失败)

"""

api_url = "http://api.apiyi.com:16888/v1/images/generations"

headers = {"Authorization": "Bearer YOUR_API_KEY"}

for attempt in range(max_retries):

try:

print(f"尝试 {attempt + 1}/{max_retries}: 生成 {size} 图像...")

start_time = time.time()

response = requests.post(

api_url,

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1

},

headers=headers,

timeout=(10, timeout) # (连接超时, 读取超时)

)

elapsed = time.time() - start_time

print(f"✅ 生成成功! 耗时: {elapsed:.2f} 秒")

return response.json()

except requests.exceptions.Timeout:

elapsed = time.time() - start_time

print(f"❌ 超时: {elapsed:.2f} 秒")

if attempt < max_retries - 1:

wait_time = 5 * (attempt + 1) # 指数退避

print(f"⏳ 等待 {wait_time} 秒后重试...")

time.sleep(wait_time)

else:

print("❌ 达到最大重试次数,生成失败")

return None

except requests.exceptions.RequestException as e:

print(f"❌ 网络错误: {e}")

if attempt < max_retries - 1:

time.sleep(5)

else:

return None

return None

# 使用示例

result = generate_image_with_retry(

prompt="A majestic mountain landscape",

size="4096x4096",

max_retries=3,

timeout=600

)

if result:

print(f"图像 URL: {result['data'][0]['url']}")

else:

print("图像生成失败,请稍后重试")

🚀 Démarrage rapide : Il est recommandé d'utiliser la plateforme APIYI (apiyi.com) pour intégrer rapidement l'API Nano Banana Pro. Cette plateforme offre les avantages suivants :

- Interface via port HTTP : http://api.apiyi.com:16888/v1, évitant la surcharge liée au handshake HTTPS.

- Configuration de timeout optimisée : Support par défaut d'un timeout de 600 secondes, couvrant les scénarios de génération en 4K.

- Mécanisme de retry intelligent : Gestion automatique des timeouts temporaires au niveau de la plateforme pour augmenter le taux de réussite.

- Compensation de facturation : Les requêtes dépassant 180 secondes déclenchent automatiquement une compensation, évitant ainsi tout gaspillage.

Avantages de l'interface via port HTTP de la plateforme APIYI

Pourquoi recommander l'utilisation du HTTP plutôt que du HTTPS ?

| Caractéristique | HTTPS (api.apiyi.com/v1) | HTTP (api.apiyi.com:16888/v1) | Recommandation |

|---|---|---|---|

| Surcharge handshake TLS | Oui (300-800ms) | Non | HTTP ✅ |

| Vitesse d'établissement | Lente (négociation TLS) | Rapide (connexion TCP directe) | HTTP ✅ |

| Négociation HTTP/2 | Risque de passage auto en HTTP/2 | HTTP/1.1 forcé | HTTP ✅ |

| Sécurité des appels | Élevée (flux chiffré) | Moyenne (flux en clair) | HTTP ⚠️ (Ok en intranet) |

| Stabilité du timeout | Moyenne (Timeout TLS + Lecture) | Élevée (Timeout lecture seule) | HTTP ✅ |

Exemple de configuration complète de l'interface HTTP APIYI

import requests

# APIYI 平台 HTTP 端口接口配置

APIYI_HTTP_ENDPOINT = "http://api.apiyi.com:16888/v1"

APIYI_API_KEY = "YOUR_APIYI_API_KEY"

def generate_nano_banana_image(

prompt: str,

size: str = "4096x4096"

) -> dict:

"""

使用 APIYI HTTP 接口生成 Nano Banana Pro 图像

Args:

prompt: 图像提示词

size: 图像尺寸

Returns:

API 响应结果

"""

# 根据分辨率动态调整超时时间

timeout_map = {

"1024x1024": 300, # 1K: 300 秒

"2048x2048": 300, # 2K: 300 秒

"4096x4096": 600 # 4K: 600 秒

}

timeout = timeout_map.get(size, 600) # 默认 600 秒

response = requests.post(

f"{APIYI_HTTP_ENDPOINT}/images/generations",

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1,

"response_format": "url" # 或 "b64_json"

},

headers={

"Authorization": f"Bearer {APIYI_API_KEY}",

"Content-Type": "application/json"

},

timeout=(10, timeout) # (连接超时, 读取超时)

)

response.raise_for_status()

return response.json()

# 使用示例

try:

result = generate_nano_banana_image(

prompt="A photorealistic portrait of a cat",

size="4096x4096"

)

print(f"✅ 生成成功!")

print(f"图像 URL: {result['data'][0]['url']}")

print(f"尺寸: {result['data'][0]['size']}")

except requests.exceptions.Timeout:

print("❌ 请求超时,请检查网络或稍后重试")

except requests.exceptions.HTTPError as e:

print(f"❌ API 错误: {e}")

except Exception as e:

print(f"❌ 未知错误: {e}")

💡 Bonne pratique : En environnement de production, il est conseillé de privilégier l'interface via port HTTP d'APIYI (http://api.apiyi.com:16888/v1). Cette interface est optimisée par la plateforme, avec des délais d'attente raisonnables et des stratégies de retry configurés par défaut, ce qui améliore considérablement le taux de succès des appels à l'API Nano Banana Pro, en particulier pour les scénarios de génération d'images en 4K.

Questions Fréquentes

Q1 : Pourquoi ai-je toujours des timeouts alors que j’ai configuré un délai de 600 secondes ?

Causes possibles :

-

Seul le timeout de connexion a été défini, pas celui de lecture :

# ❌ Erreur : timeout=600 ne s'applique qu'au délai de connexion response = requests.post(url, json=data, timeout=600) # ✅ Correct : définir séparément les délais de connexion et de lecture response = requests.post(url, json=data, timeout=(10, 600)) -

Un proxy intermédiaire ou un Load Balancer impose une limite plus courte :

- Le délai d'inactivité par défaut d'un AWS ALB est de 60 secondes.

- Nginx utilise par défaut un

proxy_read_timeoutde 60 secondes. - Le plan gratuit de Cloudflare a un timeout maximal de 100 secondes.

Solution : Utilisez l'interface du port HTTP d'APIYI, car elle a déjà été optimisée au niveau de la plateforme pour les configurations de timeout.

-

Environnement réseau instable ou temps de génération réel dépassant 600 secondes :

- Lors des pics d'utilisation du 17 janvier 2026, certaines requêtes ont pris plus de 180 secondes.

- La latence réseau internationale peut ajouter 50 à 100 secondes supplémentaires.

Solution : Implémentez un mécanisme de tentative (retry) et profitez des fonctions de compensation de facturation de la plateforme APIYI.

Q2 : L’interface HTTP est-elle sécurisée ? Risque-t-elle d’être interceptée ?

Analyse de sécurité :

| Scénario | Sécurité HTTP | Recommandation |

|---|---|---|

| Appel en réseau interne (VPC/Réseau privé) | Haute (pas d'exposition publique) | ✅ HTTP recommandé |

| Appel via Internet public (Dév/Test) | Moyenne (risque de fuite de l'API Key) | ⚠️ Attention à la sécurité de la clé |

| Appel via Internet public (Production) | Faible (transmission en clair) | ❌ Priorité au HTTPS |

| Appel via VPN/Ligne dédiée | Haute (chiffrement au niveau VPN) | ✅ HTTP recommandé |

Bonnes pratiques :

- Environnement interne : Utilisez l'interface HTTP pour des performances optimales.

- Environnement public : Si la sécurité est primordiale, utilisez HTTPS. Si vous privilégiez la stabilité, utilisez HTTP et renouvelez régulièrement vos clés API.

- Environnement hybride : Utilisez HTTP pour les invites non sensibles et HTTPS pour les contenus sensibles.

Q3 : Les images 1K et 2K nécessitent-elles aussi un timeout de 300 secondes ?

Paramétrage recommandé :

Bien que le temps de génération réel des images 1K et 2K soit généralement compris entre 30 et 120 secondes, nous recommandons tout de même un timeout de 300 secondes pour les raisons suivantes :

- Fluctuations réseau : Même si la génération est rapide, la latence réseau peut ajouter 30 à 50 secondes.

- Impact des pics d'utilisation : Les événements du 17/01/2026 ont montré que dans des cas extrêmes, le temps de génération peut doubler.

- Marge de sécurité : Un timeout de 300 secondes ne coûte rien de plus, mais évite des tentatives de rechargement inutiles.

Données réelles (statistiques de la plateforme APIYI) :

| Résolution | P50 (Médiane) | P95 (95e percentile) | P99 (99e percentile) | Timeout recommandé |

|---|---|---|---|---|

| 1K | 45 s | 90 s | 150 s | 300 s |

| 2K | 65 s | 120 s | 180 s | 300 s |

| 4K | 120 s | 170 s | 250 s | 600 s |

Conclusion : Utilisez 300 secondes pour le 1K/2K et 600 secondes pour le 4K afin de couvrir plus de 99 % des scénarios.

Q4 : Comment savoir s’il s’agit d’un problème de timeout ou d’une surcharge de l’API ?

Méthode de distinction :

| Type d'erreur | Message d'erreur type | Code d'état HTTP | Peut-on réessayer ? |

|---|---|---|---|

| Erreur de timeout | ReadTimeout, Connection timeout |

Aucun (Erreur client) | ✅ Oui |

| API surchargée | The model is overloaded |

503 ou 429 | ✅ Oui (après attente) |

| API indisponible | The service is currently unavailable |

503 | ✅ Oui (après attente) |

| Erreur d'authentification | Invalid API key |

401 | ❌ Non (vérifiez la clé) |

Caractéristiques d'une erreur de timeout :

except requests.exceptions.Timeout:

# Timeout côté client, aucune réponse reçue du serveur

print("La requête a expiré")

except requests.exceptions.HTTPError as e:

if e.response.status_code == 503:

# Le serveur renvoie 503, indiquant clairement une surcharge

print("API surchargée")

Processus de diagnostic :

- Si l'exception est de type

Timeout, c'est un problème de délai → augmentez le timeout ou utilisez l'interface HTTP. - Si vous recevez une réponse HTTP avec un code 503/429, c'est que l'API est surchargée → attendez un peu ou changez de fournisseur d'API.

- Si le contenu de la réponse mentionne "overloaded", cela signifie que les ressources de calcul de Google sont insuffisantes → envisagez d'utiliser un modèle de secours sur APIYI (comme Seedream 4.5).

Conclusion

Points clés concernant les déconnexions par timeout de l'API Nano Banana Pro :

- Configuration du timeout : 300 s recommandées pour le 1K/2K, 600 s pour le 4K, afin de pallier les fluctuations réseau et les pics de charge.

- Problématiques HTTP/2 : Dans les scénarios de connexions longues, HTTP/2 peut souffrir de blocage de tête de ligne TCP et d'épuisement des identifiants de flux. Il est conseillé de forcer l'utilisation de HTTP/1.1.

- Avantages du port HTTP : L'interface HTTP d'APIYI (http://api.apiyi.com:16888/v1) évite le surcoût du handshake TLS et la négociation HTTP/2, améliorant ainsi la stabilité.

- Stratégie de rechargement : Implémentez un retry sur timeout avec un backoff exponentiel pour gérer les instabilités réseau temporaires.

- Optimisation de la plateforme : La plateforme APIYI propose des configurations de timeout optimisées, des tentatives intelligentes et une compensation de facturation, augmentant significativement le taux de réussite de génération d'images 4K.

Nous vous recommandons d'intégrer rapidement l'API Nano Banana Pro via APIYI (apiyi.com). La plateforme fournit une interface de port HTTP dédiée, configurée par défaut avec des délais raisonnables, et supporte la génération d'images de 1K à 4K, ce qui est idéal pour un déploiement en production.

Auteur : Équipe technique APIYI | Pour toute question technique, n'hésitez pas à visiter APIYI (apiyi.com) pour découvrir plus de solutions d'accès aux modèles d'IA.