Vous voulez générer des vidéos HD 2K avec audio natif en masse grâce à l'IA, mais vous avez remarqué que l'API Seedance 2.0 n'est pas encore officiellement ouverte ? C'est le dilemme auquel font face de nombreux développeurs et créateurs de contenu en ce moment. Cet article analyse en détail les 5 capacités clés de Seedance 2.0, pour vous aider à maîtriser l'architecture technique et les méthodes d'accès à l'API de ce tout nouveau modèle de génération vidéo de ByteDance.

Valeur ajoutée : Après avoir lu cet article, vous aurez une compréhension complète des capacités techniques de Seedance 2.0, des modes d'accès à l'API et des meilleures pratiques, afin d'être prêt à l'intégrer dès son ouverture officielle.

Aperçu rapide des informations clés de l'API Seedance 2.0

Avant de plonger dans les détails techniques, voici un résumé des points essentiels concernant Seedance 2.0.

| Élément | Détails |

|---|---|

| Nom du modèle | Seedance 2.0 (Série Seed de ByteDance) |

| Éditeur | ByteDance |

| Lancement prévu de l'API | 24 février 2025 (Volcengine/BytePlus) |

| Canaux actuels | Site Dreamina (即梦), console Volcengine/BytePlus (débogage en ligne) |

| Résolution de sortie | Jusqu'à 2K (supporte la sortie 1080p de qualité production) |

| Durée de la vidéo | 4 à 15 secondes |

| Formats supportés | 16:9, 9:16, 4:3, 3:4, 21:9, 1:1 |

| Modalités d'entrée | Texte + Images (0-5) + Vidéo + Audio |

| Audio natif | Génération synchrone de dialogues, sons d'ambiance et effets |

| Plateformes | Dreamina, Volcengine, APIYI apiyi.com (supporté dès le lancement de l'API) |

🎯 Note importante : L'API Seedance 2.0 devrait être lancée le 24 février. À cette date, les développeurs pourront y accéder rapidement via une interface unifiée sur la plateforme APIYI (apiyi.com), sans avoir à s'interfacer séparément avec Volcengine.

Les 5 capacités clés de l'API Seedance 2.0

Seedance 2.0 représente une mise à niveau complète par rapport à la génération précédente, Seedance 1.5 Pro. Voici les 5 capacités clés qui retiennent le plus l'attention des développeurs.

Capacité clé 1 de Seedance 2.0 : Texte-en-vidéo (Text-to-Video)

La capacité de génération de vidéo à partir de texte est la fonction la plus fondamentale et la plus puissante de Seedance 2.0. Il vous suffit de saisir une description textuelle pour que le modèle génère un contenu vidéo de haute qualité.

Améliorations clés par rapport à la version 1.5 :

| Dimension de l'amélioration | Seedance 1.5 Pro | Seedance 2.0 | Ampleur de l'amélioration |

|---|---|---|---|

| Réalisme physique | Simulation physique de base | Gravité, momentum et causalité précis | Amélioration significative |

| Dynamique de mouvement | Fluide mais parfois peu naturel | Continuité de mouvement hautement naturelle | Amélioration significative |

| Esthétique visuelle | Qualité HD | Qualité esthétique de niveau cinéma | Amélioration notable |

| Résolution d'image | 1080p | Jusqu'à 2K | Résolution doublée |

| Génération de scènes | Principalement mono-scène | Génération auto de scènes/découpage technique | Nouvelle capacité |

| Vitesse de génération | Vitesse standard | Accélération d'environ 30 % | Efficacité accrue |

Seedance 2.0 atteint un nouveau sommet dans la compréhension des lois physiques : dans les séquences d'actions complexes, la gravité, le momentum et les relations de cause à effet restent précis. Cela signifie que dans les vidéos que vous générez, les trajectoires des objets, les effets de collision et les interactions avec l'environnement sont beaucoup plus réalistes et crédibles.

La fonction de découpage technique automatique est l'un des points forts du mode texte-en-vidéo de Seedance 2.0. Le modèle peut décomposer automatiquement un texte narratif en plusieurs plans cohérents, garantissant que l'apparence des personnages, les détails de l'environnement et la continuité narrative restent constants d'un plan à l'autre.

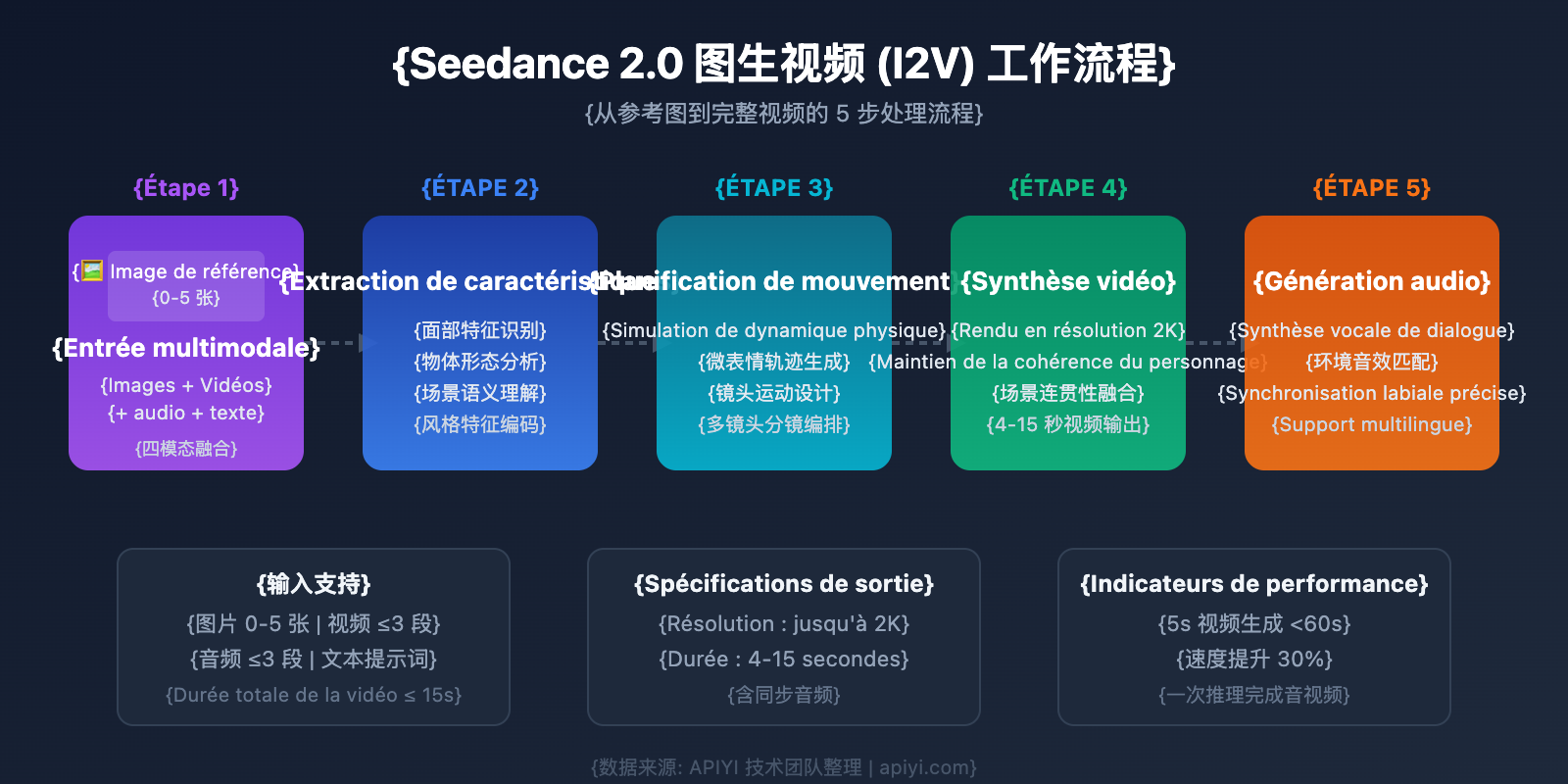

Capacité clé 2 de Seedance 2.0 : Image-en-vidéo (Image-to-Video)

L'image-en-vidéo est la capacité de transformer une image de référence statique en une vidéo dynamique. Seedance 2.0 a réalisé un bond qualitatif dans ce domaine.

Points d'amélioration clés :

- Optimisation des micro-expressions : Les micro-expressions faciales des personnages sont plus délicates et naturelles, avec des transitions fluides pour les clignotements d'yeux, les sourires ou les froncements de sourcils.

- Continuité du mouvement : La transition de l'image statique à la vidéo dynamique est plus naturelle, sans sauts d'images ni tremblements.

- Cohérence des personnages : Les traits du visage, les vêtements et la morphologie des personnages restent constants sous différents angles et dans des séquences multi-plans.

- Cohérence des objets : La forme, la position et les relations d'ombre et de lumière des objets dans la scène restent stables.

- Continuité de la scène : L'environnement d'arrière-plan ne subit pas de changements brusques pendant la lecture de la vidéo.

- Rendu des détails du produit : La capacité à restituer les textures, les logos et les emballages des produits est considérablement renforcée.

🎯 Conseil pour application commerciale : La capacité accrue de Seedance 2.0 à restituer les détails des produits le rend particulièrement adapté à la création de vidéos de produits pour l'e-commerce. En appelant l'API Seedance 2.0 via APIYI (apiyi.com), vous pouvez générer en masse des vidéos de présentation pour vos articles.

Capacité clé 3 de Seedance 2.0 : Entrées multi-références et multimodales

C'est l'une des capacités les plus différenciatrices de Seedance 2.0. Le modèle prend en charge la réception simultanée de plusieurs modes d'entrée, permettant un contrôle créatif précis.

Système d'entrée à quatre modes :

| Mode d'entrée | Quantité supportée | Utilisation |

|---|---|---|

| Image | 0-5 images (jusqu'à 9) | Référence de personnage, de scène, de style |

| Vidéo | Jusqu'à 3 segments (durée totale ≤15s) | Référence de mouvement, mouvement de caméra |

| Audio | Jusqu'à 3 segments (MP3, durée totale ≤15s) | Référence de rythme, de dialogue, d'ambiance sonore |

| Texte | Description en langage naturel | Description de scène, instructions d'action, style |

La capacité de recherche multi-références est un avantage unique de Seedance 2.0. Vous pouvez fournir de 0 à 5 images de référence, et le modèle est capable d'en extraire les caractéristiques clés pour les fusionner dans la vidéo générée. Par exemple :

- Fournir 1 photo de visage + 1 vidéo de mouvement + 1 rythme audio → Générer une vidéo d'un personnage spécifique dansant sur le rythme.

- Fournir 3 photos de produit sous différents angles → Générer une vidéo de présentation du produit avec une rotation à 360 degrés.

- Fournir 1 image de scène + une description textuelle → Générer une vidéo avec une action spécifique dans la scène indiquée.

Capacité clé 4 de Seedance 2.0 : Génération audio native

Seedance 2.0 a réalisé une première dans l'industrie avec la co-génération audio-visuelle native (Audio-Visual Co-generation), synchronisant la génération de l'image vidéo et du contenu audio au cours d'un seul processus d'inférence.

Points forts de la capacité audio :

- Génération de dialogues : Supporte la génération vocale en plusieurs langues (chinois, anglais, espagnol, etc.) avec une synchronisation labiale précise.

- Effets sonores d'ambiance : Génération automatique de sons d'ambiance correspondant à l'image (vent, eau, bruits de la ville, etc.).

- Synchronisation des effets sonores : Les sons liés aux actions sont précisément synchronisés avec les mouvements à l'écran (bruits de pas, collisions, etc.).

- Référence de voix réelle : Supporte l'entrée de voix réelles de référence pour plus de deux sujets.

- Précision vocale : La précision de la génération vocale pour des langues comme le chinois, l'anglais et l'espagnol a été considérablement améliorée.

- Pas de post-production nécessaire : Là où les flux traditionnels nécessitent l'ajout séparé d'effets sonores et de doublage, Seedance 2.0 réalise tout en une seule fois.

Cela signifie que les développeurs peuvent obtenir directement un fichier vidéo avec un audio complet via un seul appel API, simplifiant considérablement le processus de production de contenu.

Capacité clé 5 de Seedance 2.0 : Édition et extension de vidéo

En plus de générer des vidéos à partir de zéro, Seedance 2.0 permet également d'éditer et de prolonger des vidéos existantes.

| Capacité d'édition | Description | Conditions limites |

|---|---|---|

| Extension de vidéo | Prolonge naturellement l'image et l'intrigue à partir d'une vidéo existante | Vidéo d'entrée ≤15s |

| Complétion de vidéo | Complète intelligemment les parties manquantes d'une vidéo | Vidéo d'entrée ≤15s |

| Édition limitée | Ajuste le style, la colorimétrie, etc., sur des vidéos courtes | Vidéo d'entrée <15s |

| Entrées simultanées | Permet d'utiliser à la fois des images et des vidéos comme références | Limite sur le volume total image + vidéo |

Tutoriel d'intégration de l'API Seedance 2.0

État actuel de l'API Seedance 2.0

Au moment de la publication de cet article (février 2025), l'état de l'API Seedance 2.0 est le suivant :

- Volcengine (Chine) : Pas encore officiellement lancée, débogage en ligne disponible sur la console.

- BytePlus (International) : Pas encore officiellement lancée, débogage en ligne disponible sur la console.

- Jimeng (Dreamina) : Utilisable via l'interface web.

- Lancement officiel de l'API : Prévu pour le 24 février 2025.

Pour les développeurs utilisant déjà l'API Seedance 1.5 Pro ou Seedream 4.5, la bonne nouvelle est que l'interface API de Seedance 2.0 reste hautement compatible, ce qui rend le coût de migration extrêmement faible.

Code de démarrage rapide pour l'API Seedance 2.0

Voici un exemple de code de base pour appeler l'API Seedance 2.0 (basé sur le style d'API de Volcengine, utilisable directement après le lancement officiel) :

Exemple minimal de Texte-en-vidéo (T2V)

import requests

import json

# Appel de l'API Seedance 2.0 via APIYI

API_BASE = "https://api.apiyi.com/v1"

API_KEY = "votre-cle-api"

def text_to_video(prompt, aspect_ratio="16:9", duration=5):

"""Appel Texte-en-vidéo Seedance 2.0"""

response = requests.post(

f"{API_BASE}/video/generations",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

},

json={

"model": "seedance-2.0",

"prompt": prompt,

"aspect_ratio": aspect_ratio,

"duration": duration,

"audio": True # Activer la génération audio native

}

)

return response.json()

# Générer une vidéo avec audio

result = text_to_video(

prompt="Un golden retriever court sur une plage au bord de la mer, le soleil scintille sur l'eau, les vagues frappent le rivage",

aspect_ratio="16:9",

duration=8

)

print(f"URL de la vidéo : {result['data']['url']}")

print(f"Audio généré de manière synchrone : {result['data']['has_audio']}")

Voir le code complet pour l’Image-en-vidéo (I2V)

import requests

import json

import base64

from pathlib import Path

API_BASE = "https://api.apiyi.com/v1"

API_KEY = "votre-cle-api"

def image_to_video(image_paths, prompt, aspect_ratio="16:9", duration=5):

"""

Appel Image-en-vidéo Seedance 2.0

Prend en charge l'entrée de 0 à 5 images de référence

"""

# Encodage des images de référence

images = []

for path in image_paths:

with open(path, "rb") as f:

img_data = base64.b64encode(f.read()).decode()

images.append({

"type": "image",

"data": img_data

})

response = requests.post(

f"{API_BASE}/video/generations",

headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

},

json={

"model": "seedance-2.0",

"prompt": prompt,

"references": images,

"aspect_ratio": aspect_ratio,

"duration": duration,

"audio": True,

"resolution": "2k" # Utiliser la résolution 2K

}

)

result = response.json()

if result.get("status") == "processing":

task_id = result["data"]["task_id"]

print(f"Tâche soumise, ID : {task_id}")

# Les tâches asynchrones nécessitent un polling pour obtenir le résultat

return poll_result(task_id)

return result

def poll_result(task_id, max_wait=300):

"""Interrogation cyclique (polling) pour obtenir le résultat de la génération vidéo"""

import time

for _ in range(max_wait // 5):

time.sleep(5)

resp = requests.get(

f"{API_BASE}/video/generations/{task_id}",

headers={"Authorization": f"Bearer {API_KEY}"}

)

data = resp.json()

if data["data"]["status"] == "completed":

return data

elif data["data"]["status"] == "failed":

raise Exception(f"Échec de la génération : {data['data']['error']}")

raise TimeoutError("Délai d'attente dépassé")

# Exemple d'utilisation : générer une vidéo de présentation à partir de photos de produit

result = image_to_video(

image_paths=["produit_face.jpg", "produit_cote.jpg"],

prompt="Présentation du produit avec rotation à 360 degrés, éclairage doux, fond blanc",

aspect_ratio="1:1",

duration=6

)

print(f"Vidéo générée : {result['data']['url']}")

🚀 Démarrage rapide : Il est recommandé d'utiliser la plateforme APIYI (apiyi.com) pour accéder à l'API Seedance 2.0. Cette plateforme propose une interface unifiée compatible avec Volcengine, sans avoir besoin de créer un compte séparé sur Volcengine, permettant une intégration en 5 minutes.

Comparaison entre Seedance 2.0 et les principaux modèles vidéo IA

Comprendre le positionnement de Seedance 2.0 dans le domaine actuel de la génération vidéo par IA vous aidera à faire le meilleur choix technologique.

| Dimension de comparaison | Seedance 2.0 | Sora 2 | Kling 3.0 | Veo 3.1 |

|---|---|---|---|---|

| Résolution max. | 2K | 1080p | 1080p | 1080p |

| Durée de la vidéo | 4-15s | 5-20s | 5-10s | 5-8s |

| Audio natif | ✅ Support complet | ✅ Supporté | ❌ Non supporté | ✅ Supporté |

| Entrée multi-références | ✅ 0-5 images | ❌ Non supporté | ✅ 1-2 images | ❌ Non supporté |

| Entrée multimodale | Quadri-modale (Texte/Image/Vidéo/Audio) | Texte/Image | Texte/Image | Texte/Image |

| Réalisme physique | Excellent | Top niveau | Excellent | Excellent |

| Naturel du mouvement | Excellent | Excellent | Top niveau | Excellent |

| Narration multi-plans | ✅ Auto-découpage | ✅ Supporté | ❌ Non supporté | ✅ Supporté |

| Édition vidéo | ✅ Support limité | ✅ Supporté | ❌ Non supporté | ❌ Non supporté |

| Vitesse de génération | Rapide (vidéo 5s < 60s) | Plutôt lent | Rapide | Moyen |

| Disponibilité API | Lancée le 24 fév. | Déjà en ligne | Déjà en ligne | Déjà en ligne |

| Plateformes disponibles | Volcengine, APIYI apiyi.com | OpenAI | Kuaishou |

Les avantages uniques de Seedance 2.0

Seedance 2.0 présente des avantages différentiels évidents dans les trois domaines suivants :

- Système d'entrée quadri-modal : C'est actuellement le seul modèle de génération vidéo qui prend en charge l'entrée simultanée de quatre modes (texte + image + vidéo + audio), offrant une précision de contrôle créatif bien supérieure aux produits similaires.

- Recherche multi-images de référence : Prend en charge l'extraction et la fusion des caractéristiques de 0 à 5 images de référence, ce qui est particulièrement adapté aux applications commerciales nécessitant un contrôle précis des personnages et des scènes.

- Résolution native 2K : La résolution de sortie la plus élevée parmi les modèles similaires actuels, répondant aux besoins de production de contenu de qualité commerciale.

💡 Conseil de choix : Le choix du modèle vidéo dépend de votre scénario d'application spécifique. Si vous avez besoin d'un contrôle précis multimodal et d'une résolution 2K, Seedance 2.0 est le meilleur choix. Nous vous suggérons de tester plusieurs modèles simultanément via la plateforme APIYI (apiyi.com), qui prend en charge l'appel via une interface unifiée pour Seedance 2.0, Sora 2 et d'autres modèles vidéo majeurs, facilitant ainsi la comparaison rapide des résultats.

Scénarios d'application typiques de l'API Seedance 2.0

Les capacités multimodales de Seedance 2.0 le rendent idéal pour une grande variété de scénarios commerciaux et créatifs.

Vidéos de produits e-commerce

Grâce aux capacités d'image-vers-vidéo et de multi-références d'images, les commerçants peuvent générer rapidement des vidéos de présentation de haute qualité à partir de quelques photos de produits. L'expressivité accrue des détails de Seedance 2.0 permet de restituer avec précision les textures, les logos et l'emballage des produits.

Création de contenu vidéo court

La fonction de storyboard automatique du texte-vers-vidéo et la génération audio native permettent aux créateurs de générer des vidéos courtes avec un doublage et des effets sonores complets à partir d'une simple description textuelle, abaissant ainsi considérablement la barrière à la production de contenu.

Humains numériques et présentateurs virtuels

L'optimisation des micro-expressions et la génération vocale multilingue de Seedance 2.0 (supportant le chinois, l'anglais, l'espagnol, etc.), combinées à l'entrée de voix de référence réelles, permettent de créer des vidéos d'humains numériques aux expressions riches et à la synchronisation labiale précise.

Génération en masse de contenus publicitaires

En combinant l'entrée de plusieurs images de référence et les capacités d'édition vidéo, les équipes publicitaires peuvent rapidement générer plusieurs versions d'une vidéo promotionnelle à partir d'un même ensemble de ressources pour des tests A/B.

FAQ sur l'API Seedance 2.0

Q1 : Quand l’API Seedance 2.0 sera-t-elle officiellement disponible ?

Selon des sources internes, l'API Seedance 2.0 devrait être lancée officiellement le 24 février 2025. Elle sera alors disponible via Volcano Engine (Volcano Ark) et BytePlus. Si vous souhaitez l'utiliser dès le premier jour, nous vous conseillons de suivre la plateforme APIYI (apiyi.com), qui proposera un service d'accès unifié pour Seedance 2.0 dès sa sortie.

Q2 : Le coût de migration de Seedance 1.5 Pro vers la version 2.0 est-il élevé ?

Le coût de migration est très faible. L'interface API de Seedance 2.0 maintient une haute compatibilité avec la version 1.5 Pro. Les principaux changements concernent l'ajout de nouveaux paramètres comme les images de référence multiples et l'entrée audio. Le code existant pour les appels texte-vers-vidéo et image-vers-vidéo fonctionnera sur la version 2.0 pratiquement sans modification.

Q3 : Quel est le prix d’appel de l’API Seedance 2.0 ?

Le tarif officiel de Seedance 2.0 n'a pas encore été annoncé. En se basant sur la structure tarifaire de Seedance 1.5 Pro, on peut s'attendre à une facturation basée sur la durée de la vidéo et la résolution. Nous vous recommandons de consulter la plateforme APIYI (apiyi.com) pour obtenir les dernières informations sur les prix, car elle propose généralement des modes de facturation plus flexibles.

Q4 : Existe-t-il un moyen de tester Seedance 2.0 en avance ?

Vous pouvez l'essayer via les canaux suivants :

- Site web Dreamina (Jimeng) : Visitez le site officiel

jimeng.jianying.compour utiliser Seedance 2.0 directement en ligne. - Console Volcano Engine : Connectez-vous à la console Volcano Engine, vous pouvez effectuer des tests en ligne dans la zone de débogage des modèles.

- Console BytePlus : Les utilisateurs internationaux peuvent tester l'outil via la console BytePlus.

Q5 : Quelles langues sont supportées pour la génération vocale dans Seedance 2.0 ?

La génération audio native de Seedance 2.0 prend en charge plusieurs langues, notamment le chinois, l'anglais et l'espagnol. La précision de la génération vocale a été considérablement améliorée pour ces langues, en particulier en ce qui concerne la synchronisation labiale et le naturel de l'intonation.

Résumé de l'intégration de l'API Seedance 2.0

Seedance 2.0, la toute dernière génération de modèle de génération vidéo de ByteDance, marque une avancée majeure dans les domaines de l'entrée multimodale, de l'audio natif et de la résolution 2K. Son système d'entrée à quatre modalités et sa capacité de recherche multi-images de référence offrent aux développeurs une précision de contrôle créatif sans précédent.

Points clés à retenir :

- Entrée quadrimodale : Prise en charge du texte + images (0 à 5) + vidéo + audio.

- Haute performance : Sortie native en résolution 2K, avec une vitesse de génération augmentée de 30 %.

- Audio-vidéo synchronisé : Une première dans l'industrie avec la co-génération synchronisée de l'audio et de la vidéo, permettant d'obtenir une vidéo complète en un seul appel.

- Cohérence narrative : Narration multi-plans avec découpage technique automatique, garantissant une grande cohérence des personnages et des décors.

- Disponibilité : L'API devrait être disponible le 24 février, avec une compatibilité élevée avec l'interface 1.5 Pro.

Nous vous recommandons d'utiliser APIYI (apiyi.com) pour intégrer rapidement l'API Seedance 2.0. Cette plateforme permet d'appeler plusieurs modèles de génération vidéo via une interface unique, facilitant ainsi la comparaison des résultats et le choix de la meilleure solution technique.

Cet article a été rédigé par l'équipe technique d'APIYI, qui suit de près les dernières tendances de la génération vidéo par IA. Pour plus de tutoriels sur l'utilisation des modèles d'IA, rendez-vous sur le centre d'aide d'APIYI (apiyi.com).

Ressources complémentaires

-

Présentation officielle de Seedance : Documentation de la série de modèles Seed de ByteDance

- Lien :

byteplus.com/en/product/seedance

- Lien :

-

Plateforme Jimeng (Dreamina) : Accès à l'expérience en ligne de Seedance 2.0

- Lien :

jimeng.jianying.com

- Lien :

-

Volcengine ModelArk : Notes de mise à jour du modèle

- Lien :

docs.byteplus.com/en/docs/ModelArk/1159178

- Lien :