Nota do autor: Analisando profundamente o fluxo de trabalho completo para a produção em massa de dramas de IA, detalhando como utilizar o Sora 2 Character Cameo e a saída Veo 3.1 4K para alcançar uma produção eficiente.

Os dramas de IA estão se tornando a nova tendência no campo da criação de conteúdo. Como utilizar o Sora 2 e o Veo 3.1 para construir um fluxo de trabalho de produção em massa eficiente é a questão central que todo criador está explorando.

Valor Central: Ao terminar este artigo, você dominará o fluxo de trabalho completo de produção de dramas de IA, aprenderá a usar o Sora 2 Character Cameo para manter a consistência dos personagens e técnicas práticas para utilizar o Veo 3.1 na saída de vídeos verticais em 4K.

Valor Central e Oportunidades de Mercado na Produção em Massa de Dramas de IA

A produção em massa de dramas de IA está redefinindo os limites da eficiência na produção de conteúdo. A produção tradicional de dramas exige muito desenho manual e animação, mas o surgimento do Sora 2 e do Veo 3.1 permite que equipes de uma única pessoa alcancem uma produção de nível industrial.

| Dimensão de Comparação | Produção Tradicional | Produção em Massa de IA | Aumento de Eficiência |

|---|---|---|---|

| Ciclo de Produção por Episódio | 7-14 Dias | 2-4 Horas | 50-80 vezes |

| Consistência de Personagem | Depende do artista | Consistência Automática via API | 100% Consistente |

| Geração de Cenários | Desenho quadro a quadro | Geração em massa | 20-50 vezes |

| Investimento de Custo | Nível de Milhares/Episódio | Nível de Dezenas/Episódio | Redução de 90% |

| Limite de Capacidade | 2-4 episódios/mês | 50-100 episódios/mês | 25 vezes |

As Três Principais Vantagens da Produção em Massa de Dramas de IA

Primeiro: o avanço tecnológico na consistência de personagens. O recurso Character Cameo do Sora 2 permite a criação de IDs de personagens reutilizáveis, garantindo que o mesmo personagem mantenha características visuais idênticas em diferentes cenários. Isso resolve a principal dor de cabeça da "mudança de rosto" na geração tradicional de vídeo por IA.

Segundo: a padronização do processo de produção em massa. Através de interfaces de API, os criadores podem integrar a análise de roteiro, a geração de comandos, a geração de vídeo e a edição de pós-produção em uma linha de montagem automatizada. O tempo de geração para 20 a 50 cenas pode ser reduzido de várias horas para menos de uma hora.

Terceiro: a flexibilidade na adaptação multiplataforma. O Veo 3.1 suporta nativamente a geração de vídeos verticais, podendo entregar diretamente conteúdo na proporção 9:16 ideal para plataformas de vídeos curtos como TikTok, Instagram Reels e Kwai, sem a necessidade de novos cortes.

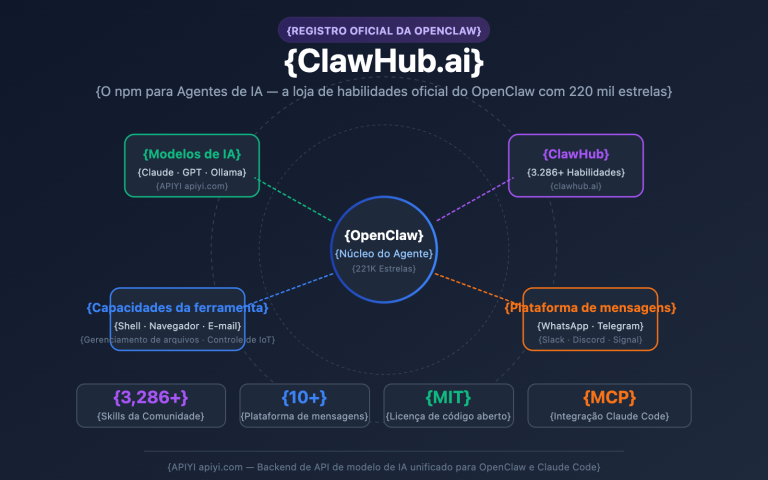

🎯 Sugestão de Plataforma: A produção em massa de dramas exige um ambiente de chamada de API estável. Recomendamos o APIYI (apiyi.com) para obter uma interface unificada para o Sora 2 e outros modelos de vídeo líderes, suportando o envio de tarefas em massa e a otimização de custos.

Análise do Fluxo de Trabalho Completo de Produção de Manhua Dramas

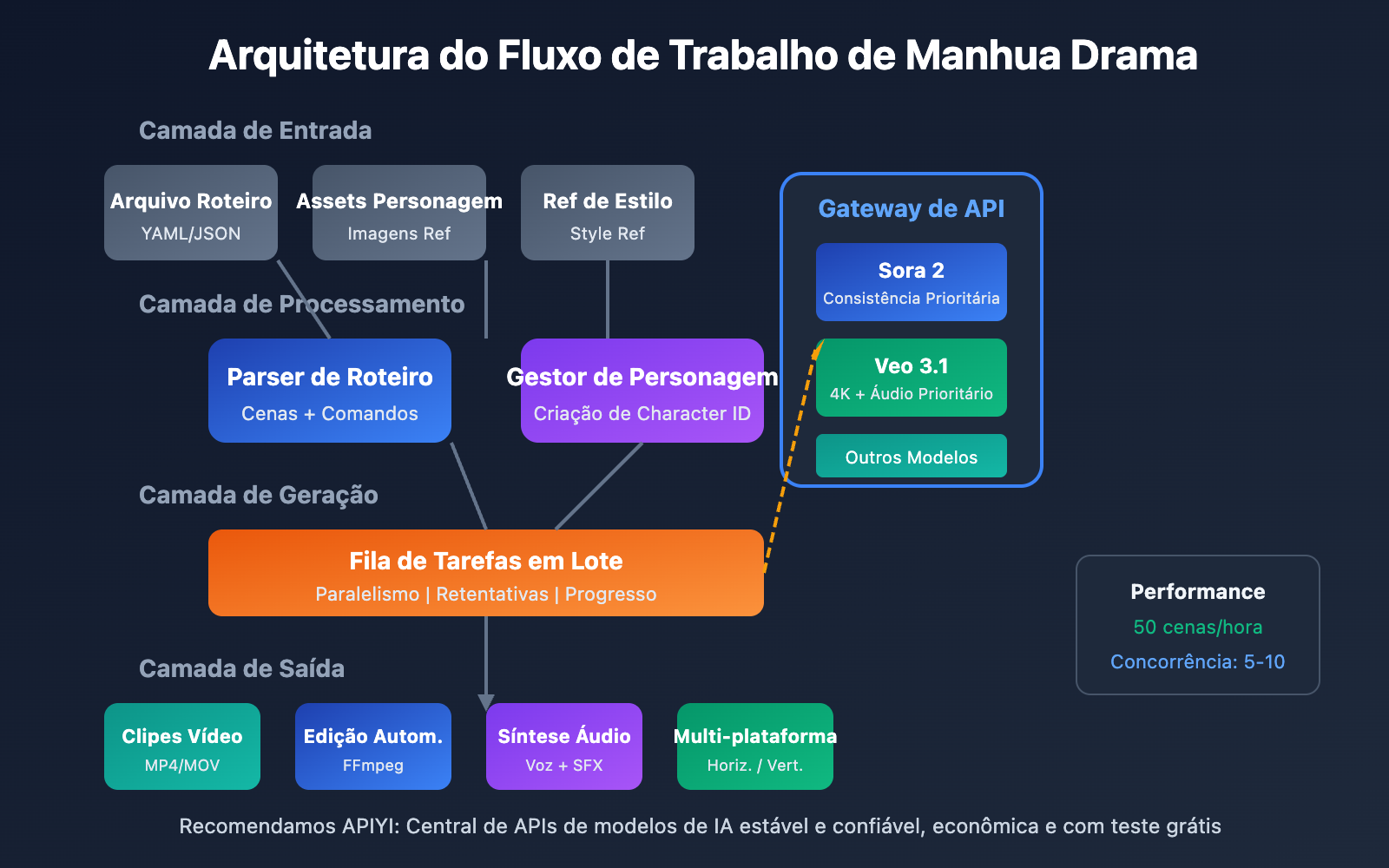

Um fluxo de trabalho completo para a produção de Manhua Dramas (novelas em formato de quadrinhos animados) pode ser dividido em cinco fases principais, cada uma com entradas, saídas e pontos técnicos bem definidos.

Fase 1 do Fluxo de Manhua Drama: Planejamento de Roteiro e Design de Storyboard

O ponto de partida do fluxo de produção é o roteiro estruturado. Diferente dos roteiros tradicionais, o roteiro para Manhua Dramas com IA precisa fornecer descrições visuais detalhadas para cada cena.

| Elemento do Roteiro | Escrita Tradicional | Escrita no Fluxo de Manhua AI | Descrição da Função |

|---|---|---|---|

| Descrição da Cena | Dentro de uma cafeteria | Cafeteria moderna e minimalista, janelas do chão ao teto, sol da tarde, tons quentes | Fornece a base para a geração visual |

| Ação do Personagem | João toma café | Homem de cabelos pretos, camisa branca, segurando uma xícara de café com a mão direita, sorrindo para a janela | Garante que a ação possa ser gerada |

| Linguagem de Câmera | Plano fechado | Plano médio-curto, perfil de 45 graus, fundo com desfoque de profundidade (bokeh) | Orienta a composição da imagem |

| Marcação de Tempo | Nenhuma | 8 segundos | Configuração de parâmetros da API |

Exemplo de formato de roteiro de storyboard:

episode: 1

title: "O Primeiro Encontro"

total_scenes: 12

characters:

- id: "char_001"

name: "Xiaoyu"

description: "Mulher de 20 anos, cabelos longos pretos, vestido branco"

- id: "char_002"

name: "Aming"

description: "Homem de 22 anos, cabelo curto, terno casual"

scenes:

- scene_id: 1

duration: 6

setting: "Rua da cidade, entardecer, luzes de neon começando a acender"

characters: ["char_001"]

action: "Xiaoyu caminha sozinha pela rua, olhando para o celular"

camera: "Câmera de acompanhamento, plano médio"

Fase 2 do Fluxo de Manhua Drama: Criação de Assets de Personagem

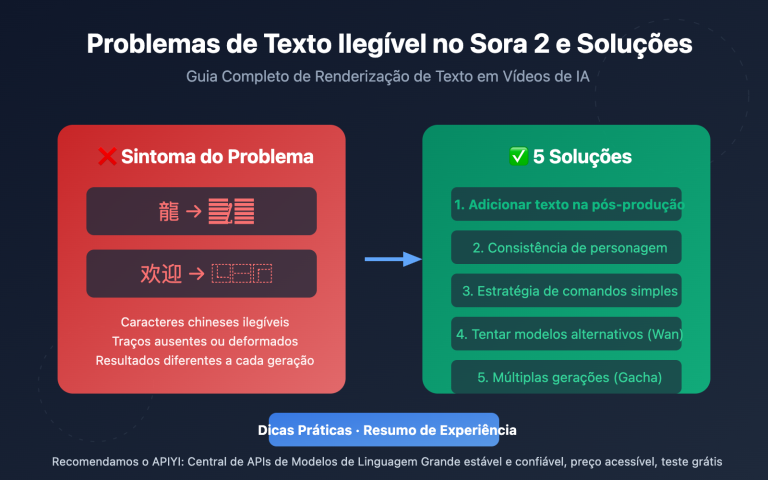

A consistência dos personagens é o principal desafio na produção em massa de Manhua Dramas. O Sora 2 e o Veo 3.1 oferecem soluções diferentes para isso.

Método de criação de personagens no Sora 2:

- Prepare imagens de referência do personagem (frente, perfil, corpo inteiro).

- Faça o upload do material de referência via Character API.

- Obtenha um Character ID reutilizável.

- Referencie esse ID nas gerações de cenas subsequentes.

Método de manutenção de personagens no Veo 3.1:

- Faça o upload de várias imagens de referência do personagem.

- Use a função

style referencepara travar o estilo. - Descreva detalhadamente as características do personagem no comando.

- Mantenha a consistência através de gerações contínuas.

Dica técnica: Recomenda-se criar de 3 a 5 imagens de referência em ângulos diferentes para os personagens principais; isso aumenta significativamente a precisão do modelo de linguagem grande na compreensão das características do personagem.

Fase 3 do Fluxo de Manhua Drama: Geração de Vídeo em Lote

Este é o elo técnico mais importante do fluxo de trabalho. Ao enviar tarefas de geração em lote via API, a capacidade de produção pode ser drasticamente aumentada.

Estratégias de Geração em Lote:

- Geração Paralela: Envio simultâneo de solicitações de geração para várias cenas.

- Gestão de Prioridades: Geração prioritária de cenas cruciais para permitir ajustes rápidos.

- Retentativa Automática: Detecção automática de falhas na geração e reenvio da tarefa.

- Validação de Resultados: Filtragem automática de saídas que atendem aos padrões de qualidade.

Fase 4 do Fluxo de Manhua Drama: Edição de Pós-Produção e Áudio

Os clipes de vídeo gerados precisam passar por integração de edição e adição de áudio.

| Etapa de Pós-produção | Ferramenta Recomendada | Proporção de Tempo | Grau de Automação |

|---|---|---|---|

| Junção de Vídeos | FFmpeg / Premiere | 15% | Pode ser totalmente automatizada |

| Efeitos de Transição | After Effects | 10% | Semiautomatizada |

| Dublagem e Música | Eleven Labs / Suno | 25% | Pode ser totalmente automatizada |

| Adição de Legendas | Whisper + Aegisub | 15% | Pode ser totalmente automatizada |

| Gradação de Cor | DaVinci Resolve | 20% | Semiautomatizada |

| Controle de Qualidade | Revisão Humana | 15% | Requer intervenção humana |

Fase 5 do Fluxo de Manhua Drama: Distribuição Multi-plataforma

Exportação dos arquivos de vídeo de acordo com as especificações de cada plataforma.

- TikTok / Reels / Kwai: Vertical 9:16, 1080×1920, menos de 60 segundos.

- YouTube / Bilibili: Horizontal 16:9, 1920×1080, sem limite de duração.

- Instagram / Red: 3:4 ou 9:16, foco na atratividade da capa.

- WhatsApp / WeChat: Suporta múltiplos formatos, recomenda-se 9:16.

🎯 Sugestão de Eficiência: Usar a interface unificada da APIYI (apiyi.com) permite chamar vários modelos de vídeo simultaneamente, escolhendo o melhor modelo para cada cena específica e alcançando um equilíbrio entre custo e qualidade.

Uso central do Sora 2 na produção de vídeos estilo mangá

O Sora 2 é o modelo de geração de vídeo lançado pela OpenAI, e sua funcionalidade "Character Cameo" é o suporte técnico fundamental para a produção em massa de séries de vídeos baseados em mangás.

Tecnologia de consistência de personagens do Sora 2 (Character Cameo)

O Character Cameo permite a criação de identidades de personagens reutilizáveis, garantindo que o mesmo personagem mantenha uma aparência consistente em diferentes cenas.

Duas formas de criar um ID de personagem:

Opção 1: Extrair de um vídeo existente

import requests

# 从视频 URL 提取角色特征

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/extract",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"video_url": "https://example.com/character_reference.mp4",

"character_name": "protagonist_male"

}

)

character_id = response.json()["character_id"]

Opção 2: Criar a partir de imagens de referência

# 从多角度参考图创建角色

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/create",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"images": [

"base64_front_view...",

"base64_side_view...",

"base64_full_body..."

],

"character_name": "protagonist_female",

"description": "20岁亚洲女性,黑色长发,温柔气质"

}

)

Aplicação da função Image-to-Video do Sora 2 na produção de mangás animados

A função Image-to-Video (imagem para vídeo) do Sora 2 consegue transformar quadros estáticos de mangás em vídeos dinâmicos, sendo uma etapa crucial no fluxo de trabalho de produção.

| Cenário de Imagem para Vídeo | Requisitos de entrada | Efeito de saída | Quando aplicar |

|---|---|---|---|

| Dinamização de imagem única | Imagem estática em HD | Vídeo dinâmico de 6 a 15 segundos | Capas, telas de transição |

| Expressões e movimentos | Close-up do personagem | Adição de microexpressões como piscar, sorrir, etc. | Cenas de diálogo |

| Extensão de cena | Imagem parcial | Movimentos de câmera (zoom in/out), extensão do ambiente | Estabelecimento de plano (establishing shots) |

| Conversão de estilo | Qualquer imagem | Conversão para estilo anime ou realista | Unificação de estilo |

Melhores práticas para geração de vídeos com Sora 2

Template estruturado de comando:

[Descrição do sujeito] + [Ação/Comportamento] + [Ambiente da cena] + [Linguagem cinematográfica] + [Especificação de estilo]

Exemplo:

"Uma garota de cabelos pretos (character_id: char_001) sentada à janela de um café,

mexendo suavemente uma xícara de café, a luz do sol entrando pela janela de vidro, tons quentes,

plano médio-curto, profundidade de campo rasa, estilo anime japonês, cores suaves"

Sugestões de parâmetros de geração:

- Duração: Recomenda-se de 6 a 10 segundos por cena, facilitando a edição posterior.

- Resolução: Priorize 1080p para equilibrar qualidade e custo.

- Predefinição de estilo: Use o preset "Comic" para obter um estilo de mangá mais estável.

🎯 Sugestão de chamada de API: Para chamadas em lote da API do Sora 2, recomendamos o uso do APIYI (apiyi.com). Ele oferece suporte ao gerenciamento de fila de tarefas e tentativas automáticas, aumentando a taxa de sucesso na geração em massa.

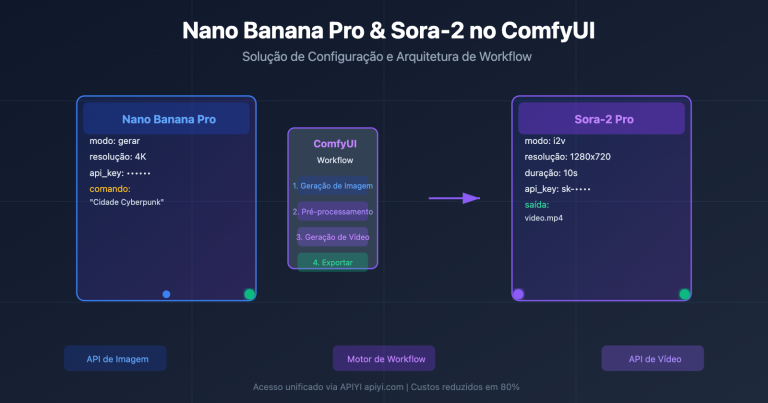

Uso central do Veo 3.1 na produção de vídeos estilo mangá

O Veo 3.1 é o mais recente Modelo de Linguagem Grande para geração de vídeo lançado pelo Google DeepMind, apresentando vantagens únicas no campo da produção em massa de vídeos curtos e mangás animados.

Saída 4K e vantagens de qualidade do Veo 3.1

Comparado às gerações anteriores, o Veo 3.1 teve uma melhoria significativa na qualidade e estabilidade da imagem, sendo ideal para projetos que exigem alta definição.

| Versão do Veo | Resolução Máxima | Suporte de Áudio | Consistência de Personagem | Velocidade de Geração |

|---|---|---|---|---|

| Veo 2 | 1080p | Não | Regular | Rápida |

| Veo 3 | 4K | Áudio Nativo | Boa | Média |

| Veo 3.1 | 4K | Áudio Aprimorado | Excelente | 30-60 segundos |

Principais vantagens do Veo 3.1:

- Geração de áudio nativo: Pode gerar simultaneamente efeitos sonoros, som ambiente e até diálogos de personagens.

- Consistência aprimorada: A função de upload de múltiplas imagens de referência melhora drasticamente a consistência.

- Suporte nativo para formato vertical: Gera vídeos diretamente na proporção 9:16, ideal para plataformas de vídeos curtos (TikTok/Reels).

- Controle de estilo preciso: Controle exato do estilo de saída através de uma imagem de "style reference".

Geração de vídeos verticais com Veo 3.1 para produções mobile

Os conteúdos de mangá para plataformas de vídeos curtos precisam do formato vertical. O suporte nativo do Veo 3.1 evita a perda de qualidade causada por recortes posteriores.

Método de geração vertical:

# 通过上传竖屏参考图触发竖屏生成

response = requests.post(

"https://vip.apiyi.com/v1/veo/generate",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"prompt": "动漫风格,黑发少女在樱花树下,微风吹动头发,唯美氛围",

"reference_image": "vertical_reference_9_16.jpg",

"duration": 8,

"with_audio": True,

"audio_prompt": "轻柔的钢琴背景音乐,树叶沙沙声"

}

)

Tecnologia de controle de personagem com múltiplas referências no Veo 3.1

O Veo 3.1 permite o upload de várias imagens de referência para orientar a geração de personagens, objetos e cenários, o que é vital para manter a consistência na produção em lote.

Estratégia de uso de múltiplas referências:

- Imagens do personagem: 3 a 5 fotos de design do personagem em diferentes ângulos.

- Imagens do cenário: 2 a 3 referências de estilo de cenário.

- Imagem de estilo: 1 a 2 referências para a estética visual geral.

🎯 Sugestão de escolha de modelo: Quando precisar de qualidade 4K e áudio nativo, escolha o Veo 3.1. Se o foco for garantir a consistência absoluta do personagem através de IDs, escolha o Sora 2. O APIYI (apiyi.com) permite a chamada unificada de ambos os modelos, facilitando a troca flexível entre eles conforme a necessidade do projeto.

Plano técnico para produção em lote de mangás dramáticos: Prática de automação via API

Automatizar o fluxo de trabalho da produção de mangás dramáticos é a chave para aumentar a produtividade. Abaixo está o plano completo de implementação técnica.

Arquitetura do script de automação para produção em lote de mangás dramáticos

import asyncio

from typing import List, Dict

class MangaDramaProducer:

"""Estrutura de automação para produção em lote de mangás dramáticos"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

async def batch_generate(

self,

scenes: List[Dict],

model: str = "sora-2"

) -> List[str]:

"""Gera vídeos de cenas em lote"""

tasks = []

for scene in scenes:

task = self.generate_scene(scene, model)

tasks.append(task)

results = await asyncio.gather(*tasks)

return results

async def generate_scene(

self,

scene: Dict,

model: str

) -> str:

"""Geração de cena única"""

# Constrói o comando (prompt)

prompt = self.build_prompt(scene)

# Chama a API

video_url = await self.call_api(prompt, model)

return video_url

Ver código completo do script de automação

import asyncio

import aiohttp

from typing import List, Dict, Optional

from dataclasses import dataclass

import json

@dataclass

class Scene:

"""Estrutura de dados da cena"""

scene_id: int

duration: int

setting: str

characters: List[str]

action: str

camera: str

dialogue: Optional[str] = None

@dataclass

class Character:

"""Estrutura de dados do personagem"""

char_id: str

name: str

description: str

reference_images: List[str]

class MangaDramaProducer:

"""Framework completo para produção em lote de mangás dramáticos"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.characters: Dict[str, str] = {} # nome -> character_id

async def create_character(

self,

character: Character

) -> str:

"""Cria o ID do personagem"""

async with aiohttp.ClientSession() as session:

async with session.post(

f"{self.base_url}/sora/characters/create",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"images": character.reference_images,

"character_name": character.char_id,

"description": character.description

}

) as resp:

result = await resp.json()

char_id = result["character_id"]

self.characters[character.name] = char_id

return char_id

def build_prompt(self, scene: Scene) -> str:

"""Constrói o comando da cena"""

char_refs = []

for char_name in scene.characters:

if char_name in self.characters:

char_refs.append(

f"(character_id: {self.characters[char_name]})"

)

prompt_parts = [

scene.action,

f"Cenário: {scene.setting}",

f"Câmera: {scene.camera}",

"Estilo anime, alta qualidade, rico em detalhes"

]

if char_refs:

prompt_parts.insert(0, " ".join(char_refs))

return ", ".join(prompt_parts)

async def generate_scene(

self,

scene: Scene,

model: str = "sora-2",

with_audio: bool = False

) -> Dict:

"""Gera uma única cena"""

prompt = self.build_prompt(scene)

async with aiohttp.ClientSession() as session:

endpoint = "sora" if "sora" in model else "veo"

async with session.post(

f"{self.base_url}/{endpoint}/generate",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"prompt": prompt,

"duration": scene.duration,

"with_audio": with_audio

}

) as resp:

result = await resp.json()

return {

"scene_id": scene.scene_id,

"video_url": result.get("video_url"),

"status": result.get("status")

}

async def batch_generate(

self,

scenes: List[Scene],

model: str = "sora-2",

max_concurrent: int = 5

) -> List[Dict]:

"""Gera cenas em lote"""

semaphore = asyncio.Semaphore(max_concurrent)

async def limited_generate(scene):

async with semaphore:

return await self.generate_scene(scene, model)

tasks = [limited_generate(s) for s in scenes]

results = await asyncio.gather(*tasks, return_exceptions=True)

# Trata tarefas que falharam

successful = []

failed = []

for i, result in enumerate(results):

if isinstance(result, Exception):

failed.append(scenes[i])

else:

successful.append(result)

# Tenta novamente as tarefas que falharam

if failed:

retry_results = await self.batch_generate(

failed, model, max_concurrent

)

successful.extend(retry_results)

return successful

# Exemplo de uso

async def main():

producer = MangaDramaProducer("sua_api_key")

# Cria personagem

protagonist = Character(

char_id="char_001",

name="Xiaoyu",

description="Mulher de 20 anos, longos cabelos pretos, temperamento suave",

reference_images=["base64_img1", "base64_img2"]

)

await producer.create_character(protagonist)

# Define as cenas

scenes = [

Scene(1, 8, "Rua da cidade ao entardecer", ["Xiaoyu"], "Caminhando sozinha olhando o celular", "Plano médio de acompanhamento"),

Scene(2, 6, "Interior de um café", ["Xiaoyu"], "Sentada à janela bebendo café", "Plano médio-curto fixo"),

Scene(3, 10, "Banco de parque", ["Xiaoyu"], "Observando o pôr do sol distraída", "Close-up com zoom lento")

]

# Geração em lote

results = await producer.batch_generate(scenes, model="sora-2")

print(json.dumps(results, indent=2, ensure_ascii=False))

if __name__ == "__main__":

asyncio.run(main())

Estratégia de otimização de custos para produção em lote de mangás dramáticos

| Direção da Otimização | Medidas Específicas | Economia Esperada | Dificuldade de Implementação |

|---|---|---|---|

| Escolha do Modelo | Usar modelos de baixo custo para cenas simples | 30-50% | Baixa |

| Controle de Resolução | Escolher 720p/1080p/4K conforme a necessidade | 20-40% | Baixa |

| Descontos por Lote | Utilizar plataformas agregadoras de API | 10-20% | Baixa |

| Reutilização de Cache | Reutilizar resultados para cenas semelhantes | 15-25% | Média |

| Otimização de Tempo | Controlar precisamente a duração de cada take | 10-15% | Média |

🎯 Sugestão de controle de custos: A APIYI (apiyi.com) oferece uma interface unificada para vários modelos de vídeo, permitindo a escolha de diferentes níveis de modelos conforme a demanda. Combinado com descontos para tarefas em lote, isso pode reduzir significativamente o custo total da produção.

Análise Comparativa Sora 2 vs. Veo 3.1 na Produção de Mangás Dramáticos

Escolher o modelo de geração de vídeo adequado é fundamental para o sucesso da produção em lote. Abaixo está uma comparação detalhada entre os dois principais modelos do mercado.

Comparativo de capacidades principais: Sora 2 vs. Veo 3.1

| Dimensão | Sora 2 | Veo 3.1 | Sugestão para Mangás Dramáticos |

|---|---|---|---|

| Duração Máxima | 15-25 segundos | 8-15 segundos | Sora 2 é ideal para planos longos |

| Consistência de Personagem | Suporte nativo via Character Cameo | Esquema de múltiplas imagens de referência | Sora 2 é mais estável |

| Geração de Áudio | Requer dublagem separada | Suporte a áudio nativo | Veo 3.1 é mais eficiente |

| Resolução de Saída | 1080p | 4K | Veo 3.1 tem melhor qualidade de imagem |

| Suporte Vertical | Requer recorte na pós-produção | Suporte nativo | Veo 3.1 é melhor para vídeos curtos |

| Predefinições de Estilo | Predefinições Comic/Anime | Style Reference | Ambos possuem vantagens |

| Velocidade de Geração | Média | 30-60 seg/clipe | Veo 3.1 é um pouco mais rápido |

| Estabilidade da API | Alta | Alta | Ambos estão prontos para uso comercial |

Guia de seleção de cenários para produção

Escolha o Sora 2 quando:

- Precisar de tramas contínuas com consistência rigorosa de personagens.

- Tiver cenas narrativas de plano sequência (mais de 10 segundos).

- Houver interações complexas entre personagens.

- Já possuir um fluxo de trabalho de dublagem maduro.

Escolha o Veo 3.1 quando:

- Buscar saída em resolução 4K de alta definição.

- O conteúdo for para plataformas de vídeos curtos (TikTok, Instagram Reels).

- Precisar de vídeos rápidos com áudio nativo.

- O projeto for focado principalmente em conteúdo vertical.

Estratégia de uso misto:

Para grandes projetos de mangás dramáticos, recomenda-se misturar os dois modelos conforme as características das cenas:

- Cenas com personagens centrais → Sora 2 (garante a consistência).

- Planos de cobertura (b-roll) ambientais → Veo 3.1 (alta qualidade + efeitos sonoros).

- Cenas de diálogo rápido → Veo 3.1 (áudio nativo).

- Cenas de ação → Sora 2 (suporte a maior duração).

🎯 Sugestão de troca de modelo: Através da interface unificada da APIYI (apiyi.com), você pode alternar de forma flexível entre Sora 2 e Veo 3.1 no mesmo projeto, sem precisar alterar a estrutura do código, apenas mudando o parâmetro do modelo.

Perguntas Frequentes

P1: Entre o Sora 2 e o Veo 3.1, qual é o melhor para a produção em massa de manjus (vídeos de quadrinhos)?

Ambos têm suas vantagens. O recurso Character Cameo do Sora 2 se destaca na consistência dos personagens, sendo ideal para tramas contínuas que exigem personagens fixos. Já o áudio nativo e a saída em 4K do Veo 3.1 são mais indicados para projetos de vídeos curtos que buscam alta qualidade de imagem e rapidez na finalização. Sugerimos alternar o uso conforme a necessidade específica de cada cena.

P2: Qual é o custo aproximado da produção em massa de manjus?

Utilizando IA para a produção em massa, o custo por episódio (3 a 5 minutos) pode ser controlado na faixa de 50 a 200 yuans, dependendo principalmente da quantidade de cenários, da resolução escolhida e do nível do modelo utilizado. Isso representa uma redução de mais de 90% em comparação à produção tradicional. Através de plataformas agregadoras como a APIYI (apiyi.com), também é possível obter descontos adicionais para grandes volumes.

P3: Como começar rapidamente a produção em massa de manjus?

Recomendamos os seguintes passos para um início rápido:

- Acesse a APIYI (apiyi.com), cadastre sua conta e obtenha sua API Key.

- Prepare fotos de referência para 2 ou 3 personagens principais.

- Escreva um roteiro de storyboard estruturado (comece com 5 a 10 cenas).

- Use os exemplos de código fornecidos neste artigo para realizar testes de geração.

- Ajuste os comandos e parâmetros conforme os resultados obtidos.

P4: Como garantir a consistência dos personagens no fluxo de produção de manjus?

Os métodos principais incluem: usar o Character Cameo do Sora 2 para criar um ID de personagem; preparar imagens de referência de vários ângulos para cada personagem; manter as descrições dos personagens consistentes nos comandos; e utilizar predefinições de estilo fixas. Recomendamos gerar de 3 a 5 cenas de teste para validar a consistência antes de iniciar a produção oficial.

Resumo

Pontos-chave da produção em massa de manjus:

- Padronização do Workflow: Estabeleça um fluxo de produção completo, desde o roteiro até a distribuição, com entradas e saídas claras em cada etapa.

- Estratégia de Seleção de Modelo: O Sora 2 foca na consistência dos personagens, enquanto o Veo 3.1 foca na qualidade de imagem e áudio. Alterne entre eles com flexibilidade.

- Automação em Lote: Envie tarefas em massa via API para reduzir o tempo de geração de 50 cenas para menos de 1 hora.

- Otimização de Custos: Escolha a resolução e o nível do modelo de acordo com a necessidade, e utilize plataformas agregadoras para obter descontos em escala.

A produção em massa de manjus por IA está amadurecendo rapidamente. Dominar os recursos principais do Sora 2 e do Veo 3.1, além de estabelecer um workflow eficiente, é a chave para aproveitar esta onda de oportunidades no mercado de conteúdo.

Recomendamos utilizar a APIYI (apiyi.com) para obter uma interface unificada de API para modelos de vídeo. A plataforma suporta os principais modelos como Sora 2 e Veo 3.1, oferecendo créditos de teste gratuitos e suporte técnico.

Referências

⚠️ Nota sobre o formato dos links: Todos os links externos utilizam o formato

Nome do Recurso: domain.com, facilitando a cópia sem permitir o clique direto, para evitar a perda de autoridade de SEO.

-

Documentação oficial do OpenAI Sora: Introdução aos recursos do Sora 2 e guia de uso da API

- Link:

help.openai.com/en/articles/12593142-sora-release-notes - Descrição: Detalhes oficiais sobre a funcionalidade Character Cameo

- Link:

-

Página oficial do Google Veo: Introdução ao modelo Veo 3.1

- Link:

deepmind.google/models/veo - Descrição: Explicação sobre a saída em 4K e capacidades de geração de áudio

- Link:

-

AI Comic Factory: Projeto de código aberto para geração de quadrinhos

- Link:

github.com/jbilcke-hf/ai-comic-factory - Descrição: Referência de implementação para geração de quadrinhos com LLM + SDXL

- Link:

-

Hugging Face AI Comic: Blog técnico sobre geração de quadrinhos

- Link:

huggingface.co/blog/ai-comic-factory - Descrição: Detalhes técnicos sobre geração em lote e integração de API

- Link:

Autor: Equipe Técnica

Troca de Experiência Técnica: Convidamos você a discutir suas experiências práticas na produção de vídeos de quadrinhos/mangás em lote na seção de comentários. Para mais materiais sobre geração de vídeo por IA, visite a comunidade técnica APIYI em apiyi.com.