ملاحظة المؤلف: تحليل متعمق لسير العمل الكامل لإنتاج مسلسلات الـ AI المانجا (Manga Drama) بكميات كبيرة، مع شرح مفصل لكيفية استخدام مخرجات Sora 2 Character Cameo و Veo 3.1 4K لتحقيق إنتاج فعال.

أصبحت مسلسلات الـ AI المانجا توجهًا جديدًا في مجال صناعة المحتوى. إن كيفية استخدام Sora 2 و Veo 3.1 لبناء سير عمل فعال للإنتاج الضخم لهذه المسلسلات هي السؤال الجوهري الذي يستكشفه كل مبدع.

القيمة الجوهرية: بنهاية هذا المقال، ستتقن سير العمل الكامل لإنتاج مسلسلات المانجا، وتتعلم كيفية استخدام خاصية Sora 2 Character Cameo للحفاظ على تناسق الشخصيات، بالإضافة إلى تقنيات عملية لاستخدام Veo 3.1 في إخراج فيديوهات عمودية بدقة 4K.

القيمة الجوهرية لإنتاج مسلسلات المانجا بالذكاء الاصطناعي وفرص السوق

يعيد الإنتاج الضخم لمسلسلات الـ AI المانجا تعريف حدود الكفاءة في صناعة المحتوى. يتطلب إنتاج المانجا التقليدي قدرًا هائلًا من الرسم اليدوي وتحريك الرسوم، بينما يتيح ظهور Sora 2 و Veo 3.1 لفريق من شخص واحد تحقيق مخرجات بمستوى صناعي احترافي.

| معيار المقارنة | الإنتاج التقليدي للمانجا | الإنتاج الضخم بذكاء اصطناعي | زيادة الكفاءة |

|---|---|---|---|

| دورة إنتاج الحلقة الواحدة | 7-14 يومًا | 2-4 ساعات | 50-80 ضعفًا |

| تناسق الشخصية | يعتمد على مهارة الرسام | حفاظ تلقائي عبر API | 100% متسق |

| توليد المشاهد | رسم كل إطار على حدة | توليد ضخم | 20-50 ضعفًا |

| تكلفة الاستثمار | بمستوى آلاف الدولارات/للحلقة | بمستوى عشرات الدولارات/للحلقة | خفض بنسبة 90% |

| القدرة الإنتاجية القصوى | 2-4 حلقات شهريًا | 50-100 حلقة شهريًا | 25 ضعفًا |

المزايا الأساسية الثلاث للإنتاج الضخم لمسلسلات المانجا

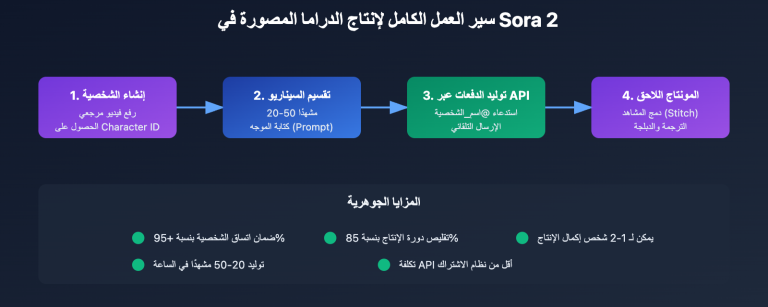

أولًا، طفرة تقنية في تناسق الشخصية. تتيح ميزة Character Cameo في Sora 2 إنشاء معرف (ID) شخصية قابل لإعادة الاستخدام، مما يضمن احتفاظ الشخصية نفسها بملامحها المظهرية تمامًا في مختلف المشاهد. هذا يحل المشكلة الجوهرية المتمثلة في "تغير ملامح" الشخصيات في توليد الفيديو التقليدي بالذكاء الاصطناعي.

ثانيًا، توحيد معايير عملية الإنتاج الضخم. من خلال واجهات برمجة التطبيقات (API)، يمكن للمبدعين دمج تحليل السيناريو، وتوليد الموجهات، وتوليد الفيديو، والمونتاج النهائي في خط إنتاج آلي واحد. يمكن ضغط وقت توليد 20-50 مشهدًا من عدة ساعات إلى أقل من ساعة واحدة.

ثالثًا، مرونة التكيف مع المنصات المتعددة. يدعم Veo 3.1 توليد الفيديو الرأسي (العمودي) بشكل أصلي، مما يسمح بإخراج محتوى بنسبة 9:16 مباشرة ليناسب منصات الفيديو القصيرة مثل تيك توك، وإنستغرام ريلز، دون الحاجة إلى قص الفيديو مرة أخرى.

🎯 نصيحة المنصة: يتطلب الإنتاج الضخم لمسلسلات المانجا بيئة استدعاء API مستقرة. نوصي بالحصول على الواجهة الموحدة لـ Sora 2 وغيرها من نماذج الفيديو الرائدة عبر APIYI (apiyi.com)، الذي يدعم تقديم المهام الجماعية وتحسين التكاليف.

تحليل سير عمل إنتاج "المانجو" (القصص المصورة المتحركة) بالكامل

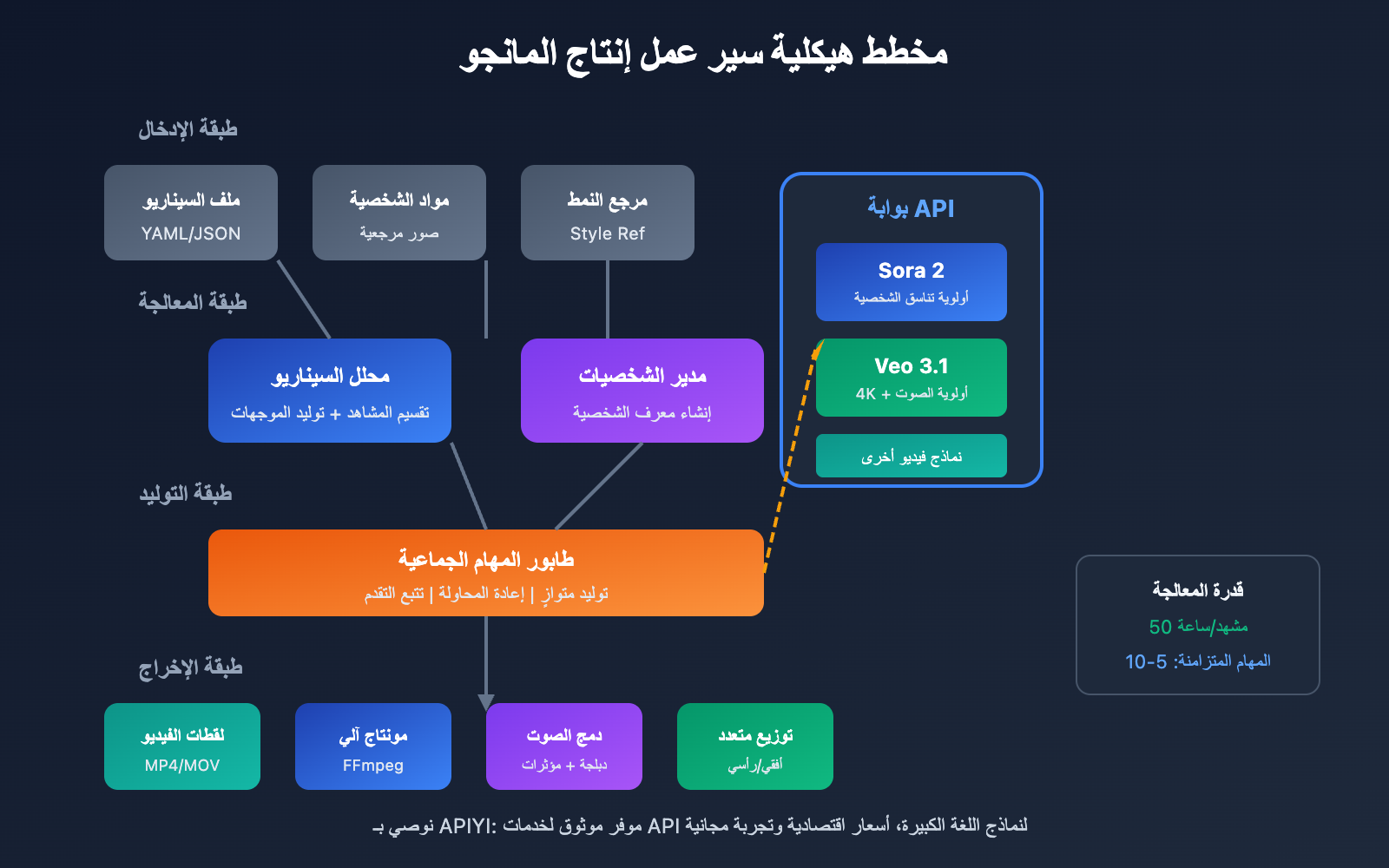

يمكن تقسيم سير عمل إنتاج المانجو بالكامل إلى خمس مراحل أساسية، ولكل مرحلة مدخلات ومخرجات واضحة ونقاط تقنية محددة.

المرحلة الأولى من سير عمل إنتاج المانجو: التخطيط للسيناريو وتصميم لوحة القصة

نقطة البداية في سير عمل إنتاج المانجو هي السيناريو المنظم. على عكس السيناريو التقليدي، يحتاج سيناريو المانجو المعتمد على الذكاء الاصطناعي إلى وصف بصري مفصل لكل لقطة.

| عناصر السيناريو | الطريقة التقليدية | طريقة سير عمل المانجو بالذكاء الاصطناعي | توضيح الدور |

|---|---|---|---|

| وصف المشهد | داخل مقهى | مقهى عصري بسيط، نوافذ ممتدة من الأرض إلى السقف، ضوء شمس بعد الظهر، ألوان دافئة | توفير أساس للتوليد البصري |

| حركة الشخصية | "أحمد" يشرب القهوة | رجل بشعر أسود، قميص أبيض، يمسك كوب قهوة بيده اليمنى، يبتسم وهو ينظر من النافذة | ضمان إمكانية توليد الحركة |

| لغة الكاميرا | لقطة قريبة | لقطة متوسطة القرب، زاوية 45 درجة، خلفية ضبابية (Depth of field) | توجيه تكوين الصورة |

| تحديد المدة | لا يوجد | 8 ثوانٍ | إعداد بارامترات الـ API |

نموذج لتنسيق نص لوحة القصة (Storyboarding):

episode: 1

title: "اللقاء الأول"

total_scenes: 12

characters:

- id: "char_001"

name: "سارة"

description: "امرأة في العشرينيات، شعر أسود طويل، فستان أبيض"

- id: "char_002"

name: "أحمد"

description: "رجل في الثانية والعشرين، شعر قصير، بدلة كاجوال"

scenes:

- scene_id: 1

duration: 6

setting: "شارع في المدينة، وقت الغروب، أضواء النيون بدأت تشتعل"

characters: ["char_001"]

action: "سارة تمشي وحدها في الشارع، تنظر إلى هاتفها"

camera: "لقطة تتبع، لقطة متوسطة"

المرحلة الثانية من سير عمل إنتاج المانجو: إنشاء أصول الشخصيات

يعد الحفاظ على تناسق الشخصية التحدي الأكبر في الإنتاج الضخم للمانجو. ويقدم كل من Sora 2 و Veo 3.1 حلولاً مختلفة لذلك.

طريقة إنشاء الشخصية في Sora 2:

- تحضير صور مرجعية للشخصية (أمامية، جانبية، صورة كاملة للجسم).

- رفع المواد المرجعية عبر Character API.

- الحصول على معرف شخصية (Character ID) قابل لإعادة الاستخدام.

- الإشارة إلى هذا المعرف في توليد المشاهد اللاحقة.

طريقة الحفاظ على الشخصية في Veo 3.1:

- رفع عدة صور مرجعية للشخصية.

- استخدام خاصية "النمط المرجعي" (style reference) لتثبيت النمط.

- وصف سمات الشخصية بالتفصيل في الموجه (Prompt).

- الحفاظ على التناسق من خلال التوليد المستمر.

نصيحة تقنية: يُنصح بإنشاء 3-5 صور مرجعية بزوايا مختلفة للشخصيات الرئيسية، فهذا يحسن بشكل كبير من دقة فهم نموذج الذكاء الاصطناعي لسمات الشخصية.

المرحلة الثالثة من سير عمل إنتاج المانجو: توليد الفيديو الجماعي

هذا هو الجزء التقني الأهم في سير عمل إنتاج المانجو. ومن خلال إرسال مهام التوليد دفعاتٍ عبر الـ API، يمكن رفع القدرة الإنتاجية بشكل هائل.

استراتيجيات التوليد الجماعي:

- التوليد المتوازي: إرسال طلبات توليد لمشاهد متعددة في وقت واحد.

- إدارة الأولويات: توليد المشاهد الرئيسية أولاً لتسهيل التعديلات السريعة.

- إعادة المحاولة التلقائية: الكشف التلقائي عن المهام الفاشلة وإعادة إرسالها.

- التحقق من النتائج: تصفية المخرجات تلقائياً بناءً على معايير الجودة.

المرحلة الرابعة من سير عمل إنتاج المانجو: المونتاج اللاحق والصوتيات

تحتاج لقطات الفيديو المولدة إلى دمج وتنسيق وإضافة صوت.

| مرحلة ما بعد الإنتاج | الأدوات الموصى بها | نسبة الوقت | مستوى الأتمتة |

|---|---|---|---|

| دمج الفيديو | FFmpeg / Premiere | 15% | أتمتة كاملة ممكنة |

| تأثيرات الانتقال | After Effects | 10% | أتمتة جزئية |

| الدبلجة والموسيقى | Eleven Labs / Suno | 25% | أتمتة كاملة ممكنة |

| إضافة الترجمة | Whisper + Aegisub | 15% | أتمتة كاملة ممكنة |

| ضبط الألوان | DaVinci Resolve | 20% | أتمتة جزئية |

| مراجعة الجودة | تدقيق بشري | 15% | يتطلب تدخل بشري |

المرحلة الخامسة من سير عمل إنتاج المانجو: التوزيع عبر منصات متعددة

يتم تصدير ملفات الفيديو بالمواصفات المناسبة لكل منصة.

- TikTok / Kwai: أبعاد 9:16 (رأسي)، 1080×1920، أقل من 60 ثانية.

- Bilibili / YouTube: أبعاد 16:9 (أفقي)، 1920×1080، لا توجد قيود على المدة.

- Instagram / Red: أبعاد 3:4 أو 9:16، التركيز على جاذبية الغلاف.

- WeChat Video Accounts: يدعم نسباً متعددة، ويُفضل 9:16.

🎯 نصيحة للكفاءة: باستخدام واجهة APIYI الموحدة (apiyi.com)، يمكنك استدعاء عدة نماذج فيديو في وقت واحد، واختيار النموذج الأفضل لكل مشهد لتحقيق التوازن بين التكلفة والجودة.

الاستخدامات الأساسية لـ Sora 2 في إنتاج مسلسلات المانجا الرقمية

يعد Sora 2، نموذج توليد الفيديو الذي أطلقته OpenAI، بمثابة الركيزة التقنية الأساسية للإنتاج الضخم لمسلسلات المانجا، بفضل ميزة Character Cameo.

تقنية اتساق الشخصية Character Cameo في Sora 2

تسمح ميزة Character Cameo بإنشاء هويات شخصيات قابلة لإعادة الاستخدام، مما يضمن احتفاظ الشخصية نفسها بمظهر متسق عبر المشاهد المختلفة.

طريقتان لإنشاء معرف الشخصية (Character ID):

الطريقة الأولى: الاستخراج من فيديو موجود

import requests

# 从视频 URL 提取角色特征

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/extract",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"video_url": "https://example.com/character_reference.mp4",

"character_name": "protagonist_male"

}

)

character_id = response.json()["character_id"]

الطريقة الثانية: الإنشاء من صور مرجعية

# 从多角度参考图创建角色

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/create",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"images": [

"base64_front_view...",

"base64_side_view...",

"base64_full_body..."

],

"character_name": "protagonist_female",

"description": "20岁亚洲女性,黑色长发,温柔气质"

}

)

تطبيق وظيفة "تحويل الصورة إلى فيديو" في Sora 2 في إنتاج مسلسلات المانجا

يمكن لوظيفة "تحويل الصورة إلى فيديو" (Image-to-Video) في Sora 2 تحويل إطارات المانجا الثابتة إلى فيديوهات متحركة، وهي حلقة وصل حيوية في سير عمل إنتاج مسلسلات المانجا.

| مشهد تحويل الصورة إلى فيديو | متطلبات الإدخال | تأثير الإخراج | حالات الاستخدام |

|---|---|---|---|

| تحريك صورة واحدة | صورة ثابتة عالية الدقة | فيديو ديناميكي مدته 6-15 ثانية | الأغلفة، مشاهد الانتقال |

| التعبيرات والحركات | لقطة مقربة للوجه | إضافة تعبيرات دقيقة مثل الرمش والابتسام | مشاهد الحوار |

| تمديد المشهد | لقطة جزئية | تقريب/إبعاد الكاميرا، تمديد البيئة | لقطات التأسيس |

| تحويل الأسلوب | أي صورة | تحويلها إلى أسلوب أنمي أو واقعي | توحيد الأسلوب الفني |

أفضل الممارسات لتوليد مسلسلات المانجا باستخدام Sora 2

قالب هيكلي للموجه:

[وصف العنصر الأساسي] + [الفعل أو الحركة] + [البيئة والمشهد] + [لغة الكاميرا] + [تحديد الأسلوب]

مثال:

"فتاة ذات شعر أسود (character_id: char_001) تجلس بجانب نافذة مقهى،

تحرك فنجان القهوة بلطف، ضوء الشمس يتدفق من النافذة الكبيرة، ألوان دافئة،

لقطة متوسطة قريبة، عمق ميدان ضحل، أسلوب أنمي ياباني، ألوان ناعمة"

توصيات معايير التوليد:

- المدة: يُنصح بـ 6-10 ثوانٍ للقطة الواحدة لتسهيل المونتاج لاحقاً.

- الدقة: الأفضلية لدقة 1080p لتحقيق التوازن بين الجودة والتكلفة.

- الإعدادات المسبقة للأسلوب: استخدم إعداد "Comic" المسبق للحصول على أسلوب مانجا أكثر استقراراً.

🎯 نصيحة لاستدعاء واجهة البرمجة (API): يوصى بإجراء الاستدعاءات الضخمة لواجهة برمجة تطبيقات Sora 2 عبر APIYI (apiyi.com)، حيث يدعم إدارة طوابير المهام وإعادة المحاولة التلقائية، مما يزيد من معدل نجاح الإنتاج الضخم.

الاستخدامات الأساسية لـ Veo 3.1 في إنتاج مسلسلات المانجا الرقمية

يعد Veo 3.1 أحدث نموذج لتوليد الفيديو من Google DeepMind، ويتمتع بمزايا فريدة في مجال الإنتاج الضخم لمسلسلات المانجا.

مخرجات 4K ومزايا جودة الصورة في Veo 3.1

يوفر Veo 3.1 تحسناً ملحوظاً في جودة الصورة والاستقرار مقارنة بالإصدارات السابقة، مما يجعله مثالياً لمشاريع مسلسلات المانجا التي تتطلب مخرجات عالية الدقة.

| إصدار Veo | أقصى دقة | دعم الصوت | اتساق الشخصية | سرعة التوليد |

|---|---|---|---|---|

| Veo 2 | 1080p | لا يوجد | متوسط | سريع نسبياً |

| Veo 3 | 4K | صوت أصلي | جيد | متوسط |

| Veo 3.1 | 4K | صوت محسن | ممتاز | 30-60 ثانية |

المزايا الأساسية لـ Veo 3.1:

- توليد صوت أصلي: يمكنه توليد المؤثرات الصوتية، أصوات البيئة، وحتى حوارات الشخصيات في آن واحد.

- تعزيز اتساق الشخصية: تعمل ميزة رفع الصور المرجعية المتعددة على تحسين الاتساق بشكل كبير.

- دعم أصلي للفيديوهات الطولية: يولد فيديوهات بنسبة 9:16 مباشرة، بما يتناسب مع منصات الفيديوهات القصيرة.

- تحكم دقيق في الأسلوب: التحكم بدقة في أسلوب المخرجات من خلال صور مرجعية للنمط (style reference).

تطبيق توليد الفيديو الطولي في Veo 3.1 في إنتاج مسلسلات المانجا

تتطلب محتوى مسلسلات المانجا على منصات الفيديوهات القصيرة تنسيقاً طولياً، ويوفر Veo 3.1 دعماً أصلياً لهذا التنسيق لتجنب فقدان تفاصيل الصورة الناتج عن القص اليدوي.

طريقة التوليد الطولي:

# 通过上传竖屏参考图触发竖屏生成

response = requests.post(

"https://vip.apiyi.com/v1/veo/generate",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"prompt": "动漫风格,黑发少女在樱花树下,微风吹动头发,唯美氛围",

"reference_image": "vertical_reference_9_16.jpg",

"duration": 8,

"with_audio": True,

"audio_prompt": "轻柔的钢琴背景音乐,树叶沙沙声"

}

)

تقنية التحكم في الشخصية عبر مراجع متعددة في Veo 3.1

يدعم Veo 3.1 رفع صور مرجعية متعددة لتوجيه عملية توليد الشخصيات، الأشياء، والمشاهد، وهذا أمر بالغ الأهمية للحفاظ على الاتساق في الإنتاج الضخم لمسلسلات المانجا.

استراتيجية استخدام المراجع المتعددة:

- صور الشخصية: 3-5 صور للشخصية من زوايا مختلفة.

- صور المشهد: 2-3 صور مرجعية لأسلوب المشهد.

- صور الأسلوب: 1-2 صورة مرجعية للنمط الفني العام.

🎯 نصيحة لاختيار النموذج: اختر Veo 3.1 عندما تحتاج إلى جودة صورة 4K وصوت أصلي، واختر Sora 2 عندما تكون الأولوية القصوى لضمان اتساق الشخصية. يدعم APIYI (apiyi.com) الاستدعاء الموحد لكلا النموذجين، مما يسهل التبديل المرن بينهما.

حل تقني للإنتاج المتسلسل للمانجا الدرامية: تطبيق عملي لأتمتة واجهة البرمجيات (API)

تُعد أتمتة سير عمل إنتاج المانجا الدرامية (Manga Drama) مفتاحاً لزيادة الإنتاجية. إليك الحل التقني المتكامل للتنفيذ.

بنية كود أتمتة الإنتاج المتسلسل للمانجا الدرامية

import asyncio

from typing import List, Dict

class MangaDramaProducer:

"""إطار عمل أتمتة الإنتاج المتسلسل للمانجا الدرامية"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

async def batch_generate(

self,

scenes: List[Dict],

model: str = "sora-2"

) -> List[str]:

"""إنشاء فيديوهات المشاهد دفعة واحدة"""

tasks = []

for scene in scenes:

task = self.generate_scene(scene, model)

tasks.append(task)

results = await asyncio.gather(*tasks)

return results

async def generate_scene(

self,

scene: Dict,

model: str

) -> str:

"""إنشاء مشهد واحد"""

# بناء الموجه

prompt = self.build_prompt(scene)

# استدعاء واجهة البرمجيات (API)

video_url = await self.call_api(prompt, model)

return video_url

عرض كود نص الأتمتة البرمجي الكامل

import asyncio

import aiohttp

from typing import List, Dict, Optional

from dataclasses import dataclass

import json

@dataclass

class Scene:

"""هيكل بيانات المشهد"""

scene_id: int

duration: int

setting: str

characters: List[str]

action: str

camera: str

dialogue: Optional[str] = None

@dataclass

class Character:

"""هيكل بيانات الشخصية"""

char_id: str

name: str

description: str

reference_images: List[str]

class MangaDramaProducer:

"""الإطار الكامل للإنتاج المتسلسل للمانجا الدرامية"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.characters: Dict[str, str] = {} # name -> character_id

async def create_character(

self,

character: Character

) -> str:

"""إنشاء معرف الشخصية (ID)"""

async with aiohttp.ClientSession() as session:

async with session.post(

f"{self.base_url}/sora/characters/create",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"images": character.reference_images,

"character_name": character.char_id,

"description": character.description

}

) as resp:

result = await resp.json()

char_id = result["character_id"]

self.characters[character.name] = char_id

return char_id

def build_prompt(self, scene: Scene) -> str:

"""بناء موجه المشهد"""

char_refs = []

for char_name in scene.characters:

if char_name in self.characters:

char_refs.append(

f"(character_id: {self.characters[char_name]})"

)

prompt_parts = [

scene.action,

f"المشهد: {scene.setting}",

f"اللقطة: {scene.camera}",

"نمط الأنمي، جودة عالية، تفاصيل غنية"

]

if char_refs:

prompt_parts.insert(0, " ".join(char_refs))

return "،".join(prompt_parts)

async def generate_scene(

self,

scene: Scene,

model: str = "sora-2",

with_audio: bool = False

) -> Dict:

"""إنشاء مشهد واحد"""

prompt = self.build_prompt(scene)

async with aiohttp.ClientSession() as session:

endpoint = "sora" if "sora" in model else "veo"

async with session.post(

f"{self.base_url}/{endpoint}/generate",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"prompt": prompt,

"duration": scene.duration,

"with_audio": with_audio

}

) as resp:

result = await resp.json()

return {

"scene_id": scene.scene_id,

"video_url": result.get("video_url"),

"status": result.get("status")

}

async def batch_generate(

self,

scenes: List[Scene],

model: str = "sora-2",

max_concurrent: int = 5

) -> List[Dict]:

"""إنشاء المشاهد دفعة واحدة"""

semaphore = asyncio.Semaphore(max_concurrent)

async def limited_generate(scene):

async with semaphore:

return await self.generate_scene(scene, model)

tasks = [limited_generate(s) for s in scenes]

results = await asyncio.gather(*tasks, return_exceptions=True)

# التعامل مع المهام الفاشلة

successful = []

failed = []

for i, result in enumerate(results):

if isinstance(result, Exception):

failed.append(scenes[i])

else:

successful.append(result)

# إعادة محاولة المهام الفاشلة

if failed:

retry_results = await self.batch_generate(

failed, model, max_concurrent

)

successful.extend(retry_results)

return successful

# مثال على الاستخدام

async def main():

producer = MangaDramaProducer("your_api_key")

# إنشاء شخصية

protagonist = Character(

char_id="char_001",

name="شياو يو",

description="امرأة تبلغ من العمر 20 عاماً، شعر أسود طويل، مزاج لطيف",

reference_images=["base64_img1", "base64_img2"]

)

await producer.create_character(protagonist)

# تعريف المشاهد

scenes = [

Scene(1, 8, "شارع المدينة وقت الغروب", ["شياو يو"], "تمشي بمفردها وتنظر إلى هاتفها", "لقطة متوسطة متتبعة"),

Scene(2, 6, "داخل مقهى", ["شياو يو"], "تجلس بجانب النافذة وتشرب القهوة", "لقطة متوسطة قريبة ثابتة"),

Scene(3, 10, "مقعد في الحديقة", ["شياو يو"], "تحدق في غروب الشمس وهي شاردة الذهن", "لقطة قريبة بتقريب بطيء")

]

# إنشاء متسلسل

results = await producer.batch_generate(scenes, model="sora-2")

print(json.dumps(results, indent=2, ensure_ascii=False))

if __name__ == "__main__":

asyncio.run(main())

استراتيجيات تحسين التكلفة للإنتاج المتسلسل للمانجا الدرامية

| اتجاه التحسين | الإجراءات المحددة | التوفير المتوقع | صعوبة التنفيذ |

|---|---|---|---|

| اختيار النموذج | استخدام نماذج منخفضة التكلفة للمشاهد البسيطة | 30-50% | منخفضة |

| التحكم في الدقة | اختيار 720p/1080p/4K حسب الحاجة | 20-40% | منخفضة |

| خصومات الجملة | استخدام منصات تجميع واجهات البرمجيات (API) | 10-20% | منخفضة |

| إعادة استخدام التخزين المؤقت | إعادة استخدام نتائج الإنشاء للمشاهد المتشابهة | 15-25% | متوسطة |

| تحسين المدة | التحكم الدقيق في مدة كل لقطة | 10-15% | متوسطة |

🎯 نصيحة للتحكم في التكلفة: توفر منصة APIYI apiyi.com واجهة موحدة للعديد من نماذج الفيديو، وتدعم اختيار فئات مختلفة من النماذج حسب الطلب، ومع خصومات المهام المتسلسلة، يمكن تقليل التكلفة الإجمالية لإنتاج المانجا الدرامية بشكل فعال.

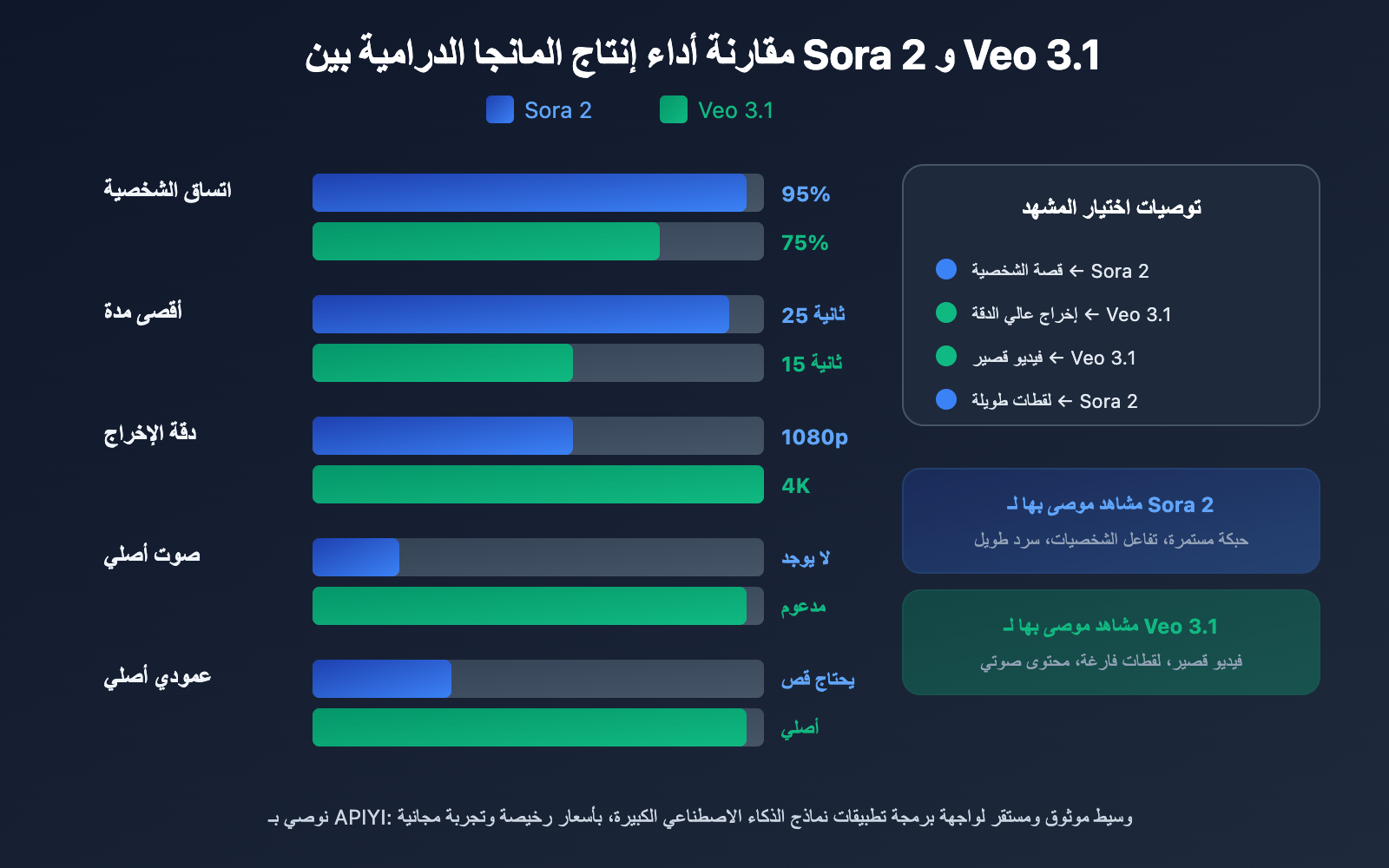

تحليل مقارن لإنتاج المانجا الدرامية بين Sora 2 و Veo 3.1

يُعد اختيار نموذج توليد الفيديو المناسب هو المفتاح لنجاح الإنتاج المتسلسل للمانجا الدرامية. إليك مقارنة مفصلة بين نموذجين رائدين.

مقارنة القدرات الجوهرية بين Sora 2 و Veo 3.1

| بُعد المقارنة | Sora 2 | Veo 3.1 | توصيات إنتاج المانجا الدرامية |

|---|---|---|---|

| أقصى مدة | 15-25 ثانية | 8-15 ثانية | Sora 2 مناسب لللقطات الطويلة |

| اتساق الشخصية | دعم أصلي لـ Character Cameo | خطة صور مرجعية متعددة | Sora 2 أكثر استقراراً |

| توليد الصوت | يحتاج دبلجة منفصلة | دعم الصوت الأصلي | Veo 3.1 أعلى كفاءة |

| دقة الإخراج | 1080p | 4K | Veo 3.1 أفضل في جودة الصورة |

| دعم الوضع العمودي | يحتاج قص في مرحلة ما بعد الإنتاج | دعم أصلي | Veo 3.1 أكثر ملاءمة للفيديوهات القصيرة |

| الإعدادات المسبقة للنمط | إعدادات مسبقة Comic/Anime | مرجع النمط (Style Reference) | لكل منهما مزاياه |

| سرعة الإنشاء | متوسطة | 30-60 ثانية/لقطة | Veo 3.1 أسرع قليلاً |

| استقرار الـ API | عالي | عالي | كلاهما جاهز للاستخدام التجاري |

دليل اختيار المشاهد لإنتاج المانجا الدرامية

المشاهد التي يُفضل فيها استخدام Sora 2:

- القصص المستمرة التي تتطلب اتساقاً صارماً للشخصيات.

- لقطات السرد الطويلة (أكثر من 10 ثوانٍ).

- مشاهد تفاعل الشخصيات المعقدة.

- المشاريع التي لديها بالفعل سير عمل ناضج للدبلجة الصوتية.

المشاهد التي يُفضل فيها استخدام Veo 3.1:

- السعي للحصول على دقة إخراج 4K عالية الجودة.

- محتوى منصات الفيديو القصيرة (تيك توك، ريلز، إلخ).

- الحاجة لإنتاج سريع مع صوت أصلي مدمج.

- المشاريع التي تعتمد أساساً على المحتوى العمودي.

استراتيجية الاستخدام المختلط:

للمشاريع الكبيرة للمانجا الدرامية، يوصى بالخلط بين النموذجين بناءً على خصائص المشاهد:

- مشاهد الشخصيات الأساسية ← Sora 2 (لضمان الاتساق).

- لقطات البيئة الفارغة ← Veo 3.1 (جودة عالية + مؤثرات صوتية).

- مشاهد الحوار ← Veo 3.1 (صوت أصلي).

- مشاهد الحركة ← Sora 2 (دعم مدة أطول).

🎯 نصيحة لتبديل النماذج: من خلال الواجهة الموحدة لـ APIYI apiyi.com، يمكنك التبديل بمرونة بين Sora 2 و Veo 3.1 في نفس المشروع دون الحاجة لتعديل هيكل الكود، فقط قم بتغيير معاملات النموذج.

الأسئلة الشائعة

س1: أيهما أفضل لإنتاج “المانجا المتحركة” (Manhua Video) بكميات كبيرة: Sora 2 أم Veo 3.1؟

لكل منهما مميزاته الخاصة. تتفوق ميزة Character Cameo في Sora 2 بشكل كبير في الحفاظ على اتساق الشخصية، مما يجعله مثاليًا للحبكات الدرامية المتسلسلة التي تتطلب شخصيات ثابتة. أما Veo 3.1، فيتميز بدعم الصوت الأصلي ومخرجات بدقة 4K، وهو ما يناسب مشاريع الفيديوهات القصيرة التي تسعى لجودة صورة فائقة وإنتاج سريع. نوصي بالدمج بينهما واستخدامهما وفقًا لاحتياجاتك المحددة.

س2: كم تبلغ تكلفة إنتاج المانجا المتحركة بكميات كبيرة تقريبًا؟

عند استخدام الذكاء الاصطناعي للإنتاج الضخم، يمكن حصر تكلفة الحلقة الواحدة (من 3 إلى 5 دقائق) في نطاق يتراوح بين 50 إلى 200 يوان صيني تقريبًا، وذلك يعتمد بشكل أساسي على عدد المشاهد، ودقة الفيديو المختارة، وفئة النموذج المستخدم. يمثل هذا انخفاضًا في التكلفة بنسبة تزيد عن 90% مقارنة بطرق الإنتاج التقليدية. كما يمكنك الحصول على خصومات إضافية للطلبات الكبيرة عبر منصات التجميع مثل APIYI apiyi.com.

س3: كيف يمكنني البدء سريعًا في إنتاج المانجا المتحركة بكميات كبيرة؟

نوصي باتباع خطوات التشغيل السريع التالية:

- قم بزيارة APIYI apiyi.com، وسجل حسابًا للحصول على مفتاح API (API Key).

- جهز صورتين أو ثلاث صور مرجعية للشخصيات الرئيسية.

- اكتب سيناريو مصورًا (Storyboard) مهيكلًا (ابدأ بـ 5 إلى 10 مشاهد).

- استخدم أمثلة الأكواد البرمجية المقدمة في هذه المقالة لإجراء اختبارات التوليد.

- قم بتعديل الموجهات (Prompts) والمعلمات بناءً على النتائج المحققة.

س4: كيف نضمن اتساق الشخصية في سير عمل إنتاج المانجا؟

تشمل الطرق الأساسية ما يلي: استخدام ميزة Character Cameo في Sora 2 لإنشاء معرف شخصية (Character ID)؛ إعداد صور مرجعية متعددة الزوايا لكل شخصية؛ الحفاظ على وصف موحد للشخصية في كافة الموجهات؛ واستخدام إعدادات نمط (Style Presets) ثابتة. يُنصح بتوليد من 3 إلى 5 مشاهد تجريبية للتحقق من الاتساق قبل البدء في الإنتاج الفعلي.

الخلاصة

النقاط الجوهرية لإنتاج المانجا المتحركة بكميات كبيرة:

- توحيد معايير سير العمل: بناء سير عمل متكامل يبدأ من السيناريو وينتهي بالتوزيع، مع تحديد المدخلات والمخرجات لكل مرحلة بوضوح.

- استراتيجية اختيار النموذج: الاعتماد على Sora 2 للتركيز على اتساق الشخصية، وVeo 3.1 للتركيز على جودة الصورة والصوت، والتبديل بينهما بمرونة حسب المشهد.

- الأتمتة الضخمة: إرسال المهام بكميات كبيرة عبر واجهة برمجة التطبيقات (API)، لتقليص وقت توليد 50 مشهدًا إلى أقل من ساعة واحدة.

- تحسين التكلفة: اختيار دقة الفيديو وفئة النموذج حسب الحاجة، واستخدام منصات التجميع للحصول على خصومات على الكميات.

إن تقنيات الإنتاج الضخم للمانجا المتحركة عبر الذكاء الاصطناعي تنضج بسرعة. إن إتقان القدرات الأساسية لنموذجي Sora 2 وVeo 3.1، وبناء سير عمل إنتاج عالي الكفاءة، هو المفتاح لاغتنام الفرص في طفرة المحتوى الحالية.

نوصي بالحصول على واجهة API موحدة لنماذج الفيديو عبر APIYI apiyi.com، حيث تدعم المنصة النماذج الرائدة مثل Sora 2 وVeo 3.1، وتوفر رصيدًا مجانيًا للاختبار مع دعم فني متخصص.

المصادر والمراجع

⚠️ توضيح تنسيق الروابط: جميع الروابط الخارجية تستخدم تنسيق

اسم المصدر: domain.comلتسهيل النسخ ولكنها غير قابلة للنقر، وذلك لتجنب فقدان قوة تحسين محركات البحث (SEO).

-

وثائق OpenAI Sora الرسمية: مقدمة لميزات Sora 2 ودليل استخدام واجهة البرمجيات (API)

- الرابط:

help.openai.com/en/articles/12593142-sora-release-notes - الوصف: شرح تفصيلي لميزة Character Cameo الرسمية

- الرابط:

-

صفحة Google Veo الرسمية: مقدمة لنموذج Veo 3.1

- الرابط:

deepmind.google/models/veo - الوصف: توضيح لقدرات إخراج بدقة 4K وتوليد الصوت

- الرابط:

-

AI Comic Factory: مشروع مفتوح المصدر لإنتاج القصص المصورة

- الرابط:

github.com/jbilcke-hf/ai-comic-factory - الوصف: مرجع لتنفيذ إنتاج القصص المصورة باستخدام نموذج لغة كبير + SDXL

- الرابط:

-

Hugging Face AI Comic: مدونة تقنية حول إنتاج القصص المصورة

- الرابط:

huggingface.co/blog/ai-comic-factory - الوصف: تفاصيل تقنية حول الإنتاج الضخم وتكامل واجهة البرمجيات (API)

- الرابط:

المؤلف: الفريق التقني

التبادل التقني: نرحب بمناقشة الخبرات العملية في الإنتاج الضخم لدراما القصص المصورة في قسم التعليقات. لمزيد من المصادر حول توليد فيديوهات الذكاء الاصطناعي، يمكنك زيارة مجتمع APIYI التقني على apiyi.com