Entendendo as Configurações de Segurança da API Gemini

Ao usar a API de geração de imagens do Gemini (como gemini-2.0-flash-exp-image-generation ou gemini-3-pro-image-preview), você pode ter encontrado códigos de configuração como este:

"safetySettings": [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_NONE"}

]

O que exatamente essa configuração significa? BLOCK_NONE realmente permite que o modelo gere qualquer tipo de conteúdo? Neste artigo, vamos analisar em detalhes como funcionam as configurações de segurança da API Gemini e como usá-las corretamente.

Valor Central: Após ler este artigo, você vai entender as quatro categorias principais de danos do Gemini, os cinco níveis de threshold disponíveis, e o real funcionamento e limitações do BLOCK_NONE.

Pontos-Chave das Configurações de Segurança do Gemini

| Ponto | Descrição | Importância |

|---|---|---|

| Quatro Categorias de Danos | Assédio, discurso de ódio, conteúdo sexualmente explícito, conteúdo perigoso | Dimensões ajustáveis de filtragem de conteúdo |

| Cinco Níveis de Threshold | OFF, BLOCK_NONE, BLOCK_FEW, BLOCK_SOME, BLOCK_MOST | Controlam a sensibilidade da filtragem |

| Significado do BLOCK_NONE | Desativa a filtragem por probabilidade nesta categoria, mas não contorna proteções centrais | A configuração ajustável mais permissiva |

| Proteções Não Ajustáveis | Segurança infantil e outros danos centrais são sempre bloqueados | Proteções hardcoded, impossíveis de desativar |

Filosofia de Design das Configurações de Segurança

As configurações de segurança da API Gemini usam um mecanismo de proteção em camadas:

- Camada Ajustável: Desenvolvedores podem ajustar os thresholds de filtragem das quatro categorias principais de acordo com o cenário de aplicação

- Camada Não Ajustável: Para danos centrais como segurança infantil, o sistema sempre bloqueia, impossível de contornar através de qualquer configuração

Isso significa que, mesmo se você definir todas as categorias como BLOCK_NONE, o modelo ainda vai recusar gerar conteúdo que envolva segurança infantil e outras violações centrais.

As Quatro Categorias de Danos

O Gemini classifica potenciais riscos de conteúdo em quatro categorias principais:

1. HARM_CATEGORY_HARASSMENT (Assédio)

Definição: Conteúdo que promove, incentiva ou representa comentários negativos ou prejudiciais direcionados a indivíduos ou grupos.

Exemplos:

- Bullying ou intimidação específica a pessoas

- Ameaças ou incitação à violência

- Degradação sistemática de grupos específicos

Cenários de Uso: Aplicações de bate-papo, análise de comentários, moderação de comunidades

2. HARM_CATEGORY_HATE_SPEECH (Discurso de Ódio)

Definição: Conteúdo que promove ou incita ódio contra pessoas baseado em atributos como raça, etnia, gênero, nacionalidade, religião, orientação sexual, etc.

Exemplos:

- Declarações discriminatórias contra grupos específicos

- Estereótipos negativos e generalizações prejudiciais

- Conteúdo que desumaniza certos grupos

Cenários de Uso: Plataformas de mídia social, sistemas de filtragem de conteúdo, análise de sentimentos

3. HARM_CATEGORY_SEXUALLY_EXPLICIT (Conteúdo Sexualmente Explícito)

Definição: Conteúdo que descreve, representa ou promove atos sexuais ou nudez de forma explícita.

Exemplos:

- Descrições detalhadas de atividades sexuais

- Imagens ou textos pornográficos

- Conteúdo sexual não consensual

Cenários de Uso: Geração de conteúdo, moderação de imagens, aplicações educacionais

4. HARM_CATEGORY_DANGEROUS_CONTENT (Conteúdo Perigoso)

Definição: Conteúdo que promove, facilita ou glorifica atividades prejudiciais ou perigosas.

Exemplos:

- Instruções para criar armas ou explosivos

- Promoção de automutilação ou suicídio

- Guias para atividades criminosas

- Desinformação médica que pode causar danos

Cenários de Uso: Ferramentas de pesquisa, chatbots educacionais, plataformas de compartilhamento de conhecimento

Os Cinco Níveis de Threshold

O Gemini oferece cinco níveis de sensibilidade de filtragem. Vamos entender o que cada um significa:

BLOCK_NONE → BLOCK_FEW → BLOCK_SOME → BLOCK_MOST → OFF

↑ ↑

Mais Permissivo Mais Restritivo

Detalhamento dos Thresholds

| Threshold | Probabilidade Bloqueada | Cenário Ideal | Permissividade |

|---|---|---|---|

| BLOCK_NONE | Nenhuma (mas proteções centrais permanecem) | Pesquisa acadêmica, análise de dados | ⭐⭐⭐⭐⭐ |

| BLOCK_FEW | HIGH (alta probabilidade) | Ferramentas criativas, ambientes controlados | ⭐⭐⭐⭐ |

| BLOCK_SOME | MEDIUM + HIGH | Aplicações empresariais gerais | ⭐⭐⭐ |

| BLOCK_MOST | LOW + MEDIUM + HIGH | Plataformas públicas | ⭐⭐ |

| OFF | Todas as probabilidades | Ambientes altamente sensíveis (padrão) | ⭐ |

O Que BLOCK_NONE Realmente Faz?

Existe um equívoco comum sobre BLOCK_NONE: muitos acreditam que ele desativa completamente a filtragem de segurança. Isso não é verdade.

A Verdade Sobre BLOCK_NONE

BLOCK_NONE significa: "Não bloquear com base em probabilidades de segurança nesta categoria, mas ainda respeitar as proteções centrais não ajustáveis."

# Configuração comum que você pode ter visto

safety_settings = [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_NONE"}

]

# Mesmo com essa configuração, o modelo AINDA VAI BLOQUEAR:

# ✗ Conteúdo envolvendo menores

# ✗ Violações graves de segurança

# ✗ Atividades ilegais explícitas

# ✗ Outras proteções hardcoded

O Que BLOCK_NONE Permite

Permite:

- ✅ Discussões maduras sobre tópicos sensíveis (em contexto apropriado)

- ✅ Conteúdo artístico ou educacional que poderia ser marcado incorretamente

- ✅ Análise de dados históricos ou pesquisa acadêmica

- ✅ Geração criativa com linguagem mais livre

Ainda Bloqueia:

- ❌ Qualquer conteúdo envolvendo menores

- ❌ Violações graves de direitos humanos

- ❌ Instruções explícitas para atividades ilegais

- ❌ Outros danos centrais definidos pelo sistema

Proteções Centrais Não Ajustáveis

Independentemente das suas configurações de safetySettings, o Gemini mantém proteções absolutas para:

🔒 Proteções Permanentes

-

Segurança Infantil (CSAM)

- Zero tolerância para qualquer conteúdo envolvendo menores

- Impossível de desativar ou ajustar

- Aplicada independentemente de outras configurações

-

Violência Extrema

- Conteúdo que promove violência grave ou terrorismo

- Instruções detalhadas para causar danos em massa

-

Atividades Ilegais Explícitas

- Tráfico de substâncias controladas

- Crimes financeiros (fraude, lavagem de dinheiro)

- Exploração ilegal

-

Violações de Privacidade

- Exposição de informações pessoais identificáveis (PII)

- Doxxing ou assédio direcionado

Por Que Essas Proteções São Absolutas?

┌─────────────────────────────────────────────┐

│ Camadas de Proteção do Gemini │

├─────────────────────────────────────────────┤

│ [Proteções Centrais - NÃO AJUSTÁVEIS] │ ← Hardcoded

│ ▪ Segurança Infantil │

│ ▪ Violência Extrema │

│ ▪ Atividades Ilegais │

├─────────────────────────────────────────────┤

│ [safetySettings - AJUSTÁVEIS] │ ← Configuráveis

│ ▪ HARASSMENT (threshold) │

│ ▪ HATE_SPEECH (threshold) │

│ ▪ SEXUALLY_EXPLICIT (threshold) │

│ ▪ DANGEROUS_CONTENT (threshold) │

└─────────────────────────────────────────────┘

Guia Prático: Como Configurar safetySettings

Cenário 1: Aplicação Pública (Máxima Segurança)

# Recomendado para aplicações voltadas ao consumidor

safety_settings = [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_MOST"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_MOST"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_MOST"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_MOST"}

]

Casos de Uso:

- Chatbots de atendimento ao cliente

- Aplicações educacionais para crianças

- Plataformas de mídia social

Cenário 2: Ferramenta Criativa (Permissividade Moderada)

# Balanceado para conteúdo criativo

safety_settings = [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_SOME"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_SOME"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_FEW"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_SOME"}

]

Casos de Uso:

- Ferramentas de escrita criativa

- Geração de histórias

- Design artístico

Cenário 3: Pesquisa/Análise (Máxima Permissividade)

# Para ambientes de pesquisa controlados

safety_settings = [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_NONE"}

]

Casos de Uso:

- Pesquisa acadêmica

- Análise de conteúdo histórico

- Estudos de moderação de conteúdo

- Ambientes de desenvolvimento/teste

⚠️ Importante: Mesmo com BLOCK_NONE, proteções centrais permanecem ativas!

Exemplo de Código Completo

Aqui está como implementar configurações de segurança em uma chamada real da API:

import google.generativeai as genai

genai.configure(api_key="SUA_API_KEY")

# Configurar modelo com configurações de segurança personalizadas

generation_config = {

"temperature": 1.0,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 8192,

}

safety_settings = [

{"category": "HARM_CATEGORY_HARASSMENT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_HATE_SPEECH", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT", "threshold": "BLOCK_NONE"},

{"category": "HARM_CATEGORY_DANGEROUS_CONTENT", "threshold": "BLOCK_NONE"}

]

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

generation_config=generation_config,

safety_settings=safety_settings

)

# Gerar conteúdo

response = model.generate_content("Seu prompt aqui")

print(response.text)

# Verificar avaliações de segurança

for rating in response.candidates[0].safety_ratings:

print(f"{rating.category}: {rating.probability}")

Tratamento de Bloqueios de Segurança

Mesmo com BLOCK_NONE, você pode encontrar bloqueios. Veja como lidar com eles:

try:

response = model.generate_content(prompt)

# Verificar se a resposta foi bloqueada

if response.candidates[0].finish_reason.name == "SAFETY":

print("❌ Conteúdo bloqueado por razões de segurança")

# Verificar qual categoria acionou o bloqueio

for rating in response.candidates[0].safety_ratings:

if rating.blocked:

print(f" Bloqueado por: {rating.category}")

print(f" Probabilidade: {rating.probability}")

else:

print("✅ Conteúdo gerado com sucesso")

print(response.text)

except Exception as e:

print(f"Erro: {e}")

Melhores Práticas

✅ Faça

- Comece conservador: Use

BLOCK_MOSTouBLOCK_SOMEinicialmente - Ajuste baseado em dados: Monitore falsos positivos e ajuste gradualmente

- Contextualize: Use thresholds diferentes para diferentes partes da sua aplicação

- Documente decisões: Registre por que você escolheu configurações específicas

- Revise regularmente: Políticas de segurança evoluem, suas configurações também devem

❌ Não Faça

- Presumir que BLOCK_NONE = Sem filtragem: Proteções centrais sempre estão ativas

- Usar BLOCK_NONE por padrão: Reserve para casos de uso específicos

- Ignorar ratings de segurança: Sempre verifique

safety_ratingsna resposta - Configurar e esquecer: Monitore ativamente as saídas da sua aplicação

Entendendo os Safety Ratings na Resposta

Cada resposta do Gemini inclui safety_ratings que mostram como o conteúdo foi avaliado:

# Estrutura do Safety Rating

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"probability": "MEDIUM", # NEGLIGIBLE, LOW, MEDIUM, HIGH

"blocked": False # True se bloqueado, False se permitido

}

Interpretando Probabilidades

| Probabilidade | Significado | Ação do Sistema |

|---|---|---|

| NEGLIGIBLE | Risco quase zero | Sempre permitido |

| LOW | Risco mínimo | Bloqueado apenas com BLOCK_MOST |

| MEDIUM | Risco moderado | Bloqueado com BLOCK_SOME+ |

| HIGH | Risco significativo | Bloqueado com BLOCK_FEW+ |

Perguntas Frequentes (FAQ)

Q1: BLOCK_NONE permite qualquer conteúdo?

R: Não. Ele desativa a filtragem baseada em probabilidade para aquela categoria, mas proteções centrais (como segurança infantil) permanecem ativas e não podem ser desativadas.

Q2: Qual threshold devo usar para minha aplicação?

R: Depende do seu cenário:

- Público geral:

BLOCK_MOST - Usuários adultos, conteúdo criativo:

BLOCK_SOMEouBLOCK_FEW - Pesquisa/ambiente controlado:

BLOCK_NONE(com supervisão apropriada)

Q3: Posso desativar completamente a filtragem de segurança?

R: Não para proteções centrais (segurança infantil, etc.). Para categorias ajustáveis, BLOCK_NONE é o mais permissivo possível.

Q4: Por que meu conteúdo foi bloqueado mesmo com BLOCK_NONE?

R: Provavelmente acionou uma proteção central não ajustável ou violou as políticas de uso da API do Google.

Q5: As configurações de segurança afetam a qualidade da saída?

R: Sim, indiretamente. Thresholds mais restritivos podem causar mais falsos positivos e bloqueios, potencialmente limitando a criatividade ou precisão do modelo em certos contextos.

Conclusão

As safetySettings do Gemini fornecem controle granular sobre a filtragem de conteúdo, mas é essencial entender suas capacidades e limitações:

Pontos-Chave para Lembrar:

- ✅ Quatro categorias ajustáveis: Assédio, discurso de ódio, conteúdo sexualmente explícito, conteúdo perigoso

- ✅ Cinco níveis de threshold: De BLOCK_NONE (mais permissivo) a OFF (mais restritivo)

- ✅ BLOCK_NONE ≠ Sem filtragem: Proteções centrais sempre permanecem

- ✅ Proteções não ajustáveis: Segurança infantil e outros danos críticos não podem ser desativados

- ✅ Ajuste baseado no contexto: Escolha thresholds apropriados para o cenário da sua aplicação

Dica Profissional: Sempre monitore safety_ratings nas respostas e ajuste suas configurações iterativamente com base em casos de uso reais. As configurações de segurança não são do tipo "configure e esqueça" — elas requerem ajuste e revisão contínuos.

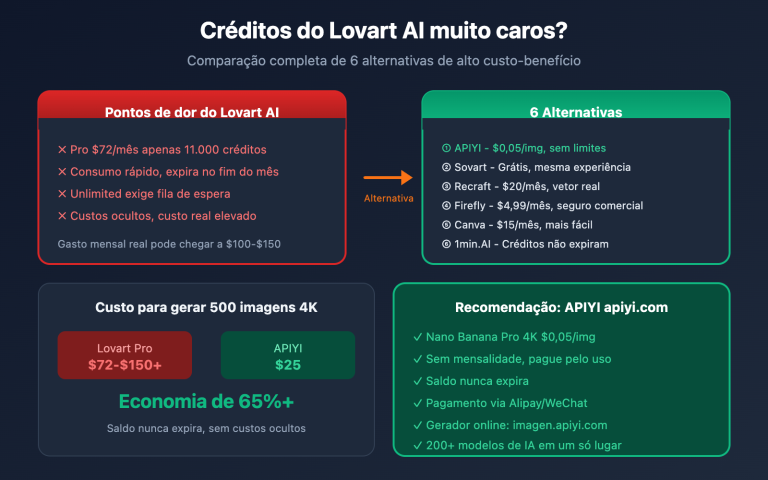

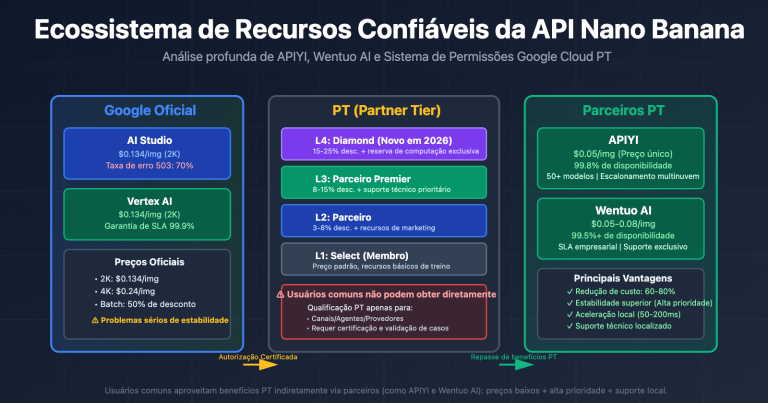

Recomendação de API: APIYI (apiyii.com) oferece acesso estável e confiável às APIs de modelos de IA de grande escala, com preços competitivos e testes gratuitos disponíveis. Ideal para desenvolvedores que trabalham com o Gemini e outros modelos de IA.

Detalhamento das Quatro Categorias de Risco

A API Gemini suporta quatro categorias de risco ajustáveis:

1. HARM_CATEGORY_HARASSMENT (Assédio)

Definição: Comentários negativos ou nocivos direcionados a identidades ou atributos protegidos

Conteúdo incluído:

- Ataques pessoais e insultos

- Discurso discriminatório contra grupos específicos

- Conteúdo relacionado a cyberbullying

2. HARM_CATEGORY_HATE_SPEECH (Discurso de Ódio)

Definição: Conteúdo grosseiro, desrespeitoso ou profano

Conteúdo incluído:

- Discurso racista

- Ódio religioso

- Discriminação baseada em gênero ou orientação sexual

3. HARM_CATEGORY_SEXUALLY_EXPLICIT (Conteúdo Sexual Explícito)

Definição: Referências a atos sexuais ou material obsceno

Conteúdo incluído:

- Descrições sexuais explícitas

- Conteúdo com nudez

- Insinuações pornográficas

4. HARM_CATEGORY_DANGEROUS_CONTENT (Conteúdo Perigoso)

Definição: Conteúdo que promove, facilita ou encoraja comportamentos nocivos

Conteúdo incluído:

- Tutoriais de fabricação de armas

- Instruções de autolesão ou dano a terceiros

- Explicações de atividades ilegais

| Categoria | Constante da API | Objeto de filtragem |

|---|---|---|

| Assédio | HARM_CATEGORY_HARASSMENT |

Ataques pessoais, discurso discriminatório |

| Discurso de ódio | HARM_CATEGORY_HATE_SPEECH |

Ódio racial/religioso |

| Conteúdo sexual | HARM_CATEGORY_SEXUALLY_EXPLICIT |

Descrições sexuais, nudez |

| Conteúdo perigoso | HARM_CATEGORY_DANGEROUS_CONTENT |

Instruções de comportamentos nocivos |

Dica: Ao chamar a API Gemini através do APIYI (apiyi.com), essas configurações de segurança também se aplicam e podem ser configuradas de acordo com suas necessidades específicas.

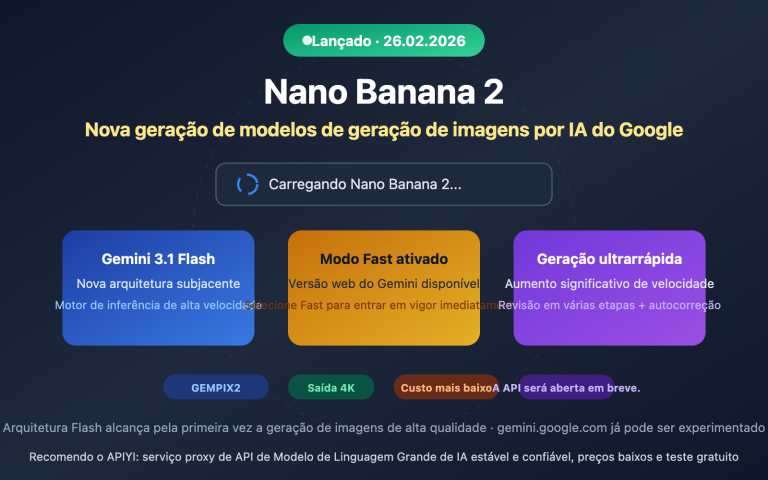

Detalhamento da Configuração dos Cinco Níveis de Limite

A API Gemini oferece cinco níveis de limite para controlar a sensibilidade da filtragem de conteúdo:

| Nome da Configuração | Valor da API | Efeito de Filtragem | Cenário de Uso |

|---|---|---|---|

| Desligado | OFF |

Desativa completamente o filtro de segurança | Padrão para Gemini 2.5+ |

| Não Bloquear | BLOCK_NONE |

Exibe conteúdo independente da avaliação de probabilidade | Necessita máxima liberdade criativa |

| Bloquear Pouco | BLOCK_ONLY_HIGH |

Bloqueia apenas conteúdo com alta probabilidade de risco | Maioria dos cenários de aplicação |

| Bloquear Moderado | BLOCK_MEDIUM_AND_ABOVE |

Bloqueia conteúdo com probabilidade média ou superior | Necessita filtragem moderada |

| Bloquear Muito | BLOCK_LOW_AND_ABOVE |

Bloqueia conteúdo com baixa probabilidade ou superior | Filtragem mais rigorosa |

Como Funcionam os Limites

O sistema Gemini realiza uma avaliação de probabilidade em cada conteúdo, julgando a possibilidade de que seja nocivo:

- HIGH: Alta probabilidade (muito provável que seja conteúdo nocivo)

- MEDIUM: Probabilidade média

- LOW: Baixa probabilidade

- NEGLIGIBLE: Probabilidade desprezível

Ponto-chave: O sistema bloqueia com base na probabilidade e não na gravidade. Isso significa que:

- Conteúdo com alta probabilidade mas baixa gravidade pode ser bloqueado

- Conteúdo com baixa probabilidade mas alta gravidade pode passar

Explicação dos Valores Padrão

| Versão do Modelo | Limite Padrão |

|---|---|

| Gemini 2.5, Gemini 3 e outros modelos GA mais recentes | OFF (Desligado) |

| Outros modelos mais antigos | BLOCK_SOME (Bloquear alguns) |

O Verdadeiro Papel do BLOCK_NONE

O que ele pode fazer

Ao configurar BLOCK_NONE:

- Desativa a filtragem por probabilidade: Aquela categoria não vai mais bloquear conteúdo baseado em avaliações probabilísticas

- Permite conteúdo limítrofe: Conteúdo legítimo que poderia ser julgado incorretamente não será bloqueado

- Aumenta a liberdade criativa: Reduz falsos bloqueios em cenários artísticos, educacionais, jornalísticos, etc.

O que ele não pode fazer

Mesmo que todas as categorias estejam configuradas como BLOCK_NONE:

- Proteções fundamentais continuam ativas: Proteções hardcoded como segurança infantil não podem ser contornadas

- Filtragem multicamada existe: Monitoramento em tempo real durante a geração e verificações pós-processamento ainda estão rodando

- Limites de política permanecem: Conteúdo que viola explicitamente as políticas do Google ainda será rejeitado

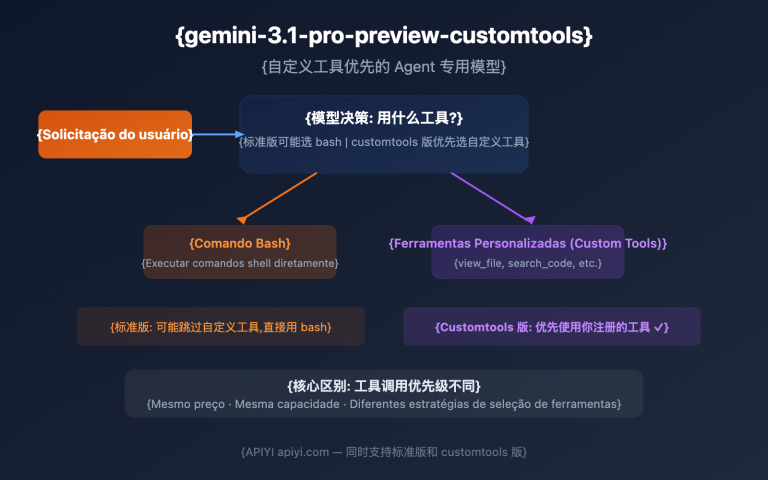

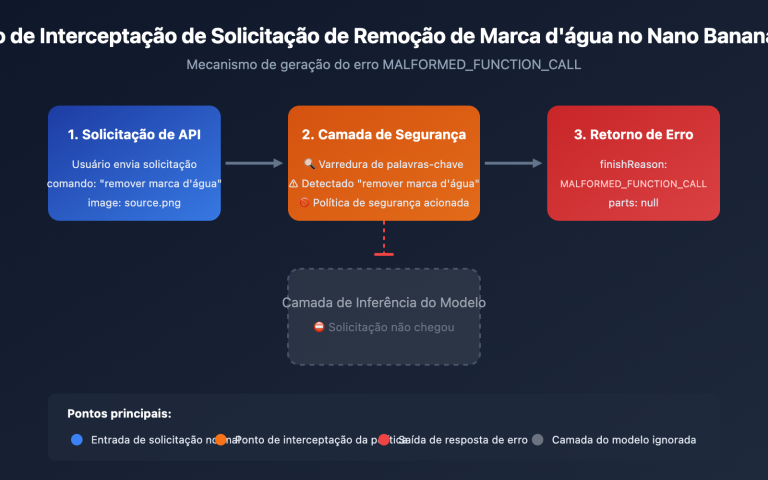

Particularidades da Geração de Imagens

Para modelos de geração de imagens (como gemini-2.0-flash-exp-image-generation), a filtragem de segurança é mais complexa:

- Filtragem de prompt: O texto de entrada é verificado primeiro

- Monitoramento durante a geração: Resultados intermediários são continuamente monitorados

- Revisão pós-geração: Após a conclusão, há ainda uma verificação de conformidade

Pesquisas mostram que prompts explícitos diretos geralmente são bloqueados, mas técnicas como escalação em conversas de múltiplas rodadas podem contornar parte das verificações.

Exemplos de Configuração Prática

Configuração com Python SDK

import google.generativeai as genai

# Configurar definições de segurança

safety_settings = [

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_NONE"

}

]

# Criar instância do modelo

model = genai.GenerativeModel(

model_name="gemini-2.0-flash-exp",

safety_settings=safety_settings

)

# Gerar conteúdo

response = model.generate_content("Seu prompt aqui")

Ver exemplo de configuração REST API

{

"model": "gemini-2.0-flash-exp-image-generation",

"contents": [

{

"role": "user",

"parts": [

{"text": "Gerar uma imagem em estilo artístico"}

]

}

],

"safetySettings": [

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_NONE"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_NONE"

}

],

"generationConfig": {

"responseModalities": ["image", "text"]

}

}

Dica: Através da APIYI apiyi.com você pode testar rapidamente os efeitos de diferentes configurações de segurança – a plataforma suporta chamadas de interface unificada para os modelos da série Gemini.

Cenários de Uso e Recomendações

Cenários Adequados para Usar BLOCK_NONE

| Cenário | Descrição | Configuração Sugerida |

|---|---|---|

| Criação Artística | Arte do corpo humano, expressão abstrata | Categoria de conteúdo sexual pode ser relaxada |

| Reportagem Jornalística | Imagens relacionadas a guerras e conflitos | Categoria de conteúdo perigoso pode ser relaxada |

| Uso Educacional | Conteúdo médico e histórico educacional | Ajustar conforme o conteúdo específico |

| Moderação de Conteúdo | Necessidade de analisar conteúdo potencialmente violador | Definir tudo como BLOCK_NONE |

Cenários Não Recomendados para Usar BLOCK_NONE

| Cenário | Descrição | Configuração Sugerida |

|---|---|---|

| Aplicações Voltadas ao Público | Produtos usados por usuários comuns | BLOCK_MEDIUM_AND_ABOVE |

| Aplicações Relacionadas a Crianças | Produtos educacionais e de entretenimento infantil | BLOCK_LOW_AND_ABOVE |

| Ferramentas Corporativas Internas | Cenários que requerem auditoria de conformidade | BLOCK_ONLY_HIGH |

Melhores Práticas

- Ajuste Progressivo: Comece com as configurações padrão e relaxe gradualmente conforme necessário

- Configuração por Categoria: Diferentes categorias podem ter limiares diferentes, não precisam ser todos iguais

- Monitoramento e Logs: Registre requisições bloqueadas e analise se ajustes são necessários

- Análise do Cenário do Usuário: Decida o nível apropriado de filtragem com base no público-alvo final

Perguntas Frequentes

Q1: Por que o conteúdo ainda é bloqueado depois de definir BLOCK_NONE?

BLOCK_NONE apenas desativa a filtragem por probabilidade dessa categoria, mas o conteúdo ainda pode ser bloqueado nos seguintes casos:

- Proteção Central: Proteções codificadas como segurança infantil não podem ser desativadas

- Outras Categorias: Se apenas algumas categorias foram definidas como BLOCK_NONE

- Linhas Vermelhas de Política: Conteúdo que viola claramente as políticas de uso do Google

- Verificação do Processo de Geração: A geração de imagens tem monitoramento adicional em tempo real

Q2: Qual é a diferença entre OFF e BLOCK_NONE?

De acordo com a documentação oficial do Google:

- OFF: Desativa completamente o filtro de segurança (valor padrão para Gemini 2.5+)

- BLOCK_NONE: Exibe o conteúdo independentemente da avaliação de probabilidade

Os efeitos práticos são muito semelhantes, mas OFF desativa mais completamente a lógica de filtragem dessa categoria. Para modelos mais recentes, ambos têm efeitos praticamente idênticos.

Q3: Como usar as configurações de segurança através de serviços intermediários de API?

Ao chamar a API Gemini através do APIYI apiyi.com:

- Os parâmetros de configuração de segurança são totalmente repassados para a API do Google

- O método de configuração é o mesmo que chamar diretamente a API do Google

- Suporta todas as quatro categorias principais e cinco níveis de limiar

- Permite validar rapidamente os efeitos de diferentes configurações durante a fase de teste

Resumo

Pontos essenciais das configurações de segurança da API Gemini:

- Quatro categorias ajustáveis: Assédio, discurso de ódio, conteúdo sexual e conteúdo perigoso – os desenvolvedores podem ajustar conforme necessário

- Cinco níveis de threshold: De OFF/BLOCK_NONE (mais permissivo) a BLOCK_LOW_AND_ABOVE (mais rigoroso)

- A essência do BLOCK_NONE: Desativa a filtragem por probabilidade, mas não contorna as proteções principais e as diretrizes de política

- Mecanismo de proteção em camadas: Camada ajustável + camada não ajustável, garantindo um nível básico de segurança

- Particularidades da geração de imagens: Filtragem multicamadas (prompt → processo de geração → revisão de saída) é mais rigorosa

Compreendendo essas configurações, você pode ajustar os parâmetros de segurança de acordo com o cenário da aplicação, encontrando o equilíbrio entre liberdade criativa e segurança de conteúdo.

Através do APIYI apiyi.com, você pode testar rapidamente os efeitos das configurações de segurança do modelo de geração de imagens Gemini – a plataforma oferece créditos gratuitos e interface unificada para múltiplos modelos.

Referências

⚠️ Nota sobre formato de links: Todos os links externos usam o formato

Nome do recurso: domain.com, facilitando a cópia mas sem redirecionamento clicável, evitando perda de peso SEO.

-

Documentação oficial de configurações de segurança da API Gemini: Guia oficial do Google

- Link:

ai.google.dev/gemini-api/docs/safety-settings - Descrição: Explicação autoritativa sobre configurações de segurança e referência da API

- Link:

-

Configuração de filtros de segurança do Vertex AI: Documentação do Google Cloud

- Link:

cloud.google.com/vertex-ai/generative-ai/docs/multimodal/configure-safety-filters - Descrição: Detalhes sobre configuração de segurança do Vertex AI em nível empresarial

- Link:

-

Guia de segurança do Gemini: Melhores práticas para desenvolvedores

- Link:

ai.google.dev/gemini-api/docs/safety-guidance - Descrição: Recomendações oficiais para uso seguro da API Gemini

- Link:

-

Configurações de segurança do Firebase AI Logic: Guia de integração do Firebase

- Link:

firebase.google.com/docs/ai-logic/safety-settings - Descrição: Configuração de segurança no ambiente Firebase

- Link:

Autor: Equipe Técnica

Troca técnica: Sinta-se à vontade para discutir nos comentários. Para mais recursos, visite a comunidade técnica APIYI apiyi.com