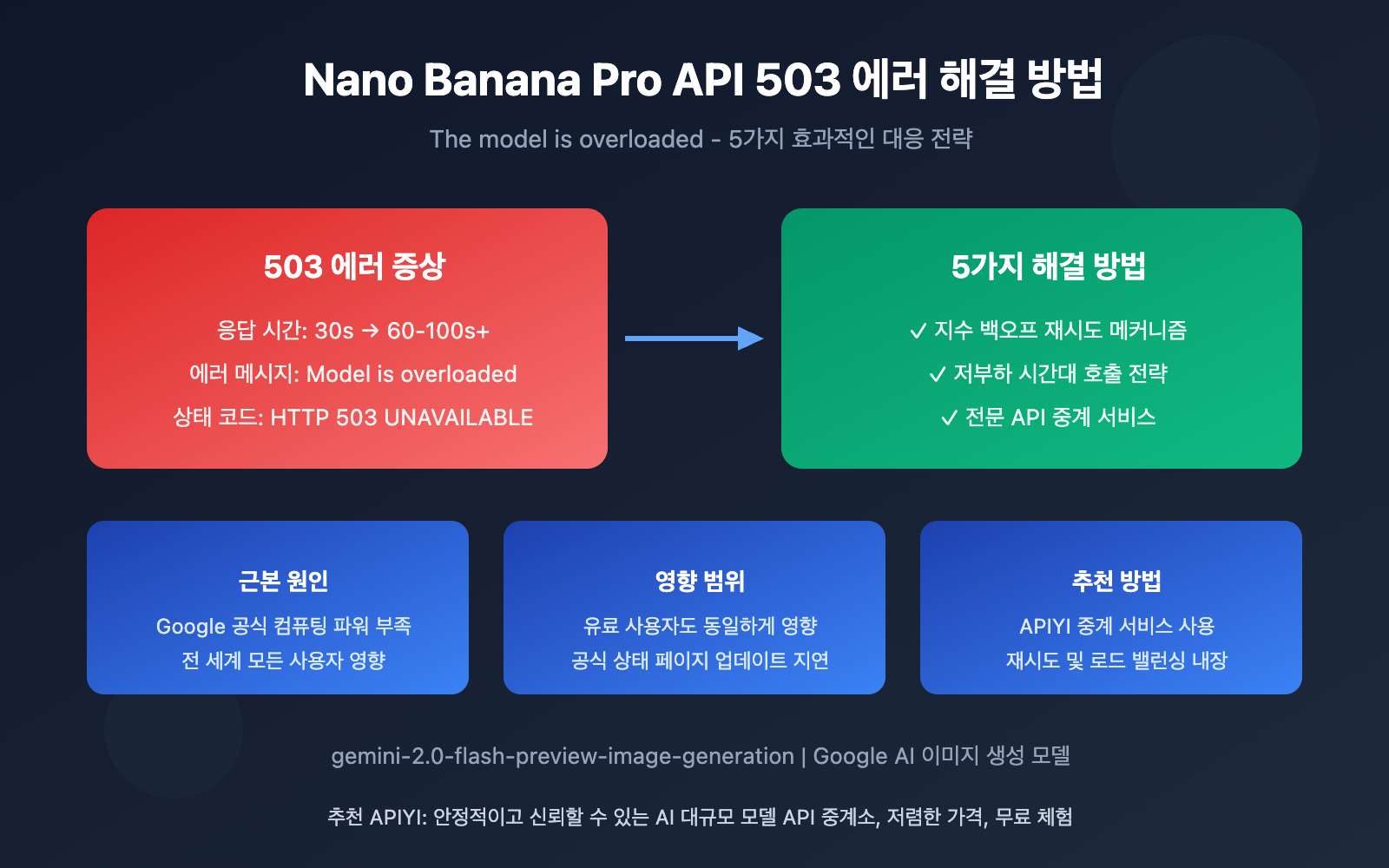

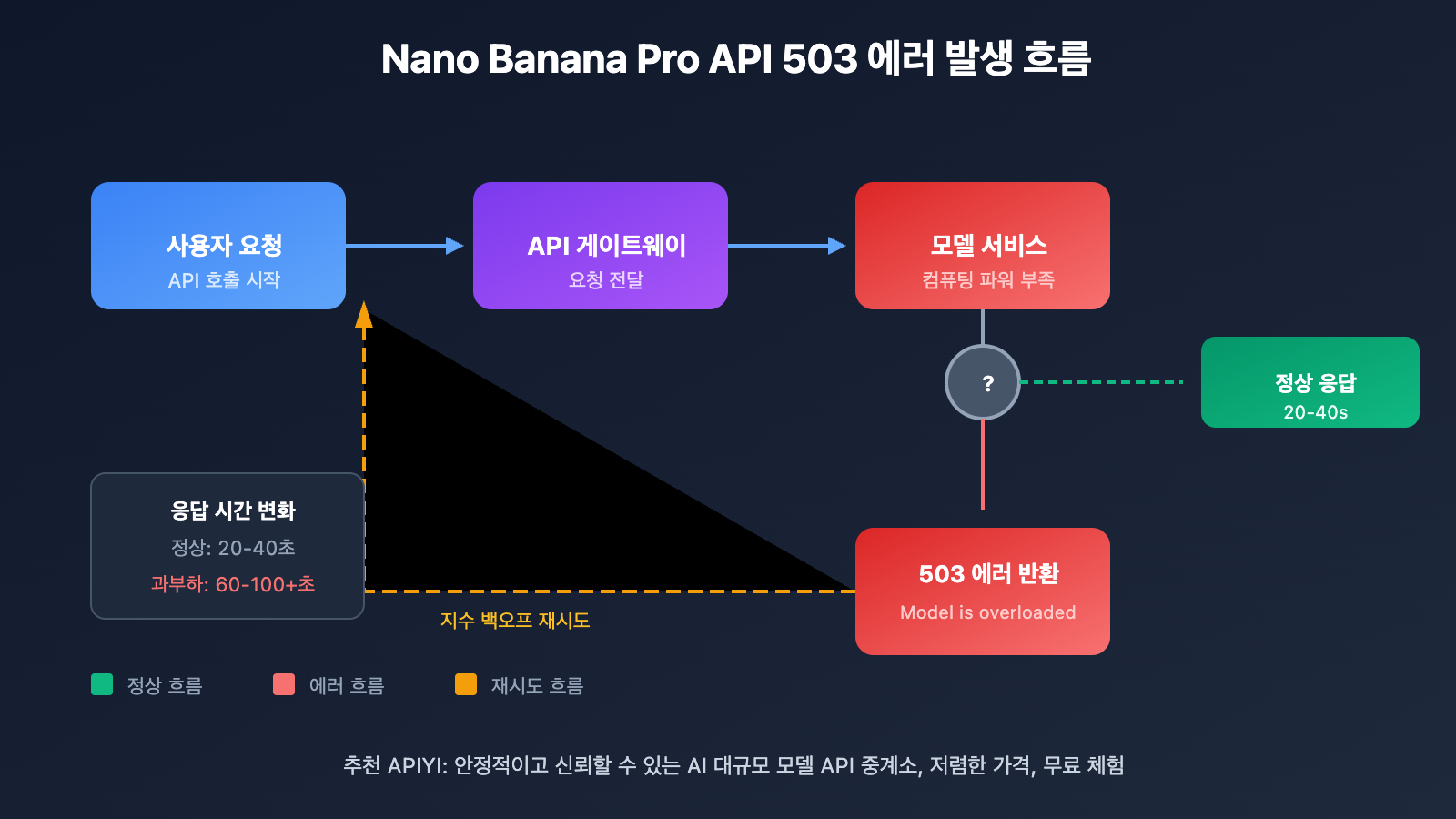

최근 많은 개발자들이 Nano Banana Pro API(gemini-2.0-flash-preview-image-generation)를 호출할 때 "The model is overloaded. Please try again later." 에러를 빈번하게 만나고 있어요. 응답 시간도 원래 30초에서 60-100초, 심지어 그 이상으로 급증하고 있죠. 이 글에서는 이 문제의 근본 원인을 깊이 분석하고, 검증된 5가지 해결 방법을 제공할게요.

핵심 가치: 이 글을 읽고 나면 Nano Banana Pro API 과부하 에러의 진짜 원인을 이해하고, 효과적인 대응 전략을 익혀서 여러분의 이미지 생성 애플리케이션을 안정적으로 운영할 수 있을 거예요.

Nano Banana Pro API 과부하 에러 핵심 요점

| 요점 | 설명 | 영향 |

|---|---|---|

| 에러 유형 | HTTP 503 UNAVAILABLE 서버 측 에러 | API 요청 완전 실패, 재시도 필요 |

| 근본 원인 | Google 공식 컴퓨팅 리소스 부족 | 해당 모델을 사용하는 모든 개발자 영향 |

| 응답 시간 | 30초에서 60-100+ 초로 지연 | 사용자 경험 심각하게 저하 |

| 영향 범위 | 전 세계 모든 API 사용자(유료 사용자 포함) | 등급 구분 없이 전반적으로 영향 |

| 공식 입장 | 상태 페이지는 정상으로 표시, 명확한 수정 시간 없음 | 개발자가 자체적으로 대응 필요 |

Nano Banana Pro API 과부하 문제 상세 분석

이 503 에러는 개발자의 코드 문제가 아니라, Google 서버 측의 컴퓨팅 용량 병목 현상이에요. Google AI 개발자 포럼의 여러 토론 스레드에 따르면, 이 문제는 2025년 하반기부터 빈번하게 발생하기 시작했고, 아직도 완전히 해결되지 않았어요.

에러의 전체 반환 형식은 다음과 같아요:

{

"error": {

"code": 503,

"message": "The model is overloaded. Please try again later.",

"status": "UNAVAILABLE"

}

}

주목할 점은, Tier 3 유료 사용자(최고 할당량 등급)도 요청 빈도가 할당량 제한보다 훨씬 낮은 상황에서도 여전히 이 에러를 만난다는 거예요. 이는 문제가 개인 계정 제한이 아닌 Google의 인프라 레벨에 있다는 것을 보여줘요.

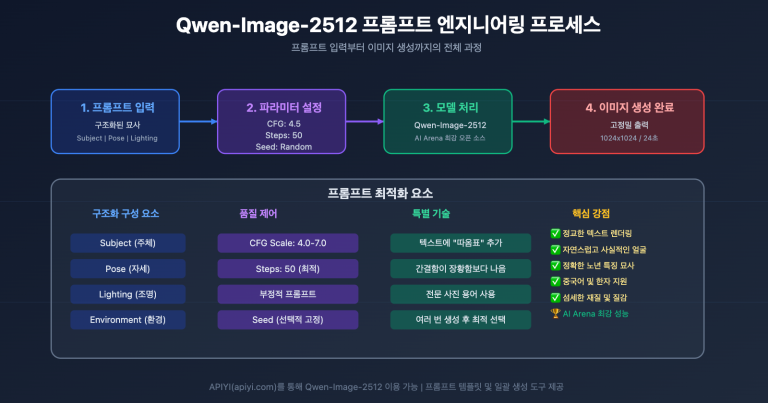

Nano Banana Pro API 과부하 해결을 위한 5가지 방법

방법 1: 지수 백오프 재시도 메커니즘 구현

503 에러는 복구 가능한 일시적 장애이기 때문에, 가장 효과적인 전략은 스마트한 재시도 로직을 구현하는 것입니다:

import openai

import time

import random

def call_nano_banana_pro_with_retry(prompt: str, max_retries: int = 5):

"""

지수 백오프를 적용한 Nano Banana Pro API 호출

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

for attempt in range(max_retries):

try:

response = client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}]

)

return response

except Exception as e:

if "503" in str(e) or "overloaded" in str(e).lower():

wait_time = (2 ** attempt) + random.uniform(0, 1)

print(f"모델 과부하 감지, {wait_time:.1f}초 후 재시도...")

time.sleep(wait_time)

else:

raise e

raise Exception("최대 재시도 횟수 초과, 잠시 후 다시 시도해주세요")

전체 구현 코드 보기 (비동기 버전 포함)

import openai

import asyncio

import random

from typing import Optional

class NanoBananaProClient:

"""

Nano Banana Pro API 클라이언트 래퍼

자동 재시도 및 에러 처리 지원

"""

def __init__(self, api_key: str, base_url: str = "https://vip.apiyi.com/v1"):

self.client = openai.OpenAI(api_key=api_key, base_url=base_url)

self.async_client = openai.AsyncOpenAI(api_key=api_key, base_url=base_url)

def generate_image(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""지수 백오프 재시도를 적용한 동기 호출"""

for attempt in range(max_retries):

try:

response = self.client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120 # 타임아웃 연장

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

print(f"[재시도 {attempt + 1}/{max_retries}] 대기 중 {delay:.1f}s")

time.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "최대 재시도 횟수 도달"}

async def generate_image_async(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""지수 백오프 재시도를 적용한 비동기 호출"""

for attempt in range(max_retries):

try:

response = await self.async_client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

await asyncio.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "최대 재시도 횟수 도달"}

# 사용 예시

client = NanoBananaProClient(api_key="YOUR_API_KEY")

result = client.generate_image("귀여운 고양이 그려줘")

추천: APIYI (apiyi.com)를 통해 Nano Banana Pro API를 호출하면 플랫폼에 내장된 스마트 재시도 메커니즘이 503 에러가 비즈니스에 미치는 영향을 효과적으로 줄여줍니다.

방법 2: 트래픽 낮은 시간대에 호출하기

커뮤니티 피드백을 보면, Nano Banana Pro API의 과부하 문제는 시간대별로 뚜렷한 패턴이 있어요:

| 시간대 (UTC) | 부하 상태 | 권장 사항 |

|---|---|---|

| 00:00 – 06:00 | 낮음 | 배치 작업에 적합 |

| 06:00 – 12:00 | 보통 | 정상적으로 사용 가능 |

| 12:00 – 18:00 | 최고조 | 호출 줄이거나 재시도 늘리기 권장 |

| 18:00 – 24:00 | 높음 | 인내심을 갖고 기다려야 함 |

방법 3: 신뢰할 수 있는 API 중계 서비스 사용

Google 공식 API를 직접 호출하면 컴퓨팅 리소스 부족 리스크에 그대로 노출됩니다. 전문 API 중계 서비스를 이용하면 다음과 같은 이점을 얻을 수 있어요:

| 비교 항목 | 공식 API 직접 호출 | APIYI 중계 서비스 사용 |

|---|---|---|

| 에러 처리 | 재시도 로직을 직접 구현해야 함 | 플랫폼 내장 스마트 재시도 |

| 안정성 | 공식 서버 리소스 변동에 크게 영향받음 | 다중 노드 로드밸런싱 |

| 응답 속도 | 30-100초 이상 변동폭 큼 | 상대적으로 안정적 |

| 기술 지원 | 커뮤니티 포럼만 가능 | 전문 기술팀 지원 |

| 비용 | 공식 가격 적용 | 높은 가성비 |

실사용 후기: APIYI (apiyi.com)를 통해 Nano Banana Pro API를 호출하면, 피크 시간대에도 공식 엔드포인트 직접 연결보다 훨씬 높은 성공률을 보여줘요. 플랫폼이 재시도와 폴백 전략을 자동으로 처리해주거든요.

방법 4: 적절한 타임아웃 설정

응답 시간이 크게 늘어난 상황이니, 클라이언트 타임아웃 설정을 조정할 필요가 있어요:

import openai

import httpx

# 더 긴 타임아웃 시간 설정

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1",

timeout=httpx.Timeout(

connect=30.0, # 연결 타임아웃

read=180.0, # 읽기 타임아웃 (이미지 생성은 시간이 더 필요해요)

write=30.0, # 쓰기 타임아웃

pool=30.0 # 커넥션 풀 타임아웃

)

)

방법 5: 요청 큐와 Rate Limiting 구현

프로덕션 환경에서는 동시 요청이 너무 많아지지 않도록 요청 큐를 구현하는 게 좋아요:

from queue import Queue

from threading import Thread

import time

class RequestQueue:

"""간단한 요청 큐 구현"""

def __init__(self, requests_per_minute: int = 10):

self.queue = Queue()

self.interval = 60 / requests_per_minute

self.running = True

self.worker = Thread(target=self._process_queue)

self.worker.start()

def add_request(self, request_func, callback):

self.queue.put((request_func, callback))

def _process_queue(self):

while self.running:

if not self.queue.empty():

request_func, callback = self.queue.get()

result = request_func()

callback(result)

time.sleep(self.interval)

else:

time.sleep(0.1)

Nano Banana Pro API 공식 상태 모니터링

Google 공식 서버 상태 확인하는 방법

Google 상태 페이지가 종종 "모든 시스템 정상"으로 표시되긴 하지만, 실시간 정보는 다음 채널들을 통해 확인할 수 있어요:

| 모니터링 채널 | 주소 | 설명 |

|---|---|---|

| Google AI Studio 상태 페이지 | aistudio.google.com/status |

공식 상태지만 업데이트가 늦을 수 있음 |

| Vertex AI 상태 페이지 | status.cloud.google.com |

엔터프라이즈급 상태 모니터링 |

| Google AI 개발자 포럼 | discuss.ai.google.dev |

커뮤니티 실시간 피드백이 가장 빠름 |

| StatusGator 서드파티 모니터링 | statusgator.com |

사용자가 직접 리포트하는 실제 상태 |

| GitHub Issues | github.com/google-gemini |

개발자 이슈 모음 |

중요한 팁: 커뮤니티 피드백에 따르면, 상태 페이지에 "0 issues"로 표시되어 있어도 실제로는 심각한 가용성 문제가 있을 수 있어요. 개발자 포럼의 실시간 논의도 함께 확인하는 걸 추천해요.

자주 묻는 질문

Q1: 유료 사용자도 503 에러를 만나는 이유가 뭔가요?

503 에러는 서버 전체의 컴퓨팅 리소스가 부족하다는 의미로, Google 인프라 레벨의 문제예요. 개인 계정의 유료 티어와는 무관하죠. 유료 사용자는 더 높은 요청 할당량(RPM/RPD)을 받긴 하지만, 전체 컴퓨팅 파워가 부족할 때는 모든 사용자가 영향을 받아요. 유료 사용자의 장점은 피크 시간대에 요청이 우선 처리된다는 점이에요.

Q2: 응답 시간이 30초에서 100초로 늘어나는 게 정상인가요?

정상이 아니에요. Google 서버 과부하의 전형적인 증상이죠. 일반적으로 Nano Banana Pro의 이미지 생성은 20-40초 안에 완료되어야 해요. 응답 시간이 크게 늘어났다는 건 서비스가 요청을 대기열에서 처리하고 있다는 뜻이니, 더 긴 타임아웃 설정과 재시도 메커니즘을 구현하는 걸 추천해요.

Q3: 503 에러가 비즈니스에 미치는 영향을 어떻게 줄일 수 있나요?

다음 전략들을 종합적으로 활용하는 걸 추천해요:

- APIYI(apiyi.com) 같은 신뢰할 수 있는 API 중계 서비스를 사용해서 내장된 재시도와 폴백 기능 활용하기

- 로컬 캐싱을 구현해서 동일한 콘텐츠를 반복 생성하지 않기

- API를 사용할 수 없을 때 대체 기능을 제공하는 우아한 폴백 방안 설계하기

- 알림 모니터링을 설정해서 서비스 이상을 즉시 감지하기

요약

Nano Banana Pro API 과부하 오류의 핵심 포인트:

- 오류의 본질: Google 서버 측 컴퓨팅 자원 부족으로 인한 503 오류로, 개발자 코드 문제가 아닙니다

- 대응 전략: 지수 백오프 재시도 메커니즘 구현이 가장 효과적인 해결책입니다

- 추천 방안: 전문 API 중계 서비스를 활용하면 더 안정적인 호출 경험을 얻을 수 있습니다

Google 공식 서버의 리소스 변동 문제에 대비해, 개발자 여러분은 충분한 장애 허용 설계를 준비해야 합니다. 합리적인 재시도 전략, 타임아웃 설정, 그리고 적절한 서비스 선택을 통해 과부하 오류가 비즈니스에 미치는 영향을 효과적으로 줄일 수 있어요.

Nano Banana Pro API 호출은 APIYI apiyi.com을 통해 이용하시는 걸 추천드려요. 플랫폼에서 안정적이고 신뢰할 수 있는 서비스, 스마트한 재시도 메커니즘, 그리고 전문적인 기술 지원을 제공하여 여러분의 이미지 생성 애플리케이션이 안정적으로 운영되도록 도와드립니다.

📚 참고 자료

⚠️ 링크 형식 안내: 모든 외부 링크는

자료명: domain.com형식을 사용합니다. 복사는 편리하지만 클릭으로 이동되지 않아 SEO 가중치 손실을 방지합니다.

-

Google AI 개발자 포럼 – Model is overloaded 토론: 503 오류에 대한 공식 커뮤니티 토론 스레드

- 링크:

discuss.ai.google.dev/t/model-is-overloaded-gemini-2-5-pro/108321 - 설명: 다른 개발자들의 경험과 해결 방법을 확인할 수 있습니다

- 링크:

-

Google AI Studio 상태 페이지: 공식 서비스 상태 모니터링

- 링크:

aistudio.google.com/status - 설명: Gemini API의 공식 운영 상태를 확인할 수 있습니다

- 링크:

-

GitHub gemini-cli Issues: 개발자 이슈 모음

- 링크:

github.com/google-gemini/gemini-cli/issues - 설명: Gemini API 관련 문제를 조회하고 리포트할 수 있습니다

- 링크:

-

Vertex AI Gemini 문서: 공식 이미지 생성 문서

- 링크:

cloud.google.com/vertex-ai/generative-ai/docs/multimodal/image-generation - 설명: Gemini 이미지 생성 모델의 공식 사용법을 확인할 수 있습니다

- 링크:

작성자: 기술팀

기술 교류: 댓글로 편하게 의견 나눠주세요. 더 많은 자료는 APIYI apiyi.com 기술 커뮤니티에서 만나보실 수 있습니다