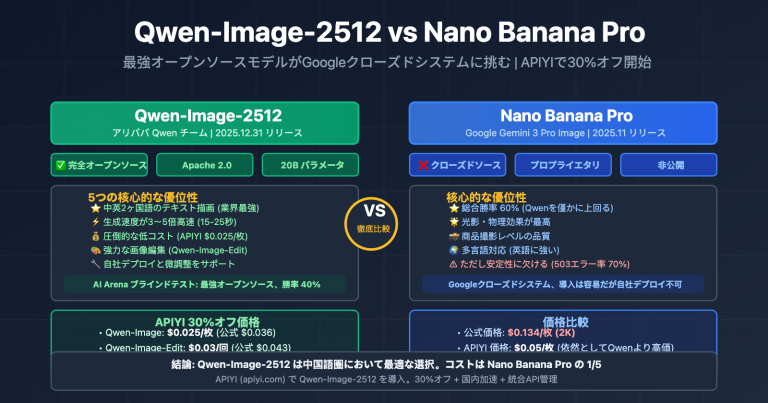

Nano Banana Pro API の 503 エラー解決完全ガイド

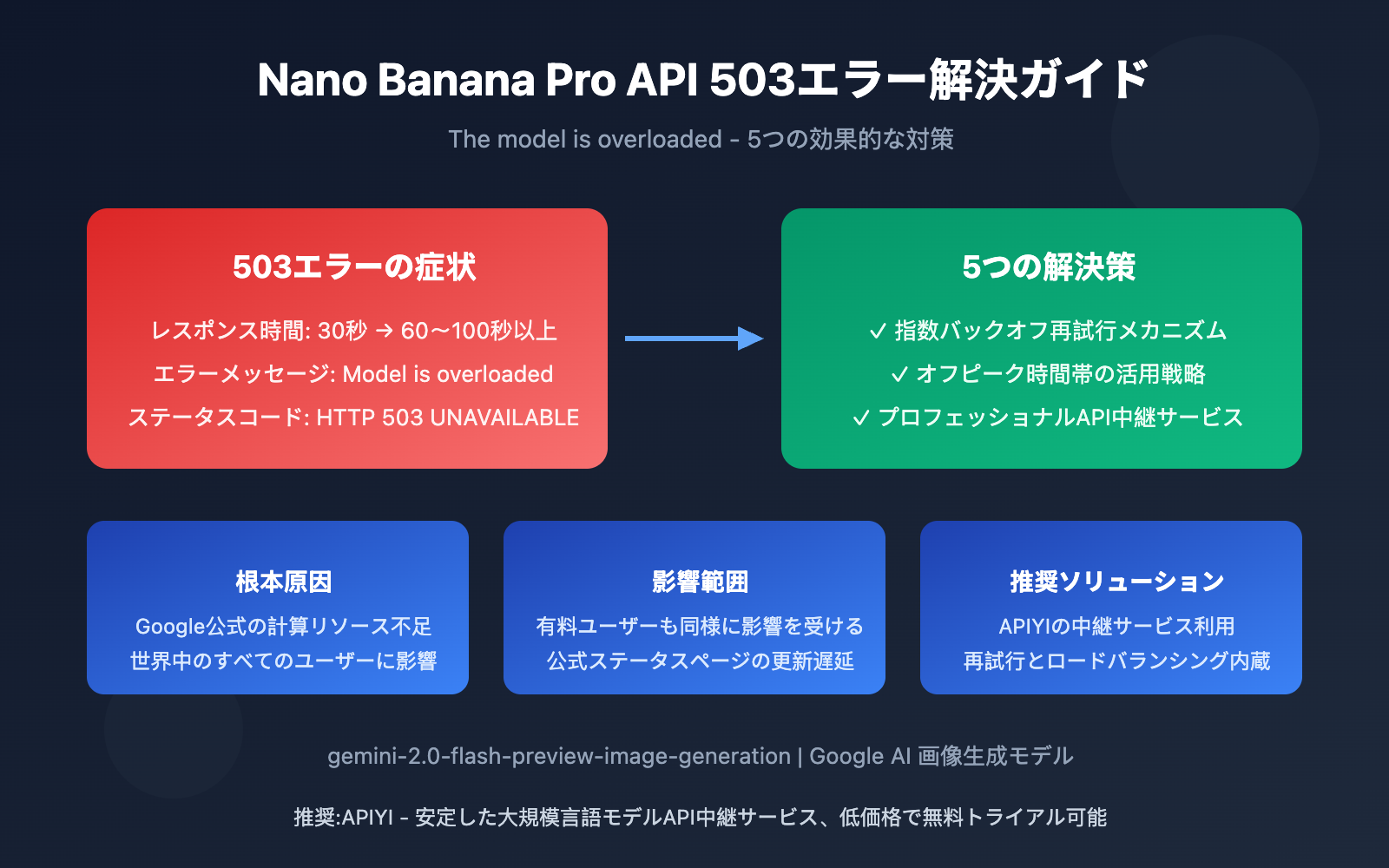

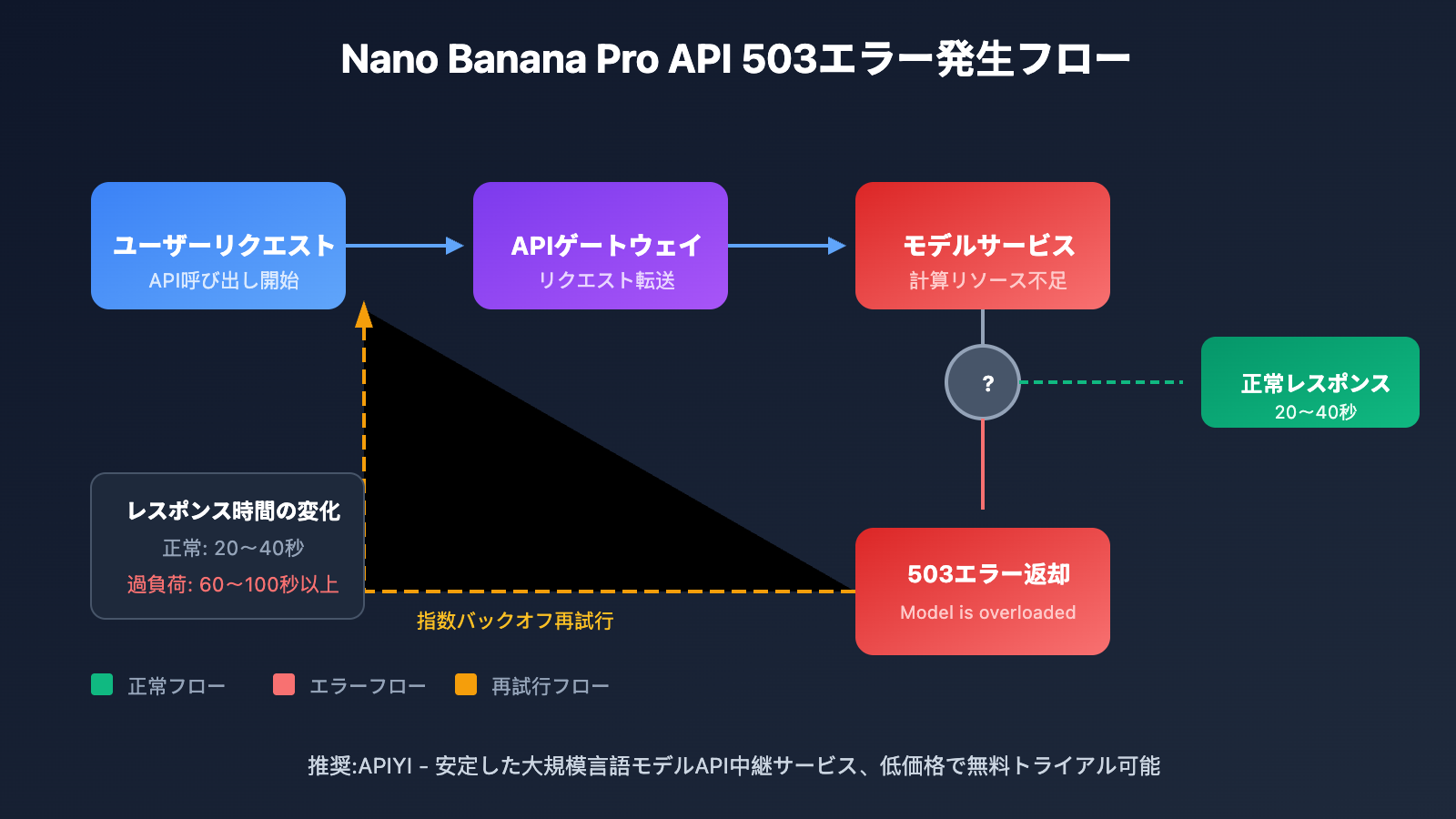

最近、多くの開発者から Nano Banana Pro API(gemini-2.0-flash-preview-image-generation)を呼び出す際に 「The model is overloaded. Please try again later.」 エラーが頻発し、レスポンス時間が従来の30秒から60〜100秒以上に急増しているとの報告が寄せられています。本記事では、この問題の根本原因を詳しく分析し、実証済みの5つの解決策をご紹介します。

この記事の価値: 本記事を読むことで、Nano Banana Pro API の過負荷エラーの真の原因を理解し、効果的な対処戦略を習得して、画像生成アプリケーションの安定稼働を確保できます。

Nano Banana Pro API 過負荷エラーの重要ポイント

| ポイント | 説明 | 影響 |

|---|---|---|

| エラータイプ | HTTP 503 UNAVAILABLE サーバー側エラー | APIリクエストが完全に失敗、再試行が必要 |

| 根本原因 | Google公式の計算リソース不足 | このモデルを使用するすべての開発者に影響 |

| レスポンス時間 | 30秒から60〜100秒以上に延長 | ユーザー体験が著しく低下 |

| 影響範囲 | 世界中のすべてのAPIユーザー(有料ユーザー含む) | レベルに関係なく広範囲に影響 |

| 公式の対応 | ステータスページは正常表示、明確な修正時期なし | 開発者が独自に対処する必要がある |

Nano Banana Pro API 過負荷問題の詳細

この503エラーは開発者のコードの問題ではなく、Googleサーバー側の計算能力のボトルネックによるものです。Google AI開発者フォーラムの複数のディスカッションスレッドによると、この問題は2025年下半期から頻繁に発生し始め、現在も完全には解決されていません。

エラーの完全な返り値の形式は以下の通りです:

{

"error": {

"code": 503,

"message": "The model is overloaded. Please try again later.",

"status": "UNAVAILABLE"

}

}

注目すべきは、Tier 3の有料ユーザー(最高クォータレベル)であっても、リクエスト頻度がクォータ制限を大きく下回っている場合でも、このエラーに遭遇する点です。これは問題がGoogleのインフラストラクチャレベルにあり、個別のアカウント制限ではないことを示しています。

Nano Banana Pro API 過負荷の5つの解決策

方法1:指数バックオフ再試行メカニズムの実装

503エラーは復旧可能な一時的障害であるため、最も効果的な戦略はスマート再試行の実装です:

import openai

import time

import random

def call_nano_banana_pro_with_retry(prompt: str, max_retries: int = 5):

"""

指数バックオフ付きNano Banana Pro API呼び出し

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

for attempt in range(max_retries):

try:

response = client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}]

)

return response

except Exception as e:

if "503" in str(e) or "overloaded" in str(e).lower():

wait_time = (2 ** attempt) + random.uniform(0, 1)

print(f"モデルが過負荷です。{wait_time:.1f}秒後に再試行します...")

time.sleep(wait_time)

else:

raise e

raise Exception("最大再試行回数に達しました。後ほど再度お試しください")

完全な実装コードを見る(非同期版を含む)

import openai

import asyncio

import random

from typing import Optional

class NanoBananaProClient:

"""

Nano Banana Pro APIクライアントラッパー

自動再試行とエラーハンドリングをサポート

"""

def __init__(self, api_key: str, base_url: str = "https://vip.apiyi.com/v1"):

self.client = openai.OpenAI(api_key=api_key, base_url=base_url)

self.async_client = openai.AsyncOpenAI(api_key=api_key, base_url=base_url)

def generate_image(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""指数バックオフ再試行付き同期呼び出し"""

for attempt in range(max_retries):

try:

response = self.client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120 # タイムアウトを延長

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

print(f"[再試行 {attempt + 1}/{max_retries}] {delay:.1}s待機中")

time.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "最大再試行回数に達しました"}

async def generate_image_async(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""指数バックオフ再試行付き非同期呼び出し"""

for attempt in range(max_retries):

try:

response = await self.async_client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

await asyncio.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "最大再試行回数に達しました"}

# 使用例

client = NanoBananaProClient(api_key="YOUR_API_KEY")

result = client.generate_image("可愛い猫ちゃんを生成")

おすすめ: APIYI apiyi.com経由でNano Banana Pro APIを呼び出すと、プラットフォームにスマート再試行メカニズムが組み込まれており、503エラーがビジネスに与える影響を効果的に軽減できます。

方法2:オフピーク時間帯の選択

コミュニティのフィードバックによると、Nano Banana Pro APIの過負荷問題には明確な時間帯パターンがあります:

| 時間帯(UTC) | 負荷状況 | 推奨アクション |

|---|---|---|

| 00:00 – 06:00 | 低い | バッチタスクに最適 |

| 06:00 – 12:00 | 中程度 | 通常使用可能 |

| 12:00 – 18:00 | ピーク | 呼び出し削減または再試行増加を推奨 |

| 18:00 – 24:00 | やや高い | 辛抱強く待つ必要あり |

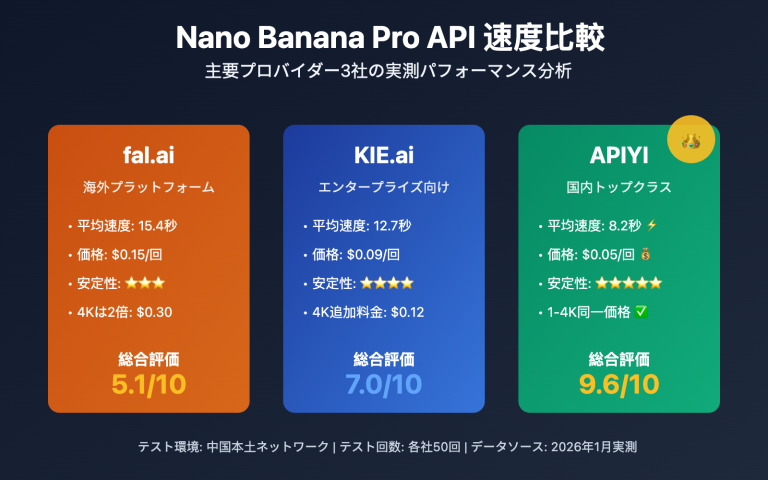

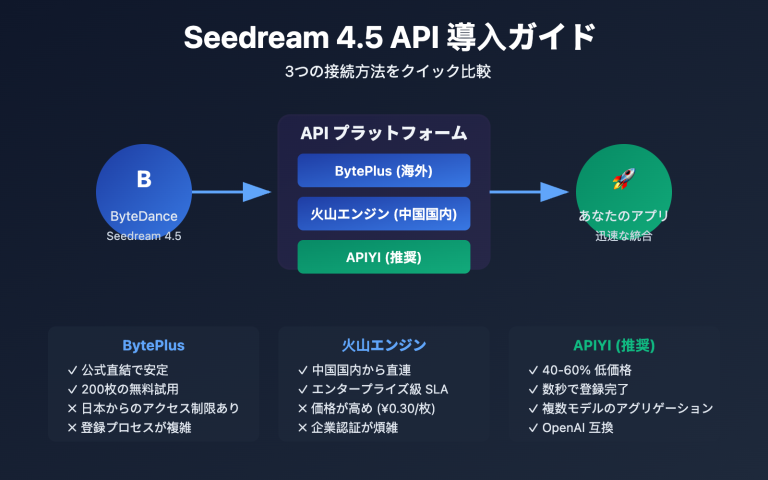

方法3:信頼性の高いAPI中継サービスの利用

Google公式APIを直接呼び出すと、計算リソース不足のリスクに直接さらされます。専門的なAPI中継サービスを使用することで以下の利点が得られます:

| 比較項目 | 公式API直接呼び出し | APIYI中継サービス利用 |

|---|---|---|

| エラー処理 | 再試行ロジックを自前実装 | プラットフォーム組み込みスマート再試行 |

| 安定性 | 公式の計算リソース変動の影響大 | マルチノード負荷分散 |

| 応答速度 | 30-100+秒の変動 | 比較的安定 |

| 技術サポート | フォーラムコミュニティのみ | 専門技術チーム |

| コスト | 公式価格通り | コストパフォーマンス高い |

実測体験: APIYI apiyi.com経由でNano Banana Pro APIを呼び出すと、ピーク時間帯の成功率が公式インターフェース直接接続よりも明らかに高く、プラットフォームが自動的に再試行とフォールバック戦略を処理してくれます。

方法4:適切なタイムアウト時間の設定

応答時間が大幅に延長されているため、クライアントのタイムアウト設定を調整する必要があります:

import openai

import httpx

# より長いタイムアウト時間を設定

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1",

timeout=httpx.Timeout(

connect=30.0, # 接続タイムアウト

read=180.0, # 読み取りタイムアウト(画像生成にはより長い時間が必要)

write=30.0, # 書き込みタイムアウト

pool=30.0 # コネクションプールタイムアウト

)

)

方法5:リクエストキューとレート制限の実装

本番環境では、並行リクエストが多すぎることを避けるためにリクエストキューを実装することをお勧めします:

from queue import Queue

from threading import Thread

import time

class RequestQueue:

"""シンプルなリクエストキュー実装"""

def __init__(self, requests_per_minute: int = 10):

self.queue = Queue()

self.interval = 60 / requests_per_minute

self.running = True

self.worker = Thread(target=self._process_queue)

self.worker.start()

def add_request(self, request_func, callback):

self.queue.put((request_func, callback))

def _process_queue(self):

while self.running:

if not self.queue.empty():

request_func, callback = self.queue.get()

result = request_func()

callback(result)

time.sleep(self.interval)

else:

time.sleep(0.1)

Nano Banana Pro API 公式ステータス監視

Google 公式の算力状態を確認する方法

Google のステータスページは「すべて正常」と表示されることが多いですが、以下のチャネルからリアルタイム情報を取得できます:

| 監視チャネル | アドレス | 説明 |

|---|---|---|

| Google AI Studio ステータスページ | aistudio.google.com/status |

公式ステータスですが、更新が遅れる場合があります |

| Vertex AI ステータスページ | status.cloud.google.com |

エンタープライズグレードのステータス監視 |

| Google AI 開発者フォーラム | discuss.ai.google.dev |

コミュニティからのリアルタイムフィードバックが最も迅速 |

| StatusGator サードパーティ監視 | statusgator.com |

ユーザーから報告された実際のステータス |

| GitHub Issues | github.com/google-gemini |

開発者の問題まとめ |

重要なお知らせ: コミュニティからのフィードバックによると、ステータスページに「0 issues」と表示されていても、実際のサービスには深刻な可用性の問題が存在する可能性があります。開発者フォーラムでのリアルタイムディスカッションも併せて確認することをおすすめします。

よくある質問

Q1: 有料ユーザーでも 503 エラーが発生するのはなぜですか?

503 エラーはサーバー側の全体的な算力不足を示しており、Google のインフラストラクチャレベルの問題です。個人アカウントの有料プランとは関係ありません。有料ユーザーは確かにより高いリクエスト制限(RPM/RPD)を享受できますが、全体的な算力が不足している場合は、すべてのユーザーに影響が及びます。有料ユーザーの利点は、ピーク時のリクエストが優先的に処理される点にあります。

Q2: レスポンスタイムが 30 秒から 100 秒に変わるのは正常ですか?

これは正常な現象ではなく、Google サーバーの過負荷の典型的な症状です。通常の状況下では、Nano Banana Pro の画像生成は 20〜40 秒以内に完了するはずです。レスポンスタイムが大幅に延長されているということは、サービスがリクエストをキューに入れて処理していることを示しています。より長いタイムアウト設定とリトライメカニズムを実装して対応することをおすすめします。

Q3: 503 エラーがビジネスに与える影響を軽減するには?

以下の戦略を組み合わせて使用することをおすすめします:

- APIYI apiyi.com のような信頼性の高い API 中継サービスを使用し、組み込みのリトライとフォールバック機能を活用する

- ローカルキャッシュを実装し、同じコンテンツの重複生成を避ける

- グレースフルデグラデーション方式を設計し、API が利用できない場合に代替機能を提供する

- アラート監視を設定し、サービス異常をタイムリーに検出する

まとめ

Nano Banana Pro API過負荷エラーの重要ポイント:

- エラーの本質: これはGoogleのサーバー側の計算リソース不足による503エラーで、開発者のコードの問題ではありません

- 対応戦略: 指数バックオフによるリトライメカニズムの実装が最も効果的な解決策です

- 推奨ソリューション: プロフェッショナルなAPI中継サービスを利用することで、より安定した呼び出し体験が得られます

Google公式の計算リソース変動の問題に対して、開発者は十分なエラー処理設計を行う必要があります。適切なリトライ戦略、タイムアウト設定、サービス選択を通じて、過負荷エラーがビジネスに与える影響を効果的に軽減できます。

APIYI apiyi.com を通じてNano Banana Pro APIを呼び出すことをお勧めします。プラットフォームは安定性の高いサービス、スマートリトライメカニズム、プロフェッショナルな技術サポートを提供し、あなたの画像生成アプリケーションの安定稼働をサポートします。

📚 参考資料

⚠️ リンク形式について: すべての外部リンクは

資料名: domain.com形式で記載しています。コピーは簡単ですが、クリックによる遷移はできません。これはSEO権重の流出を防ぐためです。

-

Google AI開発者フォーラム – Model is overloaded ディスカッション: 503エラーに関する公式コミュニティのディスカッションスレッド

- リンク:

discuss.ai.google.dev/t/model-is-overloaded-gemini-2-5-pro/108321 - 説明: 他の開発者の経験と解決策を理解できます

- リンク:

-

Google AI Studioステータスページ: 公式サービス監視ステータス

- リンク:

aistudio.google.com/status - 説明: Gemini APIの公式稼働状況を確認できます

- リンク:

-

GitHub gemini-cli Issues: 開発者の問題まとめ

- リンク:

github.com/google-gemini/gemini-cli/issues - 説明: Gemini API関連の問題を閲覧・報告できます

- リンク:

-

Vertex AI Geminiドキュメント: 公式画像生成ドキュメント

- リンク:

cloud.google.com/vertex-ai/generative-ai/docs/multimodal/image-generation - 説明: Gemini画像生成モデルの公式使用方法を理解できます

- リンク:

著者: 技術チーム

技術交流: コメント欄でのディスカッションを歓迎します。詳しい資料はAPIYI apiyi.com 技術コミュニティをご覧ください