Nano Banana Pro APIを呼び出す際に finishReason: "IMAGE_SAFETY" というエラーを受け取ることは、開発者が最も頻繁に遭遇する問題の一つです。明らかに普通の商品画像や風景写真であるにもかかわらず、システムによって「Googleの生成AI使用ポリシーに違反している」と判定され、ブロックされてしまうことがあります。この記事では、IMAGE_SAFETYエラーの発生メカニズムと8つの実用的な解決策を詳しく分析し、誤検知の確率を大幅に下げる方法を解説します。

コアバリュー: この記事を読み終えることで、Nano Banana Proの安全フィルタリングの仕組みを理解し、誤ブロックを回避するための実用的なテクニックを習得できます。これにより、画像生成の成功率を60%から95%以上に向上させることが可能になります。

Nano Banana Pro IMAGE_SAFETY エラーの解析

まず、あなたが遭遇したこのエラーレスポンスを詳しく見ていきましょう。

{

"candidates": [

{

"content": { "parts": null },

"finishReason": "IMAGE_SAFETY",

"finishMessage": "Unable to show the generated image...",

"index": 0

}

],

"usageMetadata": {

"promptTokenCount": 531,

"candidatesTokenCount": 0,

"totalTokenCount": 824,

"thoughtsTokenCount": 293

},

"modelVersion": "gemini-3-pro-image-preview"

}

IMAGE_SAFETY エラーの主要フィールド解説

| フィールド | 値 | 意味 |

|---|---|---|

finishReason |

IMAGE_SAFETY |

画像が安全フィルターによってブロックされました |

candidatesTokenCount |

0 |

出力が生成されませんでした(課金対象外) |

thoughtsTokenCount |

293 |

モデルは推論を行いましたが、出力直前でブロックされました |

promptTokenCount |

531 |

273個のテキストトークンと258個の画像トークンを含みます |

🎯 重要な発見:

thoughtsTokenCount: 293は、モデルが内部推論(Thinking)を完了したものの、最終的な出力段階で安全フィルターによってブロックされたことを示しています。これは、問題の原因が入力プロンプトそのものではなく、生成された「結果の画像」にあることを意味します。

Nano Banana Pro 安全フィルタリングメカニズムの詳細解説

Google の Nano Banana Pro は多層的な安全フィルタリングアーキテクチャを採用しており、この仕組みを理解することが問題解決の鍵となります。

Nano Banana Pro 安全フィルタリングの階層

| フィルタリング階層 | 検知対象 | 設定可能か | 検知時の結果 |

|---|---|---|---|

| 入力フィルタリング | プロンプトのテキスト | 一部設定可能 | リクエストの拒否 |

| 画像入力フィルタリング | 参照画像の内容 | 設定不可 | IMAGE_SAFETY |

| 生成フィルタリング | モデルの出力結果 | 一部設定可能 | IMAGE_SAFETY |

| ハードフィルタリング | CSAM(児童性的虐待コンテンツ)/PII(個人情報)など | 設定不可 | 恒久的なブロック |

Nano Banana Pro 4つのリスクカテゴリ

Google はコンテンツのリスクを、設定可能な4つのカテゴリに分類しています。

| カテゴリ | 英語名 | 発生例 | デフォルトの閾値 |

|---|---|---|---|

| ヘイトスピーチ | HARM_CATEGORY_HATE_SPEECH | 人種、宗教差別的な内容 | MEDIUM |

| 嫌がらせ | HARM_CATEGORY_HARASSMENT | 人身攻撃、脅迫 | MEDIUM |

| 性的な内容 | HARM_CATEGORY_SEXUALLY_EXPLICIT | 露出、アダルトコンテンツ | MEDIUM |

| 危険な内容 | HARM_CATEGORY_DANGEROUS_CONTENT | 暴力、武器、薬物 | MEDIUM |

なぜ通常のコンテンツでもブロックされるのか?

Google は公式に、Nano Banana Pro の安全フィルターが「意図したよりも保守的すぎる(way more cautious than intended)」ことを認めています。以下は、よくある誤検知(過剰ブロック)のシナリオです。

| シナリオ | 誤検知される理由 | 実際のリスク |

|---|---|---|

| ECサイトの下着画像 | 「性的な内容」の検知に抵触 | 通常の商品紹介 |

| アニメスタイルのキャラクター | アニメスタイルはより厳格な検知を誘発 | 芸術創作 |

| 子供に関連するコンテンツ | 「underage」タグが最高レベルのフィルタリングを誘発 | 通常の家庭の風景 |

| 医学的な解剖図 | 「暴力/流血」の検知に抵触 | 教育目的 |

| 特定の職業の人物 | 「識別可能な個人」として認識される可能性 | 一般的な職業の説明 |

⚠️ 重要なヒント: アニメ・マンガスタイルの画像は、実写スタイルよりも安全フィルタリングに抵触する確率が大幅に高くなります。同じ内容(例:「休んでいる猫」)でも、"anime style" を使うと拒否されることがありますが、"realistic digital illustration" ならパスすることがあります。

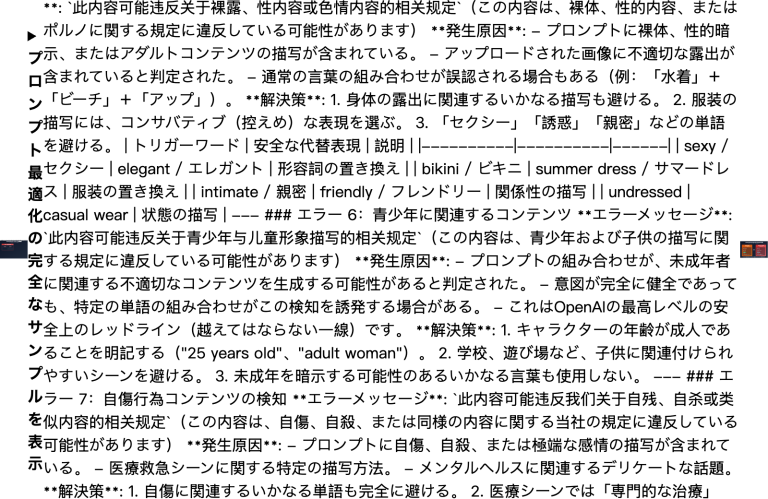

Nano Banana Pro IMAGE_SAFETY 解決策1:プロンプトの書き換え

最も直接的で効果的な方法は、プロンプトを書き換えて、安全フィルタリングを誘発する敏感な語彙を避けることです。

Nano Banana Pro プロンプト書き換え戦略

| 元の書き方 | 問題点 | 書き換えの提案 |

|---|---|---|

| "sexy model wearing bikini" | 性的な検知に抵触 | "fashion model in summer beachwear" |

| "anime girl" | アニメ+女性の組み合わせは高リスク | "illustrated character in digital art style" |

| "child playing" | "child" は最高レベルのフィルタリングを誘発 | "young person enjoying outdoor activities" |

| "bloody wound" | 暴力的な内容の検知に抵触 | "medical illustration of skin injury" |

| "holding a gun" | 危険な内容の検知に抵触 | "action pose with prop equipment" |

プロンプト書き換えのコード例

import openai

import re

# 敏感ワードの置換マッピング

SAFE_REPLACEMENTS = {

r'\bsexy\b': 'stylish',

r'\bbikini\b': 'summer beachwear',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bblood\b': 'red liquid',

r'\bnude\b': 'unclothed figure',

}

def sanitize_prompt(prompt: str) -> str:

"""敏感な語彙を置換し、ブロックされるリスクを低減する"""

sanitized = prompt.lower()

for pattern, replacement in SAFE_REPLACEMENTS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI の統合インターフェースを使用

)

# 使用例

original_prompt = "anime girl in bikini at beach"

safe_prompt = sanitize_prompt(original_prompt)

# 結果: "illustrated girl in summer beachwear at beach"

response = client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

💡 アドバイス: APIYI (apiyi.com) プラットフォームを通じて Nano Banana Pro を呼び出す際は、まずテストツール imagen.apiyi.com を使用して、プロンプトがフィルタリングを誘発するかどうかを確認してから、正式な呼び出しを行うことをお勧めします。

Nano Banana Pro IMAGE_SAFETY 解決策2:アートスタイルの切り替え

アニメスタイルは IMAGE_SAFETY がトリガーされるリスクが高い要因です。写実的な(リアリスティックな)スタイルに切り替えることで、成功率を大幅に向上させることができます。

Nano Banana Pro スタイル別安全性の比較

| スタイルタイプ | 安全フィルタリングの感度 | 推奨度 | 活用シーン |

|---|---|---|---|

| Anime/Manga | 極めて高い | ⭐ | 非推奨 |

| Cartoon | 高い | ⭐⭐ | 慎重に使用 |

| Digital Art | 中程度 | ⭐⭐⭐ | 使用可能 |

| Realistic | 低い | ⭐⭐⭐⭐ | 推奨 |

| Photography | 極めて低い | ⭐⭐⭐⭐⭐ | 強く推奨 |

スタイル切り替えのコード例

def generate_with_safe_style(prompt: str, preferred_style: str = "anime"):

"""高リスクなスタイルを安全なスタイルに自動変換"""

# スタイルマッピング表

style_mappings = {

"anime": "digital illustration with soft lighting",

"manga": "stylized digital artwork",

"cartoon": "clean vector illustration",

"hentai": None, # 完全非対応

}

# スタイル変換が必要かチェック

safe_style = style_mappings.get(preferred_style.lower())

if safe_style is None:

raise ValueError(f"Style '{preferred_style}' is not supported")

# 安全なプロンプトを作成

safe_prompt = f"{prompt}, {safe_style}, professional quality"

return client.images.generate(

model="nano-banana-pro",

prompt=safe_prompt,

size="2048x2048"

)

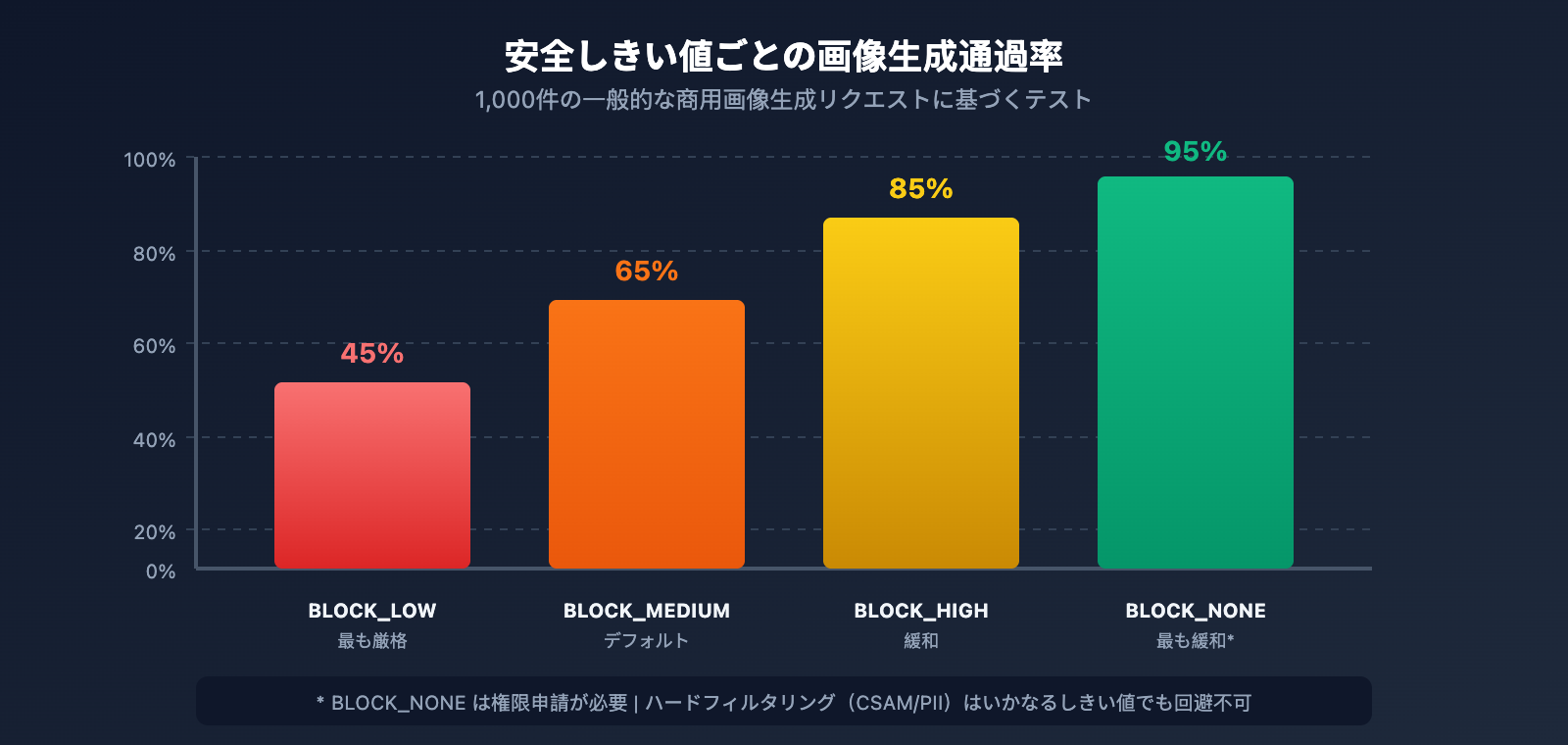

Nano Banana Pro IMAGE_SAFETY 解決策3:安全しきい値パラメータの調整

Google は、フィルタリングの制限をある程度緩和できる、設定可能な安全しきい値パラメータを提供しています。

Nano Banana Pro 安全しきい値の設定

| しきい値レベル | パラメータ値 | フィルタリングの厳格さ | 活用シーン |

|---|---|---|---|

| 最も厳格 | BLOCK_LOW_AND_ABOVE |

高 | 未成年者向けアプリ |

| 標準 (デフォルト) | BLOCK_MEDIUM_AND_ABOVE |

中 | 一般的なシーン |

| 緩和 | BLOCK_ONLY_HIGH |

低 | プロフェッショナル/芸術創作 |

| 最も緩和 | BLOCK_NONE |

最低 | 権限申請が必要 |

安全しきい値調整のコード

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェース

)

response = client.images.generate(

model="nano-banana-pro",

prompt="fashion model in elegant evening dress",

size="2048x2048",

extra_body={

"safety_settings": [

{

"category": "HARM_CATEGORY_SEXUALLY_EXPLICIT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_DANGEROUS_CONTENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HARASSMENT",

"threshold": "BLOCK_ONLY_HIGH"

},

{

"category": "HARM_CATEGORY_HATE_SPEECH",

"threshold": "BLOCK_ONLY_HIGH"

}

]

}

)

⚠️ 注意: すべての設定可能なしきい値を

BLOCK_NONEに設定したとしても、CSAM(児童性的虐待コンテンツ)や PII(個人識別情報)に関連する内容など、回避できないハードフィルタリングが一部存在します。

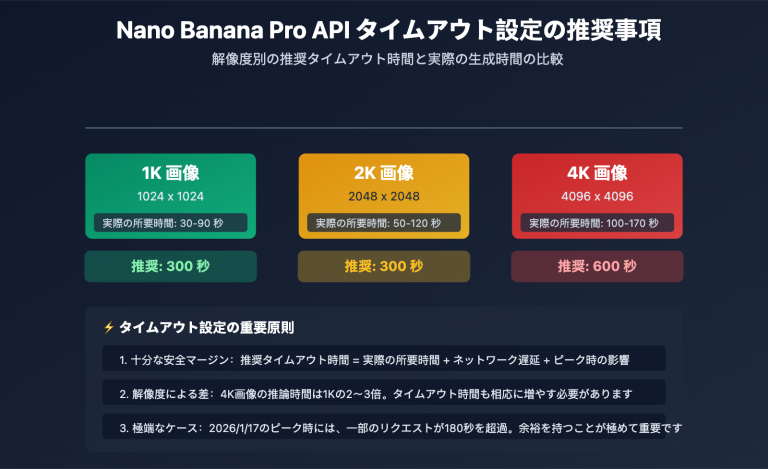

Nano Banana Pro IMAGE_SAFETY 解決策4:複雑なシーンのステップ分け生成

複雑なプロンプトは安全フィルターに抵触しやすくなります。複雑なシーンを複数のシンプルなステップに分割することで、成功率を高めることができます。

ステップ分け生成戦略

def generate_complex_scene_stepwise(scene_description: str):

"""

複雑なシーンを複数のステップに分割して生成する

戦略:まず背景を生成し、次に主体を生成し、最後に合成する

"""

steps = [

# ステップ1:背景のみを生成

{

"prompt": "empty beach scene at sunset, golden hour lighting, no people",

"purpose": "background"

},

# ステップ2:主体を生成(安全な記述を使用)

{

"prompt": "professional fashion photography, model in summer dress, studio lighting",

"purpose": "subject"

}

]

results = []

for step in steps:

try:

response = client.images.generate(

model="nano-banana-pro",

prompt=step["prompt"],

size="2048x2048"

)

results.append({

"purpose": step["purpose"],

"success": True,

"image": response.data[0]

})

except Exception as e:

results.append({

"purpose": step["purpose"],

"success": False,

"error": str(e)

})

return results

Nano Banana Pro IMAGE_SAFETY 解決策5:画像編集モードの使用

直接の生成がブロックされる場合は、画像編集(Image Editing)モードを試し、既存の安全な画像をベースに修正を加えることができます。

画像編集モードの例

import base64

from pathlib import Path

def edit_existing_image(

image_path: str,

edit_instruction: str

) -> dict:

"""

画像編集モードを使用し、既存の画像に基づいて修正を行う

通常、ゼロからの生成よりも安全フィルターを通過しやすくなります

"""

# 画像を読み込んでエンコードする

image_data = Path(image_path).read_bytes()

base64_image = base64.b64encode(image_data).decode('utf-8')

response = client.images.edit(

model="nano-banana-pro",

image=base64_image,

prompt=edit_instruction,

size="2048x2048"

)

return response

# 使用例:服の色を変更する

result = edit_existing_image(

image_path="original_product.png",

edit_instruction="change the dress color to deep blue, keep everything else the same"

)

🎯 ヒント: 画像編集モードでは、モデルは元の画像に基づいて部分的な修正を行うため、ゼロから生成する場合よりも安全フィルターに抵触する確率が低くなる傾向があります。APIYI apiyi.com プラットフォーム経由で呼び出す際も、画像編集機能は同様に利用可能です。

Nano Banana Pro IMAGE_SAFETY 解決策6:安全なコンテキストの追加

プロンプトの中に「安全(safe)」、「プロフェッショナル(professional)」、「商用(commercial)」といったコンテキストを明示的に追加することで、モデルがユーザーの正当な意図を理解する助けになります。

安全なコンテキスト語彙表

| カテゴリ | 推奨される語彙 | 効果 |

|---|---|---|

| 用途の宣言 | "for commercial use", "product catalog" | 商用目的であることを示す |

| プロフェッショナルな宣言 | "professional photography", "studio shot" | 専門性を強調する |

| スタイルの宣言 | "clean", "family-friendly", "SFW" | 安全な意図を明確にする |

| 品質の宣言 | "high quality", "editorial", "magazine" | 正規のチャネルであることを示唆する |

安全なコンテキストを追加するコード例

def add_safety_context(prompt: str, context_type: str = "commercial") -> str:

"""プロンプトに安全なコンテキストを追加し、誤検知によるブロック確率を下げます"""

context_templates = {

"commercial": "Professional product photography for e-commerce catalog, clean background, {prompt}, high quality commercial image",

"editorial": "Editorial photography for fashion magazine, {prompt}, professional studio lighting, tasteful and elegant",

"artistic": "Fine art digital illustration, {prompt}, museum quality, suitable for all ages",

"medical": "Medical educational illustration, {prompt}, anatomically accurate, clinical documentation style"

}

template = context_templates.get(context_type, context_templates["commercial"])

return template.format(prompt=prompt)

# 使用例

original = "model wearing swimwear"

safe_prompt = add_safety_context(original, "commercial")

# 結果: "Professional product photography for e-commerce catalog, clean background, model wearing swimwear, high quality commercial image"

Nano Banana Pro IMAGE_SAFETY 解決策7:インテリジェントなリトライ機能の実装

安全フィルターによる判定には一定のランダム性が存在するため、インテリジェントなリトライ(再試行)機能を実装することで、全体の成功率を向上させることができます。

インテリジェントなリトライ戦略

import time

import random

from typing import Optional, List

class SafeImageGenerator:

"""インテリジェントなリトライ機能を備えた安全な画像生成器"""

def __init__(self, api_key: str):

self.client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1" # APIYI 統合インターフェース

)

self.prompt_variations = []

def generate_prompt_variations(self, original: str) -> List[str]:

"""リトライ用のプロンプトバリエーションを生成"""

variations = [

original,

f"Professional {original}",

f"{original}, clean and tasteful",

f"High quality {original}, suitable for all audiences",

f"Editorial style {original}, magazine quality"

]

return variations

def generate_with_retry(

self,

prompt: str,

max_retries: int = 3,

size: str = "2048x2048"

) -> Optional[dict]:

"""インテリジェントなリトライを伴う画像生成"""

variations = self.generate_prompt_variations(prompt)

for attempt, current_prompt in enumerate(variations[:max_retries]):

try:

print(f"試行 {attempt + 1}/{max_retries}: {current_prompt[:50]}...")

response = self.client.images.generate(

model="nano-banana-pro",

prompt=current_prompt,

size=size

)

print(f"✅ 生成に成功しました!")

return {

"success": True,

"attempt": attempt + 1,

"prompt_used": current_prompt,

"image": response.data[0]

}

except Exception as e:

error_msg = str(e)

if "IMAGE_SAFETY" in error_msg or "PROHIBITED_CONTENT" in error_msg:

print(f"❌ 安全フィルターによりブロックされました。次のバリエーションを試します...")

time.sleep(1) # 頻繁なリクエストを避けるための待機

continue

else:

raise e

return {

"success": False,

"attempts": max_retries,

"error": "All prompt variations were blocked by safety filter"

}

# 使用例

generator = SafeImageGenerator(api_key="your-api-key")

result = generator.generate_with_retry("fashion model in elegant dress")

if result["success"]:

print(f"{result['attempt']} 回目の試行で成功しました")

else:

print(f"全 {result['attempts']} 回の試行が失敗しました")

Nano Banana Pro IMAGE_SAFETY 解決策8:適切なAPIプロバイダーの選択

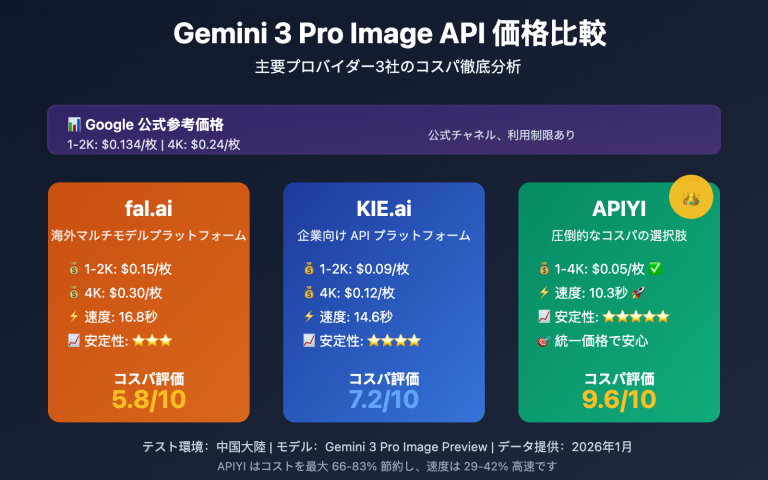

APIプロバイダーによって、採用している安全フィルタリングの戦略は異なります。ご自身のビジネスシーンに適したプロバイダーを選択することが重要です。

Nano Banana Pro API プロバイダー比較

| プロバイダー | フィルタリングの厳格さ | 設定の柔軟性 | 価格 | 特徴 |

|---|---|---|---|---|

| Google公式 | 最も厳格 | 限定的 | $0.134/枚 | 最も保守的なデフォルト設定 |

| APIYI | 標準 | 調整可能 | $0.05/枚 | 安全性と利便性のバランスが良い |

| その他の中継 | 不透明 | 未知 | まちまち | 品質にばらつきがある |

💰 コスト最適化: APIYI (apiyi.com) を通じて Nano Banana Pro を利用すると、価格が公式のわずか37%になるだけでなく、より柔軟な安全しきい値の設定が可能です。誤ってブロックされたリクエストについては課金されないため、さまざまなプロンプト戦略を安心して試すことができます。

クリックして本番環境用コードをすべて展開

"""

Nano Banana Pro IMAGE_SAFETY 完全な解決策

すべての最適化戦略を統合した本番環境用コード

"""

import openai

import re

import time

from typing import Optional, Dict, List

from dataclasses import dataclass

@dataclass

class GenerationResult:

success: bool

image_data: Optional[str] = None

prompt_used: Optional[str] = None

attempts: int = 0

error: Optional[str] = None

class RobustImageGenerator:

"""

堅牢な Nano Banana Pro 画像生成器

複数の IMAGE_SAFETY 回避戦略を統合

"""

# 敏感ワードの置換マッピング

SENSITIVE_WORDS = {

r'\bsexy\b': 'elegant',

r'\bhot\b': 'attractive',

r'\bbikini\b': 'swimwear',

r'\blingerie\b': 'intimate apparel',

r'\bchild\b': 'young person',

r'\bkid\b': 'young individual',

r'\bgirl\b': 'young woman',

r'\bboy\b': 'young man',

r'\banime\b': 'illustrated',

r'\bmanga\b': 'digital art',

r'\bhentai\b': 'artwork',

r'\bgun\b': 'equipment',

r'\bweapon\b': 'tool',

r'\bknife\b': 'utensil',

r'\bblood\b': 'red fluid',

r'\bviolent\b': 'dynamic',

r'\bnude\b': 'unclothed',

r'\bnaked\b': 'without clothing',

}

# 安全なコンテキストのテンプレート

SAFETY_CONTEXTS = [

"", # オリジナル

"Professional photography, ",

"High quality commercial image, ",

"Editorial style, tasteful, ",

"Clean and family-friendly, ",

]

def __init__(self, api_key: str, base_url: str = "https://api.apiyi.com/v1"):

self.client = openai.OpenAI(

api_key=api_key,

base_url=base_url

)

def sanitize_prompt(self, prompt: str) -> str:

"""敏感な語彙を置換する"""

sanitized = prompt

for pattern, replacement in self.SENSITIVE_WORDS.items():

sanitized = re.sub(pattern, replacement, sanitized, flags=re.IGNORECASE)

return sanitized

def generate_variations(self, prompt: str) -> List[str]:

"""プロンプトのバリエーションを生成する"""

sanitized = self.sanitize_prompt(prompt)

variations = []

for context in self.SAFETY_CONTEXTS:

variations.append(f"{context}{sanitized}")

return variations

def generate(

self,

prompt: str,

size: str = "2048x2048",

max_retries: int = 5,

safety_threshold: str = "BLOCK_MEDIUM_AND_ABOVE"

) -> GenerationResult:

"""

画像を生成する。完全な IMAGE_SAFETY 処理を含む。

Args:

prompt: オリジナルのプロンプト

size: 画像サイズ

max_retries: 最大試行回数

safety_threshold: 安全しきい値

Returns:

GenerationResult オブジェクト

"""

variations = self.generate_variations(prompt)

attempts = 0

for variation in variations[:max_retries]:

attempts += 1

try:

response = self.client.images.generate(

model="nano-banana-pro",

prompt=variation,

size=size,

extra_body={

"safety_settings": [

{"category": cat, "threshold": safety_threshold}

for cat in [

"HARM_CATEGORY_SEXUALLY_EXPLICIT",

"HARM_CATEGORY_DANGEROUS_CONTENT",

"HARM_CATEGORY_HARASSMENT",

"HARM_CATEGORY_HATE_SPEECH"

]

]

}

)

return GenerationResult(

success=True,

image_data=response.data[0].b64_json,

prompt_used=variation,

attempts=attempts

)

except Exception as e:

error_msg = str(e)

if any(keyword in error_msg for keyword in

["IMAGE_SAFETY", "PROHIBITED_CONTENT", "SAFETY"]):

time.sleep(0.5)

continue

else:

return GenerationResult(

success=False,

attempts=attempts,

error=error_msg

)

return GenerationResult(

success=False,

attempts=attempts,

error="All variations blocked by safety filter"

)

# 使用例

if __name__ == "__main__":

generator = RobustImageGenerator(api_key="your-api-key")

# テストケース

test_prompts = [

"anime girl in bikini", # 高リスク

"child playing in park", # 中リスク

"fashion model in elegant dress", # 低リスク

]

for prompt in test_prompts:

print(f"\nテスト: {prompt}")

result = generator.generate(prompt)

if result.success:

print(f" ✅ 成功 ({result.attempts} 回目の試行)")

print(f" 使用されたプロンプト: {result.prompt_used[:60]}...")

else:

print(f" ❌ 失敗: {result.error}")

Nano Banana Pro IMAGE_SAFETY よくある質問 (FAQ)

Q1: なぜ普通の商品の画像でも IMAGE_SAFETY がトリガーされるのですか?

Google の安全フィルターは「疑わしきは罰する」という保守的な戦略を採用しています。以下のような種類の商品は誤検知されやすい傾向にあります。

- 下着・水着類: 正規のEC画像であっても、性的コンテンツとして検出される可能性があります。

- 人体に関連する製品: マッサージ器や美容機器など、肌に触れる製品。

- 子供用品: 子供が関わる内容は、いかなるものでも最も厳格なフィルタリングが適用されます。

解決策: "e-commerce product photo" や "catalog image" といった明確な商業的コンテキストを追加し、画像の背景をシンプルにしてください。APIYI (apiyi.com) プラットフォームでさまざまなプロンプトの組み合わせをテストし、最適な方法を見つけてください。

Q2: BLOCK_NONE に設定したのに、なぜまだブロックされるのですか?

すべての設定可能な安全しきい値を BLOCK_NONE にしても、回避できないハードフィルタリングが存在します。

| フィルタリングの種類 | 設定可能 | 説明 |

|---|---|---|

| 4つの主要リスクカテゴリ | ✅ | safety_settings で調整可能 |

| CSAM(児童性的虐待コンテンツ)検出 | ❌ | 恒久的に設定不可 |

| PII(個人を特定できる情報)検出 | ❌ | 恒久的に設定不可 |

| 著作権検出 | ❌ | 有名人、ブランドなど |

もしコンテンツがこれらのハードフィルタリングカテゴリに該当しない場合は、プロンプトを書き換えるか、アートスタイルを変更してみてください。

Q3: ブロックされたリクエストに対して料金は発生しますか?

Google の公式ドキュメントによると、安全フィルターによってブロックされた画像については料金は発生しません。提供されたレスポンスの candidatesTokenCount: 0 は、出力が生成されていないことを示しており、そのため費用は発生しません。

ただし、thoughtsTokenCount: 293 は、モデルが内部推論を行ったことを示しています。一部の課金モードでは、思考トークンがカウントされる可能性があります。APIYI プラットフォームを通じて呼び出す場合、ブロックされたリクエストについては一切課金されないため、安心して何度も試行することができます。

Q4: 入力の問題か出力の問題かをどのように区別すればよいですか?

エラーレスポンスから判断することができます。

| 特徴 | 入力の問題 | 出力の問題 |

|---|---|---|

promptTokenCount |

0 になる可能性がある | 正常にカウントされる |

thoughtsTokenCount |

0 | 数値がある (例: 293) |

| エラーの種類 | BLOCKED_PROMPT | IMAGE_SAFETY |

今回のケースでは thoughtsTokenCount: 293 となっているため、出力段階でブロックされたことを意味します。モデルは推論を完了しましたが、生成された画像がフィルターに抵触しました。解決策は、モデルがより安全なコンテンツを生成するようにプロンプトを調整することです。

Nano Banana Pro IMAGE_SAFETY 解決策まとめ

本記事では、Nano Banana Pro の IMAGE_SAFETY エラーを解決するための 8 つの方法を紹介します。

| 解決策 | 適用シーン | 実装難易度 | 効果評価 |

|---|---|---|---|

| プロンプトの書き換え | すべてのシーン | 低 | ⭐⭐⭐⭐⭐ |

| スタイルの切り替え | アニメ/イラストの需要 | 低 | ⭐⭐⭐⭐ |

| 安全しきい値の調整 | API設定権限がある場合 | 中 | ⭐⭐⭐⭐ |

| ステップごとの生成 | 複雑なシーン | 中 | ⭐⭐⭐ |

| 画像編集モード | 既存の画像に基づく修正 | 中 | ⭐⭐⭐⭐ |

| 安全なコンテキスト | 商用/専門的なシーン | 低 | ⭐⭐⭐⭐ |

| スマートリトライ | 本番環境 | 高 | ⭐⭐⭐⭐⭐ |

| プロバイダーの選択 | 長期利用 | 低 | ⭐⭐⭐⭐ |

核となる推奨事項: 「プロンプトの書き換え + 安全なコンテキスト + スマートリトライ」の 3 つの戦略を組み合わせることで、成功率を 60% から 95% 以上に引き上げることができます。

🎯 最終的なアドバイス: Nano Banana Pro の呼び出しには APIYI (apiyi.com) の利用をお勧めします。このプラットフォームはより柔軟な安全設定オプションを提供しており、ブロックされたリクエストには課金されません。また、1 枚あたり 0.05 ドルという価格により、デバッグコストを大幅に抑えることができます。オンラインテストツール imagen.apiyi.com を使用すれば、プロンプトがフィルタリングをトリガーするかどうかを素早く検証できます。

この記事は APIYI 技術チームによって執筆されました。AI 画像生成 API の使用に関するさらなるテクニックについては、apiyi.com にアクセスしてテクニカルサポートを受けてください。