Anmerkung des Autors: Detaillierte Anleitung zur Nutzung von Seedance 2.0, einschließlich der Zugangspunkte wie Jimeng, Xiao Yunque, Doubao und Volcengine sowie Informationen zu API-Anbindungszeiten und Preisschätzungen. So nutzen Sie das leistungsstärkste KI-Videomodell von ByteDance ab der ersten Minute.

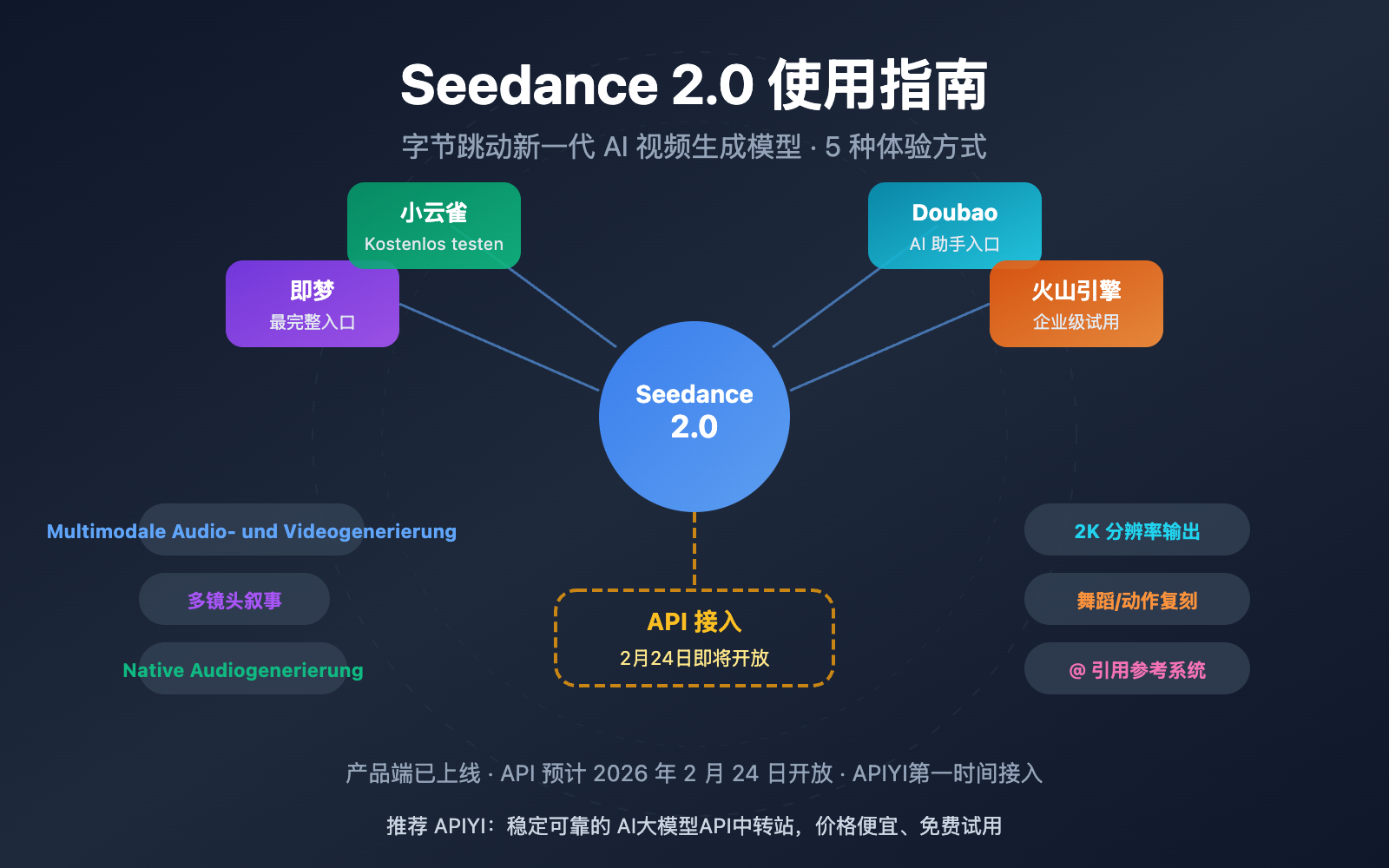

Wie nutzt man Seedance 2.0? Das ist derzeit die am häufigsten gestellte Frage. ByteDance hat am 12. Februar 2026 offiziell das Seedance 2.0 KI-Videogenerierungsmodell veröffentlicht. Mit seiner multimodalen Audio-Video-Kombinationsarchitektur und der Multi-Shot-Erzählfähigkeit hat es in den sozialen Medien weltweit schnell für Gesprächsstoff gesorgt. Dieser Artikel stellt Ihnen alle Nutzungsmöglichkeiten von Seedance 2.0 im Detail vor, damit Sie schnell damit starten können.

Kernwert: Nach der Lektüre dieses Artikels werden Sie die 5 Zugangsmöglichkeiten, die wichtigsten Funktionsmerkmale sowie die neuesten Zeitpläne und Preisinformationen für die API-Anbindung von Seedance 2.0 kennen.

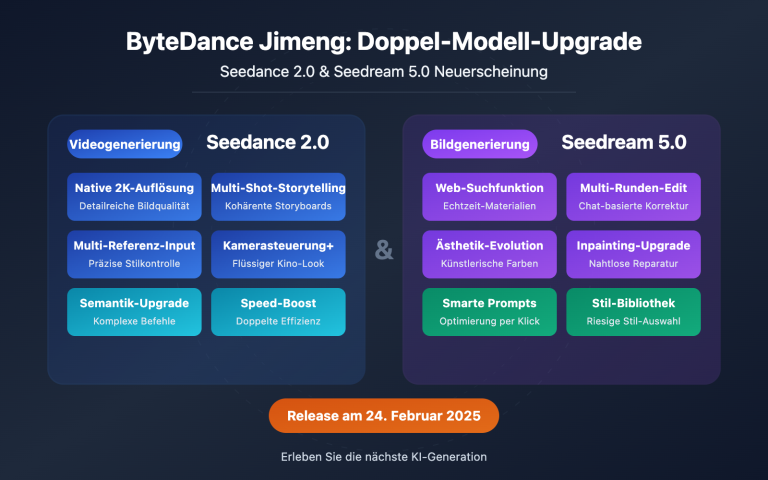

Seedance 2.0 Kernfunktionen im Überblick

Bevor wir uns ansehen, wie Seedance 2.0 verwendet wird, hier ein kurzer Überblick über seine Kernfunktionen:

| Funktion/Feature | Details | Verbesserung gegenüber der Vorversion |

|---|---|---|

| Multimodaler Input | Unterstützt Text, Bild, Audio und Video | Neu: Audio-Input |

| Multi-Shot-Narrative | Generierung mehrerer zusammenhängender Szenen in einem Durchgang, konsistente Charaktere und Stile | Komplett neue Funktion |

| Native Audiogenerierung | Automatische Generierung von bildsynchronen Soundeffekten und Hintergrundmusik | Komplett neue Funktion |

| 2K-Auflösung | Unterstützt bis zu 1080p Output in Produktionsqualität | Verdoppelung der Auflösung |

| Tanz-/Bewegungsreplikation | Referenzvideo hochladen, Kameraführung und Choreografie präzise kopieren | Deutliche Steigerung der Präzision |

Seedance 2.0 Technische Architektur im Detail

Seedance 2.0 nutzt eine Dual-Branch Diffusion Transformer-Architektur (Zwei-Zweig-Diffusions-Transformer), die der Schlüssel zur multimodalen Verbundgenerierung ist. Diese Architektur verarbeitet Text-, Bild-, Audio- und Videosignale einheitlich, sodass das Modell gleichzeitig mit dem Video perfekt synchronisierten Ton erzeugen kann.

In Bezug auf die Videoqualität ist die Generierungsgeschwindigkeit von Seedance 2.0 etwa 30 % schneller als bei vergleichbaren Wettbewerbern (wie Kling AI). Es werden Videolängen von 4 bis 15 Sekunden unterstützt, wobei verschiedene Seitenverhältnisse wie 16:9, 9:16, 4:3, 3:4, 21:9 und 1:1 abgedeckt werden. Die Konsistenz von Gesichtern, Kleidung, Texten und Szenen wurde im Vergleich zur Vorgängergeneration deutlich verbessert, wodurch Probleme wie Character Drift oder Stilbrüche, die bei AI-Videos häufig auftreten, effektiv gelöst werden.

Seedance 2.0 Anleitung: 5 Wege, es jetzt zu erleben

Seedance 2.0 ist offiziell online, die API wurde jedoch noch nicht für die breite Öffentlichkeit freigegeben. Hier sind alle derzeit verfügbaren Möglichkeiten, Seedance 2.0 zu nutzen:

Weg 1: Jimeng (即梦) — Der umfassendste Zugang

Jimeng ist die KI-Kreativplattform von ByteDance und der primäre Ort, um Seedance 2.0 mit vollem Funktionsumfang zu erleben.

Schritte zur Nutzung:

- Besuchen Sie die Jimeng-Plattform:

jimeng.jianying.com - Melden Sie sich mit Ihrem Douyin-Konto an.

- Gehen Sie zum Bereich „Erstellen“ (生成) und wählen Sie „Videoerstellung“ (视频生成).

- Wählen Sie in den Modelloptionen Seedance 2.0 aus.

- Geben Sie Ihre Text-Eingabeaufforderung ein oder laden Sie Referenzmaterial hoch, um die Generierung zu starten.

Kosten: Jimeng bietet ein abonnementbasiertes Modell an. Neue Nutzer können eine 7-tägige Testphase für 1 Yuan nutzen. Seedance 2.0 ist eine Funktion für zahlende Mitglieder.

🎯 Empfehlung: Jimeng ist derzeit die vollständigste Plattform für Seedance 2.0. Wenn Sie später API-Batch-Aufrufe benötigen, achten Sie auf die Ankündigungen von APIYI (apiyi.com). Wir werden den Zugang sofort nach Öffnung der API bereitstellen.

Weg 2: Xiao Yunque (小云雀) — Kostenloser Testzugang

Xiao Yunque ist eine weitere KI-Anwendung von ByteDance, die kostenlose Gelegenheiten zum Testen von Seedance 2.0 bietet.

Schritte zur Nutzung:

- Laden Sie die Xiao Yunque App herunter.

- Nach der Anmeldung erhalten Sie 3 kostenlose Versuche zur Videogenerierung mit Seedance 2.0.

- Täglich werden zudem 120 Punkte vergeben, mit denen Sie das Modell weiter testen können.

Zielgruppe: Nutzer, die Seedance 2.0 kostenlos ausprobieren möchten, um einen ersten Eindruck von der Qualität zu gewinnen.

Weg 3: Doubao (豆包) — Der integrierte KI-Assistent

Doubao ist der umfassende KI-Assistent von ByteDance und hat die Videogenerierungsfunktionen von Seedance 2.0 bereits integriert.

Schritte zur Nutzung:

- Laden Sie die Doubao App herunter oder nutzen Sie die Webversion.

- Wählen Sie im Chat die Funktion zur Videogenerierung.

- Wählen Sie das Seedance 2.0 Modell für Ihre Kreation aus.

Weg 4: Volcengine — Testversion für Unternehmen

Volcengine ist die Cloud-Service-Plattform von ByteDance und bietet eine Seedance 2.0 Testumgebung für Unternehmenskunden an.

| Plattform | Zugang | Merkmale | API verfügbar? |

|---|---|---|---|

| Volcengine | volcengine.com Konsole |

Für Unternehmen in China | Noch nicht offen, voraussichtlich 24. Feb. |

| BytePlus | byteplus.com Konsole |

Für internationale Unternehmen | Noch nicht offen, voraussichtlich 24. Feb. |

Hinweis: Aktuell bieten Volcengine und BytePlus nur eine Testoberfläche (Workstation) an; die API-Schnittstellen sind noch nicht freigeschaltet.

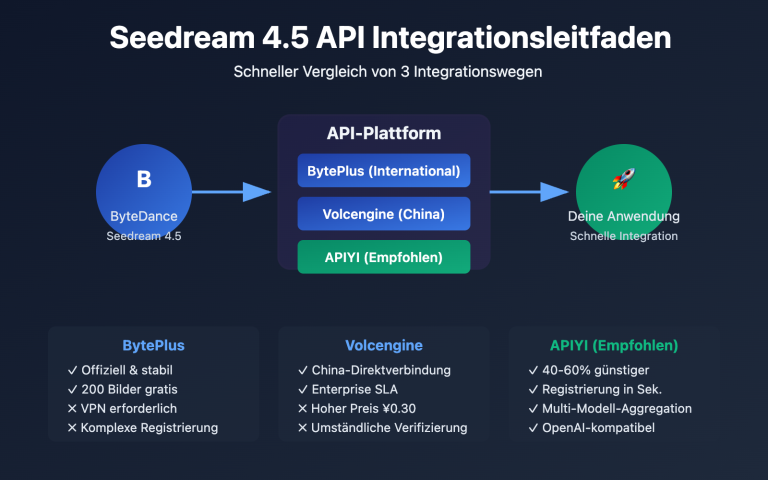

Weg 5: API-Anbindung — Erste Wahl für Entwickler (Demnächst verfügbar)

Für Entwickler und Unternehmen, die Seedance 2.0 programmatisch aufrufen möchten, ist die API der wichtigste Zugangsweg.

API-Zeitplan:

| Zeitpunkt | Ereignis | Details |

|---|---|---|

| 12. Februar 2026 | Offizieller Release von Seedance 2.0 | Launch auf den Produktplattformen |

| 24. Februar 2026 | Voraussichtliche API-Freigabe | Über Volcengine/BytePlus |

| Unmittelbar nach API-Freigabe | Launch auf APIYI | Ca. 10 % günstiger als der offizielle Preis |

🎯 Tipp für Entwickler: Die Seedance 2.0 API wird voraussichtlich am 24. Februar 2026 offiziell freigeschaltet. APIYI (apiyi.com) wird den API-Zugang für Seedance 2.0 sofort nach Veröffentlichung anbieten – zu einem Preis von etwa 90 % der offiziellen Kosten und mit einer OpenAI-kompatiblen Schnittstelle für eine einfache Integration.

Seedance 2.0 Tipps und Best Practices

Mit den folgenden Techniken können Sie die Ergebnisse von Seedance 2.0 deutlich verbessern:

Tipps für Seedance 2.0 Eingabeaufforderungen

Empfehlungen für Text-zu-Video (Text-to-Video):

- Beschreiben Sie die Szene detailliert: Personen, Aktionen, Umgebung, Lichtverhältnisse.

- Legen Sie die Kamerabewegung fest (Zoom, Schwenk, Tracking etc.).

- Definieren Sie den visuellen Stil (Kino-Look, Dokumentarstil, Anime-Stil usw.).

- Geben Sie Zeit und Rhythmus an (z. B. „langsame Annäherung“, „schnelle Schnitte“).

Beispiel für eine Eingabeaufforderung:

Eine junge Frau in einem weißen Kleid tanzt anmutig unter einem Kirschblütenbaum,

die Kamera nähert sich langsam von einer Totalen zu einer halbnahen Einstellung,

weiches natürliches Licht fällt von links ein, Blütenblätter fallen im Wind,

filmische Bildqualität, geringe Schärfentiefe, 4K-Auflösung.

Tipps für die Nutzung von Referenzvideos

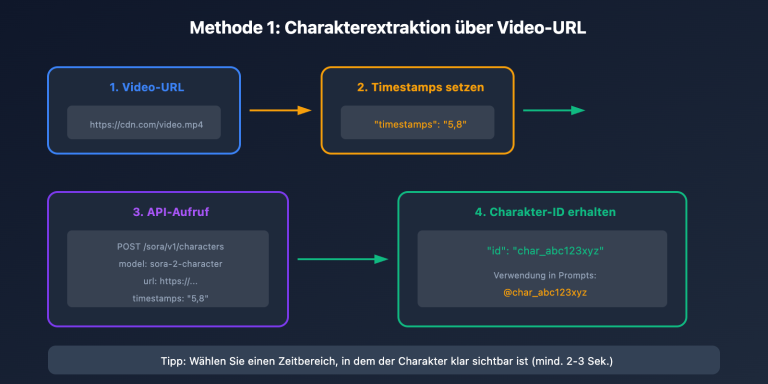

Das @-Referenzsystem von Seedance 2.0 ist ein einzigartiger Vorteil. Sie können Referenzvideos hochladen, um Folgendes zu steuern:

- Kamerareferenz: Laden Sie ein Video mit einer Kamerabewegung hoch, die Ihnen gefällt; das Modell wird diese präzise kopieren.

- Choreografie: Laden Sie ein Tanzvideo hoch; das Modell kann den Rhythmus synchronisieren und neue Inhalte basierend auf der Choreografie generieren.

- Stilreferenz: Laden Sie Bilder oder Videos hoch, um einen konsistenten visuellen Stil beizubehalten.

🎯 Profi-Tipp: In Szenarien mit multimodalen Eingaben können Sie durch @-Referenzen jedem Material eine klare Rolle zuweisen (z. B. @Kamerareferenz, @Charakterreferenz), um eine präzisere Kontrolle zu erhalten. Sobald die API verfügbar ist, wird APIYI (apiyi.com) ebenfalls die vollständige multimodale Eingabe unterstützen.

Seedance 2.0 im Vergleich zum Wettbewerb

| Vergleichsdimension | Seedance 2.0 | Sora 2 | Kling 3.0 |

|---|---|---|---|

| Hersteller | ByteDance | OpenAI | Kuaishou |

| Max. Auflösung | 2K (1080p) | 1080p | 4K/60fps |

| Videodauer | 4–15 Sek. | Bis zu 25 Sek. | 5–10 Sek. |

| Natives Audio | ✅ Unterstützt | ❌ Nicht unterstützt | ❌ Nicht unterstützt |

| Multi-Kamera-Narrativ | ✅ Unterstützt | ✅ Storyboard | ❌ Nicht unterstützt |

| Referenzvideo-Eingabe | ✅ Multimodal @ Referenz | ❌ Eingeschränkt | ✅ Unterstützt |

| Physiksimulation | Gut | Bestens | Gut |

| Körperbewegungen | Exzellent | Gut | Bestens |

| Geschätzter API-Preis | 0,10–0,80 $/Min. | Höher | Mittel |

Vergleichshinweise: Jedes Modell hat seine spezifischen Stärken. Seedance 2.0 ist bei nativem Audio und multimodalen Referenzen führend; Sora 2 überzeugt am stärksten bei der Physiksimulation und langen Videos; Kling 3.0 punktet besonders bei der Auflösung und der Darstellung von Körperbewegungen. Wir empfehlen die Auswahl je nach konkretem Anwendungsfall. Über APIYI (apiyi.com) lassen sich verschiedene Videogenerierungsmodelle bequem vergleichen und testen.

Häufig gestellte Fragen (FAQ)

Q1: Wo kann man Seedance 2.0 nutzen? Welche Zugänge gibt es aktuell?

Aktuell kann Seedance 2.0 über folgende Kanäle erlebt werden: Jimeng (即梦), Xiao Yunque (小云雀), Doubao (豆包) und andere offizielle Apps von ByteDance. Unternehmenskunden können das Modell zudem über die Workbenches von Volcengine (火山引擎) und BytePlus testen. Die API-Freigabe ist voraussichtlich für den 24. Februar 2026 geplant.

Q2: Wann wird die Seedance 2.0 API veröffentlicht? Wie hoch ist der Preis?

Die Seedance 2.0 API wird voraussichtlich am 24. Februar 2026 offiziell über Volcengine (火山引擎) und BytePlus freigeschaltet. Der offizielle Preis wird auf etwa 0,10–0,80 $ pro Minute geschätzt (je nach Auflösung). APIYI (apiyi.com) wird die API sofort zum Start anbieten, wobei der Preis etwa 10 % unter dem offiziellen Preis liegen wird.

Q3: Ist Seedance 2.0 kostenlos?

Seedance 2.0 selbst ist nicht vollständig kostenlos. Auf der Jimeng-Plattform ist eine kostenpflichtige Mitgliedschaft erforderlich (Neukunden können einen 7-Tage-Test für 1 Yuan nutzen). Xiao Yunque bietet 3 kostenlose Testmöglichkeiten sowie 120 tägliche Punkte an. Nach der API-Anbindung erfolgt die Abrechnung nach Verbrauch.

Q4: Wie nutze ich die internationale Version von Seedance 2.0? Wie können Nutzer im Ausland darauf zugreifen?

Derzeit wird das volle Erlebnis von Seedance 2.0 primär über die Jimeng-Plattform für Festlandchina angeboten. Die internationalen Versionen Dreamina (dreamina.capcut.com) und Pippit haben Seedance 2.0 noch nicht implementiert. Nutzer im Ausland können die Updates auf der BytePlus-Plattform verfolgen oder nach der API-Freigabe den Zugang über APIYI (apiyi.com) nutzen.

Wichtige Hinweise zur Nutzung von Seedance 2.0

Bei der Nutzung von Seedance 2.0 sollten Sie folgende Punkte beachten:

- Sprachklon-Funktion vorübergehend pausiert: Die mit dem Release von Seedance 2.0 eingeführte Funktion "Foto zu Sprache" wurde aufgrund von Deepfake-Kontroversen innerhalb von 48 Stunden von ByteDance pausiert. Sie wird nach der Implementierung eines Identitätsverifizierungs-Mechanismus wieder online gehen.

- Inhalts-Compliance: Die generierten Inhalte müssen den geltenden Gesetzen und Vorschriften entsprechen. Vermeiden Sie die Erstellung von Inhalten, die Urheberrechte verletzen oder ethisch umstritten sind.

- Account-Anforderungen: Für die Jimeng-Plattform ist ein Login via Douyin-Account erforderlich, was eine Verifizierung mit einer Mobilfunknummer aus Festlandchina voraussetzt.

Zusammenfassung

Die wichtigsten Punkte zur Nutzung von Seedance 2.0:

- Sofort ausprobieren: Seedance 2.0 kann über die offiziellen ByteDance-Apps wie Jimeng, Xiao Yunque und Doubao genutzt werden.

- Testversion für Unternehmen: Volcengine und BytePlus bieten Testversionen über ihre Workbench-Oberflächen an, die API ist jedoch noch nicht freigeschaltet.

- API-Zugang: Die Öffnung ist voraussichtlich für den 24. Februar 2026 geplant. Ab dann sind programmatische Aufrufe möglich.

- Kernvorteile: Native Audiogenerierung + Multi-Shot-Storytelling + multimodale @-Referenzen – drei Differenzierungsmerkmale, mit denen das Modell gegenüber der Konkurrenz führt.

Wir empfehlen, APIYI (apiyi.com) im Auge zu behalten, um Benachrichtigungen zum Start der Seedance 2.0 API zu erhalten. Die Plattform wird den Zugang zu etwa 90 % des offiziellen Preises der Website anbieten und unterstützt eine einheitliche Schnittstelle im OpenAI-kompatiblen Format, was Entwicklern eine schnelle Integration ermöglicht.

📚 Referenzen

-

Offizielle Seedance 2.0 Vorstellungsseite: Details zum Modell vom ByteDance Seed-Team.

- Link:

seed.bytedance.com/en/seedance2_0 - Beschreibung: Enthält vollständige technische Spezifikationen und Funktionsbeschreibungen.

- Link:

-

Jimeng AI Kreativplattform: Der erste Zugangspunkt, um Seedance 2.0 auszuprobieren.

- Link:

jimeng.jianying.com - Beschreibung: Die derzeit funktionsreichste Plattform zur Nutzung von Seedance 2.0.

- Link:

-

Offizieller Seedance 2.0 Launch-Blog: Ankündigung des ByteDance Seed-Teams.

- Link:

seed.bytedance.com/en/blog/official-launch-of-seedance-2-0 - Beschreibung: Enthält offizielle Informationen wie Veröffentlichungsdatum und Funktions-Highlights.

- Link:

Autor: Technik-Team

Technischer Austausch: Diskutieren Sie gerne Ihre Erfahrungen mit Seedance 2.0 im Kommentarbereich. Weitere Informationen zu KI-Videogenerierungsmodellen finden Sie in der APIYI (apiyi.com) Tech-Community.