遇到 "You've reached your rate limit. Please try again later." 这个错误是不是让你很困惑?明明之前用得好好的,Token 也没超限,怎么突然就不能用了?

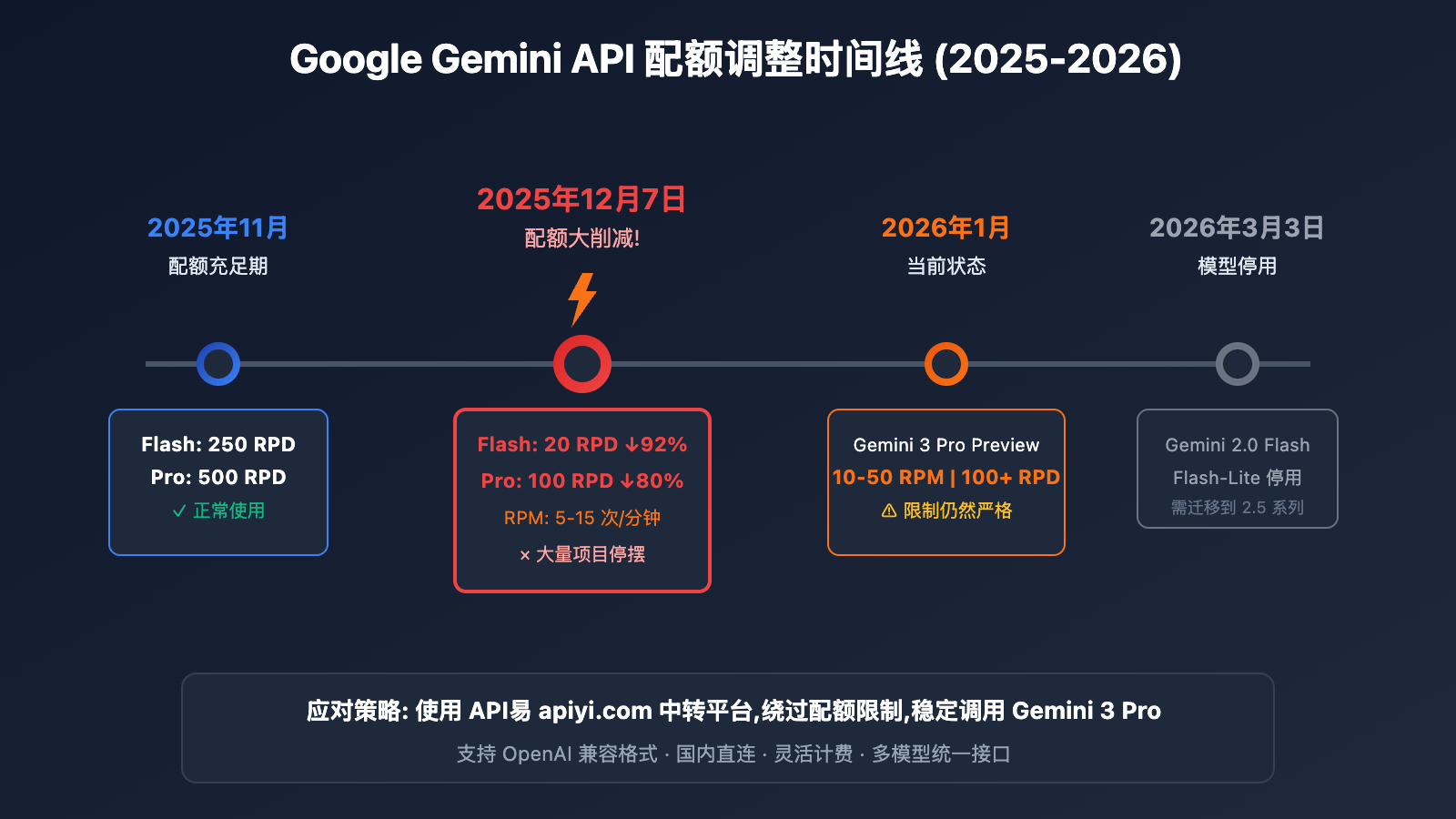

如果你是个人学习用户,在 AI Studio 使用 Gemini 3 Pro 进行文本生成时遭遇这个问题,你并不孤单。2025 年 12 月 7 日,Google 悄然将 Gemini API 免费配额削减了 50%-92%,这一变化导致全球数万开发者的项目一夜之间停摆。

核心价值: 读完本文,你将了解配额削减的真实原因,掌握 5 种突破速率限制的方法,并学会如何通过 API 中转平台稳定使用 Gemini 3 Pro。

Gemini 3 Pro 速率限制核心要点

在解决问题之前,我们需要先了解 Google 到底做了什么调整。

| 调整项 | 调整前 (2025年11月) | 调整后 (2025年12月7日) | 降幅 |

|---|---|---|---|

| Flash 模型 RPD | 250 请求/天 | 20 请求/天 | -92% |

| Pro 模型 RPD | 500 请求/天 | 100 请求/天 | -80% |

| Pro 模型 RPM | 15 请求/分钟 | 5 请求/分钟 | -67% |

| Gemini 3 Pro Preview | 不限 | 10-50 RPM,100+ RPD | 新增限制 |

Gemini 3 Pro 速率限制的 4 个维度

Google 的速率限制系统从 4 个维度控制使用量:

| 限制维度 | 全称 | 说明 | 免费层当前值 |

|---|---|---|---|

| RPM | Requests Per Minute | 每分钟请求数 | 5-15 次 |

| TPM | Tokens Per Minute | 每分钟 Token 数 | 250,000 |

| RPD | Requests Per Day | 每天请求数 | 20-100 次 |

| IPM | Images Per Minute | 每分钟图片数 | 适用于多模态 |

🔑 关键信息: Gemini 3 Pro 作为 Preview 版本,目前免费层限制约为 10-50 RPM 和 100+ RPD,但实际使用中很多用户反馈限制远比文档标注的更严格。

为什么 Google 大幅削减配额?

根据 Google 官方通告,配额调整基于以下原因:

- 需求爆发式增长: 2025 年 AI 应用爆发,API 调用量远超预期

- 基础设施压力: Gemini 2.0/3.0 模型对算力要求极高

- 保护付费用户体验: 优先保障付费层用户的服务质量

- 商业策略调整: 引导开发者转向付费方案

Gemini 3 Pro 速率限制的 5 种解决方案

针对 AI Studio 速率限制问题,以下是 5 种经过验证的解决方案:

方案一: 切换到其他 Gemini 模型

这是最简单的临时解决方案。不同模型有不同的配额限制:

| 模型 | RPM | RPD | 推荐场景 |

|---|---|---|---|

| Gemini 2.5 Flash-Lite | 15 | 1,000 | 轻量级任务首选 |

| Gemini 2.5 Flash | 10 | 500 | 均衡性能 |

| Gemini 2.5 Pro | 5 | 100 | 复杂推理 |

| Gemini 3 Pro Preview | 10-50 | 100+ | 最强能力,限制较严 |

💡 实用技巧: 如果你的任务不需要 Gemini 3 Pro 的全部能力,切换到 Gemini 2.5 Flash-Lite 可以获得高达 1,000 RPD 的配额,足够日常学习使用。

方案二: 等待配额重置

Gemini API 的 RPD (每日请求数) 配额在 太平洋时间午夜 重置。

配额重置时间对照表:

- 北京时间: 下午 4:00 (夏令时) / 下午 5:00 (冬令时)

- 东京时间: 下午 5:00 (夏令时) / 下午 6:00 (冬令时)

方案三: 升级到付费层

如果你需要稳定使用 Gemini 3 Pro,升级付费层是官方推荐的方案:

| 层级 | 要求 | RPM | RPD | 月均成本 |

|---|---|---|---|---|

| Free Tier | 无 | 5-15 | 20-100 | $0 |

| Tier 1 | 绑定信用卡 | 150-300 | 无限 | 按用量计费 |

| Tier 2 | 累计消费 $250 + 30天 | 1,000+ | 无限 | 按用量计费 |

Gemini 3 Pro 定价:

- 输入: $2.00 / 百万 Token (≤200K 上下文)

- 输出: $12.00 / 百万 Token (≤200K 上下文)

- 超长上下文 (>200K): 价格翻倍

方案四: 使用 API 中转平台 (推荐)

对于个人学习用户和中小团队,使用 API 中转平台是最具性价比的选择:

# 通过 API易 调用 Gemini 3 Pro - 极简示例

import openai

client = openai.OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # API易统一接口

)

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{"role": "user", "content": "请解释什么是 Transformer 架构"}

],

max_tokens=2000

)

print(response.choices[0].message.content)

🚀 快速开始: 推荐使用 API易 apiyi.com 平台快速接入 Gemini 3 Pro。该平台提供统一的 OpenAI 格式接口,无需担心配额限制,5 分钟即可完成集成。

查看完整代码示例 (含错误处理)

# Gemini 3 Pro 完整调用示例 - 通过 API易

import openai

from openai import OpenAI

import time

def call_gemini_3_pro(prompt: str, max_retries: int = 3) -> str:

"""

调用 Gemini 3 Pro 模型

Args:

prompt: 用户输入

max_retries: 最大重试次数

Returns:

模型响应内容

"""

client = OpenAI(

api_key="your-apiyi-key",

base_url="https://api.apiyi.com/v1" # API易统一接口

)

for attempt in range(max_retries):

try:

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{

"role": "system",

"content": "你是一个专业的 AI 助手,请用中文回答问题。"

},

{

"role": "user",

"content": prompt

}

],

max_tokens=4000,

temperature=0.7

)

return response.choices[0].message.content

except openai.RateLimitError as e:

print(f"请求过于频繁,等待后重试... ({attempt + 1}/{max_retries})")

time.sleep(2 ** attempt) # 指数退避

except openai.APIError as e:

print(f"API 错误: {e}")

raise

raise Exception("重试次数已用尽")

# 使用示例

if __name__ == "__main__":

result = call_gemini_3_pro("用 100 字解释大语言模型的工作原理")

print(result)

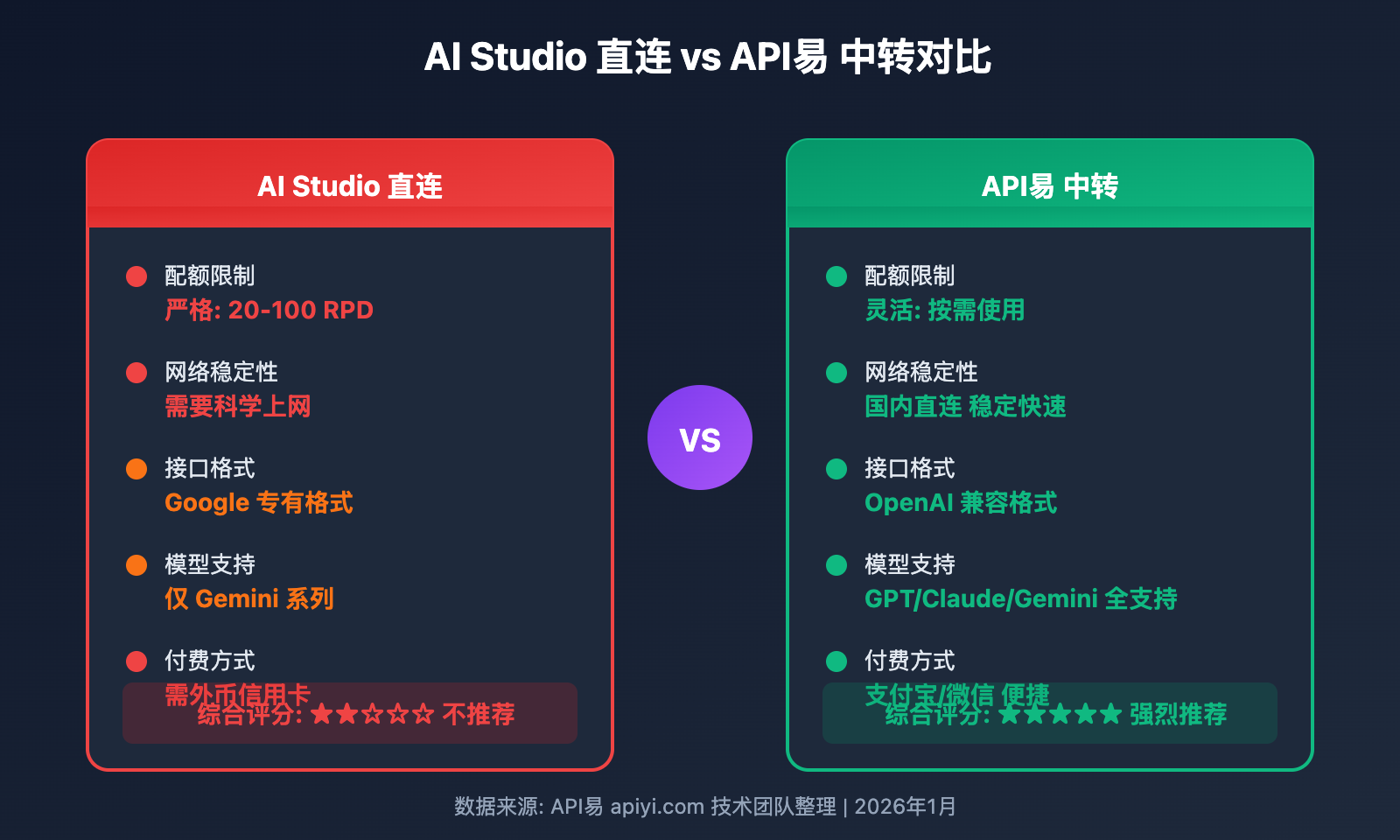

使用 API 中转平台的优势:

| 对比项 | AI Studio 直连 | API易中转 |

|---|---|---|

| 配额限制 | 严格 (20-100 RPD) | 灵活,按需使用 |

| 网络稳定性 | 需科学上网 | 国内直连 |

| 接口格式 | Google 专有格式 | OpenAI 兼容格式 |

| 多模型切换 | 仅 Gemini 系列 | 支持 GPT/Claude/Gemini 等 |

| 付费方式 | 需绑定外币信用卡 | 支持支付宝/微信 |

方案五: 合理规划请求策略

如果你必须使用免费层,以下策略可以最大化配额利用率:

1. 批量处理请求

# 将多个小问题合并为一个请求

combined_prompt = """

请依次回答以下问题:

1. Python 中 list 和 tuple 的区别是什么?

2. 什么是装饰器?

3. 如何实现单例模式?

"""

2. 使用缓存机制

import hashlib

import json

# 简单的本地缓存

cache = {}

def cached_query(prompt: str) -> str:

cache_key = hashlib.md5(prompt.encode()).hexdigest()

if cache_key in cache:

return cache[cache_key]

result = call_gemini_3_pro(prompt) # 实际 API 调用

cache[cache_key] = result

return result

3. 错峰使用

- 避开高峰时段 (美国工作时间)

- 太平洋时间午夜后配额重置

Gemini 3 Pro 速率限制常见问题

Q1: 为什么我只发了几条消息就触发速率限制?

这是 2025 年 12 月配额调整后的常见问题。当前 Gemini 3 Pro Preview 的免费层限制非常严格,可能低于官方文档标注的数值。部分用户反馈实际 RPM 只有文档的一半。

解决方案: 如果你需要持续使用,建议通过 API易 apiyi.com 等中转平台调用,可以避免直接触碰 Google 的免费层限制。

Q2: 付费层是否能完全解决限制问题?

升级到付费层 (Tier 1) 后,RPM 会提升到 150-300,RPD 限制基本取消。但需要注意:

- 需要绑定外币信用卡

- 按 Token 用量计费

- Gemini 3 Pro 定价较高 ($2-12/百万 Token)

对于个人学习用户,使用 API易 apiyi.com 等平台可能更经济实惠,同时支持国内支付方式。

Q3: 使用 API 中转是否安全?

选择正规的 API 中转平台是安全的。以 API易为例:

- 不存储用户对话内容

- 支持 HTTPS 加密传输

- 提供完整的 API 调用日志

建议选择有良好口碑、运营时间较长的平台。

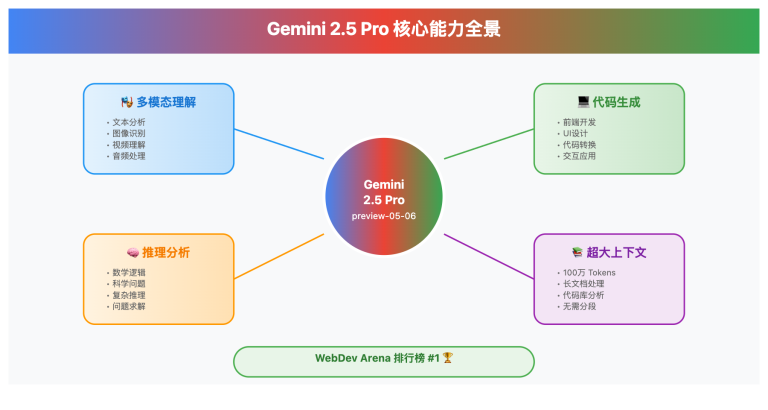

Q4: Gemini 3 Pro 和 2.5 Pro 有什么区别?

| 对比项 | Gemini 3 Pro | Gemini 2.5 Pro |

|---|---|---|

| 推理能力 | 最强 | 强 |

| 上下文长度 | 200K+ | 1M |

| 多模态能力 | 增强 | 标准 |

| 免费层配额 | 较严格 | 100 RPD |

| 定价 | $2-12/M | $1.25-5/M |

如果你的任务不需要最新能力,Gemini 2.5 Pro 的性价比更高。

Q5: 2026 年配额还会继续调整吗?

根据 Google 的公告,2026 年 3 月 3 日 Gemini 2.0 Flash 和 Flash-Lite 模型将停用。建议:

- 尽早迁移到 Gemini 2.5 系列

- 关注 Google AI 开发者论坛的最新动态

- 考虑使用 API易 apiyi.com 等支持多模型的平台,便于快速切换

Gemini 3 Pro 速率限制解决方案对比

| 方案 | 成本 | 实施难度 | 效果 | 推荐场景 |

|---|---|---|---|---|

| 切换模型 | 免费 | ⭐ | 中等 | 任务要求不高 |

| 等待重置 | 免费 | ⭐ | 有限 | 偶尔使用 |

| 升级付费层 | 较高 | ⭐⭐ | 好 | 企业用户 |

| API 中转平台 | 灵活 | ⭐⭐ | 很好 | 个人/中小团队 |

| 优化请求策略 | 免费 | ⭐⭐⭐ | 中等 | 技术用户 |

💡 选择建议: 对于个人学习用户,我们建议优先尝试切换模型或使用 API 中转平台。API易 apiyi.com 提供灵活的计费方式,支持按需付费,无需担心配额限制,是解决速率限制的高效方案。

总结

AI Studio 的 "You've reached your rate limit" 错误源于 Google 在 2025 年 12 月对免费层配额的大幅削减。本文介绍的 5 种解决方案各有优劣:

- 切换模型 – 最简单,适合临时需求

- 等待重置 – 无成本,但效率低

- 升级付费 – 效果好,但成本高

- API 中转 – 性价比高,推荐个人用户

- 优化策略 – 需要技术能力

对于大多数个人学习用户,推荐通过 API易 apiyi.com 快速解决速率限制问题。该平台支持 Gemini 3 Pro、GPT-4、Claude 3.5 等主流模型的统一调用,提供稳定的国内访问和灵活的付费方式。

参考资料

-

Google AI – Rate Limits 官方文档

- 链接:

ai.google.dev/gemini-api/docs/rate-limits - 说明: Gemini API 速率限制官方说明

- 链接:

-

Google AI Developers Forum – Rate Limit 讨论

- 链接:

discuss.ai.google.dev/t/youve-reached-your-rate-limit/35201 - 说明: 社区用户关于速率限制的讨论

- 链接:

-

Gemini API Pricing 官方定价

- 链接:

ai.google.dev/gemini-api/docs/pricing - 说明: 各模型的定价和配额信息

- 链接:

📝 作者: APIYI Team

🔗 技术支持: API易 apiyi.com – 一站式 AI 大模型 API 中转平台

📅 更新日期: 2026-01-24