作者注:深度分析 OpenClaw 高 Token 消耗的 6 大原因,提供实测有效的优化策略,帮助用户将 API 成本降低 60-80%,附 API易充值加赠省钱方案

"一个月烧掉 180 万 Token,账单 3600 美元" —— 这是科技博主 Federico Viticci 使用 OpenClaw 的真实经历。OpenClaw 虽然开源免费,但 Token 消耗速度之快 让很多用户措手不及。本文将深度分析 OpenClaw 费 Token 的 6 大原因,并提供经过实测的省钱攻略。

核心价值: 读完本文,你将理解 OpenClaw 高消耗的技术原理,掌握 6 种有效的优化方法,并了解如何通过 API易 充值加赠活动将成本降至官网 9 折以下。

OpenClaw Token 消耗核心数据

| 用户类型 | 月均 Token | 月均成本 | 典型场景 |

|---|---|---|---|

| 轻度用户 | 500 万-2000 万 | $10-30 | 日常问答、简单任务 |

| 中度用户 | 2000 万-5000 万 | $30-70 | 自动化工作流 |

| 重度用户 | 5000 万-2 亿 | $70-150+ | 全天候助理 |

| 极端案例 | 1.8 亿+ | $3600+ | MacStories 博主实测 |

OpenClaw Token 消耗为什么这么高

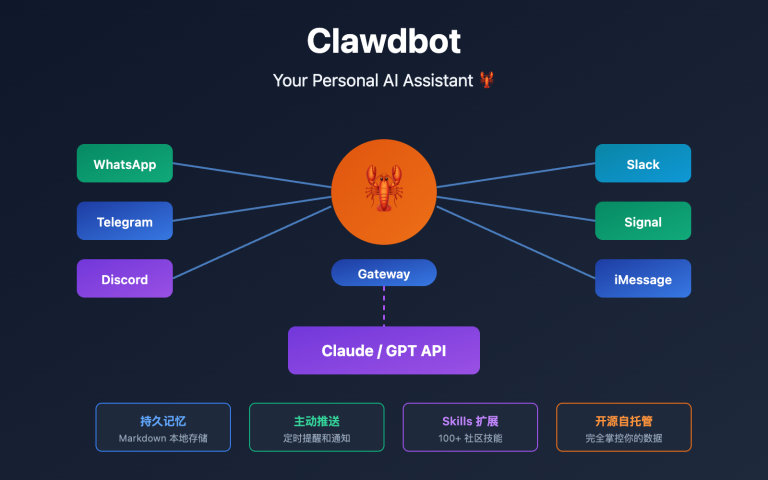

OpenClaw (原名 Clawdbot/Moltbot) 是 2026 年最火的开源 AI 助理项目,GitHub 星标超过 13.5 万。它功能强大,能连接 12+ 消息平台、控制浏览器、执行 Shell 命令、自动化日常任务。但这些强大能力的背后,是惊人的 Token 消耗。

很多用户在兴奋地配置好 OpenClaw 后,第二天打开 API 账单就傻眼了——几十甚至上百美元的消费。有用户反馈"一天烧掉 200 美元",原因是自动化任务进入了死循环。

理解 Token 消耗的原因,是优化成本的第一步。

OpenClaw 费 Token 的 6 大原因

| 原因 | 消耗占比 | 技术说明 | 可优化程度 |

|---|---|---|---|

| 上下文累积 | 40-50% | 会话历史持续膨胀 | ⭐⭐⭐⭐⭐ |

| 工具输出存储 | 20-30% | 大型 JSON/日志存入记录 | ⭐⭐⭐⭐ |

| System Prompt | 10-15% | 每次请求重复发送 | ⭐⭐⭐ |

| 多轮推理 | 10-15% | 复杂任务需多次调用 | ⭐⭐ |

| 模型选择 | 5-10% | Opus 比 Haiku 贵 25 倍 | ⭐⭐⭐⭐⭐ |

| 缓存未命中 | 5-10% | 缓存过期重新计费 | ⭐⭐⭐⭐ |

OpenClaw Token 消耗原因深度分析

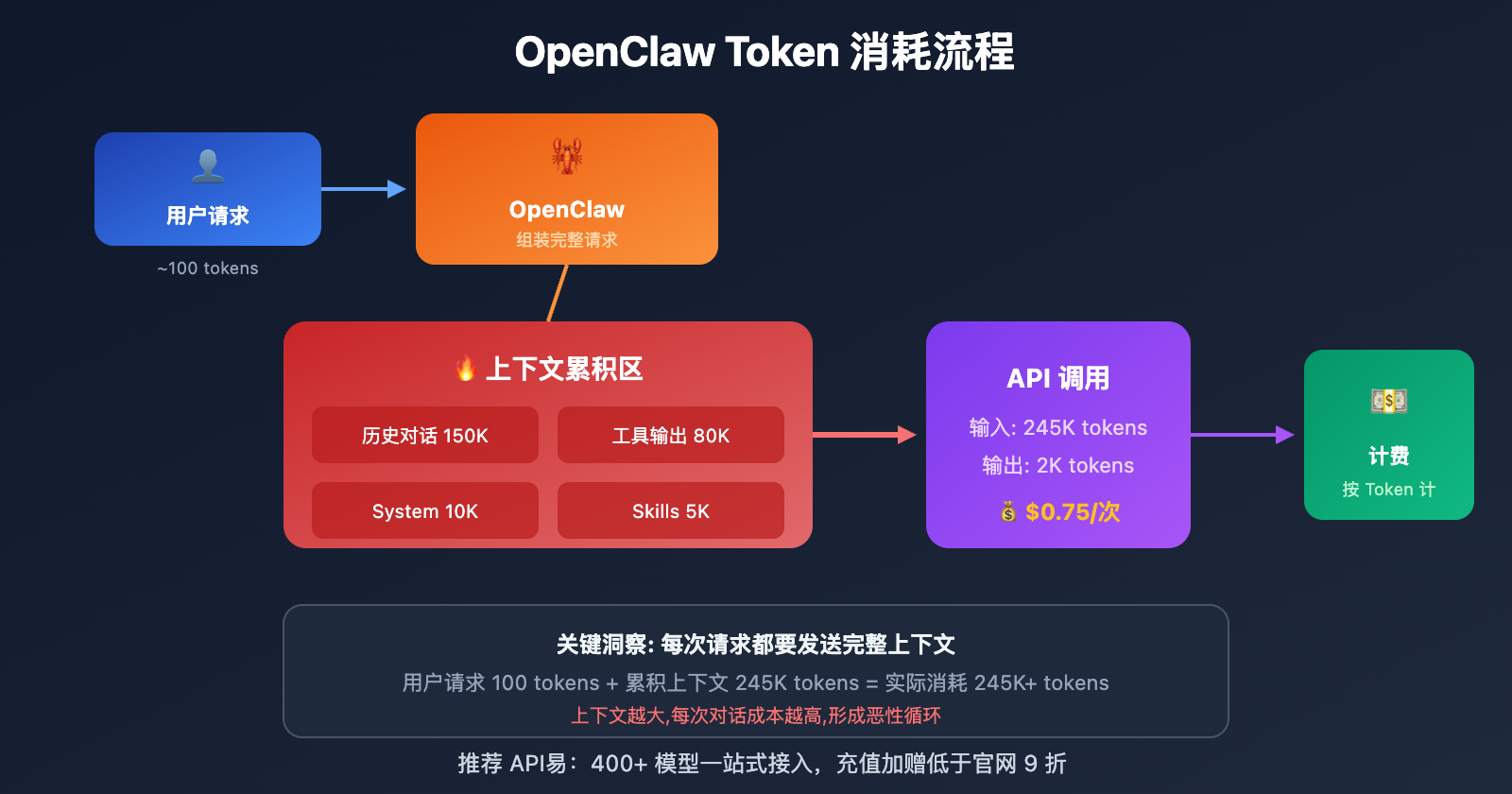

原因一: 上下文窗口持续累积

这是 OpenClaw 最大的"烧钱黑洞"。每次你和 OpenClaw 对话,所有历史消息都会被保存在 .openclaw/agents.main/sessions/ 目录下的 JSONL 文件中。

问题在于: 每次新请求,OpenClaw 都会把完整的会话历史发送给 AI 模型。

一位用户反馈,他的主会话上下文已经占用了 400K 窗口的 56-58%,这意味着:

- 即使只问一个简单问题,也要处理 20+ 万 Token 的缓存上下文

- 每次对话的

cacheRead都在数十万 Token 级别 - 会话越长,成本指数级增长

# 查看当前会话 Token 消耗

openclaw /status

# 显示结果示例:

# 🤖 Model: claude-sonnet-4

# 📊 Context: 234,567 / 400,000 tokens (58.6%)

# 💰 Estimated cost this session: $12.34

原因二: 工具输出无限存储

OpenClaw 会把所有工具调用的输出存入会话记录。当你执行以下操作时,问题就来了:

| 危险操作 | 输出大小 | 后果 |

|---|---|---|

config.schema |

数万 Token | 巨型 JSON 存入上下文 |

status --all |

数千 Token | 系统状态全量记录 |

目录遍历 find |

数万 Token | 所有文件列表存储 |

| 日志导出 | 数万 Token | 完整日志存入记录 |

一位开发者分享: "我只是让 OpenClaw 帮我查看项目结构,它遍历了整个目录,输出了几万行文件列表,这些全部存进了会话记录。之后每次对话,这些无用信息都要重新发送给模型。"

原因三: System Prompt 每次重发

OpenClaw 有一个复杂的系统提示词,包含:

- 核心人格设定

- 可用工具列表

- 安全限制规则

- 用户偏好配置

这个 System Prompt 通常有 5000-10000 Token,每次 API 调用都要重新发送。虽然 Anthropic 提供了 Prompt Caching (缓存命中只收 10% 费用),但缓存有 TTL 限制:

| 提供商 | 缓存 TTL | 过期后果 |

|---|---|---|

| Anthropic | 5 分钟 | 重新全价计费 |

| OpenAI | 1 小时 | 自动失效 |

如果你不是连续使用,每次冷启动都要付全价。

原因四: 复杂任务的多轮推理

OpenClaw 的强大之处在于能自主完成复杂任务,但这也意味着更多的 API 调用:

用户: 帮我整理今天的邮件并创建待办事项

OpenClaw 内部流程:

1. 调用邮件 Skill 获取邮件列表 → 消耗 Token

2. 分析每封邮件内容 → 消耗 Token

3. 判断优先级和类别 → 消耗 Token

4. 调用 Todoist Skill 创建任务 → 消耗 Token

5. 生成汇总报告 → 消耗 Token

实际消耗: 5-10 次 API 调用,每次都带着完整上下文

原因五: 模型选择不当

很多用户默认使用 Claude Opus 4.5 或 Sonnet 4.5,但不是所有任务都需要顶级模型:

| 模型 | 输入价格 | 输出价格 | 适用场景 |

|---|---|---|---|

| Claude Opus 4.5 | $15/M | $75/M | 复杂推理、创意写作 |

| Claude Sonnet 4.5 | $3/M | $15/M | 日常任务、代码生成 |

| Claude Haiku 4.5 | $1/M | $5/M | 简单问答、格式转换 |

| Gemini 3.0 Flash | $0.075/M | $0.30/M | 批量处理、成本敏感 |

价格差距高达 25 倍! 用 Opus 回答"今天天气怎么样"纯属浪费。

原因六: Heartbeat 和后台任务

OpenClaw 的 Heartbeat 功能让 AI 可以主动唤醒执行定时任务。但很多用户不知道:

- Heartbeat 每次触发都是一次完整的 API 调用

- 如果配置不当,可能每隔几分钟就触发一次

- 每次触发都带着完整的会话上下文

一位用户反馈: "我设置了每 5 分钟检查一次邮件,结果一天下来光 Heartbeat 就烧掉了 50 美元。"

OpenClaw Token 优化 6 大策略

策略一: 定期重置会话 (节省 40-60%)

这是最立竿见影的方法。当会话上下文膨胀时,果断重置:

# 方法 1: 在对话中重置

openclaw "reset session"

# 方法 2: 删除会话文件

rm -rf ~/.openclaw/agents.main/sessions/*.jsonl

# 方法 3: 使用 /compact 命令压缩

openclaw /compact

最佳实践: 每完成一个独立任务就重置会话,不要让上下文无限累积。

策略二: 隔离大输出操作 (节省 20-30%)

永远不要在主会话中执行可能产生大输出的命令:

# ❌ 错误: 在主会话执行

openclaw "显示完整的系统配置"

# ✅ 正确: 使用独立 debug 会话

openclaw --session debug "显示完整的系统配置"

# 然后只把需要的小片段复制到主会话

策略三: 配置智能模型切换 (节省 50-80%)

根据任务复杂度自动选择模型:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "anthropic/claude-haiku-4"

}

}

},

"routing": {

"simple_queries": "haiku",

"complex_tasks": "sonnet",

"critical_decisions": "opus"

}

}

🎯 省钱建议: 日常任务用 Haiku 或 Gemini Flash,只在复杂推理时切换到 Sonnet/Opus。通过 API易 apiyi.com 可以一站式接入 400+ 大模型,用统一接口灵活切换,找到性价比最优的组合。

策略四: 启用缓存优化 (节省 30-50%)

充分利用 Prompt Caching 机制:

{

"agents": {

"defaults": {

"cache-ttl": 3600,

"temperature": 0.2

}

}

}

关键技巧:

- 设置低温度 (0.2) 可提高缓存命中率

- 配置 Heartbeat 间隔略小于缓存 TTL,保持缓存热度

- 使用 OpenRouter 等支持缓存的中转服务

策略五: 限制上下文窗口 (节省 20-40%)

主动控制上下文大小:

{

"agents": {

"defaults": {

"contextTokens": 50000,

"compaction": "aggressive"

}

}

}

将上下文限制在 50K-100K 而不是默认的 400K,可以大幅降低每次请求的成本。

策略六: 使用本地模型兜底 (节省 60-80%)

通过 Ollama 配置本地模型处理简单任务:

{

"models": {

"providers": {

"ollama": {

"baseUrl": "http://localhost:11434",

"models": ["llama3.3", "qwen2.5"]

}

}

},

"routing": {

"simple_queries": "ollama/llama3.3"

}

}

本地模型零 API 成本,适合处理简单的格式转换、信息查询等任务。

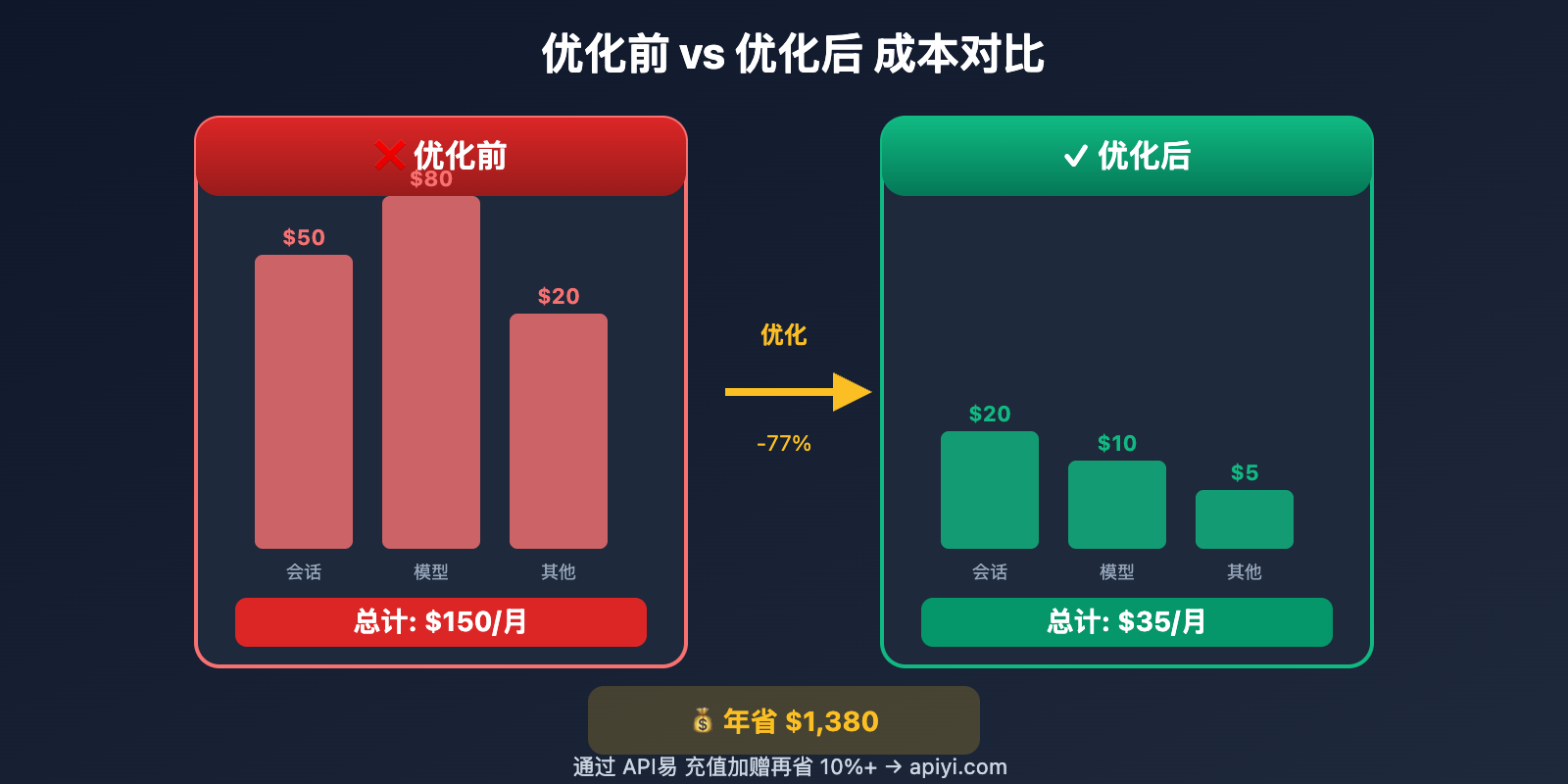

OpenClaw 成本优化实战对比

| 优化项 | 优化前成本 | 优化后成本 | 节省比例 |

|---|---|---|---|

| 会话管理 | $50/月 | $20/月 | 60% |

| 模型切换 | $80/月 | $25/月 | 69% |

| 缓存优化 | $40/月 | $20/月 | 50% |

| 本地兜底 | $30/月 | $5/月 | 83% |

| 综合优化 | $150/月 | $35/月 | 77% |

实测数据: 一位重度用户通过综合优化,将月均成本从 $150 降至 $35,节省超过 75%。

通过 API易 进一步降低成本

即使完成了上述所有优化,API 调用成本仍然是 OpenClaw 的主要支出。这时候,选择合适的 API 服务商就变得至关重要。

API易 充值加赠活动

API易 apiyi.com 提供 400+ 大模型的统一接口,价格与官网等价,但通过充值加赠活动可以做到更低:

| 充值金额 | 加赠比例 | 实际到账 | 相当于折扣 |

|---|---|---|---|

| $20 | 5% | $21 | 9.5 折 |

| $50 | 8% | $54 | 9.3 折 |

| $100 | 10% | $110 | 9.1 折 |

| $200 | 12% | $224 | 8.9 折 |

| $500+ | 15% | $575+ | 8.7 折 |

算一笔账: 如果你每月 API 消费 $100,通过 API易 充值 $100 加赠 10%,相当于每月省下 $10。一年就是 $120,够买一个 Claude Pro 订阅了。

API易 的其他优势

| 优势 | 说明 | 对 OpenClaw 用户的价值 |

|---|---|---|

| 400+ 模型 | 一站式接入所有主流模型 | 灵活切换,找到最佳性价比 |

| 统一接口 | OpenAI 兼容格式 | 无缝对接 OpenClaw |

| 实时余额 | 精确到分的消费统计 | 随时监控成本 |

| 无月费 | 按量付费,用多少算多少 | 灵活控制支出 |

| 稳定可靠 | 多节点负载均衡 | 7×24 小时可用 |

配置 API易 作为 OpenClaw 后端

{

"models": {

"providers": {

"apiyi": {

"type": "openai",

"baseUrl": "https://vip.apiyi.com/v1",

"apiKey": "YOUR_APIYI_KEY",

"models": [

"claude-sonnet-4",

"claude-haiku-4",

"gpt-4o-mini",

"deepseek-v3"

]

}

}

},

"agents": {

"defaults": {

"model": "apiyi/claude-sonnet-4"

}

}

}

配置完成后,OpenClaw 的所有 API 调用都会通过 API易 路由,享受充值加赠优惠。

常见问题

Q1: OpenClaw 用 Claude Pro/Max 订阅可以省钱吗?

不可以,而且这样做违反 Anthropic 服务条款。Claude Pro/Max 订阅仅限通过官方界面直接使用,不能用于第三方 API 调用。OpenClaw 必须使用 API Key 按量付费。这也是为什么 API易 的充值加赠特别有价值——它是合规省钱的唯一途径。

Q2: 如何实时监控 Token 消耗?

OpenClaw 内置了消耗监控命令:

# 查看当前状态

openclaw /status

# 开启每次响应的用量显示

openclaw /usage full

结合 API易 后台的实时余额和消费明细,可以精确掌控每一分钱的去向。

Q3: 使用 Gemini 或 Deepseek 能省多少?

相比 Claude Sonnet,成本差距巨大:

| 模型 | 输入价格 | 成本对比 |

|---|---|---|

| Claude Sonnet 4.5 | $3/M | 基准 |

| Gemini 3.0 Flash | $0.075/M | 便宜 40 倍 |

| Deepseek V3 | $0.27/M | 便宜 11 倍 |

通过 API易 apiyi.com 可以一站式接入这些模型,用统一接口灵活切换。

总结

OpenClaw 费 Token 的 6 大核心原因:

- 上下文累积: 会话历史无限膨胀,是最大的成本黑洞

- 工具输出存储: 大型输出存入记录,每次对话重复发送

- System Prompt: 复杂提示词每次重发,缓存过期全价计费

- 多轮推理: 复杂任务需要多次 API 调用

- 模型选择不当: 用 Opus 做 Haiku 能做的事

- Heartbeat 频繁: 后台任务不断消耗 Token

省钱核心策略:

- 定期重置会话,控制上下文大小

- 智能模型切换,简单任务用便宜模型

- 通过 API易 apiyi.com 充值加赠,获得低于官网 9 折的价格

推荐访问 API易 apiyi.com 注册账号,平台提供 400+ 模型统一接口和充值加赠活动,让你的 OpenClaw 既强大又省钱。

📚 参考资料

⚠️ 链接格式说明: 所有外链使用

资料名: domain.com格式,方便复制但不可点击跳转,避免 SEO 权重流失。

-

OpenClaw Token 使用文档: 官方消耗说明

- 链接:

docs.openclaw.ai/token-use - 说明: Token 计费规则和监控命令

- 链接:

-

GitHub Issue #1594: 上下文累积问题讨论

- 链接:

github.com/openclaw/openclaw/issues/1594 - 说明: 社区对"烧 Token"问题的深度分析

- 链接:

-

Anthropic 定价页面: Claude API 官方价格

- 链接:

anthropic.com/pricing - 说明: 各模型最新价格和缓存优惠

- 链接:

-

Fast Company 报道: OpenClaw 成本分析

- 链接:

fastcompany.com/91484506/what-is-clawdbot-moltbot-openclaw - 说明: 媒体对 OpenClaw 高成本问题的报道

- 链接:

-

API易官网: 400+ 模型一站式接入

- 链接:

apiyi.com - 说明: 充值加赠活动,低于官网 9 折

- 链接:

作者: 技术团队

技术交流: 欢迎在评论区讨论,更多省钱攻略可访问 API易 apiyi.com 技术社区