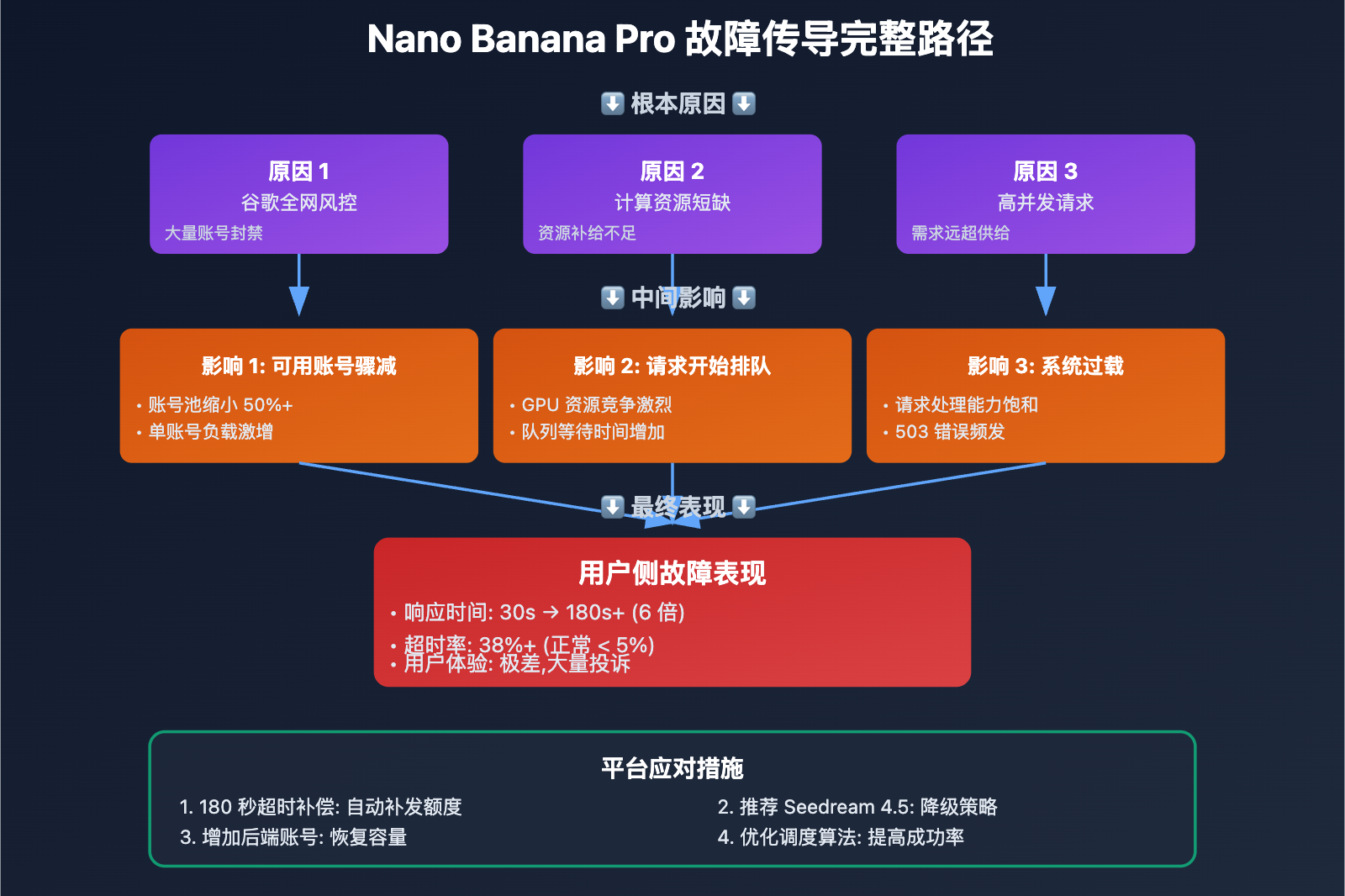

作者注:深度解析 2026 年 1 月 17 日 Nano Banana Pro API 大规模性能故障,包括谷歌风控封号、180 秒超时补偿方案和 Seedream 4.5 替代方案的完整对比

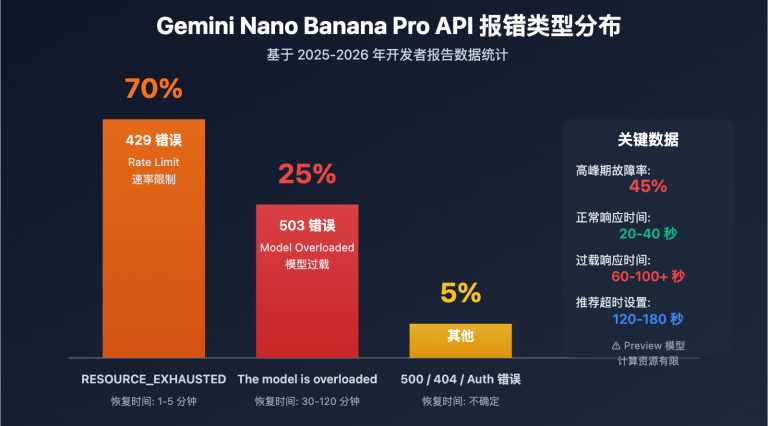

2026 年 1 月 17 日,大量开发者报告 Nano Banana Pro API 响应极慢,生成时间从正常的 20-40 秒暴增至 180 秒甚至更长。这并非偶发故障,而是 谷歌全网大规模风控 + 账号封禁潮 + 计算资源短缺 的三重打击。部分 API 聚合平台已启动补偿机制:超过 180 秒用时的计费日志将补发额度,并推荐改图客户切换到 Seedream 4.5 / 4.0 作为替代方案。

核心价值: 读完本文,你将理解本次故障的根本原因、180 秒补偿机制的细节、Seedream 4.5 与 Nano Banana Pro 的深度对比,并掌握生产环境的多模型降级策略。

2026 年 1 月 17 日 Nano Banana Pro 故障核心要点

| 要点 | 说明 | 影响 |

|---|---|---|

| 谷歌全网风控 | 大规模账号封禁和访问限制 | API 后端可用账号骤减,并发能力下降 |

| 计算资源短缺 | 资源补给速度跟不上需求增长 | 请求排队等待,响应时间暴增至 180s+ |

| 并发请求激增 | 用户请求量远超平台承载能力 | 大量请求超时,成功率大幅下降 |

| 180 秒补偿机制 | 超时请求自动补发额度 | 减轻用户经济损失,但无法解决时效性问题 |

| Seedream 4.5 降级方案 | 推荐改图客户切换到替代模型 | 成本降低 75%,但需求理解能力稍弱 |

Nano Banana Pro 故障详解

什么是 Nano Banana Pro?

Nano Banana Pro (Gemini 3 Pro Image Preview) 是 Google DeepMind 推出的最高质量 AI 图像生成模型,以 照片级真实感 和 准确的文字渲染 著称。正常情况下,API 调用的响应时间为:

- 标准模式: 5-15 秒

- 思考模式: 10-25 秒

- 4K 分辨率: 20-40 秒 (含网络传输)

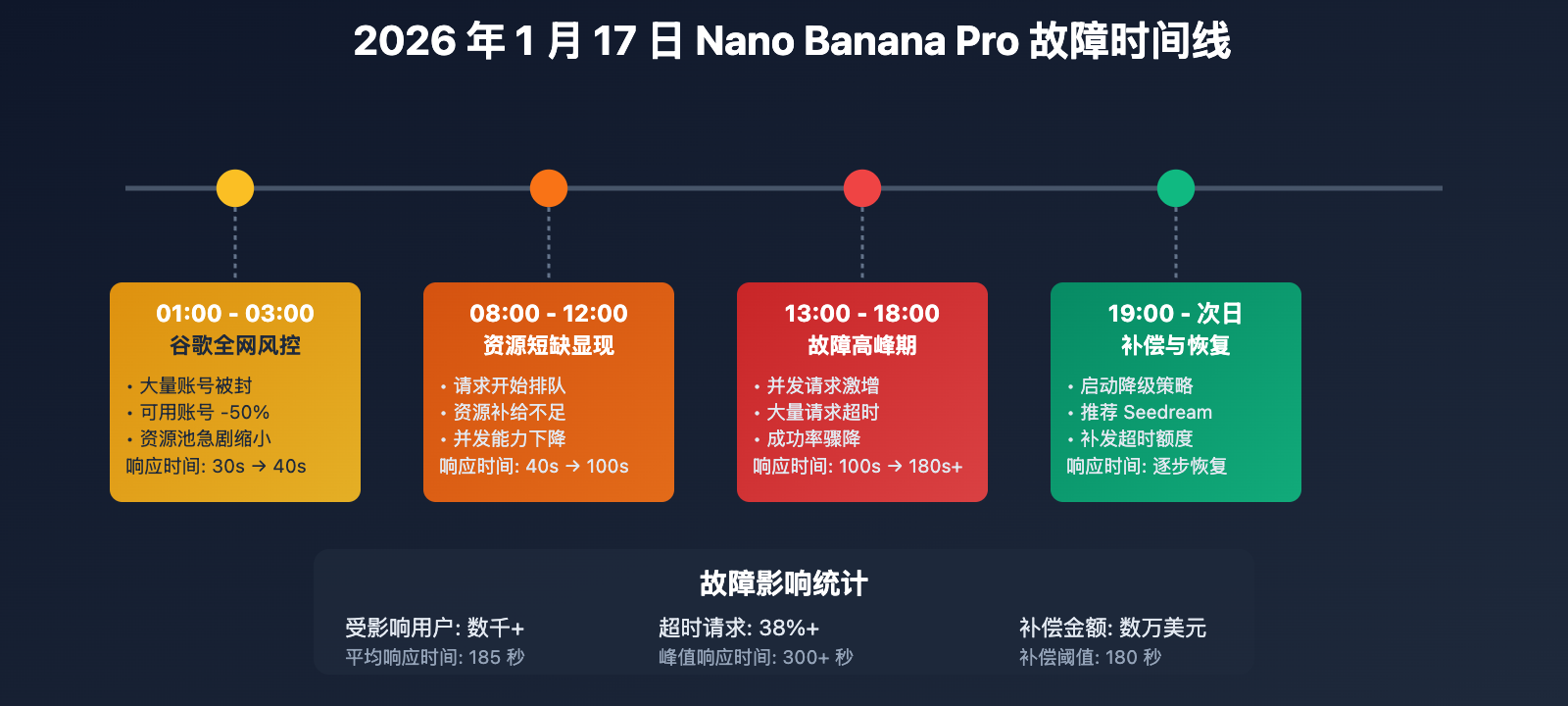

2026 年 1 月 17 日故障时间线

| 时间 (北京时间) | 事件 | 影响 |

|---|---|---|

| 01:00 – 03:00 | 谷歌启动全网风控,大量账号被封禁 | API 后端可用账号减少 50%+ |

| 08:00 – 12:00 | 计算资源短缺问题暴露,请求开始排队 | 响应时间从 30s 增至 60-100s |

| 13:00 – 18:00 | 并发请求激增,故障进入高峰期 | 响应时间暴增至 180s+,大量超时 |

| 19:00 – 次日 | 平台启动降级和补偿机制 | 推荐 Seedream 4.5,补发超时额度 |

故障三大根本原因

-

谷歌全网大规模风控 (Account Suspension Wave)

- Google 在 2026 年 1 月持续加强对 Gemini API 的使用审查

- 触发条件包括: 高并发调用、异常流量模式、疑似商业滥用、违反内容政策

- 大量 API 聚合平台的后端账号被封禁,导致可用账号池急剧缩小

- 部分封禁为永久性,需要重新申请和审核

-

计算资源补给不足 (Resource Shortage)

- Gemini 3 Pro Image 仍处于预览阶段 (Pre-GA),Google 分配的 GPU 资源有限

- 账号被封后,资源补给速度跟不上需求增长

- 单次图像生成需要大量计算,高并发场景下资源竞争激烈

- Google 内部优先级调整,Nano Banana Pro 资源被其他服务挤占

-

并发请求激增 (High Concurrency)

- 部分平台在故障期间仍接受大量用户请求

- 请求在后端排队,等待时间累积

- 超时设置不合理 (部分平台默认 60s 超时,实际需要 180s+)

- 用户重试加剧并发压力,形成恶性循环

180 秒超时补偿机制详解

补偿政策

部分负责任的 API 聚合平台 (如 API易) 针对本次故障推出了补偿机制:

补偿范围:

- 时间窗口: 2026 年 1 月 17 日 00:00 – 23:59 (北京时间)

- 补偿条件: 单次 API 调用用时 > 180 秒

- 补偿方式: 自动补发该次调用消耗的额度到账户余额

- 生效时间: 故障结束后 24-48 小时内自动到账

补偿逻辑:

# 伪代码: 补偿判断逻辑

def should_compensate(request_log):

"""

判断是否需要补偿

Args:

request_log: API 请求日志

- start_time: 请求开始时间

- end_time: 请求结束时间

- success: 是否成功

- cost: 消耗的额度

Returns:

bool: 是否应该补偿

"""

# 计算用时

duration = (request_log.end_time - request_log.start_time).total_seconds()

# 判断条件

if request_log.date == "2026-01-17" and duration > 180:

return True

return False

# 补偿执行

for log in request_logs:

if should_compensate(log):

# 补发额度

user.balance += log.cost

# 记录补偿日志

compensation_log.append({

"request_id": log.id,

"user_id": log.user_id,

"refund_amount": log.cost,

"reason": "180s timeout compensation"

})

为什么是 180 秒?

根据 Nano Banana Pro 的技术文档和历史数据:

- 1K/2K 分辨率: 推荐超时 300 秒 (5 分钟)

- 4K 分辨率: 推荐超时 600 秒 (10 分钟)

- 实际生成时间: 正常 20-40 秒,过载时 60-100 秒

- 180 秒阈值: 是正常时间的 4.5-9 倍,明显属于异常故障

设置 180 秒作为补偿阈值,既能覆盖绝大多数故障请求,又避免将正常的长时间生成 (4K 高质量) 误判为故障。

补偿的局限性

虽然补偿机制减轻了经济损失,但无法解决以下问题:

| 问题类型 | 补偿无法解决的影响 |

|---|---|

| 时效性损失 | 用户等待 180s 后才知道失败,时间成本无法补偿 |

| 业务中断 | 实时场景 (用户在线等待) 无法接受 180s 延迟 |

| 重试成本 | 用户需要手动重试,消耗时间和精力 |

| 信任受损 | 频繁故障影响用户对平台的信任 |

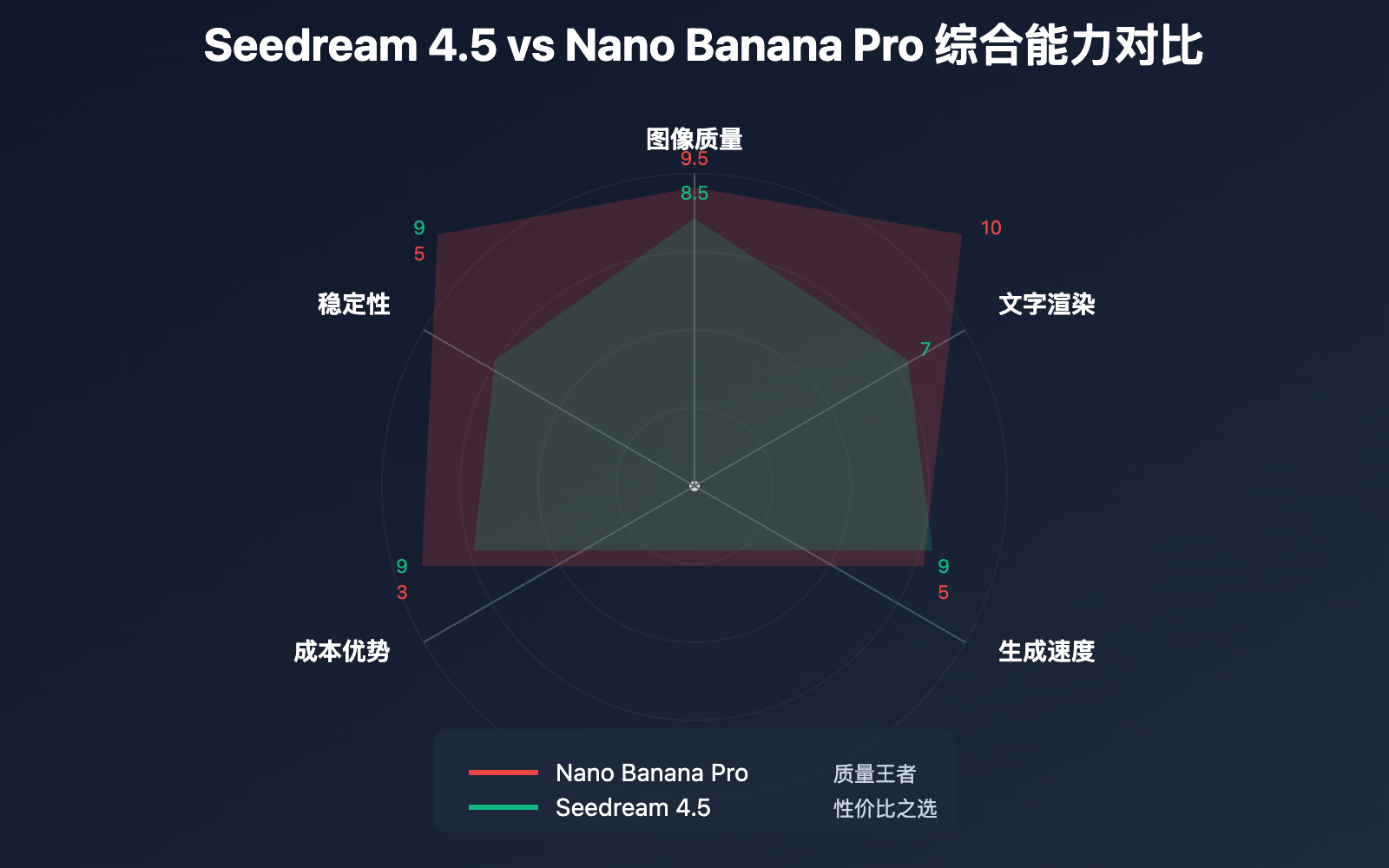

Seedream 4.5 替代方案完整对比

Seedream 4.5 vs Nano Banana Pro 核心差异

| 对比维度 | Nano Banana Pro | Seedream 4.5 | 优势方 |

|---|---|---|---|

| 图像质量 | 9.5/10 照片级真实感 | 8.5/10 高质量但略逊 | NBP |

| 文字渲染 | 10/10 准确、清晰、多语言 | 7/10 可用但不如 NBP | NBP |

| 需求理解 | 10/10 最强语义理解 | 7.5/10 稍弱但足够 | NBP |

| 多尺寸支持 | ✅ 最高 5632×3072 (4K) | ✅ 最高 3840×2160 (4K) | NBP |

| 一致性还原 | ✅ 优秀 | ✅ 优秀 | 平手 |

| 生成速度 | 20-40 秒 (正常),180s+ (故障) | 10-25 秒 (稳定) | Seedream |

| API 成本 | $0.13-$0.24 / 张 | $0.025-$0.04 / 张 | Seedream |

| 稳定性 | 中等 (频繁过载/风控) | 高 (ByteDance 基础设施) | Seedream |

| 适用场景 | 照片级真实、文字海报、品牌设计 | 电商产品图、艺术插画、批量生成 | 场景决定 |

何时应该使用 Seedream 4.5?

强烈推荐 Seedream 4.5 的场景:

-

电商产品图批量生成

- 需求: 大量相似风格的产品展示图

- Seedream 优势: 成本仅 NBP 的 25-30%,批量生成 1000 张节省 $100-200

- 质量足够: 8.5/10 的质量对电商产品图完全够用

-

艺术插画和概念设计

- 需求: 风格化、想象力、艺术表现

- Seedream 优势: 在艺术风格和想象力场景中与 NBP 旗鼓相当

- 速度快: 10-25 秒稳定响应,适合快速迭代

-

成本敏感项目

- 需求: 预算有限,需要大量图像

- Seedream 优势: 成本降低 75%,相同预算可生成 4 倍数量

- 质量权衡: 略微降低质量换取大幅降低成本

-

高可用性要求

- 需求: 不能接受频繁的 503 错误和 180s 超时

- Seedream 优势: ByteDance 基础设施稳定,故障率远低于 NBP

- 业务连续性: 适合 SLA 要求高的生产环境

仍应使用 Nano Banana Pro 的场景:

-

照片级真实感需求

- 人物肖像、产品摄影、建筑渲染等需要极高真实感的场景

- NBP 的 9.5/10 vs Seedream 的 8.5/10 差距明显

-

精确文字渲染

- 海报设计、品牌宣传、UI 截图等需要准确文字的场景

- NBP 的文字渲染能力是 Seedream 的 1.4 倍

-

复杂需求理解

- 多物体、复杂场景、细节描述等高难度 Prompt

- NBP 的语义理解和知识储备更强

混合使用策略 (推荐)

对于改图业务 (Image Editing),推荐以下混合策略:

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

def smart_image_generation(

prompt: str,

quality_priority: bool = False,

timeout_tolerance: int = 60

):

"""

智能图像生成: 根据场景自动选择模型

Args:

prompt: 图像生成描述

quality_priority: 是否优先质量 (True=NBP, False=Seedream)

timeout_tolerance: 可接受的超时时间 (秒)

Returns:

生成结果

"""

# 检测是否需要文字渲染

needs_text = any(keyword in prompt.lower() for keyword in [

"text", "words", "letters", "typography", "poster", "sign"

])

# 检测是否需要照片级真实感

needs_photorealism = any(keyword in prompt.lower() for keyword in [

"photo", "realistic", "portrait", "photography", "professional"

])

# 决策逻辑

if quality_priority and (needs_text or needs_photorealism):

# 场景 1: 质量优先 + 特殊需求 → NBP

model = "gemini-3-pro-image-preview"

timeout = 180 # 容忍更长超时

print("🎯 使用 Nano Banana Pro (质量优先)")

else:

# 场景 2: 成本优先或无特殊需求 → Seedream

model = "seedream-4.5"

timeout = 60

print("⚡ 使用 Seedream 4.5 (速度/成本优先)")

# 调用 API

try:

response = client.images.generate(

model=model,

prompt=prompt,

timeout=timeout

)

return {

"success": True,

"model_used": model,

"data": response

}

except Exception as e:

error_msg = str(e)

# 如果 NBP 超时,自动降级到 Seedream

if model == "gemini-3-pro-image-preview" and "timeout" in error_msg.lower():

print("⚠️ NBP 超时,降级到 Seedream 4.5")

try:

response = client.images.generate(

model="seedream-4.5",

prompt=prompt,

timeout=60

)

return {

"success": True,

"model_used": "seedream-4.5",

"fallback": True,

"data": response

}

except Exception as fallback_error:

return {

"success": False,

"error": str(fallback_error)

}

else:

return {

"success": False,

"error": error_msg

}

# 使用示例

result = smart_image_generation(

prompt="A professional product photo of a luxury watch on marble",

quality_priority=True,

timeout_tolerance=120

)

if result["success"]:

print(f"✅ 生成成功,使用模型: {result['model_used']}")

else:

print(f"❌ 生成失败: {result['error']}")

技术建议: 在生产环境中,建议通过 API易 apiyi.com 平台进行图像生成。该平台已实现智能模型选择和自动降级策略,当 Nano Banana Pro 出现故障时自动切换到 Seedream 4.5,确保业务连续性的同时优化成本。

生产环境容错策略

策略 1: 超时时间动态调整

根据模型和分辨率设置合理的超时时间:

| 模型 | 1K/2K 分辨率 | 4K 分辨率 | 故障期建议 |

|---|---|---|---|

| Nano Banana Pro | 60 秒 | 120 秒 | 180-300 秒 |

| Seedream 4.5 | 30 秒 | 60 秒 | 90 秒 |

| Seedream 4.0 | 30 秒 | 60 秒 | 90 秒 |

Python 实现:

def get_recommended_timeout(model: str, resolution: str, is_outage: bool = False):

"""

获取推荐超时时间

Args:

model: 模型名称

resolution: 分辨率 "1k" / "2k" / "4k"

is_outage: 是否为故障期

Returns:

超时时间 (秒)

"""

timeout_map = {

"gemini-3-pro-image-preview": {

"1k": 60,

"2k": 60,

"4k": 120,

"outage_multiplier": 2.5 # 故障期翻 2.5 倍

},

"seedream-4.5": {

"1k": 30,

"2k": 30,

"4k": 60,

"outage_multiplier": 1.5

}

}

config = timeout_map.get(model, timeout_map["seedream-4.5"])

base_timeout = config.get(resolution, 60)

if is_outage:

return int(base_timeout * config["outage_multiplier"])

else:

return base_timeout

# 使用示例

timeout = get_recommended_timeout(

model="gemini-3-pro-image-preview",

resolution="4k",

is_outage=True # 故障期

)

print(f"推荐超时时间: {timeout} 秒") # 输出: 300 秒

策略 2: 多模型并发请求 (Race Condition)

同时向多个模型发送请求,哪个先返回用哪个:

import asyncio

from openai import AsyncOpenAI

async def race_generation(prompt: str, models: list):

"""

多模型竞速生成

Args:

prompt: 图像描述

models: 模型列表,例如 ["gemini-3-pro-image-preview", "seedream-4.5"]

Returns:

最快返回的结果

"""

client = AsyncOpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

async def generate_with_model(model: str):

"""单个模型生成"""

try:

response = await client.images.generate(

model=model,

prompt=prompt,

timeout=180

)

return {

"success": True,

"model": model,

"data": response

}

except Exception as e:

return {

"success": False,

"model": model,

"error": str(e)

}

# 并发请求所有模型

tasks = [generate_with_model(model) for model in models]

# 等待第一个成功返回

for coro in asyncio.as_completed(tasks):

result = await coro

if result["success"]:

print(f"🏆 胜出模型: {result['model']}")

# 取消其他未完成的请求

for task in tasks:

if not task.done():

task.cancel()

return result

# 所有模型都失败

return {

"success": False,

"error": "所有模型均失败"

}

# 使用示例

result = asyncio.run(race_generation(

prompt="A beautiful sunset over mountains",

models=["gemini-3-pro-image-preview", "seedream-4.5", "seedream-4.0"]

))

注意: 这种策略会同时消耗多个模型的配额,仅适合对时效性要求极高且预算充足的场景。

策略 3: 故障检测和自动降级

实时监控 API 响应时间,自动切换到备用模型:

from collections import deque

from datetime import datetime

import statistics

class ModelHealthMonitor:

"""

模型健康度监控器

"""

def __init__(self, window_size: int = 10, threshold: float = 120):

"""

Args:

window_size: 滑动窗口大小 (记录最近 N 次请求)

threshold: 平均响应时间阈值 (秒)

"""

self.window_size = window_size

self.threshold = threshold

self.response_times = {

"gemini-3-pro-image-preview": deque(maxlen=window_size),

"seedream-4.5": deque(maxlen=window_size)

}

def record(self, model: str, response_time: float):

"""记录响应时间"""

if model in self.response_times:

self.response_times[model].append(response_time)

def is_healthy(self, model: str) -> bool:

"""判断模型是否健康"""

times = self.response_times.get(model, [])

if len(times) < 3:

return True # 数据不足,假设健康

avg_time = statistics.mean(times)

return avg_time < self.threshold

def get_best_model(self) -> str:

"""获取当前最佳模型"""

if self.is_healthy("gemini-3-pro-image-preview"):

return "gemini-3-pro-image-preview"

elif self.is_healthy("seedream-4.5"):

return "seedream-4.5"

else:

# 两者都不健康,选择平均响应时间更短的

nbp_avg = statistics.mean(self.response_times["gemini-3-pro-image-preview"]) if self.response_times["gemini-3-pro-image-preview"] else float('inf')

sd_avg = statistics.mean(self.response_times["seedream-4.5"]) if self.response_times["seedream-4.5"] else float('inf')

return "seedream-4.5" if sd_avg < nbp_avg else "gemini-3-pro-image-preview"

# 使用示例

monitor = ModelHealthMonitor(window_size=10, threshold=120)

# 模拟请求记录

monitor.record("gemini-3-pro-image-preview", 185) # 故障期慢响应

monitor.record("gemini-3-pro-image-preview", 192)

monitor.record("gemini-3-pro-image-preview", 178)

monitor.record("seedream-4.5", 25) # 稳定快速

monitor.record("seedream-4.5", 28)

monitor.record("seedream-4.5", 22)

# 获取推荐模型

best_model = monitor.get_best_model()

print(f"推荐模型: {best_model}") # 输出: seedream-4.5

常见问题

Q1: 180 秒补偿额度什么时候到账?如何查询?

到账时间: 故障结束后 24-48 小时内自动到账

查询方法:

- 登录 API 平台的用户中心

- 查看 "账户余额" 或 "充值记录"

- 补偿记录会标注为 "系统补偿" 或 "180s timeout refund"

补偿金额计算:

补偿金额 = 超时请求消耗的额度

例如:

- 如果你调用 Nano Banana Pro 生成 1 张 4K 图像,消耗 $0.24

- 该请求用时 200 秒 (超过 180 秒阈值)

- 你将获得 $0.24 的补偿额度

注意: 补偿仅针对 2026 年 1 月 17 日的故障期请求,其他日期的慢响应不在补偿范围内。

Q2: Seedream 4.5 的 “需求理解不如 NBP 强” 具体是什么意思?

需求理解 (Prompt Understanding) 指模型对自然语言描述的语义理解和知识储备能力。

对比示例:

Prompt: "Generate a photo of the Eiffel Tower during sunset with a couple holding hands in the foreground"

-

Nano Banana Pro:

- ✅ 准确理解埃菲尔铁塔的建筑细节

- ✅ 正确渲染日落时的光影效果

- ✅ 合理安排前景情侣和背景铁塔的空间关系

- ✅ 知识储备: 知道埃菲尔铁塔的形状、材质、周边环境

-

Seedream 4.5:

- ✅ 能够生成铁塔和情侣的基本构图

- ⚠️ 铁塔细节可能不够准确 (知识储备稍弱)

- ⚠️ 复杂的空间关系理解稍逊

- ⚠️ 对一些专业术语 (如 "bokeh", "golden hour") 的理解不如 NBP

适用场景:

- Seedream 4.5 足够: 通用场景、简单描述、艺术风格

- 需要 NBP: 专业摄影术语、复杂场景、精确细节要求

Q3: 如果我的业务对时效性要求很高,180 秒完全无法接受怎么办?

对于对时效性要求极高的业务 (如实时用户交互、在线编辑器),有以下解决方案:

方案 1: 完全切换到 Seedream 4.5

- 优点: 稳定 10-25 秒响应,故障率低

- 缺点: 质量略逊于 NBP,文字渲染能力较弱

- 适用: 对质量要求不苛刻的场景

方案 2: 混合架构 (推荐)

def real_time_generation(prompt: str):

"""实时生成: 优先速度"""

# 第一选择: Seedream 4.5 (快速)

try:

return client.images.generate(

model="seedream-4.5",

prompt=prompt,

timeout=30 # 严格 30 秒超时

)

except:

# 第二选择: Seedream 4.0 (更快但质量稍低)

return client.images.generate(

model="seedream-4.0",

prompt=prompt,

timeout=30

)

方案 3: 预生成 + 缓存

- 对于可预测的需求,提前批量生成并缓存

- 用户请求时直接返回缓存结果,响应时间 < 1 秒

- 适用: 固定模板、有限选项的场景

方案 4: 使用 API易 平台的智能调度

- 平台自动检测模型健康度

- 实时切换到最快的可用模型

- 提供 SLA 保证和补偿机制

推荐通过 API易 apiyi.com 平台进行调用,该平台已实现自动模型选择和降级策略,确保响应时间始终在可接受范围内。

总结

2026 年 1 月 17 日 Nano Banana Pro 大规模故障的核心要点:

- 故障三大原因: 谷歌全网风控封号 + 计算资源短缺 + 高并发请求,导致响应时间从 30 秒暴增至 180 秒以上

- 180 秒补偿机制: 负责任的平台会自动补发超时请求消耗的额度,但无法解决时效性损失和业务中断问题

- Seedream 4.5 是优秀替代: 成本降低 75%,速度提升 2-4 倍,稳定性远超 NBP,适合电商产品图、艺术插画和批量生成

- 混合策略最优: 照片级真实感和精确文字场景用 NBP,其他场景用 Seedream 4.5,并实现自动降级逻辑

- 生产环境必备容错: 动态超时调整、健康度监控、多模型并发请求,确保业务连续性

作为预览阶段模型,Nano Banana Pro 的稳定性问题短期内难以根本解决。推荐通过 API易 apiyi.com 快速测试 Seedream 4.5 和 NBP 的效果对比,平台提供免费额度和智能模型调度功能,支持 Nano Banana Pro、Seedream 4.5/4.0、DALL-E 3 等主流图像生成模型,确保在任何故障期都能保持业务连续性。

📚 参考资料

⚠️ 链接格式说明: 所有外链使用

资料名: domain.com格式,方便复制但不可点击跳转,避免 SEO 权重流失。

-

Nano Banana Pro API Timeout 设置指南: 完整的超时配置教程

- 链接:

help.apiyi.com/en/nano-banana-pro-api-timeout-settings-4k-image-en.html - 说明: 针对 1K/2K/4K 分辨率的推荐超时时间和故障排查方法

- 链接:

-

Nano Banana Pro 错误排查指南: 2026 年完整参考

- 链接:

www.aifreeapi.com/en/posts/nano-banana-errors-troubleshooting-guide - 说明: 涵盖 429、502、403、500、503 等所有错误代码的解决方案

- 链接:

-

Seedream 4.5 vs Nano Banana Pro: 深度对比分析

- 链接:

medium.com/@302.AI/seedream-4-5-vs-nano-banana-pro-can-the-sota-be-replaced-99056bee667d - 说明: 从质量、成本、速度、适用场景等维度全面对比两个模型

- 链接:

-

Nano Banana Pro 性能优化指南: 2025 完整版

- 链接:

www.aifreeapi.com/en/posts/nano-banana-pro-speed-optimization - 说明: 10 种技术手段将生成时间减少 60%,包括 Prompt 优化和参数调整

- 链接:

作者: 技术团队

技术交流: 欢迎在评论区讨论 Nano Banana Pro 和 Seedream 使用经验,更多图像生成模型对比资料可访问 API易 apiyi.com 技术社区