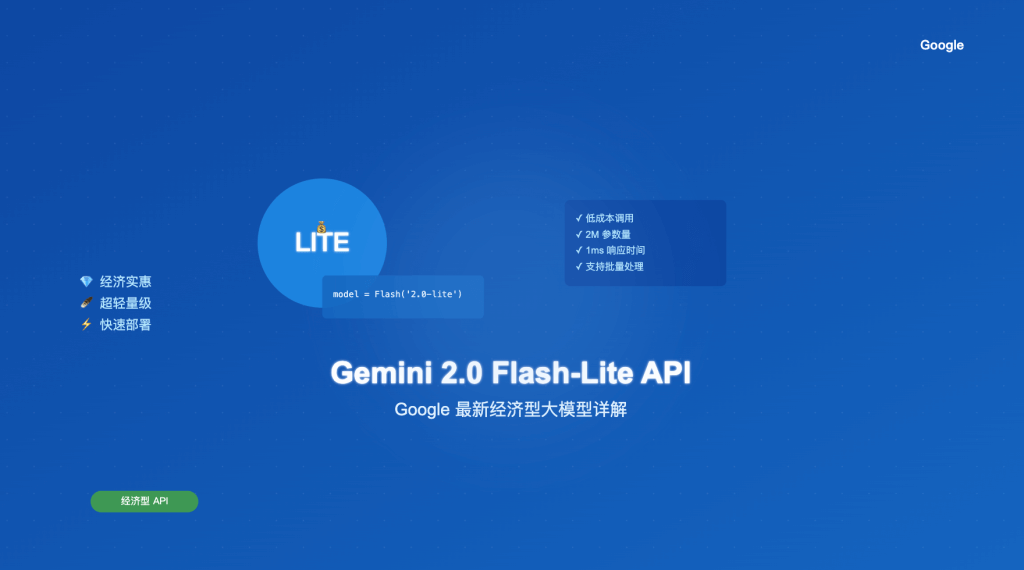

站长注:详细介绍 Google 最新经济型 Gemini 2.0 Flash-Lite API 的特点、优势和接入方法,助你快速上手这款高性价比大模型。

Google 于 2025 年 2 月 5 日推出了 Gemini 2.0 Flash-Lite,这是 Gemini 系列中最具性价比的模型。通过 API易,你可以立即开始使用这款经济实惠的 AI 模型,享受稳定可靠的服务体验。接入模型名称是 gemini-2.0-flash-lite-preview-02-05

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Gemini 2.0 Flash-Lite 等全系列模型,让 AI 开发更简单

注册即送 1.1 美金额度,立即免费体验。好用再充值 www.apiyi.com

Gemini 2.0 Flash-Lite 模型特点

1. 核心优势

- 经济实惠

- 输入:7.5美分/百万tokens

- 输出:30美分/百万tokens

- 与 Gemini 1.5 Flash 同价位

- 性能表现

- 保持 Flash 系列的高速特性

- 大多数基准测试优于 1.5 版本

- 响应速度快,成本更低

- 技术规格

- 输入上下文:支持 100 万 tokens

- 输出限制:8K tokens

- 支持多模态输入

2. 功能限制

注意:相比标准版 Gemini 2.0 Flash,Lite 版本有以下限制:

- 不支持的功能

- 多模态输出生成

- Multimodal Live API 集成

- Thinking 模式

- 内置工具使用

- 使用建议

- 适合文本处理任务

- 适合成本敏感场景

- 适合大规模简单调用

3. Flash vs Flash-Lite 详细对比

- 共同特点

- 100 万 tokens 的输入上下文窗口

- 支持多模态输入(文本、音频、图像)

- 文本输出生成能力

- 快速的响应速度

- 主要区别

| 特性 | Flash-Lite | Flash |

|---|---|---|

| 价格 | 输入:$0.075/百万tokens 输出:$0.30/百万tokens |

更高的定价 |

| 工具支持 | 不支持高级工具 | 支持搜索、代码执行、函数调用等 |

| 多模态输出 | 仅支持文本输出 | 未来支持图像和音频输出 |

| 性能表现 | 与 Gemini 1.5 Flash 相当 | 更快的响应速度和更好的任务处理能力 |

| 适用场景 | 成本敏感的基础任务 | 需要高级工具和高精度的复杂应用 |

- 选择建议

- 选择 Flash-Lite 如果你:

- 需要控制成本

- 主要处理文本任务

- 进行大规模简单调用

- 选择 Flash 如果你:

- 需要高级工具支持

- 处理复杂应用场景

- 要求更高的准确性

- 选择 Flash-Lite 如果你:

4. Flash-Lite vs GPT-4o mini 性能对比

作为经济型大模型的代表,Flash-Lite 和 GPT-4o mini 的对比对成本敏感的用户特别有帮助

- 成本对比

| 计费类型 | Flash-Lite | GPT-4o mini | 成本优势 |

|---|---|---|---|

| 输入tokens | $0.075/百万 | $0.15/百万 | 节省50% |

| 输出tokens | $0.30/百万 | $0.60/百万 | 节省50% |

- 性能指标

| 指标 | Flash-Lite | GPT-4o mini | 对比结果 |

|---|---|---|---|

| 处理速度 | 269.7 tokens/秒 | 85.2 tokens/秒 | Flash-Lite 更快 |

| 上下文窗口 | 100万 tokens | 12.8万 tokens | Flash-Lite 更大 |

| MMLU 基准测试 | 79.0% | 82.0% | GPT-4o mini 略高 |

- 选择建议

- 选择 Flash-Lite 的场景:

- 预算有限,需要最大化成本效益

- 需要处理超长文本(>12.8万 tokens)

- 对响应速度要求高

- 大规模并发调用场景

- 选择 GPT-4o mini 的场景:

- 对准确性要求极高的任务

- OpenAI 生态深度整合的项目

- 中等长度文本处理(<12.8万 tokens)

5. 适用场景

- 成本敏感场景

- 大规模文本处理

- 批量内容生成

- 高频率调用应用

- 基础 AI 功能

- 文本对话

- 内容总结

- 简单问答

- 企业应用

- 客服机器人

- 内容审核

- 数据处理

快速接入步骤

1. 准备工作

- 获取 API易 密钥

- 访问 API易注册页面

- 完成注册并登录

- 在后台的【令牌】栏目,获取 API 密钥

- 模型可用

- 在 API易 后台查看模型列表

- 复制模型名称

gemini-2.0-flash-lite-preview-02-05使用 - 查看价格:新模型的推出早期,价格可能有浮动。

2. 接口调用

- 基础配置

from openai import OpenAI

openai.api_base = "https://vip.apiyi.com/v1"

openai.api_key = "你的API易密钥"

# 设置模型名称

model_name = "gemini-2.0-flash-lite-preview-02-05"

- 文本对话示例

response = openai.ChatCompletion.create(

model=model_name,

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Tell me about AI technology."}

]

)

print(response.choices.message.content)

- 流式输出示例

response = openai.ChatCompletion.create(

model=model_name,

messages=[

{"role": "user", "content": "Write a story about technology"}

],

stream=True

)

for chunk in response:

if chunk and chunk.choices.delta.content:

print(chunk.choices.delta.content, end="")

3. 最佳实践

- 成本优化

- 合理设置文本长度

- 使用缓存机制

- 监控使用量

- 性能优化

- 使用流式输出

- 实现并发控制

- 错误重试机制

使用建议

1. 场景选择

- 最适合

- 基础文本处理

- 高频率调用

- 成本敏感应用

- 不建议

- 复杂推理任务

- 多模态输出需求

- 需要思考过程展示

2. 开发提示

- 接口调用

- 使用 OpenAI 兼容接口

- 实现错误处理

- 添加监控机制

- 应用优化

- 实现本地缓存

- 控制请求频率

- 优化响应处理

常见问题

1. 接入相关

Q: 如何选择合适的接口模式?

A: 推荐使用 OpenAI 兼容接口:

- 接入简单,文档丰富

- 生态支持完善

- 便于后续切换模型

2. 性能相关

Q: 如何提升响应速度?

A: 建议:

- 使用流式输出

- 控制输入长度

- 实现并发请求

为什么选择 API易

- 稳定可靠的供给

- 官方正式版本直接对接

- 稳定的服务保障

- 充足的算力支持

- 简单快速的接入

- OpenAI 兼容接口

- 3分钟即可接入

- 详细的接入文档

- 经济实惠的价格

- 与官方价格持平

- 按量计费灵活

- 免费额度体验

- 优质的服务支持

- 7×24 技术支持

- 完善的文档

- 持续的更新维护

总结

Gemini 2.0 Flash-Lite 作为 Google 最新推出的经济型大模型,通过 API易 平台可以快速接入使用。其优秀的性价比和稳定的性能,加上 API易 提供的便捷服务和技术支持,让你能够以更低的成本构建 AI 应用。现在就可以通过 API易 免费获取 1.1 美金体验额度,亲身体验这款经济实惠的模型。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Gemini 2.0 Flash-Lite 等全系列模型,让 AI 开发更简单

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。