Nota del autor: Tutorial completo: utiliza la API de comprensión de video de Gemini para aplicar ingeniería inversa a las indicaciones de videos virales y luego usa Sora 2 para generar nuevos videos similares, completando un flujo de trabajo de replicación de videos de comercio electrónico en un solo lugar.

Ver un video viral de la competencia y no saber cómo replicarlo es un problema común en la gestión de comercio electrónico. En este artículo, presentaremos el flujo de trabajo completo de Comprensión de video + Generación de video con IA para ayudarte a dominar rápidamente las técnicas prácticas de replicación de videos virales.

Valor central: Al terminar de leer este artículo, habrás aprendido a usar la comprensión de video de Gemini para extraer la indicación de cualquier video y utilizar Sora 2 para generar nuevos videos con el mismo estilo.

Puntos clave para la replicación de videos virales mediante comprensión de video

| Punto clave | Descripción | Valor |

|---|---|---|

| Ingeniería inversa de video | Usa IA para analizar la imagen, el movimiento de cámara, el estilo y el ritmo del video. | Extrae con precisión los elementos centrales del video viral. |

| Generación de indicaciones | Genera automáticamente una indicación estructurada apta para la creación de video. | Elimina la necesidad de adivinar manualmente y de realizar ajustes repetitivos. |

| Replicación en un clic | Introduce la indicación directamente en Sora 2 para generar una versión similar. | Produce rápidamente nuevos videos con el mismo estilo. |

| API en un solo lugar | Llamadas unificadas a Gemini + Sora 2 en una sola plataforma. | Simplifica el flujo de trabajo y reduce los costos de integración. |

Detalles importantes de la replicación de videos virales con comprensión de video

La comprensión de video (Video Understanding) es una de las capacidades centrales de la IA multimodal. Los modelos de la serie Gemini pueden procesar simultáneamente el flujo de audio y los fotogramas visuales de un video, extrayendo información de la imagen a una frecuencia de muestreo de 1 fotograma por segundo, combinándola con el contenido de la pista de audio para un análisis integral. Esto significa que la IA no solo puede "entender" qué hay en el video, sino que también comprende el lenguaje cinematográfico, el estilo de iluminación, el ritmo de edición y otros elementos profesionales.

La ingeniería inversa de indicaciones (Reverse Prompt Engineering) es la tecnología clave para aplicar la capacidad de comprensión de video a la creación de contenido. A través de indicaciones de análisis cuidadosamente diseñadas, la IA puede extraer de un video: composición de la toma, movimiento de cámara, estilo de iluminación, tono de color, acciones del sujeto, características de la música de fondo, etc., y reorganizar estos elementos en una indicación de generación apta para Sora 2.

Flujo de trabajo completo para replicar videos virales

Paso 1: Subir el video viral

Existen varios métodos para ingresar videos:

| Método de entrada | Escenario de uso | Limitaciones |

|---|---|---|

| Carga local | Archivos de video ya descargados | Archivos < 100MB, transferencia en línea |

| File API | Archivos grandes o videos largos | Soporta > 100MB, reutilizable |

| YouTube URL | Análisis directo de videos en línea | Soporte nativo de Gemini |

Paso 2: Análisis y comprensión de video

Utiliza el modelo de comprensión de video de Gemini para analizar el contenido del video y extraer los elementos creativos clave:

import requests

import base64

# Configuración de la API

api_key = "TU_API_KEY"

base_url = "https://vip.apiyi.com/v1"

# Leer el archivo de video

with open("viral_video.mp4", "rb") as f:

video_base64 = base64.b64encode(f.read()).decode()

# Análisis de comprensión de video

response = requests.post(

f"{base_url}/chat/completions",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "gemini-2.5-pro-preview",

"messages": [{

"role": "user",

"content": [

{"type": "video", "video": video_base64},

{"type": "text", "text": """Analiza este video y extrae los siguientes elementos creativos:

1. Composición de la toma y relación de aspecto

2. Movimiento de cámara (zoom, paneo, seguimiento, estático, etc.)

3. Estilo de iluminación y tono de color

4. Acción del sujeto y ritmo

5. Descripción del entorno y fondo

6. Palabras clave del estilo visual general

Por favor, organiza los resultados en un formato de indicación en inglés listo para Sora 2."""}

]

}]

}

)

print(response.json()["choices"][0]["message"]["content"])

Paso 3: Generación de una indicación estructurada

Ejemplo del resultado del análisis devuelto por la comprensión de video:

Camera: Slow push-in, centered composition, shallow depth of field

Lighting: Soft diffused studio lighting, warm color temperature (3200K)

Subject: Premium leather handbag rotating on white marble pedestal

Movement: 360-degree rotation over 8 seconds, smooth and elegant

Style: Luxury commercial aesthetic, minimalist background

Color: Warm tones, high contrast, subtle vignette

Sora 2 Prompt:

"A premium leather handbag slowly rotating 360 degrees on a white marble

pedestal, soft diffused studio lighting with warm color temperature,

shallow depth of field, luxury commercial aesthetic, centered composition,

smooth cinematic movement, minimalist white background, high-end product

showcase style"

Paso 4: Sora 2 genera un video similar

Introduce la indicación extraída en Sora 2 para generar el nuevo video:

# Generar el nuevo video usando la indicación extraída

sora_response = requests.post(

f"{base_url}/videos/generations",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "sora-2",

"prompt": extracted_prompt, # La indicación extraída en el paso anterior

"aspect_ratio": "9:16",

"duration": 10

}

)

print(sora_response.json())

Sugerencia: A través de APIYI (apiyi.com) puedes llamar simultáneamente a las API de comprensión de video de Gemini y de generación de video de Sora 2. Es la forma más fácil de completar todo el flujo de trabajo en un solo lugar sin tener que lidiar con múltiples plataformas.

Guía rápida para replicar videos virales

Ejemplo minimalista

Aquí tienes el código completo para replicar un video viral, listo para ejecutar con un solo clic:

import requests

import base64

api_key = "TU_API_KEY"

base_url = "https://vip.apiyi.com/v1"

def clone_viral_video(video_path: str) -> dict:

"""Replica un video viral con un solo clic"""

# 1. Leer video

with open(video_path, "rb") as f:

video_b64 = base64.b64encode(f.read()).decode()

# 2. Comprensión de video con Gemini

analysis = requests.post(

f"{base_url}/chat/completions",

headers={"Authorization": f"Bearer {api_key}"},

json={

"model": "gemini-2.5-pro-preview",

"messages": [{"role": "user", "content": [

{"type": "video", "video": video_b64},

{"type": "text", "text": "Analyze and generate Sora 2 prompt"}

]}]

}

).json()

prompt = analysis["choices"][0]["message"]["content"]

# 3. Generación de video con Sora 2

result = requests.post(

f"{base_url}/videos/generations",

headers={"Authorization": f"Bearer {api_key}"},

json={"model": "sora-2", "prompt": prompt}

).json()

return {"prompt": prompt, "video": result}

# Uso

result = clone_viral_video("video_competencia.mp4")

Ver código de implementación completo (incluye procesamiento por lotes y manejo de errores)

import requests

import base64

import time

from typing import Optional, List

from pathlib import Path

class ViralVideoCloner:

"""Clase de utilidad para la replicación de videos virales"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.headers = {"Authorization": f"Bearer {api_key}"}

def analyze_video(self, video_path: str) -> str:

"""Usa Gemini para analizar el video y extraer la indicación"""

with open(video_path, "rb") as f:

video_b64 = base64.b64encode(f.read()).decode()

analysis_prompt = """Analyze this video and extract creative elements:

1. Camera movement and composition

2. Lighting style and color grading

3. Subject action and pacing

4. Background and environment

5. Overall visual style

Generate a detailed Sora 2 prompt in English that can recreate

a similar video with different products."""

response = requests.post(

f"{self.base_url}/chat/completions",

headers=self.headers,

json={

"model": "gemini-2.5-pro-preview",

"messages": [{

"role": "user",

"content": [

{"type": "video", "video": video_b64},

{"type": "text", "text": analysis_prompt}

]

}]

}

)

return response.json()["choices"][0]["message"]["content"]

def generate_video(

self,

prompt: str,

aspect_ratio: str = "9:16",

duration: int = 10

) -> dict:

"""Usa Sora 2 para generar el nuevo video"""

response = requests.post(

f"{self.base_url}/videos/generations",

headers=self.headers,

json={

"model": "sora-2",

"prompt": prompt,

"aspect_ratio": aspect_ratio,

"duration": duration

}

)

return response.json()

def clone(

self,

video_path: str,

custom_subject: Optional[str] = None

) -> dict:

"""Flujo completo de replicación de video"""

# Analizar el video original

base_prompt = self.analyze_video(video_path)

# Si se especifica un sujeto personalizado, reemplazar la descripción en la indicación

if custom_subject:

base_prompt = self._replace_subject(base_prompt, custom_subject)

# Generar el nuevo video

result = self.generate_video(base_prompt)

return {

"original_video": video_path,

"extracted_prompt": base_prompt,

"generated_video": result

}

def batch_clone(self, video_paths: List[str]) -> List[dict]:

"""Replicar varios videos por lotes"""

results = []

for path in video_paths:

result = self.clone(path)

results.append(result)

time.sleep(2) # Evitar límites de frecuencia

return results

def _replace_subject(self, prompt: str, new_subject: str) -> str:

"""Reemplazar el sujeto en la indicación"""

# Procesamiento simplificado, en la práctica se pueden usar métodos de NLP más complejos

return f"{new_subject}, {prompt}"

# Ejemplo de uso

cloner = ViralVideoCloner("TU_API_KEY")

result = cloner.clone(

"best_seller_competencia.mp4",

custom_subject="my product: wireless earbuds in charging case"

)

print(result["extracted_prompt"])

Sugerencia: Consigue tus créditos para las API de Gemini y Sora 2 a través de APIYI (apiyi.com). La plataforma permite gestionar llamadas a múltiples modelos de forma centralizada, simplificando enormemente el desarrollo.

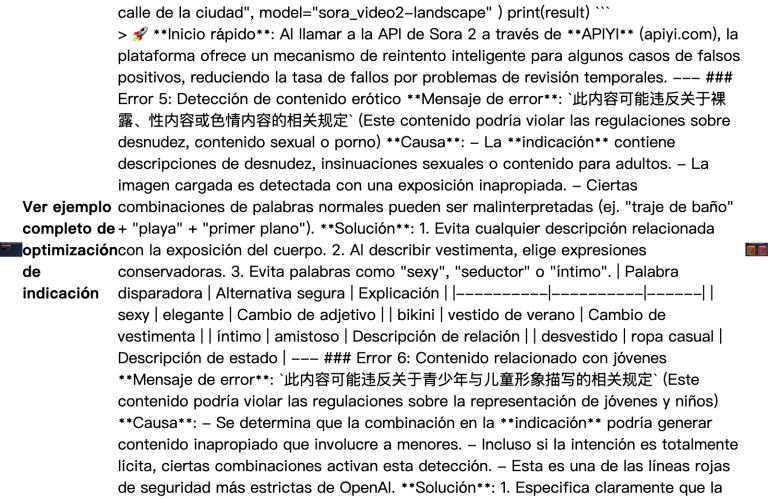

Comparativa de modelos para replicar videos virales

| Modelo | Capacidad de comprensión de video | Duración máxima | Escenarios de uso | Plataformas disponibles |

|---|---|---|---|---|

| Gemini 2.5 Pro | Análisis de flujo dual visual + audio | ~6 horas | Análisis profundo de videos largos | APIYI y otras |

| Gemini 2.5 Flash | Análisis visual rápido | ~1 hora | Procesamiento rápido de videos cortos | APIYI y otras |

| GPT-4o | Análisis de fotogramas visuales | Corta | Comprensión de escenas simples | APIYI y otras |

¿Por qué recomendamos Gemini para la comprensión de video?

La serie Gemini 2.5 lidera actualmente los benchmarks de comprensión de video en la industria:

- Procesamiento de flujo dual: Analiza simultáneamente los fotogramas visuales y las pistas de audio para una comprensión mucho más completa.

- Contexto ultra largo: Su soporte para 2 millones de tokens permite procesar videos de hasta 6 horas de duración.

- Control detallado: Permite personalizar parámetros como la tasa de muestreo y la resolución.

- Localización por marcas de tiempo: Puede citar momentos específicos del video con precisión en formato MM:SS.

Sugerencia de selección: Recomendamos usar Gemini 2.5 Pro para el análisis de video, el cual puedes invocar fácilmente a través de APIYI (apiyi.com).

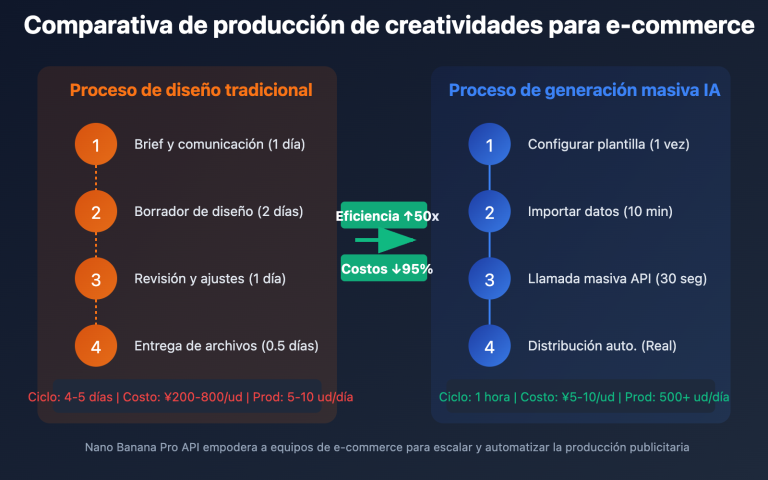

Casos de uso para replicar videos virales

Este enfoque es ideal para los siguientes escenarios de comercio electrónico:

- Análisis de la competencia: Analiza los videos virales de tus competidores y extrae los elementos clave de su éxito.

- Transferencia de estilo: Aplica el estilo de videos populares a la presentación de tus propios productos.

- Producción por lotes: Utiliza una plantilla de estilo ganadora para generar rápidamente videos de múltiples productos.

- Pruebas A/B: Genera diversas variantes de estilo para testear cuál funciona mejor en tus campañas.

| Escenario | Entrada | Salida | Mejora de eficiencia |

|---|---|---|---|

| Réplica de competencia | Video viral del competidor | Video de producto propio con el mismo estilo | 10x |

| Transferencia de estilo | Video con estilo tendencia | Video estilizado de producto propio | 8x |

| Lotes por plantilla | 1 video de plantilla | N videos de productos | 20x |

Preguntas frecuentes

P1: ¿Qué formatos y duraciones admite la comprensión de video?

Gemini admite formatos de video comunes (MP4, MOV, AVI, etc.). Los archivos de menos de 100 MB se pueden transmitir directamente de forma integrada (inline), mientras que los archivos más grandes deben cargarse mediante la File API. El contexto de 2 millones de tokens de Gemini 2.5 Pro permite teóricamente analizar unas 6 horas de video.

P2: ¿Es necesario ajustar manualmente las indicaciones extraídas?

Las indicaciones generadas por IA suelen poder usarse directamente, pero se recomienda realizar ajustes finos según las necesidades reales:

- Reemplazar la descripción del sujeto por tu producto.

- Ajustar los parámetros de duración y relación de aspecto.

- Añadir palabras clave de estilo relacionadas con la marca.

P3: ¿Cómo empezar rápidamente a probar la comprensión y replicación de videos?

Se recomienda utilizar una plataforma de agregación de APIs que admita múltiples modelos para realizar las pruebas:

- Visita APIYI (apiyi.com) y registra una cuenta.

- Obtén tu API Key y saldo gratuito.

- Utiliza los ejemplos de código de este artículo para una validación rápida.

- Realiza todo el proceso en un solo lugar: comprensión de video con Gemini + generación con Sora 2.

Resumen

Puntos clave para replicar videos virales mediante la comprensión de video:

- La comprensión de video es la clave: La capacidad multimodal de Gemini permite extraer con precisión los elementos creativos de un video.

- Automatización de la ingeniería de indicaciones: La IA convierte automáticamente el análisis visual en indicaciones de generación listas para usar.

- Flujo de trabajo integral: Llamadas API unificadas de Gemini + Sora 2, lo que simplifica el proceso de desarrollo.

Al dominar este flujo de trabajo, los responsables de e-commerce pueden replicar rápidamente los estilos de los videos más exitosos del sector, reduciendo drásticamente los costos de prueba y error en la creación de contenido.

Te recomendamos usar APIYI (apiyi.com) para validar los resultados rápidamente; la plataforma ofrece tanto la API de comprensión de video de Gemini como la de generación de video de Sora 2, permitiéndote completar todo el proceso de replicación en un solo lugar.

📚 Materiales de Referencia

⚠️ Nota sobre el formato de los enlaces: Todos los enlaces externos utilizan el formato

Nombre del recurso: dominio.com. Esto facilita copiarlos pero evita que se pueda hacer clic, para prevenir la pérdida de autoridad SEO.

-

Documentación oficial de Gemini para comprensión de video: Parámetros detallados de la API y métodos de uso.

- Enlace:

ai.google.dev/gemini-api/docs/video-understanding - Descripción: Documentación oficial de referencia para conocer todas las capacidades de comprensión de video.

- Enlace:

-

Guía de indicaciones para Sora 2: Mejores prácticas de indicaciones oficiales de OpenAI.

- Enlace:

cookbook.openai.com/examples/sora/sora2_prompting_guide - Descripción: Aprende a escribir indicaciones de alta calidad para la generación de video.

- Enlace:

-

Guía de ingeniería de indicaciones inversas: Detalles técnicos de Video-to-Prompt.

- Enlace:

skywork.ai/skypage/en/Video-to-Prompt-A-Hands-On-Guide - Descripción: Entiende en profundidad cómo funciona Video-to-Prompt.

- Enlace:

Autor: Equipo Técnico

Intercambio Técnico: Te invitamos a debatir en la sección de comentarios. Para más materiales, visita la comunidad técnica de APIYI apiyi.com.