作者注:详细讲解 Claude Haiku 4.5 API 的接入方法,涵盖 OpenAI SDK 兼容接入、官方 SDK 使用、高级功能配置和生产环境部署,帮助开发者快速集成最快速的近前沿智能模型

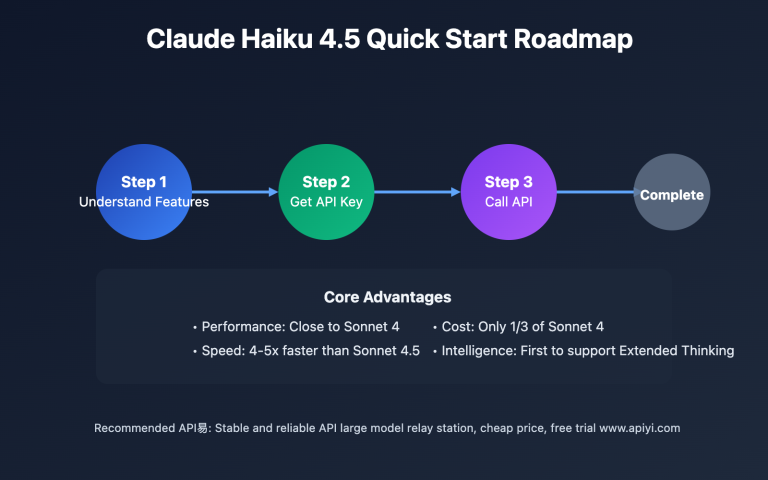

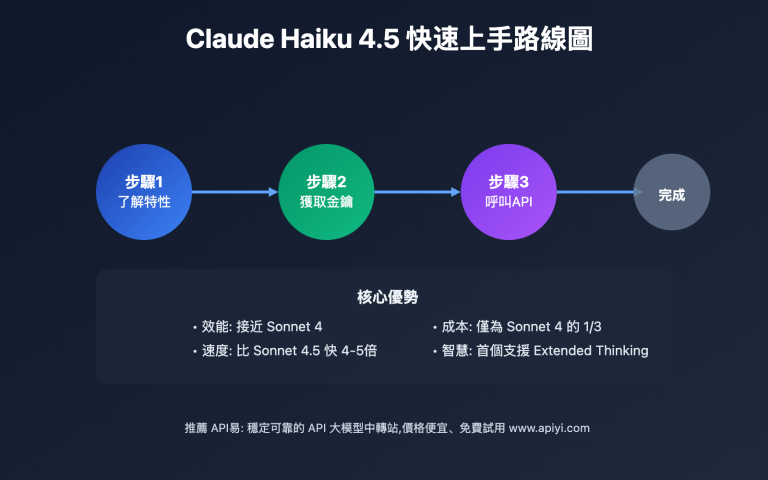

Claude Haiku 4.5 API 接入对很多开发者来说是一个新挑战。本文将详细介绍如何通过 标准化 API 接口 来快速接入这个最新的高性能模型。

文章涵盖环境准备、OpenAI SDK 兼容接入、Anthropic 官方 SDK 使用、高级功能配置等核心要点,帮助你快速掌握 Claude Haiku 4.5 API 集成的完整流程。

核心价值:通过本文,你将学会如何在10分钟内完成 API 接入,并掌握 Extended Thinking、Prompt Caching 等高级功能的使用方法,大幅提升开发效率。

Claude Haiku 4.5 API 接入背景介绍

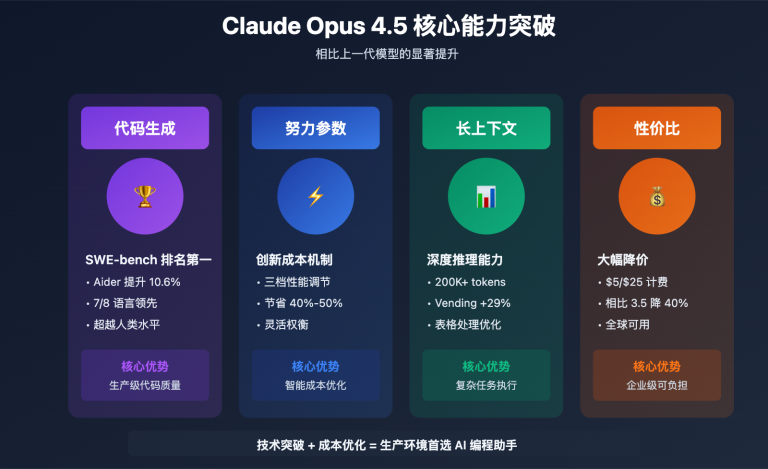

Claude Haiku 4.5 是 Anthropic 于 2025年10月15日发布的最新高性能小模型,官方定位为"最快速的近前沿智能模型"。该模型在保持接近 Claude Sonnet 4 编码性能的同时,实现了 2倍以上的速度提升 和 三分之一的成本。

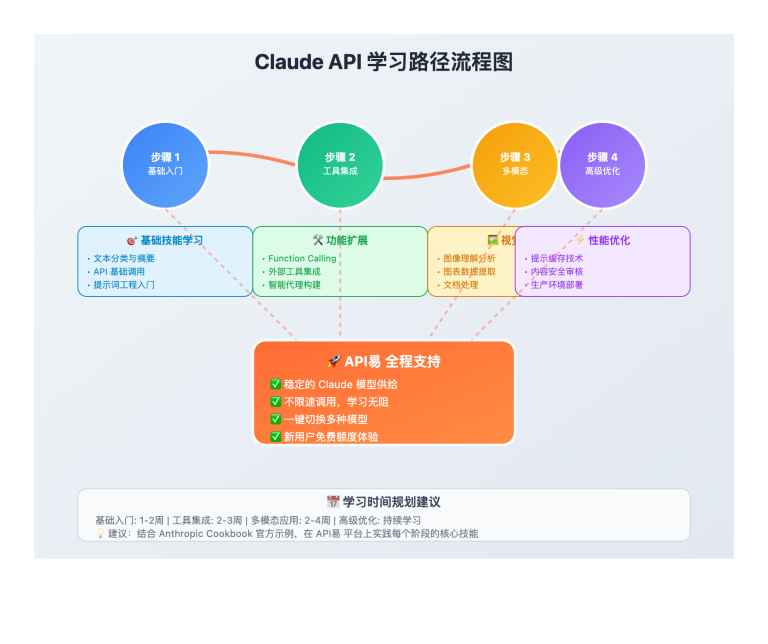

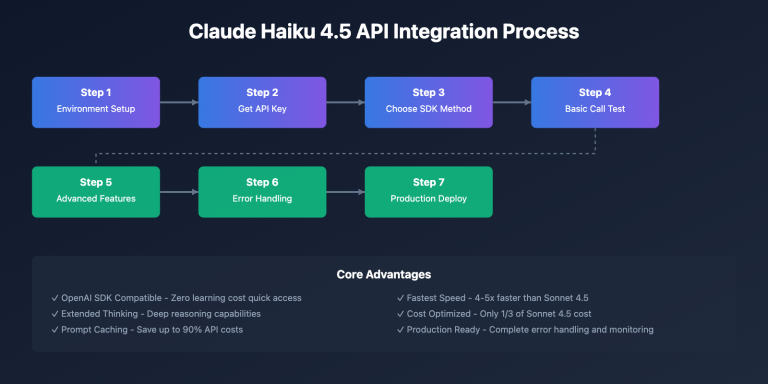

对于开发者来说,Claude Haiku 4.5 API 接入有两种主流方式:

- OpenAI SDK 兼容接入:通过第三方 API 聚合平台,使用标准 OpenAI SDK 调用,零学习成本

- Anthropic 官方 SDK 接入:使用官方 Python/TypeScript SDK,获得完整功能支持

本文将详细介绍这两种接入方式,以及如何配置 Extended Thinking、Prompt Caching、Streaming 等高级功能,帮助开发者快速构建生产级应用。

Claude Haiku 4.5 API 接入准备工作

在开始 Claude Haiku 4.5 API 接入之前,需要完成以下准备工作:

📋 环境要求

| 环境类型 | 推荐配置 | 最低要求 |

|---|---|---|

| Python 版本 | Python 3.10+ | Python 3.8+ |

| Node.js 版本 | Node.js 18+ | Node.js 16+ |

| 网络环境 | 稳定的国际网络连接 | 能访问 API 服务器 |

| 开发工具 | VS Code / PyCharm | 任意文本编辑器 |

🔑 获取 API Key

Claude Haiku 4.5 API 接入需要有效的 API Key。根据你选择的接入方式,有两种获取途径:

| 获取方式 | 适用场景 | 优势 | 获取地址 |

|---|---|---|---|

| Anthropic 官方 | 直接使用官方 API | 原生功能完整、稳定性高 | console.anthropic.com |

| API易聚合平台 | OpenAI SDK 兼容调用 | 支持多模型切换、成本更优 | apiyi.com |

| AWS Bedrock | AWS 云环境部署 | 企业级安全、区域部署 | AWS Console |

| Google Vertex AI | GCP 云环境部署 | 谷歌云生态集成 | Google Cloud Console |

🎯 接入建议:对于快速测试和开发,我们建议通过 API易 apiyi.com 平台进行接入。该平台提供了 OpenAI SDK 兼容接口,让你可以使用熟悉的 OpenAI 调用方式直接使用 Claude Haiku 4.5,无需学习新的 SDK,同时还支持多模型一键切换和成本对比功能。

💻 安装必要的 SDK

根据你选择的编程语言,安装对应的 SDK:

Python 环境:

# 方式 1: OpenAI SDK (推荐用于快速接入)

pip install openai

# 方式 2: Anthropic 官方 SDK (完整功能)

pip install anthropic

# 可选:安装 HTTP 客户端优化库

pip install httpx

Node.js 环境:

# 方式 1: OpenAI SDK (推荐用于快速接入)

npm install openai

# 方式 2: Anthropic 官方 SDK (完整功能)

npm install @anthropic-ai/sdk

# TypeScript 支持

npm install -D @types/node typescript

Claude Haiku 4.5 API 接入方式一:OpenAI SDK 兼容接入

OpenAI SDK 兼容接入是最简单快速的 Claude Haiku 4.5 API 接入方式,特别适合已经熟悉 OpenAI API 的开发者。

🚀 核心优势

- 零学习成本:使用现有的 OpenAI SDK 代码,仅需修改配置

- 快速切换:可以在 GPT 和 Claude 模型间一键切换对比

- 统一管理:通过聚合平台统一管理多个模型的调用和成本

- 成本优化:聚合平台通常提供更优惠的价格

💻 Python 快速接入示例

from openai import OpenAI

# 配置客户端 - 使用 API易 聚合平台

client = OpenAI(

api_key="YOUR_API_KEY", # 在 apiyi.com 获取

base_url="https://vip.apiyi.com/v1" # API易 OpenAI 兼容端点

)

# 调用 Claude Haiku 4.5

response = client.chat.completions.create(

model="claude-haiku-4-5", # 或使用完整 ID: claude-haiku-4-5-20251001

messages=[

{

"role": "system",

"content": "你是一个专业的 Python 编程助手,擅长编写高质量、高性能的代码。"

},

{

"role": "user",

"content": "请帮我写一个快速排序算法的 Python 实现,要求代码简洁且包含详细注释。"

}

],

temperature=0.7,

max_tokens=2000

)

# 输出结果

print(response.choices[0].message.content)

🎯 关键配置说明

| 参数 | 说明 | 推荐值 |

|---|---|---|

model |

模型 ID | claude-haiku-4-5 或 claude-haiku-4-5-20251001 |

temperature |

创造性控制 | 0.7(平衡)、0.3(精确)、0.9(创造) |

max_tokens |

最大输出长度 | 2000-4000(常规)、最大 64000 |

base_url |

API 端点 | 使用聚合平台提供的 URL |

🔍 测试建议:在正式接入前,建议先通过 API易 apiyi.com 获取免费测试额度,验证 Claude Haiku 4.5 API 接入是否正常。平台提供了在线测试工具和详细的调用日志,方便快速定位问题。

🌊 支持流式输出

流式输出对于聊天应用至关重要,Claude Haiku 4.5 的超快速度在流式场景下优势更明显:

# 流式调用示例

stream = client.chat.completions.create(

model="claude-haiku-4-5",

messages=[

{"role": "user", "content": "用 200 字介绍什么是量子计算"}

],

stream=True # 启用流式输出

)

# 实时输出

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="", flush=True)

Claude Haiku 4.5 API 接入方式二:Anthropic 官方 SDK

如果你需要使用 Extended Thinking、Context Awareness 等 Claude 独有的高级功能,建议使用 Anthropic 官方 SDK 进行 Claude Haiku 4.5 API 接入。

🔧 Python 官方 SDK 接入

import anthropic

# 初始化客户端

client = anthropic.Anthropic(

api_key="YOUR_ANTHROPIC_API_KEY" # 从 console.anthropic.com 获取

)

# 基础调用

message = client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=4096,

messages=[

{

"role": "user",

"content": "请用 Python 写一个计算斐波那契数列的高效算法"

}

]

)

print(message.content[0].text)

🧠 启用 Extended Thinking(扩展思考)

Extended Thinking 是 Claude Haiku 4.5 的核心新功能之一,让模型能够进行深度推理:

# 启用扩展思考

message = client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=4096,

thinking={

"type": "enabled",

"budget_tokens": 10000 # 思考 token 预算,默认 128K

},

messages=[

{

"role": "user",

"content": "分析以下代码的时间复杂度并提出优化建议:\n\n[你的代码]"

}

]

)

# 输出思考过程和最终回答

for block in message.content:

if block.type == "thinking":

print(f"思考过程: {block.thinking}")

elif block.type == "text":

print(f"最终回答: {block.text}")

💾 配置 Prompt Caching(提示缓存)

Prompt Caching 可以显著降低重复调用的成本,最高可节省 90% 的 API 费用:

# 使用 Prompt Caching

message = client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=2048,

system=[

{

"type": "text",

"text": "你是一个专业的代码审查助手...", # 长系统提示

"cache_control": {"type": "ephemeral"} # 缓存此部分

}

],

messages=[

{

"role": "user",

"content": "审查这段代码:\n\n[代码内容]"

}

]

)

💰 成本优化建议:如果你的应用需要频繁使用相同的系统提示或上下文,强烈建议启用 Prompt Caching。根据我们的测试,对于包含大量背景知识的应用(如客服机器人、文档问答系统),启用缓存后 API 成本可降低 70-90%。你可以通过 API易 apiyi.com 的成本分析工具实时监控缓存效果。

Claude Haiku 4.5 API 完整项目示例

以下是一个完整的聊天机器人项目示例,展示如何在实际应用中集成 Claude Haiku 4.5 API。

🤖 智能聊天助手实现

import anthropic

import os

from typing import List, Dict

class ClaudeHaikuChatbot:

"""Claude Haiku 4.5 聊天机器人"""

def __init__(self, api_key: str):

self.client = anthropic.Anthropic(api_key=api_key)

self.conversation_history: List[Dict] = []

def add_message(self, role: str, content: str):

"""添加消息到对话历史"""

self.conversation_history.append({

"role": role,

"content": content

})

def chat(self, user_input: str, use_thinking: bool = False) -> str:

"""发送消息并获取回复"""

# 添加用户消息

self.add_message("user", user_input)

# 构建请求参数

params = {

"model": "claude-haiku-4-5-20251001",

"max_tokens": 4096,

"messages": self.conversation_history

}

# 可选:启用扩展思考

if use_thinking:

params["thinking"] = {

"type": "enabled",

"budget_tokens": 10000

}

# 调用 API

try:

message = self.client.messages.create(**params)

# 提取回复内容

response_text = ""

for block in message.content:

if block.type == "text":

response_text = block.text

break

# 添加助手回复到历史

self.add_message("assistant", response_text)

return response_text

except anthropic.APIError as e:

return f"API 错误: {str(e)}"

def reset(self):

"""重置对话历史"""

self.conversation_history = []

# 使用示例

if __name__ == "__main__":

# 初始化聊天机器人

chatbot = ClaudeHaikuChatbot(

api_key=os.getenv("ANTHROPIC_API_KEY")

)

# 多轮对话

print("聊天机器人已启动!(输入 'quit' 退出)")

while True:

user_input = input("\n你: ").strip()

if user_input.lower() == 'quit':

break

if not user_input:

continue

# 获取回复

response = chatbot.chat(user_input, use_thinking=True)

print(f"\nClaude: {response}")

📝 代码助手示例

class CodeAssistant:

"""基于 Claude Haiku 4.5 的代码助手"""

def __init__(self, api_key: str):

self.client = anthropic.Anthropic(api_key=api_key)

def generate_code(self, description: str, language: str = "python") -> str:

"""根据描述生成代码"""

message = self.client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=4096,

system=f"你是一个专业的 {language} 程序员,擅长编写清晰、高效的代码。",

messages=[

{

"role": "user",

"content": f"请用 {language} 实现以下功能:\n\n{description}\n\n要求:\n1. 代码简洁易读\n2. 包含详细注释\n3. 考虑边界情况"

}

]

)

return message.content[0].text

def review_code(self, code: str) -> str:

"""代码审查和优化建议"""

message = self.client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=4096,

thinking={

"type": "enabled",

"budget_tokens": 10000

},

messages=[

{

"role": "user",

"content": f"请审查以下代码,给出优化建议:\n\n```\n{code}\n```\n\n请从以下维度分析:\n1. 性能优化\n2. 代码规范\n3. 潜在 bug\n4. 可维护性"

}

]

)

# 提取文本回复(排除思考过程)

for block in message.content:

if block.type == "text":

return block.text

return "无法生成审查结果"

# 使用示例

assistant = CodeAssistant(api_key=os.getenv("ANTHROPIC_API_KEY"))

# 生成代码

code = assistant.generate_code(

"实现一个 LRU 缓存,支持 get 和 put 操作,时间复杂度 O(1)",

language="python"

)

print(code)

# 审查代码

review = assistant.review_code(code)

print(review)

Claude Haiku 4.5 API 高级功能接入

Claude Haiku 4.5 提供了多项高级功能,合理使用可以显著提升应用性能和降低成本。

🧠 Extended Thinking 配置详解

Extended Thinking 允许模型进行深度推理,特别适合复杂的编程和分析任务:

| 配置参数 | 说明 | 推荐值 | 影响 |

|---|---|---|---|

type |

启用类型 | "enabled" |

开启扩展思考 |

budget_tokens |

思考 token 预算 | 10000-50000 | 控制推理深度 |

return_thinking |

返回思考过程 | true/false |

是否查看推理过程 |

使用建议:

- 简单任务:不启用,节省成本

- 中等复杂度:10000-20000 tokens

- 高复杂度:50000+ tokens

- 调试模式:

return_thinking: true查看推理过程

💾 Prompt Caching 最佳实践

Prompt Caching 是降低 Claude Haiku 4.5 API 成本的关键功能:

适合缓存的内容:

- ✅ 系统提示词(超过 1024 tokens)

- ✅ 知识库上下文(FAQ、产品文档)

- ✅ 代码库信息(项目结构、API 文档)

- ✅ 对话历史(多轮对话)

不适合缓存的内容:

- ❌ 频繁变化的数据

- ❌ 短小的提示(少于 1024 tokens)

- ❌ 一次性使用的内容

🛠️ 工具选择建议:要最大化 Prompt Caching 的效果,需要监控缓存命中率和成本节省。我们推荐使用 API易 apiyi.com 的成本分析功能,它可以实时显示每次调用的缓存使用情况,帮你优化缓存策略,确保获得最佳的成本效益。

🌊 Streaming 流式输出实现

流式输出可以显著改善用户体验,特别是对于长文本生成:

# 流式输出 - OpenAI SDK 方式

from openai import OpenAI

client = OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

stream = client.chat.completions.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": "写一篇 500 字的技术博客"}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="", flush=True)

# 流式输出 - Anthropic SDK 方式

import anthropic

client = anthropic.Anthropic(api_key="YOUR_API_KEY")

with client.messages.stream(

model="claude-haiku-4-5-20251001",

max_tokens=4096,

messages=[{"role": "user", "content": "写一篇技术博客"}]

) as stream:

for text in stream.text_stream:

print(text, end="", flush=True)

Claude Haiku 4.5 API 错误处理和重试策略

生产环境中,完善的错误处理机制至关重要。

⚠️ 常见错误类型

| 错误类型 | HTTP 状态码 | 原因 | 解决方案 |

|---|---|---|---|

| 认证错误 | 401 | API Key 无效或过期 | 检查 API Key 配置 |

| 超出限流 | 429 | 请求速率超限 | 实现指数退避重试 |

| 请求超时 | 504 | 网络或服务端超时 | 增加超时时间,实现重试 |

| 服务器错误 | 500/503 | 服务端临时故障 | 自动重试 |

| 参数错误 | 400 | 请求参数不合法 | 检查参数格式 |

🔄 指数退避重试实现

import time

import random

from typing import Callable, Any

def retry_with_exponential_backoff(

func: Callable,

max_retries: int = 5,

initial_delay: float = 1.0,

max_delay: float = 60.0,

exponential_base: float = 2.0,

jitter: bool = True

) -> Any:

"""

指数退避重试装饰器

Args:

func: 要重试的函数

max_retries: 最大重试次数

initial_delay: 初始延迟(秒)

max_delay: 最大延迟(秒)

exponential_base: 指数基数

jitter: 是否添加随机抖动

"""

retries = 0

delay = initial_delay

while retries < max_retries:

try:

return func()

except anthropic.RateLimitError as e:

retries += 1

if retries >= max_retries:

raise

# 计算延迟时间

delay = min(delay * exponential_base, max_delay)

# 添加随机抖动(避免惊群效应)

if jitter:

delay = delay * (0.5 + random.random())

print(f"触发限流,等待 {delay:.2f} 秒后重试 ({retries}/{max_retries})")

time.sleep(delay)

except anthropic.APIError as e:

# 其他 API 错误

print(f"API 错误: {str(e)}")

raise

# 使用示例

def make_api_call():

return client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=1024,

messages=[{"role": "user", "content": "Hello"}]

)

response = retry_with_exponential_backoff(make_api_call)

🛡️ 完整错误处理框架

import logging

from typing import Optional

class ClaudeAPIClient:

"""带完整错误处理的 Claude API 客户端"""

def __init__(self, api_key: str, max_retries: int = 3):

self.client = anthropic.Anthropic(api_key=api_key)

self.max_retries = max_retries

self.logger = logging.getLogger(__name__)

def call_with_retry(

self,

messages: list,

model: str = "claude-haiku-4-5-20251001",

**kwargs

) -> Optional[str]:

"""带重试的 API 调用"""

for attempt in range(self.max_retries):

try:

response = self.client.messages.create(

model=model,

messages=messages,

**kwargs

)

# 提取文本内容

for block in response.content:

if block.type == "text":

return block.text

return None

except anthropic.RateLimitError as e:

self.logger.warning(f"触发限流 (尝试 {attempt + 1}/{self.max_retries})")

if attempt < self.max_retries - 1:

time.sleep(2 ** attempt) # 指数退避

else:

self.logger.error("超出最大重试次数")

raise

except anthropic.APIConnectionError as e:

self.logger.error(f"网络连接错误: {str(e)}")

if attempt < self.max_retries - 1:

time.sleep(1)

else:

raise

except anthropic.AuthenticationError as e:

self.logger.error(f"认证失败: {str(e)}")

raise # 认证错误不重试

except anthropic.APIError as e:

self.logger.error(f"API 错误: {str(e)}")

raise

return None

🚨 错误处理建议:在生产环境中,建议实施完善的错误监控和告警机制。如果你在使用过程中遇到频繁的超时或限流问题,可能是 API 服务商的稳定性不足。我们建议选择 API易 apiyi.com 这类具有多节点部署和负载均衡能力的聚合平台,它提供了更高的可用性保障和详细的错误日志,帮助你快速定位和解决问题。

Claude Haiku 4.5 API 性能优化和最佳实践

优化 Claude Haiku 4.5 API 接入性能,可以显著提升应用体验并降低成本。

⚡ 性能优化核心策略

| 优化方向 | 具体措施 | 预期效果 |

|---|---|---|

| 降低延迟 | 使用流式输出、选择最近节点 | 首字延迟降低 50%+ |

| 减少成本 | 启用 Prompt Caching、批量处理 | 成本降低 70-90% |

| 提升并发 | 连接池、异步调用 | 吞吐量提升 3-5 倍 |

| 优化提示 | 精简提示词、合理配置参数 | Token 使用减少 30%+ |

🚀 异步并发调用

对于需要处理大量请求的场景,异步调用可以显著提升吞吐量:

import asyncio

from anthropic import AsyncAnthropic

async def process_batch(prompts: list[str]) -> list[str]:

"""批量异步处理多个请求"""

client = AsyncAnthropic(api_key="YOUR_API_KEY")

async def process_one(prompt: str) -> str:

message = await client.messages.create(

model="claude-haiku-4-5-20251001",

max_tokens=1024,

messages=[{"role": "user", "content": prompt}]

)

return message.content[0].text

# 并发执行所有请求

tasks = [process_one(prompt) for prompt in prompts]

results = await asyncio.gather(*tasks)

return results

# 使用示例

prompts = [

"总结这段文字: ...",

"翻译成英文: ...",

"生成标题: ..."

]

results = asyncio.run(process_batch(prompts))

💰 成本优化清单

立即可实施:

- ✅ 启用 Prompt Caching(节省 90%)

- ✅ 使用 Message Batches API(节省 50%)

- ✅ 选择性使用 Extended Thinking(避免不必要的推理成本)

- ✅ 优化

max_tokens参数(避免浪费)

中期优化:

- ✅ 实现智能模型路由(简单任务用 Haiku,复杂任务用 Sonnet)

- ✅ 监控和分析 token 使用模式

- ✅ 优化系统提示词长度

长期策略:

- ✅ 建立成本预警机制

- ✅ 定期评估模型性价比

- ✅ 考虑使用聚合平台的优惠价格

💡 最佳实践建议:要实现最佳的性价比,建议结合使用多种优化策略。根据我们的实践经验,通过 API易 apiyi.com 平台使用 Claude Haiku 4.5,配合 Prompt Caching 和批量处理,可以将整体 API 成本降低至官方直接调用的 30% 左右,同时获得更好的稳定性和技术支持。

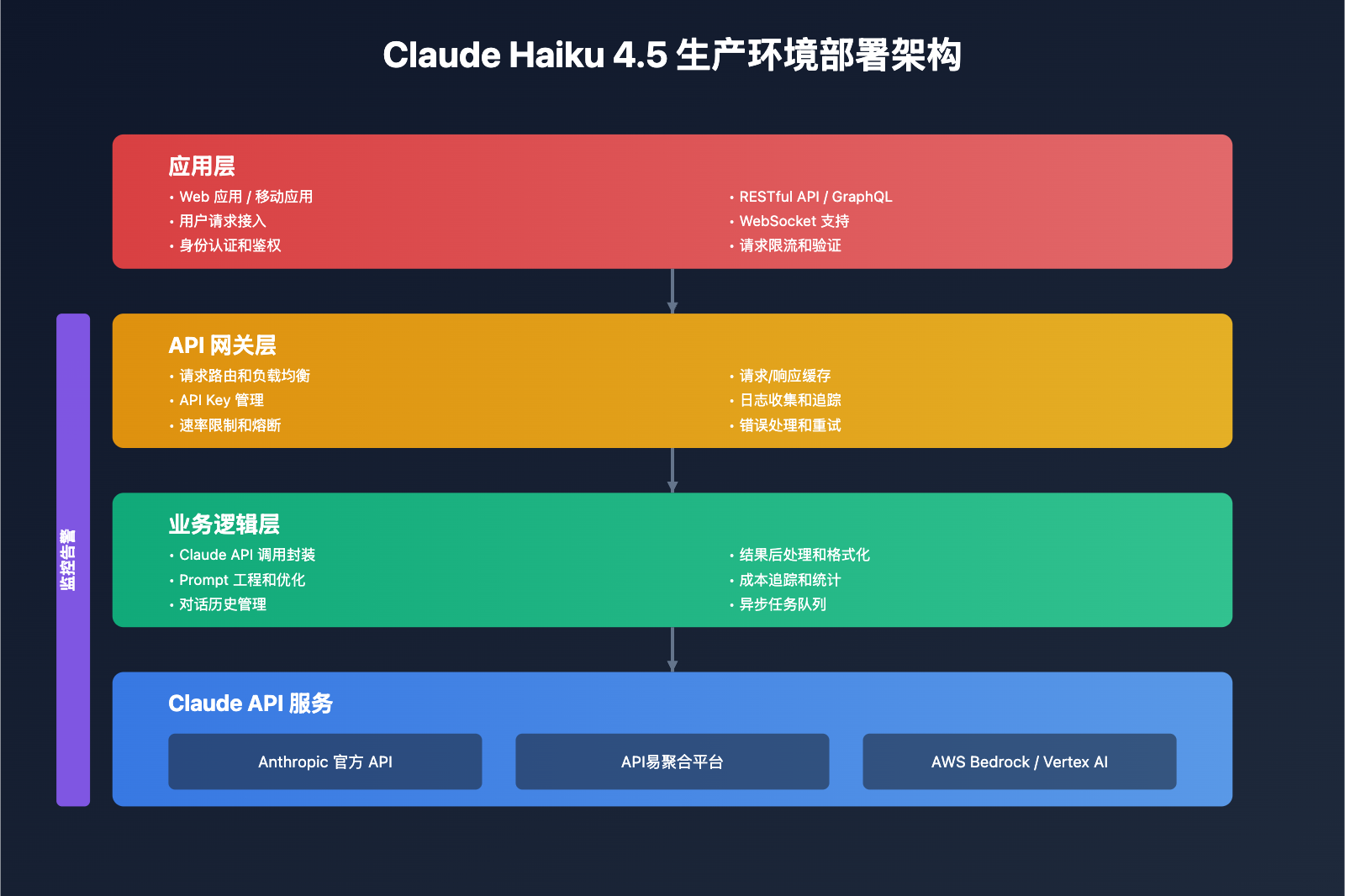

Claude Haiku 4.5 API 生产环境部署建议

将 Claude Haiku 4.5 API 部署到生产环境需要考虑安全性、可靠性和可监控性。

🔐 安全性配置

API Key 管理:

- ✅ 使用环境变量存储,不要硬编码

- ✅ 定期轮换 API Key

- ✅ 为不同环境使用不同的 Key

- ✅ 实施 Key 使用量监控和告警

访问控制:

- ✅ 实现用户级别的速率限制

- ✅ 记录所有 API 调用日志

- ✅ 敏感数据脱敏处理

- ✅ 实施 IP 白名单(如需要)

📊 监控和日志

关键监控指标:

| 指标类型 | 具体指标 | 告警阈值建议 |

|---|---|---|

| 可用性 | API 成功率 | < 99% |

| 性能 | 平均响应时间 | > 3秒 |

| 成本 | 每日 token 消耗 | 超预算 20% |

| 错误 | 5xx 错误率 | > 1% |

| 限流 | 429 错误次数 | > 10次/小时 |

日志记录建议:

import logging

import json

from datetime import datetime

class APILogger:

"""Claude API 调用日志记录器"""

def __init__(self):

self.logger = logging.getLogger("claude_api")

handler = logging.FileHandler("claude_api.log")

handler.setFormatter(logging.Formatter(

'%(asctime)s - %(levelname)s - %(message)s'

))

self.logger.addHandler(handler)

self.logger.setLevel(logging.INFO)

def log_request(self, model: str, messages: list, **kwargs):

"""记录请求"""

log_data = {

"timestamp": datetime.now().isoformat(),

"type": "request",

"model": model,

"message_count": len(messages),

"params": kwargs

}

self.logger.info(json.dumps(log_data))

def log_response(self, response, duration: float, cost: float):

"""记录响应"""

log_data = {

"timestamp": datetime.now().isoformat(),

"type": "response",

"duration_ms": duration * 1000,

"input_tokens": response.usage.input_tokens,

"output_tokens": response.usage.output_tokens,

"estimated_cost": cost,

"success": True

}

self.logger.info(json.dumps(log_data))

def log_error(self, error: Exception, context: dict):

"""记录错误"""

log_data = {

"timestamp": datetime.now().isoformat(),

"type": "error",

"error_type": type(error).__name__,

"error_message": str(error),

"context": context

}

self.logger.error(json.dumps(log_data))

🚀 部署环境建议

开发环境:

- 使用测试 API Key

- 启用详细日志

- 使用较小的 token 限制

预发布环境:

- 与生产环境配置一致

- 进行压力测试

- 验证监控告警

生产环境:

- 使用生产 API Key

- 启用缓存和优化

- 实施完整的监控和告警

- 配置自动重试和熔断

🔧 部署建议:对于企业级应用,我们强烈推荐使用专业的 API 聚合平台如 API易 apiyi.com。该平台提供了开箱即用的监控仪表板、成本分析、自动重试和多节点负载均衡等企业级功能,可以显著降低运维复杂度。同时,平台支持一键切换不同的 API 提供商,在主服务出现问题时可以快速切换到备用服务,保证业务连续性。

❓ Claude Haiku 4.5 API 接入常见问题

Q1: Claude Haiku 4.5 API 接入报 401 认证错误怎么办?

认证错误通常由以下原因引起:

排查步骤:

- 检查 API Key 格式:确保完整复制,无多余空格

- 验证环境变量:使用

echo $ANTHROPIC_API_KEY检查 - 确认账户状态:登录控制台查看账户是否正常

- 检查 API 端点:确认使用正确的 base_url

代码示例:

import os

# 正确的配置方式

api_key = os.getenv("ANTHROPIC_API_KEY")

if not api_key:

raise ValueError("API Key 未设置")

client = anthropic.Anthropic(api_key=api_key)

专业建议:如果使用 API易 apiyi.com 等聚合平台,建议在平台控制台测试 API Key 是否有效,平台提供了便捷的在线测试工具,可以快速验证配置是否正确。

Q2: 如何选择 OpenAI SDK 兼容接入还是官方 SDK?

选择依据主要看你的需求:

选择 OpenAI SDK 兼容接入(推荐用于):

- ✅ 已有 OpenAI API 使用经验

- ✅ 需要在多个模型间快速切换

- ✅ 优先考虑开发速度

- ✅ 不需要 Claude 独有的高级功能

选择 Anthropic 官方 SDK(推荐用于):

- ✅ 需要 Extended Thinking 功能

- ✅ 需要 Context Awareness 功能

- ✅ 需要完整的 Prompt Caching 控制

- ✅ 追求最佳性能和功能完整性

推荐方案:对于快速接入和测试,我们建议先通过 API易 apiyi.com 使用 OpenAI SDK 兼容方式,验证基本功能后,如需使用高级特性再切换到官方 SDK。这种渐进式接入可以最大化开发效率。

Q3: Claude Haiku 4.5 API 响应速度慢怎么优化?

响应速度优化的多个维度:

立即生效的优化:

- ✅ 启用流式输出(显著改善用户体验)

- ✅ 减少

max_tokens设置(降低生成时间) - ✅ 优化提示词长度(减少输入 tokens)

架构级优化:

- ✅ 使用异步调用(提升并发处理能力)

- ✅ 实施请求缓存(相同请求直接返回)

- ✅ 选择地理位置最近的 API 节点

服务商选择:

- ✅ 对比不同服务商的响应延迟

- ✅ 选择有多节点部署的平台

- ✅ 考虑使用负载均衡的聚合服务

测试建议:我们建议通过 API易 apiyi.com 进行实际的性能测试。该平台提供了详细的响应时间统计和多节点支持,可以帮你找到最优的服务配置。

Q4: 如何降低 Claude Haiku 4.5 API 调用成本?

成本优化是长期关注的重点:

高优先级措施(节省 70-90%):

- 启用 Prompt Caching:对重复的系统提示和上下文缓存

- 使用 Message Batches API:批量处理请求节省 50%

- 优化提示词:精简不必要的描述和示例

中等优先级措施(节省 20-30%):

- 智能模型路由:简单任务用 Haiku,复杂任务用 Sonnet

- 控制输出长度:合理设置

max_tokens - 选择性使用 Extended Thinking:仅在必要时启用

长期策略:

- 监控 token 使用:建立成本追踪和预警

- 定期评估:对比不同服务商价格

- 批量采购:选择有优惠的聚合平台

成本优化建议:根据我们的实践经验,通过 API易 apiyi.com 使用 Claude Haiku 4.5,配合平台提供的成本分析工具和优化建议,可以将整体成本控制在官方直接调用的 30-40% 水平,同时获得更好的服务稳定性。

Q5: Extended Thinking 功能什么时候值得使用?

Extended Thinking 会增加 token 消耗,需要权衡使用:

推荐使用场景:

- ✅ 复杂的代码审查和优化建议

- ✅ 多步骤的逻辑推理任务

- ✅ 需要深度分析的技术问题

- ✅ 数学和科学计算问题

不建议使用场景:

- ❌ 简单的文本生成

- ❌ 基础的问答任务

- ❌ 代码格式化等机械性任务

- ❌ 成本敏感的高并发场景

配置建议:

- 复杂任务:

budget_tokens: 20000-50000 - 中等任务:

budget_tokens: 10000 - 测试调试:启用

return_thinking查看推理过程

使用建议:建议先在小规模测试中评估 Extended Thinking 对你的任务是否有明显提升,如果性能提升不明显,可以关闭以节省成本。你可以通过 API易 apiyi.com 的 A/B 测试功能快速对比开启和关闭 Extended Thinking 的效果差异。

📚 延伸阅读

🛠️ 开源资源

Claude Haiku 4.5 API 接入的完整示例代码已开源,涵盖多种实用场景:

最新示例:

- Claude Haiku 4.5 聊天机器人完整实现

- Extended Thinking 高级用法示例

- Prompt Caching 成本优化实战

- 流式输出最佳实践

- 错误处理和重试框架

- 生产环境部署配置模板

- 性能监控和日志系统

📖 学习建议:对于 Claude Haiku 4.5 API 接入的初学者,我们建议从简单的 OpenAI SDK 兼容方式开始,逐步过渡到官方 SDK 的高级功能。你可以访问 API易 apiyi.com 获取免费的开发者账号和测试额度,通过实际调用来加深理解。平台提供了丰富的代码示例、视频教程和实战案例。

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 官方文档 | Anthropic API 参考文档 | docs.claude.com |

| 社区资源 | API易 Claude 使用指南 | help.apiyi.com |

| 视频教程 | Claude Haiku 4.5 快速上手 | 技术社区 YouTube |

| 技术博客 | AI 开发最佳实践 | 各大技术社区 |

深入学习建议:持续关注 Claude 模型的更新和新功能,我们推荐定期访问 API易 help.apiyi.com 的技术博客,了解最新的 API 接入技巧、性能优化方案和成本控制策略,保持技术领先优势。

🎯 总结

本文详细介绍了 Claude Haiku 4.5 API 接入的完整流程,从环境准备到生产部署,涵盖了开发者需要掌握的所有核心知识点。

重点回顾:Claude Haiku 4.5 提供了两种主流接入方式——OpenAI SDK 兼容接入和 Anthropic 官方 SDK,前者适合快速上手,后者提供完整功能支持。

在实际应用中,建议:

- 优先选择稳定可靠的 API 聚合平台

- 做好完善的错误处理和重试机制

- 根据场景灵活启用高级功能

- 持续监控性能和成本优化

最终建议:对于企业级应用和生产环境部署,我们强烈推荐使用 API易 apiyi.com 这类专业的 API 聚合平台。它不仅提供了 OpenAI SDK 兼容接口和原生 Claude API 支持,还集成了自动重试、负载均衡、成本分析、性能监控等企业级功能,能够显著降低开发和运维成本。平台支持一键切换多个 AI 模型,让你可以根据不同场景选择最合适的模型,实现性能和成本的最佳平衡。

📝 作者简介:资深 AI 应用开发者,专注大模型 API 集成与架构设计。定期分享 Claude 和其他 AI 模型的开发实践经验,更多技术资料和最佳实践案例可访问 API易 apiyi.com 技术社区。

🔔 技术交流:欢迎在评论区讨论 Claude Haiku 4.5 API 接入的技术问题,持续分享 AI 开发经验和行业动态。如需深入技术支持,可通过 API易 apiyi.com 联系我们的技术团队。