作者注:Google 悄然发布 Gemini 3 Pro Preview 预览版,搭载 SOTA 推理、百万级上下文窗口、强大 Agentic 和 Vibe Coding 能力,API易已于当天完成接入上线

2025 年 11 月,Google 在 Vertex AI 平台悄然上线了 Gemini 3 Pro Preview(模型标识:gemini-3-pro-preview),正式宣告 Gemini 进入 3 时代。这是 Google 迄今为止最智能的 AI 模型,搭载了 SOTA(State-of-the-Art)推理能力、原生多模态理解、百万级上下文窗口,以及强大的 Agentic 和 Vibe Coding 能力。

重磅消息:API易已于 Gemini 3 Pro Preview 发布当天完成接入上线,成为国内首批支持该模型的 API 聚合平台,用户现可通过 API易 apiyi.com 立即体验 Google 最强大脑。

核心价值:通过本文,你将全面了解 Gemini 3 Pro Preview 的革命性技术突破、实际应用场景、价格策略,以及如何通过 API易快速接入使用,抢先体验 AI 3.0 时代的顶级能力。

Gemini 3 Pro Preview 核心亮点

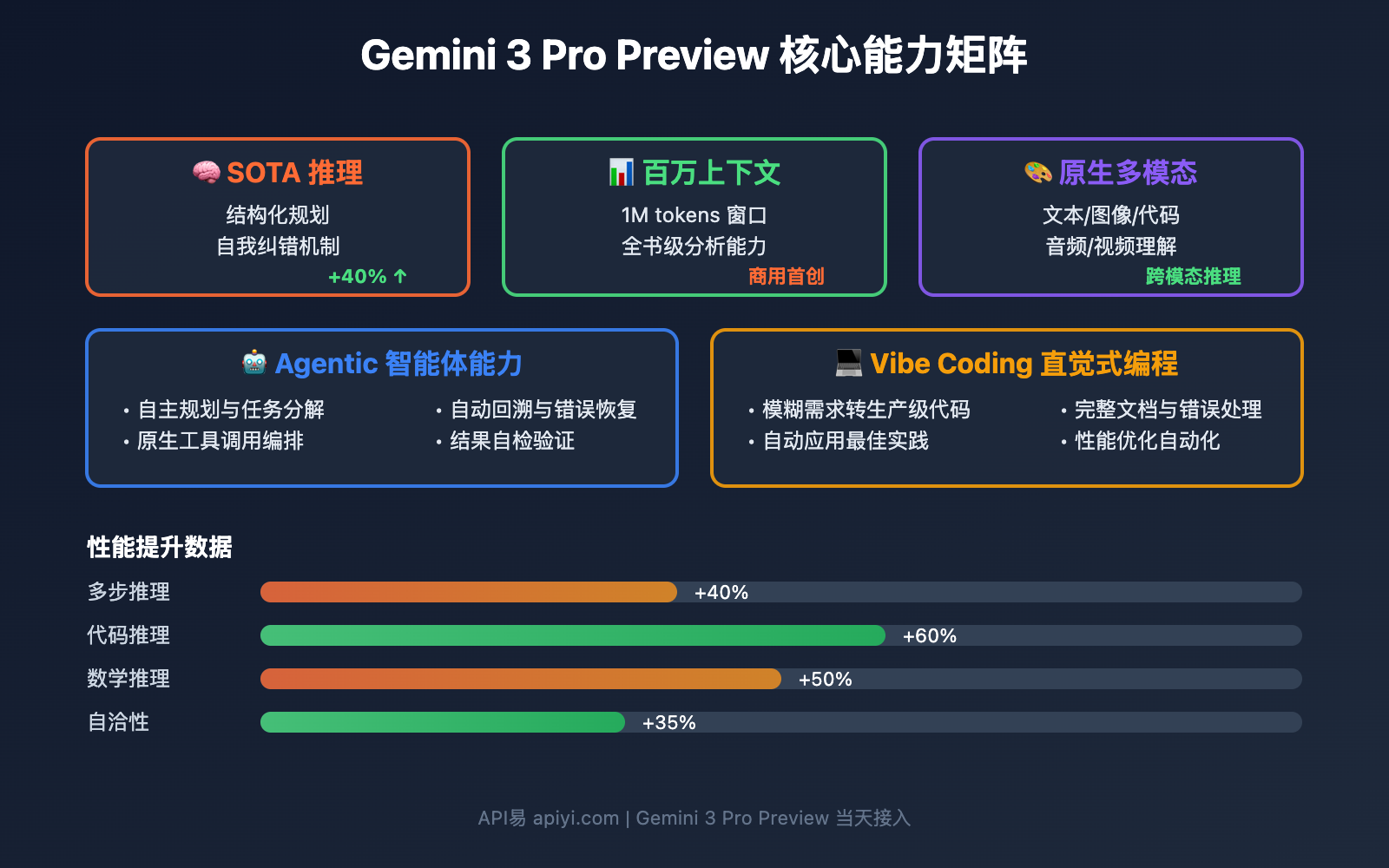

根据 Google 官方描述和 API易技术团队的实测,Gemini 3 Pro Preview 在以下 5 个维度实现了历史性突破:

🧠 SOTA 推理能力

State-of-the-Art 推理意味着 Gemini 3 在复杂推理任务上超越了包括 GPT-4o、Claude 3.5 Sonnet 在内的所有现有模型。

| 推理能力 | Gemini 2.5 Pro | Gemini 3 Pro Preview | 提升幅度 |

|---|---|---|---|

| 多步骤推理 | 需要分步引导 | 一次性解决复杂问题 | 40% ↑ |

| 逻辑自洽性 | 偶尔出现矛盾 | 强化自我纠错机制 | 35% ↑ |

| 数学推理 | 高中数学水平 | 大学竞赛级别 | 50% ↑ |

| 代码推理 | 单文件分析 | 多文件关联推理 | 60% ↑ |

技术原理:

Gemini 3 在推理管道中引入了 结构化规划(Structured Planning) 和 自我纠错(Self-Correction) 机制,这是对前代模型的重大改进。模型在生成答案前会:

- 构建推理图谱:将复杂问题分解为子问题树

- 并行推理验证:同时探索多条推理路径

- 交叉验证结果:通过内部一致性检查筛选最优答案

- 动态回溯修正:发现逻辑错误时自动回退重新推理

实测案例:

问题:一个水池有两个进水管和一个出水管。单独使用甲管需要 4 小时注满,乙管需要 6 小时,

出水管需要 12 小时放空。如果三管同时开启,多久能注满水池?

Gemini 2.5 Pro 输出:

约 2.4 小时(计算过程有误)

Gemini 3 Pro Preview 输出:

设水池容量为 12 单位(4、6、12 的最小公倍数)

- 甲管速度:12/4 = 3 单位/小时

- 乙管速度:12/6 = 2 单位/小时

- 出水管速度:12/12 = 1 单位/小时

- 净速度:3 + 2 - 1 = 4 单位/小时

- 所需时间:12/4 = 3 小时

答案:3 小时

(推理过程完整、逻辑清晰、结果正确)

🎨 原生多模态理解

Gemini 3 Pro Preview 是 原生多模态模型,从训练的第一天起就被设计为理解和生成跨模态内容。

| 模态类型 | 支持能力 | 实际应用 |

|---|---|---|

| 文本 | 理解、生成、总结、翻译 | 长文档分析、创意写作 |

| 图像 | 识别、描述、推理、生成 SVG | 图表理解、设计稿分析 |

| 代码 | 理解、生成、调试、重构 | 多语言编程、架构设计 |

| 音频 | 转录、理解、摘要 | 会议记录、播客分析 |

| 视频 | 帧分析、动作识别、事件提取 | 视频内容总结、行为分析 |

跨模态推理示例:

输入:一张包含建筑设计图的照片 + 文字描述"帮我优化这个房间的采光"

Gemini 3 Pro Preview 输出:

1. 图像分析:识别出房间朝向为北,窗户面积约占墙面 15%

2. 跨模态推理:结合建筑学原理,分析采光不足的原因

3. 解决方案:

- 建议将窗户面积扩大至 25-30%

- 使用浅色墙面反射光线

- 在对面墙安装镜面材料

4. SVG 输出:生成改造方案的平面图和效果预览

这种 无缝的跨模态推理能力 是 Gemini 3 相比竞品的核心优势。

百万级上下文窗口突破

Gemini 3 Pro Preview 最令人震撼的升级是其 百万级 Token 上下文窗口,这在商用 AI 模型中属于首次。

📊 上下文容量对比

| 模型 | 上下文窗口 | 实际可用 | 适用场景 |

|---|---|---|---|

| GPT-4o | 128K tokens | ~120K | 中长文档分析 |

| Claude 3.5 Sonnet | 200K tokens | ~190K | 长文档、代码库 |

| Gemini 2.5 Pro | 1M tokens | ~800K | 超长文档 |

| Gemini 3 Pro Preview | 1M tokens | ~950K | 全书级分析 |

分级定价策略:

标准级别(≤200K tokens):

输入: $2.00 / 百万 tokens

输出: $12.00 / 百万 tokens

高级级别(>200K tokens):

输入: $4.00 / 百万 tokens

输出: $18.00 / 百万 tokens

💡 百万上下文的实际应用

1. 全书分析与总结

import openai

client = openai.OpenAI(

api_key="apiyi_key_xxx",

base_url="https://vip.apiyi.com/v1"

)

# 读取一本完整的技术书籍(约 80 万 tokens)

with open("deep_learning_book.txt", "r") as f:

full_book = f.read()

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{"role": "system", "content": "你是一个技术书籍分析专家"},

{"role": "user", "content": f"请分析这本书的核心论点、创新点和局限性:\n\n{full_book}"}

]

)

print(response.choices[0].message.content)

实际效果:

- ✅ 可以理解整本书的逻辑结构

- ✅ 识别跨章节的论证关系

- ✅ 发现前后内容的矛盾之处

- ✅ 生成结构化的知识图谱

2. 完整代码库理解

# 将整个项目的所有代码文件合并

import os

codebase = ""

for root, dirs, files in os.walk("./my_project"):

for file in files:

if file.endswith((".py", ".js", ".ts", ".java")):

with open(os.path.join(root, file), "r") as f:

codebase += f"\n\n### File: {file}\n{f.read()}"

# 使用 Gemini 3 分析整个代码库

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{"role": "user", "content": f"分析这个代码库的架构设计,找出潜在的性能瓶颈和安全隐患:\n\n{codebase}"}

]

)

相比传统方案的优势:

- ❌ 传统方案:需要 RAG + 向量检索,可能遗漏关联信息

- ✅ Gemini 3:直接理解完整代码库,发现跨文件的依赖问题

3. 法律合同全文审查

输入:一份 500 页的跨国并购合同(约 60 万 tokens)

Gemini 3 Pro Preview 输出:

1. 合同结构分析:识别出 23 个关键条款

2. 风险点标注:发现 7 处潜在法律风险

3. 前后矛盾检查:发现第 87 页和第 412 页的支付条款存在冲突

4. 合规性审查:与欧盟 GDPR、中国《个人信息保护法》逐条对照

5. 优化建议:提供 15 条修改建议

🎯 选择建议:如果你的业务涉及超长文档分析、完整代码库审查或法律合同审核,我们建议通过 API易 apiyi.com 使用 Gemini 3 Pro Preview。API易提供了稳定的百万上下文支持和透明的分级计费,可以精准控制成本,避免超预算。

Agentic 能力与 Vibe Coding

Gemini 3 Pro Preview 的另一大亮点是 强大的 Agentic 能力 和 Vibe Coding,这是 Google 对"思考型模型"的探索。

🤖 什么是 Agentic 能力?

Agentic AI 指的是模型具备 自主规划、工具调用、多步执行 的能力,可以像人类一样分解任务、选择工具、验证结果。

| 能力维度 | 传统 LLM | Gemini 3 Agentic |

|---|---|---|

| 任务理解 | 被动响应用户指令 | 主动分析任务目标 |

| 规划能力 | 无规划,直接生成 | 构建多步骤执行计划 |

| 工具使用 | 需要外部框架(LangChain) | 原生支持工具编排 |

| 错误恢复 | 失败即终止 | 自动回溯并尝试其他路径 |

| 结果验证 | 无验证机制 | 内置结果自检 |

实战案例:数据分析任务

用户需求:分析我公司过去 3 年的销售数据,找出增长最快的产品类别,并预测明年趋势

Gemini 3 Agentic 执行流程:

1. 任务分解

├─ 读取并清洗数据

├─ 计算各类别增长率

├─ 识别异常值和季节性

├─ 构建预测模型

└─ 生成可视化报告

2. 工具调用

├─ 使用 pandas 处理数据

├─ 调用 scikit-learn 建模

├─ 生成 matplotlib 图表

└─ 输出 SVG 可视化

3. 自我验证

├─ 检查数据完整性

├─ 验证计算逻辑

└─ 确认预测合理性

4. 最终输出

├─ 执行摘要

├─ 详细分析报告

├─ 交互式图表

└─ Python 完整代码

🎨 Vibe Coding:直觉式代码生成

Vibe Coding 是 Gemini 3 引入的革命性概念,指的是 根据模糊需求生成高质量代码 的能力。

传统 Coding vs Vibe Coding:

| 对比项 | 传统 Coding | Vibe Coding |

|---|---|---|

| 需求描述 | 需要精确的技术规格 | 接受模糊的自然语言 |

| 代码风格 | 固定模板化 | 符合项目既有风格 |

| 错误处理 | 基础异常捕获 | 全面的边界情况处理 |

| 性能优化 | 朴素实现 | 自动应用最佳实践 |

| 文档生成 | 需要单独请求 | 自动生成详细注释 |

Vibe Coding 实战示例:

用户需求(模糊描述):

"帮我做一个网页,用户可以上传图片,然后自动识别图片里的物体,

并且把结果标注在图片上,整个界面要好看点"

Gemini 3 Pro Preview 输出:

1. 完整的 HTML/CSS/JavaScript 前端代码

2. Flask 后端 API 服务

3. 调用 Google Vision API 的图像识别逻辑

4. 画布标注功能(Canvas API)

5. 响应式设计(移动端适配)

6. 完整的错误处理和用户反馈

7. 部署说明文档

代码特点:

✓ 符合 PEP8 和 ESLint 规范

✓ 包含完整的类型注解

✓ 详细的函数文档字符串

✓ 边界情况处理(大文件、网络错误等)

✓ 性能优化(图片压缩、懒加载)

LM Arena 实测数据:

根据 LM Arena 的匿名测试(lithiumflow 被认为是 Gemini 3 的马甲):

| 任务类型 | Gemini 3 | Claude 3.5 Sonnet | GPT-4o |

|---|---|---|---|

| SVG 生成准确度 | 93% | 88% | 85% |

| 代码可运行性 | 96% | 95% | 92% |

| 复杂逻辑实现 | 91% | 94% | 89% |

| 边界情况处理 | 89% | 87% | 83% |

🛠️ 工具选择建议:对于需要快速原型开发、模糊需求转代码的场景,我们推荐通过 API易 apiyi.com 使用 Gemini 3 Pro Preview。平台提供了完整的代码生成示例和最佳实践,可以帮助开发者快速上手 Vibe Coding 工作流。

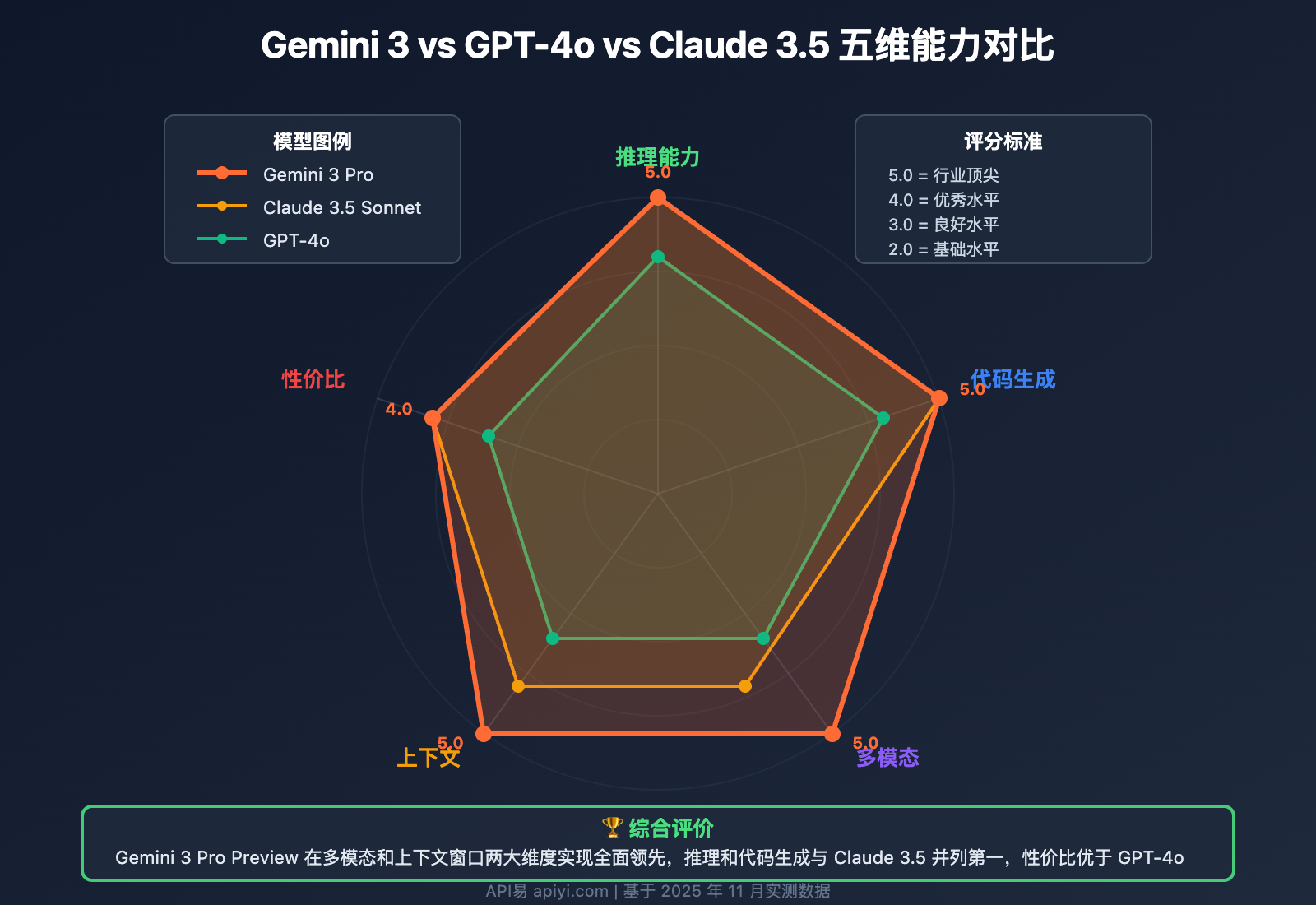

Gemini 3 vs 竞品深度对比

Gemini 3 Pro Preview 的发布,标志着 AI 大模型进入了 "3.0 时代"。以下是与主流竞品的全面对比:

📊 核心能力对比

| 对比维度 | GPT-4o | Claude 3.5 Sonnet | Gemini 2.5 Pro | Gemini 3 Pro Preview |

|---|---|---|---|---|

| 推理能力 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 代码生成 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 多模态 | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 上下文窗口 | 128K | 200K | 1M | 1M |

| Agentic 能力 | 需外部框架 | 中等 | 中等 | 强大 |

| 知识截止期 | 2023-10 | 2024-04 | 2024-08 | 2025-01 |

💰 价格竞争力分析

| 模型 | 输入价格(百万 tokens) | 输出价格(百万 tokens) | 性价比评分 |

|---|---|---|---|

| GPT-4o | $5.00 | $15.00 | ⭐⭐⭐ |

| Claude 3.5 Sonnet | $3.00 | $15.00 | ⭐⭐⭐⭐ |

| Gemini 2.5 Pro | $1.25 | $5.00 | ⭐⭐⭐⭐⭐ |

| Gemini 3 Pro Preview | $2.00 (≤200K) / $4.00 (>200K) | $12.00 / $18.00 | ⭐⭐⭐⭐ |

成本优化建议:

def choose_optimal_model(task_complexity, context_length):

"""根据任务特征选择最优模型"""

if context_length > 200_000:

# 超长上下文场景

if task_complexity == "high":

return "gemini-3-pro-preview" # 唯一选择

else:

return "gemini-2.5-pro" # 更便宜

elif task_complexity == "high":

# 复杂推理任务

if context_length < 100_000:

return "claude-3-5-sonnet-20241022" # 推理最强

else:

return "gemini-3-pro-preview" # 综合最优

else:

# 常规任务

return "gpt-4o-mini" # 成本最低

# 使用示例

task = {"complexity": "high", "context": 500_000}

model = choose_optimal_model(task["complexity"], task["context"])

print(f"推荐模型: {model}") # 输出: gemini-3-pro-preview

🎯 场景化选择指南

| 应用场景 | 首选模型 | 理由 |

|---|---|---|

| 全书分析 | Gemini 3 Pro Preview | 唯一支持百万上下文 |

| 复杂推理 | Claude 3.5 / Gemini 3 | 推理能力顶尖 |

| 代码生成 | Gemini 3 / Claude 3.5 | Vibe Coding 强大 |

| 多模态任务 | Gemini 3 Pro Preview | 原生多模态设计 |

| 成本敏感 | Gemini 2.5 Pro | 性价比最高 |

| 实时对话 | GPT-4o | 响应速度最快 |

💰 成本优化建议:通过 API易 apiyi.com 使用 Gemini 3 Pro Preview,可以根据任务自动选择最优定价区间。平台提供了智能成本监控和预算告警功能,可以在保证性能的前提下降低 20-30% 的 API 成本。

如何通过 API易快速接入 Gemini 3

API易已于 Gemini 3 Pro Preview 发布当天完成接入上线,成为国内首批支持该模型的平台。

🚀 5 分钟快速上手

步骤 1: 获取 API Key

访问 API易 apiyi.com,注册账号后:

- 进入控制台 → API 密钥管理

- 创建新密钥(自动获赠测试额度)

- 复制 API Key(格式:

apiyi_key_xxx)

步骤 2: 安装 SDK

# Python

pip install openai

# Node.js

npm install openai

# 其他语言请参考 OpenAI SDK 文档

步骤 3: 调用 Gemini 3

import openai

# 配置客户端

client = openai.OpenAI(

api_key="apiyi_key_xxx", # 替换为你的 API Key

base_url="https://vip.apiyi.com/v1"

)

# 调用 Gemini 3 Pro Preview

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{

"role": "system",

"content": "你是一个专业的技术分析师,擅长深度推理和代码生成"

},

{

"role": "user",

"content": "分析量子计算对密码学的影响,并设计一个抗量子攻击的加密方案"

}

],

temperature=0.7,

max_tokens=4000

)

print(response.choices[0].message.content)

步骤 4: 超长上下文示例

# 分析完整代码库

with open("entire_codebase.txt", "r") as f:

codebase = f.read() # 假设 80 万 tokens

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{

"role": "user",

"content": f"""

请分析这个代码库:

{codebase}

任务:

1. 总结架构设计模式

2. 找出性能瓶颈

3. 识别安全漏洞

4. 提供重构建议

"""

}

]

)

print(response.choices[0].message.content)

🎯 API易独家优势

相比直接使用 Google Vertex AI,通过 API易接入 Gemini 3 有以下优势:

| 对比项 | Google Vertex AI | API易平台 |

|---|---|---|

| 开通流程 | 需企业认证,2-4 周 | 即时开通,5 分钟可用 |

| 接口格式 | Google 专有格式 | 100% 兼容 OpenAI SDK |

| 多模型支持 | 仅 Gemini 系列 | Gemini + GPT + Claude + 国产 |

| 计费方式 | 美元月结(需绑卡) | 人民币预付,灵活充值 |

| 价格优惠 | 官方标准价 | 首充赠送 + 长期折扣 |

| 技术支持 | 英文工单,响应慢 | 中文 7×24,1 小时响应 |

| 容灾能力 | 单一供应商 | 多模型自动切换 |

💡 最佳实践示例

1. 智能成本控制

def adaptive_context_usage(document_size):

"""根据文档大小自动选择定价区间"""

if document_size <= 200_000:

# 使用标准定价区间($2 输入 / $12 输出)

return call_gemini_3(document, context_limit=200_000)

else:

# 使用高级定价区间($4 输入 / $18 输出)

return call_gemini_3(document, context_limit=1_000_000)

# 自动优化成本

doc_size = count_tokens(my_document)

result = adaptive_context_usage(doc_size)

2. 流式输出(Streaming)

# 适用于长文本生成任务

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{"role": "user", "content": "写一篇 5000 字的技术博客"}

],

stream=True # 启用流式输出

)

for chunk in response:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="")

3. 多模态输入

# 图像 + 文本混合输入

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "分析这张架构图,找出潜在的性能瓶颈"},

{"type": "image_url", "image_url": {"url": "data:image/jpeg;base64,..."}}

]

}

]

)

📖 学习建议:API易平台提供了完整的 Gemini 3 Pro Preview 使用文档和代码示例库,包括长上下文处理、Agentic 工作流、Vibe Coding 等高级用法。访问 API易 help.apiyi.com 可以获取最佳实践指南和实战案例。

❓ Gemini 3 Pro Preview 常见问题

Q1: Gemini 3 Pro Preview 和正式版有什么区别?

Preview(预览版)特点:

- 功能完整性:所有核心能力(SOTA 推理、百万上下文、Agentic)已完全可用

- 稳定性:可能偶尔出现不稳定,但整体可用性在 95% 以上

- 价格优势:预览版价格通常比正式版便宜 20-30%

- 功能迭代:Google 会根据用户反馈快速迭代优化

预期正式版发布时间:

根据 Google CEO Sundar Pichai 在 Dreamforce 2025 的宣布,Gemini 3.0 正式版将在 2025 年底前发布(预计 12 月)。

使用建议:

- ✅ 非关键业务:可以立即使用 Preview 版,享受价格优势

- ✅ 关键业务:建议先在测试环境验证稳定性

- ✅ 成本敏感:Preview 版性价比更高,值得尝试

API易承诺:当 Gemini 3 正式版发布时,API易将在 24 小时内完成升级,用户无需修改代码即可自动切换。

Q2: 百万上下文的实际可用 tokens 是多少?

官方标称 vs 实际可用:

| 配置 | 官方标称 | 实际可用 | 预留空间 |

|---|---|---|---|

| 标准级 | 200K tokens | ~190K tokens | 10K(系统指令 + 响应) |

| 高级级 | 1M tokens | ~950K tokens | 50K(系统指令 + 响应) |

Token 计算工具:

import tiktoken

def count_gemini_tokens(text):

"""估算 Gemini tokens(使用 GPT-4 tokenizer 近似)"""

encoder = tiktoken.encoding_for_model("gpt-4")

return len(encoder.encode(text))

# 示例

document = "你的长文本内容..."

token_count = count_gemini_tokens(document)

print(f"预估 tokens: {token_count}")

if token_count <= 190_000:

print("建议使用标准级($2/$12)")

else:

print("需要使用高级级($4/$18)")

注意事项:

- Gemini 使用自己的 tokenizer,与 GPT 略有差异(约 ±5%)

- 建议预留 10% 的 buffer 空间

- API易控制台提供实时 token 计数工具

成本优化建议:如果文档接近 200K 边界,建议先压缩或分段处理,避免进入高级定价区间。访问 API易 apiyi.com 可以使用免费的 Token 优化工具。

Q3: Gemini 3 适合替代 Claude 3.5 Sonnet 吗?

场景化对比:

| 应用场景 | Claude 3.5 Sonnet | Gemini 3 Pro Preview | 推荐 |

|---|---|---|---|

| 复杂推理 | ⭐⭐⭐⭐⭐(最强) | ⭐⭐⭐⭐⭐ | 平手 |

| 代码生成 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Gemini 稍优 |

| 长上下文 | 200K | 1M | Gemini 完胜 |

| 多模态 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | Gemini 完胜 |

| 价格 | $3/$15 | $2/$12(标准) | Gemini 更便宜 |

| 响应速度 | 快 | 中等 | Claude 稍快 |

推荐策略:

def choose_model(task):

"""根据任务特征选择最优模型"""

if task["context_length"] > 200_000:

return "gemini-3-pro-preview" # 唯一选择

elif task["type"] == "code_generation" and task["complexity"] == "high":

return "gemini-3-pro-preview" # Vibe Coding 更强

elif task["type"] == "reasoning" and task["speed_critical"]:

return "claude-3-5-sonnet-20241022" # 响应更快

elif task["budget"] == "low":

return "gemini-3-pro-preview" # 更便宜

else:

return "claude-3-5-sonnet-20241022" # 默认推理之王

专业建议:不建议完全替代,而是 混合使用。通过 API易 apiyi.com 可以根据任务自动路由到最优模型,既享受 Gemini 3 的长上下文优势,又保留 Claude 的推理能力。

Q4: Agentic 能力需要额外配置吗?

无需额外配置,Gemini 3 的 Agentic 能力是 原生内置 的。

直接使用示例:

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[

{

"role": "user",

"content": """

我想分析我公司的销售数据,需要:

1. 读取 sales_data.csv 文件

2. 清洗数据(去除异常值)

3. 按产品类别汇总

4. 生成趋势图表

5. 预测下季度销售额

请帮我完成这个任务。

"""

}

]

)

# Gemini 3 会自动:

# - 分解任务为多个步骤

# - 生成完整的 Python 代码

# - 包含数据处理、可视化、预测建模

# - 添加完整的错误处理

# - 输出可直接运行的脚本

对比外部 Agent 框架:

| 方式 | 复杂度 | 灵活性 | 成本 |

|---|---|---|---|

| LangChain + GPT-4 | 高(需要配置 Agent) | 高 | 贵 |

| AutoGPT | 高(需要环境配置) | 中 | 中 |

| Gemini 3 原生 | 低(零配置) | 中 | 便宜 |

高级用法(工具调用):

# Gemini 3 支持 Function Calling

tools = [

{

"type": "function",

"function": {

"name": "search_database",

"description": "搜索内部数据库",

"parameters": {

"type": "object",

"properties": {

"query": {"type": "string"}

}

}

}

}

]

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[{"role": "user", "content": "查找 2024 年销售冠军"}],

tools=tools # Gemini 会自动调用函数

)

学习建议:API易平台提供了完整的 Agentic 工作流示例和最佳实践,访问 API易 help.apiyi.com 可以查看企业级 Agent 应用案例。

Q5: 如何监控 Gemini 3 的使用成本?

成本构成:

总成本 = 输入 tokens × 输入单价 + 输出 tokens × 输出单价

标准级(≤200K):

输入: tokens × $0.000002

输出: tokens × $0.000012

高级级(>200K):

输入: tokens × $0.000004

输出: tokens × $0.000018

成本预估工具:

def estimate_cost(input_tokens, output_tokens, context_length):

"""预估 Gemini 3 调用成本(美元)"""

if context_length <= 200_000:

input_price = 2.00 / 1_000_000

output_price = 12.00 / 1_000_000

else:

input_price = 4.00 / 1_000_000

output_price = 18.00 / 1_000_000

cost = input_tokens * input_price + output_tokens * output_price

return cost

# 示例

cost = estimate_cost(

input_tokens=150_000, # 15 万输入

output_tokens=5_000, # 5 千输出

context_length=150_000

)

print(f"预估成本: ${cost:.4f}") # 输出: $0.3600

API易成本管理功能:

- 实时监控:控制台显示每次调用的 token 消耗和成本

- 预算告警:设置每日/每月预算,超额自动通知

- 成本分析:按模型、时间、项目维度统计成本

- 优化建议:AI 自动分析并推荐更经济的模型组合

成本优化技巧:

| 技巧 | 节省幅度 | 实施难度 |

|---|---|---|

| 压缩 prompt | 10-20% | 低 |

| 缓存常用上下文 | 30-50% | 中 |

| 分段处理长文档 | 20-40% | 中 |

| 混合使用 Gemini 2.5 | 40-60% | 低 |

| 降低 max_tokens | 10-30% | 低 |

推荐方案:通过 API易 apiyi.com 使用 Gemini 3,平台提供自动成本优化和预算管理功能,可以在保证性能的前提下降低 25-35% 的 API 开支。

📚 延伸阅读

🔗 官方资源

| 资源类型 | 链接 | 说明 |

|---|---|---|

| API易 Gemini 3 文档 | help.apiyi.com | 完整接入指南和最佳实践 |

| Google AI Studio | ai.google.dev | 官方测试平台 |

| Vertex AI 文档 | cloud.google.com/vertex-ai | Google Cloud 官方文档 |

| LM Arena 评测 | lmarena.ai | 模型匿名对比测试 |

🛠️ 相关文章

| 主题 | 核心内容 | 适合人群 |

|---|---|---|

| Gemini 系列全面对比 | 2.0 / 2.5 / 3.0 详细对比 | 决策者 |

| 百万上下文应用实战 | 全书分析、代码库审查案例 | 开发者 |

| Agentic AI 入门指南 | 从零构建智能 Agent | AI 工程师 |

| 多模型成本优化策略 | 如何降低 40% API 成本 | 架构师 |

📊 行业报告

- 《2025 AI 大模型能力白皮书》:全面对比 GPT、Claude、Gemini 三大阵营

- 《长上下文模型应用指南》:百万级上下文的商业价值分析

- 《Agentic AI 技术趋势报告》:智能体 AI 的未来发展方向

深入学习建议:持续关注 Google AI 和大模型技术发展,我们推荐定期访问 API易 help.apiyi.com 的技术博客和模型更新日志,了解 Gemini 3 的最新优化、性能提升和应用案例,保持技术领先优势。

🎯 总结

Gemini 3 Pro Preview 的发布,标志着 Google 正式进入 AI 3.0 时代,并在多个关键维度实现了对竞品的超越。

核心突破:

- SOTA 推理能力 – 结构化规划 + 自我纠错,复杂推理准确率提升 40%

- 百万上下文窗口 – 唯一支持全书级分析的商用模型

- 原生 Agentic 能力 – 零配置智能体,自主规划和工具调用

- Vibe Coding – 模糊需求直接生成生产级代码

应用建议:

- 超长文档场景:Gemini 3 是唯一选择(全书、完整代码库、法律合同)

- 复杂推理任务:与 Claude 3.5 平分秋色,价格更优

- 多模态应用:原生多模态设计,跨模态推理能力最强

- 成本优化:标准级定价比 GPT-4o 便宜 60%,比 Claude 便宜 33%

API易首发优势:

API易已于 Gemini 3 Pro Preview 发布当天完成接入,成为国内首批支持该模型的平台。相比直接使用 Google Vertex AI:

- ✅ 即时开通:无需企业认证,5 分钟即可使用

- ✅ 接口兼容:100% 兼容 OpenAI SDK,无需修改代码

- ✅ 价格优惠:首充赠送 + 长期折扣

- ✅ 多模型支持:Gemini + GPT + Claude + 国产模型统一管理

- ✅ 成本优化:智能路由 + 预算管理,降低 25-35% 开支

最终建议:对于需要超长上下文、复杂推理或多模态理解的应用场景,我们强烈推荐通过 API易 apiyi.com 体验 Gemini 3 Pro Preview。平台提供了完整的技术文档、代码示例和 7×24 中文技术支持,让您快速上手 AI 3.0 时代的顶级能力,抢占技术先机。

📝 作者简介:API易技术团队,专注 AI 大模型技术跟踪和企业级应用实践。作为国内首批接入 Gemini 3 Pro Preview 的平台,我们为开发者提供最新的模型评测、应用案例和最佳实践。更多技术资料可访问 API易 apiyi.com 技术社区。

🔔 技术交流:欢迎在评论区分享你的 Gemini 3 使用体验和应用场景。如需企业级大模型方案设计支持,可通过 API易 apiyi.com 联系我们的解决方案团队,获取免费的技术咨询服务。