作者注:深度分析 OpenClaw 高 Token 消耗的 6 大原因,提供實測有效的優化策略,幫助用戶將 API 成本降低 60-80%,附 API易充值加贈省錢方案

"一個月燒掉 180 萬 Token,賬單 3600 美元" —— 這是科技博主 Federico Viticci 使用 OpenClaw 的真實經歷。OpenClaw 雖然開源免費,但 Token 消耗速度之快 讓很多用戶措手不及。本文將深度分析 OpenClaw 費 Token 的 6 大原因,並提供經過實測的省錢攻略。

核心價值: 讀完本文,你將理解 OpenClaw 高消耗的技術原理,掌握 6 種有效的優化方法,並瞭解如何通過 API易 充值加贈活動將成本降至官網 9 折以下。

OpenClaw Token 消耗核心數據

| 用戶類型 | 月均 Token | 月均成本 | 典型場景 |

|---|---|---|---|

| 輕度用戶 | 500 萬-2000 萬 | $10-30 | 日常問答、簡單任務 |

| 中度用戶 | 2000 萬-5000 萬 | $30-70 | 自動化工作流 |

| 重度用戶 | 5000 萬-2 億 | $70-150+ | 全天候助理 |

| 極端案例 | 1.8 億+ | $3600+ | MacStories 博主實測 |

OpenClaw Token 消耗爲什麼這麼高

OpenClaw (原名 Clawdbot/Moltbot) 是 2026 年最火的開源 AI 助理項目,GitHub 星標超過 13.5 萬。它功能強大,能連接 12+ 消息平臺、控制瀏覽器、執行 Shell 命令、自動化日常任務。但這些強大能力的背後,是驚人的 Token 消耗。

很多用戶在興奮地配置好 OpenClaw 後,第二天打開 API 賬單就傻眼了——幾十甚至上百美元的消費。有用戶反饋"一天燒掉 200 美元",原因是自動化任務進入了死循環。

理解 Token 消耗的原因,是優化成本的第一步。

OpenClaw 費 Token 的 6 大原因

| 原因 | 消耗佔比 | 技術說明 | 可優化程度 |

|---|---|---|---|

| 上下文累積 | 40-50% | 會話歷史持續膨脹 | ⭐⭐⭐⭐⭐ |

| 工具輸出存儲 | 20-30% | 大型 JSON/日誌存入記錄 | ⭐⭐⭐⭐ |

| System Prompt | 10-15% | 每次請求重複發送 | ⭐⭐⭐ |

| 多輪推理 | 10-15% | 複雜任務需多次調用 | ⭐⭐ |

| 模型選擇 | 5-10% | Opus 比 Haiku 貴 25 倍 | ⭐⭐⭐⭐⭐ |

| 緩存未命中 | 5-10% | 緩存過期重新計費 | ⭐⭐⭐⭐ |

OpenClaw Token 消耗原因深度分析

原因一: 上下文窗口持續累積

這是 OpenClaw 最大的"燒錢黑洞"。每次你和 OpenClaw 對話,所有歷史消息都會被保存在 .openclaw/agents.main/sessions/ 目錄下的 JSONL 文件中。

問題在於: 每次新請求,OpenClaw 都會把完整的會話歷史發送給 AI 模型。

一位用戶反饋,他的主會話上下文已經佔用了 400K 窗口的 56-58%,這意味着:

- 即使只問一個簡單問題,也要處理 20+ 萬 Token 的緩存上下文

- 每次對話的

cacheRead都在數十萬 Token 級別 - 會話越長,成本指數級增長

# 查看當前會話 Token 消耗

openclaw /status

# 顯示結果示例:

# 🤖 Model: claude-sonnet-4

# 📊 Context: 234,567 / 400,000 tokens (58.6%)

# 💰 Estimated cost this session: $12.34

原因二: 工具輸出無限存儲

OpenClaw 會把所有工具調用的輸出存入會話記錄。當你執行以下操作時,問題就來了:

| 危險操作 | 輸出大小 | 後果 |

|---|---|---|

config.schema |

數萬 Token | 巨型 JSON 存入上下文 |

status --all |

數千 Token | 系統狀態全量記錄 |

目錄遍歷 find |

數萬 Token | 所有文件列表存儲 |

| 日誌導出 | 數萬 Token | 完整日誌存入記錄 |

一位開發者分享: "我只是讓 OpenClaw 幫我查看項目結構,它遍歷了整個目錄,輸出了幾萬行文件列表,這些全部存進了會話記錄。之後每次對話,這些無用信息都要重新發送給模型。"

原因三: System Prompt 每次重發

OpenClaw 有一個複雜的系統提示詞,包含:

- 核心人格設定

- 可用工具列表

- 安全限制規則

- 用戶偏好配置

這個 System Prompt 通常有 5000-10000 Token,每次 API 調用都要重新發送。雖然 Anthropic 提供了 Prompt Caching (緩存命中只收 10% 費用),但緩存有 TTL 限制:

| 提供商 | 緩存 TTL | 過期後果 |

|---|---|---|

| Anthropic | 5 分鐘 | 重新全價計費 |

| OpenAI | 1 小時 | 自動失效 |

如果你不是連續使用,每次冷啓動都要付全價。

原因四: 複雜任務的多輪推理

OpenClaw 的強大之處在於能自主完成複雜任務,但這也意味着更多的 API 調用:

用戶: 幫我整理今天的郵件並創建待辦事項

OpenClaw 內部流程:

1. 調用郵件 Skill 獲取郵件列表 → 消耗 Token

2. 分析每封郵件內容 → 消耗 Token

3. 判斷優先級和類別 → 消耗 Token

4. 調用 Todoist Skill 創建任務 → 消耗 Token

5. 生成彙總報告 → 消耗 Token

實際消耗: 5-10 次 API 調用,每次都帶着完整上下文

原因五: 模型選擇不當

很多用戶默認使用 Claude Opus 4.5 或 Sonnet 4.5,但不是所有任務都需要頂級模型:

| 模型 | 輸入價格 | 輸出價格 | 適用場景 |

|---|---|---|---|

| Claude Opus 4.5 | $15/M | $75/M | 複雜推理、創意寫作 |

| Claude Sonnet 4.5 | $3/M | $15/M | 日常任務、代碼生成 |

| Claude Haiku 4.5 | $1/M | $5/M | 簡單問答、格式轉換 |

| Gemini 3.0 Flash | $0.075/M | $0.30/M | 批量處理、成本敏感 |

價格差距高達 25 倍! 用 Opus 回答"今天天氣怎麼樣"純屬浪費。

原因六: Heartbeat 和後臺任務

OpenClaw 的 Heartbeat 功能讓 AI 可以主動喚醒執行定時任務。但很多用戶不知道:

- Heartbeat 每次觸發都是一次完整的 API 調用

- 如果配置不當,可能每隔幾分鐘就觸發一次

- 每次觸發都帶着完整的會話上下文

一位用戶反饋: "我設置了每 5 分鐘檢查一次郵件,結果一天下來光 Heartbeat 就燒掉了 50 美元。"

OpenClaw Token 優化 6 大策略

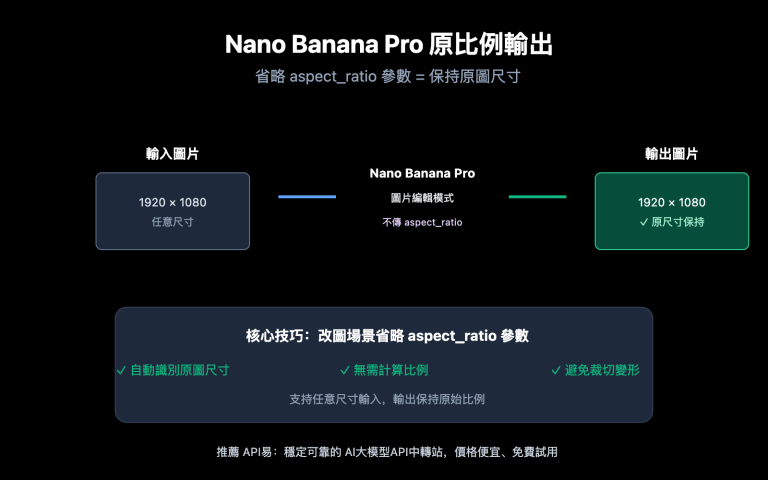

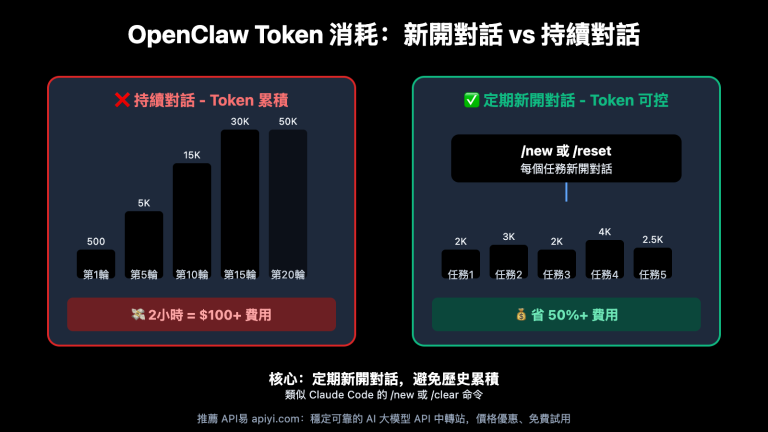

策略一: 定期重置會話 (節省 40-60%)

這是最立竿見影的方法。當會話上下文膨脹時,果斷重置:

# 方法 1: 在對話中重置

openclaw "reset session"

# 方法 2: 刪除會話文件

rm -rf ~/.openclaw/agents.main/sessions/*.jsonl

# 方法 3: 使用 /compact 命令壓縮

openclaw /compact

最佳實踐: 每完成一個獨立任務就重置會話,不要讓上下文無限累積。

策略二: 隔離大輸出操作 (節省 20-30%)

永遠不要在主會話中執行可能產生大輸出的命令:

# ❌ 錯誤: 在主會話執行

openclaw "顯示完整的系統配置"

# ✅ 正確: 使用獨立 debug 會話

openclaw --session debug "顯示完整的系統配置"

# 然後只把需要的小片段複製到主會話

策略三: 配置智能模型切換 (節省 50-80%)

根據任務複雜度自動選擇模型:

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-sonnet-4",

"fallback": "anthropic/claude-haiku-4"

}

}

},

"routing": {

"simple_queries": "haiku",

"complex_tasks": "sonnet",

"critical_decisions": "opus"

}

}

🎯 省錢建議: 日常任務用 Haiku 或 Gemini Flash,只在複雜推理時切換到 Sonnet/Opus。通過 API易 apiyi.com 可以一站式接入 400+ 大模型,用統一接口靈活切換,找到性價比最優的組合。

策略四: 啓用緩存優化 (節省 30-50%)

充分利用 Prompt Caching 機制:

{

"agents": {

"defaults": {

"cache-ttl": 3600,

"temperature": 0.2

}

}

}

關鍵技巧:

- 設置低溫度 (0.2) 可提高緩存命中率

- 配置 Heartbeat 間隔略小於緩存 TTL,保持緩存熱度

- 使用 OpenRouter 等支持緩存的中轉服務

策略五: 限制上下文窗口 (節省 20-40%)

主動控制上下文大小:

{

"agents": {

"defaults": {

"contextTokens": 50000,

"compaction": "aggressive"

}

}

}

將上下文限制在 50K-100K 而不是默認的 400K,可以大幅降低每次請求的成本。

策略六: 使用本地模型兜底 (節省 60-80%)

通過 Ollama 配置本地模型處理簡單任務:

{

"models": {

"providers": {

"ollama": {

"baseUrl": "http://localhost:11434",

"models": ["llama3.3", "qwen2.5"]

}

}

},

"routing": {

"simple_queries": "ollama/llama3.3"

}

}

本地模型零 API 成本,適合處理簡單的格式轉換、信息查詢等任務。

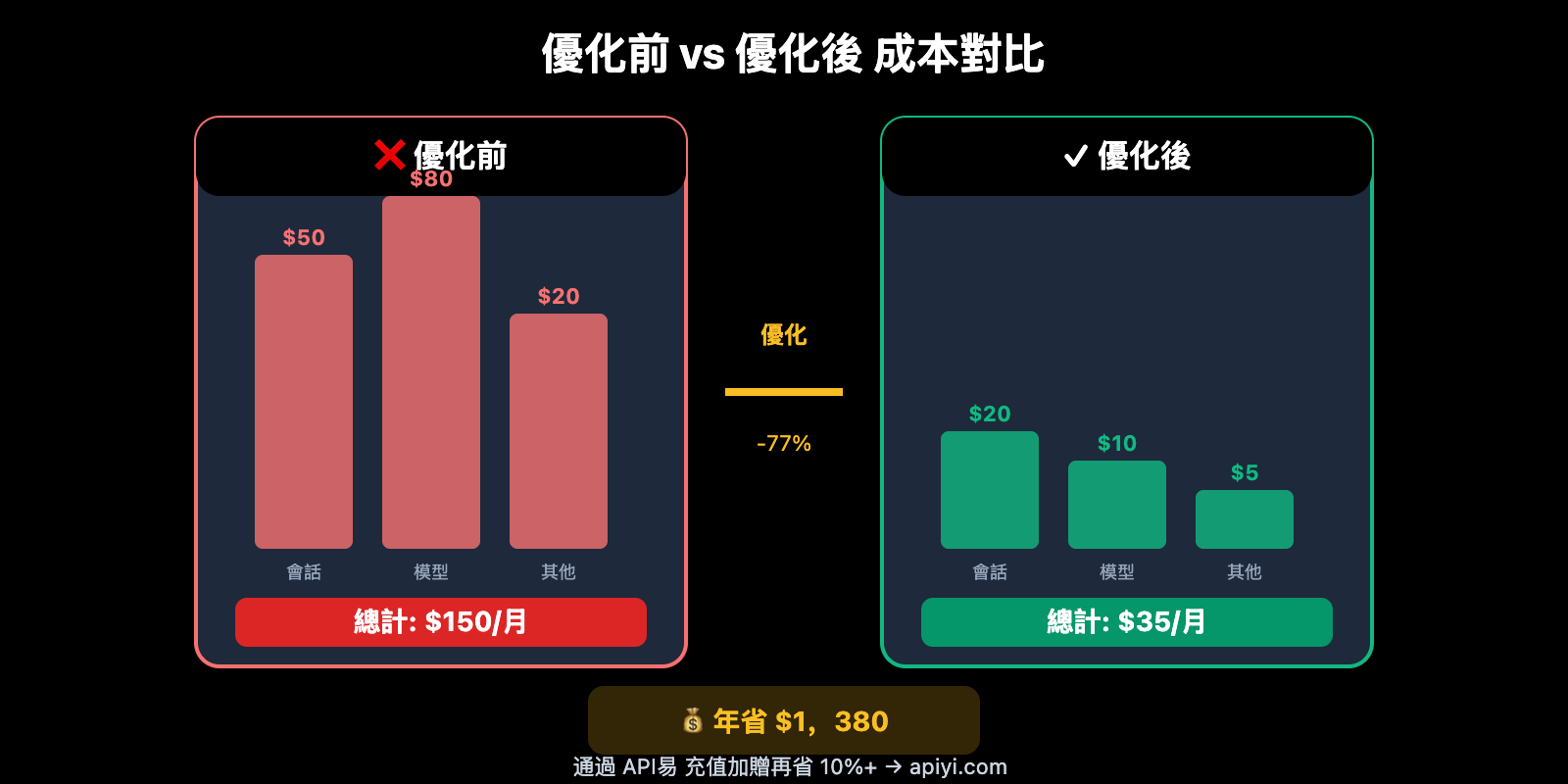

OpenClaw 成本優化實戰對比

| 優化項 | 優化前成本 | 優化後成本 | 節省比例 |

|---|---|---|---|

| 會話管理 | $50/月 | $20/月 | 60% |

| 模型切換 | $80/月 | $25/月 | 69% |

| 緩存優化 | $40/月 | $20/月 | 50% |

| 本地兜底 | $30/月 | $5/月 | 83% |

| 綜合優化 | $150/月 | $35/月 | 77% |

實測數據: 一位重度用戶通過綜合優化,將月均成本從 $150 降至 $35,節省超過 75%。

通過 API易 進一步降低成本

即使完成了上述所有優化,API 調用成本仍然是 OpenClaw 的主要支出。這時候,選擇合適的 API 服務商就變得至關重要。

API易 充值加贈活動

API易 apiyi.com 提供 400+ 大模型的統一接口,價格與官網等價,但通過充值加贈活動可以做到更低:

| 充值金額 | 加贈比例 | 實際到賬 | 相當於折扣 |

|---|---|---|---|

| $20 | 5% | $21 | 9.5 折 |

| $50 | 8% | $54 | 9.3 折 |

| $100 | 10% | $110 | 9.1 折 |

| $200 | 12% | $224 | 8.9 折 |

| $500+ | 15% | $575+ | 8.7 折 |

算一筆賬: 如果你每月 API 消費 $100,通過 API易 充值 $100 加贈 10%,相當於每月省下 $10。一年就是 $120,夠買一個 Claude Pro 訂閱了。

API易 的其他優勢

| 優勢 | 說明 | 對 OpenClaw 用戶的價值 |

|---|---|---|

| 400+ 模型 | 一站式接入所有主流模型 | 靈活切換,找到最佳性價比 |

| 統一接口 | OpenAI 兼容格式 | 無縫對接 OpenClaw |

| 實時餘額 | 精確到分的消費統計 | 隨時監控成本 |

| 無月費 | 按量付費,用多少算多少 | 靈活控制支出 |

| 穩定可靠 | 多節點負載均衡 | 7×24 小時可用 |

配置 API易 作爲 OpenClaw 後端

{

"models": {

"providers": {

"apiyi": {

"type": "openai",

"baseUrl": "https://vip.apiyi.com/v1",

"apiKey": "YOUR_APIYI_KEY",

"models": [

"claude-sonnet-4",

"claude-haiku-4",

"gpt-4o-mini",

"deepseek-v3"

]

}

}

},

"agents": {

"defaults": {

"model": "apiyi/claude-sonnet-4"

}

}

}

配置完成後,OpenClaw 的所有 API 調用都會通過 API易 路由,享受充值加贈優惠。

常見問題

Q1: OpenClaw 用 Claude Pro/Max 訂閱可以省錢嗎?

不可以,而且這樣做違反 Anthropic 服務條款。Claude Pro/Max 訂閱僅限通過官方界面直接使用,不能用於第三方 API 調用。OpenClaw 必須使用 API Key 按量付費。這也是爲什麼 API易 的充值加贈特別有價值——它是合規省錢的唯一途徑。

Q2: 如何實時監控 Token 消耗?

OpenClaw 內置了消耗監控命令:

# 查看當前狀態

openclaw /status

# 開啓每次響應的用量顯示

openclaw /usage full

結合 API易 後臺的實時餘額和消費明細,可以精確掌控每一分錢的去向。

Q3: 使用 Gemini 或 Deepseek 能省多少?

相比 Claude Sonnet,成本差距巨大:

| 模型 | 輸入價格 | 成本對比 |

|---|---|---|

| Claude Sonnet 4.5 | $3/M | 基準 |

| Gemini 3.0 Flash | $0.075/M | 便宜 40 倍 |

| Deepseek V3 | $0.27/M | 便宜 11 倍 |

通過 API易 apiyi.com 可以一站式接入這些模型,用統一接口靈活切換。

總結

OpenClaw 費 Token 的 6 大核心原因:

- 上下文累積: 會話歷史無限膨脹,是最大的成本黑洞

- 工具輸出存儲: 大型輸出存入記錄,每次對話重複發送

- System Prompt: 複雜提示詞每次重發,緩存過期全價計費

- 多輪推理: 複雜任務需要多次 API 調用

- 模型選擇不當: 用 Opus 做 Haiku 能做的事

- Heartbeat 頻繁: 後臺任務不斷消耗 Token

省錢核心策略:

- 定期重置會話,控制上下文大小

- 智能模型切換,簡單任務用便宜模型

- 通過 API易 apiyi.com 充值加贈,獲得低於官網 9 折的價格

推薦訪問 API易 apiyi.com 註冊賬號,平臺提供 400+ 模型統一接口和充值加贈活動,讓你的 OpenClaw 既強大又省錢。

📚 參考資料

⚠️ 鏈接格式說明: 所有外鏈使用

資料名: domain.com格式,方便複製但不可點擊跳轉,避免 SEO 權重流失。

-

OpenClaw Token 使用文檔: 官方消耗說明

- 鏈接:

docs.openclaw.ai/token-use - 說明: Token 計費規則和監控命令

- 鏈接:

-

GitHub Issue #1594: 上下文累積問題討論

- 鏈接:

github.com/openclaw/openclaw/issues/1594 - 說明: 社區對"燒 Token"問題的深度分析

- 鏈接:

-

Anthropic 定價頁面: Claude API 官方價格

- 鏈接:

anthropic.com/pricing - 說明: 各模型最新價格和緩存優惠

- 鏈接:

-

Fast Company 報道: OpenClaw 成本分析

- 鏈接:

fastcompany.com/91484506/what-is-clawdbot-moltbot-openclaw - 說明: 媒體對 OpenClaw 高成本問題的報道

- 鏈接:

-

API易官網: 400+ 模型一站式接入

- 鏈接:

apiyi.com - 說明: 充值加贈活動,低於官網 9 折

- 鏈接:

作者: 技術團隊

技術交流: 歡迎在評論區討論,更多省錢攻略可訪問 API易 apiyi.com 技術社區