站长注:深度分析VSCode Cline插件在使用AI大模型API时token消耗过大的原因,提供多种实用优化策略,包括上下文管理、对话摘要和代码参考控制,帮助开发者显著降低API调用成本。

作为一款流行的VSCode AI辅助编码插件,Cline为开发者提供了强大的代码生成、解释和重构功能。然而,随着项目规模增长和使用时间延长,许多用户反映Cline插件的token消耗量急剧增加,不仅导致API使用成本上升,还可能影响AI模型的性能和稳定性。本文将深入分析这一问题,并提供多种实用的优化策略,帮助您在享受AI编程助手便利的同时,有效控制API调用成本。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Claude、GPT-4o等全系列顶级大语言模型,提供成本优化的API调用服务

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

VSCode Cline插件token消耗过大的深层原因

在探讨优化策略之前,我们需要理解导致Cline插件token消耗激增的核心原因:

1. 累积的对话历史

根据用户反馈,随着开发会话的持续,Cline会在每次API请求中包含越来越多的历史对话:

- 完整的对话记录:每次请求都会发送全部历史对话,包括代码生成和修改的过程

- token激增:长时间会话可能导致单次请求输入token达到10万-50万之多

- 超出模型限制:当累积到一定程度时,可能会超出Claude或GPT等模型的上下文窗口限制

2. 全代码库上下文传输

Cline的工作方式导致token使用效率低下:

- 整个代码文件发送:每次请求都会发送当前文件的完整内容

- 历史修订版本:已完成的代码修改历史依然会作为上下文传输

- 多文件参考:在某些情况下,VSCode中打开的多个标签页内容也会被发送

- 重复传输:相同的代码上下文会在每次API调用中重复发送

3. 缺乏智能上下文管理

当前的实现缺少有效的上下文管理机制:

- 无选择性过滤:不会智能过滤掉不相关或过时的信息

- 无压缩摘要:没有将已完成的任务转换为更简洁的摘要

- 无渐进式遗忘:较早的对话内容即使不再相关也会一直保留

Cline插件token消耗优化的核心策略

针对上述问题,我们提供以下优化策略,帮助您显著降低Cline插件的token消耗:

策略一:主动管理对话历史

手动管理对话历史是最直接的优化方法:

1. 定期开启新会话

对于长期项目,建议:

- 每完成一个功能模块后开始新的会话

- 复杂项目每1-2天开启一次新会话

- 在开始新的较大功能前重置会话

2. 使用"清理历史"功能

Cline插件提供了清理历史记录的选项:

步骤:

1. 在VSCode中打开Cline侧边栏

2. 点击右上角的"..."菜单

3. 选择"Clear conversation history"

4. 在弹出的确认框中点击"确认"

3. 为关键功能创建专用会话

针对不同功能创建独立的、专注的会话:

- 代码生成会话:专注于生成新功能代码

- 代码审查会话:专门用于代码审查和优化

- 调试会话:专注于修复bug和问题

策略二:上下文优化技术

通过优化提供给模型的上下文,可以大幅降低token消耗:

1. 手动提供简化上下文

不要让Cline自动加载所有内容,而是手动提供必要信息:

// 替代发送整个代码库,使用这种方式提供上下文

我正在开发一个用户认证系统,以下是关键接口:

```typescript

interface User {

id: string;

username: string;

email: string;

}

interface AuthService {

login(username: string, password: string): Promise<User>;

logout(): void;

}

请帮我实现AuthService的具体类。

#### 2. 使用引用而非完整代码

当讨论代码时,使用文件路径和行号引用而非粘贴整段代码:

// 不好的方式

这是我的代码,帮我找出问题:

[粘贴几百行代码]

// 更好的方式

我在src/services/auth.ts文件中的login方法(第45-60行)遇到问题,

主要逻辑是验证用户凭证并返回用户信息。错误提示是"TypeError: Cannot read property 'id' of undefined"。

#### 3. 使用代码片段而非整个文件

只提供与当前任务直接相关的代码片段:

// 不好的方式

这是我的UserService.ts文件,帮我在其中添加删除用户的功能:

[粘贴整个文件内容,包含数百行代码]

// 更好的方式

这是我UserService类的基本结构,请帮我添加一个deleteUser方法:

class UserService {

// 这里只展示与任务相关的方法

async getUserById(id: string): Promise<User> {

// 实现细节...

}

// 需要添加的新方法

// async deleteUser(id: string): Promise<boolean>

}

### 策略三:利用任务总结和关键点提取

通过总结已完成的任务,可以保留重要信息的同时减少token消耗:

#### 1. 主动提供会话摘要

在长时间开发后,可以这样总结并开始新的上下文:

// 会话转换示例

我们之前已经完成了:

- 用户认证服务的基本实现(login, logout方法)

- JWT令牌验证的中间件

- 密码重置功能

现在,我们需要实现用户角色和权限系统。可以基于之前的代码继续开发吗?

#### 2. 使用"保存为笔记"功能

一些Cline版本提供了将对话保存为笔记的功能:

步骤:

- 选择重要的对话部分

- 右键单击 > "Save as note"

- 将生成的笔记用作未来任务的参考,而不是保留完整对话

#### 3. 创建任务切换点

在复杂项目中切换任务时,明确标记切换点:

/// 任务切换示例

// 总结前一个任务

我们已经完成了用户认证模块,主要包括:

- 实现了基于JWT的认证系统

- 添加了密码哈希和验证

- 集成了双因素认证支持

// 开始新任务

现在我想开始一个新任务:实现产品目录功能。

这个功能需要创建ProductService和相关的数据模型。

### 策略四:插件设置调整

通过配置Cline插件的设置,可以从根本上控制token消耗:

#### 1. 限制文件大小

在Cline配置中设置最大允许的文件大小:

```json

// 在VSCode的settings.json中添加

{

"cline.maxFileSize": 50000, // 设置最大文件大小为50KB

"cline.autoIncludeOpenTabs": false, // 禁止自动包含打开的标签页

"cline.contextSize": "medium" // 控制发送给API的上下文大小

}

2. 控制包含的文件类型

排除不需要发送给AI模型的文件类型:

{

"cline.excludeFilePatterns": [

"**/*.min.js",

"**/*.bundle.js",

"**/node_modules/**",

"**/dist/**",

"**/build/**"

]

}

3. 调整发送给API的上下文范围

根据需要选择最合适的上下文范围:

{

// 仅包含当前文件

"cline.contextMode": "currentFile",

// 或者,仅包含与当前任务最相关的文件

"cline.contextMode": "relatedFiles",

"cline.relatedFileMaxCount": 3 // 限制相关文件数量

}

策略五:采用高级技术方案

对于技术水平较高的用户,可以考虑以下更先进的优化方案:

1. 自定义API代理层

创建一个中间代理层来优化Cline发送的请求:

// 简化的proxy.js示例

const express = require('express');

const axios = require('axios');

const app = express();

app.use(express.json());

// 处理从Cline发来的请求

app.post('/api/proxy', async (req, res) => {

try {

// 提取请求内容

const { messages, model } = req.body;

// 优化messages,例如截断历史、摘要化等

const optimizedMessages = optimizeMessages(messages);

// 转发到实际的API(如Claude API或OpenAI API)

const response = await axios.post('https://vip.apiyi.com/v1/chat/completions', {

model,

messages: optimizedMessages

}, {

headers: {

'Authorization': `Bearer ${process.env.API_KEY}`,

'Content-Type': 'application/json'

}

});

res.json(response.data);

} catch (error) {

console.error('Proxy error:', error);

res.status(500).json({ error: error.message });

}

});

// 优化消息历史的函数

function optimizeMessages(messages) {

// 1. 保留最新的n条消息

if (messages.length > 10) {

const important = messages.slice(0, 2); // 保留最初的系统消息

const recent = messages.slice(-8); // 保留最近的8条消息

messages = [...important, ...recent];

}

// 2. 压缩代码块(可以实现更复杂的代码压缩逻辑)

messages = messages.map(msg => {

if (msg.content && typeof msg.content === 'string') {

// 简化代码块,例如移除注释、缩短长代码段等

msg.content = simplifyCodeBlocks(msg.content);

}

return msg;

});

return messages;

}

// 简化代码块的函数

function simplifyCodeBlocks(content) {

// 实现代码简化逻辑

return content;

}

app.listen(3000, () => {

console.log('API proxy running at http://localhost:3000');

});

2. 实现RAG(检索增强生成)方案

使用向量数据库存储代码知识,按需检索:

# 简化的RAG方案示例 (pip install langchain faiss-cpu)

import os

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.embeddings import OpenAIEmbeddings

from langchain.vectorstores import FAISS

# 1. 加载代码库文件

def load_codebase(directory):

code_files = []

for root, _, files in os.walk(directory):

for file in files:

if file.endswith(('.js', '.ts', '.py', '.java', '.c', '.cpp')):

file_path = os.path.join(root, file)

with open(file_path, 'r', encoding='utf-8') as f:

try:

content = f.read()

code_files.append({"path": file_path, "content": content})

except Exception as e:

print(f"Error reading {file_path}: {e}")

return code_files

# 2. 分割代码为小块

def split_code(code_files):

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200

)

docs = []

for file in code_files:

chunks = text_splitter.split_text(file["content"])

for chunk in chunks:

docs.append(f"File: {file['path']}\n\n{chunk}")

return docs

# 3. 创建向量存储

def create_vector_index(docs):

embeddings = OpenAIEmbeddings()

vector_store = FAISS.from_texts(docs, embeddings)

return vector_store

# 4. 根据查询检索相关代码

def retrieve_relevant_code(vector_store, query, k=3):

docs = vector_store.similarity_search(query, k=k)

return docs

# 使用示例

code_files = load_codebase("./my_project")

docs = split_code(code_files)

vector_store = create_vector_index(docs)

# 当开发者提问时,检索相关代码

query = "用户认证如何实现?"

relevant_code = retrieve_relevant_code(vector_store, query)

# 将检索结果与用户查询一起发送给AI模型

# 这样就不需要发送整个代码库,只发送相关部分

3. 使用记忆管理器

实现高级的对话记忆管理系统:

# 简化的对话记忆管理器示例

class ConversationMemoryManager:

def __init__(self, max_tokens=4000):

self.short_term_memory = [] # 完整的最近对话

self.long_term_memory = [] # 重要信息的摘要

self.max_tokens = max_tokens

self.token_count = 0

def add_message(self, message):

# 添加消息到短期记忆

self.short_term_memory.append(message)

# 估算token数量(简化版)

self.token_count += len(message.split()) * 1.3

# 如果超出限制,进行优化

if self.token_count > self.max_tokens:

self._optimize_memory()

def _optimize_memory(self):

# 1. 找出重要消息并创建摘要

important_messages = self._identify_important_messages()

summary = self._create_summary(important_messages)

# 2. 将摘要添加到长期记忆

self.long_term_memory.append(summary)

# 3. 保留最近的几条消息

self.short_term_memory = self.short_term_memory[-5:]

# 4. 重新计算token数量

self._recalculate_tokens()

def _identify_important_messages(self):

# 简化版:假设最早的几条消息包含重要信息

return self.short_term_memory[:-5]

def _create_summary(self, messages):

# 在实际应用中,可以使用AI生成摘要

# 这里使用简化示例

combined = " ".join([m for m in messages])

return f"SUMMARY: {combined[:300]}..."

def _recalculate_tokens(self):

all_text = " ".join(self.short_term_memory)

self.token_count = len(all_text.split()) * 1.3

def get_optimized_context(self):

# 返回优化后的上下文,包括长期记忆摘要和短期最近对话

return self.long_term_memory + self.short_term_memory

VSCode Cline使用中的常见问题与解答

问题1:为什么随着使用时间延长,Cline的响应速度会变慢?

回答:随着对话历史的积累,每次API请求发送的token数量增加,可能从几千增长到几十万。这不仅增加了API请求的处理时间,还可能导致模型处理更复杂,从而响应速度变慢。

解决方案:定期开始新会话或清理历史记录,尤其是在完成一个功能模块后。

问题2:如何知道我当前消耗了多少token?

回答:Cline插件本身可能不会直接显示token使用量,但您可以:

- 查看API提供商的控制台/仪表板(如Claude、OpenAI等)

- 使用第三方token计算器估算文本的token数量

- 在API易平台上,可以在控制台清晰查看每次请求的token用量

补充:作为经验法则,英文文本中每75个单词约等于100个token,代码通常比普通文本消耗更多token。

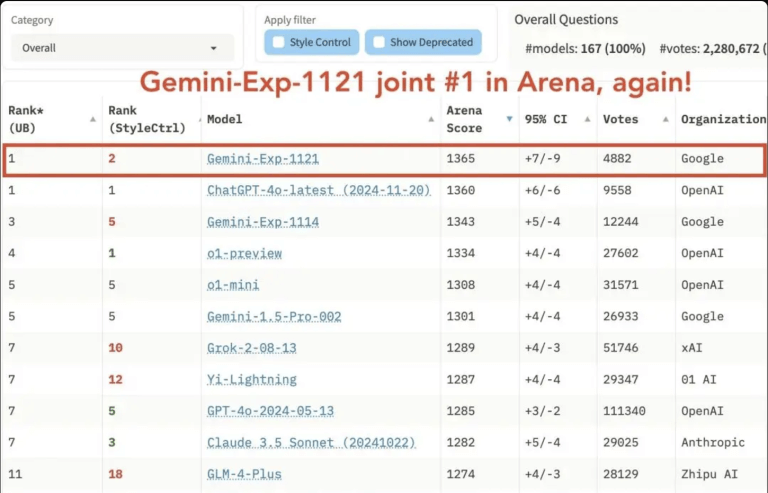

问题3:使用哪种大模型可以在保持性能的同时降低token消耗?

回答:不同模型在处理长上下文和代码方面有各自的优势:

- Claude-3.5-Sonnet:对代码理解能力强,上下文窗口大,适合复杂编程任务

- GPT-4o-mini:上下文窗口适中,token价格较低,适合一般编程辅助

- Gemini-1.5-flash:性价比较高,处理代码能力不错,适合日常开发

- Deepseek:专为代码优化的模型,对编程任务token利用效率较高

问题4:在团队协作项目中,如何管理Cline的token消耗?

回答:团队环境中可以采取以下策略:

- 创建共享的设置文件(.vscode/settings.json),统一配置token优化设置

- 建立团队最佳实践,如定期清理历史、按功能模块创建会话等

- 为不同类型的开发任务创建专门的API密钥,便于成本跟踪

- 考虑实现团队共享的代理/RAG服务,统一优化token使用

为什么选择API易平台提供的模型服务

在使用VSCode Cline插件进行AI辅助开发时,选择合适的API提供商对于控制成本和提升效率至关重要。API易平台在这方面提供了多项优势:

1. 优化的token计费模式

- 精确计费:只对实际使用的token进行计费,无隐藏费用

- 分级定价:根据不同模型和用量提供更经济的价格

- 批量优惠:大量使用时提供更优惠的价格策略

2. 多样化的模型选择

通过API易平台,您可以轻松在Cline中切换不同的模型,根据任务需求平衡性能和成本:

- 高性能需求:Claude-3.5-Sonnet、GPT-4o等

- 日常开发:GPT-4o-mini、Gemini-1.5-flash等

- 代码特化模型:Deepseek等专注代码的模型

3. 企业级token管理功能

- 用量监控:实时查看token消耗情况

- 预算控制:设置使用限额,防止意外超支

- 详细报告:按项目、模型、时间等维度分析使用情况

总结:VSCode Cline插件token使用优化最佳实践

通过本文介绍的优化策略,您可以显著降低VSCode Cline插件的token消耗,同时保持AI辅助编码的高效体验:

-

主动管理对话上下文:定期开始新会话,使用"清理历史"功能,为不同功能创建专用会话。

-

优化输入提示:提供简化的上下文,使用引用而非完整代码,只包含与当前任务直接相关的代码片段。

-

实现任务总结:定期总结已完成的工作,创建任务切换点,使用"保存为笔记"功能保留关键信息。

-

调整插件设置:限制文件大小,控制包含的文件类型,调整发送给API的上下文范围。

-

考虑高级技术方案:自定义API代理层,实现RAG(检索增强生成),使用对话记忆管理系统。

通过以上策略的组合应用,许多开发者已成功将Cline插件的token消耗降低50%-80%,不仅节省了API使用成本,还改善了AI助手的响应质量和速度。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

多种大模型随意切换,为您的VSCode AI开发体验提供更经济高效的解决方案

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。