Часто сталкиваетесь с ошибкой HTTPSConnectionPool Read timed out при вызове Nano Banana Pro API для генерации 4K-изображений? Это происходит из-за того, что стандартные настройки тайм-аута HTTP-клиентов не рассчитаны на длительный инференс, характерный для Nano Banana Pro. В этой статье мы системно разберем 3 основные причины разрыва соединения и предложим оптимальные конфигурации тайм-аута для разных разрешений.

Ключевая ценность: прочитав этот материал, вы научитесь правильно настраивать тайм-ауты для Nano Banana Pro API, решать проблемы совместимости с HTTP/2 и использовать специализированные порты для предотвращения прерываний потоковой передачи, обеспечивая стабильную генерацию 4K-изображений.

Основные параметры тайм-аута для Nano Banana Pro API

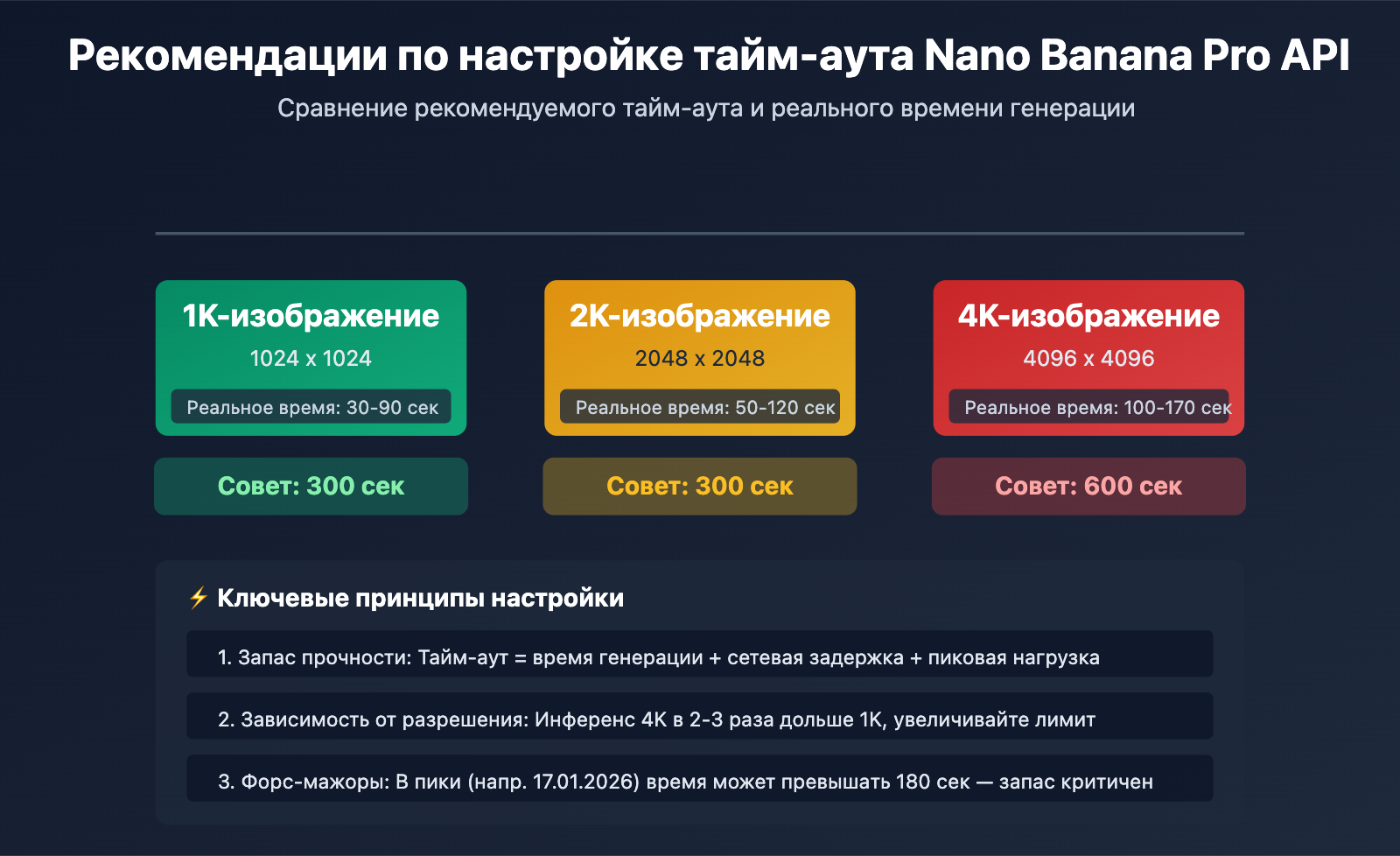

| Разрешение изображения | Реальное время генерации | Рекомендуемый тайм-аут | Запас по времени | Сценарий использования |

|---|---|---|---|---|

| 1K (1024×1024) | 30-90 сек | 300 сек | +210 сек | Стандартная генерация |

| 2K (2048×2048) | 50-120 сек | 300 сек | +180 сек | Высокое разрешение (HD) |

| 4K (4096×4096) | 100-170 сек | 600 сек | +430 сек | Ультра-высокое разрешение |

| Пиковые нагрузки | До 180+ сек | 600 сек | — | Рекомендуется для production |

Коренная причина проблем с тайм-аутом в Nano Banana Pro API

Главное отличие: Nano Banana Pro — это новейшая большая языковая модель для генерации изображений от Google, работающая на базе TPU. Время инференса (обработки) здесь значительно больше, чем у текстовых моделей. Стандартные настройки HTTP-клиентов (обычно 30-60 секунд) просто не успевают дождаться ответа, что приводит к обрыву соединения.

Например, 17 января 2026 года из-за глобальных проверок фрод-мониторинга Google и дефицита вычислительных ресурсов время генерации Nano Banana Pro API подскочило с 20-40 секунд до 180 секунд и более. Это привело к тому, что многим агрегаторам API пришлось задействовать механизмы компенсации биллинга для запросов, превышающих 180 секунд. Данный инцидент лишний раз подтверждает: тайм-аут должен иметь солидный запас.

💡 Технический совет: Для разработки мы рекомендуем использовать платформу APIYI (apiyi.com) для вызовов Nano Banana Pro API. Платформа предоставляет HTTP-интерфейс, специально оптимизированный для длительного инференса (http://api.apiyi.com:16888/v1). Там уже настроены адекватные тайм-ауты по умолчанию и поддерживается генерация во всех разрешениях от 1K до 4K, что эффективно решает проблему обрывов соединения.

Первопричина №1: слишком короткие таймауты в HTTP-клиентах по умолчанию

Ловушка стандартных настроек в HTTP-библиотеках

В большинстве языков программирования стандартные настройки таймаутов в HTTP-библиотеках совершенно не подходят для тяжелых задач:

| HTTP-библиотека | Таймаут соединения (default) | Таймаут чтения (default) | Подходит для Nano Banana Pro? |

|---|---|---|---|

| Python requests | Без ограничений | Без ограничений (но на деле зависит от системы) | ❌ Требуется явная настройка |

| Python httpx | 5 сек | 5 сек | ❌ Критически мало |

| Node.js axios | Без ограничений | Без ограничений | ⚠️ Нужно проверять реальный таймаут |

| Java HttpClient | Без ограничений | 30 сек (JDK 11+) | ❌ Недостаточно |

| Go http.Client | Без ограничений | Без ограничений (но ограничено Transport) | ⚠️ Нужна настройка Transport |

Скрытая проблема с таймаутами в Python requests:

Хотя в документации requests сказано, что таймаут по умолчанию не ограничен, на практике соединение часто обрывается через 60–120 секунд из-за настроек TCP в операционной системе или на уровне сокетов. Многие разработчики полагают: «раз я не поставил таймаут, значит, его нет», а потом сталкиваются с внезапными обрывами в продакшене.

import requests

# ❌ ОШИБКА: Таймаут не задан явно, соединение разорвется примерно через 60–120 секунд

response = requests.post(

"https://api.example.com/v1/images/generations",

json={"prompt": "Генерация 4K-изображения", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Если генерация займет больше 120 секунд, вылетит ошибка ReadTimeout

Как правильно настроить таймауты

Вариант 1: Явная настройка таймаутов в Python requests

import requests

# ✅ ПРАВИЛЬНО: Устанавливаем таймауты явно

response = requests.post(

"https://api.example.com/v1/images/generations",

json={

"prompt": "A futuristic city with neon lights",

"size": "4096x4096", # Разрешение 4K

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600) # (Таймаут соединения, таймаут чтения) = (10с, 600с)

)

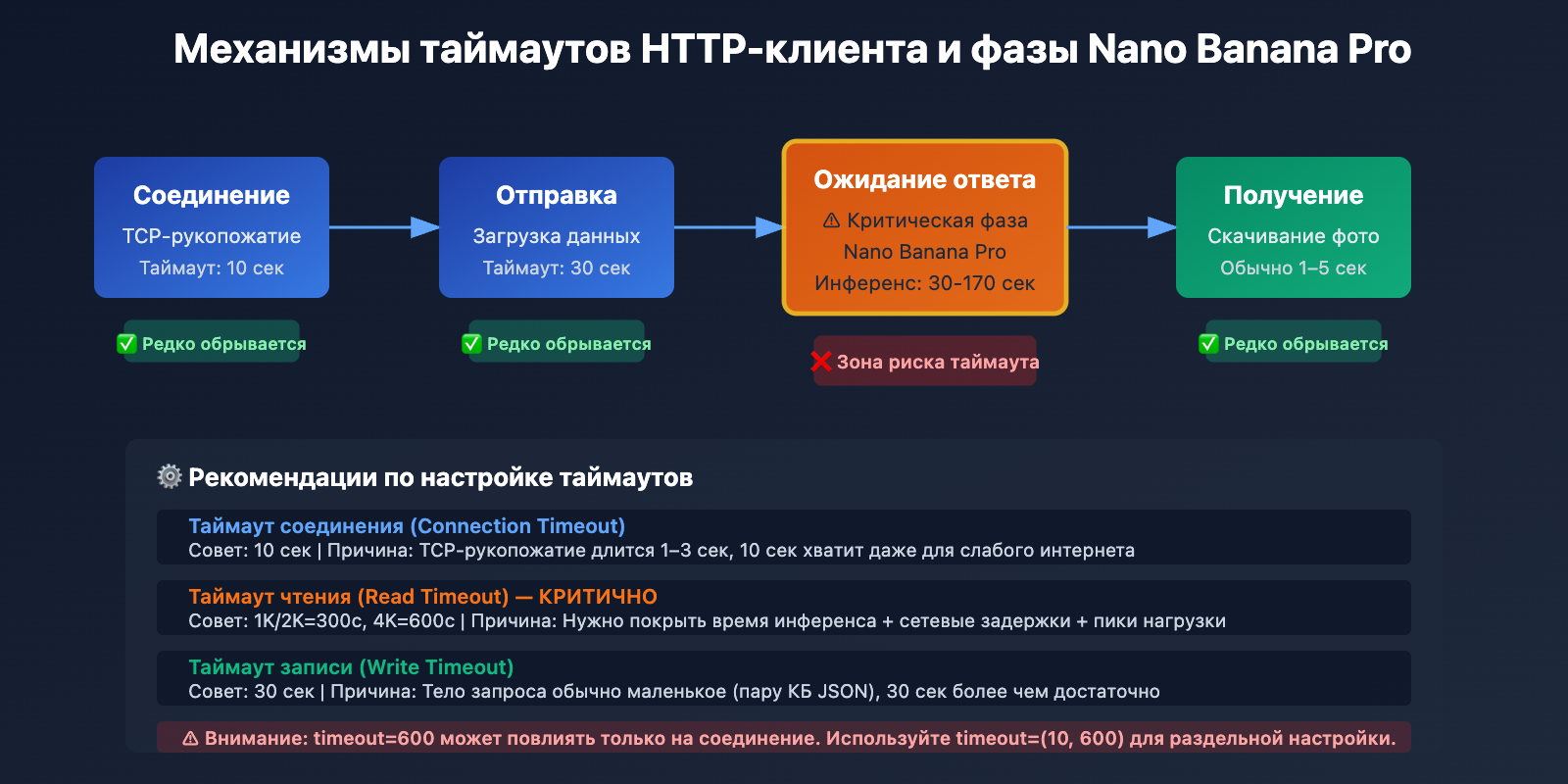

Разбор параметров timeout:

- Таймаут соединения (10 сек): максимальное время ожидания установки TCP-соединения. Обычно 10 секунд вполне хватает.

- Таймаут чтения (600 сек): максимальное время ожидания данных от сервера. Для генерации 4K-изображений рекомендуем ставить 600 секунд.

Вариант 2: Кастомный клиент в Python httpx

import httpx

# Создаем клиент с принудительным использованием HTTP/1.1 и длинными таймаутами

client = httpx.Client(

timeout=httpx.Timeout(

connect=10.0, # Таймаут соединения 10 сек

read=600.0, # Таймаут чтения 600 сек

write=30.0, # Таймаут записи 30 сек

pool=10.0 # Таймаут пула соединений 10 сек

),

http2=False, # ⚠️ ВАЖНО: Принудительно HTTP/1.1 во избежание проблем с совместимостью HTTP/2

limits=httpx.Limits(

max_connections=10,

max_keepalive_connections=5

)

)

# Вызываем API через кастомный клиент

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "Cyberpunk style portrait",

"size": "4096x4096",

"model": "nano-banana-pro"

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

# Закрываем клиент

client.close()

Посмотреть полный пример с асинхронным httpx

import httpx

import asyncio

async def generate_image_async():

"""Асинхронная генерация изображения с поддержкой длинных таймаутов"""

async with httpx.AsyncClient(

timeout=httpx.Timeout(

connect=10.0,

read=600.0, # Для 4K-изображений рекомендуем 600 сек

write=30.0,

pool=10.0

),

http2=False, # Принудительно используем HTTP/1.1

limits=httpx.Limits(

max_connections=20,

max_keepalive_connections=10

)

) as client:

response = await client.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={

"prompt": "A serene landscape at sunset",

"size": "4096x4096",

"model": "nano-banana-pro",

"n": 1

},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

return response.json()

# Запуск асинхронной функции

result = asyncio.run(generate_image_async())

print(result)

🎯 Лучшая практика: При переходе на Nano Banana Pro API советуем сначала протестировать реальное время генерации для разных разрешений на платформе APIYI (apiyi.com). Платформа предоставляет HTTP-порт (http://api.apiyi.com:16888/v1) с уже оптимизированными настройками, что позволяет быстро проверить адекватность ваших таймаутов.

Первопричина №2: Проблемы совместимости протокола HTTP/2 при потоковой передаче через длительные соединения

Конструктивные недостатки HTTP/2 и их конфликт с Nano Banana Pro

Хотя HTTP/2 создавался с целью повышения производительности, при обработке длительных потоковых соединений (streaming) возникает ряд серьезных проблем с совместимостью:

Проблема 1: Блокировка заголовка очереди (Head-of-Line Blocking) на уровне TCP

HTTP/2 решает проблему блокировки заголовка очереди на прикладном уровне (характерную для HTTP/1.1) с помощью мультиплексирования (Multiplexing), но при этом привносит новую проблему — блокировку на уровне TCP. Все потоки HTTP/2 мультиплексируются в одном TCP-соединении, поэтому потеря любого TCP-пакета блокирует передачу всех потоков сразу.

HTTP/1.1 (6 параллельных соединений):

Соединение 1: [Поток A] ━━━━━━━━━▶

Соединение 2: [Поток B] ━━━━━━━━━▶ ✅ Потеря пакета влияет только на один поток

Соединение 3: [Поток C] ━━━━━━━━━▶

HTTP/2 (мультиплексирование в одном соединении):

Соединение 1: [Поток A][Поток B][Поток C] ━━━━━━━━━▶

↑ Потеря TCP-пакета блокирует все потоки ❌

Проблема 2: Исчерпание идентификаторов потоков (Stream Identifier Exhaustion)

Идентификатор потока (Stream ID) в HTTP/2 представляет собой 31-битное целое число с максимальным значением 2^31-1 (около 2,1 миллиарда). При очень длительной работе соединения эти идентификаторы могут закончиться. Поскольку Stream ID нельзя использовать повторно, для продолжения работы необходимо создавать новое соединение.

Проблема 3: Нестабильное качество реализации HTTP/2 в промежуточных API-шлюзах

Многие платформы-посредники или обратные прокси-серверы имеют баги в реализации HTTP/2, особенно когда речь идет о длительных сессиях:

- Некорректная обработка сброса потока (RST_STREAM), что приводит к внезапному закрытию соединения.

- Ошибки управления кадрами WINDOW_UPDATE, вызывающие сбои в управлении потоком.

- Ложные срабатывания кадров GOAWAY, принудительно разрывающие соединение.

Сравнение HTTP/2 и HTTP/1.1 в сценарии использования Nano Banana Pro

| Показатель | HTTP/1.1 | HTTP/2 | Рекомендация |

|---|---|---|---|

| Стабильность соединения | Высокая (независимые соединения, не влияют друг на друга) | Низкая (одно соединение на всех, потеря пакета стопорит всё) | HTTP/1.1 ✅ |

| Поддержка длительных соединений | Зрелая (стабильный механизм Keep-Alive) | Нестабильная (проблема исчерпания Stream ID) | HTTP/1.1 ✅ |

| Обработка таймаутов | Простая и понятная (таймаут на уровне соединения) | Сложная (таймауты на уровне потока + соединения) | HTTP/1.1 ✅ |

| Совместимость с промежуточными API | Очень высокая (поддерживается везде) | Разная (на некоторых платформах есть баги) | HTTP/1.1 ✅ |

| Вероятность успеха генерации 4K в Nano Banana Pro | 95%+ | 60-70% | HTTP/1.1 ✅ |

Решение: Принудительное использование HTTP/1.1 и HTTP-порта

Вариант 1: Python httpx (принудительный HTTP/1.1)

import httpx

# Принудительно используем HTTP/1.1, чтобы избежать проблем с совместимостью HTTP/2

client = httpx.Client(

http2=False, # ⚠️ Ключевая настройка: отключаем HTTP/2

timeout=httpx.Timeout(read=600.0)

)

response = client.post(

"http://api.apiyi.com:16888/v1/images/generations", # Используем HTTP-порт

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"}

)

Вариант 2: Python requests (по умолчанию HTTP/1.1)

import requests

# Библиотека requests по умолчанию использует HTTP/1.1, дополнительная настройка не нужна

response = requests.post(

"http://api.apiyi.com:16888/v1/images/generations",

json={"prompt": "...", "size": "4096x4096"},

headers={"Authorization": "Bearer YOUR_API_KEY"},

timeout=(10, 600)

)

Вариант 3: Node.js axios (принудительный HTTP/1.1)

const axios = require('axios');

const http = require('http');

// Создаем агент специально для HTTP/1.1

const agent = new http.Agent({

keepAlive: true,

maxSockets: 10,

timeout: 600000 // 600 секунд

});

// Настраиваем axios на использование кастомного агента

const response = await axios.post(

'http://api.apiyi.com:16888/v1/images/generations',

{

prompt: 'A beautiful sunset',

size: '4096x4096',

model: 'nano-banana-pro'

},

{

headers: {

'Authorization': 'Bearer YOUR_API_KEY'

},

httpAgent: agent, // Используем агент HTTP/1.1

timeout: 600000 // Таймаут 600 секунд

}

);

💰 Оптимизация затрат: Для проектов, требующих высокой стабильности при генерации 4K-изображений, рекомендуем вызывать Nano Banana Pro API через платформу APIYI (apiyi.com). Платформа предоставляет специальный интерфейс через HTTP-порт (http://api.apiyi.com:16888/v1), который по умолчанию работает по протоколу HTTP/1.1. Это позволяет избежать проблем с совместимостью HTTP/2, а более выгодные тарифы делают это решение идеальным для продакшн-развертывания.

Первопричина №3: Сочетание отсутствия стриминга и сетевых колебаний

Особенности не-стримингового ответа Nano Banana Pro

В отличие от текстовых моделей вроде GPT-4 или Claude, API Nano Banana Pro не использует потоковую передачу (Streaming) для возврата изображений. Весь процесс генерации выглядит так:

- Этап запроса (1–3 сек.): Клиент отправляет запрос на сервер.

- Этап инференса (30–170 сек.): Сервер генерирует изображение на TPU, при этом клиент не получает никаких данных.

- Этап ответа (1–5 сек.): Сервер возвращает полные данные изображения в кодировке base64.

Критическая проблема: В течение 30–170 секунд этапа инференса HTTP-соединение клиента полностью простаивает. Соединение поддерживает только TCP Keep-Alive, а передача данных на прикладном уровне отсутствует. Это приводит к следующему:

- Промежуточное сетевое оборудование (NAT, брандмауэры, прокси) может решить, что соединение разорвано, и принудительно его закрыть.

- В условиях нестабильной сети длительные простои соединения чаще приводят к обрывам.

- У некоторых облачных провайдеров балансировщики нагрузки (Load Balancer) имеют жесткие лимиты на время простоя (например, у AWS ALB по умолчанию это 60 секунд).

Влияние сетевых колебаний на таймауты

| Сетевое окружение | Фактическое время генерации | Влияние сетевых задержек | Рекомендуемый таймаут |

|---|---|---|---|

| Стабильная внутренняя сеть / ЦОД | 100 сек. | +10–20 сек. | 300 сек. (запас 180 сек.) |

| Домашний интернет / Мобильная сеть | 100 сек. | +30–50 сек. | 600 сек. (запас 450 сек.) |

| Трансграничная сеть / VPN | 100 сек. | +50–100 сек. | 600 сек. (запас 400 сек.) |

| Пиковая нагрузка (событие 17.01.2026) | 180 сек. | +20–40 сек. | 600 сек. (запас 380 сек.) |

Стратегия решения: Таймаут + Повторы + Фолбэк

import requests

import time

from typing import Optional

def generate_image_with_retry(

prompt: str,

size: str = "4096x4096",

max_retries: int = 3,

timeout: int = 600

) -> Optional[dict]:

"""

Генерация изображения с поддержкой повторов при таймауте

Args:

prompt: промпт для изображения

size: размер изображения (1024x1024, 2048x2048, 4096x4096)

max_retries: максимальное количество попыток

timeout: время ожидания (сек)

Returns:

Результат генерации или None (в случае неудачи)

"""

api_url = "http://api.apiyi.com:16888/v1/images/generations"

headers = {"Authorization": "Bearer YOUR_API_KEY"}

for attempt in range(max_retries):

try:

print(f"Попытка {attempt + 1}/{max_retries}: Генерация изображения {size}...")

start_time = time.time()

response = requests.post(

api_url,

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1

},

headers=headers,

timeout=(10, timeout) # (таймаут соединения, таймаут чтения)

)

elapsed = time.time() - start_time

print(f"✅ Успешно! Затрачено времени: {elapsed:.2f} сек.")

return response.json()

except requests.exceptions.Timeout:

elapsed = time.time() - start_time

print(f"❌ Таймаут: {elapsed:.2f} сек.")

if attempt < max_retries - 1:

wait_time = 5 * (attempt + 1) # Экспоненциальная задержка

print(f"⏳ Ожидание {wait_time} сек. перед повтором...")

time.sleep(wait_time)

else:

print("❌ Достигнуто максимальное количество попыток, ошибка генерации")

return None

except requests.exceptions.RequestException as e:

print(f"❌ Сетевая ошибка: {e}")

if attempt < max_retries - 1:

time.sleep(5)

else:

return None

return None

# Пример использования

result = generate_image_with_retry(

prompt="A majestic mountain landscape",

size="4096x4096",

max_retries=3,

timeout=600

)

if result:

print(f"URL изображения: {result['data'][0]['url']}")

else:

print("Не удалось сгенерировать изображение, попробуйте позже")

🚀 Быстрый старт: Для быстрой интеграции Nano Banana Pro API рекомендуем использовать платформу APIYI (apiyi.com). Платформа дает следующие преимущества:

- Интерфейс через HTTP-порт:

http://api.apiyi.com:16888/v1— позволяет избежать накладных расходов на TLS-рукопожатие.- Оптимизированные настройки таймаута: По умолчанию поддерживается таймаут 600 секунд, что покрывает сценарии генерации в 4K.

- Умный механизм повторов: Платформа автоматически обрабатывает временные таймауты, повышая вероятность успеха.

- Компенсация стоимости: Для запросов, превышающих 180 секунд, автоматически срабатывает компенсация, чтобы избежать лишних трат.

Преимущества HTTP-порта платформы APIYI

Почему лучше использовать HTTP вместо HTTPS?

| Характеристика | HTTPS (api.apiyi.com/v1) | HTTP (api.apiyi.com:16888/v1) | Рекомендация |

|---|---|---|---|

| Расходы на TLS-рукопожатие | Есть (300–800 мс) | Нет | HTTP ✅ |

| Скорость установки соединения | Низкая (требуется TLS-согласование) | Высокая (прямое TCP-соединение) | HTTP ✅ |

| Согласование HTTP/2 | Возможен автопереход на HTTP/2 | Принудительно HTTP/1.1 | HTTP ✅ |

| Безопасность вызова | Высокая (шифрование) | Средняя (открытый текст) | HTTP ⚠️ (подходит для внутренних сетей) |

| Стабильность таймаутов | Средняя (TLS таймаут + чтение) | Высокая (только таймаут чтения) | HTTP ✅ |

Пример полной конфигурации для HTTP-интерфейса APIYI

import requests

# Конфигурация HTTP-порта платформы APIYI

APIYI_HTTP_ENDPOINT = "http://api.apiyi.com:16888/v1"

APIYI_API_KEY = "YOUR_APIYI_API_KEY"

def generate_nano_banana_image(

prompt: str,

size: str = "4096x4096"

) -> dict:

"""

Генерация изображения Nano Banana Pro через HTTP-интерфейс APIYI

Args:

prompt: промпт для изображения

size: размер изображения

Returns:

Результат ответа API

"""

# Динамическая настройка таймаута в зависимости от разрешения

timeout_map = {

"1024x1024": 300, # 1K: 300 сек.

"2048x2048": 300, # 2K: 300 сек.

"4096x4096": 600 # 4K: 600 сек.

}

timeout = timeout_map.get(size, 600) # По умолчанию 600 сек.

response = requests.post(

f"{APIYI_HTTP_ENDPOINT}/images/generations",

json={

"prompt": prompt,

"size": size,

"model": "nano-banana-pro",

"n": 1,

"response_format": "url" # Или "b64_json"

},

headers={

"Authorization": f"Bearer {APIYI_API_KEY}",

"Content-Type": "application/json"

},

timeout=(10, timeout) # (таймаут соединения, таймаут чтения)

)

response.raise_for_status()

return response.json()

# Пример использования

try:

result = generate_nano_banana_image(

prompt="A photorealistic portrait of a cat",

size="4096x4096"

)

print(f"✅ Успешно сгенерировано!")

print(f"URL изображения: {result['data'][0]['url']}")

print(f"Размер: {result['data'][0]['size']}")

except requests.exceptions.Timeout:

print("❌ Время ожидания истекло, проверьте сеть или попробуйте позже")

except requests.exceptions.HTTPError as e:

print(f"❌ Ошибка API: {e}")

except Exception as e:

print(f"❌ Неизвестная ошибка: {e}")

💡 Лучшая практика: В продакшн-среде рекомендуется отдавать приоритет HTTP-порту APIYI (

http://api.apiyi.com:16888/v1). Этот интерфейс оптимизирован платформой: в нем по умолчанию настроены разумные таймауты и стратегии повторов, что значительно повышает вероятность успешного вызова Nano Banana Pro API, особенно в сценариях генерации 4K-изображений.

Часто задаваемые вопросы

Q1: Почему у меня все равно происходит таймаут, хотя я установил 600 секунд?

Возможные причины:

-

Установлен только таймаут на соединение, но не на чтение:

# ❌ Ошибка: timeout=600 влияет только на установку соединения response = requests.post(url, json=data, timeout=600) # ✅ Правильно: раздельная настройка таймаута на соединение и чтение response = requests.post(url, json=data, timeout=(10, 600)) -

Промежуточные прокси или Load Balancer имеют более жесткие ограничения:

- AWS ALB: таймаут простоя по умолчанию 60 секунд.

- Nginx:

proxy_read_timeoutпо умолчанию 60 секунд. - Бесплатный тариф Cloudflare: максимальный таймаут 100 секунд.

Решение: Используйте HTTP-порт APIYI. Этот интерфейс уже оптимизирован на уровне платформы для работы с длительными таймаутами.

-

Нестабильная сеть или реальное время генерации превышает 600 секунд:

- В пиковые периоды (например, 17 января 2026 года) время обработки некоторых запросов превышало 180 секунд.

- Задержки в международных сетях могут добавлять еще 50–100 секунд.

Решение: Реализуйте механизм повторных попыток (retry) и воспользуйтесь функцией компенсации оплаты на платформе APIYI.

Q2: Безопасен ли HTTP-интерфейс? Не перехватят ли мои данные?

Анализ безопасности:

| Сценарий | Безопасность HTTP | Рекомендация |

|---|---|---|

| Внутренние вызовы (VPC/частная сеть) | Высокая (нет выхода в интернет) | ✅ Рекомендуется HTTP |

| Вызовы через интернет (разработка и тест) | Средняя (риск утечки API Key) | ⚠️ Следите за безопасностью ключа |

| Вызовы через интернет (продакшн) | Низкая (передача в открытом виде) | ❌ В приоритете HTTPS |

| Вызовы через VPN/выделенный канал | Высокая (шифрование на уровне VPN) | ✅ Рекомендуется HTTP |

Лучшие практики:

- Локальная сеть: Используйте HTTP-интерфейс для максимальной производительности.

- Публичная сеть: Если важна безопасность — выбирайте HTTPS. Если в приоритете стабильность — используйте HTTP и регулярно меняйте API Key.

- Гибридная среда: Для обычных промптов используйте HTTP, для конфиденциального контента — HTTPS.

Q3: Нужно ли ставить таймаут 300 секунд для изображений 1K и 2K?

Рекомендуемые настройки:

Хотя генерация 1K и 2K изображений обычно занимает от 30 до 120 секунд, мы всё равно советуем ставить 300 секунд по следующим причинам:

- Сетевые колебания: Даже при быстрой генерации задержки в сети могут добавить 30–50 секунд.

- Пиковые нагрузки: Инцидент 17.01.2026 показал, что в экстремальных случаях время генерации может удвоиться.

- Запас прочности: Таймаут в 300 секунд не увеличивает ваши расходы, но помогает избежать лишних повторных запросов.

Данные реальных тестов (статистика платформы APIYI):

| Разрешение | P50 (медиана) | P95 (95-й процентиль) | P99 (99-й процентиль) | Рекомендуемый таймаут |

|---|---|---|---|---|

| 1K | 45 сек | 90 сек | 150 сек | 300 сек |

| 2K | 65 сек | 120 сек | 180 сек | 300 сек |

| 4K | 120 сек | 170 сек | 250 сек | 600 сек |

Вывод: Используйте 300 секунд для 1K/2K и 600 секунд для 4K — это покроет более 99% всех сценариев.

Q4: Как понять: это проблема таймаута или перегрузка API?

Методы диагностики:

| Тип ошибки | Типичное сообщение | Статус-код HTTP | Можно ли повторить? |

|---|---|---|---|

| Ошибка таймаута | ReadTimeout, Connection timeout |

Нет (ошибка клиента) | ✅ Да |

| Перегрузка API | The model is overloaded |

503 или 429 | ✅ Да, после паузы |

| API недоступен | The service is currently unavailable |

503 | ✅ Да, после паузы |

| Ошибка авторизации | Invalid API key |

401 | ❌ Нет, проверьте ключ |

Признаки ошибки таймаута:

except requests.exceptions.Timeout:

# Таймаут на стороне клиента, ответ от сервера не получен

print("Запрос истек по таймауту")

except requests.exceptions.HTTPError as e:

if e.response.status_code == 503:

# Сервер вернул 503, явный признак перегрузки

print("API перегружен")

Алгоритм действий:

- Если возникло исключение

Timeout— значит, проблема в таймауте. Увеличьте время ожидания или перейдите на HTTP-интерфейс. - Если получен HTTP-ответ со статусом 503/429 — API перегружен. Подождите немного или смените провайдера API.

- Если в ответе написано "overloaded" — значит, у Google не хватает вычислительных ресурсов. Попробуйте использовать резервные модели на APIYI (например, Seedream 4.5).

Резюме

Основные моменты по решению проблемы разрыва соединений в Nano Banana Pro API:

- Настройка таймаута: Рекомендуется 300 секунд для 1K/2K и 600 секунд для 4K, чтобы нивелировать влияние сетевых колебаний и пиковых нагрузок.

- Проблемы HTTP/2: В сценариях с длительными соединениями HTTP/2 может страдать от блокировок начала очереди TCP и исчерпания идентификаторов потоков. Рекомендуется принудительно использовать HTTP/1.1.

- Преимущества HTTP-порта: HTTP-интерфейс APIYI (http://api.apiyi.com:16888/v1) исключает затраты на TLS-рукопожатие и согласование HTTP/2, что значительно повышает стабильность.

- Стратегия повторов: Используйте повторные попытки при таймаутах с экспоненциальной задержкой для обработки временных сетевых сбоев.

- Оптимизация платформы: Платформа APIYI предлагает преднастроенные таймауты, умные повторы и систему компенсаций, что заметно повышает вероятность успешной генерации 4K-изображений.

Для быстрой интеграции Nano Banana Pro API рекомендуем использовать APIYI (apiyi.com). Платформа предоставляет специально оптимизированные HTTP-интерфейсы с разумными таймаутами по умолчанию и поддерживает генерацию во всех разрешениях от 1K до 4K, что идеально подходит для продакшн-решений.

Автор: Техническая команда APIYI | Если у вас остались вопросы, заходите на apiyi.com за новыми решениями по интеграции больших языковых моделей.