«Привет! У меня есть аккаунт в Google AI Studio, но бесплатный лимит исчерпан. Я хочу и дальше создавать модели в AI Studio, но мой аккаунт не позволяет пополнить баланс. Как мне закинуть деньги на этот аккаунт или как использовать сервис по-другому?»

Такие вопросы мы получаем каждый день. Бесплатные лимиты Google AI Studio действительно невелики, а в декабре 2025 года Google еще и существенно урезал квоты для бесплатного уровня.

Хорошая новость: вам не нужно пополнять баланс аккаунта Google, чтобы продолжать пользоваться всей линейкой моделей Gemini.

Основная идея проста: экспортируйте свой код и вызывайте API локально.

В этой статье мы подробно разберем 3 решения, которые помогут вам продолжить работу с Gemini после исчерпания лимитов.

Разбираемся с лимитами AI Studio

Текущие квоты бесплатного уровня (2026 год)

7 декабря 2025 года Google внес серьезные изменения в квоты Gemini Developer API, из-за чего приложения многих разработчиков внезапно начали выдавать ошибку 429:

| Модель | RPM (Бесплатный уровень) | RPD (Бесплатный уровень) | RPM (Платный уровень) |

|---|---|---|---|

| Gemini 2.5 Pro | 5 | 25 | 1 000 |

| Gemini 2.5 Flash | 15 | 500 | 2 000 |

| Gemini 2.0 Flash | 15 | 1 500 | 4 000 |

Примечание: RPM = количество запросов в минуту, RPD = количество запросов в день.

Почему лимиты внезапно заканчиваются

| Причина | Описание |

|---|---|

| Превышение RPM | Слишком много запросов за короткий промежуток времени |

| Превышение RPD | Достигнут суточный лимит запросов |

| Превышение TPM | Длинный контекст потребляет большое количество токенов |

| Снижение квот | После корректировки Google в 12.2025 ограничения стали намного строже |

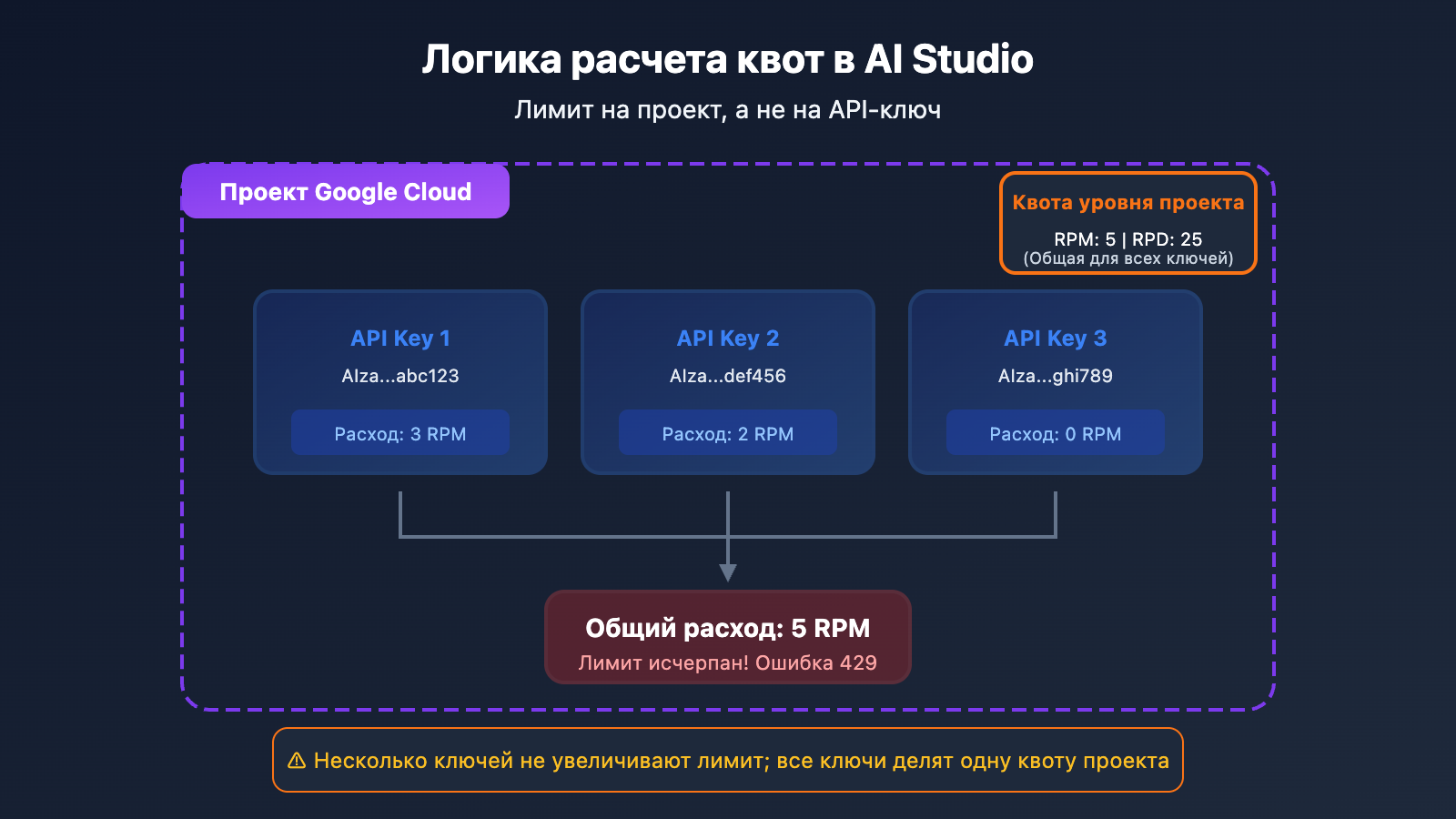

Важное напоминание: несколько API-ключей не суммируют квоту

Многие пользователи думают, что создание нескольких API-ключей даст им больше лимитов, но на деле:

Квота рассчитывается на проект (Project), а не на API-ключ. Создание нескольких ключей в рамках одного проекта не увеличит общую квоту.

Вариант 1: Экспорт кода для локальной разработки (рекомендуется)

Суть метода

AI Studio — это, по сути, визуальный инструмент для отладки промптов. Модели, которые вы создаете, и промпты, которые вы отлаживаете в AI Studio, можно экспортировать в виде кода и запускать в локальной среде, используя собственный API Key.

Инструкция

Шаг 1: Отладка промпта в AI Studio

Используйте бесплатные лимиты AI Studio, чтобы довести до идеала ваш промпт и настроить параметры конфигурации.

Шаг 2: Экспорт кода

AI Studio предлагает несколько способов экспорта:

- Скачать ZIP: экспорт полного пакета кода на локальный компьютер.

- Push в GitHub: прямая отправка в ваш репозиторий.

- Копирование фрагментов: копирование кода на Python, JavaScript или curl.

Шаг 3: Настройка API Key локально

# Установка переменной окружения (рекомендуется)

export GEMINI_API_KEY="ваш-api-key"

# Или

export GOOGLE_API_KEY="ваш-api-key"

Шаг 4: Локальный запуск

import google.generativeai as genai

import os

# Автоматическое чтение API Key из переменных окружения

genai.configure(api_key=os.environ.get("GEMINI_API_KEY"))

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Привет, расскажи о себе")

print(response.text)

На что обратить внимание

| Момент | Описание |

|---|---|

| Безопасность API Key | Не зашивайте API Key прямо в код приложения |

| Переменные окружения | Используйте GEMINI_API_KEY или GOOGLE_API_KEY |

| Ограничение квот | Локальные вызовы всё равно ограничены бесплатным уровнем доступа |

🎯 Технический совет: Если после экспорта кода бесплатных квот всё равно не хватает, присмотритесь к сторонним провайдерам, таким как APIYI (apiyi.com). Эти платформы предлагают расширенные лимиты и более гибкие тарифы.

Вариант 2: Использование сторонних прокси-сервисов API (оптимальный выбор)

Что такое прокси-сервис API

Провайдеры прокси-сервисов агрегируют множество ключей и ресурсов аккаунтов, предоставляя единый интерфейс API. Вам нужно лишь:

- Зарегистрироваться на платформе-агрегаторе и получить API Key.

- Заменить в коде адрес API на адрес прокси-сервера.

- Продолжать работу, забыв о проблемах с квотами.

Почему стоит выбрать API-прокси

| Преимущество | Описание |

|---|---|

| Никакой тревоги из-за квот | Провайдер сам управляет лимитами, вы просто пользуетесь |

| Поддержка всех моделей | Полный охват: Gemini Pro, Flash, Nano Banana и другие |

| Формат OpenAI | Не нужно менять структуру существующего кода |

| Оплата по факту | Платите только за то, что использовали, без абонентской платы |

| Стабильность | Балансировка нагрузки между узлами исключает блокировки |

Пример миграции кода

До (прямой вызов Google API):

import google.generativeai as genai

genai.configure(api_key="YOUR_GOOGLE_API_KEY")

model = genai.GenerativeModel('gemini-2.0-flash')

response = model.generate_content("Hello")

После (через API-прокси):

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # Унифицированный интерфейс APIYI

)

response = client.chat.completions.create(

model="gemini-2.0-flash",

messages=[{"role": "user", "content": "Hello"}]

)

print(response.choices[0].message.content)

Список поддерживаемых моделей

| Серия моделей | Конкретные модели | Описание |

|---|---|---|

| Gemini 2.5 | gemini-2.5-pro, gemini-2.5-flash | Новейшие мультимодальные модели |

| Gemini 2.0 | gemini-2.0-flash, gemini-2.0-flash-thinking | Модели с быстрым рассуждением |

| Gemini 3 | gemini-3-pro-image-preview | Модели генерации изображений |

| Nano Banana | nano-banana-pro | Нативная генерация изображений |

💡 Быстрый старт: Для быстрого подключения рекомендуем платформу APIYI (apiyi.com). Она поддерживает всю линейку моделей Gemini, совместима с форматом OpenAI, а миграция займет не более 5 минут.

Вариант 3: Переход на платный уровень Google

Сравнение квот на платных уровнях

Если вы хотите продолжать использовать официальные сервисы Google, можно рассмотреть переход на платный тариф (Pay-as-you-go):

| Уровень | Условие активации | Gemini 2.5 Pro RPM | Gemini 2.5 Flash RPM |

|---|---|---|---|

| Free | По умолчанию | 5 | 15 |

| Tier 1 | Включен биллинг | 150 | 1 000 |

| Tier 2 | Расходы > $50 | 500 | 2 000 |

| Tier 3 | Расходы > $500 | 1 000 | 4 000 |

Как перейти на платный уровень

- Войдите в Google Cloud Console.

- Создайте или выберите существующий проект.

- Включите биллинг (привяжите банковскую карту).

- Проверьте изменение лимитов в AI Studio.

Нюансы платных уровней

| Проблема | Описание |

|---|---|

| Нужна международная карта | Пользователям внутри РФ и некоторых других стран оформить её сложно. |

| Аккаунт Google Cloud | Настройка биллинга и проектов сложнее, чем просто получение ключа. |

| Порог минимальных трат | Для перехода на высокие уровни (Tier 2/3) нужно сначала потратить определенную сумму. |

| Лимиты все равно есть | Это не «безлимит», а просто расширенные квоты. |

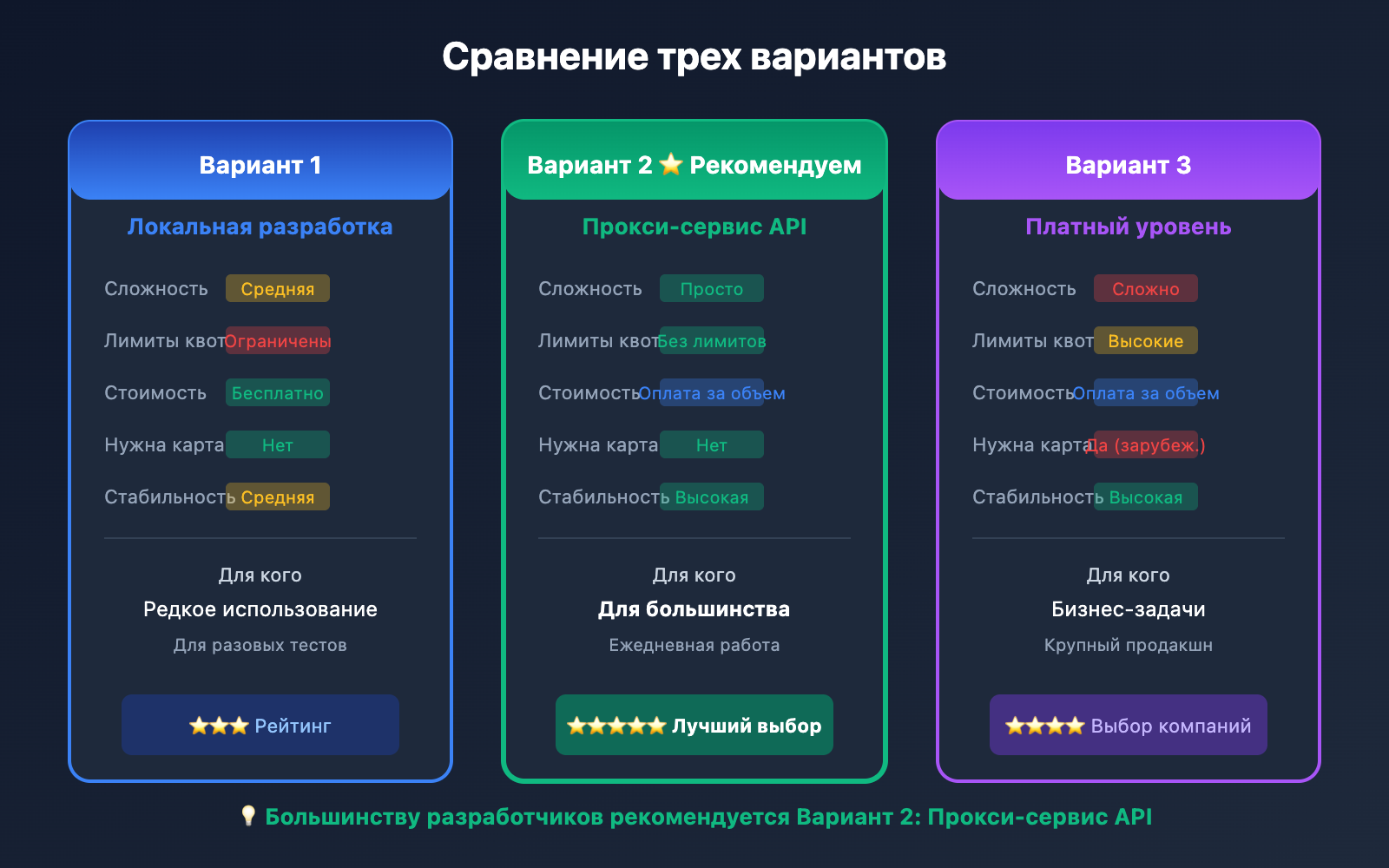

Сравнение трех вариантов

| Критерий сравнения | Локальная разработка | Прокси-сервис API | Платный уровень Google |

|---|---|---|---|

| Сложность настройки | Средняя | Просто | Сложно |

| Лимиты квот | Все еще ограничены | Практически безлимитно | Лимиты значительно выше |

| Стоимость | Бесплатно (с лимитами) | Оплата по факту использования | Оплата по факту использования |

| Нужна банк. карта | Нет | Нет | Да (международная) |

| Стабильность | Средняя | Высокая | Высокая |

| Кому подходит | Редкое использование | Рекомендуем большинству | Корпоративный сектор |

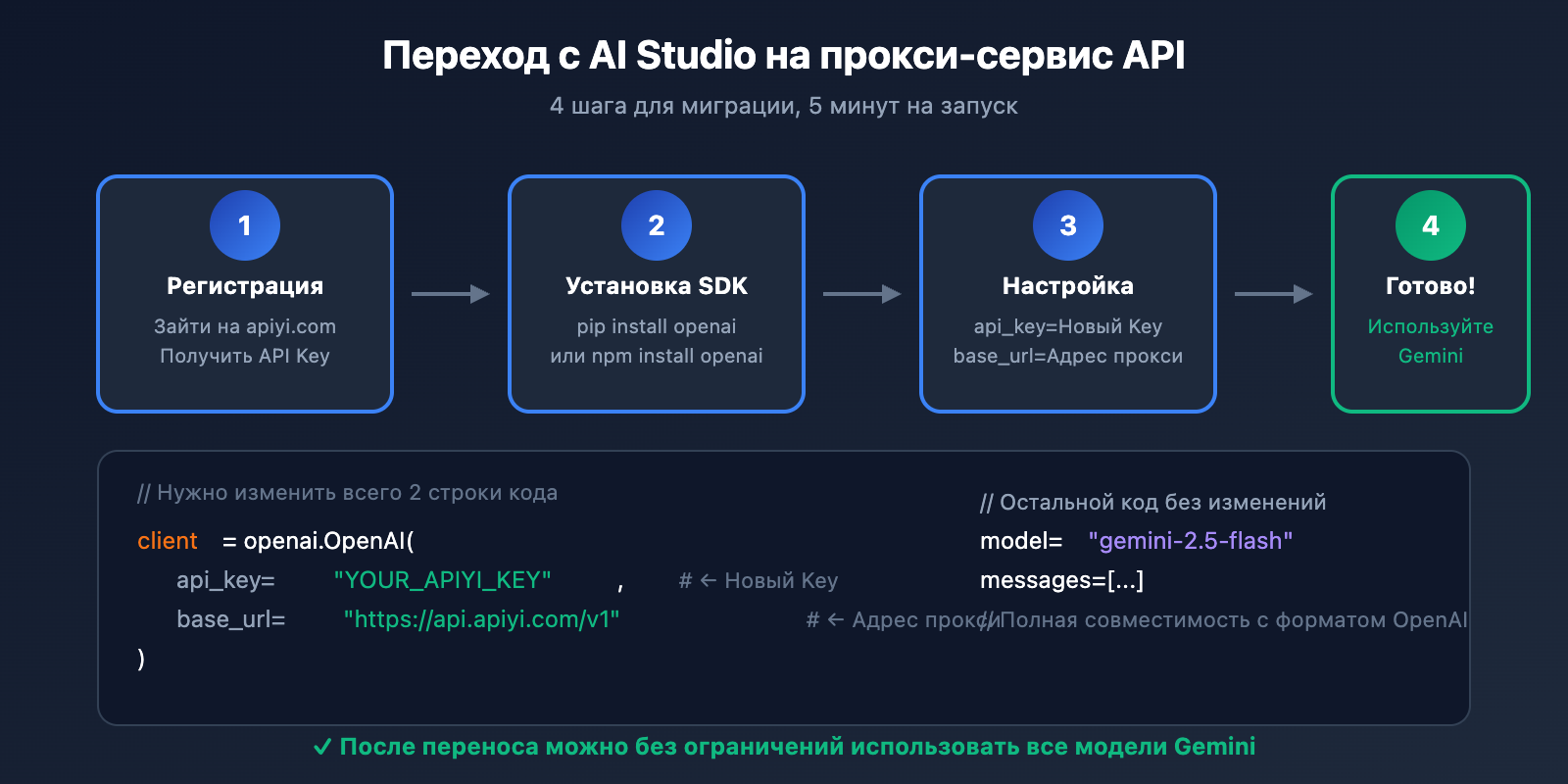

Подробное руководство: переход с AI Studio на API-прокси

Шаг 1: Регистрация аккаунта на платформе API-прокси

Зайдите на сайт APIYI (apiyi.com), зарегистрируйтесь и получите свой API Key.

Шаг 2: Установка OpenAI SDK

# Python

pip install openai

# Node.js

npm install openai

Шаг 3: Настройка кода

Пример на Python:

import openai

# 配置 API 代理

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1" # APIYI统一接口

)

# 调用 Gemini 模型

def chat_with_gemini(prompt):

response = client.chat.completions.create(

model="gemini-2.5-flash", # 可选其他 Gemini 模型

messages=[

{"role": "user", "content": prompt}

],

temperature=0.7,

max_tokens=2048

)

return response.choices[0].message.content

# 使用示例

result = chat_with_gemini("用 Python 写一个快速排序算法")

print(result)

Пример на Node.js:

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: 'YOUR_APIYI_KEY',

baseURL: 'https://api.apiyi.com/v1'

});

async function chatWithGemini(prompt) {

const response = await client.chat.completions.create({

model: 'gemini-2.5-flash',

messages: [

{ role: 'user', content: prompt }

]

});

return response.choices[0].message.content;

}

// 使用示例

const result = await chatWithGemini('解释什么是机器学习');

console.log(result);

Шаг 4: Тестирование и проверка

# 测试连接

try:

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": "Hello, 测试连接"}],

max_tokens=50

)

print("连接成功:", response.choices[0].message.content)

except Exception as e:

print("连接失败:", e)

Миграция моделей генерации изображений

Генерация изображений в AI Studio

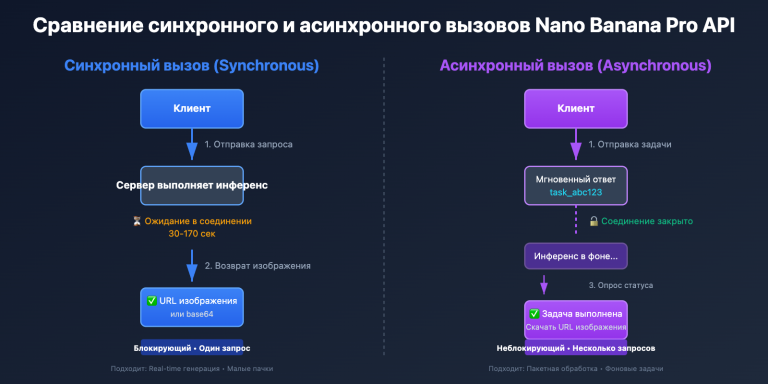

Если вы используете функции генерации изображений Gemini (Nano Banana Pro) в AI Studio, вы точно так же можете продолжать работу через API-прокси:

import openai

client = openai.OpenAI(

api_key="YOUR_APIYI_KEY",

base_url="https://api.apiyi.com/v1"

)

# 图像生成

response = client.images.generate(

model="nano-banana-pro",

prompt="一只可爱的橘猫在阳光下打盹,写实摄影风格",

size="1024x1024",

quality="hd"

)

image_url = response.data[0].url

print(f"生成的图像: {image_url}")

Мультимодальные диалоги (текст + изображения)

import base64

def encode_image(image_path):

with open(image_path, "rb") as f:

return base64.b64encode(f.read()).decode()

image_base64 = encode_image("example.jpg")

response = client.chat.completions.create(

model="gemini-2.5-flash",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": "描述这张图片的内容"},

{

"type": "image_url",

"image_url": {

"url": f"data:image/jpeg;base64,{image_base64}"

}

}

]

}

]

)

print(response.choices[0].message.content)

💰 Оптимизация затрат: Для задач генерации изображений платформа APIYI (apiyi.com) предлагает гибкую систему тарификации и поддержку множества моделей, включая Nano Banana Pro, DALL-E и Stable Diffusion, что позволяет выбрать оптимальное решение под ваши нужды.

Обработка распространенных ошибок

Ошибка 1: 429 Too Many Requests

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10))

def call_api_with_retry(prompt):

return client.chat.completions.create(

model="gemini-2.5-flash",

messages=[{"role": "user", "content": prompt}]

)

Ошибка 2: Недействительный API-ключ

# 检查 API Key 配置

import os

api_key = os.environ.get("APIYI_KEY")

if not api_key:

raise ValueError("请设置 APIYI_KEY 环境变量")

client = openai.OpenAI(

api_key=api_key,

base_url="https://api.apiyi.com/v1"

)

Ошибка 3: Модель не существует

# 确认模型名称正确

SUPPORTED_MODELS = [

"gemini-2.5-pro",

"gemini-2.5-flash",

"gemini-2.0-flash",

"nano-banana-pro"

]

model_name = "gemini-2.5-flash"

if model_name not in SUPPORTED_MODELS:

print(f"警告: {model_name} 可能不在支持列表中")

Часто задаваемые вопросы (FAQ)

Q1: Когда обновляются бесплатные лимиты AI Studio?

- RPM (запросов в минуту): скользящее окно, обновляется каждую минуту.

- RPD (запросов в день): обновляется в полночь по тихоокеанскому времени (PST).

- TPM (токенов в минуту): скользящее окно, обновляется каждую минуту.

Если лимиты нужны прямо сейчас, рекомендуем использовать платформу APIYI (apiyi.com) — там не нужно ждать сброса квот.

Q2: Безопасно ли использовать API-прокси?

Использовать проверенных сервис-провайдеров безопасно. Главное помнить о базовых правилах:

- Выбирайте поставщиков с хорошей репутацией.

- Не прописывайте API-ключи прямо в коде (хардкод).

- Используйте переменные окружения для управления ключами.

Q3: Сколько стоят услуги API-прокси?

Большинство прокси-сервисов работают по модели оплаты за фактическое использование (Pay-as-you-go), и часто это выходит выгоднее официальных тарифов. Платформа APIYI (apiyi.com) предлагает прозрачную систему тарификации, которую можно изучить прямо на сайте.

Q4: Придется ли сильно переписывать код после миграции?

Если вы используете API-прокси с поддержкой формата OpenAI, изменения будут минимальными:

- Нужно заменить только

api_keyиbase_url. - Возможно, подправить названия моделей.

- Вся остальная логика кода останется прежней.

Q5: Можно ли использовать несколько API-сервисов одновременно?

Конечно. Вы можете комбинировать их в зависимости от задач:

- Бесплатные лимиты AI Studio — для легких тестов.

- API-прокси — для повседневной разработки.

- Официальный платный тариф — для специфических корпоративных задач.

Итоги

Когда бесплатные лимиты в Google AI Studio заканчиваются, у вас есть 3 варианта:

| Вариант | Кому подходит | Что нужно сделать |

|---|---|---|

| Локальная разработка | Тем, кто пользуется редко | Экспортировать код и запускать локально |

| API-прокси | Большинству разработчиков | Сменить base_url и работать дальше |

| Платный тариф | Корпоративному сектору | Привязать иностранную карту и поднять лимиты |

Основные советы:

- Не спешите пополнять баланс Google-аккаунта (если только у вас нет международной карты и вам не нужны корпоративные мощности).

- Экспортируйте свой код в локальную среду.

- Используйте API-прокси, чтобы продолжить работу с моделями Gemini.

- Суть в одной фразе: Просто заберите свой код и запускайте его локально.

Для быстрого восстановления доступа к Gemini рекомендуем APIYI (apiyi.com). Платформа поддерживает всю линейку моделей Gemini, совместима с форматом OpenAI, поэтому переезд займет считанные минуты.

Что еще почитать:

- Лимиты Gemini API: ai.google.dev/gemini-api/docs/rate-limits

- Режимы сборки в AI Studio: ai.google.dev/gemini-api/docs/aistudio-build-mode

- Гайд по использованию API-ключей: ai.google.dev/gemini-api/docs/api-key

📝 Автор: Техническая команда APIYI | Специализируемся на интеграции и оптимизации API больших языковых моделей.

🔗 Общение и поддержка: Заходите на APIYI (apiyi.com) для доступа ко всей линейке моделей Gemini.