好消息——Gemini 3.1 Pro Preview 已在 APIYI上线,现在就可以通过 API 调用。模型名称 gemini-3.1-pro-preview,提示价格 $2.00/1M tokens,补全价格 $12.00/1M tokens,与 Gemini 3.0 Pro Preview 价格完全一致。

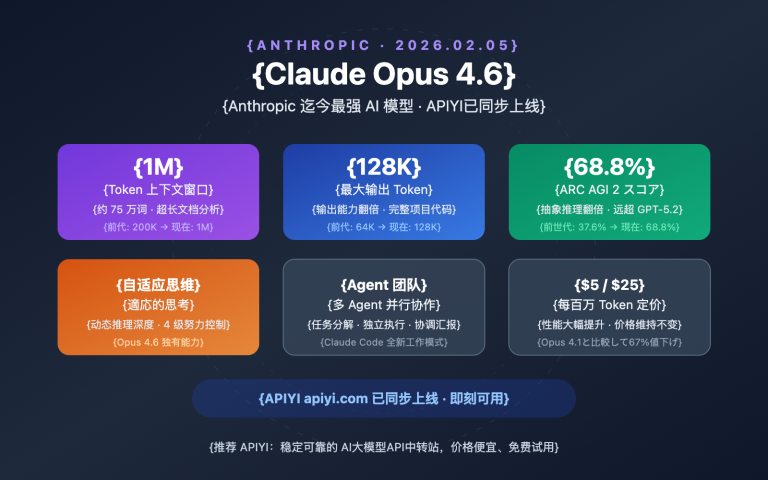

但能力完全不在一个量级: Gemini 3.1 Pro 在 ARC-AGI-2 推理基准上达到 77.1%,是 3.0 Pro 的 2 倍以上; SWE-Bench Verified 编码评分 80.6%,首次超越 Claude Opus 4.6 的 80.9% 形成正面竞争; 输出效率提升 15%,用更少的 token 得到更可靠的结果。

核心价值: 本文将详解 Gemini 3.1 Pro Preview 的 6 大核心升级、API 调用方法、与竞品的详细对比,以及在不同场景下的最佳实践。

Gemini 3.1 Pro Preview 核心参数一览

| 参数项 | 详情 |

|---|---|

| 模型名称 | gemini-3.1-pro-preview |

| 发布日期 | 2026 年 2 月 19 日 |

| 提示价格 (≤200K tokens) | $2.00 / 百万 tokens |

| 补全价格 (≤200K tokens) | $12.00 / 百万 tokens |

| 提示价格 (>200K tokens) | $4.00 / 百万 tokens |

| 补全价格 (>200K tokens) | $18.00 / 百万 tokens |

| 上下文窗口 | 1,000,000 tokens (1M) |

| 最大输出 | 65,000 tokens (65K) |

| 文件上传上限 | 100MB (原 20MB) |

| 知识截止日期 | 2025 年 1 月 |

| APIYI可用状态 | ✅ 已上线 |

🚀 即刻体验: Gemini 3.1 Pro Preview 已在 APIYI apiyi.com 上线,通过 OpenAI 兼容格式即可调用,无需注册谷歌账号,5 分钟完成集成。

Gemini 3.1 Pro Preview 6つの主要アップデート

アップデート 1: 推論性能が倍増——ARC-AGI-2で77.1%を達成

今回のアップデートで最も注目すべき点です。未知の論理パターンを解決する能力を評価するARC-AGI-2ベンチマークにおいて、Gemini 3.1 Proは77.1%を記録しました。これはGemini 3.0 Proの2倍以上のスコアです。

また、Model Context Protocolを用いたマルチステップのワークフロー能力を測定するMCP Atlasベンチマークでは、3.1 Proが69.2%に達し、3.0 Proの54.1%から15ポイント向上しました。

これは、複雑な推論、多段階の論理チェーン、エージェントのワークフローといったシナリオにおいて、Gemini 3.1 Proが質的な飛躍を遂げたことを意味しています。

アップデート 2: 3段階の思考深度システム——Deep Think Mini

Gemini 3.1 Proでは、新たに3段階の思考深度システムが導入されました。開発者はタスクの複雑さに応じて「推論予算」を柔軟に調整できます。

| 思考レベル | 行動特性 | 活用シーン | 遅延への影響 |

|---|---|---|---|

| high | Gemini Deep Thinkのミニ版に近い深い推論 | 数学的証明、複雑なデバッグ、戦略立案 | 高め |

| medium | 3.0 Proのhighレベルに相当 | コードレビュー、技術分析、アーキテクチャ設計 | 適度 |

| low | 高速レスポンス、最小限の推論コスト | データ抽出、フォーマット変換、簡単な質疑応答 | 最低 |

重要なポイント:3.1 Proのhighレベルは意味合いが一新されました。これは現在、Gemini Deep Thinkの「ミニ版」となっており、推論の深さは3.0 Proのhighを遥かに凌駕します。一方で3.1のmediumが従来の3.0のhighとほぼ同等であるため、mediumを使用するだけでも、以前の最高レベルの推論品質を得ることができます。

アップデート 3: コーディング能力がトップクラスに到達——SWE-Bench 80.6%

Gemini 3.1 Proのコーディング分野における進化は目覚ましいものがあります。

| コーディングベンチマーク | Gemini 3.0 Pro | Gemini 3.1 Pro | 向上幅 |

|---|---|---|---|

| SWE-Bench Verified | 76.8% | 80.6% | +3.8% |

| Terminal-Bench 2.0 | 56.9% | 68.5% | +11.6% |

| LiveCodeBench Pro | — | Elo 2887 | 新ベンチマーク |

SWE-Bench Verifiedで80.6%という成績は、Gemini 3.1 ProがソフトウェアエンジニアリングタスクにおいてClaude 3.5 SonnetやClaude 4.6 (80.9%) とほぼ肩を並べ、その差がわずか0.3ポイントであることを示しています。

Terminal-Bench 2.0は、エージェントのターミナル操作によるコーディング能力を評価するものです。56.9%から68.5%への向上は、エージェント(Agentic)シナリオにおける3.1 Proの信頼性が大幅に強化されたことを裏付けています。

アップデート 4: 出力能力と効率の全面的な向上

| 項目 | Gemini 3.0 Pro | Gemini 3.1 Pro | 改善点 |

|---|---|---|---|

| 最大出力トークン | 不明 | 65,000 (65K) | 大幅向上 |

| ファイルアップロード上限 | 20MB | 100MB | 5倍 |

| YouTube URL対応 | ❌ | ✅ | 新機能 |

| 出力効率 | 基準 | +15% | より少ないトークンでより信頼性の高い結果 |

65Kの出力上限により、モデルは長大なドキュメント、大規模なコードブロック、詳細な分析レポートを、複数回に分けてリクエストすることなく一度に生成できるようになりました。

ファイルアップロードが20MBから100MBに拡張され、100万トークンのコンテキストウィンドウと組み合わせることで、大規模なコードリポジトリ、長尺動画、大量のドキュメントを直接分析することが可能です。

YouTube URLの直接入力は非常に実用的な新機能です。開発者はプロンプトにYouTubeのリンクを直接含めることができ、モデルが自動的に動画内容を分析します。手動でダウンロードしてアップロードする手間が省けます。

アップデート 5: customtools専用エンドポイント——エージェント開発の強力な武器

Googleは同時に、エージェント開発シナリオ向けに深く最適化されたgemini-3.1-pro-preview-customtools専用エンドポイントをリリースしました。

- ツール呼び出しの優先順位の最適化:

view_fileやsearch_codeなど、開発者が頻繁に使用するツールの呼び出し優先順位が調整されています。 - Bashとカスタム関数のハイブリッド: Bashコマンドとカスタム関数を切り替える必要があるエージェントのワークフローに特に適しています。

- エージェントシナリオの安定性: マルチステップのエージェントタスクにおいて、汎用バージョンよりも高い信頼性を発揮します。

AIプログラミングアシスタント、コードレビューBot、自動運用エージェントなどを構築している場合、customtoolsエンドポイントが最適な選択肢となります。

アップデート 6: ウェブ検索能力の飛躍——BrowseComp 85.9%

BrowseCompベンチマークは、モデルのエージェントによるウェブ検索能力を評価します。Gemini 3.1 Proは85.9%に達し、3.0 Proの59.2%から26.7ポイントという驚異的な向上を見せました。

この能力は、リアルタイムの情報検索を必要とするアプリケーション(リサーチアシスタント、競合分析、ニュース要約など)において大きな意義を持ちます。

💡 技術インサイト: Gemini 3.1 Proには、Bashコマンドとカスタム関数を併用する開発者向けに最適化された

gemini-3.1-pro-preview-customtoolsエンドポイントも用意されており、view_fileやsearch_codeといったツールの優先順位が特別に調整されています。APIYI (apiyi.com) を通じて、この専用エンドポイントを直接呼び出すことが可能です。

Gemini 3.1 Pro Preview API 活用ガイド

シンプルな呼び出し例 (Python)

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI统一接口

)

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "user", "content": "分析这段代码的时间复杂度并给出优化建议:\n\ndef two_sum(nums, target):\n for i in range(len(nums)):\n for j in range(i+1, len(nums)):\n if nums[i] + nums[j] == target:\n return [i, j]"}

]

)

print(response.choices[0].message.content)

完全な呼び出し例を表示(思考深度の制御とマルチモーダルを含む)

import openai

import base64

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://api.apiyi.com/v1" # APIYI统一接口

)

# 示例 1: 高推理深度 - 复杂数学推理

response_math = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": "证明: 对于所有正整数 n, n^3 - n 必然能被 6 整除。请给出严格的数学证明。"

}],

temperature=0.2,

max_tokens=4096

)

# 示例 2: 多模态分析 - 图片理解

with open("architecture.png", "rb") as f:

img_data = base64.b64encode(f.read()).decode()

response_vision = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "详细分析这张系统架构图,指出潜在的性能瓶颈和改进建议"},

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{img_data}"}}

]

}],

max_tokens=8192

)

# 示例 3: 长上下文代码 analysis

with open("large_codebase.txt", "r") as f:

code_content = f.read() # 可达数十万 tokens

response_code = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "system", "content": "你是一位资深软件架构师,请仔细分析整个代码仓库。"},

{"role": "user", "content": f"以下是完整代码仓库:\n\n{code_content}\n\n请分析:\n1. 整体架构设计\n2. 潜在的 bug\n3. 性能优化建议\n4. 代码重構方案"}

],

max_tokens=16384 # 利用 65K 输出能力

)

print(f"数学推理: {response_math.choices[0].message.content[:200]}...")

print(f"视觉分析: {response_vision.choices[0].message.content[:200]}...")

print(f"代码分析: {response_code.choices[0].message.content[:200]}...")

🎯 導入ヒント: APIYI (apiyi.com) を通じてGemini 3.1 Pro Previewを呼び出す際は、標準のOpenAI SDKを使用でき、追加のライブラリをインストールする必要はありません。既存のOpenAI形式のプロジェクトであれば、

base_urlとmodelパラメータを変更するだけで簡単に切り替えが可能です。