Bonne nouvelle — Gemini 3.1 Pro Preview est désormais disponible sur APIYI, et vous pouvez dès à présent l'appeler via API. Le nom du modèle est gemini-3.1-pro-preview, avec un prix de 2,00 $ / 1M de tokens pour l'invite et 12,00 $ / 1M de tokens pour la complétion, soit exactement le même tarif que Gemini 3.0 Pro Preview.

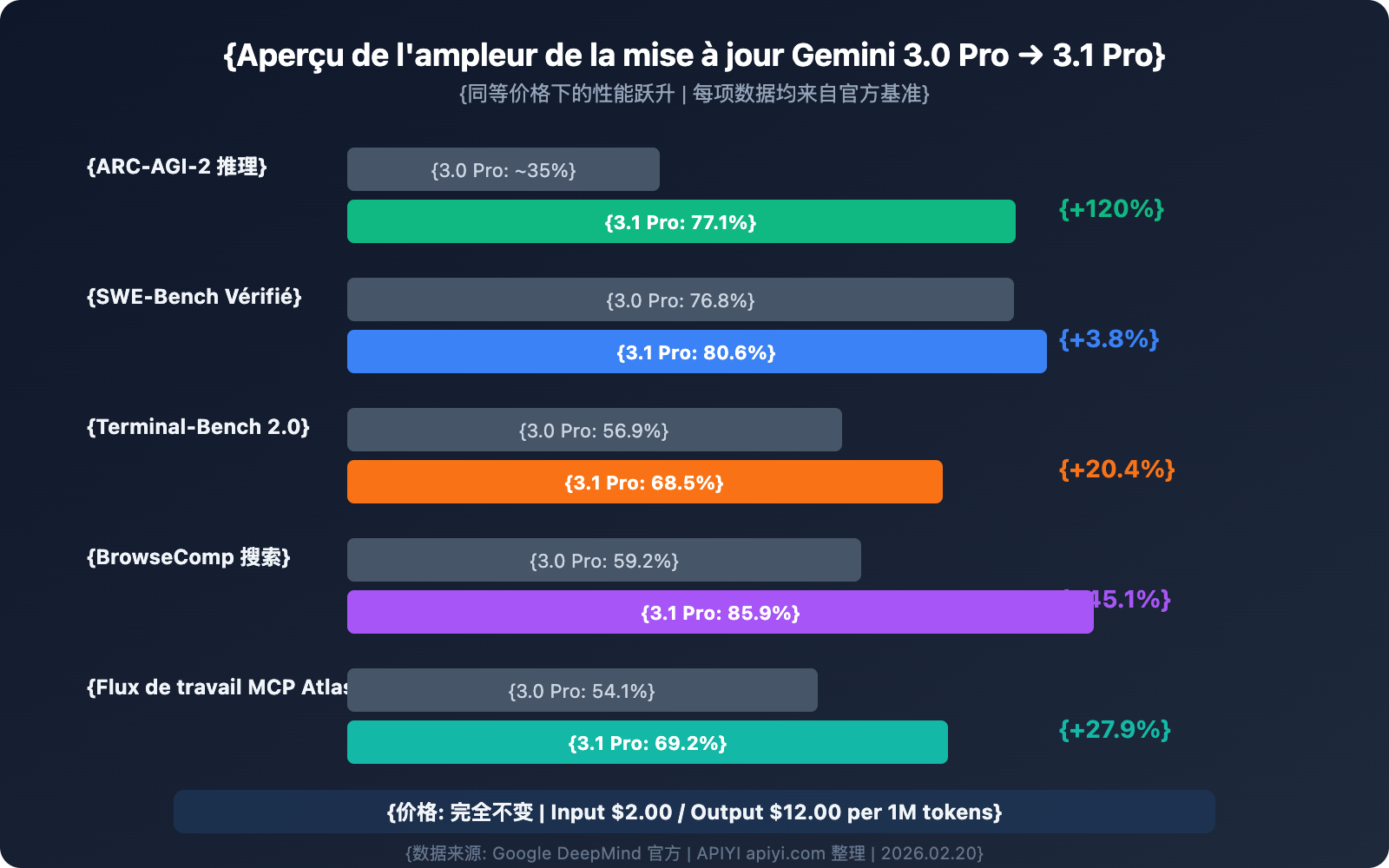

Pourtant, les capacités ne sont pas du tout du même ordre : Gemini 3.1 Pro atteint 77,1 % sur le benchmark de raisonnement ARC-AGI-2, soit plus de deux fois le score du 3.0 Pro. Son score de codage SWE-Bench Verified est de 80,6 %, surpassant pour la première fois les 80,9 % de Claude Opus 4.6 pour une compétition frontale. L'efficacité de sortie a été améliorée de 15 %, permettant d'obtenir des résultats plus fiables avec moins de tokens.

Valeur ajoutée : Cet article détaille les 6 améliorations majeures de Gemini 3.1 Pro Preview, la méthode d'appel API, une comparaison détaillée avec la concurrence, ainsi que les meilleures pratiques pour différents scénarios.

Aperçu des paramètres clés de Gemini 3.1 Pro Preview

| Paramètre | Détails |

|---|---|

| Nom du modèle | gemini-3.1-pro-preview |

| Date de sortie | 19 février 2026 |

| Prix de l'invite (≤200K tokens) | 2,00 $ / million de tokens |

| Prix de la complétion (≤200K tokens) | 12,00 $ / million de tokens |

| Prix de l'invite (>200K tokens) | 4,00 $ / million de tokens |

| Prix de la complétion (>200K tokens) | 18,00 $ / million de tokens |

| Fenêtre de contexte | 1 000 000 tokens (1M) |

| Sortie maximale | 65 000 tokens (65K) |

| Limite d'upload de fichiers | 100 Mo (contre 20 Mo auparavant) |

| Date de coupure des connaissances | Janvier 2025 |

| État de disponibilité sur APIYI | ✅ En ligne |

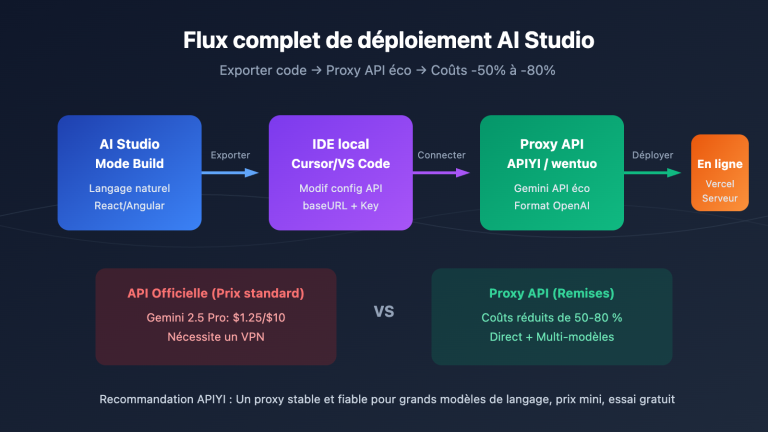

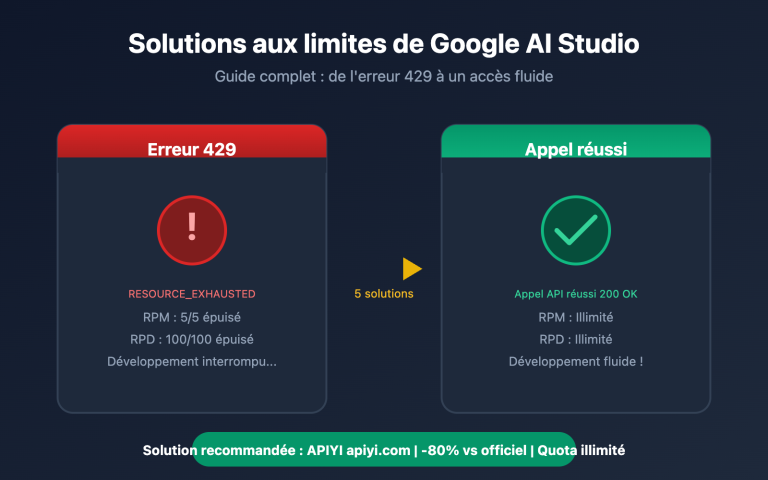

🚀 Testez-le dès maintenant : Gemini 3.1 Pro Preview est disponible sur APIYI (apiyi.com). Vous pouvez l'appeler via le format compatible OpenAI, sans avoir besoin de créer un compte Google. Intégration terminée en 5 minutes.

Les 6 améliorations majeures de Gemini 3.1 Pro Preview

Amélioration 1 : Performances de raisonnement doublées — ARC-AGI-2 atteint 77,1 %

C'est l'amélioration la plus frappante. Dans le benchmark ARC-AGI-2 (qui évalue la capacité du modèle à résoudre de nouveaux schémas logiques), Gemini 3.1 Pro atteint 77,1 %, soit plus de 2 fois le score de Gemini 3.0 Pro.

Parallèlement, sur le benchmark MCP Atlas (qui mesure la capacité à gérer des workflows multi-étapes via le Model Context Protocol), le 3.1 Pro atteint 69,2 %, soit une progression de 15 points par rapport aux 54,1 % du 3.0 Pro.

Cela signifie que pour le raisonnement complexe, les chaînes logiques multi-étapes et les workflows d'Agents, Gemini 3.1 Pro franchit un véritable cap qualitatif.

Amélioration 2 : Système de profondeur de réflexion à trois niveaux — Deep Think Mini

Gemini 3.1 Pro introduit un tout nouveau système de profondeur de réflexion à trois niveaux, permettant aux développeurs d'ajuster le « budget de raisonnement » selon la complexité de la tâche :

| Niveau de réflexion | Caractéristiques comportementales | Scénarios d'application | Impact sur la latence |

|---|---|---|---|

| high | Version mini de Gemini Deep Think, raisonnement profond | Preuves mathématiques, débogage complexe, planification stratégique | Élevée |

| medium | Équivalent au niveau "high" du 3.0 Pro | Revue de code, analyse technique, conception d'architecture | Modérée |

| low | Réponse rapide, coût de raisonnement minimal | Extraction de données, conversion de format, questions-réponses simples | Très faible |

Point clé : le niveau high du 3.1 Pro redéfinit la donne — il s'agit désormais d'une version « mini » de Gemini Deep Think, avec une profondeur de raisonnement bien supérieure au niveau high du 3.0 Pro. Le niveau medium du 3.1 équivaut à peu près au high du 3.0, ce qui signifie qu'on obtient l'ancienne qualité maximale même en réglage intermédiaire.

Amélioration 3 : Capacités de codage au sommet — SWE-Bench 80,6 %

Les performances de Gemini 3.1 Pro dans le domaine du code font un bond en avant :

| Benchmark de codage | Gemini 3.0 Pro | Gemini 3.1 Pro | Progression |

|---|---|---|---|

| SWE-Bench Verified | 76,8 % | 80,6 % | +3,8 % |

| Terminal-Bench 2.0 | 56,9 % | 68,5 % | +11,6 % |

| LiveCodeBench Pro | — | Elo 2887 | Nouveau benchmark |

Le score de 80,6 % sur SWE-Bench Verified signifie que Gemini 3.1 Pro fait désormais quasiment jeu égal avec Claude Opus 4.6 (80,9 %) sur les tâches de génie logiciel, avec un écart de seulement 0,3 point.

Terminal-Bench 2.0 évalue les capacités de codage en terminal pour les Agents — la progression de 56,9 % à 68,5 % montre que la fiabilité du 3.1 Pro dans les scénarios agentiques a été considérablement renforcée.

Amélioration 4 : Capacité de sortie et efficacité boostées

| Élément | Gemini 3.0 Pro | Gemini 3.1 Pro | Amélioration |

|---|---|---|---|

| Tokens de sortie max | Inconnu | 65 000 (65K) | Augmentation massive |

| Limite d'upload de fichiers | 20 Mo | 100 Mo | x 5 |

| Support des URL YouTube | ❌ | ✅ | Nouveau |

| Efficacité de sortie | Référence | +15 % | Plus de fiabilité avec moins de tokens |

La limite de sortie de 65K signifie que le modèle peut générer d'un seul coup des documents longs complets, de larges blocs de code ou des rapports d'analyse détaillés, sans avoir à multiplier les requêtes.

L'extension de l'upload de fichiers de 20 Mo à 100 Mo, combinée au contexte de 1M de tokens, permet d'analyser directement d'énormes dépôts de code, de longues vidéos ou des volumes massifs de documents.

Le support direct des URL YouTube est une nouvelle fonctionnalité très pratique : les développeurs peuvent passer un lien YouTube directement dans l'invite, et le modèle analysera automatiquement le contenu de la vidéo sans téléchargement manuel préalable.

Amélioration 5 : Endpoint dédié customtools — L'outil ultime pour les Agents

Google a également lancé l'endpoint dédié gemini-3.1-pro-preview-customtools, une version optimisée pour le développement d'Agents :

- Priorisation des appels d'outils : Optimisation spécifique de la priorité d'appel pour les outils fréquemment utilisés par les développeurs comme

view_fileousearch_code. - Mix Bash + Fonctions personnalisées : Particulièrement adapté aux workflows d'Agents devant basculer entre commandes bash et fonctions sur mesure.

- Stabilité en scénario agentique : Une fiabilité accrue par rapport à la version générique pour les tâches d'Agents multi-étapes.

Si vous construisez des assistants de programmation IA, des bots de revue de code ou des agents d'automatisation Ops, l'endpoint customtools est le meilleur choix.

Amélioration 6 : Bond en avant de la recherche web — BrowseComp 85,9 %

Le benchmark BrowseComp évalue la capacité de recherche web agentique du modèle. Gemini 3.1 Pro atteint 85,9 %, contre seulement 59,2 % pour le 3.0 Pro — soit une progression fulgurante de 26,7 points.

Cette capacité est cruciale pour les applications nécessitant une récupération d'informations en temps réel (assistants de recherche, analyse concurrentielle, résumés d'actualités).

💡 Insight technique : Gemini 3.1 Pro propose également l'endpoint spécialisé

gemini-3.1-pro-preview-customtools, optimisé pour les développeurs mélangeant commandes bash et fonctions personnalisées, avec un réglage fin des priorités pour des outils commeview_fileetsearch_code. Vous pouvez appeler cet endpoint dédié directement via APIYI (apiyi.com).

Mise en pratique de l'appel API Gemini 3.1 Pro Preview

Exemple d'appel minimaliste (Python)

import openai

client = openai.OpenAI(

api_key="VOTRE_CLE_API",

base_url="https://api.apiyi.com/v1" # Interface unifiée APIYI

)

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "user", "content": "Analyse la complexité temporelle de ce code et propose des optimisations :\n\ndef two_sum(nums, target):\n for i in range(len(nums)):\n for j in range(i+1, len(nums)):\n if nums[i] + nums[j] == target:\n return [i, j]"}

]

)

print(response.choices[0].message.content)

Voir l’exemple complet (avec contrôle de profondeur et multimodal)

import openai

import base64

client = openai.OpenAI(

api_key="VOTRE_CLE_API",

base_url="https://api.apiyi.com/v1" # Interface unifiée APIYI

)

# Exemple 1 : Haute profondeur de raisonnement - Raisonnement mathématique complexe

response_math = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": "Démontre que pour tout entier naturel n, n^3 - n est nécessairement divisible par 6. Fournis une démonstration mathématique rigoureuse."

}],

temperature=0.2,

max_tokens=4096

)

# Exemple 2 : Analyse multimodale - Compréhension d'image

with open("architecture.png", "rb") as f:

img_data = base64.b64encode(f.read()).decode()

response_vision = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "Analyse en détail ce schéma d'architecture système, identifie les goulots d'étranglement potentiels et suggère des améliorations."},

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{img_data}"}}

]

}],

max_tokens=8192

)

# Exemple 3 : Analyse de code sur contexte long

with open("large_codebase.txt", "r") as f:

code_content = f.read() # Peut atteindre des centaines de milliers de tokens

response_code = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "system", "content": "Tu es un architecte logiciel senior, analyse attentivement l'intégralité de ce dépôt de code."},

{"role": "user", "content": f"Voici le code complet du dépôt :\n\n{code_content}\n\nAnalyse :\n1. La conception architecturale globale\n2. Les bugs potentiels\n3. Les suggestions d'optimisation de performance\n4. Un plan de refactorisation"}

],

max_tokens=16384 # Exploitation de la capacité de sortie de 65K

)

print(f"Raisonnement mathématique : {response_math.choices[0].message.content[:200]}...")

print(f"Analyse visuelle : {response_vision.choices[0].message.content[:200]}...")

print(f"Analyse de code : {response_code.choices[0].message.content[:200]}...")

🎯 Conseil d'intégration : Pour appeler Gemini 3.1 Pro Preview via APIYI (apiyi.com), utilisez simplement le SDK OpenAI standard, sans installation de dépendances supplémentaires. Pour vos projets déjà au format OpenAI, il suffit de modifier les paramètres

base_urletmodelpour basculer.

Comparaison détaillée entre Gemini 3.1 Pro Preview et ses concurrents

Tableau comparatif des benchmarks clés

| Benchmark | Gemini 3.1 Pro | Claude Opus 4.6 | Claude Sonnet 4.6 | Vainqueur |

|---|---|---|---|---|

| SWE-Bench Verified | 80,6% | 80,9% | 79,6% | Claude Opus (de peu) |

| ARC-AGI-2 | 77,1% | ~65% | — | Gemini 3.1 Pro |

| Terminal-Bench 2.0 | 68,5% | — | — | Gemini 3.1 Pro |

| BrowseComp | 85,9% | ~71% | — | Gemini 3.1 Pro |

| MCP Atlas | 69,2% | — | — | Gemini 3.1 Pro |

| Fenêtre de contexte | 1M tokens | 200K | 200K | Gemini 3.1 Pro |

| Sortie maximale | 65K | — | — | Gemini 3.1 Pro |

| Prix Input | $2,00 | $15,00 | $3,00 | Gemini 3.1 Pro |

| Plateformes disponibles | APIYI apiyi.com etc. | APIYI apiyi.com etc. | APIYI apiyi.com etc. | — |

Recommandations de scénarios d'utilisation

| Scénario d'utilisation | Modèle recommandé | Raison principale |

|---|---|---|

| Raisonnement complexe et mathématiques | Gemini 3.1 Pro Preview | ARC-AGI-2 à 77,1%, raisonnement doublé |

| Analyse de documents ultra-longs / dépôts de code | Gemini 3.1 Pro Preview | Fenêtre de contexte de 1M de tokens, unique sur le marché |

| Programmation Agentic | Claude Opus 4.6 / Gemini 3.1 Pro | Résultats SWE-Bench quasi identiques |

| Workflows de recherche par Agent | Gemini 3.1 Pro Preview | BrowseComp à 85,9%, largement en tête |

| Codage quotidien de complexité moyenne | Claude Sonnet 4.6 | Excellent rapport qualité-prix, 79,6% en codage |

| Besoins haut de gamme avec budget limité | Gemini 3.1 Pro Preview | $2/$12, le prix le plus bas pour un modèle phare |

| Analyse multimodale Vidéo/Audio | Gemini 3.1 Pro Preview | Multimodalité native, support des URL YouTube |

💰 Comparaison des coûts : À capacités égales, le prix d'entrée (Input) de Gemini 3.1 Pro ($2,00) ne représente que 13% de celui de Claude Opus 4.6 ($15,00). Pour les scénarios de raisonnement et de multimodalité, l'avantage du rapport qualité-prix est flagrant. Via la plateforme APIYI apiyi.com, vous pouvez basculer rapidement entre les modèles avec une interface unique.

Meilleures pratiques pour Gemini 3.1 Pro Preview

Utiliser judicieusement les trois niveaux de réflexion

# Utiliser 'high' pour le raisonnement complexe (mode Deep Think Mini)

# Utiliser 'medium' pour les tâches quotidiennes (équivalent à l'ancien 'high')

# Utiliser 'low' pour les tâches simples (réponse la plus rapide)

# Lors de l'appel via APIYI, passez le niveau de réflexion via extra_body

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{"role": "user", "content": "Votre question"}],

extra_body={"thinking_level": "high"} # high/medium/low

)

Tirer pleinement parti de la fenêtre de contexte de 1M de Tokens

La fenêtre de contexte de 1M de tokens de Gemini 3.1 Pro Preview est la plus grande parmi tous les modèles phares actuels. Voici quelques scénarios à haute valeur ajoutée :

Analyse globale de dépôts de code : Envoyez des dizaines de fichiers d'un coup pour permettre au modèle de comprendre l'architecture complète avant de suggérer des refactorisations. C'est bien plus efficace que l'analyse fichier par fichier pour détecter les problèmes de couplage entre modules.

Compréhension profonde de documents longs : Contrats juridiques, spécifications techniques, recueils d'articles académiques — 1M de tokens peuvent contenir un livre entier. Combiné à la profondeur de raisonnement accrue de la version 3.1 Pro, même les liens implicites dans les documents longs peuvent être identifiés.

Analyse de vidéos YouTube (Nouvelle fonctionnalité) : Passez directement l'URL YouTube dans l'invite, sans avoir à télécharger ou uploader le fichier vidéo. Le modèle analysera automatiquement le contenu, idéal pour la modération, l'analyse concurrentielle ou le résumé de tutoriels.

Mémoire à long terme pour les dialogues : Une fenêtre de 1M de tokens signifie que le modèle peut "se souvenir" d'historiques de conversation extrêmement longs, un avantage majeur pour le support client, le conseil ou l'enseignement.

Attention au seuil de prix de 200K : Lorsque l'entrée dépasse 200K tokens, le prix double, passant de $2/$12 à $4/$18. Il est conseillé d'évaluer le nombre réel de tokens avant d'utiliser un contexte long ; pour les scénarios entre 200K et 300K, essayez de condenser l'entrée sous les 200K pour économiser la moitié des coûts.

Utilisation du point de terminaison customtools

Si vous construisez des applications basées sur des agents, le point de terminaison gemini-3.1-pro-preview-customtools mérite votre attention :

# Point de terminaison dédié au développement d'Agents

response = client.chat.completions.create(

model="gemini-3.1-pro-preview-customtools", # Version optimisée pour les Agents

messages=[{"role": "user", "content": "Trouve toutes les exceptions non gérées dans le projet et propose des correctifs"}],

tools=[

{"type": "function", "function": {"name": "search_code", "description": "Rechercher du code"}},

{"type": "function", "function": {"name": "view_file", "description": "Voir le fichier"}},

]

)

Ce point de terminaison surpasse la version générique en termes de précision et de fiabilité des appels d'outils, particulièrement pour les scénarios mélangeant commandes bash et fonctions personnalisées.

Stratégies d'optimisation des coûts

| Stratégie | Méthode | Économie attendue |

|---|---|---|

| Basculer le niveau de réflexion selon le besoin | 'low' pour les tâches simples, 'high' uniquement pour le complexe | 30-50% |

| Réduire les requêtes via le contexte long | Regrouper plusieurs questions liées en une seule requête | 20-40% |

| Vigilance sur le seuil >200K tokens | Le prix double au-delà de 200K, contrôlez la longueur d'entrée | Évite un surcoût de 2x |

| Contrôle des tokens de sortie | Définir un max_tokens raisonnable pour éviter la redondance | 10-20% |

| Choisir le bon modèle Gemini | Utiliser Flash pour les tâches simples, 3.1 Pro pour le complexe | 60-80% |

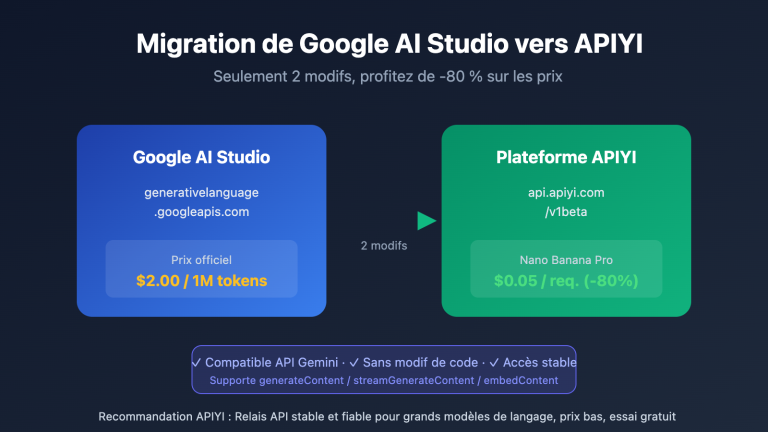

Étapes pour migrer de Gemini 3.0 Pro vers 3.1 Pro

Le processus de migration est extrêmement simple :

Étape 1 : Modifier le paramètre model

# Ancienne version

model="gemini-3-pro-preview"

# Nouvelle version

model="gemini-3.1-pro-preview"

Étape 2 : Tester les fonctionnalités clés — lancez quelques cas typiques dans vos scénarios principaux pour confirmer que la qualité de sortie répond à vos attentes.

Étape 3 : Explorer les nouvelles capacités — essayez le raisonnement profond avec le niveau 'high', l'upload de fichiers de 100 Mo, l'analyse d'URL YouTube, etc.

Étape 4 : Optimiser les coûts — réglez le niveau de réflexion selon les tâches. Utiliser 'medium' au lieu de 'high' pour les tâches courantes permet de réduire la latence et la consommation de tokens tout en maintenant la qualité.

🎯 Conseil de migration : Sur la plateforme APIYI apiyi.com, la migration ne nécessite que le changement d'un paramètre. Il est recommandé de garder l'ancien modèle en secours (fallback) au début, puis de basculer totalement une fois la stabilité de la 3.1 confirmée.

Questions fréquemment posées

Q1 : L’appel à Gemini 3.1 Pro Preview sur APIYI est-il identique aux modèles Gemini précédents ?

Absolument. Sur la plateforme APIYI (apiyi.com), Gemini 3.1 Pro Preview utilise le format standard compatible OpenAI. Il vous suffit de renseigner gemini-3.1-pro-preview dans le paramètre model. Si vous utilisez déjà Gemini 3.0 Pro, modifiez simplement le nom du modèle ; aucune autre modification de code n'est nécessaire.

Q2 : Le 3.1 Pro et le 3.0 Pro sont au même prix, est-il vraiment nécessaire de changer ?

C'est fortement recommandé. Le prix est strictement identique (2 $ / 12 $), mais les capacités de raisonnement ont doublé, le score en codage est passé de 76,8 % à 80,6 %, et l'efficacité de sortie a augmenté de 15 %. C'est une mise à niveau totalement gratuite, il n'y a aucune raison de s'en priver. Sur APIYI (apiyi.com), le basculement se fait en changeant un seul paramètre.

Q3 : Comment choisir entre les trois niveaux de profondeur de réflexion ? Cela impacte-t-il le prix ?

La profondeur de réflexion influence principalement la latence et la consommation de tokens. Le niveau high offre un raisonnement plus poussé mais consomme plus de tokens de sortie et de temps. Le niveau low est le plus rapide mais avec un raisonnement plus superficiel. Nous conseillons le niveau medium pour un usage quotidien (équivalent à la qualité high de l'ancienne version) et de réserver le high aux scénarios de raisonnement complexes. La facturation se base sur la consommation réelle de tokens ; le niveau de réflexion en lui-même n'entraîne pas de frais supplémentaires.

Q4 : Entre Gemini 3.1 Pro Preview et Claude Opus 4.6, lequel choisir ?

Tout dépend de votre cas d'usage et de votre budget : si vous avez besoin d'un contexte ultra-large (1M vs 200K), d'analyse multimodale (vidéo/YouTube) ou si vous êtes sensible au prix (2 $ vs 15 $), choisissez Gemini 3.1 Pro. Si vous recherchez la perfection absolue en codage (80,9 % vs 80,6 %) et un écosystème d'Agents plus mature, optez pour Claude Opus 4.6. Sur APIYI (apiyi.com), les deux sont accessibles via la même interface, ce qui facilite grandement vos tests A/B.

Guide de sélection panoramique de la gamme Gemini 3

La série Gemini 3 propose désormais plusieurs modèles, chacun adapté à des besoins spécifiques :

| Modèle | Positionnement | Atouts majeurs | Scénarios idéaux | Prix sur APIYI |

|---|---|---|---|---|

| gemini-3.1-pro-preview | Raisonnement Flagship (NOUVEAU) | Raisonnement doublé, codage de pointe | Raisonnement complexe, génération de code, Agents | 2 $ / 12 $ |

| gemini-3-pro-preview | Flagship polyvalent | Programmation agentique, multimodal | Tâches générales (mise à niveau vers 3.1 conseillée) | 2 $ / 12 $ |

| gemini-3-flash-preview | Rapide et léger | Réponse ultra-rapide, coût minimal | Dialogue en temps réel, traitement par lots, appels haute fréquence | Encore plus bas |

| gemini-3-pro-image-preview | Génération d'images | Text-to-image, édition d'images | Design créatif, production de contenu | Facturation à l'image |

Arbre de décision :

- Besoin du meilleur raisonnement et codage ? →

gemini-3.1-pro-preview - Besoin de vitesse maximale et du coût le plus bas ? →

gemini-3-flash-preview - Besoin de générer des images ? →

gemini-3-pro-image-preview - Vous utilisez déjà le 3.0 Pro ? → Passez directement au

gemini-3.1-pro-preview

Dans quels cas Gemini 3.1 Pro Preview n'est-il pas le meilleur choix ?

Bien que le 3.1 Pro soit excellent dans la plupart des situations, d'autres options peuvent être préférables dans ces cas précis :

- Besoin d'une précision de codage extrême : Le score de 80,9 % de Claude Opus 4.6 sur SWE-Bench reste légèrement supérieur aux 80,6 % du 3.1 Pro. L'écart est minime, mais peut compter pour des exigences de précision critiques.

- Applications en temps réel nécessitant une latence ultra-faible : Le mode de réflexion

highdu 3.1 Pro induit une latence élevée. Dans ce cas, Gemini 3 Flash ou Claude Sonnet 4.6 sont de meilleures alternatives. - Besoin de garanties SLA stables : Les modèles "Preview" n'offrent pas d'engagements SLA officiels. Pour des environnements de production exigeant une disponibilité maximale, évaluez bien les risques.

- Tâches simples : Utiliser le 3.1 Pro pour des tâches peu complexes peut être un gaspillage de ressources ; la gamme Flash est alors bien plus rentable.

Résumé des avantages concurrentiels de Gemini 3.1 Pro Preview

Dans le paysage des modèles d'IA de février 2026, les avantages clés de Gemini 3.1 Pro Preview se résument en trois points :

- Le plus grand contexte : 1M de tokens, soit 5 fois plus que Claude Opus 4.6 (200K).

- Le prix "Flagship" le plus bas : 2,00 $ en entrée, soit seulement 13 % du prix de Claude Opus 4.6 (15,00 $).

- Le plus grand bond en raisonnement : Un score ARC-AGI-2 qui double pour atteindre 77,1 %, devançant tous ses concurrents sur cette dimension.

Ses points faibles relatifs se situent principalement sur le codage pur (80,6 % vs 80,9 % pour Claude Opus, un écart infime) et sur la maturité de l'écosystème des Agents.

💡 Conseil global : Pour la majorité des développeurs, le rapport qualité-prix de Gemini 3.1 Pro Preview est actuellement le meilleur parmi les modèles phares. Via APIYI (apiyi.com), vous pouvez comparer et tester Gemini, Claude, GPT et tous les autres modèles majeurs sur une seule et même plateforme pour trouver celui qui correspond parfaitement à vos besoins.

Résumé : Une mise à niveau majeure avec des performances doublées au même prix, Gemini 3.1 Pro Preview mérite d'être adopté immédiatement

Gemini 3.1 Pro Preview est une mise à jour majeure : capacités doublées pour un prix inchangé.

- Raisonnement doublé : ARC-AGI-2 passe de ~35 % à 77,1 %, soit plus de 2 fois les performances de la version 3.0.

- Codage au niveau des meilleurs : SWE-Bench à 80,6 %, à seulement 0,3 % de Claude Opus 4.6.

- Bond en avant pour les capacités d'Agent : Terminal-Bench +20 %, BrowseComp +45 %, MCP Atlas +28 %.

- Efficacité globale améliorée : Sortie de 65k tokens, limite de fichier à 100 Mo, efficacité en hausse de 15 %.

- Système de réflexion à trois niveaux : Le mode "high" équivaut à Deep Think Mini, permettant d'ajuster le budget de raisonnement selon les besoins.

Découvrez dès maintenant Gemini 3.1 Pro Preview via APIYI (apiyi.com) — interface unifiée, disponibilité immédiate. Il vous suffit de modifier le paramètre du modèle en gemini-3.1-pro-preview pour effectuer la mise à niveau.

Références

-

Blog officiel de Google : Annonce de la sortie de Gemini 3.1 Pro

- Lien :

blog.google/innovation-and-ai/models-and-research/gemini-models/gemini-3-1-pro - Description : Présentation officielle des fonctionnalités et scores de référence.

- Lien :

-

Fiche technique (Model Card) de Google DeepMind : Détails techniques de Gemini 3.1 Pro

- Lien :

deepmind.google/models/model-cards/gemini-3-1-pro - Description : Évaluations de sécurité et paramètres détaillés.

- Lien :

-

Documentation officielle de l'API Gemini : Liste des modèles et méthodes d'appel

- Lien :

ai.google.dev/gemini-api/docs/models/gemini-3-1-pro-preview - Description : Paramètres de l'API, tarification et guide d'utilisation.

- Lien :

-

Article de VentureBeat : Premières impressions sur Gemini 3.1 Pro

- Lien :

venturebeat.com/technology/google-gemini-3-1-pro-first-impressions - Description : Caractéristiques de Deep Think Mini et expérience utilisateur réelle.

- Lien :

-

Analyse de MarkTechPost : Décryptage technique de Gemini 3.1 Pro

- Lien :

marktechpost.com/2026/02/19/google-ai-releases-gemini-3-1-pro - Description : Données de tests de référence et impact sur l'industrie.

- Lien :

📝 Auteur : Équipe APIYI | Pour tout échange technique, visitez APIYI (apiyi.com)

📅 Date de mise à jour : 20 février 2026

🏷️ Mots-clés : API Gemini 3.1 Pro Preview, lancement sur APIYI, raisonnement doublé, SWE-Bench 80.6%, ARC-AGI-2 77.1%