Anmerkung des Autors: Tiefgehende Analyse des kompletten Workflows für die Batch-Produktion von AI-Mangadramen. Erfahren Sie im Detail, wie Sie Sora 2 Character Cameo und Veo 3.1 4K-Output für eine effiziente Produktion nutzen.

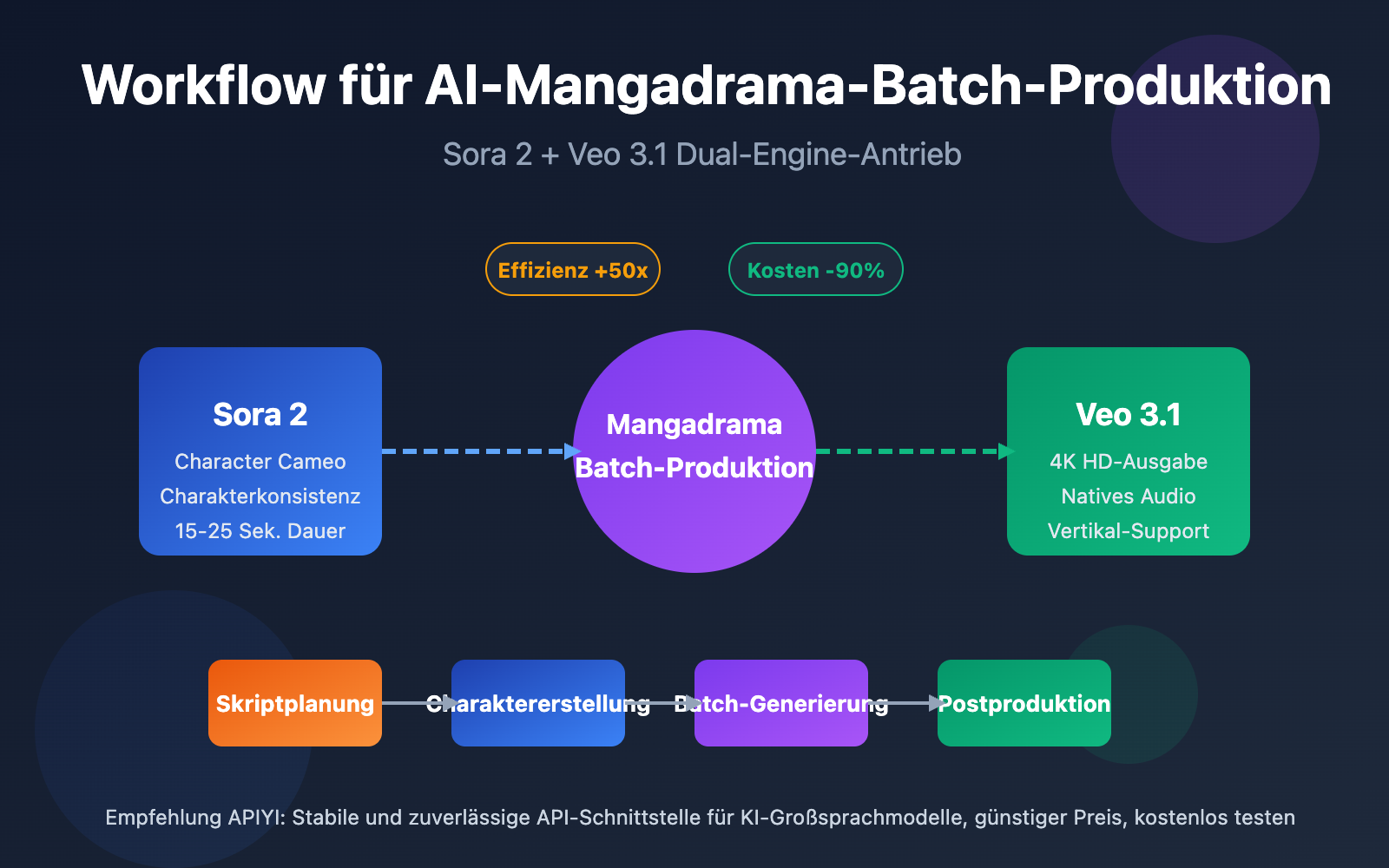

AI-Mangadramen entwickeln sich zum neuen Trend in der Content-Erstellung. Die Frage, wie man Sora 2 und Veo 3.1 nutzt, um einen effizienten Workflow für die Batch-Produktion aufzubauen, ist eine Kernfrage für jeden Creator.

Kernwert: Nach der Lektüre dieses Artikels werden Sie den vollständigen Workflow für die Produktion von Mangadramen beherrschen. Sie lernen, wie Sie mit Sora 2 Character Cameo die Charakterkonsistenz bewahren und mit Veo 3.1 4K-Vertikalvideos in der Praxis erstellen.

Kernwerte und Marktchancen der AI-Mangadrama-Batch-Produktion

Die Batch-Produktion von AI-Mangadramen definiert die Effizienzgrenzen der Content-Erstellung neu. Während die traditionelle Produktion massenhaft manuelle Zeichnungen und Animationen erfordert, ermöglicht die Kombination aus Sora 2 und Veo 3.1 selbst Einzelpersonen eine Produktion auf Industrieniveau.

| Vergleichsdimension | Traditionelle Produktion | AI-Mangadrama-Batch-Produktion | Effizienzsteigerung |

|---|---|---|---|

| Produktionszyklus pro Folge | 7-14 Tage | 2-4 Stunden | 50-80-fach |

| Charakterkonsistenz | Abhängig von Zeichner-Skills | Automatisch via API | 100% konsistent |

| Szenengenerierung | Frame-für-Frame-Zeichnung | Batch-Generierung | 20-50-fach |

| Kostenaufwand | Tausende Euro / Folge | Zehner-Bereich / Folge | 90% Reduktion |

| Kapazitätsobergrenze | 2-4 Folgen / Monat | 50-100 Folgen / Monat | 25-fach |

Drei Kernvorteile der Batch-Produktion von Mangadramen

Erstens: Technologischer Durchbruch bei der Charakterkonsistenz. Die Character Cameo-Funktion von Sora 2 ermöglicht die Erstellung wiederverwendbarer Charakter-IDs. Dies stellt sicher, dass derselbe Charakter in verschiedenen Szenen völlig identische äußere Merkmale beibehält – eine Lösung für das größte Problem herkömmlicher KI-Videogenerierung: das "Changing Face"-Syndrom.

Zweitens: Standardisierung des Batch-Workflows. Über API-Schnittstellen können Creator die Skriptanalyse, Generierung von Eingabeaufforderungen, Videoproduktion und Postproduktion zu einer automatisierten Pipeline integrieren. Die Zeit für die Generierung von 20 bis 50 Szenen lässt sich so von mehreren Stunden auf unter eine Stunde komprimieren.

Drittens: Flexibilität durch Multi-Plattform-Adaption. Veo 3.1 unterstützt nativ die Generierung vertikaler Videos. Es kann direkt Inhalte im 9:16-Format ausgeben, die perfekt für Plattformen wie TikTok, Instagram Reels oder YouTube Shorts geeignet sind, ohne dass ein nachträglicher Zuschnitt erforderlich ist.

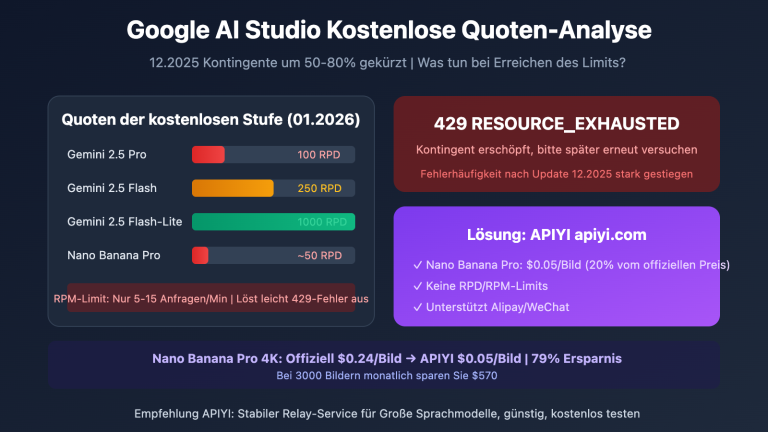

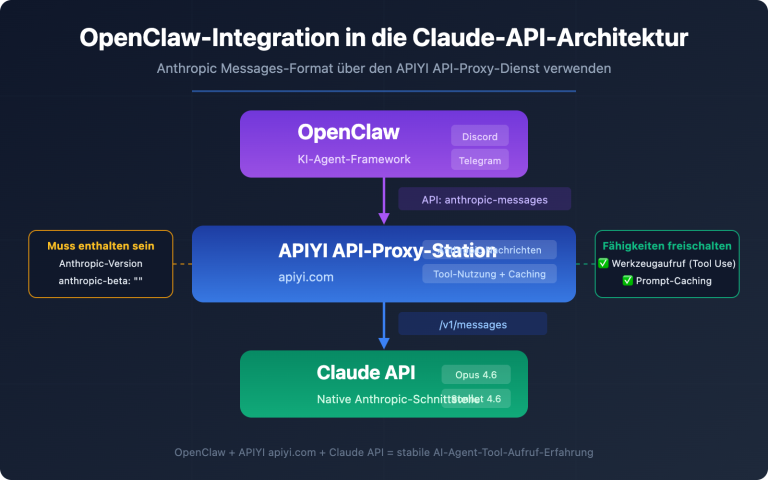

🎯 Plattform-Empfehlung: Die Batch-Produktion von Mangadramen erfordert eine stabile API-Aufrufumgebung. Wir empfehlen APIYI (apiyi.com) als zuverlässigen Hub für APIs großer Sprachmodelle. Dort erhalten Sie Zugang zu Sora 2 und anderen führenden Videomodellen zu günstigen Preisen und mit der Möglichkeit zum kostenlosen Testen.

Analyse des vollständigen Manhua-Video-Produktionsworkflows

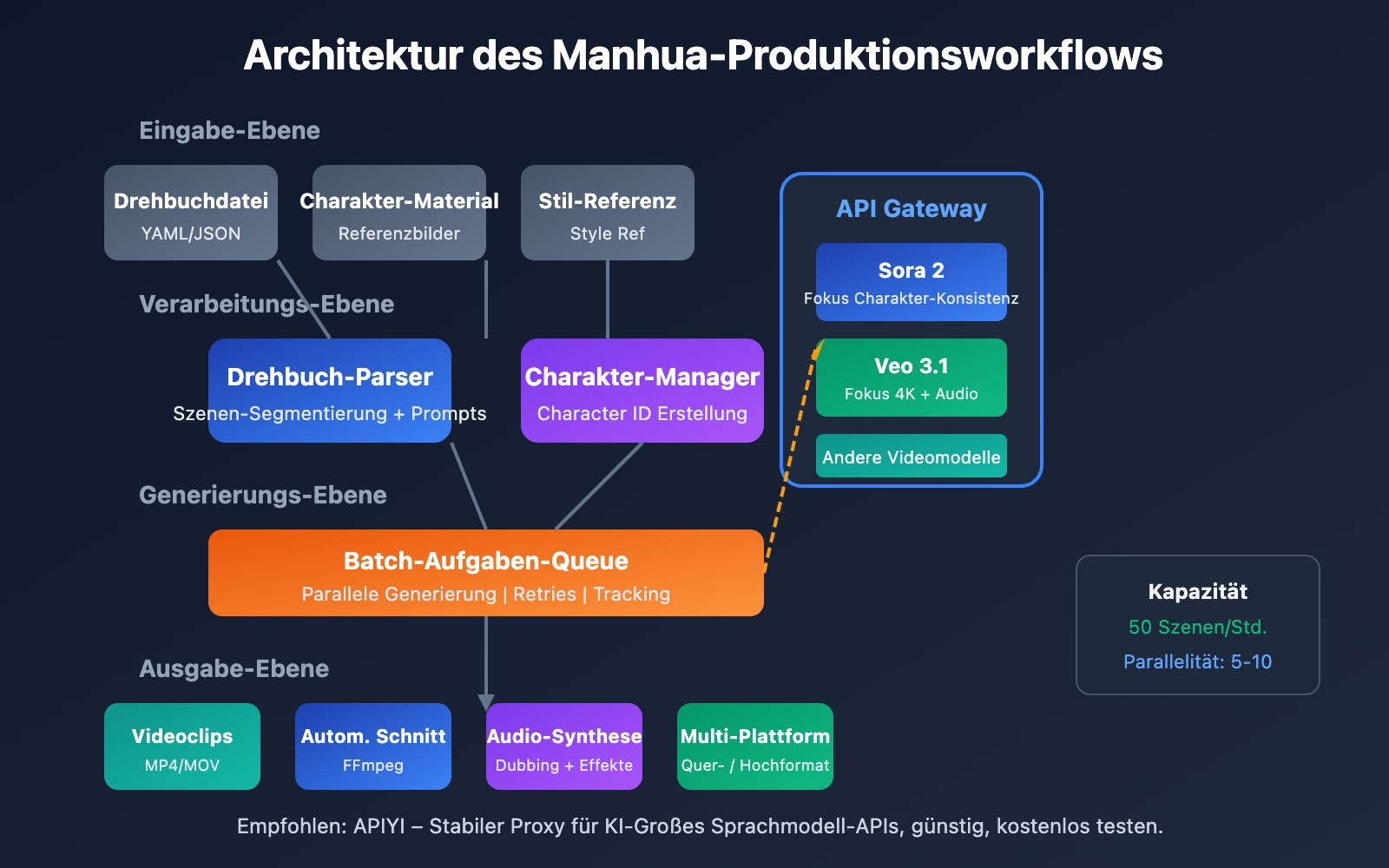

Ein vollständiger Workflow für die Produktion von Manhua-Videos (Comic-Videos) lässt sich in fünf Kernphasen unterteilen, wobei jede Phase klare Inputs, Outputs und technische Schwerpunkte aufweist.

Manhua-Produktionsworkflow Phase 1: Drehbuchplanung und Storyboard-Design

Der Ausgangspunkt des Manhua-Produktionsworkflows ist ein strukturiertes Drehbuch. Im Gegensatz zu herkömmlichen Drehbüchern muss ein KI-Manhua-Drehbuch detaillierte visuelle Beschreibungen für jede Einstellung liefern.

| Drehbuchelement | Traditionelle Schreibweise | KI-Manhua-Workflow-Schreibweise | Funktionsbeschreibung |

|---|---|---|---|

| Szenenbeschreibung | Im Café | Modernes, minimalistisches Café, bodentiefe Fenster, Nachmittagssonne, warme Töne | Grundlage für die visuelle Generierung |

| Charakter-Aktionen | Xiao Ming trinkt Kaffee | Schwarzhaariger Mann, weißes Hemd, hält Kaffeetasse in der rechten Hand, lächelt aus dem Fenster | Stellt sicher, dass Aktionen generierbar sind |

| Kamerasprache | Nahaufnahme | Halbnahaufnahme, 45-Grad-Seitenansicht, Tiefenunschärfe im Hintergrund | Leitet die Bildkomposition |

| Dauer-Markierung | Keine | 8 Sekunden | Einstellung der API-Parameter |

Beispielformat für ein Storyboard-Skript:

episode: 1

title: "Die erste Begegnung"

total_scenes: 12

characters:

- id: "char_001"

name: "Xiao Yu"

description: "20-jährige Frau, langes schwarzes Haar, weißes Kleid"

- id: "char_002"

name: "A Ming"

description: "22-jähriger Mann, kurzes Haar, Freizeitanzug"

scenes:

- scene_id: 1

duration: 6

setting: "Stadtstraße, Abenddämmerung, die ersten Neonlichter leuchten auf"

characters: ["char_001"]

action: "Xiao Yu geht allein die Straße entlang und schaut auf ihr Handy"

camera: "Tracking-Shot, mittlere Einstellungsgröße"

Manhua-Produktionsworkflow Phase 2: Erstellung von Charakter-Assets

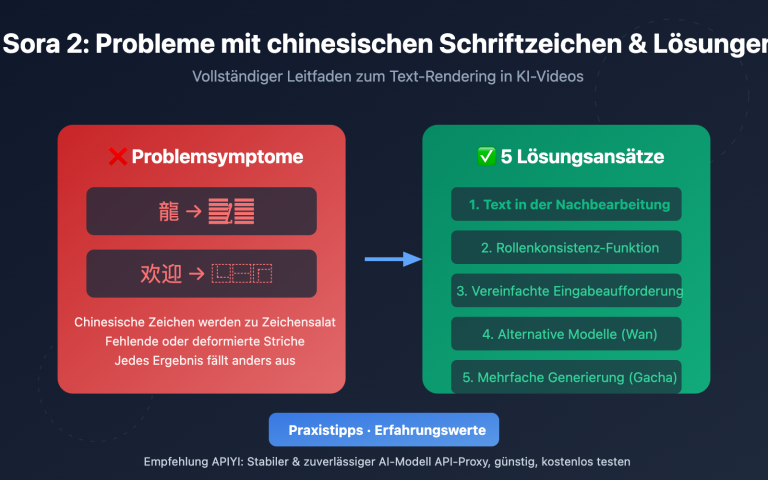

Die Charakter-Konsistenz ist die zentrale Herausforderung bei der Batch-Produktion von Manhua-Videos. Sora 2 und Veo 3.1 bieten hierfür unterschiedliche Lösungen an.

Sora 2 Methode zur Charaktererstellung:

- Vorbereitung von Charakter-Referenzbildern (Front-, Seiten- und Ganzkörperansicht)

- Hochladen des Referenzmaterials über die Character API

- Erhalt einer wiederverwendbaren Character ID

- Referenzierung dieser ID in nachfolgenden Szenengenerierungen

Veo 3.1 Methode zur Charaktererhaltung:

- Hochladen mehrerer Charakter-Referenzbilder

- Nutzung der Style-Reference-Funktion, um den Stil festzulegen

- Detaillierte Beschreibung der Charaktermerkmale in der Eingabeaufforderung

- Aufrechterhaltung der Konsistenz durch kontinuierliche Generierung

Technischer Tipp: Es wird empfohlen, für die Hauptcharaktere 3–5 Referenzbilder aus verschiedenen Blickwinkeln zu erstellen. Dies verbessert die Genauigkeit, mit der das KI-Modell die Charaktermerkmale versteht, erheblich.

Manhua-Produktionsworkflow Phase 3: Batch-Videogenerierung

Dies ist der technologische Kern des Manhua-Produktionsworkflows. Durch das Batch-Senden von Generierungsaufgaben über APIs kann die Produktionskapazität massiv gesteigert werden.

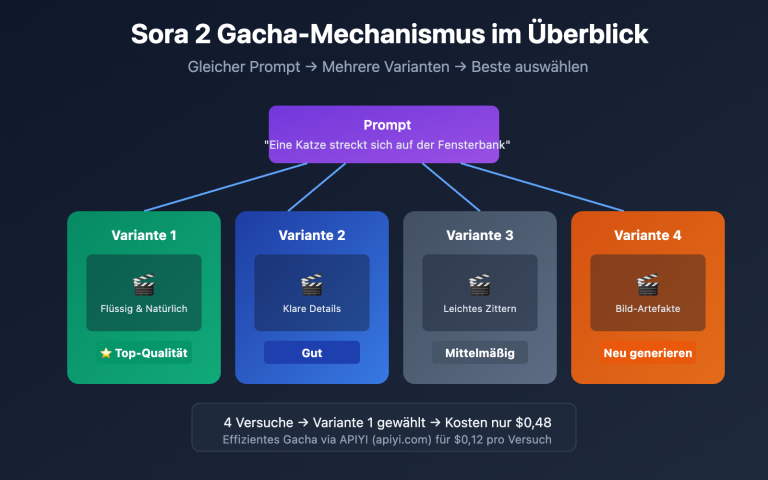

Strategien für die Batch-Generierung:

- Parallele Generierung: Gleichzeitiges Senden von Generierungsanfragen für mehrere Szenen.

- Prioritätsmanagement: Wichtige Szenen werden zuerst generiert, um rechtzeitige Anpassungen zu ermöglichen.

- Fehler-Retry: Automatisches Erkennen fehlgeschlagener Aufgaben und erneutes Senden.

- Ergebnisvalidierung: Automatisches Filtern von Outputs, die den Qualitätsstandards entsprechen.

Manhua-Produktionsworkflow Phase 4: Postproduktion und Audio

Die generierten Videoclips müssen zusammengeschnitten und mit Audio unterlegt werden.

| Postproduktion-Schritt | Empfohlenes Tool | Zeitanteil | Automatisierungsgrad |

|---|---|---|---|

| Videoschnitt | FFmpeg / Premiere | 15% | Vollständig automatisierbar |

| Übergangseffekte | After Effects | 10% | Teilautomatisiert |

| Vertonung & Musik | Eleven Labs / Suno | 25% | Vollständig automatisierbar |

| Untertitel | Whisper + Aegisub | 15% | Vollständig automatisierbar |

| Color Grading | DaVinci Resolve | 20% | Teilautomatisiert |

| Qualitätskontrolle | Manuelle Prüfung | 15% | Erfordert menschliches Eingreifen |

Manhua-Produktionsworkflow Phase 5: Multi-Plattform-Distribution

Ausgabe der Videodateien gemäß den Spezifikationen der verschiedenen Plattformen.

- TikTok / Reels: 9:16 Hochformat, 1080×1920, unter 60 Sekunden.

- YouTube / Bilibili: 16:9 Querformat, 1920×1080, keine Zeitbeschränkung.

- Instagram / Pinterest: 3:4 oder 9:16, Fokus auf attraktive Vorschaubilder.

- WhatsApp/WeChat Channels: Unterstützt verschiedene Formate, 9:16 empfohlen.

🎯 Effizienz-Tipp: Durch die Nutzung der einheitlichen Schnittstelle von APIYI (apiyi.com) können mehrere Videomodelle gleichzeitig aufgerufen werden. So lässt sich für jede Szene das optimale Modell wählen, um ein ideales Verhältnis zwischen Kosten und Ergebnis zu erzielen.

Sora 2 in der Comic-Produktion: Kerneinsatzgebiete

Sora 2 ist das von OpenAI vorgestellte Video-Generierungsmodell, dessen "Character Cameo"-Funktion die technische Schlüsselsäule für die Massenproduktion von Comic-Serien und Motion-Comics darstellt.

Sora 2 Character Cameo: Technologie für Charakterkonsistenz

Character Cameo ermöglicht die Erstellung wiederverwendbarer Charakteridentitäten und stellt sicher, dass dieselbe Figur in verschiedenen Szenen ein konsistentes Erscheinungsbild behält.

Zwei Wege zur Erstellung einer Charakter-ID:

Weg 1: Extraktion aus einem bestehenden Video

import requests

# Charaktermerkmale aus einer Video-URL extrahieren

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/extract",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"video_url": "https://example.com/character_reference.mp4",

"character_name": "protagonist_male"

}

)

character_id = response.json()["character_id"]

Weg 2: Erstellung aus Referenzbildern

# Charakter aus Referenzbildern verschiedener Perspektiven erstellen

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/create",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"images": [

"base64_front_view...",

"base64_side_view...",

"base64_full_body..."

],

"character_name": "protagonist_female",

"description": "20-jährige Asiatin, langes schwarzes Haar, sanfte Ausstrahlung"

}

)

Einsatz der Sora 2 Bild-zu-Video-Funktion in der Comic-Produktion

Die Bild-zu-Video-Funktion (Image-to-Video) von Sora 2 kann statische Comic-Panels in dynamische Videos verwandeln – ein entscheidender Schritt im Workflow der Comic-Erstellung.

| Szenario für Bild-zu-Video | Input-Anforderungen | Output-Effekt | Anwendungsfall |

|---|---|---|---|

| Einzelbild-Animation | Hochauflösendes statisches Bild | 6-15 Sekunden dynamisches Video | Cover, Übergangsszenen |

| Mimik & Gestik | Nahaufnahme der Figur | Hinzufügen von Blinzeln, Lächeln etc. | Dialogszenen |

| Szenenerweiterung | Teilbild | Kamerafahrten (Zoom/Pan), Umgebungserweiterung | Establishing Shots |

| Stilkonvertierung | Beliebiges Bild | Umwandlung in Anime/realistischen Stil | Stilvereinheitlichung |

Best Practices für die Comic-Generierung mit Sora 2

Strukturierte Vorlage für die Eingabeaufforderung:

[Beschreibung des Hauptmotivs] + [Aktion/Verhalten] + [Umgebung/Szene] + [Kamerasprache] + [Stilvorgabe]

Beispiel:

"Ein schwarzhaariges Mädchen (character_id: char_001) sitzt am Fenster eines Cafés,

rührt sanft in ihrer Kaffeetasse, Sonnenlicht fällt durch das Panoramafenster, warme Farbtöne,

Halbnahaufnahme, geringe Tiefenschärfe, japanischer Anime-Stil, weiche Farben"

Empfehlungen für Generierungsparameter:

- Dauer: Einzelszenen sollten idealerweise 6–10 Sekunden lang sein, um den späteren Schnitt zu erleichtern.

- Auflösung: Bevorzugt 1080p, um Qualität und Kosten in Einklang zu bringen.

- Stil-Presets: Nutzen Sie das "Comic"-Preset für einen stabileren Zeichenstil.

🎯 API-Empfehlung: Für die Massenabwicklung von Sora 2 API-Aufrufen empfiehlt sich APIYI (apiyi.com). Es unterstützt Warteschlangenmanagement und automatische Wiederholungsversuche, was die Erfolgsrate bei der Batch-Generierung deutlich erhöht.

Veo 3.1 in der Comic-Produktion: Kerneinsatzgebiete

Veo 3.1 ist das neueste Video-Generierungsmodell von Google DeepMind und bietet spezifische Vorteile für die skalierbare Produktion von Motion-Comics.

Veo 3.1: 4K-Ausgabe und Bildqualitätsvorteile

Veo 3.1 bietet im Vergleich zum Vorgänger eine deutlich höhere Bildqualität und Stabilität, was es ideal für Comic-Projekte macht, die eine hochauflösende Ausgabe erfordern.

| Veo Version | Max. Auflösung | Audiounterstützung | Charakterkonsistenz | Generierungstempo |

|---|---|---|---|---|

| Veo 2 | 1080p | Keine | Mittelmäßig | Schnell |

| Veo 3 | 4K | Natives Audio | Gut | Mittel |

| Veo 3.1 | 4K | Erweitertes Audio | Exzellent | 30-60 Sek. |

Kernvorteile von Veo 3.1:

- Native Audiogenerierung: Kann simultan Soundeffekte, Umgebungsgeräusche und sogar Charakterdialoge erzeugen.

- Verbesserte Charakterkonsistenz: Die Multi-Referenzbild-Funktion steigert die Konsistenz massiv.

- Nativer Support für Hochkant-Formate: Erzeugt direkt Videos im 9:16-Format, ideal für Kurzvideo-Plattformen (TikTok, Reels).

- Präzise Stilkontrolle: Exakte Steuerung des Ausgabestils über "Style Reference"-Bilder.

Einsatz der vertikalen Videogenerierung von Veo 3.1

Comic-Inhalte für soziale Medien benötigen oft das Hochkant-Format. Der native Support von Veo 3.1 vermeidet Qualitätsverluste, die sonst durch nachträgliches Zuschneiden entstehen würden.

Methode zur vertikalen Generierung:

# Vertikale Generierung durch Hochladen eines Hochkant-Referenzbildes auslösen

response = requests.post(

"https://vip.apiyi.com/v1/veo/generate",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"prompt": "Anime-Stil, schwarzhaariges Mädchen unter einem Kirschblütenbaum, der Wind weht durch ihr Haar, ästhetische Atmosphäre",

"reference_image": "vertical_reference_9_16.jpg",

"duration": 8,

"with_audio": True,

"audio_prompt": "Sanfte Klaviermusik im Hintergrund, Rascheln von Blättern"

}

)

Veo 3.1 Multi-Referenzbild-Technologie zur Charaktersteuerung

Veo 3.1 erlaubt das Hochladen mehrerer Referenzbilder, um die Generierung von Charakteren, Objekten und Szenen zu steuern – essenziell für die Konsistenz in der Serienproduktion.

Strategie für Multi-Referenzbilder:

- Charakterbilder: 3–5 Aufnahmen der Figur aus verschiedenen Winkeln (Model Sheet).

- Szenenbilder: 2–3 Referenzen für den Stil der Umgebung.

- Stilbilder: 1–2 Bilder für die allgemeine künstlerische Anmutung.

🎯 Modellauswahl: Wählen Sie Veo 3.1, wenn Sie 4K-Qualität und natives Audio benötigen. Greifen Sie zu Sora 2, wenn höchste Priorität auf der Charakteridentität liegt. APIYI (apiyi.com) ermöglicht den kombinierten Zugriff auf beide Modelle über eine einheitliche Schnittstelle, was einen flexiblen Wechsel erlaubt.

Technisches Konzept für die Batch-Produktion von Manga-Dramen: API-Automatisierung in der Praxis

Die Automatisierung des Workflows für die Manga-Drama-Produktion ist der Schlüssel zur Steigerung der Kapazität. Hier ist das vollständige technische Umsetzungskonzept.

Automatisierungs-Skript-Architektur für die Batch-Produktion von Manga-Dramen

import asyncio

from typing import List, Dict

class MangaDramaProducer:

"""Automatisierungs-Framework für die Batch-Produktion von Manga-Dramen"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

async def batch_generate(

self,

scenes: List[Dict],

model: str = "sora-2"

) -> List[str]:

"""Szenenvideos im Batch generieren"""

tasks = []

for scene in scenes:

task = self.generate_scene(scene, model)

tasks.append(task)

results = await asyncio.gather(*tasks)

return results

async def generate_scene(

self,

scene: Dict,

model: str

) -> str:

"""Einzelne Szene generieren"""

# Eingabeaufforderung (Prompt) erstellen

prompt = self.build_prompt(scene)

# API aufrufen

video_url = await self.call_api(prompt, model)

return video_url

Vollständigen Automatisierungs-Skript-Code anzeigen

import asyncio

import aiohttp

from typing import List, Dict, Optional

from dataclasses import dataclass

import json

@dataclass

class Scene:

"""Szenen-Datenstruktur"""

scene_id: int

duration: int

setting: str

characters: List[str]

action: str

camera: str

dialogue: Optional[str] = None

@dataclass

class Character:

"""Charakter-Datenstruktur"""

char_id: str

name: str

description: str

reference_images: List[str]

class MangaDramaProducer:

"""Vollständiges Framework für die Batch-Produktion von Manga-Dramen"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.characters: Dict[str, str] = {} # name -> character_id

async def create_character(

self,

character: Character

) -> str:

"""Charakter-ID erstellen"""

async with aiohttp.ClientSession() as session:

async with session.post(

f"{self.base_url}/sora/characters/create",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"images": character.reference_images,

"character_name": character.char_id,

"description": character.description

}

) as resp:

result = await resp.json()

char_id = result["character_id"]

self.characters[character.name] = char_id

return char_id

def build_prompt(self, scene: Scene) -> str:

"""Szenen-Prompt erstellen"""

char_refs = []

for char_name in scene.characters:

if char_name in self.characters:

char_refs.append(

f"(character_id: {self.characters[char_name]})"

)

prompt_parts = [

scene.action,

f"Szene: {scene.setting}",

f"Kamera: {scene.camera}",

"Anime-Stil, hohe Qualität, detailreich"

]

if char_refs:

prompt_parts.insert(0, " ".join(char_refs))

return ", ".join(prompt_parts)

async def generate_scene(

self,

scene: Scene,

model: str = "sora-2",

with_audio: bool = False

) -> Dict:

"""Einzelne Szene generieren"""

prompt = self.build_prompt(scene)

async with aiohttp.ClientSession() as session:

endpoint = "sora" if "sora" in model else "veo"

async with session.post(

f"{self.base_url}/{endpoint}/generate",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"prompt": prompt,

"duration": scene.duration,

"with_audio": with_audio

}

) as resp:

result = await resp.json()

return {

"scene_id": scene.scene_id,

"video_url": result.get("video_url"),

"status": result.get("status")

}

async def batch_generate(

self,

scenes: List[Scene],

model: str = "sora-2",

max_concurrent: int = 5

) -> List[Dict]:

"""Szenen im Batch generieren"""

semaphore = asyncio.Semaphore(max_concurrent)

async def limited_generate(scene):

async with semaphore:

return await self.generate_scene(scene, model)

tasks = [limited_generate(s) for s in scenes]

results = await asyncio.gather(*tasks, return_exceptions=True)

# Fehlgeschlagene Tasks verarbeiten

successful = []

failed = []

for i, result in enumerate(results):

if isinstance(result, Exception):

failed.append(scenes[i])

else:

successful.append(result)

# Retry für fehlgeschlagene Tasks

if failed:

retry_results = await self.batch_generate(

failed, model, max_concurrent

)

successful.extend(retry_results)

return successful

# Anwendungsbeispiel

async def main():

producer = MangaDramaProducer("your_api_key")

# Charakter erstellen

protagonist = Character(

char_id="char_001",

name="Xiao Yu",

description="20-jährige Frau, langes schwarzes Haar, sanfte Ausstrahlung",

reference_images=["base64_img1", "base64_img2"]

)

await producer.create_character(protagonist)

# Szenen definieren

scenes = [

Scene(1, 8, "Stadtstraße bei Abenddämmerung", ["Xiao Yu"], "Läuft alleine und schaut aufs Handy", "Medium Shot, folgend"),

Scene(2, 6, "Café Innenansicht", ["Xiao Yu"], "Sitzt am Fenster und trinkt Kaffee", "Statischer Medium Close-up"),

Scene(3, 10, "Parkbank", ["Xiao Yu"], "Schaut in den Sonnenuntergang und hängt Gedanken nach", "Langsame Close-up-Fahrt")

]

# Batch-Generierung

results = await producer.batch_generate(scenes, model="sora-2")

print(json.dumps(results, indent=2, ensure_ascii=False))

if __name__ == "__main__":

asyncio.run(main())

Strategien zur Kostenoptimierung bei der Batch-Produktion

| Optimierungsrichtung | Konkrete Maßnahmen | Erwartete Ersparnis | Umsetzungsaufwand |

|---|---|---|---|

| Modellauswahl | Kostengünstige Modelle für einfache Szenen | 30-50% | Niedrig |

| Auflösungskontrolle | Auswahl von 720p/1080p/4K je nach Bedarf | 20-40% | Niedrig |

| Batch-Rabatte | Nutzung von API-Aggregationsplattformen | 10-20% | Niedrig |

| Cache-Wiederverwendung | Wiederverwendung von Ergebnissen für ähnliche Szenen | 15-25% | Mittel |

| Dauer-Optimierung | Präzise Steuerung der Dauer pro Take | 10-15% | Mittel |

🎯 Empfehlung zur Kostenkontrolle: APIYI (apiyi.com) bietet eine einheitliche Schnittstelle für verschiedene Videomodelle. Es unterstützt die bedarfsgerechte Auswahl unterschiedlicher Modellstufen und kann in Kombination mit Batch-Rabatten die Gesamtkosten der Manga-Drama-Produktion effektiv senken.

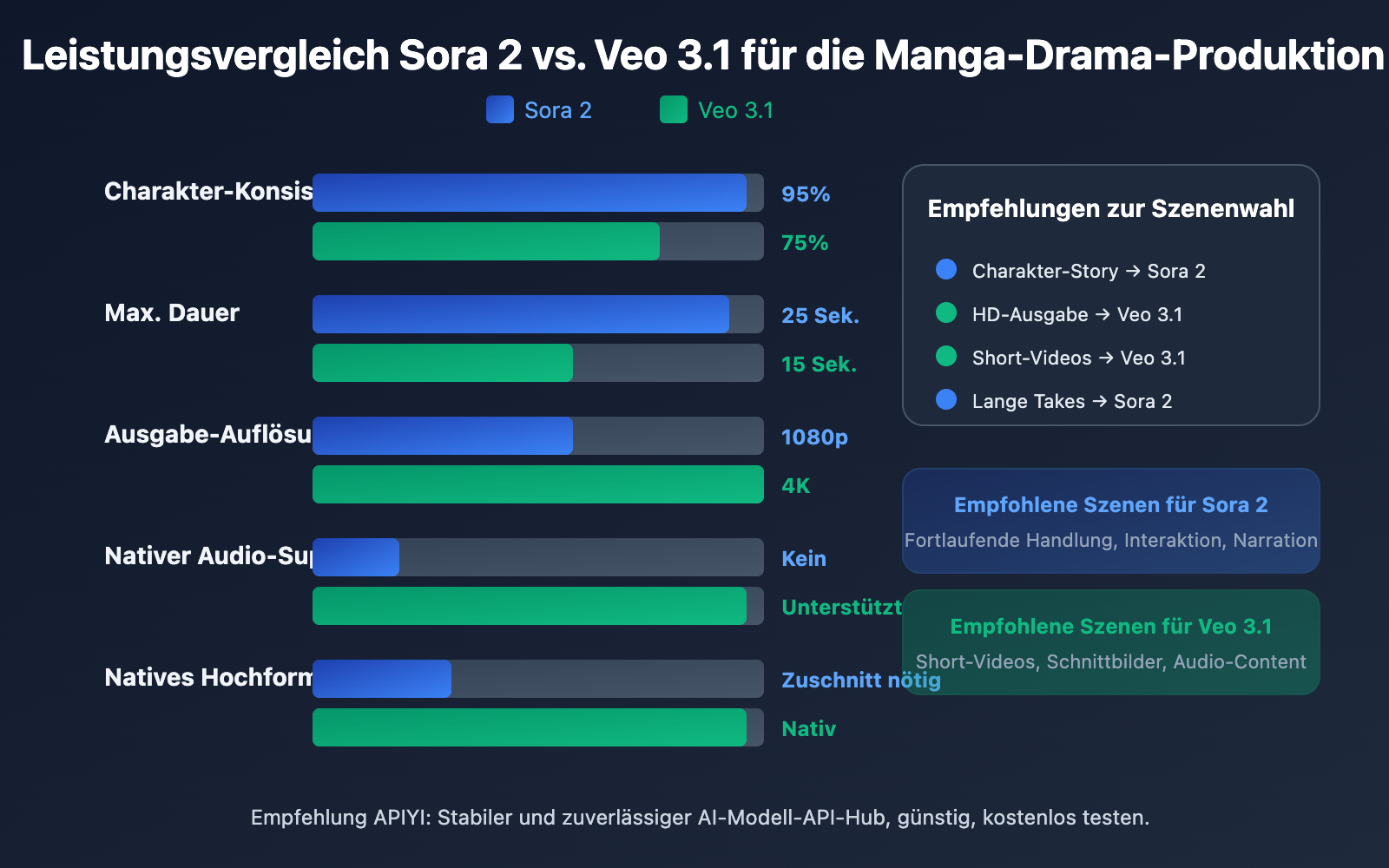

Vergleichsanalyse: Sora 2 vs. Veo 3.1 für die Manga-Drama-Produktion

Die Wahl des richtigen Videogenerierungsmodells ist entscheidend für den Erfolg der Batch-Produktion von Manga-Dramen. Hier ist ein detaillierter Vergleich der beiden führenden Modelle.

Kernkompetenzen im Vergleich: Sora 2 vs. Veo 3.1

| Vergleichsdimension | Sora 2 | Veo 3.1 | Empfehlung für Manga-Dramen |

|---|---|---|---|

| Max. Dauer | 15-25 Sek. | 8-15 Sek. | Sora 2 eignet sich für lange Takes |

| Charakter-Konsistenz | Native Character-Cameo-Unterstützung | Lösung mit mehreren Referenzbildern | Sora 2 ist stabiler |

| Audio-Generierung | Separates Voiceover nötig | Nativer Audio-Support | Veo 3.1 ist effizienter |

| Ausgabe-Auflösung | 1080p | 4K | Veo 3.1 bietet bessere Bildqualität |

| Hochformat-Unterstützung | Post-Processing (Zuschnitt) nötig | Native Unterstützung | Veo 3.1 besser für Short-Videos |

| Stil-Presets | Comic/Anime Presets | Style Reference | Beide haben Vorteile |

| Generierungsgeschwindigkeit | Mittel | 30-60 Sek./Video | Veo 3.1 ist etwas schneller |

| API-Stabilität | Hoch | Hoch | Beide kommerziell nutzbar |

Leitfaden zur Szenenwahl in der Manga-Produktion

Wählen Sie Sora 2 für:

- Fortlaufende Handlungen, die strikte Charakter-Konsistenz erfordern.

- Szenen mit langer narrativer Dauer (über 10 Sekunden).

- Komplexe Interaktionen zwischen Charakteren.

- Projekte mit bereits etabliertem Voiceover-Workflow.

Wählen Sie Veo 3.1 für:

- Projekte, die 4K-HD-Ausgabe anstreben.

- Inhalte für Short-Video-Plattformen (TikTok, Instagram Reels etc.).

- Schnelle Produktion mit nativem Audio.

- Projekte, die primär auf Hochformat-Inhalten basieren.

Hybrid-Strategie:

Für umfangreiche Manga-Drama-Projekte wird empfohlen, beide Modelle je nach Szenencharakteristik kombiniert einzusetzen:

- Kernszenen mit Charakteren → Sora 2 (Gewährleistung der Konsistenz).

- Atmosphärische Schnittbilder/Landschaften → Veo 3.1 (hohe Qualität + Soundeffekte).

- Dialogszenen → Veo 3.1 (nativer Audio-Support).

- Actionszenen → Sora 2 (Unterstützung für längere Takes).

🎯 Empfehlung zum Modellwechsel: Über die einheitliche Schnittstelle von APIYI (apiyi.com) können Sie in demselben Projekt flexibel zwischen Sora 2 und Veo 3.1 wechseln, ohne die Codestruktur anpassen zu müssen – es reicht die Änderung der Modellparameter.

Häufig gestellte Fragen

F1: Sora 2 oder Veo 3.1 – was eignet sich besser für die Batch-Produktion von Manga-Serien?

Beide haben ihre spezifischen Vorteile. Die „Character Cameo“-Funktion von Sora 2 ist bei der Charakter-Konsistenz überlegen und eignet sich ideal für fortlaufende Handlungen mit festen Charakteren. Veo 3.1 hingegen punktet mit nativem Audio und 4K-Ausgabe, was es zur besseren Wahl für Kurzvideo-Projekte macht, bei denen Bildqualität und schnelle Produktion im Vordergrund stehen. Wir empfehlen, beide Modelle je nach Bedarf kombiniert einzusetzen.

F2: Wie hoch sind die Kosten für die Batch-Produktion von Manga-Serien in etwa?

Bei der KI-gestützten Batch-Produktion lassen sich die Kosten pro Folge (3–5 Minuten) auf einen Bereich von ca. 50 bis 200 RMB (ca. 7–25 EUR) senken. Dies hängt primär von der Anzahl der Szenen, der gewählten Auflösung und der Modellklasse ab. Im Vergleich zur traditionellen Produktion bedeutet dies eine Kostenersparnis von über 90 %. Über Aggregations-Plattformen wie APIYI (apiyi.com) können zudem zusätzliche Mengenrabatte erzielt werden.

F3: Wie starte ich schnell mit der Batch-Produktion?

Wir empfehlen die folgenden Schritte für einen schnellen Start:

- Besuchen Sie APIYI (apiyi.com), registrieren Sie ein Konto und rufen Sie Ihren API-Key ab.

- Bereiten Sie Referenzbilder für 2–3 Hauptcharaktere vor.

- Erstellen Sie ein strukturiertes Storyboard-Skript (beginnen Sie mit 5–10 Szenen).

- Nutzen Sie die in diesem Artikel bereitgestellten Code-Beispiele für Testläufe.

- Optimieren Sie die Eingabeaufforderung (Prompts) und Parameter basierend auf den Ergebnissen.

F4: Wie lässt sich die Charakter-Konsistenz im Workflow sicherstellen?

Zu den Kernmethoden gehören: Die Verwendung der Sora 2 „Character Cameo“-Funktion zur Erstellung einer Charakter-ID; das Bereitstellen von Referenzbildern aus verschiedenen Blickwinkeln für jeden Charakter; die Beibehaltung einer konsistenten Charakterbeschreibung in der Eingabeaufforderung sowie die Nutzung fester Stil-Presets. Es wird empfohlen, vor der eigentlichen Produktion 3–5 Test-Szenen zu generieren, um die Konsistenz zu prüfen.

Zusammenfassung

Die wichtigsten Punkte für die Batch-Produktion von Manga-Serien:

- Standardisierung des Workflows: Etablieren Sie einen vollständigen Produktionsprozess vom Skript bis zur Distribution, mit klar definierten Inputs und Outputs für jeden Schritt.

- Strategie zur Modellwahl: Nutzen Sie Sora 2 für den Fokus auf Charakter-Konsistenz und Veo 3.1 für Bildqualität und Audio. Wechseln Sie flexibel je nach Szene.

- Batch-Automatisierung: Übermitteln Sie Aufgaben massenweise per API, um die Generierungszeit für beispielsweise 50 Szenen auf unter eine Stunde zu komprimieren.

- Kostenoptimierung: Wählen Sie Auflösung und Modellklasse bedarfsgerecht aus und nutzen Sie Aggregations-Plattformen für Mengenrabatte.

Die KI-gestützte Batch-Produktion von Manga-Serien reift rasant. Das Beherrschen der Kernfunktionen von Sora 2 und Veo 3.1 sowie der Aufbau eines effizienten Workflows sind entscheidend, um von diesem Content-Trend zu profitieren.

Wir empfehlen APIYI (apiyi.com) als zentrale API-Schnittstelle für Videomodelle. Die Plattform unterstützt führende Modelle wie Sora 2 und Veo 3.1 und bietet kostenlose Testkontingente sowie technischen Support.

Referenzen

⚠️ Hinweis zum Linkformat: Alle externen Links verwenden das Format

Name: domain.com, um das Kopieren zu erleichtern, sind jedoch nicht anklickbar, um den Verlust von SEO-Gewicht zu vermeiden.

-

Offizielle OpenAI Sora Dokumentation: Vorstellung der Sora 2 Funktionen und API-Leitfaden

- Link:

help.openai.com/en/articles/12593142-sora-release-notes - Beschreibung: Detaillierte Erklärung der offiziellen Character-Cameo-Funktion

- Link:

-

Offizielle Google Veo Seite: Vorstellung des Veo 3.1 Modells

- Link:

deepmind.google/models/veo - Beschreibung: Erläuterung der 4K-Ausgabe- und Audiogenerierungsfunktionen

- Link:

-

AI Comic Factory: Open-Source-Projekt zur Comic-Generierung

- Link:

github.com/jbilcke-hf/ai-comic-factory - Beschreibung: Referenz für die Comic-Generierungsimplementierung mit LLM + SDXL

- Link:

-

Hugging Face AI Comic: Technischer Blog zur Comic-Generierung

- Link:

huggingface.co/blog/ai-comic-factory - Beschreibung: Technische Details zu Batch-Generierung und API-Integration

- Link:

Autor: Technik-Team

Technischer Austausch: Willkommen zur Diskussion über Praxiserfahrungen in der Massenproduktion von Comic-Dramen im Kommentarbereich. Weitere Materialien zur AI-Videogenerierung finden Sie in der APIYI apiyi.com Technik-Community.