Gute Nachrichten – Gemini 3.1 Pro Preview ist ab sofort bei APIYI verfügbar und kann direkt über die API aufgerufen werden. Der Modellname lautet gemini-3.1-pro-preview. Der Preis für Eingabeaufforderungen liegt bei 2,00 $/1M Tokens und für Vervollständigungen bei 12,00 $/1M Tokens – exakt derselbe Preis wie bei Gemini 3.0 Pro Preview.

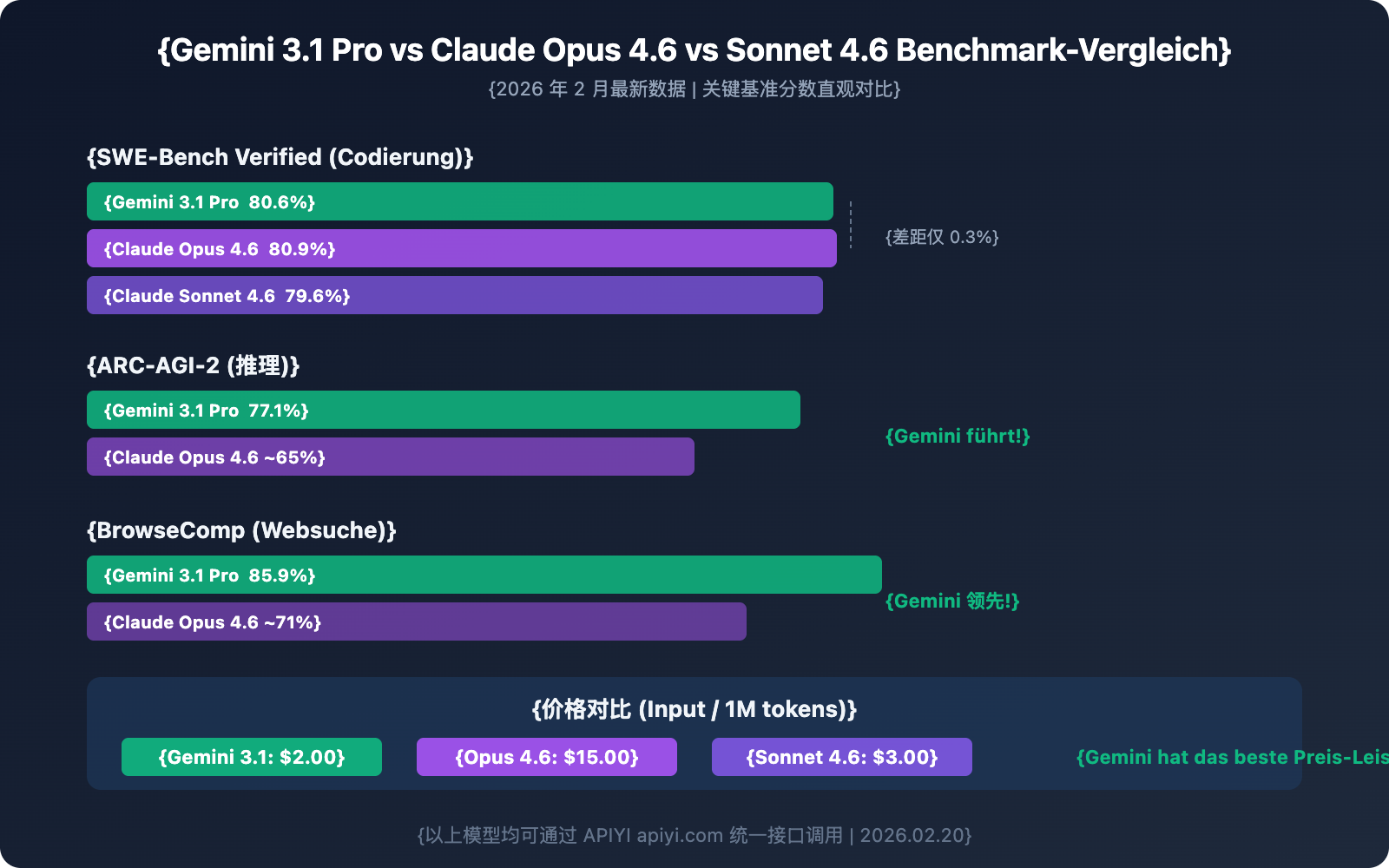

Die Leistungsfähigkeit spielt jedoch in einer völlig anderen Liga: Gemini 3.1 Pro erreicht im ARC-AGI-2 Reasoning-Benchmark 77,1 %, was mehr als das Doppelte von 3.0 Pro ist. Der SWE-Bench Verified Coding-Score liegt bei 80,6 %, womit es erstmals in direkten Wettbewerb mit Claude Opus 4.6 (80,9 %) tritt. Die Output-Effizienz wurde um 15 % gesteigert, was zuverlässigere Ergebnisse mit weniger Tokens ermöglicht.

Kernwert: Dieser Artikel erläutert die 6 wichtigsten Upgrades von Gemini 3.1 Pro Preview, die API-Aufrufmethoden, einen detaillierten Vergleich mit Wettbewerbern sowie Best Practices für verschiedene Szenarien.

Gemini 3.1 Pro Preview: Kernparameter im Überblick

| Parameter | Details |

|---|---|

| Modellname | gemini-3.1-pro-preview |

| Veröffentlichungsdatum | 19. Februar 2026 |

| Preis Eingabe (≤200K Tokens) | 2,00 $ / Million Tokens |

| Preis Vervollständigung (≤200K Tokens) | 12,00 $ / Million Tokens |

| Preis Eingabe (>200K Tokens) | 4,00 $ / Million Tokens |

| Preis Vervollständigung (>200K Tokens) | 18,00 $ / Million Tokens |

| Kontextfenster | 1.000.000 Tokens (1M) |

| Maximaler Output | 65.000 Tokens (65K) |

| Datei-Upload-Limit | 100 MB (vorher 20 MB) |

| Wissensstand bis | Januar 2025 |

| APIYI Verfügbarkeitsstatus | ✅ Online |

🚀 Jetzt testen: Gemini 3.1 Pro Preview ist ab sofort auf APIYI (apiyi.com) verfügbar. Der Aufruf erfolgt im OpenAI-kompatiblen Format – keine Google-Konto-Registrierung erforderlich, Integration in nur 5 Minuten.

Die 6 wichtigsten Upgrades von Gemini 3.1 Pro Preview

Upgrade 1: Verdoppelte Reasoning-Leistung – 77,1 % bei ARC-AGI-2

Dies ist das bemerkenswerteste Upgrade. Im ARC-AGI-2-Benchmark (der die Fähigkeit eines Modells bewertet, völlig neue logische Muster zu lösen) erreicht Gemini 3.1 Pro 77,1 %, was mehr als das Doppelte von Gemini 3.0 Pro ist.

Gleichzeitig erreichte 3.1 Pro im MCP-Atlas-Benchmark (der die Fähigkeit für mehrstufige Workflows unter Verwendung des Model Context Protocol misst) 69,2 %, was eine Steigerung von 15 Prozentpunkten gegenüber den 54,1 % von 3.0 Pro bedeutet.

Dies bedeutet einen Quantensprung für Gemini 3.1 Pro in Szenarien wie komplexem Reasoning, mehrstufigen Logikketten und Agent-Workflows.

Upgrade 2: Dreistufiges System für die Denktiefe – Deep Think Mini

Gemini 3.1 Pro führt ein völlig neues dreistufiges System für die Denktiefe ein, mit dem Entwickler das „Reasoning-Budget“ je nach Komplexität der Aufgabe flexibel anpassen können:

| Denkstufe | Verhaltensmerkmale | Anwendungsszenarien | Latenzauswirkung |

|---|---|---|---|

| high | Ähnlich einer Mini-Version von Gemini Deep Think, tiefes Reasoning | Mathematische Beweise, komplexes Debugging, strategische Planung | Höher |

| medium | Entspricht der Stufe „high“ von 3.0 Pro | Code-Reviews, technische Analysen, Architekturdesign | Moderat |

| low | Schnelle Antwort, minimaler Reasoning-Aufwand | Datenextraktion, Formatkonvertierung, einfache Fragen & Antworten | Niedrigst |

Wichtiger Punkt: Die Stufe „high“ von 3.1 Pro definiert die Bedeutung neu – sie ist jetzt eine „Mini-Version“ von Gemini Deep Think, deren Reasoning-Tiefe weit über das „high“ von 3.0 Pro hinausgeht. Das „medium“ von 3.1 entspricht in etwa dem „high“ von 3.0, was bedeutet, dass man selbst mit „medium“ die ursprüngliche maximale Reasoning-Qualität erhält.

Upgrade 3: Coding-Fähigkeiten in der Spitzenklasse – 80,6 % bei SWE-Bench

Die Leistung von Gemini 3.1 Pro im Bereich Programmierung ist ein gewaltiger Sprung nach vorn:

| Coding-Benchmark | Gemini 3.0 Pro | Gemini 3.1 Pro | Steigerung |

|---|---|---|---|

| SWE-Bench Verified | 76,8 % | 80,6 % | +3,8 % |

| Terminal-Bench 2.0 | 56,9 % | 68,5 % | +11,6 % |

| LiveCodeBench Pro | — | Elo 2887 | Neuer Benchmark |

Das Ergebnis von 80,6 % bei SWE-Bench Verified bedeutet, dass Gemini 3.1 Pro bei Software-Engineering-Aufgaben fast mit Claude Opus 4.6 (80,9 %) gleichzieht – der Unterschied beträgt nur 0,3 Prozentpunkte.

Terminal-Bench 2.0 bewertet die Terminal-Coding-Fähigkeiten von Agenten. Die Steigerung von 56,9 % auf 68,5 % zeigt, dass die Zuverlässigkeit von 3.1 Pro in agentischen Szenarien erheblich gestärkt wurde.

Upgrade 4: Umfassende Verbesserung von Output und Effizienz

| Funktion/Fähigkeit | Gemini 3.0 Pro | Gemini 3.1 Pro | Verbesserung |

|---|---|---|---|

| Max. Output-Token | Unbekannt | 65.000 (65K) | Deutlich erhöht |

| Dateiupload-Limit | 20 MB | 100 MB | 5-fach |

| YouTube-URL-Support | ❌ | ✅ | Neu hinzugefügt |

| Output-Effizienz | Basis | +15 % | Weniger Token für zuverlässigere Ergebnisse |

Das Output-Limit von 65K bedeutet, dass das Modell vollständige lange Dokumente, große Codeblöcke oder detaillierte Analyseberichte auf einmal erstellen kann, ohne dass mehrere Anfragen zusammengesetzt werden müssen.

Die Erweiterung des Dateiuploads von 20 MB auf 100 MB ermöglicht in Kombination mit dem 1M-Token-Kontext die direkte Analyse großer Code-Repositories, langer Videos oder umfangreicher Dokumentensammlungen.

Die direkte Übergabe von YouTube-URLs ist eine praktische neue Funktion – Entwickler können YouTube-Links direkt in die Eingabeaufforderung einfügen, und das Modell analysiert den Videoinhalt automatisch, ohne dass ein manueller Download und Upload erforderlich ist.

Upgrade 5: Dedizierter customtools-Endpunkt – Ein Werkzeug für die Agent-Entwicklung

Google hat gleichzeitig den dedizierten Endpunkt gemini-3.1-pro-preview-customtools veröffentlicht, eine Version, die tiefgreifend für Agent-Entwicklungsszenarien optimiert wurde:

- Optimierung der Tool-Aufrufpriorität: Die Aufrufpriorität für häufig von Entwicklern genutzte Tools wie

view_fileundsearch_codewurde speziell abgestimmt. - Mix aus Bash + benutzerdefinierten Funktionen: Besonders geeignet für Agent-Workflows, die zwischen Bash-Befehlen und benutzerdefinierten Funktionen wechseln müssen.

- Stabilität in agentischen Szenarien: Höhere Zuverlässigkeit bei mehrstufigen Agent-Aufgaben im Vergleich zur allgemeinen Version.

Das bedeutet: Wenn Sie KI-Programmierassistenten, Code-Review-Bots oder automatisierte Ops-Agenten entwickeln, ist der customtools-Endpunkt die bessere Wahl.

Upgrade 6: Sprung bei der Websuche – 85,9 % bei BrowseComp

Der BrowseComp-Benchmark bewertet die Websuchfähigkeiten von Agenten. Gemini 3.1 Pro erreicht hier 85,9 %, während 3.0 Pro nur bei 59,2 % lag – eine Steigerung von 26,7 Prozentpunkten.

Diese Fähigkeit ist von großer Bedeutung für Anwendungen, die Echtzeit-Informationsabrufe erfordern (wie Recherche-Assistenten, Wettbewerbsanalysen oder News-Zusammenfassungen).

💡 Technischer Einblick: Gemini 3.1 Pro bietet zudem den speziellen Endpunkt

gemini-3.1-pro-preview-customtoolsan. Dieser ist für Entwickler optimiert, die Bash-Befehle und benutzerdefinierte Funktionen mischen, wobei die Priorität von Tools wieview_fileundsearch_codebesonders feinjustiert wurde. Über APIYI (apiyi.com) kann dieser dedizierte Endpunkt direkt aufgerufen werden.

Praxisleitfaden: Gemini 3.1 Pro Preview API-Aufruf

Minimalistisches Beispiel (Python)

import openai

client = openai.OpenAI(

api_key="IHR_API_KEY",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI

)

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "user", "content": "Analysiere die Zeitkomplexität dieses Codes und gib Optimierungsvorschläge:\n\ndef two_sum(nums, target):\n for i in range(len(nums)):\n for j in range(i+1, len(nums)):\n if nums[i] + nums[j] == target:\n return [i, j]"}

]

)

print(response.choices[0].message.content)

Vollständiges Beispiel ansehen (inkl. Steuerung der Denktiefe und Multimodalität)

import openai

import base64

client = openai.OpenAI(

api_key="IHR_API_KEY",

base_url="https://api.apiyi.com/v1" # Einheitliche Schnittstelle von APIYI

)

# Beispiel 1: Hohe Reasoning-Tiefe - Komplexe mathematische Schlussfolgerung

response_math = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": "Beweise: Für alle positiven ganzen Zahlen n ist n^3 - n immer durch 6 teilbar. Bitte gib einen strengen mathematischen Beweis an."

}],

temperature=0.2,

max_tokens=4096

)

# Beispiel 2: Multimodale Analyse - Bildverständnis

with open("architecture.png", "rb") as f:

img_data = base64.b64encode(f.read()).decode()

response_vision = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{

"role": "user",

"content": [

{"type": "text", "text": "Analysiere dieses Systemarchitekturdiagramm im Detail und weise auf potenzielle Leistungsengpässe sowie Verbesserungsvorschläge hin."},

{"type": "image_url", "image_url": {"url": f"data:image/png;base64,{img_data}"}}

]

}],

max_tokens=8192

)

# Beispiel 3: Code-Analyse mit langem Kontext

with open("large_codebase.txt", "r") as f:

code_content = f.read() # Kann bis zu mehreren hunderttausend Token umfassen

# Hinweis: In der Praxis würde man hier den 1M Kontext nutzen

response_code = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[

{"role": "system", "content": "Du bist ein erfahrener Softwarearchitekt. Bitte analysiere das gesamte Code-Repository sorgfältig."},

{"role": "user", "content": f"Hier ist das vollständige Code-Repository:\n\n{code_content}\n\nBitte analysiere:\n1. Das gesamte Architekturdesign\n2. Potenzielle Bugs\n3. Optimierungsvorschläge für die Performance\n4. Refactoring-Pläne"}

],

max_tokens=16384 # Nutzt die 65K Output-Kapazität

)

print(f"Mathematisches Reasoning: {response_math.choices[0].message.content[:200]}...")

print(f"Visuelle Analyse: {response_vision.choices[0].message.content[:200]}...")

print(f"Code-Analyse: {response_code.choices[0].message.content[:200]}...")

🎯 Integrations-Tipp: Um Gemini 3.1 Pro Preview über APIYI (apiyi.com) aufzurufen, können Sie das Standard-OpenAI-SDK verwenden, ohne zusätzliche Abhängigkeiten installieren zu müssen. Bei bestehenden Projekten im OpenAI-Format müssen lediglich die Parameter

base_urlundmodelangepasst werden, um zu wechseln.

Gemini 3.1 Pro Preview im detaillierten Vergleich mit der Konkurrenz

Zusammenfassende Vergleichstabelle der wichtigsten Benchmarks

| Benchmark | Gemini 3.1 Pro | Claude Opus 4.6 | Claude Sonnet 4.6 | Gewinner |

|---|---|---|---|---|

| SWE-Bench Verified | 80,6 % | 80,9 % | 79,6 % | Claude Opus (hauchdünn) |

| ARC-AGI-2 | 77,1 % | ~65 % | — | Gemini 3.1 Pro |

| Terminal-Bench 2.0 | 68,5 % | — | — | Gemini 3.1 Pro |

| BrowseComp | 85,9 % | ~71 % | — | Gemini 3.1 Pro |

| MCP Atlas | 69,2 % | — | — | Gemini 3.1 Pro |

| Kontextfenster | 1M Tokens | 200K | 200K | Gemini 3.1 Pro |

| Max. Output | 65K | — | — | Gemini 3.1 Pro |

| Input-Preis | $2,00 | $15,00 | $3,00 | Gemini 3.1 Pro |

| Verfügbare Plattformen | APIYI apiyi.com etc. | APIYI apiyi.com etc. | APIYI apiyi.com etc. | — |

Empfehlungen für Anwendungsszenarien

| Anwendungsszenario | Empfohlenes Modell | Hauptgrund |

|---|---|---|

| Komplexes Reasoning & Mathe | Gemini 3.1 Pro Preview | ARC-AGI-2 77,1 %, verdoppelte Reasoning-Leistung |

| Analyse langer Dokumente/Code-Repos | Gemini 3.1 Pro Preview | 1M Token Kontext, einzigartig am Markt |

| Agentisches Programmieren | Claude Opus 4.6 / Gemini 3.1 Pro | SWE-Bench fast gleichauf |

| Agent-Such-Workflows | Gemini 3.1 Pro Preview | BrowseComp 85,9 %, deutlicher Vorsprung |

| Alltägliches Coding (mittlere Komplexität) | Claude Sonnet 4.6 | Hohes Preis-Leistungs-Verhältnis, 79,6 % Coding |

| Flaggschiff-Leistung bei knappem Budget | Gemini 3.1 Pro Preview | $2/$12, günstigster Flaggschiff-Preis |

| Multimodale Video-/Audioanalyse | Gemini 3.1 Pro Preview | Natives Multimodal, YouTube-URL-Unterstützung |

💰 Kostenvergleich: Bei vergleichbarer Flaggschiff-Leistung beträgt der Input-Preis von Gemini 3.1 Pro ($2,00) nur 13 % des Preises von Claude Opus 4.6 ($15,00). Besonders für Reasoning- und multimodale Szenarien ist der Preis-Leistungs-Vorteil enorm. Über die Plattform APIYI (apiyi.com) können Sie über dieselbe Schnittstelle schnell zwischen den Modellen wechseln und testen.

Gemini 3.1 Pro Preview Best Practices

Die drei Stufen der Denktiefe (Thinking Levels) geschickt nutzen

# Komplexes Reasoning: high (Deep Think Mini Modus)

# Alltagsaufgaben: medium (entspricht dem alten high)

# Einfache Aufgaben: low (schnellste Antwort)

# Bei Aufrufen über APIYI wird das Thinking Level via extra_body übergeben

response = client.chat.completions.create(

model="gemini-3.1-pro-preview",

messages=[{"role": "user", "content": "Deine Frage"}],

extra_body={"thinking_level": "high"} # high/medium/low

)

Das 1M Token Kontextfenster voll ausschöpfen

Das 1M Token Kontextfenster von Gemini 3.1 Pro Preview ist das derzeit größte unter allen Flaggschiff-Modellen. Hier sind einige besonders wertvolle Einsatzbereiche:

Globale Analyse von Code-Repositories: Übergeben Sie dutzende Dateien auf einmal, damit das Modell die gesamte Architektur versteht und Refactoring-Vorschläge macht. Dies deckt Kopplungsprobleme zwischen Modulen und globale Optimierungschancen viel besser auf als eine dateiweise Analyse.

Tiefenverständnis langer Dokumente: Juristische Verträge, technische Spezifikationen, wissenschaftliche Publikationsreihen – 1M Tokens fassen ein ganzes Buch. In Kombination mit der verbesserten Reasoning-Tiefe von 3.1 Pro lassen sich so auch implizite Zusammenhänge in langen Texten identifizieren.

YouTube-Videoanalyse (Neu): Übergeben Sie YouTube-URLs direkt im Prompt, ohne Videodateien herunter- oder hochladen zu müssen. Das Modell analysiert den Videoinhalt automatisch – ideal für Content-Moderation, Wettbewerbsanalysen oder Tutorial-Zusammenfassungen.

Langzeitgedächtnis in Multi-Turn-Dialogen: Ein 1M Token Fenster bedeutet, dass das Modell sich an extrem lange Gesprächsverläufe „erinnern“ kann. Das ist ein klarer Vorteil für Kundenservice, Beratung oder E-Learning-Szenarien, die viel Kontext erfordern.

Achtung beim 200K Preis-Schwellenwert: Wenn der Input 200K Tokens überschreitet, verdoppelt sich der Preis von $2/$12 auf $4/$18. Es empfiehlt sich, bei langem Kontext die tatsächliche Token-Anzahl vorab zu prüfen. In Szenarien zwischen 200K und 300K Tokens kann das Kürzen des Inputs auf unter 200K die Kosten halbieren.

Nutzung des customtools-Endpunkts

Wenn Sie Agent-Anwendungen bauen, ist der Endpunkt gemini-3.1-pro-preview-customtools die erste Wahl:

# Spezieller Endpunkt für Agent-Entwicklung

response = client.chat.completions.create(

model="gemini-3.1-pro-preview-customtools", # Optimierte Version für Agents

messages=[{"role": "user", "content": "Finde alle unbehandelten Exceptions im Projekt und schlage Fixes vor"}],

tools=[

{"type": "function", "function": {"name": "search_code", "description": "Code durchsuchen"}},

{"type": "function", "function": {"name": "view_file", "description": "Datei ansehen"}},

]

)

Dieser Endpunkt ist bei der Genauigkeit und Zuverlässigkeit von Tool-Aufrufen der Standardversion überlegen, besonders in Szenarien, in denen Bash-Befehle mit benutzerdefinierten Funktionen gemischt werden.

Strategien zur Kostenoptimierung

| Strategie | Methode | Erwartete Ersparnis |

|---|---|---|

| Denktiefe nach Bedarf | Low für einfache Aufgaben, High nur für Komplexe | 30–50 % |

| Kontext für Sammelanfragen nutzen | Mehrere verwandte Fragen in einem Request bündeln | 20–40 % |

| Limit bei >200K Tokens beachten | Preisverdopplung ab 200K vermeiden durch Input-Kürzung | Vermeidung von 2x Aufschlag |

| Output-Token-Kontrolle | Sinnvolle max_tokens setzen, um Redundanz zu vermeiden | 10–20 % |

| Das richtige Gemini-Modell wählen | Flash für einfache Aufgaben, 3.1 Pro nur für Komplexe | 60–80 % |

Schritte zur Migration von Gemini 3.0 Pro auf 3.1 Pro

Der Migrationsprozess ist extrem einfach:

Schritt 1: Model-Parameter anpassen

# Alt

model="gemini-3-pro-preview"

# Neu

model="gemini-3.1-pro-preview"

Schritt 2: Kernfunktionen testen – Lassen Sie einige typische Cases Ihrer Hauptanwendung laufen, um sicherzustellen, dass die Output-Qualität den Erwartungen entspricht.

Schritt 3: Neue Fähigkeiten erkunden – Testen Sie Deep Reasoning mit dem Level „high“, 100MB Datei-Uploads oder die YouTube-URL-Analyse.

Schritt 4: Kosten optimieren – Setzen Sie je nach Aufgabe das passende Thinking Level. Die Nutzung von „medium“ statt „high“ für Alltagsaufgaben senkt die Latenz und den Token-Verbrauch bei gleichbleibender Qualität.

🎯 Migrations-Tipp: Auf der Plattform APIYI (apiyi.com) erfordert die Migration lediglich die Änderung eines Parameters. Wir empfehlen, den alten Modellaufruf zunächst als Fallback beizubehalten und erst nach Bestätigung der Stabilität von 3.1 vollständig umzustellen.

Häufig gestellte Fragen

F1: Ist der Aufruf von Gemini 3.1 Pro Preview auf APIYI identisch mit den vorherigen Gemini-Modellen?

Absolut identisch. Auf der Plattform APIYI (apiyi.com) nutzt Gemini 3.1 Pro Preview das standardmäßige OpenAI-kompatible Format. Als model-Parameter geben Sie einfach gemini-3.1-pro-preview an. Wenn Sie bereits Gemini 3.0 Pro nutzen, müssen Sie lediglich den Modellnamen ändern; am restlichen Code sind keine Anpassungen erforderlich.

F2: 3.1 Pro und 3.0 Pro kosten dasselbe – lohnt sich der Wechsel?

Ein Wechsel wird dringend empfohlen. Der Preis ist exakt gleich ($2/$12), aber die Reasoning-Fähigkeiten haben sich verdoppelt, die Coding-Leistung stieg von 76,8 % auf 80,6 % und die Output-Effizienz hat sich um 15 % verbessert. Es handelt sich um ein reines Gratis-Upgrade – es gibt keinen Grund, nicht zu wechseln. Über APIYI (apiyi.com) ist der Umstieg durch die Änderung eines einzigen Parameters erledigt.

F3: Wie wählt man die drei Stufen der Denktiefe (Thinking Depth) aus? Beeinflusst das den Preis?

Die Denktiefe beeinflusst primär die Latenz und den Token-Verbrauch. Die Stufe „high“ bietet tiefergehendes Reasoning, verbraucht aber mehr Output-Token und Zeit. Die Stufe „low“ ist am schnellsten, bietet aber ein flacheres Reasoning. Für den Alltag empfehlen wir „medium“ (entspricht qualitativ dem „high“ der Vorgängerversion). Nutzen Sie „high“ nur für komplexe logische Szenarien. Die Abrechnung erfolgt nach dem tatsächlichen Token-Verbrauch; für die Wahl der Denktiefe selbst fallen keine zusätzlichen Gebühren an.

F4: Gemini 3.1 Pro Preview oder Claude Opus 4.6 – welches Modell soll ich wählen?

Das hängt vom Szenario und dem Budget ab: Wenn Sie einen extrem langen Kontext benötigen (1M vs. 200K), multimodale Analysen durchführen (Video/YouTube) oder preisbewusst sind ($2 vs. $15), wählen Sie Gemini 3.1 Pro. Wenn Sie Wert auf ultimative Coding-Präzision (80,9 % vs. 80,6 %) und ein ausgereiftes Agent-Ökosystem legen, ist Claude Opus 4.6 die bessere Wahl. Beide können über APIYI (apiyi.com) über dieselbe Schnittstelle aufgerufen werden, was A/B-Tests sehr einfach macht.

Leitfaden zur Modellauswahl der Gemini 3-Serie

Die Gemini 3-Serie umfasst mittlerweile mehrere verfügbare Modelle. Je nach Szenario sollten Sie die passende Version wählen:

| Modell | Positionierung | Kernvorteile | Anwendungsbereiche | APIYI-Preis |

|---|---|---|---|---|

| gemini-3.1-pro-preview | Flaggschiff-Reasoning (NEU) | Verdoppeltes Reasoning, Top-Coding | Komplexe Logik, Code-Generierung, Agents | $2/$12 |

| gemini-3-pro-preview | Flaggschiff-Allrounder | Agentische Programmierung, Multimodalität | Allgemeine Aufgaben (Upgrade auf 3.1 empfohlen) | $2/$12 |

| gemini-3-flash-preview | Schnell & Leichtgewichtig | Extrem schnelle Reaktion, niedrigste Kosten | Echtzeit-Dialoge, Batch-Verarbeitung, hohe Aufruffrequenz | Günstiger |

| gemini-3-pro-image-preview | Bildgenerierung | KI-Text-zu-Bild, Bildbearbeitung | Kreativdesign, Content-Erstellung | Pro Bild |

Entscheidungsbaum:

- Benötigen Sie stärkstes Reasoning und Coding? →

gemini-3.1-pro-preview - Benötigen Sie höchste Geschwindigkeit und niedrigste Kosten? →

gemini-3-flash-preview - Müssen Sie Bilder generieren? →

gemini-3-pro-image-preview - Nutzen Sie bereits 3.0 Pro? → Direkt auf

gemini-3.1-pro-previewupgraden

Wann Gemini 3.1 Pro Preview nicht geeignet ist

Obwohl 3.1 Pro in den meisten Szenarien hervorragend abschneidet, gibt es Fälle, in denen andere Modelle vorzuziehen sind:

- Bedarf an extremer Coding-Genauigkeit: Der SWE-Bench-Wert von Claude Opus 4.6 liegt mit 80,9 % immer noch leicht über den 80,6 % von 3.1 Pro. Dieser kleine Unterschied kann bei extremen Präzisionsanforderungen entscheidend sein.

- Echtzeitanwendungen mit extrem niedriger Latenz: Der „high“-Denkmodus von 3.1 Pro weist eine höhere Latenz auf. In solchen Fällen sind Gemini 3 Flash oder Claude Sonnet 4.6 die bessere Wahl.

- Bedarf an stabilen SLA-Garantien: Preview-Modelle bieten keine offiziellen SLA-Zusagen. Für Produktionsumgebungen mit extrem hohen Anforderungen an die Verfügbarkeit müssen die Risiken abgewogen werden.

- Überdimensionierung für einfache Aufgaben: Bei Aufgaben mit geringer Komplexität ist der Einsatz von 3.1 Pro reine Kostenverschwendung; hier ist die Flash-Serie deutlich wirtschaftlicher.

Zusammenfassung der Wettbewerbsvorteile von Gemini 3.1 Pro Preview

In der KI-Modell-Landschaft vom Februar 2026 lassen sich die Kernvorteile von Gemini 3.1 Pro Preview in drei Superlativen zusammenfassen:

- Größter Kontext: 1M Token – das ist das Fünffache von Claude Opus 4.6 (200K).

- Niedrigster Flaggschiff-Preis: Input für $2,00 – das sind nur 13 % des Preises von Claude Opus 4.6 ($15,00).

- Stärkster Reasoning-Sprung: ARC-AGI-2 auf 77,1 % verdoppelt – damit führend in der Reasoning-Dimension gegenüber allen Wettbewerbern.

Relative Schwächen liegen lediglich in reinen Coding-Szenarien (SWE-Bench 80,6 % vs. Claude Opus 80,9 %, ein minimaler Unterschied) und in der Reife des Agent-Ökosystems.

💡 Fazit: Für die meisten Entwickler bietet Gemini 3.1 Pro Preview derzeit das beste Preis-Leistungs-Verhältnis unter den Flaggschiff-Modellen. Über APIYI (apiyi.com) können Sie Gemini, Claude, GPT und alle anderen führenden Modelle auf einer einzigen Plattform vergleichen und testen, um die optimale Lösung für Ihr Szenario zu finden.

Zusammenfassung: Upgrade zum gleichen Preis bei doppelter Leistung – Gemini 3.1 Pro Preview lohnt den sofortigen Wechsel

Gemini 3.1 Pro Preview ist ein bedeutendes Upgrade: Gleicher Preis, doppelte Leistung.

- Schlussfolgerungsfähigkeit (Reasoning) verdoppelt: ARC-AGI-2 stieg von ~35 % auf 77,1 %, was mehr als das Doppelte im Vergleich zu Version 3.0 ist.

- Coding auf Augenhöhe mit der Spitze: Mit 80,6 % im SWE-Bench liegt das Modell nur noch 0,3 % hinter Claude Opus 4.6.

- Sprung in der Agent-Leistung: Terminal-Bench +20 %, BrowseComp +45 %, MCP Atlas +28 %.

- Umfassende Effizienzsteigerung: Output von 65K Tokens, Dateilimit von 100 MB, allgemeine Effizienz +15 %.

- Dreistufiges Denksystem: Der "high"-Modus entspricht Deep Think Mini; das Reasoning-Budget lässt sich je nach Bedarf anpassen.

Erleben Sie Gemini 3.1 Pro Preview jetzt über APIYI (apiyi.com) – einheitliche Schnittstelle, sofort einsatzbereit. Ändern Sie einfach den Modellparameter auf gemini-3.1-pro-preview, um das Upgrade abzuschließen.

Referenzen

-

Offizieller Google Blog: Gemini 3.1 Pro Ankündigung

- Link:

blog.google/innovation-and-ai/models-and-research/gemini-models/gemini-3-1-pro - Beschreibung: Offizielle Funktionsvorstellung und Benchmark-Ergebnisse.

- Link:

-

Google DeepMind Model Card: Technische Details zu Gemini 3.1 Pro

- Link:

deepmind.google/models/model-cards/gemini-3-1-pro - Beschreibung: Sicherheitsbewertungen und detaillierte Parameter.

- Link:

-

Offizielle Gemini API Dokumentation: Modellliste und Aufrufmethoden

- Link:

ai.google.dev/gemini-api/docs/models/gemini-3.1-pro-preview - Beschreibung: API-Parameter, Preisgestaltung und Nutzungsleitfaden.

- Link:

-

VentureBeat Bericht: Erste Eindrücke von Gemini 3.1 Pro

- Link:

venturebeat.com/technology/google-gemini-3-1-pro-first-impressions - Beschreibung: Features von Deep Think Mini und Praxiserfahrungen.

- Link:

-

MarkTechPost Analyse: Technische Interpretation von Gemini 3.1 Pro

- Link:

marktechpost.com/2026/02/19/google-ai-releases-gemini-3-1-pro - Beschreibung: Benchmark-Daten und Auswirkungen auf die Branche.

- Link:

📝 Autor: APIYI Team | Für technischen Austausch besuchen Sie APIYI apiyi.com

📅 Aktualisierungsdatum: 20. Februar 2026

🏷️ Schlüsselwörter: Gemini 3.1 Pro Preview API, APIYI Launch, Reasoning verdoppelt, SWE-Bench 80,6 %, ARC-AGI-2 77,1 %