Möchten Sie OpenCode, diesen Open-Source-AI-Programmierassistenten, nutzen, haben aber Bedenken wegen der hohen offiziellen API-Preise oder instabiler Netzwerkverbindungen? Ein API-Relay ist die ideale Lösung für Sie. In diesem Artikel zeigen wir Ihnen Schritt für Schritt, wie Sie in nur 3 Schritten OpenCode mit Relay-Diensten wie APIYI, OpenRouter und anderen verbinden, damit Sie kostengünstig auf über 75 führende KI-Modelle wie Claude, GPT-4 und Gemini zugreifen können.

Kernvorteil: Nach der Lektüre dieses Artikels werden Sie wissen, wie Sie OpenCode mit jeder OpenAI-kompatiblen API konfigurieren, um einen flexiblen Modellwechsel und eine Kostenoptimierung zu erreichen.

Was ist OpenCode? Warum ein API-Relay nutzen?

OpenCode ist ein quelloffener KI-Programmierassistent für das Terminal, der oft als Open-Source-Alternative zu Claude Code bezeichnet wird. Es basiert auf der Sprache Go und bietet eine elegante TUI-Oberfläche, Multi-Session-Management, LSP-Integration und weitere professionelle Funktionen.

OpenCode Kernfunktionen im Überblick

| Funktion | Beschreibung | Nutzen |

|---|---|---|

| 75+ Modell-Support | Unterstützt OpenAI, Claude, Gemini, Bedrock etc. | Keine Bindung an einen Anbieter |

| Terminal-nativ | Mit Bubble Tea erstellte, elegante TUI | Entwicklerfreundliches Bedienkonzept |

| Open Source & Kostenlos | Vollständig quelloffen, keine Abogebühren | Kostenkontrolle durch Pay-per-Call |

| LSP-Integration | Automatische Erkennung von Language Servern | Intelligente Code-Vervollständigung & Diagnose |

| Multi-Session-Management | Paralleles Ausführen mehrerer Agents | Aufteilung komplexer Aufgaben |

| Vim-Modus | Integrierter Editor im Vim-Stil | Nahtloser Wechsel für Terminal-Nutzer |

Warum ein API-Relay verwenden?

Die direkte Nutzung offizieller APIs kann folgende Hürden mit sich bringen:

| Problem | Lösung durch ein API-Relay |

|---|---|

| Hohe Preise | Relays bieten oft günstigere Konditionen für Individualentwickler |

| Instabiles Netzwerk | Optimierte Routen für besseren globalen Zugriff |

| Komplexe Abrechnung | Einheitliche Schnittstelle, Multi-Modell-Verwaltung aus einer Hand |

| Kontingentbeschränkungen | Relays bieten oft flexiblere Quoten |

| Registrierungshürden | Keine ausländische Telefonnummer oder Kreditkarte erforderlich |

🚀 Schnellstart: Wir empfehlen die Nutzung von APIYI (apiyi.com) als Relay. Es bietet sofort einsatzbereite OpenAI-kompatible Schnittstellen. Registrieren Sie sich und erhalten Sie ein kostenloses Testguthaben – die Konfiguration von OpenCode dauert nur 5 Minuten.

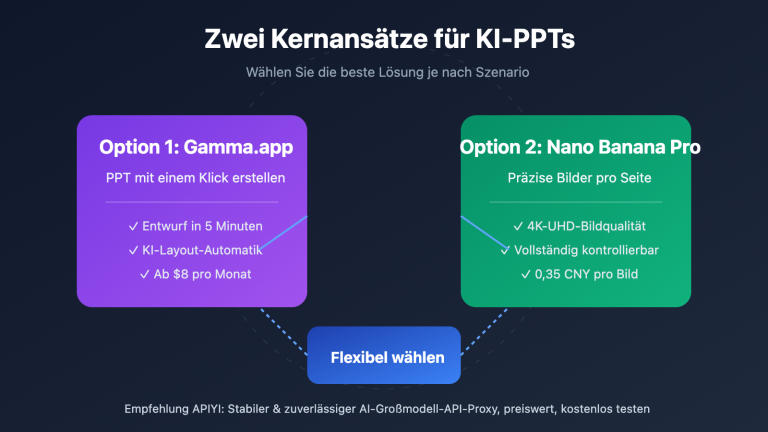

Kernelemente der OpenCode-Anbindung an API-Relaisstationen

Bevor du mit der Konfiguration beginnst, werfen wir einen Blick auf das API-Anbindungsprinzip von OpenCode:

Beschreibung der Konfigurationsarchitektur

OpenCode nutzt ein einheitliches Konfigurationsmanagement-System, das mehrschichtige Überschreibungen unterstützt:

| Konfigurationsebene | Dateipfad | Priorität | Anwendungsfall |

|---|---|---|---|

| Remote-Konfiguration | .well-known/opencode |

Niedrigste | Einheitliche Team-Konfiguration |

| Globale Konfiguration | ~/.config/opencode/opencode.json |

Mittel | Persönliche Standardeinstellungen |

| Umgebungsvariable | Datei via OPENCODE_CONFIG |

Mittel-Hoch | Temporäre Überschreibung |

| Projektkonfiguration | Projektwurzel opencode.json |

Hoch | Projektspezifische Einstellungen |

| Inline-Konfiguration | OPENCODE_CONFIG_CONTENT |

Höchste | CI/CD-Szenarien |

API-Relais-Anbindungsprinzip

OpenCode unterstützt über den @ai-sdk/openai-compatible-Adapter jede OpenAI-kompatible API. Die wichtigsten Konfigurationspunkte sind:

- baseURL: Die Schnittstellenadresse der API-Relaisstation.

- apiKey: Der von der Relaisstation bereitgestellte API-Key.

- models: Liste der verfügbaren Modelle.

Das bedeutet: Solange die Relaisstation die Standard-Schnittstelle /v1/chat/completions bereitstellt, kann sie direkt in OpenCode eingebunden werden.

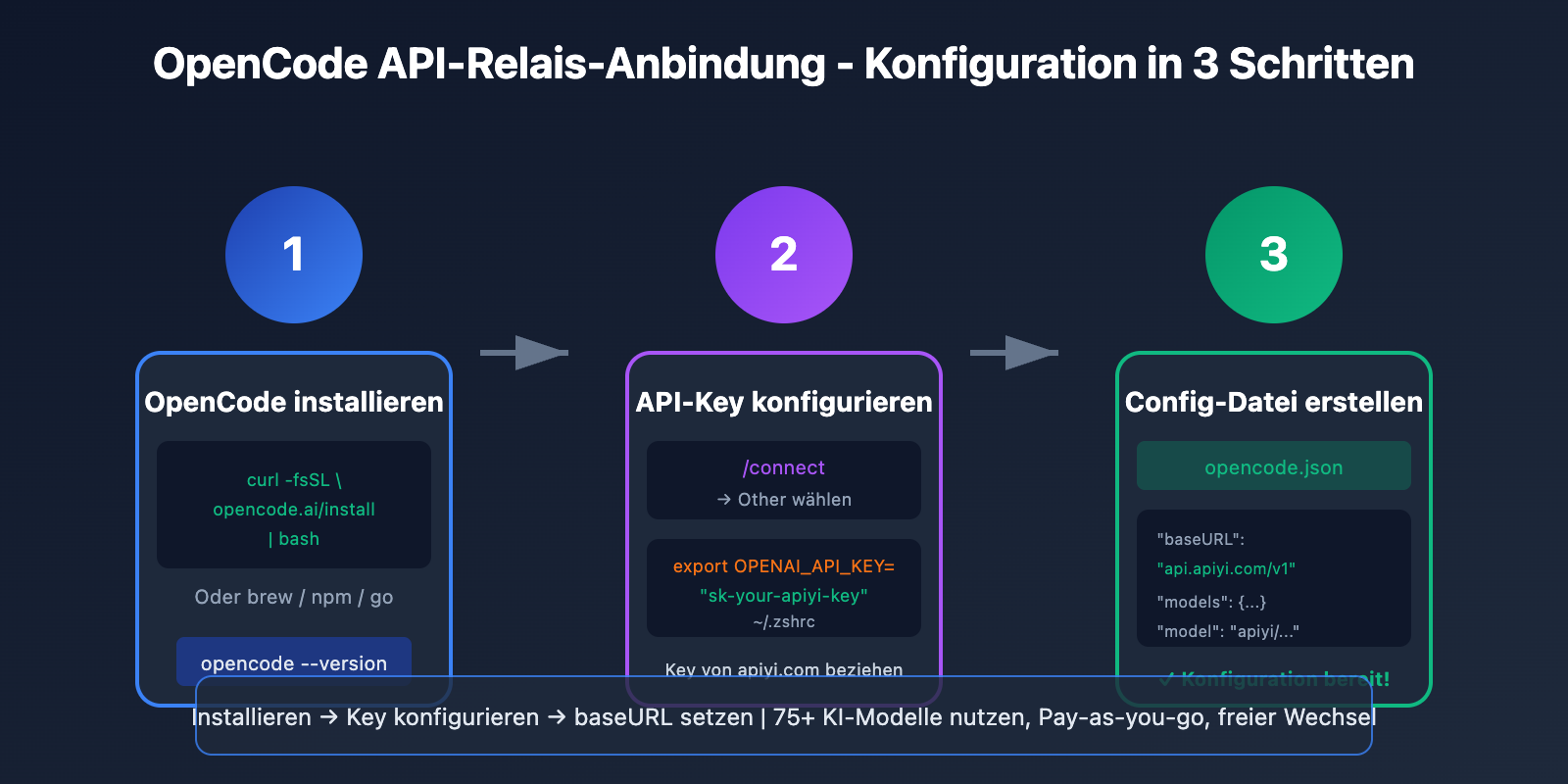

OpenCode Schnellstart-Konfiguration

Schritt 1: OpenCode installieren

OpenCode bietet verschiedene Installationswege an, wähle den für dich passendsten:

Ein-Klick-Installationsskript (empfohlen):

curl -fsSL https://opencode.ai/install | bash

Homebrew Installation (macOS/Linux):

brew install opencode-ai/tap/opencode

npm Installation:

npm i -g opencode-ai@latest

Go Installation:

go install github.com/opencode-ai/opencode@latest

Installation überprüfen:

opencode --version

Schritt 2: API-Relais-Key konfigurieren

OpenCode unterstützt zwei Authentifizierungsmethoden:

Option 1: Über den /connect-Befehl (empfohlen)

Starte OpenCode und gib den Befehl /connect ein:

opencode

# Im TUI-Interface eingeben

/connect

Wähle Other, um einen benutzerdefinierten Provider hinzuzufügen, und gib deinen API-Key ein. Der Key wird sicher unter ~/.local/share/opencode/auth.json gespeichert.

Option 2: Konfiguration über Umgebungsvariablen

Füge in deiner ~/.zshrc oder ~/.bashrc hinzu:

# APIYI Relais-Konfiguration

export OPENAI_API_KEY="sk-your-apiyi-key"

export OPENAI_BASE_URL="https://api.apiyi.com/v1"

Konfiguration anwenden:

source ~/.zshrc

Schritt 3: opencode.json Konfigurationsdatei erstellen

Dies ist der wichtigste Schritt: Erstelle eine Konfigurationsdatei, um die API-Relaisstation festzulegen.

Globale Konfiguration (gilt für alle Projekte):

mkdir -p ~/.config/opencode

touch ~/.config/opencode/opencode.json

Projektkonfiguration (gilt nur für das aktuelle Projekt):

touch opencode.json # Im Projekt-Stammverzeichnis

Minimalistisches Konfigurationsbeispiel

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI",

"options": {

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "{env:OPENAI_API_KEY}"

},

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4"

},

"gpt-4o": {

"name": "GPT-4o"

}

}

}

},

"model": "apiyi/claude-sonnet-4-20250514"

}

Konfigurationshinweis: Die Syntax

{env:OPENAI_API_KEY}liest automatisch die Umgebungsvariable aus, um das Hardcoding von Keys in der Datei zu vermeiden. API-Keys, die über APIYI (apiyi.com) bezogen werden, sind OpenAI-kompatibel und können direkt verwendet werden.

Vollständiges Konfigurationsbeispiel ansehen (inkl. mehrerer Provider)

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI (empfohlen)",

"options": {

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "{env:APIYI_API_KEY}"

},

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4",

"limit": {

"context": 200000,

"output": 65536

}

},

"claude-opus-4-20250514": {

"name": "Claude Opus 4",

"limit": {

"context": 200000,

"output": 32000

}

},

"gpt-4o": {

"name": "GPT-4o",

"limit": {

"context": 128000,

"output": 16384

}

},

"gpt-4o-mini": {

"name": "GPT-4o Mini",

"limit": {

"context": 128000,

"output": 16384

}

},

"gemini-2.5-pro": {

"name": "Gemini 2.5 Pro",

"limit": {

"context": 1000000,

"output": 65536

}

},

"deepseek-chat": {

"name": "DeepSeek V3",

"limit": {

"context": 64000,

"output": 8192

}

}

}

},

"openrouter": {

"npm": "@ai-sdk/openai-compatible",

"name": "OpenRouter",

"options": {

"baseURL": "https://openrouter.ai/api/v1",

"apiKey": "{env:OPENROUTER_API_KEY}",

"headers": {

"HTTP-Referer": "https://your-site.com",

"X-Title": "OpenCode Client"

}

},

"models": {

"anthropic/claude-sonnet-4": {

"name": "Claude Sonnet 4 (OpenRouter)"

},

"openai/gpt-4o": {

"name": "GPT-4o (OpenRouter)"

}

}

}

},

"model": "apiyi/claude-sonnet-4-20250514",

"small_model": "apiyi/gpt-4o-mini",

"agent": {

"coder": {

"model": "apiyi/claude-sonnet-4-20250514",

"maxTokens": 8000

},

"planner": {

"model": "apiyi/gpt-4o",

"maxTokens": 4000

}

},

"tools": {

"write": true,

"bash": true,

"glob": true,

"grep": true

}

}

Vergleich der von OpenCode unterstützten API-Proxys

Konfigurationsparameter gängiger API-Proxys

| Proxy | baseURL | Besonderheiten | Empfohlene Szenarien |

|---|---|---|---|

| APIYI | https://api.apiyi.com/v1 |

Günstige Preise, schnelle Reaktionszeiten | Erste Wahl für lokale Entwickler |

| OpenRouter | https://openrouter.ai/api/v1 |

Umfassendste Auswahl, 400+ Modelle | Wenn häufiger Modellwechsel nötig ist |

| Together AI | https://api.together.xyz/v1 |

Große Auswahl an Open-Source-Modellen | Llama- und Mistral-Nutzer |

| Groq | https://api.groq.com/openai/v1 |

Extrem schnell, Gratis-Kontingent | Latenzkritische Anwendungen |

APIYI-Konfiguration im Detail

APIYI ist eine für Entwickler optimierte Plattform für AI-API-Proxys und bietet:

- Eine einheitliche, OpenAI-kompatible Schnittstelle

- Unterstützung für Claude, GPT, Gemini, DeepSeek und andere gängige Modelle

- Pay-as-you-go Abrechnung ohne monatliche Grundgebühr

- Gratis-Testguthaben für den Einstieg

- Dedizierten Support

{

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI",

"options": {

"baseURL": "https://api.apiyi.com/v1"

},

"models": {

"claude-sonnet-4-20250514": { "name": "Claude Sonnet 4" },

"claude-opus-4-20250514": { "name": "Claude Opus 4" },

"gpt-4o": { "name": "GPT-4o" },

"gpt-4o-mini": { "name": "GPT-4o Mini" },

"gemini-2.5-pro": { "name": "Gemini 2.5 Pro" },

"deepseek-chat": { "name": "DeepSeek V3" }

}

}

}

}

OpenRouter-Konfiguration im Detail

OpenRouter aggregiert über 400 KI-Modelle und ist ideal, wenn du flexibel zwischen verschiedenen Modellen wechseln möchtest:

{

"provider": {

"openrouter": {

"npm": "@ai-sdk/openai-compatible",

"name": "OpenRouter",

"options": {

"baseURL": "https://openrouter.ai/api/v1",

"apiKey": "{env:OPENROUTER_API_KEY}",

"headers": {

"HTTP-Referer": "https://your-app.com",

"X-Title": "My OpenCode App"

}

},

"models": {

"anthropic/claude-sonnet-4": {

"name": "Claude Sonnet 4"

},

"google/gemini-2.5-pro": {

"name": "Gemini 2.5 Pro"

},

"meta-llama/llama-3.1-405b": {

"name": "Llama 3.1 405B"

}

}

}

}

}

💡 Empfehlung: Wenn du hauptsächlich Claude- und GPT-Modelle nutzt, ist APIYI (apiyi.com) aufgrund der attraktiven Preise und der hohen Geschwindigkeit zu empfehlen. Für spezielle Open-Source- oder Nischenmodelle bietet OpenRouter die beste Abdeckung.

OpenCode Fortgeschrittene Konfigurationstipps

Zuweisungsstrategie für Agent-Modelle

OpenCode verfügt über zwei integrierte Agents, den Coder und den Planner. Sie können diesen unterschiedliche Modelle zuweisen:

{

"agent": {

"coder": {

"model": "apiyi/claude-sonnet-4-20250514",

"maxTokens": 8000,

"description": "Hauptkodierungsaufgaben, verwendet ein leistungsstarkes Modell"

},

"planner": {

"model": "apiyi/gpt-4o-mini",

"maxTokens": 4000,

"description": "Planungsanalyse, verwendet ein leichtgewichtiges Modell zur Kostenersparnis"

}

}

}

Wechsel zwischen mehreren Providern

Sobald mehrere Provider konfiguriert sind, können Sie in OpenCode jederzeit mit dem Befehl /models zwischen ihnen wechseln:

# OpenCode starten

opencode

# In der TUI das Modell wechseln

/models

# Wählen Sie apiyi/claude-sonnet-4-20250514 oder ein anderes Modell aus

Best Practices für Umgebungsvariablen

Es wird empfohlen, API-Keys in einer .env-Datei zu verwalten:

# .env Datei

APIYI_API_KEY=sk-your-apiyi-key

OPENROUTER_API_KEY=sk-or-your-openrouter-key

Referenzieren Sie diese anschließend in der opencode.json:

{

"provider": {

"apiyi": {

"options": {

"apiKey": "{env:APIYI_API_KEY}"

}

}

}

}

Konfiguration von Token-Limits

Legen Sie Kontext- und Ausgabebeschränkungen für Modelle fest, um Fehler durch Limitüberschreitungen zu vermeiden:

{

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4",

"limit": {

"context": 200000,

"output": 65536

}

}

}

}

OpenCode Fehlerbehebung und häufig gestellte Fragen (FAQ)

Hier finden Sie Lösungen für Probleme, die bei der Konfiguration auftreten können:

F1: Fehlermeldung „Route /api/messages not found“ nach der Konfiguration?

Dies liegt in der Regel an einer fehlerhaften baseURL. Überprüfen Sie folgende Punkte:

- Stellen Sie sicher, dass die

baseURLauf/v1endet und nicht auf/v1/chat/completions. - Vergewissern Sie sich, dass das API-Gateway das Standard-OpenAI-Schnittstellenformat unterstützt.

- Überprüfen Sie, ob der API-Key gültig ist.

Richtiges Format:

"baseURL": "https://api.apiyi.com/v1"

Falsches Format:

"baseURL": "https://api.apiyi.com/v1/chat/completions"

Die über APIYI (apiyi.com) bezogenen Schnittstellenadressen sind verifiziert und können direkt verwendet werden.

F2: Fehlermeldung „ProviderModelNotFoundError“ – Modell nicht gefunden?

Dies tritt auf, wenn die konfigurierte Modell-ID nicht mit der im Provider definierten ID übereinstimmt. Lösung:

- Prüfen Sie das Format des Feldes

model:provider-id/model-id - Stellen Sie sicher, dass das Modell im

models-Objekt definiert ist.

Beispiel:

{

"provider": {

"apiyi": {

"models": {

"claude-sonnet-4-20250514": { "name": "Claude Sonnet 4" }

}

}

},

"model": "apiyi/claude-sonnet-4-20250514"

}

F3: Wie überprüfe ich, ob die Konfiguration erfolgreich war?

Verwenden Sie die folgenden Befehle zur Überprüfung:

# Konfigurierte Authentifizierungsinformationen anzeigen

opencode auth list

# Verfügbare Modelle anzeigen

opencode

/models

# Einfachen Dialog testen

opencode -p "Hallo, bitte antworte auf Deutsch"

Wenn Sie eine normale Antwort erhalten, war die Konfiguration erfolgreich. Auf der Plattform APIYI (apiyi.com) können Sie im Dashboard die API-Aufrufprotokolle einsehen, was die Fehlersuche erleichtert.

F4: Wo sollte die Konfigurationsdatei am besten abgelegt werden?

Wählen Sie den Ort je nach Anwendungsszenario:

| Szenario | Empfohlener Pfad | Beschreibung |

|---|---|---|

| Persönlicher globaler Standard | ~/.config/opencode/opencode.json |

Wird von allen Projekten geteilt |

| Projektspezifische Konfiguration | Projekt-Root opencode.json |

Kann in Git eingecheckt werden (ohne Keys) |

| CI/CD-Umgebung | Umgebungsvariable OPENCODE_CONFIG_CONTENT |

Dynamische Injektion der Konfiguration |

F5: Wie wechsle ich in OpenCode zwischen verschiedenen API-Gateways?

Wenn Sie mehrere Provider konfiguriert haben, nutzen Sie den Befehl /models zum Wechseln:

opencode

/models

# Wählen Sie einfach ein Modell unter einem anderen Provider aus

Sie können auch ein Standardmodell in der Konfiguration festlegen:

{

"model": "apiyi/claude-sonnet-4-20250514"

}

OpenCode vs. Claude Code: Vergleich der API-Anbindungsmethoden

| Vergleichsdimension | OpenCode | Claude Code |

|---|---|---|

| Modellunterstützung | 75+ Modelle, frei konfigurierbar | Nur Claude-Serie |

| API-Gateways | Unterstützt jede OpenAI-kompatible Schnittstelle | Keine Unterstützung für benutzerdefinierte Schnittstellen |

| Preis | Kostenlose Software + API Pay-as-you-go | $17-100/Monat Abo + API |

| Konfigurationsmethode | JSON-Konfigurationsdatei + Umgebungsvariablen | Integrierte Konfiguration, nicht änderbar |

| Open-Source-Status | Vollständig Open Source | Closed Source |

| Leistung | Abhängig vom gewählten Modell | Claude native Optimierung, SWE-bench 80.9% |

🎯 Technischer Rat: Der größte Vorteil von OpenCode ist die Modellflexibilität. In Kombination mit dem APIYI (apiyi.com) Gateway können Sie mit derselben Konfiguration zwischen verschiedenen Modellen wie Claude, GPT-4 und Gemini wechseln, um die kosteneffizienteste Lösung zu finden.

Referenzmaterialien

Hier sind einige Referenzmaterialien, die Sie bei der Konfiguration von OpenCode benötigen könnten:

| Material | Link | Beschreibung |

|---|---|---|

| Offizielle OpenCode-Dokumentation | opencode.ai/docs |

Vollständige Konfigurationsreferenz |

| OpenCode GitHub-Repository | github.com/opencode-ai/opencode |

Quellcode und Issues |

| OpenCode Provider-Konfiguration | opencode.ai/docs/providers |

Detaillierte Beschreibung der Provider |

| OpenRouter-Dokumentation | openrouter.ai/docs |

Leitfaden zur OpenRouter-Anbindung |

Fazit

Mit der in diesem Artikel beschriebenen 3-Schritte-Konfiguration haben Sie Folgendes gelernt:

- Installation von OpenCode: Schnelle Installation über ein One-Click-Skript oder einen Paketmanager.

- Konfiguration des API-Schlüssels: Einrichtung der Authentifizierung über

/connectoder Umgebungsvariablen. - Erstellung der Konfigurationsdatei: Schreiben der

opencode.json, um den API-Proxy und das Modell festzulegen.

Als Open-Source-KI-Programmierassistent für das Terminal bietet OpenCode in Kombination mit einem API-Proxy ein Erlebnis, das mit Claude Code vergleichbar ist – bei gleichzeitig kontrollierbaren Kosten und Modellflexibilität.

Wir empfehlen, Ihren API-Schlüssel schnell über APIYI apiyi.com zu beziehen und mit dem Testen zu beginnen. Die Plattform bietet ein kostenloses Kontingent, unterstützt gängige Modelle wie Claude, GPT und Gemini und macht die Konfiguration durch ein einheitliches Schnittstellenformat noch einfacher.

📝 Autor: APIYI-Technikteam | APIYI apiyi.com – Macht den Aufruf von KI-APIs einfacher.