站长注:详解AI API蒸馏技术及其应用,以及如何通过API易平台畅快获取蒸馏所需的API资源,降低成本并提高效率。

在人工智能快速发展的当下,大型语言模型(LLM)的能力令人惊叹,但同时其部署和使用成本也常常令人望而却步。可以说,API蒸馏技术成为了连接高端AI能力与实际应用场景的重要桥梁。本文将详细介绍API蒸馏的概念、方法和优势,并着重分析如何通过API易平台高效进行Deepseek R1等大模型的蒸馏,让您轻松获取蒸馏所需的API资源。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Deepseek R1/V3等全系列模型,畅快进行API蒸馏,不受限制

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

API蒸馏背景介绍

API蒸馏是一种基于知识蒸馏技术的特殊应用,它允许开发者通过调用大型语言模型的API接口来获取其输出,然后用这些输出来训练一个更小、更高效的模型。这种方法使得即使没有大模型的完整参数和架构,也能够”提取”其核心能力。

知识蒸馏的基本原理

知识蒸馏(Knowledge Distillation)最早由Hinton等人在2015年提出,其核心思想是将”教师模型”(通常是复杂度高、参数量大的模型)的知识转移到”学生模型”(通常是更小、更轻量级的模型)中。这一过程主要通过以下方式实现:

- 软标签学习:学生模型不仅学习硬标签(正确答案),还学习教师模型的概率分布(软标签)

- 蒸馏温度:通过调整温度参数控制软标签的”软硬程度”

- 联合优化:同时优化对真实标签的预测和对教师模型输出的模仿

在传统的知识蒸馏中,研究者需要完全访问教师模型的参数和架构。而API蒸馏则突破了这一限制,使得只要能够调用API,就可以进行知识迁移。

API蒸馏的特点与意义

API蒸馏具有以下几个显著特点:

- 黑盒访问:仅通过API接口与大模型交互,无需了解其内部结构

- 数据驱动:通过构造大量有代表性的输入样本,收集大模型的输出作为训练数据

- 定制灵活:可以针对特定领域或任务进行定向蒸馏

- 降低依赖:蒸馏完成后可脱离原API独立运行

这种技术的出现,为AI的民主化和普及提供了重要支持,使得更多开发者和企业能够以更低的成本获取大模型的能力。

API蒸馏核心方法

要成功实施API蒸馏,需要遵循一系列系统性步骤和方法。下面将详细介绍这一过程:

数据准备与设计

API蒸馏的第一步是精心设计和准备用于查询大模型的数据:

- 多样化输入:构造覆盖目标应用场景的多样化输入

- 领域定制:根据具体应用领域设计专业性的查询

- 提示工程:设计有效的提示(prompts)以获取高质量输出

- 数据增强:通过变换和重组扩充数据集

高质量的数据设计对蒸馏效果至关重要,它决定了学生模型能够获取到多少教师模型的知识。

API调用策略

在实际进行API蒸馏时,API调用策略直接关系到效率和成本:

- 批量处理:尽可能使用批处理减少API调用次数

- 错误处理:建立健壮的错误重试和处理机制

- 速率控制:根据API服务提供商的限制调整调用频率

- 并行请求:在允许的情况下并行发送请求提高效率

- 成本优化:在保证数据多样性的前提下优化API调用成本

一个好的API调用策略可以在确保数据质量的同时,显著降低蒸馏过程的时间和成本。

学生模型设计与训练

收集到教师模型的输出后,下一步是设计并训练学生模型:

- 模型选择:根据应用场景和资源限制选择合适的模型架构

- 优化目标:设计合适的损失函数,平衡对教师模型的模仿和对真实标签的预测

- 训练策略:采用分阶段训练、渐进式蒸馏等高级技术

- 评估方法:建立全面的评估体系,比较学生模型与教师模型的性能差距

学生模型的设计应该根据实际的部署环境和性能要求进行调整,在模型大小和效果之间找到平衡点。

API蒸馏应用场景

API蒸馏技术在多个领域都有广泛的应用前景,下面列举几个典型场景:

企业级应用定制

企业可以通过API蒸馏为特定业务场景定制AI能力:

- 客服自动化:蒸馏适合企业特定产品和服务的客服机器人

- 内部知识库:基于企业内部资料蒸馏专业领域知识问答系统

- 行业专家系统:针对特定行业的专业知识进行蒸馏

这种方式使企业能够在保护数据隐私的同时,获得定制化的AI能力。

移动端与边缘计算

API蒸馏使得将大模型能力迁移到资源受限设备成为可能:

- 移动APP内置AI:将大模型蒸馏后嵌入移动应用

- 离线智能设备:为物联网设备提供离线AI能力

- 实时交互应用:降低延迟,提升用户体验

这对于需要实时响应或离线工作的场景尤为重要。

特定语言与领域适应

针对小语种或特定专业领域,API蒸馏可以提供定向优化:

- 小语种模型:对小语种进行专门优化的轻量级模型

- 专业领域优化:医学、法律、金融等专业领域的领域适应

- 方言与地域适应:针对特定地域的语言特点进行优化

这使得AI能够更好地服务于多样化的语言和文化环境。

使用API易进行Deepseek R1和V3蒸馏

API易平台作为国内领先的AI大模型聚合服务平台,为API蒸馏提供了理想的基础设施和资源。特别是对于Deepseek R1和Deepseek V3等高性能模型的蒸馏,API易平台具有显著优势。

API易蒸馏优势

在API蒸馏领域,API易平台相比其他服务提供商具有以下独特优势:

- 无限制调用:不设置API调用频率限制,允许大批量、高频率请求

- 稳定可靠:多节点部署,确保API服务的稳定性和可靠性

- 透明定价:按量计费,无隐藏费用,成本可控

- 模型丰富:提供Deepseek R1/V3、Claude、GPT等多种顶级模型

- 一站式服务:一个API密钥访问多种模型,方便比较不同模型蒸馏效果

这些优势使得研究者和开发者能够更加高效、经济地进行API蒸馏实验和项目。

Deepseek R1蒸馏实践

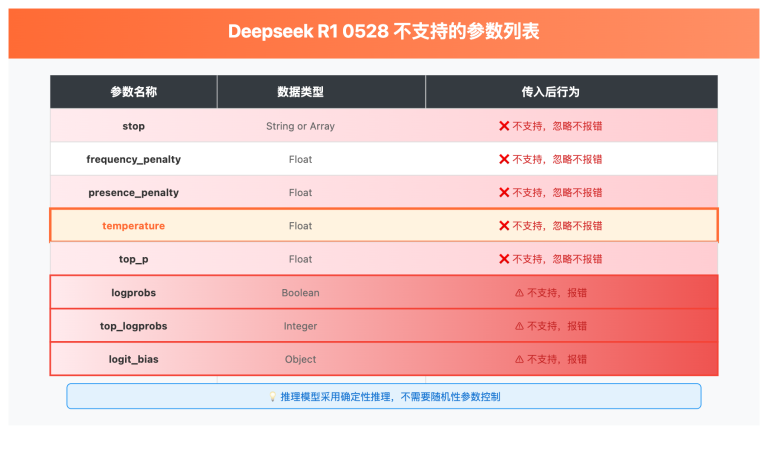

Deepseek R1(即deepseek-reasoner)作为一款专注于推理能力的大模型,其蒸馏过程具有一些特殊考量:

- 多步推理问题构造:

- 设计数学、逻辑、代码等多步推理问题

- 确保问题覆盖不同难度和推理深度

- 收集R1的详细推理过程,而非仅收集最终答案

- 思维链数据提取:

- 使用”思维链”(Chain-of-Thought)提示

- 提取模型的推理步骤和中间思考过程

- 让学生模型学习推理路径而非结果

- 实际案例:某AI研究团队通过API易平台对Deepseek R1进行蒸馏,成功将其核心推理能力压缩到原始模型1/10的规模,在特定数学推理任务上保持了90%的性能。团队表示:”API易平台的无限制调用极大加速了我们的实验进度,使得蒸馏周期从预计的3个月缩短到了不到1个月。”

Deepseek V3蒸馏实践

Deepseek V3(即deepseek-chat)作为一款更通用的对话模型,其蒸馏过程也有独特之处:

- 多样化对话场景:

- 构造涵盖日常对话、知识问答、创意写作等多种场景

- 设计多轮对话收集上下文理解能力

- 考虑不同语言风格和表达方式

- 指令遵循能力:

- 特别关注模型对各类指令的理解和执行能力

- 收集对复杂、模糊指令的解释和澄清过程

- 设计对抗性样本测试边界情况

- 实际案例:一家教育科技公司利用API易平台对Deepseek V3进行蒸馏,成功开发了适用于特定教育场景的轻量级AI辅导模型。该模型部署在学生的平板设备上,无需联网即可提供专业的学习指导。公司CTO表示:”通过API易高效获取蒸馏数据,我们不仅大幅降低了开发成本,还显著提升了产品的用户体验。”

API蒸馏实施步骤

如果您打算利用API易平台进行API蒸馏,以下是一个详细的实施步骤指南:

步骤一:准备工作

- 注册API易账号:

- 访问API易官网注册账号

- 获取API密钥,用于后续API调用

- 确定蒸馏目标:

- 明确蒸馏的具体目标和应用场景

- 选择合适的教师模型(如Deepseek R1、V3等)

- 确定学生模型的大小和架构

- 准备蒸馏环境:

- 设置Python环境和必要的库

- 准备数据存储和处理环境

- 确保有足够的计算资源用于训练学生模型

步骤二:数据收集

- 设计输入数据:

- 根据目标应用场景设计多样化的输入样本

- 考虑边界情况和挑战性样本

- 构建结构化的数据集,便于后续处理

- API调用:

import requests import json API_KEY = "your_apiyi_api_key" API_URL = "https://vip.apiyi.com/v1/chat/completions" headers = { "Content-Type": "application/json", "Authorization": f"Bearer {API_KEY}" } def get_model_response(prompt, model="deepseek-reasoner"): data = { "model": model, "messages": [{"role": "user", "content": prompt}], "temperature": 0.7 } response = requests.post(API_URL, headers=headers, json=data) return response.json() # 批量处理示例 prompts = ["计算 125 * 37 的结果并解释步骤", "分析下面这个Python函数的时间复杂度..."] responses = [get_model_response(prompt) for prompt in prompts] # 保存结果 with open("distillation_data.json", "w") as f: json.dump(responses, f, ensure_ascii=False, indent=4) - 数据预处理:

- 清洗和格式化API返回的数据

- 提取有价值的部分用于训练

- 进行必要的数据增强和标准化

步骤三:学生模型训练

- 模型构建:

import torch from transformers import AutoModelForCausalLM, AutoTokenizer, Trainer, TrainingArguments # 加载预训练的小模型作为起点 model_name = "distilgpt2" # 或其他适合的小模型 tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name) # 准备训练数据 # 这里需要根据前面收集的数据进行处理 # 设置训练参数 training_args = TrainingArguments( output_dir="./distilled_model", per_device_train_batch_size=8, num_train_epochs=3, save_steps=1000, save_total_limit=2, ) # 开始训练 trainer = Trainer( model=model, args=training_args, train_dataset=train_dataset, tokenizer=tokenizer, ) trainer.train() model.save_pretrained("./final_distilled_model") - 评估和优化:

- 对比学生模型和教师模型在测试集上的表现

- 分析差距并针对性地调整训练策略

- 进行多轮迭代优化,直到达到预期目标

- 模型压缩与优化:

- 应用量化、剪枝等技术进一步压缩模型

- 优化推理速度和资源占用

- 针对部署环境进行特定优化

步骤四:部署与应用

- 模型导出:

- 将训练好的模型导出为适合部署的格式

- 进行必要的转换和优化

- 集成应用:

- 将蒸馏后的模型集成到目标应用中

- 开发必要的接口和服务

- 监控与更新:

- 建立监控机制跟踪模型性能

- 收集用户反馈,持续改进

- 必要时进行增量蒸馏更新

API蒸馏常见问题解答

技术问题

问题:如何评估蒸馏效果?

评估蒸馏效果可以从多个维度进行:

- 性能对比:在相同测试集上比较学生模型与教师模型的性能差距

- 任务特定评估:针对具体任务设计专门的评估指标

- 资源效率:对比推理速度、内存占用等资源指标

- 用户体验:进行A/B测试评估实际用户体验的差异

理想情况下,一个成功的蒸馏应当在显著减小模型体积的同时,保持较高的任务性能。

问题:蒸馏过程中常见的陷阱有哪些?

API蒸馏过程中的常见陷阱包括:

- 数据不均衡:输入数据覆盖不全面,导致学生模型能力片面

- 过拟合教师:过度模仿教师模型的结果,包括其错误和偏见

- 忽视边界情况:没有足够测试模型在边界情况的表现

- 架构不匹配:学生模型架构不适合学习教师模型的能力

- 评估不全面:仅使用简单指标评估,忽视实际应用中的关键要素

避免这些陷阱需要在设计阶段充分考虑,并在实施过程中不断调整和优化。

问题:如何平衡API调用成本和蒸馏效果?

平衡API调用成本和蒸馏效果的策略:

- 主动学习:优先选择最有信息量的样本进行API调用

- 分阶段蒸馏:先用少量数据进行初步蒸馏,再针对性补充

- 自举策略:使用早期蒸馏的模型生成部分数据,减少API调用

- 数据增强:通过变换已有数据创造更多训练样本

- 领域聚焦:将蒸馏范围限定在特定领域,提高效率

在API易平台上,由于提供了更经济的API调用价格和不限频率的访问,这一平衡更容易实现。

API易相关问题

问题:API易对大规模API调用有什么优势?

API易平台在大规模API调用方面具有以下优势:

- 不限速调用:无频率限制,支持高并发请求

- 多节点部署:确保服务的稳定性和可用性

- 透明计费:按实际使用量计费,无隐藏费用

- 批量处理:支持批量请求,提高效率

- 丰富的模型:一个平台可以蒸馏多种模型,便于比较

这些特点使得API易成为进行API蒸馏的理想平台,尤其适合需要大量API调用的项目。

问题:在API易平台上进行蒸馏需要多少费用?

费用主要取决于以下因素:

- 数据规模:需要生成的训练数据量

- 模型选择:不同模型的价格有所不同(Deepseek R1一般比大多数模型略贵)

- 迭代次数:优化过程中的实验次数

- 使用时段:API易不同时段可能有不同优惠策略

一个参考估算:针对中等规模的特定领域蒸馏,生成10万条训练数据,大约需要500-2000美元不等,具体取决于所选模型和输入/输出长度。

相较于从零训练模型或直接长期使用API,蒸馏后的模型在长期使用中能显著降低总体成本。

问题:API易支持哪些模型的蒸馏?

API易平台支持多种顶级模型的蒸馏:

- Deepseek系列:Deepseek R1(推理模型)、Deepseek V3(对话模型)

- OpenAI系列:GPT-4o、GPT-3.5等

- Anthropic系列:Claude 3.5 Sonnet等

- Google系列:Gemini 1.5、Gemini 2.0等

- 阿里系列:Qwen系列模型

- x.ai系列:Grok系列模型

每种模型都有其独特的能力和特点,可以根据蒸馏的具体目标选择最合适的教师模型。

为什么选择 API易 进行AI API蒸馏

- 无限制调用

- 不设置频率限制,满足大规模蒸馏需求

- 并发请求支持,加速数据收集过程

- 批量处理能力,提高效率

- 稳定可靠的资源供给

- 解决模型官方平台充值受限问题

- 确保稳定的模型供给

- 无需担心额度用尽问题

- 丰富的模型选择

- Deepseek系列全覆盖(R1、V3)

- 多种顶级模型一站式提供

- 便于对比不同模型的蒸馏效果

- 经济实惠

- 透明定价策略

- 新用户免费额度

- 大规模调用更具成本优势

- 技术支持

- API蒸馏专业咨询

- 7×24小时技术支持

- 定制化解决方案

提示:以蒸馏项目为例,通过API易可以:

- 不受API调用频率限制,加速蒸馏数据收集

- 一个平台尝试多种顶级模型作为教师

- 享受更经济的调用价格,降低蒸馏成本

- 获得专业的技术支持和解决方案

总结

API蒸馏技术为人工智能的普及和定制化应用提供了强大的支持,使得更多开发者和企业能够以更低的成本获取大模型的能力。在这一过程中,API易平台以其无限制调用、稳定可靠的服务、丰富的模型选择和经济实惠的价格,成为进行API蒸馏的理想选择。

特别是对于Deepseek R1和V3等高端模型的蒸馏,API易平台提供了畅通无阻的API资源,解决了调用频率限制、不稳定供给等常见问题,让研究者和开发者能够专注于蒸馏本身,而非API调用的技术难题。

随着API蒸馏技术的不断发展和完善,我们有理由相信,更多定制化、轻量级、高性能的AI应用将会涌现,为各行各业带来更大的价值和变革。而API易平台也将继续为这一进程提供强有力的基础设施支持。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Deepseek R1/V3等全系列模型,畅享无限制API蒸馏体验

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。