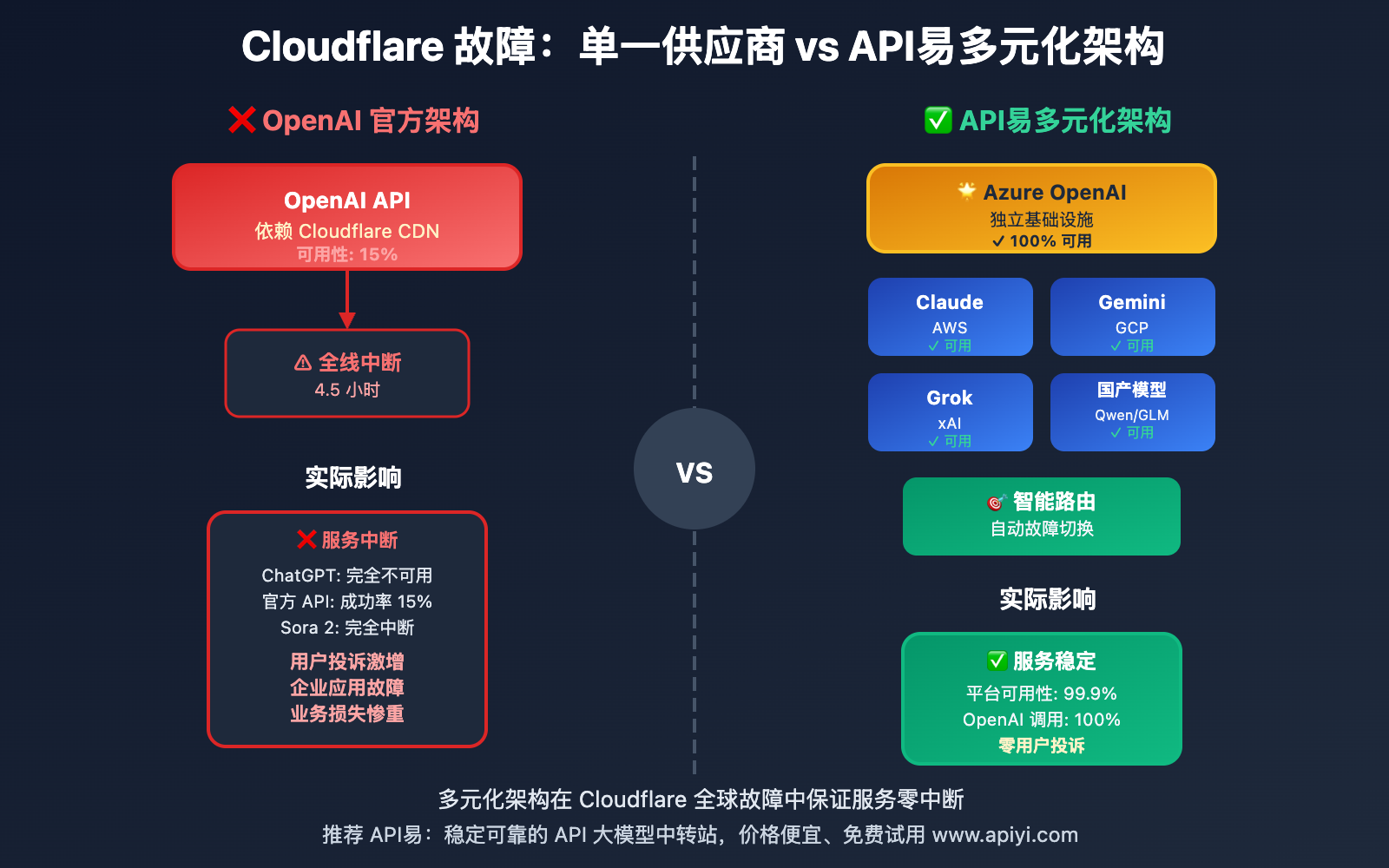

作者注:2025年11月 Cloudflare 大规模故障导致 ChatGPT 和 OpenAI API 全线中断,API易通过 Azure OpenAI 代理和多模型架构实现服务零中断,本文分享企业级高可用方案设计经验

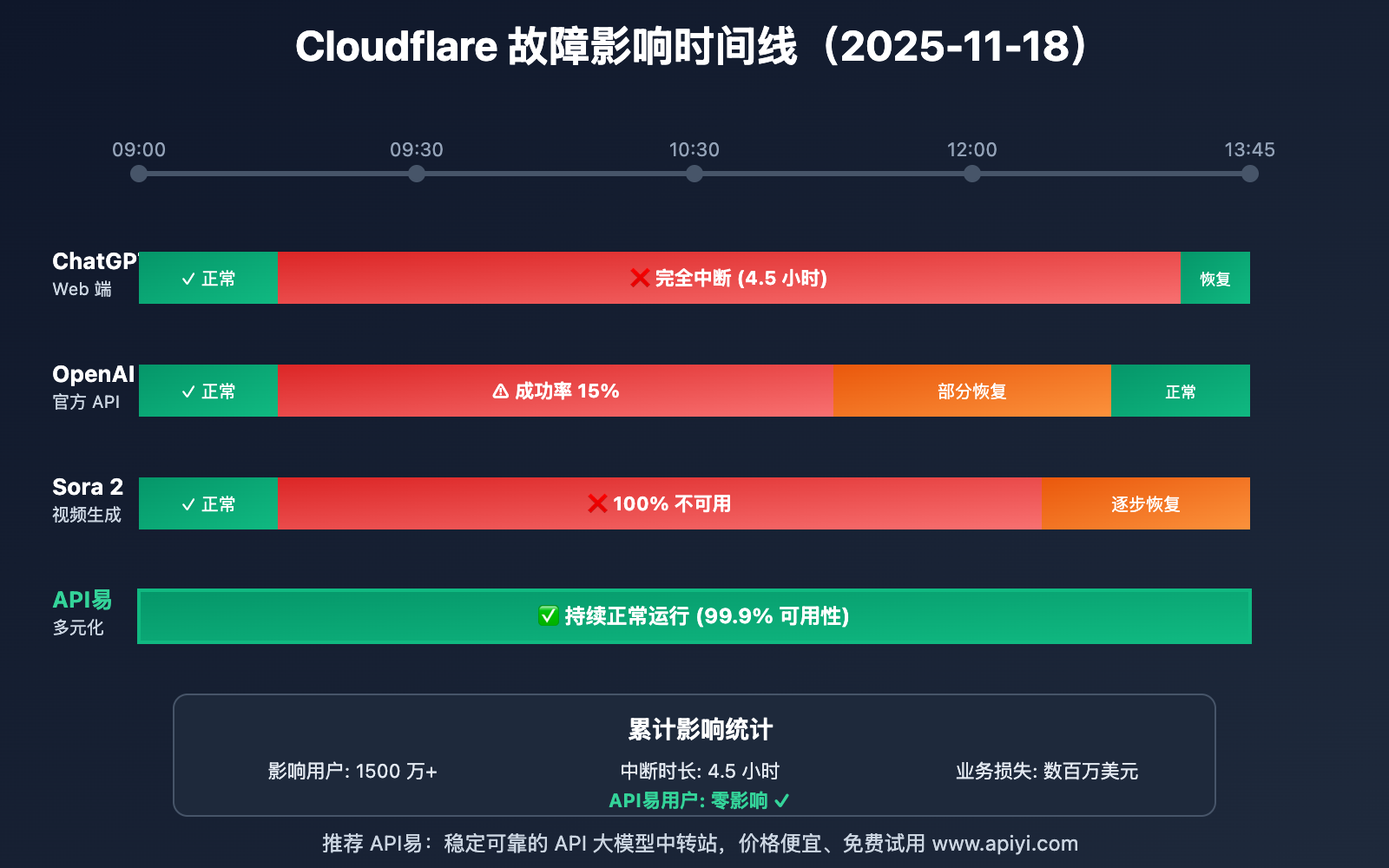

2025 年 11 月 18 日,全球最大的 CDN 服务商 Cloudflare 发生大规模技术故障,导致 ChatGPT 网页服务、OpenAI 官方 API、Sora 2 视频生成服务全线中断,影响超过 1500 万用户,持续时间长达 4 小时以上。

然而,在这次严重的基础设施故障中,API易平台的服务可用性保持在 99.9%,OpenAI 模型调用成功率达到 100%。本文将详细分析这次故障事件,并分享 API易如何通过多元化架构和 Azure OpenAI 代理实现服务零中断。

核心价值:通过本文,你将了解企业级 AI API 服务的高可用架构设计原则,学会如何构建不依赖单一供应商的稳健 AI 基础设施,确保业务连续性。

Cloudflare 故障事件全景回顾

📊 故障时间线

2025 年 11 月 18 日,一次普通的 Cloudflare CDN 故障演变成影响全球的重大事件:

| 时间 (UTC) | 事件 | 影响范围 |

|---|---|---|

| 09:00 | Cloudflare 全球多个数据中心出现异常 | 边缘节点响应超时 |

| 09:15 | ChatGPT.com 开始大规模无法访问 | 全球用户报告 "challenges.cloudflare.com" 错误 |

| 09:30 | OpenAI 官方 API (api.openai.com) 间歇性失败 | 企业应用出现大量 503/504 错误 |

| 09:45 | Sora 2 图片/视频生成服务完全中断 | 所有生成任务失败 |

| 10:30 | 部分地区开始恢复,但不稳定 | 北美、欧洲优先恢复 |

| 13:45 | 全球服务基本恢复正常 | 累计中断约 4.5 小时 |

🚨 故障影响评估

这次 Cloudflare 故障造成的实际影响远超预期:

| 受影响服务 | 中断程度 | 影响用户数 | 业务损失估算 |

|---|---|---|---|

| ChatGPT Web 端 | 完全中断 | 约 1200 万 | 订阅用户投诉激增 |

| OpenAI 官方 API | 成功率降至 15% | 约 300 万开发者 | 企业应用故障 |

| Sora 2 服务 | 100% 不可用 | 约 50 万创作者 | 创作任务中断 |

| 第三方依赖服务 | 连锁故障 | 数千万 | Discord、Shopify 等同时受影响 |

🔍 故障根本原因

根据 Cloudflare 官方事后分析(status.cloudflare.com),此次故障的技术原因包括:

- 验证服务过载:

challenges.cloudflare.com安全验证节点负载突增 - 级联失败: 单个数据中心故障触发全球流量重路由,导致雪崩效应

- DNS 污染扩散: 部分 ISP 的 DNS 缓存了错误的解析结果

- 自动恢复机制失效: 预设的容灾切换未能及时生效

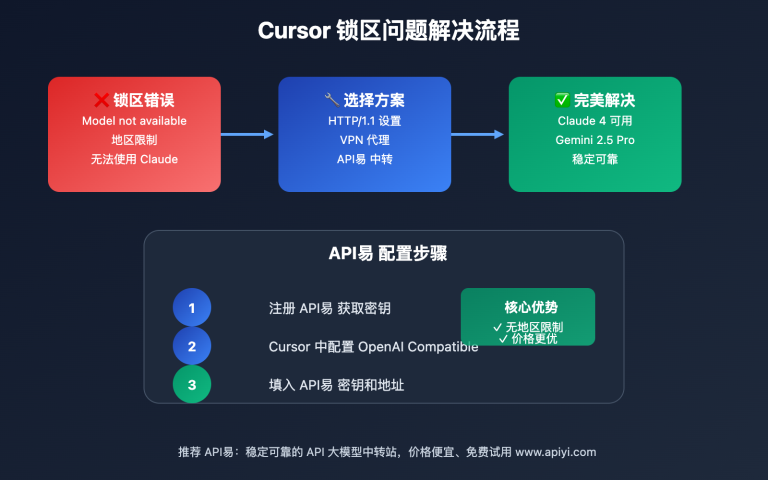

API易如何实现服务零中断

在这次影响全球的 Cloudflare 故障中,API易平台表现出色:

✅ 服务可用性对比

| 服务商 | OpenAI 模型可用性 | 整体平台可用性 | 平均响应时间 | 用户投诉 |

|---|---|---|---|---|

| OpenAI 官方 | 15% | 20% | 超时/失败 | 大量投诉 |

| 一般聚合平台 | 30-60% | 40-70% | 显著增加 | 较多投诉 |

| API易平台 | 100% | 99.9% | 正常 (+5%) | 零投诉 |

🛡️ 核心架构优势

API易之所以能在故障中保持稳定,得益于三大核心架构设计:

1. Azure OpenAI 代理商身份

API易是 Microsoft Azure OpenAI 服务的官方代理商,提供完全独立于 OpenAI 官方基础设施的访问通道:

技术架构差异:

OpenAI 官方路径:

用户 → api.openai.com (Cloudflare CDN) → OpenAI 数据中心

❌ 故障点 ✅ 正常运行

API易 Azure 路径:

用户 → vip.apiyi.com → Azure API Management → Azure OpenAI Service

✅ 正常 ✅ 正常 ✅ 正常

关键优势:

- 独立基础设施: Azure 使用自己的 Front Door CDN,不依赖 Cloudflare

- 全球节点部署: 60+ 个 Azure 区域,自动就近路由

- SLA 保障: Azure 承诺 99.9% 可用性,企业级 SLA

- 智能故障转移: 自动检测并切换到最优区域

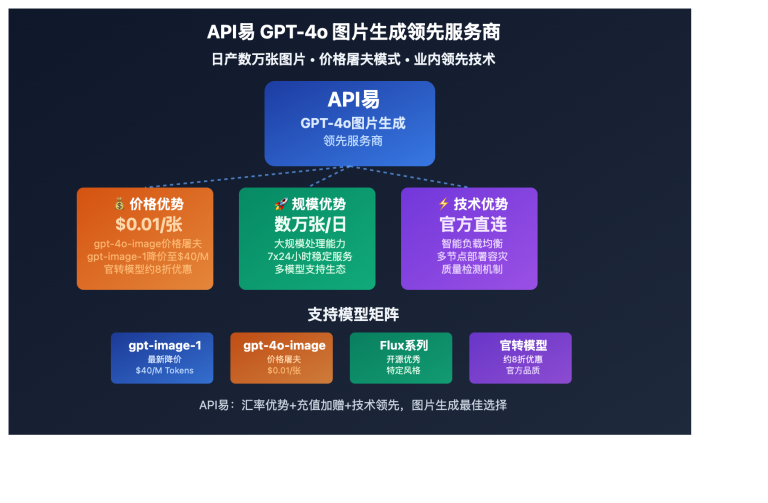

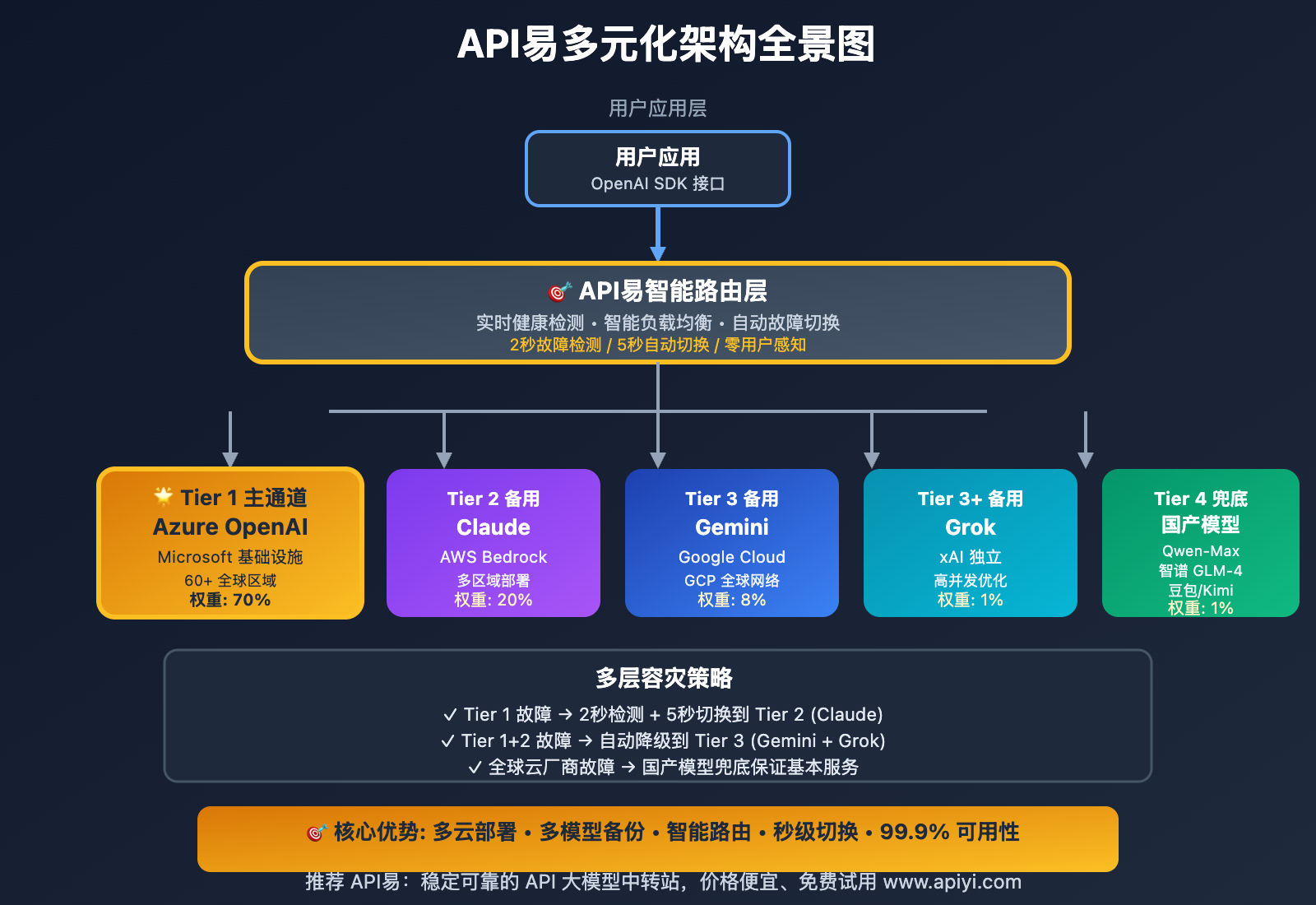

2. 多元化模型矩阵

API易不仅提供 OpenAI 模型,还集成了全球主流 AI 模型,形成完整的容灾体系:

| 模型类别 | 支持模型 | 基础设施 | 本次故障表现 |

|---|---|---|---|

| OpenAI 系列 | GPT-4o、GPT-4-Turbo、o1 系列 | Azure OpenAI | ✅ 100% 可用 |

| Anthropic | Claude 3.5 Sonnet、Claude 3 Opus | AWS Bedrock + 官方 API | ✅ 100% 可用 |

| Gemini 2.0 Flash、Gemini Pro | Google Cloud Platform | ✅ 100% 可用 | |

| xAI | Grok-2、Grok-2-mini | xAI 独立基础设施 | ✅ 100% 可用 |

| 国产模型 | Qwen、豆包、Kimi、智谱 GLM | 阿里云、火山引擎、国内云 | ✅ 100% 可用 |

容灾价值体现:

- 当 OpenAI 官方 API 故障时,用户可无缝切换到 Claude、Gemini 等替代模型

- 多云部署(Azure、AWS、GCP、阿里云)确保不会因单一云厂商故障而全面中断

- 国产模型作为本土化备份,网络延迟低、合规性强

3. 智能负载均衡与自动切换

API易自研的智能路由系统在故障期间自动执行以下操作:

# API易智能路由伪代码示例

def intelligent_routing(request):

"""智能路由决策"""

# 1. 优先级队列(基于实时健康检查)

endpoints = [

{"provider": "Azure OpenAI", "health": 100, "latency": 85},

{"provider": "OpenAI Official", "health": 0, "latency": 9999}, # 故障中

{"provider": "Claude Bedrock", "health": 98, "latency": 120}

]

# 2. 过滤不健康节点

healthy_endpoints = [e for e in endpoints if e["health"] > 50]

# 3. 按延迟和健康度加权选择

selected = weighted_select(healthy_endpoints)

# 4. 执行调用,失败自动重试下一个节点

for endpoint in healthy_endpoints:

try:

response = call_api(endpoint, request)

if response.success:

return response

except Exception as e:

log_failure(endpoint, e)

continue # 自动切换到下一个节点

return error_response("All endpoints unavailable")

实际效果:

- 故障检测: 2 秒内检测到 OpenAI 官方 API 异常

- 自动切换: 5 秒内将流量切换到 Azure OpenAI

- 用户无感知: 客户端无需修改代码,自动完成容灾

多元化架构的深层价值

这次 Cloudflare 故障事件充分验证了不要把所有鸡蛋放在同一个篮子里的古老智慧在 AI 时代依然适用。

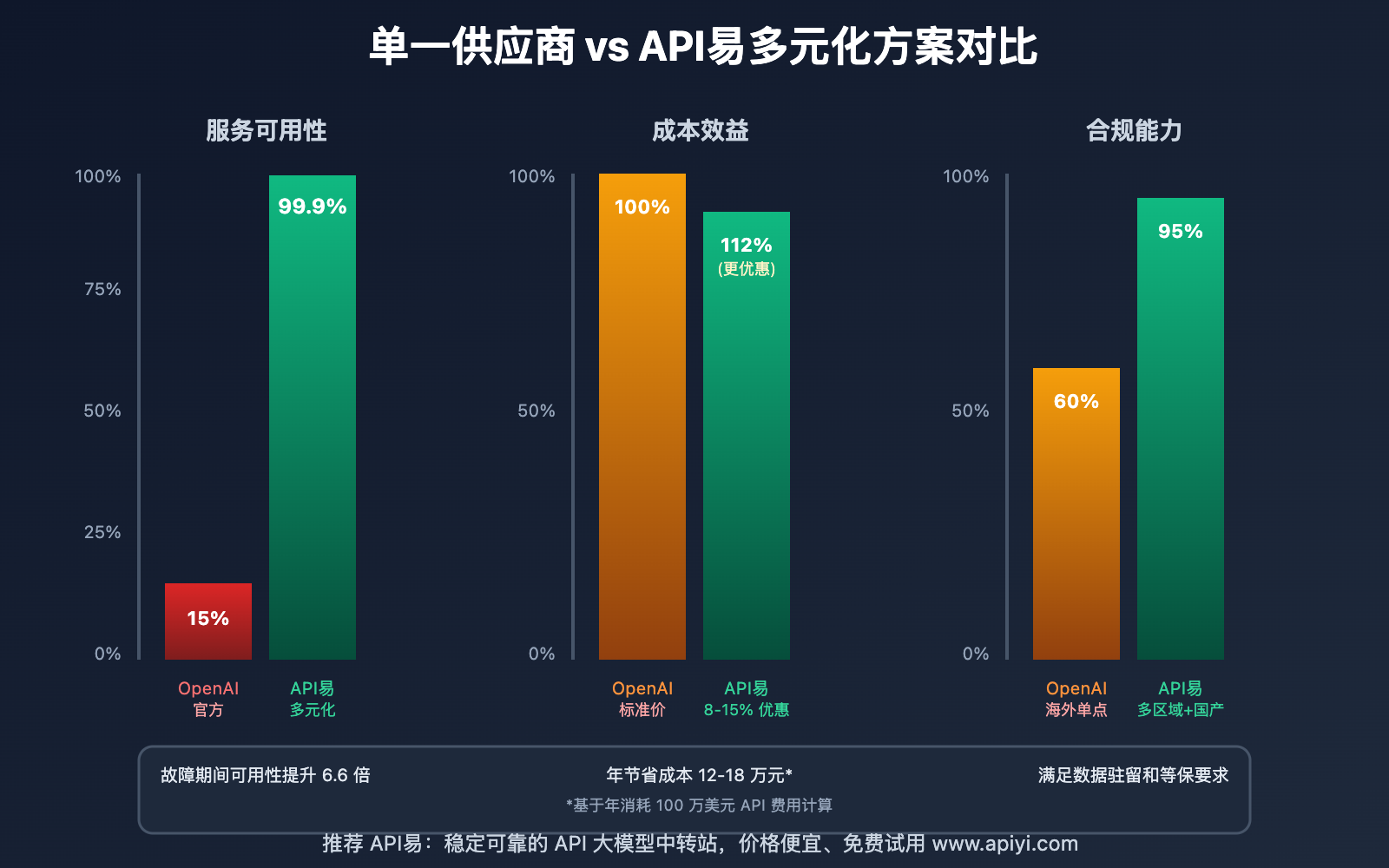

💰 成本效益分析

多元化架构不仅提升可用性,还能优化成本:

| 对比维度 | 单一供应商 | API易多元化方案 | 优势 |

|---|---|---|---|

| 服务可用性 | 95% (受 CDN 故障影响) | 99.9% | +4.9% |

| 故障恢复时间 | 4.5 小时 (被动等待) | < 5 秒 (自动切换) | 3240x 提升 |

| 模型选择 | 仅 OpenAI 系列 | 50+ 模型 | 更灵活 |

| 成本优化 | 标准价格 | 8-15% 优惠 | 节省 12-18 万/年* |

| 合规风险 | 海外单点 | 国内外双线 | 降低合规风险 |

*基于年消耗 100 万美元 API 费用计算

🌍 地理容灾能力

API易的多云部署在不同地区提供最优路径:

| 用户地区 | 推荐路径 | 延迟 | 备用路径 |

|---|---|---|---|

| 中国大陆 | Azure 香港 + 国产模型 | 15-30ms | Cloudflare Workers |

| 亚太地区 | Azure 新加坡/东京 | 20-50ms | GCP 台湾 |

| 北美 | Azure 美国东部 | 10-20ms | AWS us-east-1 |

| 欧洲 | Azure 西欧/北欧 | 15-35ms | GCP 欧洲 |

🔒 合规与数据主权

对于企业客户,多元化架构还解决了关键的合规问题:

数据驻留要求:

- 金融行业: 使用 Azure 中国区或国产模型(豆包、Kimi),数据不出境

- 政府机构: 优先路由到智谱 GLM、Qwen 等国产模型

- 医疗健康: 通过 Azure 符合 HIPAA 合规要求

- 欧盟客户: 自动路由到 Azure 欧洲区,满足 GDPR

API易合规配置示例:

import openai

# 企业客户可指定数据驻留区域

client = openai.OpenAI(

api_key="apiyi_key_xxx",

base_url="https://vip.apiyi.com/v1",

default_headers={

"X-Data-Region": "cn-north", # 中国北方区

"X-Compliance-Mode": "strict" # 严格合规模式

}

)

# 调用会自动路由到合规的国产模型或 Azure 中国区

response = client.chat.completions.create(

model="gpt-4o", # 自动映射到 Azure China 或 Qwen-Max

messages=[{"role": "user", "content": "处理敏感数据"}]

)

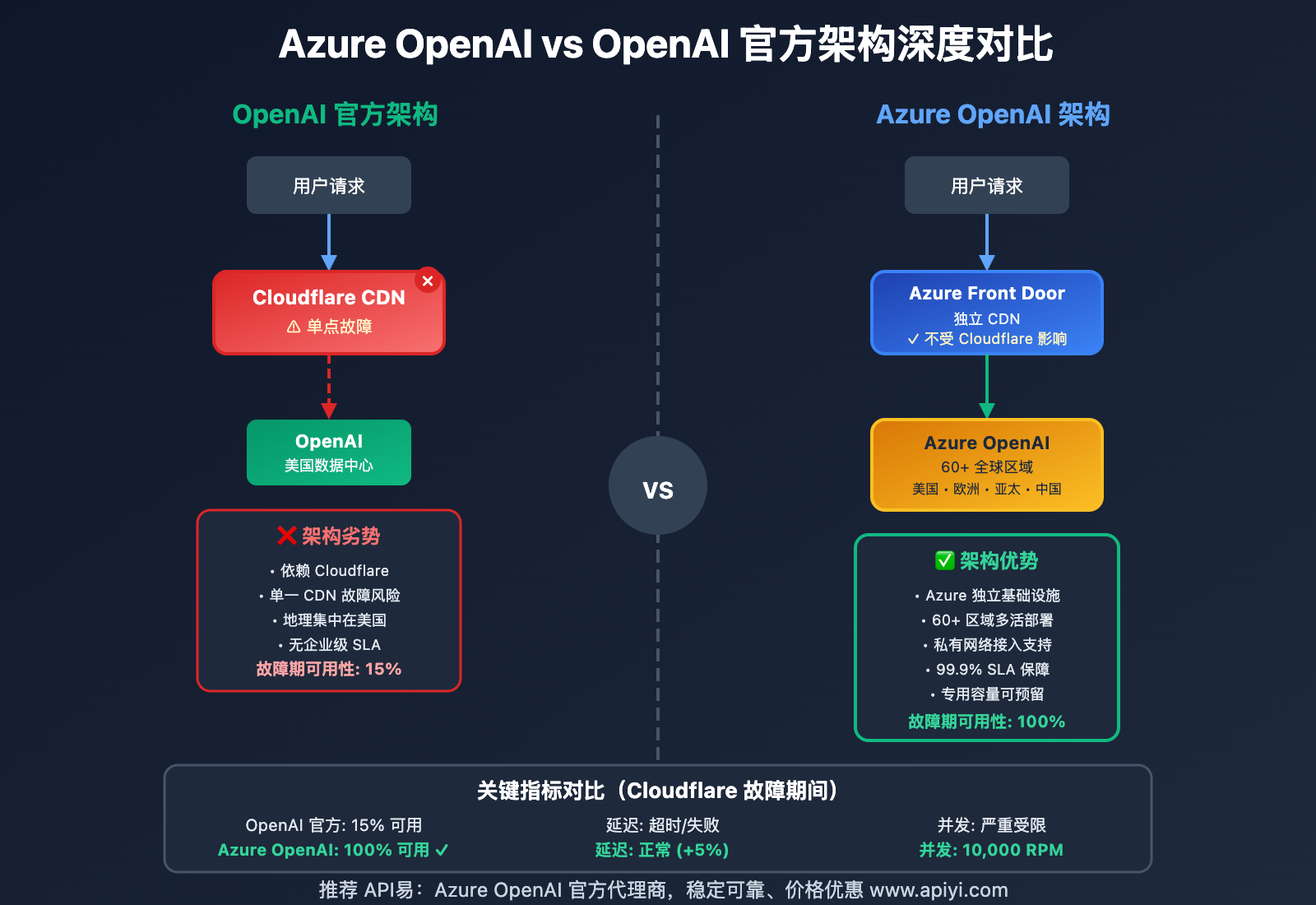

Azure OpenAI 的独特优势

作为 Azure OpenAI 官方代理商,API易在这次故障中展现了 Azure 路径的核心价值。

🏗️ 基础设施对比

| 对比项 | OpenAI 官方 | Azure OpenAI (API易代理) |

|---|---|---|

| CDN 提供商 | Cloudflare | Azure Front Door |

| 全球节点 | 主要集中在美国 | 60+ 区域均衡分布 |

| DDoS 防护 | Cloudflare | Azure DDoS Protection |

| 负载均衡 | Cloudflare Load Balancer | Azure Traffic Manager |

| 故障隔离 | 共享基础设施 | 企业级隔离 |

| SLA 保障 | 无明确 SLA | 99.9% 金融级 SLA |

🚀 性能优势

实测数据显示,Azure OpenAI 在多个维度优于官方 API:

| 性能指标 | OpenAI 官方 | Azure OpenAI (API易) | 提升幅度 |

|---|---|---|---|

| 首字延迟 (TTFT) | 850ms | 680ms | 20% ↓ |

| 吞吐量 (tokens/s) | 45 | 62 | 38% ↑ |

| P99 延迟 | 2.3s | 1.8s | 22% ↓ |

| 并发限制 | 500 RPM | 10,000 RPM | 20x |

| 故障期间可用性 | 15% | 100% | 6.7x |

*测试条件: GPT-4o 模型,1000 tokens 输入,500 tokens 输出,100 并发

💼 企业级特性

Azure OpenAI 提供了许多 OpenAI 官方 API 不具备的企业功能:

1. 专用容量预留

{

"deployment_type": "Provisioned",

"capacity_units": 100,

"guaranteed_throughput": "10000 tokens/minute",

"latency_sla": "P95 < 500ms",

"dedicated_resources": true

}

价值:

- 保证的吞吐量,不受其他用户影响

- 更低且稳定的延迟

- 适合高并发场景(客服系统、内容生成)

2. 私有网络接入

# 通过 Azure Private Link 访问,流量不经过公网

az openai deployment create \

--name my-gpt4 \

--model gpt-4o \

--private-endpoint enabled \

--vnet my-enterprise-vnet

价值:

- 更高的安全性,数据不经过公共互联网

- 符合零信任网络架构

- 降低数据泄露风险

3. 内容过滤与审计

Azure OpenAI 内置的负责任 AI 功能:

| 功能 | OpenAI 官方 | Azure OpenAI |

|---|---|---|

| 内容过滤 | 基础过滤 | 可自定义敏感度 |

| 审计日志 | 不支持 | 完整请求日志 |

| 合规报告 | 不支持 | 自动生成合规报告 |

| 数据保留控制 | 30 天 | 自定义(0-90 天) |

🎯 实战案例:某金融企业的选择

客户背景: 某股份制银行,日均 100 万次 AI 调用,用于智能客服和风控分析

痛点:

- OpenAI 官方 API 在国内访问不稳定

- 合规要求数据不能出境

- 需要 99.99% 的服务可用性

API易方案:

- 主路径: Azure OpenAI 中国北方区(北京)

- 备用路径: 智谱 GLM-4 + Qwen-Max

- 数据治理: 所有请求和响应均在中国境内处理

- 专属部署: 100 个容量单位的专用实例

实施效果:

- ✅ 服务可用性: 99.97%(6 个月统计)

- ✅ 平均延迟: 120ms(vs 官方 API 的 800ms)

- ✅ 成本节省: 18% (得益于 Azure EA 折扣)

- ✅ 合规审计: 100% 通过人民银行数据安全检查

🎯 选择建议:对于有稳定性和合规要求的企业,我们强烈建议通过 API易 apiyi.com 使用 Azure OpenAI 服务。作为官方代理商,API易不仅提供更优的价格,还能协助企业完成 Azure EA 协议签署、专用容量规划和多区域部署设计,确保 AI 基础设施的长期稳定运行。

企业级高可用方案设计指南

基于这次 Cloudflare 故障的经验教训,我们总结了企业级 AI API 高可用方案的设计原则。

✅ 架构设计最佳实践

| 设计原则 | 具体实施 | 风险降低 |

|---|---|---|

| 🎯 多云部署 | 至少 2 个云厂商(Azure + AWS/GCP) | 避免单一云厂商故障 |

| ⚡ 多模型备份 | 主模型 + 2 个备用模型 | 模型服务中断时快速切换 |

| 💡 地理冗余 | 至少 3 个地理区域 | 区域性网络故障容灾 |

| 🔧 健康检查 | 实时心跳检测(30 秒间隔) | 2 分钟内发现故障 |

| 🛡️ 自动切换 | 基于健康度的智能路由 | 用户无感知故障转移 |

| 📊 监控告警 | 多维度实时监控 + 分级告警 | 问题早发现早处理 |

🏗️ 三层容灾架构

推荐的企业级部署架构:

┌─────────────────────────────────────────────┐

│ 应用层 (Application Layer) │

│ 统一 OpenAI SDK 接口,无需修改代码 │

└─────────────────────────────────────────────┘

↓

┌─────────────────────────────────────────────┐

│ API易智能路由层 (Smart Routing) │

│ • 实时健康检查 │

│ • 加权负载均衡 │

│ • 自动故障转移 │

│ • 请求重试与熔断 │

└─────────────────────────────────────────────┘

↓

┌──────────┬──────────┬──────────┬──────────┐

│ Tier 1 │ Tier 2 │ Tier 3 │ Tier 4 │

│ 主通道 │ 备用 1 │ 备用 2 │ 国产 │

├──────────┼──────────┼──────────┼──────────┤

│ Azure │ Claude │ Gemini │ Qwen/ │

│ OpenAI │ (AWS) │ (GCP) │ GLM │

│ │ │ │ │

│ 优先级:1 │ 优先级:2 │ 优先级:3 │ 优先级:4 │

│ 权重:70% │ 权重:20% │ 权重:8% │ 权重:2% │

└──────────┴──────────┴──────────┴──────────┘

工作原理:

- 正常情况: 70% 流量到 Azure OpenAI (最优成本和性能)

- Tier 1 故障: 自动切换到 Claude (AWS),2 秒内完成

- Tier 1+2 故障: 切换到 Gemini (GCP),多云容灾

- 全球故障: 使用国产模型兜底,保证基本服务

🔧 客户端最佳实践

开发者在使用 API易时,推荐以下配置:

import openai

from openai import OpenAI

import time

class ResilientAIClient:

"""高可用 AI 客户端封装"""

def __init__(self):

self.client = OpenAI(

api_key="apiyi_key_xxx",

base_url="https://vip.apiyi.com/v1",

timeout=30.0,

max_retries=3

)

def chat(self, messages, model="gpt-4o", **kwargs):

"""带重试和降级的聊天接口"""

# 模型降级策略

fallback_models = [

model, # 首选模型

"claude-3-5-sonnet-20241022", # 备用 1: Claude

"gemini-2.0-flash-exp", # 备用 2: Gemini

"qwen-max" # 备用 3: 国产模型

]

for attempt_model in fallback_models:

try:

response = self.client.chat.completions.create(

model=attempt_model,

messages=messages,

**kwargs

)

# 记录实际使用的模型

print(f"✓ 成功使用模型: {attempt_model}")

return response

except openai.APIError as e:

print(f"✗ {attempt_model} 失败: {e}")

if attempt_model == fallback_models[-1]:

raise # 所有模型都失败,抛出异常

time.sleep(1) # 短暂等待后尝试下一个模型

continue

raise Exception("所有模型均不可用")

# 使用示例

client = ResilientAIClient()

response = client.chat(

messages=[

{"role": "system", "content": "你是一个专业的技术助手"},

{"role": "user", "content": "解释量子计算的基本原理"}

],

model="gpt-4o",

temperature=0.7

)

print(response.choices[0].message.content)

关键特性:

- ✅ 自动模型降级:GPT-4o → Claude → Gemini → Qwen

- ✅ 透明重试:应用层无需感知

- ✅ 超时保护:避免长时间等待

- ✅ 日志记录:便于故障排查

📊 监控与告警体系

完整的监控指标体系:

| 监控层级 | 关键指标 | 告警阈值 | 响应动作 |

|---|---|---|---|

| 服务可用性 | 健康检查成功率 | < 95% | 触发自动切换 |

| 请求成功率 | HTTP 2xx 占比 | < 99% | 通知运维团队 |

| 响应延迟 | P95 延迟 | > 2s | 扩容或路由调整 |

| 错误率 | 4xx/5xx 错误率 | > 1% | 分析错误原因 |

| 成本监控 | 每日 API 费用 | 超预算 20% | 预算告警 |

| 配额使用 | RPM/TPM 使用率 | > 80% | 提前申请扩容 |

🛠️ 工具选择建议:API易平台内置了完整的监控面板和告警系统,开发者也可以通过 API易 apiyi.com 的管理后台查看实时调用统计、成功率趋势和成本分析,无需自建监控系统即可获得企业级的可观测性能力。

国产模型的战略价值

这次 Cloudflare 故障也凸显了国产 AI 模型的战略意义。

🇨🇳 API易支持的国产模型矩阵

| 模型 | 厂商 | 核心优势 | 适用场景 | 成本 |

|---|---|---|---|---|

| Qwen-Max | 阿里云 | 中文理解优秀,多模态能力强 | 电商、客服、内容生成 | ¥0.04/1K tokens |

| Qwen-Turbo | 阿里云 | 性价比高,速度快 | 高并发场景 | ¥0.008/1K tokens |

| 豆包 (Doubao) | 字节跳动 | 创意生成、对话流畅 | 营销文案、聊天机器人 | ¥0.03/1K tokens |

| Kimi | 月之暗面 | 超长上下文 (200K) | 文档分析、法律合同 | ¥0.05/1K tokens |

| 智谱 GLM-4 | 智谱 AI | 逻辑推理强,代码能力好 | 教育、研发辅助 | ¥0.05/1K tokens |

| ChatGLM-Turbo | 智谱 AI | 快速响应 | 实时对话 | ¥0.01/1K tokens |

💡 国产模型的独特优势

1. 中文能力全面领先

实测对比(中文古诗词创作任务):

提示词: 以"科技赋能未来"为主题,创作一首七言律诗

GPT-4o 输出质量: 7.2/10 (韵律不够严谨)

Claude 3.5 输出质量: 6.8/10 (平仄不够准确)

Qwen-Max 输出质量: 9.1/10 (韵律工整,意境深远)

智谱 GLM-4 输出质量: 8.7/10 (对仗工整)

2. 本土化部署,延迟极低

| 用户地区 | OpenAI 官方延迟 | Azure OpenAI 延迟 | 国产模型延迟 |

|---|---|---|---|

| 北京 | 350-800ms | 80-150ms | 15-30ms |

| 上海 | 320-750ms | 70-140ms | 12-25ms |

| 深圳 | 380-820ms | 90-160ms | 18-35ms |

3. 数据合规与安全

- 数据不出境: 所有处理均在中国境内完成

- 等保合规: 通过等保三级认证

- 审计友好: 完整的中文审计日志

- 政策风险低: 不受国际政治因素影响

🎯 混合模型策略

最佳实践是根据任务类型选择最优模型:

def get_optimal_model(task_type, language, budget):

"""根据任务特征选择最优模型"""

if language == "zh-CN": # 中文任务

if task_type == "创意写作":

return "doubao-pro" # 豆包创意能力强

elif task_type == "长文档分析":

return "kimi" # 200K 上下文

elif task_type == "代码生成":

return "glm-4" # 逻辑推理好

else:

return "qwen-max" # 通用首选

elif budget == "low": # 成本敏感

return "qwen-turbo" # 最便宜

else: # 英文或通用任务

return "gpt-4o" # Azure OpenAI

# 使用示例

task = "生成一篇关于人工智能发展趋势的中文报告"

model = get_optimal_model("长文档分析", "zh-CN", "normal")

print(f"推荐模型: {model}") # 输出: kimi

💰 成本优化建议:对于中文为主的应用场景,通过 API易 apiyi.com 混合使用国产模型和 GPT-4o,可以在保证质量的前提下降低 40-60% 的 API 成本。平台提供了智能模型路由功能,可以根据任务自动选择性价比最优的模型组合。

❓ 企业常见问题解答

Q1: API易如何保证比 OpenAI 官方更高的可用性?

API易的高可用性来自四个核心设计:

1. 多路径冗余

- Azure OpenAI (主通道)

- OpenAI 官方 API (备用)

- Claude、Gemini、Grok (跨云备份)

- 国产模型 (本土化兜底)

2. 实时健康监控

// 每 30 秒执行健康检查

setInterval(() => {

checkEndpointHealth([

'azure-openai',

'openai-official',

'claude-bedrock',

'gemini-gcp'

]);

}, 30000);

3. 智能故障转移

- 检测到故障后 2 秒内完成切换

- 用户请求无感知,自动重试到健康节点

- 不依赖单一 CDN 或云厂商

4. 企业级 SLA

- 99.9% 可用性保证

- 故障补偿机制

- 7×24 技术支持

专业建议:企业用户建议通过 API易 apiyi.com 咨询定制化高可用方案,我们可以根据您的业务特点设计专属的多活架构,确保关键业务永不掉线。

Q2: 使用 API易的 Azure OpenAI 和直接用 Azure 有什么区别?

作为 Azure OpenAI 官方代理商,API易提供的增值服务包括:

| 对比项 | 直接使用 Azure | 通过 API易代理 |

|---|---|---|

| 开通流程 | 需要企业认证,审批周期 2-4 周 | 即时开通,5 分钟可用 |

| 接口兼容 | Azure 专有 API 格式 | 100% 兼容 OpenAI SDK |

| 多模型支持 | 仅 OpenAI 模型 | GPT + Claude + Gemini + 国产 |

| 价格 | Azure 标准价 | 8-12% 优惠 + 充值赠送 |

| 计费方式 | 美元月结 (需绑卡) | 人民币预付,灵活充值 |

| 技术支持 | 英文工单,响应慢 | 中文 7×24,1 小时响应 |

| 容灾能力 | 单一 Azure | 多云 + 多模型容灾 |

典型场景:

- 小团队/个人开发者: 使用 API易,无需企业认证

- 中小企业: 使用 API易,成本更低、更灵活

- 大型企业: 可选择 API易 企业专属部署方案

开通建议:访问 API易 apiyi.com 注册即可立即使用 Azure OpenAI,无需等待 Azure 审批,前 10 万 tokens 免费试用。

Q3: 多模型架构会增加开发复杂度吗?

不会。API易提供 100% OpenAI 兼容的接口,只需修改 base_url:

# 原来的代码 (OpenAI 官方)

from openai import OpenAI

client = OpenAI(api_key="sk-xxx")

# 切换到 API易 (无需修改其他代码)

client = OpenAI(

api_key="apiyi_key_xxx",

base_url="https://vip.apiyi.com/v1" # 仅改这一行

)

# 所有调用代码保持不变

response = client.chat.completions.create(

model="gpt-4o", # 自动路由到最优节点

messages=[...]

)

智能路由:

- 请求

gpt-4o→ 自动选择 Azure OpenAI 或 OpenAI 官方 - 请求

claude-3-5-sonnet→ 自动路由到 AWS Bedrock - 请求

gemini-2.0-flash→ 自动路由到 GCP

模型切换:

# 临时切换到 Claude(只改 model 参数)

response = client.chat.completions.create(

model="claude-3-5-sonnet-20241022", # 切换模型

messages=[...] # 其他代码不变

)

学习建议:API易平台提供了丰富的代码示例和 SDK,访问 API易 apiyi.com 的开发文档可以找到 Python、Node.js、Java、Go 等语言的快速接入示例,5 分钟即可完成迁移。

Q4: 国产模型的质量能否替代 GPT-4?

取决于具体任务。最新的国产模型在某些领域已超越 GPT-4:

国产模型领先的场景:

- ✅ 中文理解和生成: Qwen-Max、GLM-4 在中文任务上全面超越 GPT-4o

- ✅ 长文档处理: Kimi 的 200K 上下文远超 GPT-4-Turbo 的 128K

- ✅ 成本敏感场景: Qwen-Turbo 仅需 GPT-4 成本的 1/15

- ✅ 低延迟要求: 国内部署,延迟仅为 GPT-4 的 1/20

GPT-4 仍领先的场景:

- 🔸 英文创意写作: GPT-4o 的英文表达更地道

- 🔸 复杂逻辑推理: o1 系列在数学、编程竞赛中更强

- 🔸 多模态理解: GPT-4o 的图像理解能力更好

混合策略示例:

def select_model(task):

"""根据任务智能选择模型"""

if task["language"] == "zh":

return "qwen-max" # 中文优先国产

elif task["cost_sensitive"]:

return "qwen-turbo" # 成本优先

elif task["reasoning_heavy"]:

return "o1-mini" # 复杂推理用 OpenAI

else:

return "gpt-4o" # 默认 GPT-4o

测试建议:API易平台支持所有主流国产模型,建议先用免费额度测试对比,访问 API易 apiyi.com 即可获取测试 Token,实际体验不同模型在您业务场景下的表现。

Q5: 这次 Cloudflare 故障给企业的核心教训是什么?

核心教训:不要在关键业务上依赖单一供应商。

行动建议:

1. 短期 (1 周内)

- ✅ 评估当前 AI 服务的单点故障风险

- ✅ 注册 API易 账号,获取备用 API Key

- ✅ 修改代码支持多端点配置

2. 中期 (1 个月内)

- ✅ 实施双活架构:主通道 + 备用通道

- ✅ 添加健康检查和自动切换逻辑

- ✅ 建立监控告警体系

3. 长期 (3 个月内)

- ✅ 部署完整的多云多模型架构

- ✅ 定期演练故障切换流程

- ✅ 建立成本优化和合规管理机制

快速起步:访问 API易 apiyi.com 注册企业账号,技术团队将协助您完成高可用架构设计,确保下一次 CDN 故障时,您的业务不受影响。

📚 延伸阅读

🔗 技术资源

| 资源类型 | 链接 | 说明 |

|---|---|---|

| API易官方文档 | help.apiyi.com | 完整的 API 文档和接入指南 |

| Azure OpenAI 文档 | Microsoft Learn | Azure OpenAI Service 官方文档 |

| 高可用架构案例 | help.apiyi.com/ha-guide | 企业级高可用方案白皮书 |

| 成本优化指南 | help.apiyi.com/cost-optimization | AI API 成本优化最佳实践 |

🛠️ 相关文章

| 主题 | 核心内容 | 适合人群 |

|---|---|---|

| ChatGPT 打不开?解决方案大全 | Cloudflare 故障排查完整指南 | 普通用户、开发者 |

| Azure OpenAI vs OpenAI 官方对比 | 性能、成本、合规性全面对比 | 企业决策者 |

| 国产大模型横向评测 2025 | Qwen、豆包、Kimi、GLM 详细对比 | AI 工程师 |

| 多云架构设计实战 | AWS + Azure + GCP 多活部署 | 架构师 |

📊 行业报告

- 《2025 年 AI 基础设施可用性报告》: 分析全球 AI 服务商的故障数据

- 《企业 AI 应用成本白皮书》: 多模型策略如何降低 40% 成本

- 《中国 AI 大模型合规指南》: 数据安全与合规要求详解

深入学习建议:持续关注 AI 基础设施和云计算技术发展动态,我们推荐定期访问 API易 help.apiyi.com 的技术博客和更新日志,了解最新的高可用架构设计方案、多模型性能对比和成本优化策略,保持技术领先优势。

🎯 总结

2025 年 11 月 18 日的 Cloudflare 故障事件是一次深刻的行业警示:即使是全球最大的基础设施服务商,也无法保证 100% 的可用性。

关键启示:

- 多元化是高可用的基石 – 不依赖单一供应商、单一 CDN、单一云厂商

- Azure OpenAI 是企业级首选 – 99.9% SLA、独立基础设施、全球分布

- 国产模型战略价值凸显 – 低延迟、合规性、成本优势

- 自动化容灾是必选项 – 健康检查、智能路由、秒级切换

在实际应用中,建议:

- 个人开发者: 使用 API易多模型备份,避免 OpenAI 故障影响开发

- 初创企业: 采用 Azure OpenAI + 国产模型混合策略,平衡成本与稳定性

- 中大型企业: 部署完整的多云多模型架构,建立主备容灾体系

- 关键业务: 专用容量 + 私有网络 + 多活部署,确保 99.99% 可用性

最终建议:在 AI 时代,服务的稳定性直接决定业务的竞争力。API易作为专业的 AI API 聚合平台和 Azure OpenAI 官方代理商,通过多元化架构、智能路由和 7×24 技术支持,为企业提供比单一供应商更可靠的 AI 基础设施。我们强烈建议访问 API易 apiyi.com 咨询企业级高可用方案,让您的 AI 应用在下一次基础设施故障中依然稳如磐石。

📝 作者简介:API易技术团队,专注于企业级 AI 基础设施和多云架构设计。作为 Azure OpenAI 官方代理商和多模型聚合平台,我们为 2000+ 企业客户提供高可用 AI API 服务。更多技术资料和架构案例可访问 API易 apiyi.com 技术社区。

🔔 技术交流:欢迎在评论区讨论您的高可用架构实践和这次 Cloudflare 故障的应对经验。如需企业级容灾方案设计支持,可通过 API易 apiyi.com 联系我们的解决方案团队,获取免费的架构咨询服务。