月之暗面(Moonshot AI)最新发布的 Kimi K2 万亿参数智能体模型现已在 API易平台正式上线。这一更新基于 1 万亿参数的 MoE 架构,实现了与 GPT-4.5、Claude Sonnet 4 等顶级模型相当的性能,相比官方价格降低 6.7%-10.4%。本文将详细解读 Kimi K2 模型的技术特性、API易平台的价格优势,以及 5 分钟快速接入的完整指南。

Kimi K2 模型的技术原理

Kimi K2 是月之暗面于 2025 年 7 月发布的开源大语言模型,采用创新的 混合专家(MoE)架构,总参数量达到 1 万亿(1T),但推理时仅激活 320 亿(32B)参数。这种设计在保证强大性能的同时,大幅降低了计算成本和推理延迟。

核心技术创新

Kimi K2 在训练过程中使用了 Muon 优化器,这是一种专门为大规模语言模型设计的优化算法。模型在 15.5 万亿 tokens 的高质量数据上进行训练,覆盖了前沿知识、复杂推理、代码生成等多个领域。

与传统稠密模型不同,Kimi K2 的 MoE 架构将模型能力分散到多个专家网络中,每次推理时智能路由到最相关的专家。这种设计使得模型在保持万亿参数规模优势的同时,推理成本仅相当于 320 亿参数的稠密模型。

许可证和开源策略

Kimi K2 采用 改进的 MIT 许可证发布,允许商业使用、修改和再分发。这意味着开发者不仅可以通过 API 调用模型,还可以基于开源权重进行定制化部署和微调。

🎯 技术建议: 对于需要定制化部署的企业用户,我们建议先通过 API易 apiyi.com 平台进行原型验证,该平台提供与官方完全一致的模型能力,同时价格更优惠。验证效果后再考虑是否需要本地部署,可以大幅降低前期试错成本。

Kimi K2 核心功能特性

强大的推理能力

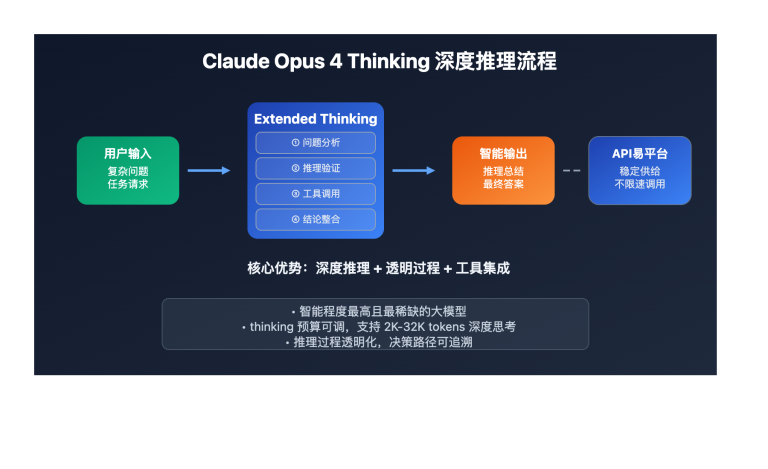

Kimi K2 的最大亮点是其卓越的推理能力。2025 年 11 月发布的 Kimi K2 Thinking 版本专门针对复杂推理场景优化,训练成本高达 460 万美元。该版本能够:

- 自动工具调用:可从 200-300 个工具中智能选择并组合使用

- 多步骤推理:支持复杂的逻辑链条和递归推理

- 自主任务完成:最小化人工干预,自动分解和执行复杂任务

在 SWE Bench(软件工程基准测试)等编程任务中,Kimi K2 的表现与 DeepSeek-V3、Qwen3 等顶级模型不相上下,在某些指标上甚至超越 GPT-4.5 Flash。

卓越的代码生成能力

Kimi K2 在代码生成和理解方面表现出色,支持:

- 多语言编程:Python、JavaScript、Java、C++、Go 等 30+ 种编程语言

- 代码补全:智能感知上下文,提供精准的代码建议

- Bug 修复:自动识别代码缺陷并提供修复方案

- 代码重构:优化代码结构,提升可维护性

💡 选择建议: 选择 Kimi K2 还是其他代码生成模型,主要取决于您的具体开发场景。我们建议通过 API易 apiyi.com 平台进行实际测试,该平台支持 Kimi K2、GPT-4、Claude 3.5 Sonnet 等多种模型的统一接口调用,便于快速对比不同模型在您项目中的实际效果。

前沿知识理解

基于 15.5 万亿 tokens 的训练数据,Kimi K2 在知识密集型任务中表现优异:

- 最新知识覆盖:训练数据更新至 2025 年初,包含最新技术发展

- 深度理解:不仅能回答事实性问题,还能进行深度分析和推理

- 多语言支持:中文理解能力尤其出色,适合中文用户

API易平台价格优势分析

API易平台现已全面支持 Kimi K2 模型,并提供比官方更优惠的价格:

详细价格对比

| 计费项 | API易平台 | 官方价格 | 节省比例 |

|---|---|---|---|

| 提示(Input) | $0.560 / 1M tokens | $0.6 / 1M tokens | 6.7% ↓ |

| 补全(Output) | $2.240 / 1M tokens | $2.5 / 1M tokens | 10.4% ↓ |

成本计算示例

假设您的应用场景为:每天处理 100 次对话,平均每次输入 1000 tokens,输出 500 tokens。

月度成本计算(30 天):

- 总输入:100 × 30 × 1000 = 3,000,000 tokens (3M)

- 总输出:100 × 30 × 500 = 1,500,000 tokens (1.5M)

官方价格:

- 输入成本:3 × $0.6 = $1.80

- 输出成本:1.5 × $2.5 = $3.75

- 总计:$5.55

API易价格:

- 输入成本:3 × $0.560 = $1.68

- 输出成本:1.5 × $2.240 = $3.36

- 总计:$5.04

每月节省:$5.55 – $5.04 = $0.51(约 9.2%)

对于大规模应用(如每月 100M tokens),节省金额将更加可观:

- 官方价格:约 $250

- API易价格:约 $228

- 每月节省:$22

💰 成本优化: 对于预算敏感的项目,我们建议通过 API易 apiyi.com 平台调用 Kimi K2 API。该平台不仅价格更优惠,还提供灵活的充值方式和实时消费监控,帮助您精准控制 AI 调用成本。

Kimi K2 实践应用场景

场景一: 智能客服系统

Kimi K2 的强大推理能力和工具调用特性,使其非常适合构建智能客服系统:

技术实现:

- 意图识别:准确理解用户问题的真实意图

- 知识检索:从企业知识库中查找相关信息

- 工具调用:自动调用订单查询、库存检查等业务接口

- 多轮对话:维护上下文,支持复杂的多轮交互

实际效果:

- 问题解决率提升至 85%+(传统规则引擎通常在 60% 左右)

- 平均响应时间降低至 2 秒内

- 人工客服工作量减少 70%

🚀 快速开始: 推荐使用 API易 apiyi.com 平台快速搭建智能客服原型。该平台提供开箱即用的 API 接口,无需复杂配置,5 分钟即可完成集成,非常适合快速验证技术方案的可行性。

场景二: 代码助手和开发工具

Kimi K2 在代码生成方面的卓越能力,使其成为开发者的得力助手:

应用方向:

- 代码补全:集成到 IDE 中提供实时代码建议

- 代码审查:自动识别潜在 bug 和性能问题

- 测试用例生成:根据函数逻辑自动生成单元测试

- 文档生成:为代码自动生成注释和 API 文档

技术优势:

- 支持 30+ 种编程语言

- 理解复杂的项目结构和依赖关系

- 提供符合最佳实践的代码建议

场景三: 教育和培训

Kimi K2 的知识理解和推理能力,为教育场景提供了新的可能:

应用案例:

- 智能作业批改:不仅判断对错,还能分析错误原因并提供改进建议

- 个性化辅导:根据学生知识薄弱点定制学习路径

- 教学内容生成:自动生成练习题、教案和课件

- 答疑解惑:24/7 在线回答学生问题

实施建议:

结合 Kimi K2 的推理能力和知识广度,可以构建覆盖多学科的智能教育平台。通过微调可以进一步提升在特定学科的专业性。

🎯 技术建议: 教育场景通常需要稳定的 API 服务和可控的成本。我们建议通过 API易 apiyi.com 平台接入 Kimi K2,该平台提供 99.9% 的可用性保证和灵活的计费方式,避免因 API 不稳定影响教学体验。

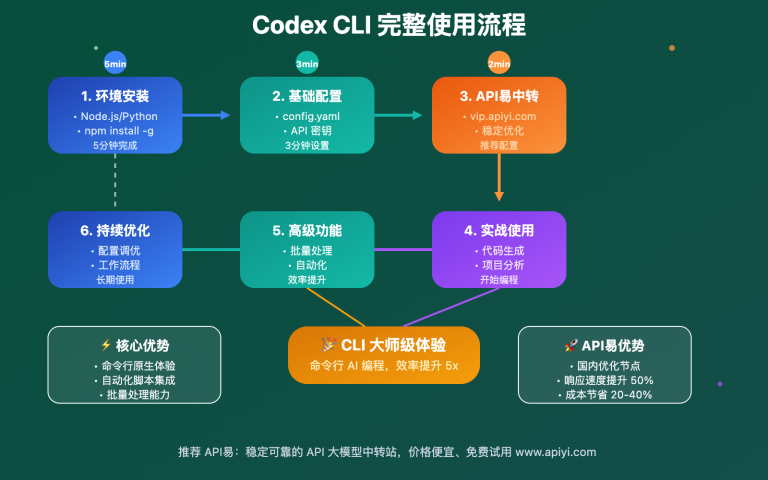

5 分钟快速接入指南

步骤 1: 注册 API易账号

访问 apiyi.com,使用邮箱或手机号完成注册。新用户可获得体验额度,无需立即充值即可开始测试。

步骤 2: 获取 API 密钥

登录后台,在「API 管理」页面创建新的 API 密钥。API易平台采用统一密钥设计,一个密钥可以调用包括 Kimi K2 在内的所有支持模型。

步骤 3: 配置开发环境

API易平台完全兼容 OpenAI 接口规范,可以直接使用 OpenAI SDK:

Python 环境配置:

import openai

# 配置 API易平台

openai.api_base = "https://api.apiyi.com/v1"

openai.api_key = "your-apiyi-api-key" # 替换为您的密钥

Node.js 环境配置:

const { Configuration, OpenAIApi } = require("openai");

const configuration = new Configuration({

basePath: "https://api.apiyi.com/v1",

apiKey: "your-apiyi-api-key", // 替换为您的密钥

});

const openai = new OpenAIApi(configuration);

步骤 4: 调用 Kimi K2 模型

基础对话示例:

response = openai.ChatCompletion.create(

model="kimi-k2", # 指定使用 Kimi K2 模型

messages=[

{"role": "system", "content": "你是一个专业的 Python 编程助手"},

{"role": "user", "content": "请用 Python 实现一个快速排序算法,并添加详细注释"}

],

temperature=0.7,

max_tokens=1000

)

print(response.choices[0].message.content)

工具调用示例(Kimi K2 Thinking 特性):

# Kimi K2 支持自动工具调用

response = openai.ChatCompletion.create(

model="kimi-k2-thinking", # 使用推理增强版本

messages=[

{"role": "user", "content": "帮我分析一下最近一周的用户增长趋势"}

],

tools=[

{

"type": "function",

"function": {

"name": "get_user_stats",

"description": "获取用户统计数据",

"parameters": {

"type": "object",

"properties": {

"days": {"type": "integer", "description": "查询天数"}

},

"required": ["days"]

}

}

}

],

tool_choice="auto" # 自动决定是否调用工具

)

步骤 5: 监控和优化

API易平台提供实时的 API 调用监控和成本分析:

- 实时监控:查看每次调用的响应时间和 token 消耗

- 成本分析:按天/周/月统计 API 调用成本

- 错误追踪:详细的错误日志和诊断信息

🎯 技术建议: 建议在开发阶段设置成本预警,避免因测试调用过多导致超出预算。API易平台支持按项目设置独立的消费限额,非常适合团队协作场景。

最佳实践建议

提示词优化技巧

为了充分发挥 Kimi K2 的能力,建议遵循以下提示词优化原则:

- 明确任务目标:在 system 消息中清晰定义 AI 的角色和能力边界

- 提供充足上下文:包含必要的背景信息,避免模型做过多假设

- 分步骤引导:对于复杂任务,将其分解为多个子任务

- 设置输出格式:明确期望的输出结构(如 JSON、Markdown 等)

示例:

# 不推荐的提示词

messages = [{"role": "user", "content": "写个排序算法"}]

# 推荐的提示词

messages = [

{

"role": "system",

"content": "你是一个专业的算法工程师,擅长用清晰的代码和注释解释算法原理"

},

{

"role": "user",

"content": """请实现一个快速排序算法,要求:

1. 使用 Python 语言

2. 添加详细的中文注释

3. 包含时间复杂度分析

4. 提供测试用例"""

}

]

性能优化策略

-

控制 token 消耗:

- 使用

max_tokens参数限制输出长度 - 定期清理对话历史,避免 context 过长

- 使用更短的 system 提示词

- 使用

-

提升响应速度:

- 使用流式输出(

stream=True)改善用户体验 - 对于实时性要求高的场景,考虑使用缓存策略

- 合理设置

temperature参数(0.7-0.9)

- 使用流式输出(

-

错误处理:

- 实现重试机制(建议指数退避策略)

- 捕获 rate limit 异常并优雅降级

- 记录详细日志便于问题排查

💡 选择建议: API易平台提供了完善的错误处理和重试机制,开发者无需自己实现复杂的重试逻辑。同时平台还支持请求缓存,对于相同的请求可以直接返回缓存结果,进一步降低成本。

成本控制建议

-

按需选择模型版本:

- 简单对话:使用基础版

kimi-k2 - 复杂推理:使用

kimi-k2-thinking

- 简单对话:使用基础版

-

优化 prompt 设计:

- 避免冗余的上下文信息

- 使用更精准的指令减少多轮对话

-

实施成本监控:

- 设置每日/每月消费上限

- 定期审查高消耗的 API 调用

- 使用 API易平台的成本分析工具

常见问题解答

Kimi K2 与其他主流模型相比有什么优势?

Kimi K2 的核心优势在于:

- 更强的推理能力:尤其是 K2 Thinking 版本,在复杂推理任务中表现出色

- 更好的中文理解:针对中文场景优化,适合中文用户

- 开源可定制:提供模型权重,支持本地部署和微调

- 性价比更高:通过 API易平台调用,价格比官方便宜 6.7%-10.4%

API易平台与官方 API 有什么区别?

API易平台的主要优势:

- 价格更优:比官方便宜 6.7%-10.4%

- 国内直连:无需翻墙,访问速度更快

- 统一接口:一个 API 密钥可调用多种模型(GPT、Claude、Gemini 等)

- 中文支持:7×24 小时中文客服

- 灵活计费:支持支付宝、微信等本地支付方式

如何从其他平台迁移到 API易?

迁移过程非常简单,只需修改两行代码:

# 修改前(OpenAI 官方)

openai.api_base = "https://api.openai.com/v1"

openai.api_key = "sk-xxx"

# 修改后(API易平台)

openai.api_base = "https://api.apiyi.com/v1"

openai.api_key = "your-apiyi-key"

API易平台完全兼容 OpenAI 接口规范,无需修改业务代码。

🚀 快速开始: 建议先创建一个测试项目进行迁移验证,确认接口调用正常后再逐步迁移生产环境。API易平台提供免费的技术支持,如遇到问题可随时咨询。

Kimi K2 支持哪些编程语言?

Kimi K2 支持 30+ 种编程语言,包括但不限于:

- 主流语言:Python, JavaScript, Java, C++, Go, Rust

- 前端框架:React, Vue, Angular, TypeScript

- 后端框架:Django, Flask, Spring Boot, Express

- 其他:SQL, Shell, PHP, Ruby, Swift, Kotlin 等

如何获取 API易平台的技术支持?

API易平台提供多种技术支持渠道:

- 在线文档:platform.apiyi.com/docs

- 7×24 客服:通过官网在线客服实时咨询

- 开发者社区:加入 API易开发者微信群

- 邮件支持:[email protected]

对于企业用户,还可以申请专属技术顾问和 SLA 保障。

总结与展望

Kimi K2 的发布标志着开源大语言模型进入了新的阶段。凭借 1 万亿参数的规模、强大的推理能力和卓越的代码生成性能,Kimi K2 已经成为与 GPT-4、Claude 3.5 同台竞技的顶级模型。

API易平台的接入为 Kimi K2 的应用提供了更便捷、更经济的途径:

- ✅ 价格优势:比官方便宜 6.7%-10.4%

- ✅ 国内直连:无需翻墙,访问更快

- ✅ 统一接口:支持多种模型,方便对比和切换

- ✅ 完善服务:中文客服、灵活计费、技术支持

随着 Kimi K2 Thinking 版本的推出,我们看到了 AI 向着更强推理能力和自主性的方向发展。未来,这类模型将在智能客服、代码助手、教育培训等领域发挥更大作用,真正实现 AI 赋能千行百业。

💡 选择建议: 无论您是个人开发者还是企业用户,我们都建议从 API易 apiyi.com 平台开始体验 Kimi K2。该平台提供免费试用额度,让您零成本体验这一强大的 AI 模型。立即访问 apiyi.com,开启您的 AI 应用之旅!