Sora 2 隐私保护指南:Cameo 功能的 7 个安全使用要点

核心观点: Sora 2 的 Cameo 功能让用户能够将自己"插入"AI 生成的任何场景,这是视频创作的革命性突破,但同时也带来了深度伪造(Deepfake)、身份冒用和隐私泄露等重大安全风险。本文系统分析 Cameo 功能的安全机制、潜在风险和防护策略,帮助您安全地使用这项创新技术。

2025 年 10 月 1 日,OpenAI 发布了 Sora 2 模型,其中最引人注目的创新功能之一就是 Cameo(客串功能)。通过上传一段自己的视频,Sora 2 可以将您"带入"任何 AI 生成的场景中——无论是在巴黎铁塔下漫步、在火星表面探险,还是与恐龙共舞。

这项技术令人兴奋,但也引发了严重的隐私和安全担忧:

- ⚠️ 如果有人上传了我的视频并冒充我怎么办?

- ⚠️ 我上传的视频会被 OpenAI 如何使用和存储?

- ⚠️ Cameo 生成的视频会被用于 Deepfake 诈骗吗?

- ⚠️ 如何防止未经授权的身份盗用?

这些问题不仅关乎技术细节,更关乎每个用户的数字身份安全和隐私权保护。本文将深入解析 Sora 2 Cameo 功能的技术原理、安全机制、潜在风险,并提供系统化的隐私保护策略。

📋 目录

- Cameo 功能技术原理解析

- OpenAI 的安全机制和隐私政策

- Cameo 功能的 5 大隐私风险

- 安全使用 Cameo 的 7 个核心要点

- 5 种风险场景与应对策略

- 儿童和未成年人保护

- 企业和品牌的 Cameo 使用合规

- 技术防护工具推荐

- 未来展望和监管趋势

- 总结与建议

Cameo 功能技术原理解析

在讨论安全问题之前,我们需要理解 Cameo 功能是如何工作的。

核心工作流程

Cameo 功能的 4 个关键步骤:

- 视频上传: 用户上传一段自己的参考视频(通常 5-10 秒)

- 特征提取: Sora 2 分析视频,提取面部特征、身体姿态、声音特征、运动模式等

- 身份验证: 系统要求用户完成实时身份验证(例如特定动作或语音确认)

- 场景插入: Sora 2 将提取的特征"嵌入"到新生成的视频场景中

技术背后的核心机制

Cameo 使用了哪些 AI 技术?

-

面部识别和重建(Face Recognition & Reconstruction)

- 基于 3D Morphable Face Models (3DMM)

- 提取数百个面部特征点

- 重建面部几何结构和纹理

-

姿态估计和迁移(Pose Estimation & Transfer)

- 骨骼关键点检测

- 运动轨迹分析

- 姿态风格迁移

-

声音克隆(Voice Cloning)

- 声纹特征提取

- 音色和韵律建模

- 语音合成生成

-

风格迁移(Style Transfer)

- 将用户特征"融合"到新场景

- 保持光照和透视一致性

- 确保物理真实感

关键隐私问题: 这些技术都需要提取和处理高度敏感的生物特征数据,包括:

- 面部生物特征(唯一识别个人身份)

- 声纹信息(可用于声音验证系统)

- 行为特征(步态、手势等个人习惯)

这些数据如果被不当使用或泄露,可能导致严重的身份盗用和隐私侵犯。

OpenAI 的安全机制和隐私政策

OpenAI 声称为 Cameo 功能实施了多层安全防护机制。让我们详细分析这些措施的有效性。

1. 强制身份验证机制

OpenAI 的官方说明:

"用户必须按照说明进行身份验证,以防止未经授权的冒充。"

实际验证流程:

- 活体检测(Liveness Detection): 要求用户完成随机动作(如转头、眨眼、微笑)

- 实时视频录制: 不接受预录制视频,必须现场录制

- 声音验证: 可能要求用户朗读随机文本进行声纹匹配

- 多因素认证: 结合账号验证(email/phone)

有效性评估: ⭐⭐⭐⭐ (4/5)

- ✅ 能够有效防止使用他人照片或旧视频冒充

- ✅ 活体检测技术相对成熟

- ⚠️ 但仍可能被高质量的实时 Deepfake 攻击绕过

- ⚠️ 无法完全防止"强迫录制"(如诈骗场景)

2. 数据存储和加密

OpenAI 的隐私政策(基于 ChatGPT 相关政策推断):

- 用户上传的视频和提取的特征数据会被存储

- 存储期限:通常 30 天(用于服务改进),之后可能删除或匿名化

- 加密措施:传输加密(TLS)和存储加密(AES-256)

关键问题:

- ❓ 训练数据使用: OpenAI 是否会使用 Cameo 视频改进模型?

- 根据 OpenAI 历史政策,除非用户明确 opt-out,否则可能被用于训练

- ❓ 数据共享: OpenAI 是否会与第三方(如 Microsoft)共享这些数据?

- ❓ 法律请求: 政府或执法机构可以要求访问这些数据吗?

有效性评估: ⭐⭐⭐ (3/5)

- ✅ 基本的加密和安全存储措施

- ⚠️ 存储期限和使用范围不够透明

- ⚠️ 缺少用户自主删除机制的明确说明

3. 内容审核和滥用检测

OpenAI 的防滥用措施:

- 内容政策检测: 禁止生成暴力、色情、仇恨、误导性内容

- Deepfake 标识: Cameo 生成的视频可能会嵌入隐形水印或元数据标记

- 账号监控: 检测异常使用模式(如批量生成、频繁更换面孔)

- 举报机制: 用户可以举报滥用的 Cameo 内容

有效性评估: ⭐⭐⭐ (3/5)

- ✅ AI 内容审核可以拦截明显的违规内容

- ⚠️ 难以检测所有滥用场景(如精准定向诈骗)

- ⚠️ 水印和标记可能被去除或绕过

4. 用户协议和法律责任

关键条款(基于 OpenAI 标准条款推断):

- 用户对上传内容拥有所有权

- 用户授予 OpenAI 使用上传内容的许可(用于提供服务和改进模型)

- 用户保证拥有上传内容中所有人物的使用权

- 违规使用可能导致账号封禁和法律追责

法律灰色地带:

- ⚠️ 如果有人未经同意上传您的视频,您的追责途径有限

- ⚠️ 跨境法律问题:不同国家对生物特征数据的法律保护差异巨大

- ⚠️ Deepfake 法律仍在完善中,执法困难

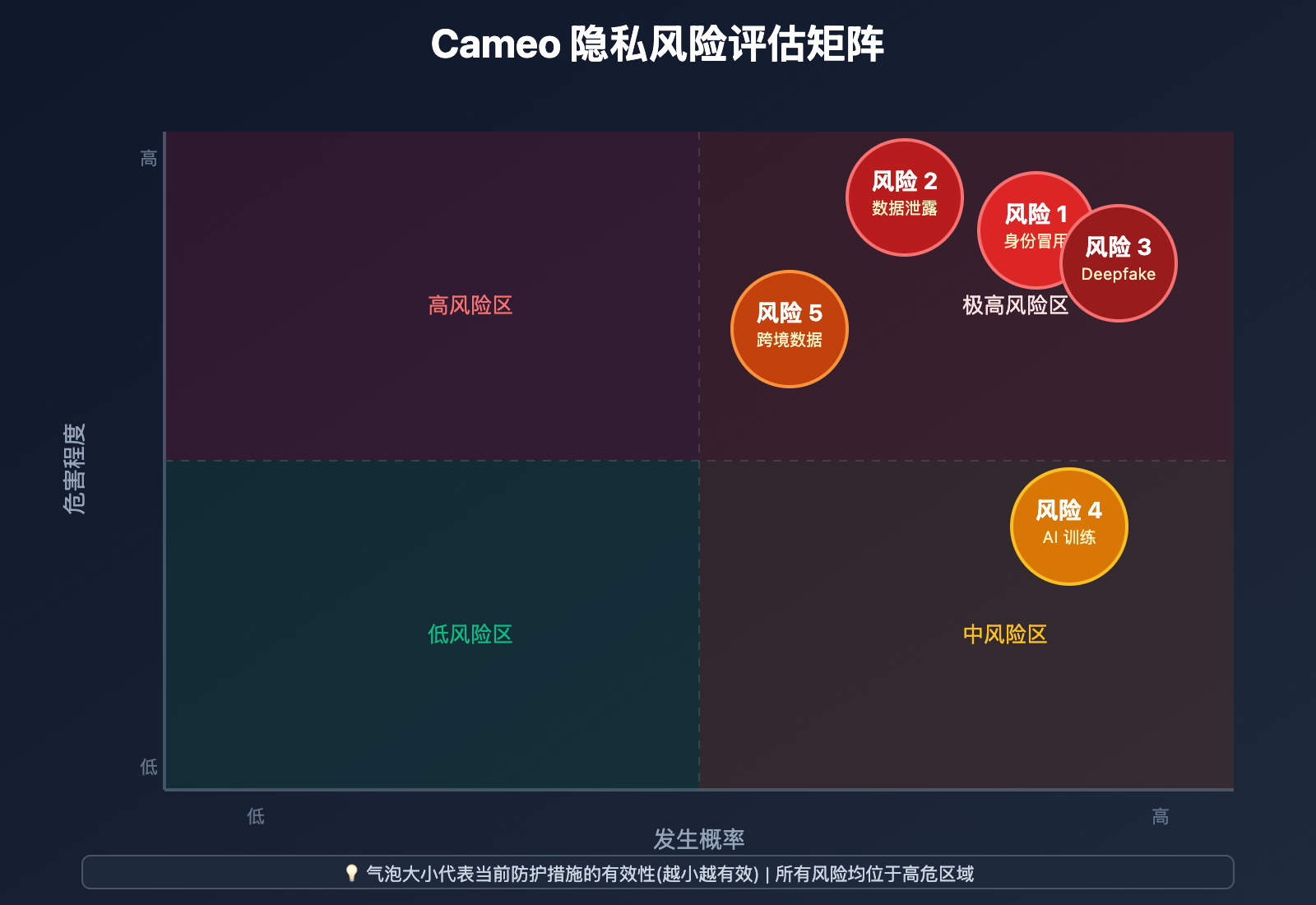

Cameo 功能的 5 大隐私风险

风险 1: 未经授权的身份冒用

风险场景:

- 他人未经您同意,上传您的社交媒体视频或公开视频

- 使用 Cameo 功能生成您出现在虚假场景中的视频

- 用于诈骗、诽谤、骚扰或其他恶意目的

真实案例类比:

2024 年,有诈骗团伙使用 Deepfake 技术克隆公司 CEO 的面孔和声音,通过视频会议诈骗财务人员转账,涉案金额达数百万美元。Cameo 功能降低了这类攻击的技术门槛。

受害者识别难度: ⭐⭐⭐⭐⭐ (极难)

- 您可能完全不知道有人正在使用您的面孔生成虚假视频

- 这些视频可能在您不知情的情况下广泛传播

防护措施:

- 限制社交媒体上的视频公开范围

- 定期搜索您的面孔是否出现在可疑视频中(使用反向图像/视频搜索)

- 了解并使用"数字身份保护服务"

风险 2: 生物特征数据泄露

风险描述:

Cameo 功能提取的面部特征、声纹、步态等生物特征数据,如果被泄露或黑客攻击窃取,后果极为严重。

生物特征数据的特殊性:

- 不可更改: 与密码不同,面孔和声纹无法"重置"

- 唯一性: 可以精确识别个人身份

- 多重用途: 可能被用于绕过面部识别安全系统

历史泄露案例:

- 2019 年,Clearview AI 面部识别数据库被黑客入侵,数十亿张面孔数据泄露

- 2023 年,某语音助手公司的声纹数据库泄露,影响数百万用户

Cameo 的泄露风险: ⭐⭐⭐⭐ (高风险)

- OpenAI 作为高价值目标,可能受到国家级黑客攻击

- 内部员工滥用或数据库管理不善

- 第三方合作伙伴的安全漏洞

防护措施:

- 仅在必要时使用 Cameo 功能

- 定期检查 OpenAI 的安全公告

- 启用账号的所有安全功能(2FA 等)

风险 3: Deepfake 诈骗和误导信息传播

风险场景:

- 金融诈骗: 冒充您向家人或同事索要金钱

- 虚假证言: 生成您"承认"某事或"支持"某立场的视频

- 政治操纵: 在政治敏感场景中冒用公众人物形象

- 社交工程: 伪造您的视频来获取信任进行钓鱼攻击

技术可行性: ⭐⭐⭐⭐⭐ (非常高)

Cameo 功能的设计目标就是生成高度逼真的视频,恶意使用者无需额外技术即可实现以上攻击。

社会危害性: ⭐⭐⭐⭐⭐ (极高)

- 破坏信任体系

- 造成经济损失

- 损害名誉和人际关系

- 传播虚假信息和误导公众

防护措施:

- 与家人和同事建立"视频验证暗号"(特定词语或动作)

- 对任何视频请求进行多渠道验证(电话确认等)

- 教育周围的人识别 Deepfake 的迹象

风险 4: 数据被用于 AI 训练和商业化

风险描述:

您上传的 Cameo 视频可能被 OpenAI 用于:

- 训练和改进未来版本的 Sora 模型

- 商业化应用(例如授权给企业客户)

- 研究目的(可能发表论文或公开部分数据)

法律模糊性:

- OpenAI 的服务条款通常包含"使用用户数据改进服务"的条款

- 大多数用户不会仔细阅读这些条款

- "匿名化"数据仍可能通过交叉分析重新识别个人

长期风险:

您今天上传的视频,可能在未来数年甚至数十年后:

- 被用于训练更先进的 AI 模型

- 在您不知情的情况下影响 AI 对您的模拟能力

- 成为未来隐私诉讼的争议焦点

防护措施:

- 仔细阅读并理解 OpenAI 的数据使用政策

- 如果可能,选择 opt-out 数据训练使用

- 考虑使用"一次性"面孔(化妆、滤镜)而非真实面孔

风险 5: 跨境数据传输和法律管辖

风险描述:

OpenAI 是美国公司,您的 Cameo 数据可能:

- 存储在美国服务器上

- 受美国法律管辖(如 CLOUD Act,允许美国政府访问)

- 难以受到您所在国家隐私法律的保护(如欧盟 GDPR)

地缘政治风险:

- 不同国家对生物特征数据的保护标准差异巨大

- 国际数据传输可能违反某些国家的数据主权法律

- 在国际关系紧张时期,您的数据可能被政治化使用

案例参考:

2020 年,TikTok 因数据存储在中国服务器而被多国政府审查。类似地,存储在美国的 Cameo 数据也可能面临其他国家用户的信任危机。

防护措施:

- 了解您所在国家对生物特征数据的法律保护

- 如果您是欧盟居民,明确行使 GDPR 权利(访问权、删除权)

- 谨慎使用涉及敏感身份信息的功能

安全使用 Cameo 的 7 个核心要点

基于以上风险分析,我们总结了 7 个核心安全使用要点。

要点 1: 最小化数据原则 – 只在必要时使用

核心建议:

- ❌ 不要"为了好玩"随意上传自己的视频

- ✅ 只在有明确创作目的时使用 Cameo 功能

- ✅ 考虑使用替代方案(动画角色、虚拟形象)

为什么重要?

您上传的每一段视频都会增加数据泄露或滥用的风险。数据一旦上传,就失去了完全的控制权。

实践建议:

- 如果只是想测试功能,使用化妆、假发或道具改变外貌

- 对于商业用途,考虑使用专业演员而非真实员工

- 定期审查并删除不再需要的 Cameo 视频

要点 2: 强化账号安全 – 多因素认证必须开启

核心建议:

- ✅ 必须启用 OpenAI 账号的两步验证(2FA)

- ✅ 使用强密码(16+ 字符,包含特殊字符)

- ✅ 定期更换密码

- ✅ 不要在多个平台使用相同密码

为什么重要?

如果您的 OpenAI 账号被黑,攻击者可以:

- 访问您上传的所有 Cameo 视频和特征数据

- 使用您的面孔生成虚假视频

- 冒充您进行诈骗

额外措施:

- 启用登录通知(及时发现异常登录)

- 使用密码管理器(如 1Password, Bitwarden)

- 定期检查账号活动日志

要点 3: 隐私设置优化 – 控制数据使用范围

核心建议:

- ✅ 检查并调整 OpenAI 账号的隐私设置

- ✅ 如果可选,选择退出数据用于训练模型

- ✅ 限制 Cameo 视频的分享和可见性设置

OpenAI 隐私设置位置(假设路径):

账号设置 → 隐私 → 数据控制 → 模型训练 → 选择退出

关键检查项:

- 是否允许 OpenAI 使用我的数据训练模型?

- 我的 Cameo 视频是否默认公开或私密?

- 第三方应用是否可以访问我的 Cameo 数据?

- 数据保留期限是多久?我能否手动删除?

🎯 最佳实践建议: 如果您需要更精细的隐私控制和数据管理,我们推荐通过 API易 apiyi.com 平台使用 Sora 2 服务。该平台提供企业级的数据隐私保护选项,包括数据不用于训练、定期自动删除、完全加密存储等功能。对于有严格隐私要求的商业用户,这是比直接使用 OpenAI 官方服务更安全的选择。

要点 4: 水印和元数据检查 – 确保可追溯性

核心建议:

- ✅ 在生成的 Cameo 视频中嵌入明显的水印或标识

- ✅ 在元数据中标注"AI生成内容"

- ✅ 保留原始生成记录以便日后验证

为什么重要?

如果您的 Cameo 视频被恶意传播,水印和元数据可以帮助:

- 证明视频来源和真伪

- 追踪传播路径

- 提供法律证据

技术实现:

- 使用视频编辑工具添加半透明水印

- 在视频描述中明确标注"本视频由 AI 生成"

- 使用区块链时间戳技术记录生成时间

要点 5: 社交媒体谨慎分享 – 限制公开范围

核心建议:

- ⚠️ 不要将 Cameo 视频公开发布在社交媒体上

- ✅ 如果必须分享,仅限私密群组或可信好友

- ✅ 设置社交媒体账号为"仅好友可见"

- ✅ 禁止他人下载或转发您的 Cameo 视频

风险案例:

一旦 Cameo 视频在社交媒体上公开:

- 任何人都可以下载和二次使用

- 可能被训练新的 Deepfake 模型

- 难以完全删除(缓存、截图、转发)

分享清单:

发布前问自己:

- 这个视频是否包含敏感场景或言论?

- 我是否信任所有可能看到视频的人?

- 视频是否可能被误解或恶意剪辑?

- 是否已添加水印和免责声明?

要点 6: 定期安全审计 – 主动监控和应对

核心建议:

- ✅ 每月进行一次"数字身份审计"

- ✅ 使用反向图像/视频搜索检查您的面孔是否出现在可疑内容中

- ✅ 设置 Google Alerts 监控您的名字+Deepfake 相关关键词

- ✅ 熟悉并准备好应对身份冒用的预案

审计清单:

- OpenAI 账号是否有异常登录?

- 我上传的 Cameo 视频数量和内容是否正确?

- 互联网上是否出现了我未授权的视频?

- 家人和同事是否收到冒充我的视频请求?

发现异常时的应对:

- 立即更改 OpenAI 账号密码

- 联系 OpenAI 客服报告滥用

- 向社交媒体平台举报虚假内容

- 考虑法律途径(记录证据、咨询律师)

要点 7: 法律意识和权利保护 – 了解您的权利

核心建议:

- ✅ 了解您所在地区关于生物特征数据的法律保护

- ✅ 熟悉 OpenAI 的服务条款和用户协议

- ✅ 知道如何行使数据访问权、更正权、删除权

- ✅ 必要时寻求法律专业人士帮助

主要法律框架:

| 地区 | 主要法律 | 核心权利 |

|---|---|---|

| 欧盟 | GDPR | 访问权、删除权("被遗忘权")、数据可携权 |

| 美国 | BIPA(伊利诺伊州等)、CCPA(加州) | 知情权、opt-out 权利、诉讼权 |

| 中国 | 个人信息保护法(PIPL) | 知情同意、删除权、投诉权 |

| 其他 | 各国数据保护法 | 因国家而异 |

如何行使权利(GDPR 示例):

- 向 OpenAI 提交正式的"数据访问请求"(Data Access Request)

- 要求提供您的所有 Cameo 数据副本

- 如需删除,提交"删除请求"(Right to Erasure)

- OpenAI 必须在 30 天内响应

法律诉讼准备(如遇严重侵权):

- 保存所有证据(截图、视频、通信记录)

- 记录时间线和受害经过

- 咨询专业律师评估诉讼可行性

- 了解 Deepfake 相关法律的最新发展

5 种风险场景与应对策略

场景 1: 收到"自己"发来的诈骗视频

场景描述:

您的家人或朋友收到一个视频,视频中的"您"声称遇到紧急情况需要借钱或提供敏感信息。

识别 Deepfake 的 7 个迹象:

- 不自然的眨眼频率: AI 生成的面孔眨眼可能过少或过多

- 光照不一致: 面部光照与环境不匹配

- 边缘模糊: 面部与背景交界处有模糊或失真

- 微表情异常: 情绪表达不自然或延迟

- 声音唇形不同步: 说话时嘴型与声音略有偏差

- 背景异常: 背景可能是生成的或过于简化

- 元数据检查: 视频文件元数据显示异常生成时间或软件

应对策略:

✅ 立即验证: 通过其他渠道(电话、当面见面)确认真实性

✅ 不要立即行动: 任何紧急请求都应先验证

✅ 建立"验证暗号": 与家人约定只有你们知道的验证词或动作

✅ 报告: 向视频发送平台和执法机构报告

✅ 警告网络: 通知您的社交圈警惕类似诈骗

场景 2: 发现网络上流传冒用您形象的视频

场景描述:

您在网上发现一个视频,视频中的人物看起来是您,但您从未拍摄或授权过这段内容。

取证步骤:

- 立即截图和下载: 保存完整证据,包括 URL、发布时间、平台信息

- 元数据提取: 使用工具提取视频元数据,查找生成痕迹

- 记录传播范围: 搜索视频在多少平台和账号上出现

- 截取关键帧: 保存最具代表性的画面

法律应对路径:

✅ 平台举报: 在视频所在平台提交侵权投诉(多数平台有 Deepfake 政策)

✅ DMCA 通知(如适用): 如果您拥有原始视频版权,发送 DMCA 下架通知

✅ 执法机构报案: 如果涉及诈骗、诽谤或威胁,向警方报案

✅ 律师函: 委托律师向上传者和平台发送法律警告

✅ 媒体曝光: 必要时通过媒体曝光以警示公众和施压平台

预防性措施:

- 在主流平台预先建立"数字身份档案",明确真实内容来源

- 使用 Content Authenticity Initiative (CAI) 等技术认证您的真实内容

场景 3: OpenAI 数据泄露或黑客攻击

场景描述:

OpenAI 公布了数据泄露事件,您的 Cameo 数据可能被泄露。

立即行动(发生后 24-48 小时内):

✅ 更改密码: 立即更改 OpenAI 账号及所有关联账号密码

✅ 启用额外安全措施: 开启 2FA,检查设备登录记录

✅ 监控账号活动: 查看是否有异常生成或下载记录

✅ 信用监控(如适用): 如果泄露包含支付信息,监控信用卡和银行账户

中期行动(1-3 个月):

✅ 身份监控服务: 注册身份盗窃监控服务(如 LifeLock, Identity Guard)

✅ 设置警报: Google Alerts 监控您的名字+ Deepfake 关键词

✅ 通知网络: 告知家人、朋友、同事警惕冒充视频

✅ 法律咨询: 评估集体诉讼或个人诉讼的可行性

长期防护:

✅ 数字卫生习惯: 定期审计所有AI平台的隐私设置

✅ 分散风险: 不要在单一平台存储过多生物特征数据

✅ 关注政策: 追踪 OpenAI 和行业的安全改进措施

场景 4: 儿童或未成年人被冒用

场景描述:

发现有人使用未成年人(包括您的孩子)的面孔生成 Cameo 视频,可能涉及不当内容。

紧急性: ⭐⭐⭐⭐⭐ (最高优先级)

儿童 Deepfake 可能涉及儿童剥削和性虐待内容(CSAM),属于严重刑事犯罪。

立即行动:

✅ 报警: 立即向执法机构报案(FBI, 欧洲刑警组织, 各国网警)

✅ 向 NCMEC 报告(美国): National Center for Missing & Exploited Children

✅ 平台紧急举报: 使用平台的"儿童安全"紧急举报通道

✅ 保护孩子: 与孩子沟通,提供心理支持

法律保护:

- 大多数国家对儿童 Deepfake 有更严格的法律保护

- 可能涉及罪名:儿童剥削、制作/传播 CSAM、身份盗窃

- 刑罚通常远重于成人案件

预防措施:

- ❌ 不要上传儿童视频到任何 AI 生成平台

- ✅ 限制儿童面孔在社交媒体上的公开曝光

- ✅ 教育孩子关于数字身份安全的知识

- ✅ 使用家长控制工具监控孩子的在线活动

场景 5: 企业员工身份被冒用进行商业欺诈

场景描述:

公司高管或关键员工的面孔被 Cameo 功能冒用,进行商业决策、合同签署或资金转移。

真实案例参考:

2024 年,某跨国公司财务人员在"视频会议"中收到"CFO"的转账指令,损失 $25M。后证实"CFO"是 Deepfake。

企业应对策略:

✅ 多因素验证流程: 所有重大决策必须通过多渠道验证(视频 + 电话 + 邮件 + 当面)

✅ 视频验证协议: 建立企业内部的"视频真实性验证"标准流程

✅ 员工培训: 定期培训员工识别 Deepfake 的能力

✅ 技术防护: 使用 Deepfake 检测工具扫描所有incoming视频通信

✅ 保险覆盖: 购买包含 Deepfake 诈骗的网络安全保险

企业政策建议:

- 禁止员工在公开平台发布高质量面部视频

- 为高管和关键员工建立"数字身份保护档案"

- 制定明确的 Cameo 功能使用政策(是否允许、如何使用)

🎯 企业用户建议: 对于需要使用 Sora 2 进行商业内容创作的企业,我们强烈建议通过 API易 apiyi.com 平台进行。该平台提供企业级的安全功能,包括专用的数据隔离、完整的审计日志、合规性报告以及专业的技术支持团队。此外,平台还提供 Deepfake 检测 API,帮助企业验证incoming视频的真实性,有效防范商业欺诈风险。

儿童和未成年人保护

儿童的数字身份保护需要特别关注,因为:

- 儿童缺乏风险识别和自我保护能力

- 儿童 Deepfake 可能涉及更严重的法律和伦理问题

- 儿童的生物特征数据泄露影响其一生

OpenAI 对未成年人的政策

年龄限制(基于 OpenAI 标准政策):

- 使用 Cameo 功能的最低年龄:通常为 18 岁

- 13-18 岁可能需要家长同意(根据 COPPA 等法律)

- 不允许上传 13 岁以下儿童的识别性视频

家长责任:

即使有年龄限制,家长仍需承担监护责任:

- 监控孩子的在线活动和账号使用

- 教育孩子不要分享面部视频

- 了解孩子使用的平台和功能

家长行动指南

预防措施:

✅ 隐私设置: 将孩子的社交媒体账号设为完全私密

✅ 面部模糊: 在公开发布的家庭照片/视频中对孩子面部模糊处理

✅ 数字素养教育: 教孩子识别和防范在线风险

✅ 家长控制工具: 使用Screen Time、Family Link 等工具监控设备使用

发现问题时:

✅ 保持冷静: 避免责怪孩子,建立信任以便了解完整情况

✅ 立即报案: 涉及儿童的 Deepfake 是刑事案件,必须报警

✅ 心理支持: 必要时寻求专业心理咨询帮助孩子应对

✅ 法律行动: 咨询专业律师,保护孩子的法律权益

学校和教育机构的责任

建议措施:

- 将 AI 安全和数字身份保护纳入课程

- 禁止在学校活动中使用未经授权的面部识别或 AI 生成技术

- 建立明确的学生数据保护政策

- 为教师和家长提供 Deepfake 识别培训

企业和品牌的 Cameo 使用合规

企业使用 Cameo 功能进行营销或内容创作时,面临额外的合规和法律责任。

员工同意和授权

合规要求:

- ✅ 必须获得员工的明确书面同意才能使用其面孔

- ✅ 同意书应明确说明使用目的、范围、期限

- ✅ 员工有权随时撤回同意

- ✅ 离职员工的 Cameo 数据应及时删除

同意书关键条款示例:

本人 [姓名] 明确同意 [公司名称] 使用本人的面部和声音特征,

通过 AI 技术(包括但不限于 OpenAI Sora 2 Cameo 功能)生成视频内容,

用于以下目的:

- 内部培训材料制作

- 对外营销视频创作(需进一步书面批准)

使用期限: [具体日期] 至 [具体日期]

本人有权在任何时候撤回本同意,撤回后公司应在30日内删除所有相关数据。

签名: __________ 日期: __________

代言人和公众人物

风险:

使用名人或代言人的 Cameo 进行营销,可能面临:

- 肖像权侵权诉讼

- 代言合同违约(如果未经授权使用 AI 生成内容)

- 品牌形象受损(如果 Deepfake 被识破)

合规建议:

✅ 在代言合同中明确包含"AI 生成内容"条款

✅ 对所有 Cameo 营销内容标注"AI 生成"或类似免责声明

✅ 购买相应的保险以覆盖潜在法律风险

✅ 咨询专业律师审查所有相关合同和内容

行业特殊合规要求

| 行业 | 特殊要求 | 监管机构 |

|---|---|---|

| 金融服务 | 必须符合 KYC/AML 规定,AI 生成内容可能不被接受用于身份验证 | SEC, FINRA, FCA 等 |

| 医疗健康 | 受 HIPAA 等隐私法保护,严格限制患者面部使用 | FDA, HHS |

| 教育 | FERPA 保护学生隐私,COPPA 保护儿童数据 | Department of Education |

| 媒体出版 | 新闻真实性标准,必须区分真实和 AI 生成内容 | FCC, 各国监管机构 |

技术防护工具推荐

除了政策和行为措施,技术工具可以提供额外的防护层。

1. Deepfake 检测工具

推荐工具:

- Microsoft Video Authenticator: 微软开发的 Deepfake 检测工具

- Sensity AI: 专业的 Deepfake 监测和检测平台

- Reality Defender: 实时 Deepfake 检测 API

- Deepware Scanner: 免费在线 Deepfake 扫描工具

使用场景:

- 验证收到的可疑视频真伪

- 企业定期扫描incoming视频通信

- 媒体机构验证新闻素材真实性

2. 数字水印和内容认证

技术方案:

- Content Authenticity Initiative (CAI): Adobe 领导的内容真实性标准

- C2PA: 联盟制定的内容来源和真实性认证协议

- 区块链时间戳: 使用区块链技术为内容生成不可篡改的时间证明

如何使用:

- 为您的真实视频内容添加 CAI 水印

- 生成加密签名证明内容来源

- 在视频元数据中嵌入 C2PA 证书

- 公开您的"真实内容库",以便他人验证

3. 隐私监控服务

推荐服务:

- Google Alerts: 免费监控您的名字和关键词

- Brandwatch: 社交媒体监控和品牌保护平台

- LifeLock: 身份盗窃保护和监控服务

- IDShield: 数字身份监控和恢复服务

设置建议:

- 监控关键词:"您的名字" + "Deepfake", "AI generated", "Cameo"

- 设置即时通知,快速响应潜在威胁

- 定期审查监控报告

4. 生物特征加密

技术原理:

将生物特征数据加密存储,只有授权应用可以在本地解密使用,云端不存储原始数据。

解决方案:

- Apple Face ID/Touch ID: 本地安全区域存储,不上传云端

- FIDO2: 使用生物特征进行身份验证,但不传输生物特征数据

- 同态加密: 允许在加密数据上进行计算,不需解密

未来趋势:

理想的 Cameo 功能应采用边缘计算模型:

- 特征提取在本地设备完成

- 只上传加密的特征向量,不上传原始视频

- 服务器端无法还原原始面孔

未来展望和监管趋势

法律和监管发展

全球 Deepfake 立法趋势:

-

美国:

- 联邦层面:DEEPFAKES Accountability Act(待通过)

- 州层面:加州、德州、弗吉尼亚等州已立法禁止恶意 Deepfake

- 重点:政治 Deepfake、色情 Deepfake、商业欺诈

-

欧盟:

- AI Act: 将 Deepfake 列为"高风险 AI 应用"

- 要求所有 AI 生成内容必须明确标识

- GDPR 扩展解释:生物特征数据受严格保护

-

中国:

- 《互联网信息服务深度合成管理规定》(2023)

- 要求 Deepfake 内容显著标识

- 服务提供者承担审核和管理责任

-

其他国家:

- 韩国:《深度伪造影像预防法》

- 澳大利亚:正在立法规范 Deepfake 的恶意使用

- 印度:信息技术法修正案纳入 Deepfake 条款

技术发展方向

Deepfake 检测技术:

- 生物信号检测: 分析心跳、眨眼、微表情等难以伪造的生理信号

- 区块链溯源: 为真实内容建立不可篡改的来源证明

- 对抗性训练: AI 模型持续学习识别最新的 Deepfake 技术

隐私保护技术:

- 联邦学习: 在不上传数据的情况下训练 AI 模型

- 差分隐私: 在数据中添加噪声,保护个人隐私

- 零知识证明: 验证身份而不暴露实际生物特征数据

行业自律和标准

主要倡议:

- Partnership on AI: 科技公司联盟制定 AI 伦理准则

- Content Authenticity Initiative (CAI): Adobe 等公司推动内容真实性标准

- Deepfake Detection Challenge: Facebook 等举办的检测技术竞赛

OpenAI 可能的未来改进:

- 更强的实时验证机制(活体检测)

- 更透明的数据使用政策

- 用户自主控制数据删除功能

- 强制性的"AI 生成"水印

- 与第三方 Deepfake 检测工具集成

总结与建议

核心要点回顾

- Cameo 功能是双刃剑: 革命性创新的同时带来严重隐私和安全风险

- 生物特征数据特殊性: 不可更改、唯一识别,泄露后果严重

- 5 大主要风险: 身份冒用、数据泄露、Deepfake 诈骗、AI 训练使用、跨境数据问题

- 7 个核心安全要点: 最小化使用、强化账号安全、优化隐私设置、水印标识、谨慎分享、定期审计、法律意识

- 特殊群体保护: 儿童、企业员工、公众人物需要额外防护

- 技术防护: 使用 Deepfake 检测、数字水印、隐私监控等工具

- 法律权利: 了解并主动行使数据访问权、删除权、投诉权

风险-收益决策框架

何时应该使用 Cameo?

✅ 您有明确的创作或商业目的

✅ 您理解并接受潜在风险

✅ 您已采取所有推荐的安全措施

✅ 您的使用场景不涉及敏感或可能被误解的内容

✅ 您有能力监控和应对潜在的滥用

何时不应使用 Cameo?

❌ 仅为"好玩"或测试功能

❌ 您不信任 OpenAI 的数据保护能力

❌ 您的职业或身份特别敏感(政治人物、安全部门、高管)

❌ 您无法承受身份冒用的风险

❌ 您所在的法律环境对生物特征数据保护不足

给不同用户群体的建议

个人用户:

- 优先使用其他创意工具(动画、虚拟形象)

- 只在必要时使用 Cameo,并采取全部 7 个核心要点

- 定期进行数字身份审计

- 教育家人识别 Deepfake 诈骗

内容创作者:

- 为所有 Cameo 内容添加明显的"AI 生成"标识

- 使用数字水印和区块链时间戳保护原创内容

- 建立真实内容库供粉丝验证

- 购买相应的法律和网络安全保险

企业用户:

- 制定明确的 Cameo 使用政策和员工培训计划

- 使用企业级隐私保护方案(如 API易 平台)

- 建立视频真实性验证流程

- 为高管和关键员工建立数字身份保护档案

- 购买包含 Deepfake 诈骗的网络安全保险

家长:

- ❌ 不要上传儿童视频到任何 AI 生成平台

- 限制儿童面孔在社交媒体的曝光

- 教育孩子关于数字身份安全

- 使用家长控制工具监控在线活动

持续关注和学习

推荐资源:

- OpenAI 安全博客: 关注官方安全更新和最佳实践

- AI Incident Database: 追踪 AI 相关的安全事件和案例

- 电子前沿基金会(EFF): 数字隐私权利倡导组织

- NIST AI 风险管理框架: 美国国家标准与技术研究院的 AI 安全指南

保持警惕:

- Cameo 功能和相关风险将持续演变

- 定期更新您的安全知识和防护措施

- 关注法律和监管的最新发展

- 参与社区讨论,分享经验和最佳实践

最后的话

Sora 2 的 Cameo 功能代表了 AI 视频生成技术的巨大飞跃,但"能力越大,责任越大"。作为用户,我们需要在享受技术便利的同时,保持高度的安全意识和隐私保护意识。

关键原则:

- 谨慎使用: 不是所有新功能都值得尝试

- 主动防护: 不要等到出问题才采取措施

- 持续学习: 技术和风险都在快速演变

- 集体行动: 通过社区和法律途径推动更好的保护机制

记住:

- 您的面孔和声音是您最私密的个人数据

- 一旦上传,就失去了完全的控制权

- 预防永远比补救更有效

- 您的数字身份安全掌握在您自己手中

🎯 最终建议: 对于需要使用 Sora 2 进行视频创作的用户,如果您对隐私和安全有较高要求,我们建议通过 API易 apiyi.com 平台使用 Sora 2 服务。该平台提供企业级的隐私保护方案,包括数据不用于训练、自主删除控制、完全加密存储、专用数据隔离以及专业的安全咨询服务。相比直接使用 OpenAI 官方服务,这是一个更安全、更可控的选择,特别适合企业用户和有严格隐私要求的个人创作者。

希望本指南能帮助您安全地探索 Sora 2 的创新功能,同时充分保护您的数字身份和隐私权利。

保持安全,保护隐私! 🔒

关键词: Sora 2 Cameo, Sora 2 隐私保护, Deepfake 防护, AI 视频安全, 生物特征数据保护, 数字身份安全, OpenAI 隐私, Cameo 安全使用

作者: APIYI 技术团队

更新日期: 2025-10-01

版本: v1.0