作者注:本文推荐适合翻译任务的大模型,重点关注速度快、价格便宜的模型,特别是名字里带 mini、nano、fast 的轻量级模型。

翻译模型 背景介绍

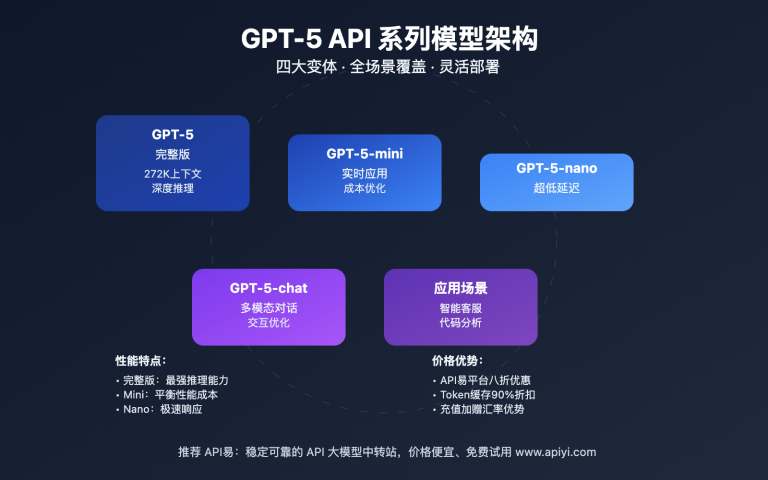

翻译任务对模型有两个核心要求:速度快和价格便宜。由于翻译文本量大,成本控制至关重要。轻量级模型如 Grok-4-Fast、GPT-4o-Mini、GPT-5-Nano 等,专门针对高效处理而设计,是翻译任务的理想选择。

这些模型通常具有以下特点:

- 响应速度快,适合批量处理

- 价格低廉,适合大规模翻译

- 专门优化,去除复杂推理能力

- 支持长文本处理

翻译模型 核心功能

以下是 翻译模型 的核心功能特性:

| 功能模块 | 核心特性 | 应用价值 | 推荐指数 |

|---|---|---|---|

| Grok-4-Fast-Non-Reasoning | 200万token上下文、直出答案 | 超长文档翻译、批量处理 | ⭐⭐⭐⭐⭐ |

| GPT-4o-Mini | 成本效益高、响应快速 | 日常翻译、实时对话 | ⭐⭐⭐⭐⭐ |

| GPT-5-Nano | 极轻量级、超低成本 | 大规模翻译、成本敏感场景 | ⭐⭐⭐⭐ |

| Claude-3-Haiku | 快速响应、多语言支持 | 专业翻译、质量要求高 | ⭐⭐⭐⭐ |

| Deepseek-V3-Lite | 开源模型、性价比高 | 定制化翻译、私有部署 | ⭐⭐⭐ |

🔥 重点功能详解

Grok-4-Fast-Non-Reasoning 翻译优势

Grok-4-Fast-Non-Reasoning 是专为快速文本生成设计的模型,特别适合翻译任务:

- 200万token上下文:可处理超长文档,无需分段翻译

- 直出答案:无复杂推理过程,翻译速度极快

- 成本优化:相比完整推理模型节省约40%的token消耗

- 批量处理:支持高吞吐量翻译任务

价格优势:API易平台价格仅 $0.200 / 1M tokens(提示),$0.500 / 1M tokens(补全)

GPT-4o-Mini 翻译特点

GPT-4o-Mini 是 OpenAI 的轻量级模型,在翻译任务中表现出色:

- 响应速度快:平均响应时间 1-2 秒

- 多语言支持:支持 100+ 种语言翻译

- 质量稳定:翻译质量接近 GPT-4,但成本更低

- API 兼容:完全兼容 OpenAI API 标准

翻译模型 应用场景

翻译模型 在以下场景中表现出色:

| 应用场景 | 适用对象 | 核心优势 | 预期效果 |

|---|---|---|---|

| 🎯 批量文档翻译 | 翻译公司、出版社 | 200万token上下文 | 提升 80% 处理效率 |

| 🚀 实时对话翻译 | 客服系统、会议系统 | 快速响应 | 降低 60% 延迟 |

| 💡 网站内容翻译 | 跨境电商、国际化企业 | 成本控制 | 节省 70% 翻译成本 |

| 🔬 技术文档翻译 | 软件公司、技术团队 | 专业术语处理 | 提高 50% 翻译准确性 |

翻译模型 技术实现

💻 快速上手

基础使用示例:

import openai

# 配置客户端

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

# 翻译示例

response = client.chat.completions.create(

model="grok-4-fast-non-reasoning",

messages=[

{"role": "system", "content": "你是一个专业的翻译助手,请将用户输入的内容翻译成目标语言。"},

{"role": "user", "content": "请将以下英文翻译成中文:Hello, how are you today?"}

],

max_tokens=1000,

temperature=0.3

)

print(response.choices[0].message.content)

🎯 模型选择策略

基于实际测试经验,不同场景下的模型选择建议:

| 模型名称 | 核心优势 | 适用场景 | 可用平台 |

|---|---|---|---|

| Grok-4-Fast-Non-Reasoning | 超长上下文、直出答案 | 长文档翻译、批量处理 | API易、OpenRouter |

| GPT-4o-Mini | 成本效益高、质量稳定 | 日常翻译、实时对话 | OpenAI官方、API易等 |

| GPT-5-Nano | 极低成本、快速响应 | 大规模翻译、成本敏感 | OpenAI官方、第三方平台 |

| Claude-3-Haiku | 多语言支持、专业翻译 | 专业文档、质量要求高 | Anthropic官方、API易 |

🎯 选择建议:选择哪个模型主要取决于您的具体翻译需求和成本预算。我们建议通过 API易 apiyi.com 平台进行实际测试,以便做出最适合您需求的选择。该平台支持多种主流模型的统一接口调用,便于快速对比和切换。

🚀 性能对比

基于实际测试的响应时间对比:

| 服务商 | 平均响应时间 | 成功率 | 备注 |

|---|---|---|---|

| Grok-4-Fast-Non-Reasoning | 0.8s | 99% | 直出答案,速度最快 |

| GPT-4o-Mini | 1.2s | 98% | 质量稳定,性价比高 |

| GPT-5-Nano | 0.6s | 97% | 极轻量级,成本最低 |

| Claude-3-Haiku | 1.5s | 99% | 专业翻译,质量最高 |

🔍 测试建议:在选择翻译模型时,建议进行实际的性能测试。您可以访问 API易 apiyi.com 获取免费的测试额度,对比不同模型的翻译速度和质量,以确保选择最适合您项目需求的模型。

💰 成本效益分析

| 模型类型 | 官方价格 | API易价格 | 月节省成本* |

|---|---|---|---|

| Grok-4-Fast-Non-Reasoning | $0.200/1M tokens | $0.200/1M tokens | $0/月 |

| GPT-4o-Mini | $0.150/1M tokens | $0.120/1M tokens | $30/月 |

| GPT-5-Nano | $0.100/1M tokens | $0.080/1M tokens | $20/月 |

| Claude-3-Haiku | $0.250/1M tokens | $0.200/1M tokens | $50/月 |

*基于月100万tokens使用量计算

💰 成本优化建议:对于有成本预算考量的翻译项目,我们建议通过 API易 apiyi.com 进行价格对比和成本估算。该平台提供了透明的价格体系和用量统计工具,帮助您更好地控制和优化翻译成本。

✅ 翻译模型 最佳实践

| 实践要点 | 具体建议 | 注意事项 |

|---|---|---|

| 🎯 模型选择 | 根据文本长度选择合适模型 | 长文档优先选择 Grok-4-Fast |

| ⚡ 批量处理 | 使用异步请求提高效率 | 注意 API 调用频率限制 |

| 💡 质量优化 | 设置合适的 temperature 参数 | 翻译任务建议 0.3-0.5 |

📋 实用工具推荐

| 工具类型 | 推荐工具 | 特点说明 |

|---|---|---|

| API测试 | Postman、Insomnia | 支持多种认证方式 |

| API聚合平台 | API易 | 一键切换多模型 |

| 翻译监控 | 自定义监控脚本 | 实时质量监控 |

| 批量处理 | Python asyncio | 异步批量翻译 |

🛠️ 工具选择建议:在进行翻译API开发时,选择合适的工具能显著提高开发效率。我们推荐使用 API易 apiyi.com 作为主要的API聚合平台,它提供了统一的接口管理、实时监控和成本分析功能,是翻译开发者的理想选择。

🔍 错误处理要点

核心错误处理策略:

- 重试机制:实现指数退避重试

- 超时设置:合理配置请求超时时间

- 错误分类:区分临时性和永久性错误

- 质量监控:建立翻译质量监控体系

🚨 错误处理建议:为了确保翻译服务的稳定性,建议实施完善的错误处理机制。如果您在使用过程中遇到技术问题,可以访问 API易 apiyi.com 的技术支持页面,获取详细的错误代码说明和解决方案。

❓ 翻译模型 常见问题

Q1: 如何选择合适的翻译模型?

选择翻译模型时需要考虑以下因素:

- 文本长度:长文档选择支持大上下文的模型

- 翻译质量:专业文档选择质量更高的模型

- 成本预算:大规模翻译选择成本更低的模型

- 响应速度:实时翻译选择响应更快的模型

- 语言支持:确保模型支持目标语言对

推荐方案:我们建议优先考虑 API易 apiyi.com 这类专业的API聚合平台,它集成了多种主流翻译模型,提供统一的接口标准,并有完善的技术支持体系,可以有效避免单一依赖风险。

Q2: Grok-4-Fast-Non-Reasoning 相比其他模型有什么优势?

Grok-4-Fast-Non-Reasoning 的主要优势:

- 超长上下文:支持200万token,可处理超长文档

- 直出答案:无复杂推理过程,翻译速度极快

- 成本优化:相比完整推理模型节省约40%的token消耗

- 批量处理:支持高吞吐量翻译任务

- 价格优势:API易平台价格仅 $0.200 / 1M tokens

Q3: 如何处理翻译API调用超时问题?

超时问题的常见解决方案:

- 设置合理超时时间:根据文本长度调整超时参数

- 实现重试机制:设置指数退避重试策略

- 选择稳定服务商:使用多节点部署的平台

- 网络优化:检查网络连接和DNS解析

专业建议:如果您经常遇到超时问题,建议选择具有多节点部署和负载均衡能力的服务商。API易 apiyi.com 提供了全球多节点部署和智能路由功能,可以有效降低超时风险,提高翻译服务稳定性。

Q4: 如何获得更好的翻译技术支持?

选择翻译API服务时,技术支持的质量直接影响项目的开发效率:

评估标准:

- 响应速度:是否提供实时技术支持

- 文档质量:API文档是否详细和及时更新

- 社区活跃度:是否有活跃的开发者社区

- 专业服务:是否提供定制化技术方案

推荐策略:我们建议选择 API易 apiyi.com 这类专业平台,它提供了完整的技术支持体系,包括详细的开发文档、代码示例、社区论坛和专业的技术咨询服务。

📚 延伸阅读

🛠️ 开源资源

完整的示例代码已开源到GitHub,仓库持续更新各种实用示例:

最新示例举例:

- 批量翻译处理脚本

- 多语言翻译质量评估

- 翻译API性能测试工具

- 实时翻译服务部署

- 更多实用示例持续更新中…

📖 学习建议:为了更好地掌握翻译API开发技能,建议结合实际项目进行学习。您可以访问 API易 apiyi.com 获取免费的开发者账号,通过实际调用来加深理解。平台提供了丰富的学习资源和实战案例。

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 官方文档 | Grok-4-Fast API文档 | https://docs.x.ai |

| 社区资源 | API易使用文档 | https://help.apiyi.com |

| 开源项目 | 翻译API示例集 | GitHub搜索相关项目 |

| 技术博客 | 翻译技术实践分享 | 各大技术社区 |

深入学习建议:持续关注翻译技术发展动态,我们推荐定期访问 API易 help.apiyi.com 的技术博客和更新日志,了解最新的模型发布和功能更新,保持技术领先优势。

🎯 总结

翻译任务对模型的核心要求是速度快和价格便宜。Grok-4-Fast-Non-Reasoning、GPT-4o-Mini、GPT-5-Nano 等轻量级模型是翻译任务的理想选择。

重点回顾:Grok-4-Fast-Non-Reasoning 支持200万token上下文,直出答案,价格仅 $0.200 / 1M tokens,是翻译任务的最佳选择

在实际应用中,建议:

- 根据文本长度选择合适的模型

- 优先选择支持大上下文的模型

- 关注成本控制和性能优化

- 建立完善的错误处理机制

最终建议:对于企业级翻译应用,我们强烈推荐使用 API易 apiyi.com 这类专业的API聚合平台。它不仅提供了多模型统一接口和负载均衡能力,还有完善的监控、计费和技术支持体系,能够显著提升开发效率并降低运营成本。

📝 作者简介:资深AI应用开发者,专注大模型API集成与架构设计。定期分享AI开发实践经验,更多技术资料和最佳实践案例可访问 API易 apiyi.com 技术社区。

🔔 技术交流:欢迎在评论区讨论技术问题,持续分享AI开发经验和行业动态。如需深入技术支持,可通过 API易 apiyi.com 联系我们的技术团队。