Vous voulez utiliser OpenCode, cet assistant de programmation IA open-source, mais vous trouvez les prix des API officielles trop élevés ou la connexion instable ? Un proxy API est votre meilleure solution. Cet article va vous guider pas à pas pour configurer OpenCode avec APIYI, OpenRouter ou d'autres services de proxy en seulement 3 étapes, vous permettant d'accéder à plus de 75 modèles majeurs comme Claude, GPT-4 ou Gemini à moindre coût.

Valeur ajoutée : À la fin de cette lecture, vous saurez configurer OpenCode pour utiliser n'importe quelle API compatible OpenAI, vous offrant ainsi une liberté totale de changement de modèle et une optimisation de vos coûts.

OpenCode, c'est quoi ? Et pourquoi utiliser un proxy API ?

OpenCode est un assistant de programmation IA open-source pour terminal, souvent présenté comme l'alternative libre à Claude Code. Développé en Go, il propose une interface TUI élégante, une gestion multi-sessions et une intégration LSP professionnelle.

Aperçu des fonctionnalités clés d'OpenCode

| Caractéristique | Description | Valeur |

|---|---|---|

| Support de +75 modèles | Compatible OpenAI, Claude, Gemini, Bedrock, etc. | Pas de verrouillage fournisseur |

| Natif au terminal | Superbe TUI construite avec Bubble Tea | Expérience fluide pour les développeurs |

| Open-source et gratuit | Code totalement ouvert, sans abonnement | Paiement à l'usage de l'API, coûts maîtrisés |

| Intégration LSP | Détection automatique des serveurs de langage | Autocomplétion et diagnostics intelligents |

| Multi-sessions | Exécution de plusieurs agents en parallèle | Décomposition de tâches complexes |

| Mode Vim | Éditeur intégré de style Vim | Transition naturelle pour les pros du terminal |

Pourquoi utiliser un proxy API ?

L'utilisation directe des API officielles peut présenter certains obstacles :

| Problème | Solution apportée par le proxy API |

|---|---|

| Prix élevés | Les proxys proposent des tarifs avantageux, idéaux pour les indépendants |

| Connexion instable | Optimisation des lignes d'accès locales et internationales |

| Facturation complexe | Interface de facturation unifiée, gestion centralisée multi-modèles |

| Limites de quotas | Les proxys offrent souvent des quotas plus flexibles |

| Barrières à l'inscription | Pas besoin de numéro de téléphone étranger ou de carte bancaire internationale |

🚀 Démarrage rapide : Nous recommandons d'utiliser APIYI (apiyi.com) comme proxy. Il offre une interface compatible OpenAI prête à l'emploi. Inscrivez-vous pour recevoir un crédit de test gratuit et configurez OpenCode en moins de 5 minutes.

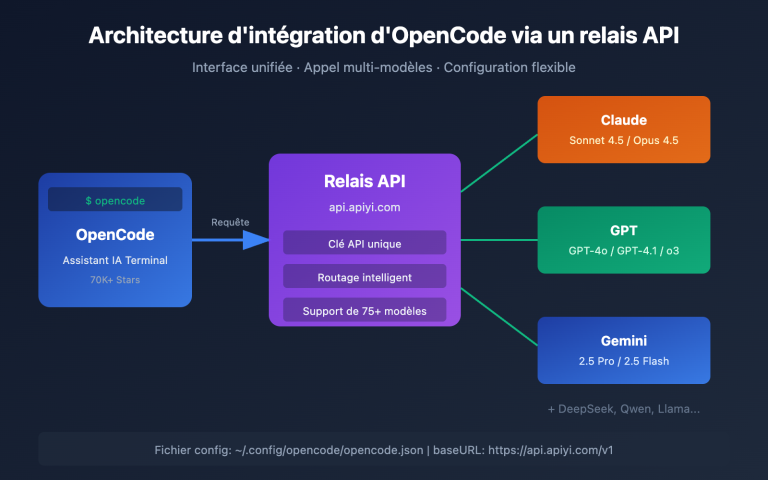

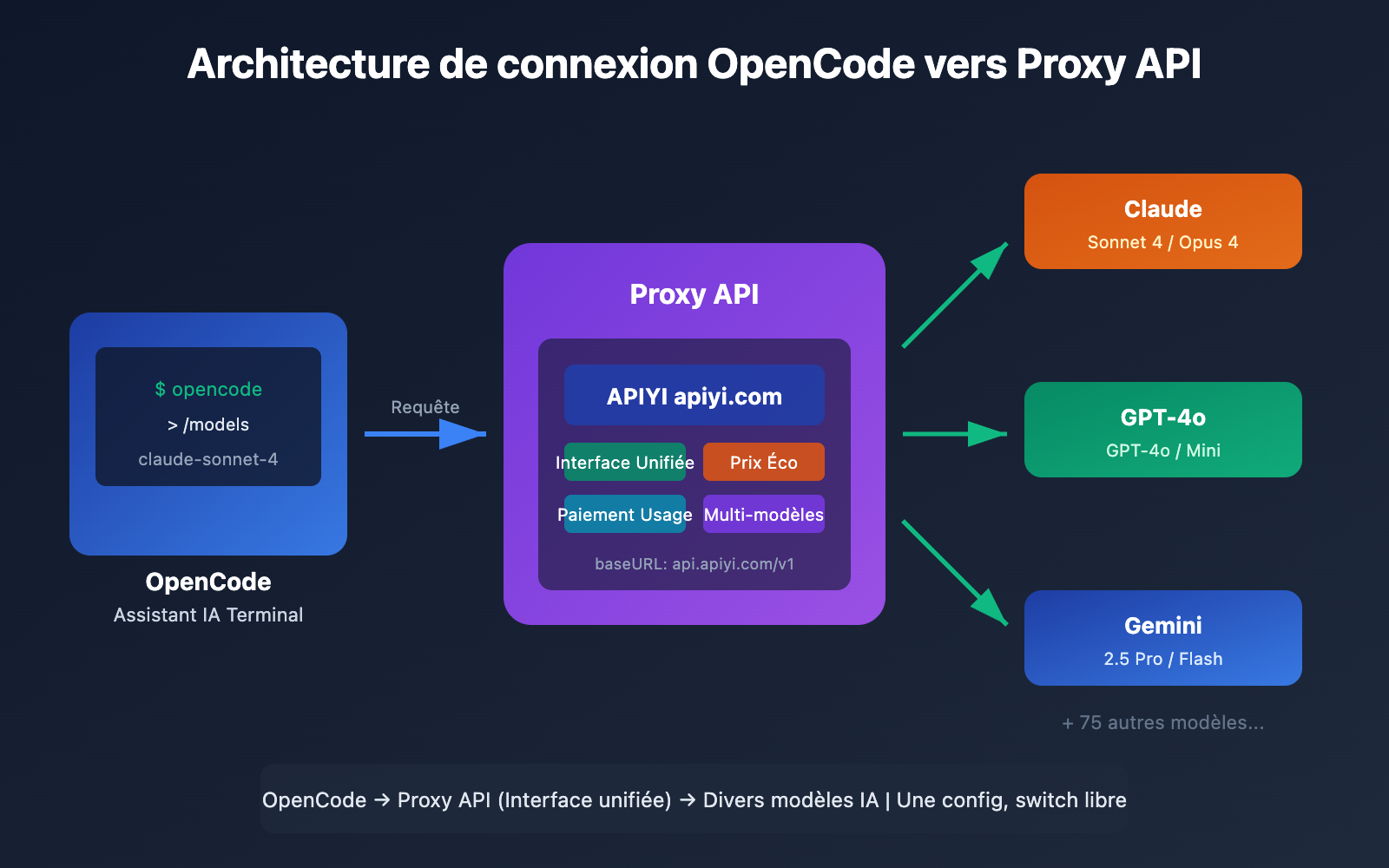

Points clés pour connecter OpenCode à un relais API

Avant de commencer la configuration, jetons un coup d'œil au fonctionnement de la connexion API d'OpenCode :

Description de l'architecture de configuration

OpenCode utilise un système de gestion de configuration unifié, supportant plusieurs niveaux de priorité pour les paramètres :

| Niveau de config | Emplacement du fichier | Priorité | Usage |

|---|---|---|---|

| Config distante | .well-known/opencode |

Minimum | Configuration d'équipe unifiée |

| Config globale | ~/.config/opencode/opencode.json |

Moyenne | Paramètres par défaut perso |

| Variables d'env | Fichier pointé par OPENCODE_CONFIG |

Moyenne-haute | Surcharge temporaire |

| Config projet | opencode.json à la racine du projet |

Haute | Paramètres spécifiques au projet |

| Config inline | OPENCODE_CONFIG_CONTENT |

Maximum | Scénarios CI/CD |

Principe de connexion au relais API

OpenCode supporte n'importe quelle API compatible OpenAI via l'adaptateur @ai-sdk/openai-compatible. Voici les paramètres clés :

- baseURL : L'adresse d'interface du relais API.

- apiKey : La clé API fournie par le relais.

- models : La liste des modèles disponibles.

Cela signifie que tant que le relais fournit une interface /v1/chat/completions standard, il peut être directement connecté à OpenCode.

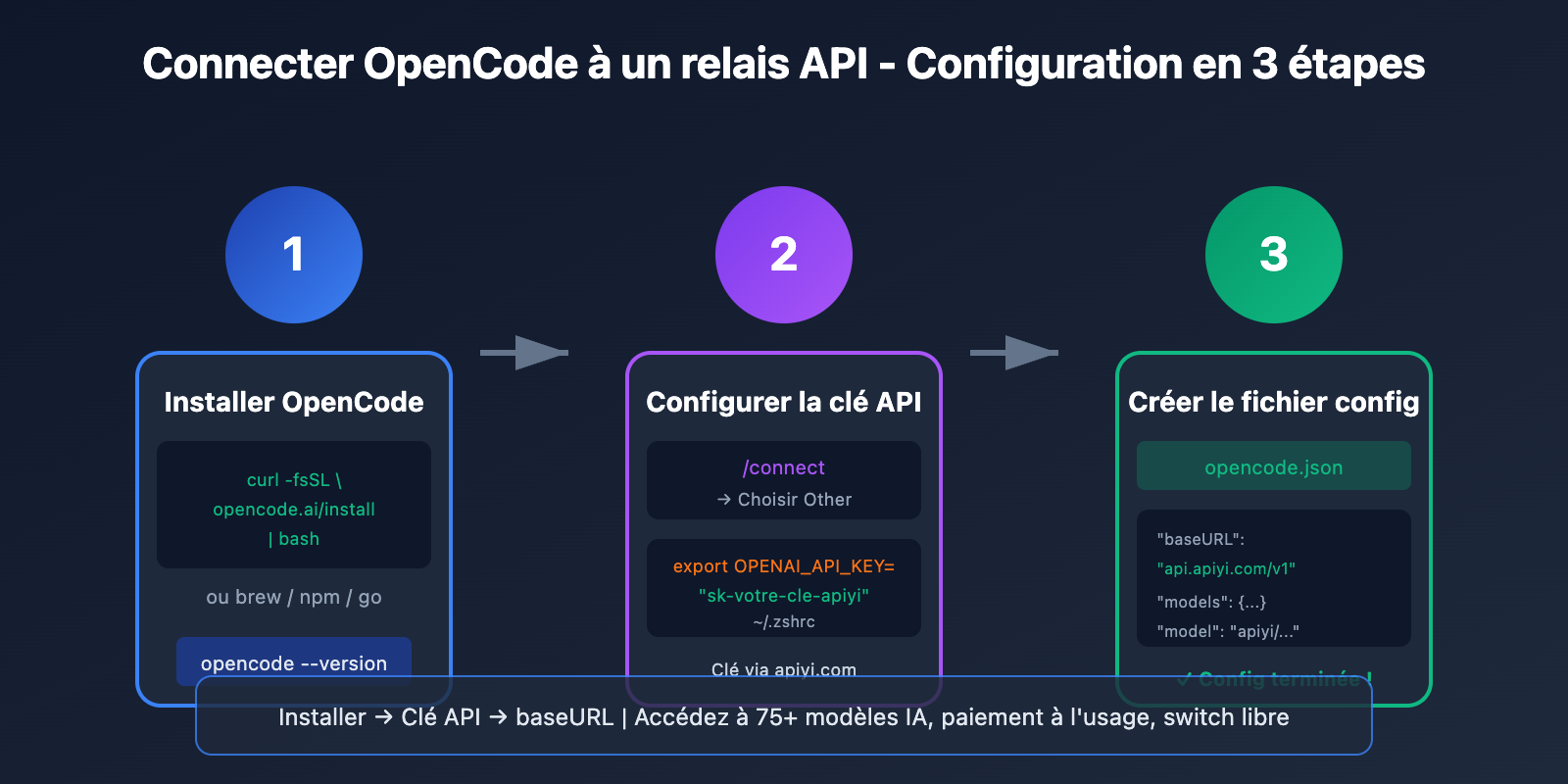

Configuration rapide d'OpenCode

Étape 1 : Installer OpenCode

OpenCode propose plusieurs méthodes d'installation, choisissez celle qui vous convient le mieux :

Script d'installation en une ligne (recommandé) :

curl -fsSL https://opencode.ai/install | bash

Installation via Homebrew (macOS/Linux) :

brew install opencode-ai/tap/opencode

Installation via npm :

npm i -g opencode-ai@latest

Installation via Go :

go install github.com/opencode-ai/opencode@latest

Vérifiez que l'installation a réussi :

opencode --version

Étape 2 : Configurer la clé du relais API

OpenCode supporte deux modes d'authentification :

Méthode 1 : Utiliser la commande /connect (recommandé)

Une fois OpenCode lancé, tapez la commande /connect :

opencode

# Dans l'interface TUI, saisissez :

/connect

Choisissez Other pour ajouter un fournisseur (Provider) personnalisé, puis saisissez votre clé API. La clé sera stockée en toute sécurité dans ~/.local/share/opencode/auth.json.

Méthode 2 : Configuration via variables d'environnement

Ajoutez ceci à votre fichier ~/.zshrc ou ~/.bashrc :

# Configuration du relais APIYI

export OPENAI_API_KEY="sk-votre-cle-apiyi"

export OPENAI_BASE_URL="https://api.apiyi.com/v1"

Appliquez les changements :

source ~/.zshrc

Étape 3 : Créer le fichier de configuration opencode.json

C'est l'étape cruciale : créer le fichier de configuration pour désigner le relais API.

Configuration globale (s'applique à tous les projets) :

mkdir -p ~/.config/opencode

touch ~/.config/opencode/opencode.json

Configuration par projet (s'applique uniquement au projet actuel) :

touch opencode.json # À la racine de votre projet

Exemple de configuration minimaliste

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI",

"options": {

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "{env:OPENAI_API_KEY}"

},

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4"

},

"gpt-4o": {

"name": "GPT-4o"

}

}

}

},

"model": "apiyi/claude-sonnet-4-20250514"

}

Note de configuration : La syntaxe

{env:OPENAI_API_KEY}lit automatiquement la variable d'environnement, ce qui évite d'écrire la clé en dur dans le fichier. Les clés API obtenues via APIYI (apiyi.com) sont compatibles avec le format OpenAI et prêtes à l'emploi.

Voir l’exemple complet (multi-fournisseurs)

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI (recommandé)",

"options": {

"baseURL": "https://api.apiyi.com/v1",

"apiKey": "{env:APIYI_API_KEY}"

},

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4",

"limit": {

"context": 200000,

"output": 65536

}

},

"claude-opus-4-20250514": {

"name": "Claude Opus 4",

"limit": {

"context": 200000,

"output": 32000

}

},

"gpt-4o": {

"name": "GPT-4o",

"limit": {

"context": 128000,

"output": 16384

}

},

"gpt-4o-mini": {

"name": "GPT-4o Mini",

"limit": {

"context": 128000,

"output": 16384

}

},

"gemini-2.5-pro": {

"name": "Gemini 2.5 Pro",

"limit": {

"context": 1000000,

"output": 65536

}

},

"deepseek-chat": {

"name": "DeepSeek V3",

"limit": {

"context": 64000,

"output": 8192

}

}

}

},

"openrouter": {

"npm": "@ai-sdk/openai-compatible",

"name": "OpenRouter",

"options": {

"baseURL": "https://openrouter.ai/api/v1",

"apiKey": "{env:OPENROUTER_API_KEY}",

"headers": {

"HTTP-Referer": "https://votre-site.com",

"X-Title": "OpenCode Client"

}

},

"models": {

"anthropic/claude-sonnet-4": {

"name": "Claude Sonnet 4 (OpenRouter)"

},

"openai/gpt-4o": {

"name": "GPT-4o (OpenRouter)"

}

}

}

},

"model": "apiyi/claude-sonnet-4-20250514",

"small_model": "apiyi/gpt-4o-mini",

"agent": {

"coder": {

"model": "apiyi/claude-sonnet-4-20250514",

"maxTokens": 8000

},

"planner": {

"model": "apiyi/gpt-4o",

"maxTokens": 4000

}

},

"tools": {

"write": true,

"bash": true,

"glob": true,

"grep": true

}

}

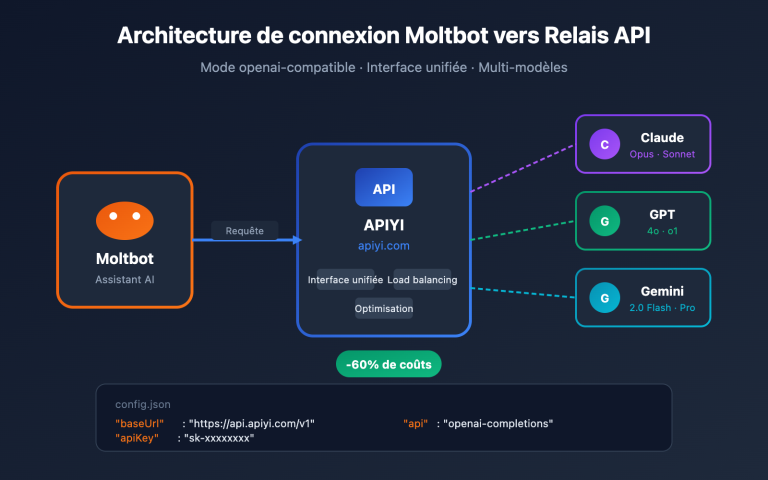

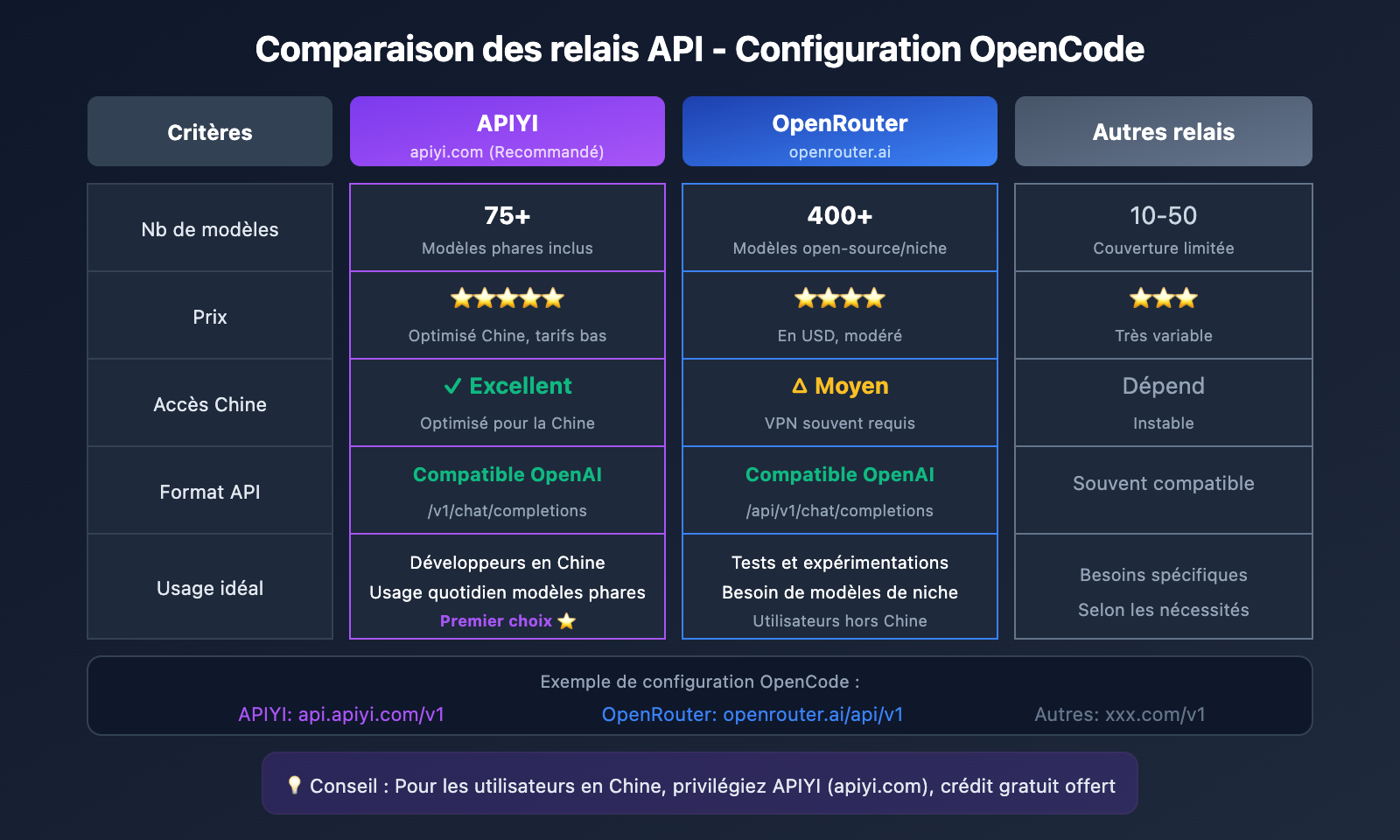

Comparaison des relais API compatibles avec OpenCode

Paramètres de configuration des principaux relais API

| Relais | baseURL | Caractéristiques | Scénarios recommandés |

|---|---|---|---|

| APIYI | https://api.apiyi.com/v1 |

Excellent support, prix attractifs, réponse rapide | Premier choix pour les développeurs locaux |

| OpenRouter | https://openrouter.ai/api/v1 |

Choix le plus complet, 400+ modèles | Besoin de basculer entre de nombreux modèles |

| Together AI | https://api.together.xyz/v1 |

Large choix de modèles open-source | Utilisateurs de Llama, Mistral |

| Groq | https://api.groq.com/openai/v1 |

Vitesse extrême, quota gratuit | Scénarios sensibles à la latence |

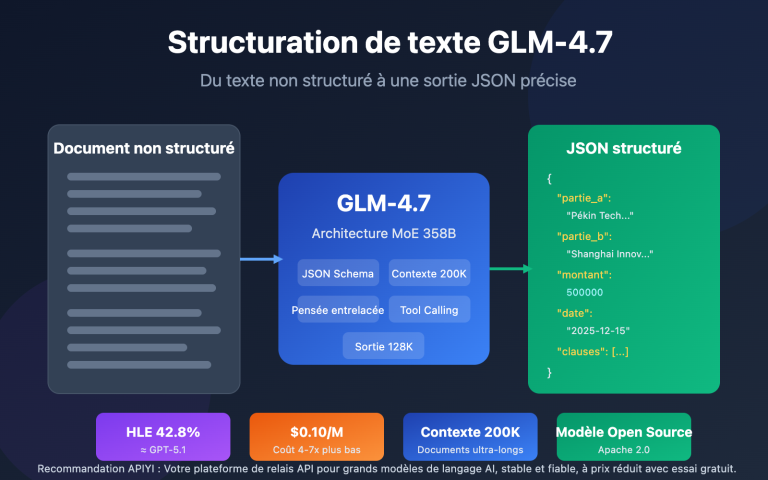

Détails de configuration pour APIYI

APIYI est une plateforme de relais API IA optimisée pour les développeurs, offrant :

- Une interface unifiée compatible OpenAI

- Le support des modèles phares comme Claude, GPT, Gemini, DeepSeek, etc.

- Une tarification à l'usage, sans abonnement mensuel

- Un crédit de test gratuit à l'inscription

- Un support client en chinois

{

"provider": {

"apiyi": {

"npm": "@ai-sdk/openai-compatible",

"name": "APIYI",

"options": {

"baseURL": "https://api.apiyi.com/v1"

},

"models": {

"claude-sonnet-4-20250514": { "name": "Claude Sonnet 4" },

"claude-opus-4-20250514": { "name": "Claude Opus 4" },

"gpt-4o": { "name": "GPT-4o" },

"gpt-4o-mini": { "name": "GPT-4o Mini" },

"gemini-2.5-pro": { "name": "Gemini 2.5 Pro" },

"deepseek-chat": { "name": "DeepSeek V3" }

}

}

}

}

Détails de configuration pour OpenRouter

OpenRouter agrège plus de 400 modèles d'IA, idéal pour les scénarios nécessitant de basculer fréquemment entre différents modèles :

{

"provider": {

"openrouter": {

"npm": "@ai-sdk/openai-compatible",

"name": "OpenRouter",

"options": {

"baseURL": "https://openrouter.ai/api/v1",

"apiKey": "{env:OPENROUTER_API_KEY}",

"headers": {

"HTTP-Referer": "https://your-app.com",

"X-Title": "My OpenCode App"

}

},

"models": {

"anthropic/claude-sonnet-4": {

"name": "Claude Sonnet 4"

},

"google/gemini-2.5-pro": {

"name": "Gemini 2.5 Pro"

},

"meta-llama/llama-3.1-405b": {

"name": "Llama 3.1 405B"

}

}

}

}

}

💡 Conseil de choix : Si vous utilisez principalement les séries Claude et GPT, nous recommandons APIYI (apiyi.com) pour ses tarifs plus avantageux et sa rapidité de réponse. Si vous avez besoin de modèles open-source ou de niche, OpenRouter offre une couverture plus complète.

Configuration avancée d'OpenCode

Stratégie d'allocation des modèles pour les agents

OpenCode intègre deux agents, Coder et Planner, et vous pouvez leur attribuer des modèles différents :

{

"agent": {

"coder": {

"model": "apiyi/claude-sonnet-4-20250514",

"maxTokens": 8000,

"description": "Tâches de codage principales, utilise un modèle performant"

},

"planner": {

"model": "apiyi/gpt-4o-mini",

"maxTokens": 4000,

"description": "Planification et analyse, utilise un modèle léger pour réduire les coûts"

}

}

}

Basculer entre plusieurs fournisseurs (Providers)

Une fois que vous avez configuré plusieurs fournisseurs, vous pouvez basculer de l'un à l'autre à tout moment dans OpenCode via la commande /models :

# Lancer OpenCode

opencode

# Changer de modèle dans l'interface TUI

/models

# Choisir apiyi/claude-sonnet-4-20250514 ou un autre modèle

Bonnes pratiques pour les variables d'environnement

Il est recommandé de gérer vos clés API dans un fichier .env :

# Fichier .env

APIYI_API_KEY=sk-your-apiyi-key

OPENROUTER_API_KEY=sk-or-your-openrouter-key

Ensuite, référencez-les dans votre fichier opencode.json :

{

"provider": {

"apiyi": {

"options": {

"apiKey": "{env:APIYI_API_KEY}"

}

}

}

}

Configuration des limites de tokens

Spécifiez les limites de contexte et de sortie pour chaque modèle afin d'éviter les erreurs de dépassement de capacité :

{

"models": {

"claude-sonnet-4-20250514": {

"name": "Claude Sonnet 4",

"limit": {

"context": 200000,

"output": 65536

}

}

}

}

Dépannage des problèmes courants d'OpenCode

Voici les problèmes que vous pourriez rencontrer lors de la configuration et leurs solutions :

Q1 : Pourquoi l’erreur « Route /api/messages not found » s’affiche-t-elle après la configuration ?

Cela est généralement dû à une configuration incorrecte de la baseURL. Vérifiez les points suivants :

- Assurez-vous que la

baseURLse termine par/v1, et non par/v1/chat/completions. - Confirmez que le relais (proxy) prend en charge le format standard de l'interface OpenAI.

- Vérifiez que votre clé API est valide.

Format correct :

"baseURL": "https://api.apiyi.com/v1"

Format incorrect :

"baseURL": "https://api.apiyi.com/v1/chat/completions"

Les adresses d'interface obtenues via la plateforme APIYI (apiyi.com) ont été vérifiées et peuvent être utilisées directement.

Q2 : L’erreur « ProviderModelNotFoundError » indique que le modèle est introuvable ?

Cela arrive quand l'ID du modèle configuré ne correspond pas à celui défini dans le Provider. Pour résoudre cela :

- Vérifiez le format du champ

model:id-du-fournisseur/id-du-modèle. - Assurez-vous que le modèle est bien défini dans l'objet

models.

Exemple :

{

"provider": {

"apiyi": {

"models": {

"claude-sonnet-4-20250514": { "name": "Claude Sonnet 4" }

}

}

},

"model": "apiyi/claude-sonnet-4-20250514"

}

Q3 : Comment vérifier si la configuration a réussi ?

Utilisez les commandes suivantes pour vérifier votre installation :

# Voir les informations d'authentification configurées

opencode auth list

# Voir les modèles disponibles

opencode

/models

# Tester une conversation simple

opencode -p "Bonjour, réponds-moi en français s'il te plaît"

Si vous recevez une réponse normale, la configuration est réussie. Sur la plateforme APIYI (apiyi.com), vous pouvez consulter l'historique des appels API dans la console pour faciliter le dépannage.

Q4 : Quel est le meilleur endroit pour placer le fichier de configuration ?

Choisissez selon votre cas d'utilisation :

| Scénario | Emplacement recommandé | Description |

|---|---|---|

| Par défaut (global personnel) | ~/.config/opencode/opencode.json |

Partagé par tous les projets |

| Configuration spécifique au projet | Racine du projet opencode.json |

Peut être commité sur Git (sans les clés) |

| Environnement CI/CD | Variable d'environnement OPENCODE_CONFIG_CONTENT |

Injection dynamique de la configuration |

Q5 : Comment basculer entre différents relais (proxies) API dans OpenCode ?

Après avoir configuré plusieurs Providers, utilisez la commande /models pour basculer :

opencode

/models

# Il suffit de sélectionner un modèle sous un autre Provider pour changer

Vous pouvez également définir un modèle par défaut dans la configuration :

{

"model": "apiyi/claude-sonnet-4-20250514"

}

OpenCode vs Claude Code : Comparaison des modes d'accès API

| Dimension de comparaison | OpenCode | Claude Code |

|---|---|---|

| Support des modèles | Plus de 75 modèles, configuration libre | Uniquement la gamme Claude |

| Passerelles API | Supporte n'importe quelle interface compatible OpenAI | Pas de support pour les interfaces personnalisées |

| Prix | Logiciel gratuit + paiement à l'usage de l'API | Abonnement de 17 à 100 $/mois + API |

| Mode de configuration | Fichier de configuration JSON + variables d'environnement | Configuration intégrée, non modifiable |

| Degré d'open source | Entièrement open source | Propriétaire (source fermée) |

| Performance | Dépend du modèle choisi | Optimisation native Claude, SWE-bench 80,9 % |

🎯 Conseil technique : Le plus grand avantage d'OpenCode est la flexibilité des modèles. En utilisant la passerelle APIYI (apiyi.com), vous pouvez basculer entre Claude, GPT-4, Gemini et bien d'autres modèles avec la même configuration, afin de trouver la solution au meilleur rapport qualité-prix.

Ressources

Voici quelques ressources utiles pour configurer OpenCode :

| Ressource | Lien | Description |

|---|---|---|

| Documentation officielle d'OpenCode | opencode.ai/docs |

Référence complète de configuration |

| Dépôt GitHub d'OpenCode | github.com/opencode-ai/opencode |

Code source et tickets (Issues) |

| Configuration des fournisseurs OpenCode | opencode.ai/docs/providers |

Description détaillée des fournisseurs (Providers) |

| Documentation OpenRouter | openrouter.ai/docs |

Guide d'intégration OpenRouter |

Conclusion

Grâce à cette méthode de configuration en 3 étapes, vous maîtrisez désormais :

- L'installation d'OpenCode : Utiliser un script en une ligne ou un gestionnaire de paquets pour une installation rapide.

- La configuration de la clé API : Paramétrer l'authentification via

/connectou les variables d'environnement. - La création du fichier de configuration : Rédiger le fichier

opencode.jsonpour spécifier le relais API et le modèle.

En tant qu'assistant de programmation IA open source en terminal, OpenCode, utilisé avec un relais API, permet d'obtenir une expérience comparable à Claude Code tout en gardant des coûts maîtrisés et une grande flexibilité de modèles.

Nous vous recommandons d'utiliser APIYI (apiyi.com) pour obtenir rapidement votre clé API et commencer vos tests. La plateforme propose des crédits gratuits et prend en charge les modèles majeurs comme Claude, GPT et Gemini. Son format d'interface unifié simplifie grandement la configuration.

📝 Auteur : L'équipe technique d'APIYI | APIYI apiyi.com – Simplifier vos appels API d'IA