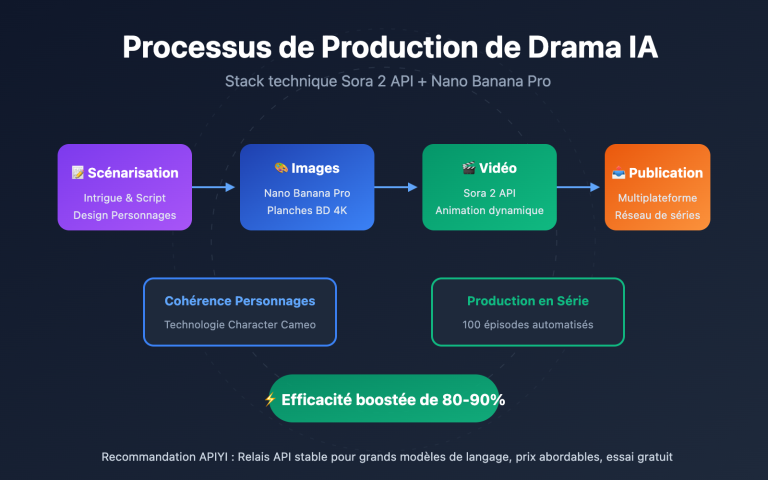

Note de l'auteur : Analyse approfondie du flux de travail complet pour la production en série de drames AI, avec une présentation détaillée de l'utilisation de Sora 2 Character Cameo et de la sortie 4K de Veo 3.1 pour une production efficace.

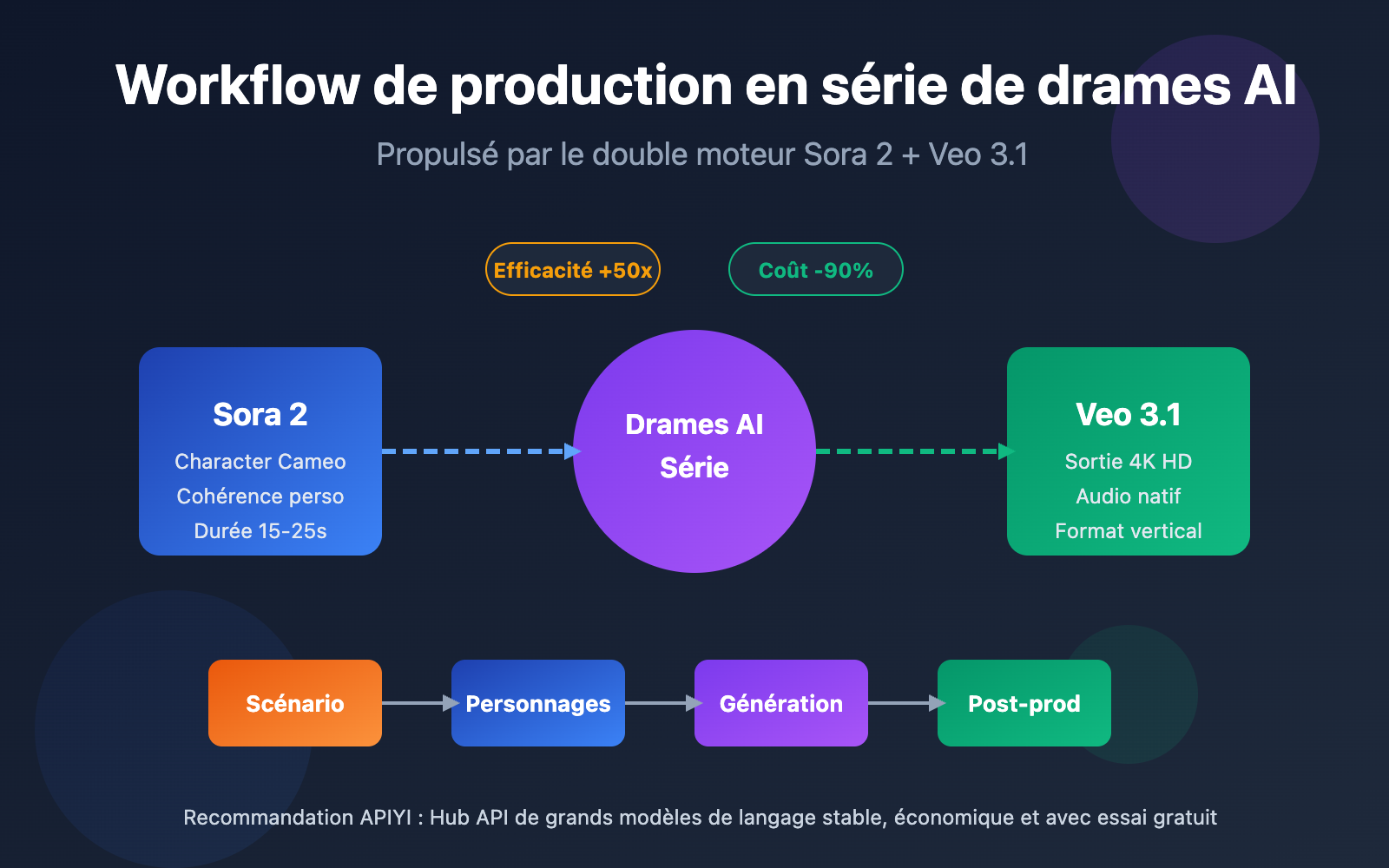

Le drame AI devient la nouvelle tendance phare dans le domaine de la création de contenu. Comment exploiter Sora 2 et Veo 3.1 pour construire un flux de travail de production en série efficace est la question centrale que tout créateur explore aujourd'hui.

Valeur ajoutée : En lisant cet article, vous maîtriserez le flux de travail complet de production de drames AI, apprendrez à utiliser Sora 2 Character Cameo pour maintenir la cohérence des personnages, et découvrirez des techniques concrètes pour produire des vidéos verticales 4K avec Veo 3.1.

Valeur ajoutée et opportunités du marché de la production en série de drames AI

La production en série de drames AI redéfinit les limites de l'efficacité dans la création de contenu. Là où la production traditionnelle exigeait une main-d'œuvre importante pour le dessin et l'animation, Sora 2 et Veo 3.1 permettent à une équipe d'une seule personne d'atteindre un niveau de production industriel.

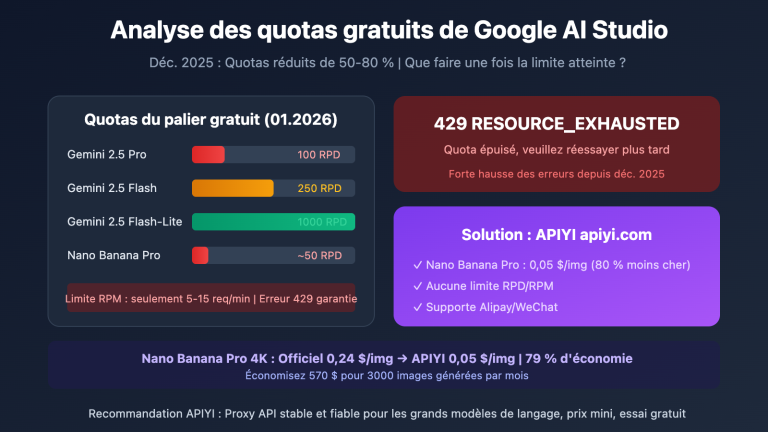

| Critères de comparaison | Production traditionnelle | Production AI en série | Gain d'efficacité |

|---|---|---|---|

| Cycle de production par épisode | 7-14 jours | 2-4 heures | 50-80 fois |

| Cohérence des personnages | Dépend du talent de l'artiste | Automatisation via API | 100% cohérent |

| Génération de décors | Dessin image par image | Génération par lots | 20-50 fois |

| Investissement (coût) | ~1000€+ / épisode | ~10€ / épisode | Réduction de 90% |

| Capacité maximale | 2-4 épisodes / mois | 50-100 épisodes / mois | 25 fois |

Les trois piliers de la production en série de drames AI

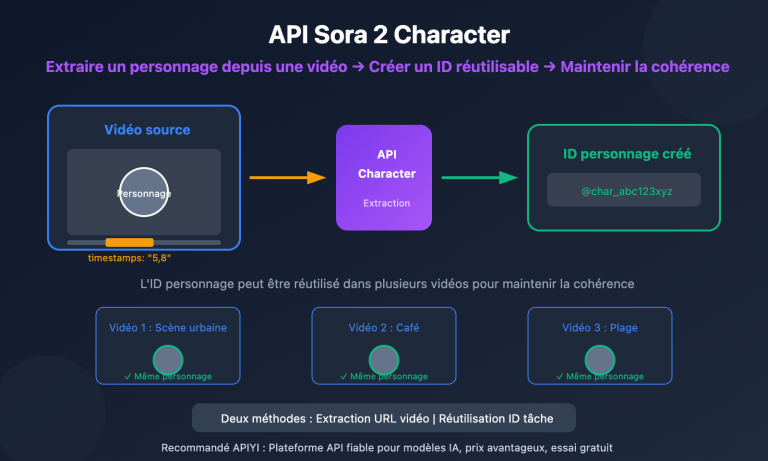

Premièrement, la percée technologique de la cohérence des personnages. La fonction Character Cameo de Sora 2 permet de créer des ID de personnages réutilisables, garantissant que le même personnage conserve exactement les mêmes traits physiques à travers différentes scènes. Cela résout le problème majeur du "changement de visage" rencontré auparavant dans la génération vidéo par IA.

Deuxièmement, la standardisation du flux de production. Grâce aux interfaces API, les créateurs peuvent intégrer l'analyse du scénario, la génération d'invites, la création vidéo et le montage final dans une ligne de production automatisée. Le temps de génération pour 20 à 50 scènes peut être réduit de plusieurs heures à moins d'une heure.

Troisièmement, la flexibilité de l'adaptation multi-plateforme. Veo 3.1 supporte nativement la génération de vidéos verticales, permettant de sortir directement du contenu au format 9:16 adapté à TikTok, Instagram Reels ou YouTube Shorts, sans nécessiter de recadrage ultérieur.

🎯 Conseil pratique : La production en série de drames AI nécessite un environnement d'appel API stable. Nous vous recommandons d'utiliser APIYI (apiyi.com) pour accéder aux interfaces unifiées de Sora 2 et d'autres modèles vidéo majeurs, facilitant ainsi la soumission de tâches par lots et l'optimisation des coûts.

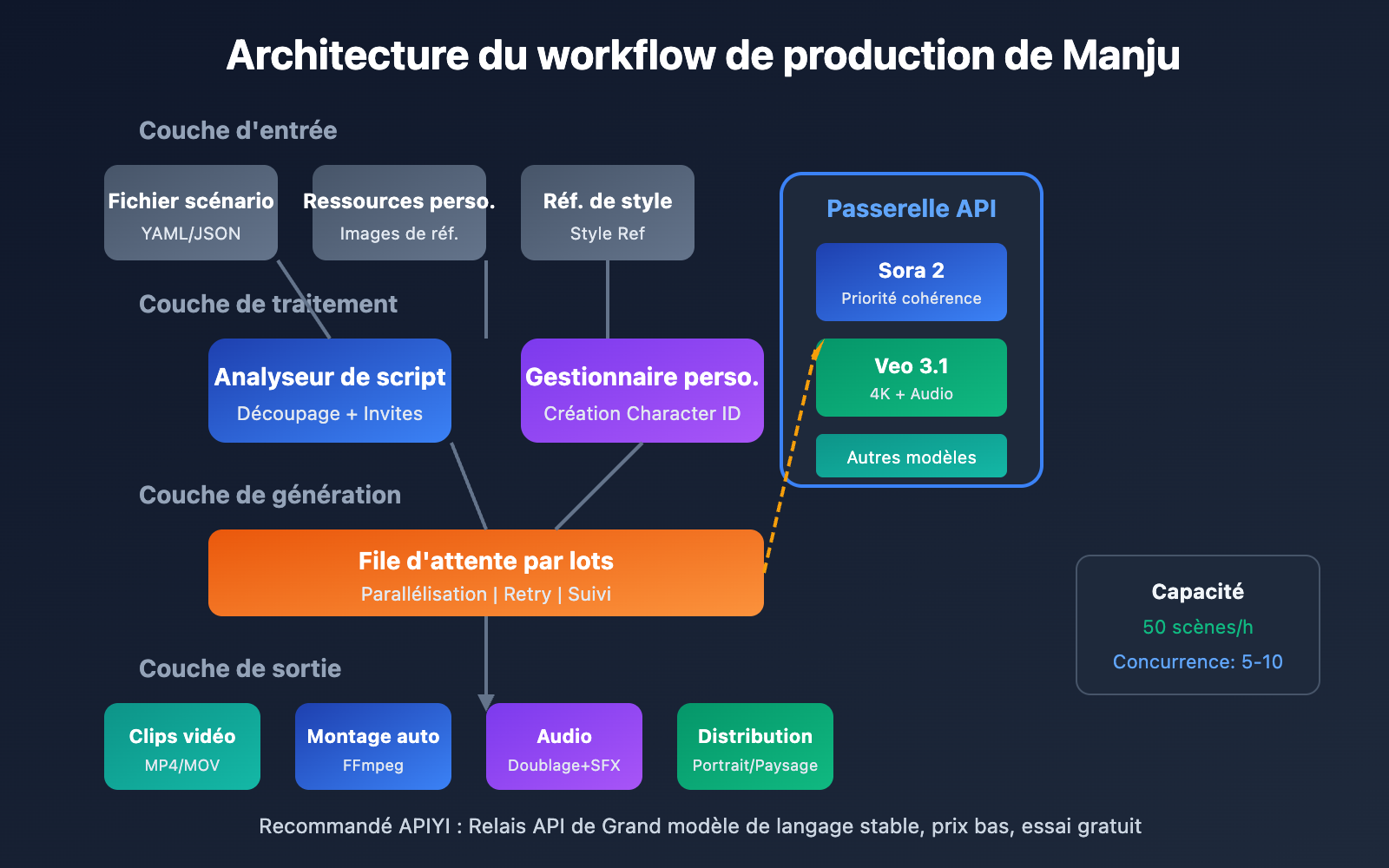

Analyse complète du workflow de production de Manju

Le workflow complet de production d'un Manju (série de bande dessinée animée) peut être divisé en cinq phases clés, chacune ayant des entrées, des sorties et des points techniques bien définis.

Phase 1 du workflow : Planification du scénario et conception du storyboard

Le point de départ du workflow de production de Manju est un scénario structuré. Contrairement aux scénarios traditionnels, un scénario de Manju par IA nécessite des descriptions visuelles détaillées pour chaque plan.

| Éléments du scénario | Écriture traditionnelle | Écriture pour le workflow Manju par IA | Utilité |

|---|---|---|---|

| Description de la scène | Dans un café | Café moderne et minimaliste, baies vitrées, lumière du soleil d'après-midi, tons chauds | Base pour la génération visuelle |

| Actions des personnages | Xiao Ming boit un café | Homme aux cheveux noirs, chemise blanche, tenant une tasse de café de la main droite, souriant en regardant par la fenêtre | Garantit que l'action est générable |

| Langage cinématographique | Gros plan | Plan moyen rapproché, profil à 45 degrés, arrière-plan avec flou de profondeur (bokeh) | Guide la composition de l'image |

| Durée | Aucune | 8 secondes | Paramétrage de l'API |

Exemple de format de script de storyboard :

episode: 1

title: "初次相遇"

total_scenes: 12

characters:

- id: "char_001"

name: "小雨"

description: "20岁女性,黑色长发,白色连衣裙"

- id: "char_002"

name: "阿明"

description: "22岁男性,短发,休闲西装"

scenes:

- scene_id: 1

duration: 6

setting: "城市街道,傍晚,霓虹灯初亮"

characters: ["char_001"]

action: "小雨独自走在街道上,低头看手机"

camera: "跟随镜头,中景"

Phase 2 du workflow : Création des ressources de personnages

La cohérence des personnages est le défi central de la production de masse de Manju. Sora 2 et Veo 3.1 proposent chacun des solutions différentes.

Méthode de création de personnage avec Sora 2 :

- Préparer des images de référence du personnage (face, profil, plein pied).

- Télécharger les éléments de référence via la Character API.

- Obtenir un Character ID réutilisable.

- Référencer cet ID lors de la génération des scènes suivantes.

Méthode de maintien du personnage avec Veo 3.1 :

- Télécharger plusieurs images de référence du personnage.

- Utiliser la fonction "style reference" pour verrouiller le style.

- Décrire précisément les caractéristiques du personnage dans l'invite.

- Maintenir la cohérence grâce à la génération continue.

Conseil technique : Il est recommandé de créer 3 à 5 images de référence sous différents angles pour les personnages principaux ; cela améliore considérablement la précision de compréhension du modèle d'IA concernant les traits du personnage.

Phase 3 du workflow : Génération vidéo par lots

C'est l'étape technique la plus cruciale du workflow. L'envoi groupé de tâches via API permet d'augmenter massivement la capacité de production.

Stratégies de génération par lots :

- Génération parallèle : Soumettre simultanément les requêtes de génération pour plusieurs scènes.

- Gestion des priorités : Générer d'abord les scènes clés pour permettre des ajustements rapides.

- Retours sur échec : Détecter automatiquement les tâches ayant échoué et les soumettre à nouveau.

- Validation des résultats : Filtrer automatiquement les sorties conformes aux standards de qualité.

Phase 4 du workflow : Montage post-production et audio

Les clips vidéo générés doivent être assemblés et agrémentés d'audio.

| Étape de post-prod | Outils recommandés | Part du temps | Degré d'automatisation |

|---|---|---|---|

| Assemblage vidéo | FFmpeg / Premiere | 15% | Entièrement automatisable |

| Effets de transition | After Effects | 10% | Semi-automatisé |

| Doublage et musique | Eleven Labs / Suno | 25% | Entièrement automatisable |

| Ajout de sous-titres | Whisper + Aegisub | 15% | Entièrement automatisable |

| Étalonnage et sortie | DaVinci Resolve | 20% | Semi-automatisé |

| Contrôle qualité (CQ) | Révision humaine | 15% | Intervention humaine requise |

Phase 5 du workflow : Distribution multi-plateforme

Exporter les fichiers vidéo selon les spécifications requises par chaque plateforme.

- TikTok / Douyin : Format 9:16 vertical, 1080×1920, moins de 60 secondes.

- YouTube / Bilibili : Format 16:9 paysage, 1920×1080, pas de limite de durée.

- Instagram / Xiaohongshu : Format 3:4 ou 9:16, focus sur l'attractivité de la couverture.

- WeChat Channels : Supporte plusieurs ratios, 9:16 recommandé.

🎯 Conseil d'efficacité : Utiliser l'interface unifiée d'APIYI (apiyi.com) permet d'appeler simultanément plusieurs modèles vidéo et de choisir le meilleur selon la scène, équilibrant ainsi coût et qualité.

L'utilisation centrale de Sora 2 dans la production de drames animés

Sora 2 est le grand modèle de langage vidéo lancé par OpenAI, et sa fonctionnalité Character Cameo est le pilier technique essentiel pour la production de masse de drames animés (vidéos narratives basées sur des mangas/manhuas).

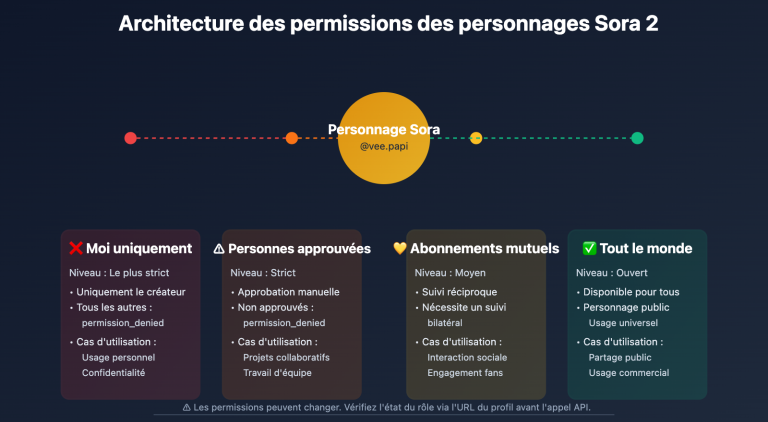

La technologie de cohérence des personnages Sora 2 Character Cameo

Character Cameo permet de créer des identités de personnages réutilisables, garantissant qu'un même personnage conserve une apparence identique à travers différentes scènes.

Deux façons de créer un ID de personnage :

Méthode 1 : Extraction à partir d'une vidéo existante

import requests

# Extraire les caractéristiques du personnage à partir de l'URL d'une vidéo

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/extract",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"video_url": "https://example.com/character_reference.mp4",

"character_name": "protagonist_male"

}

)

character_id = response.json()["character_id"]

Méthode 2 : Création à partir d'images de référence

# Créer un personnage à partir d'images de référence sous plusieurs angles

# Le paramètre "description" utilise une invite pour définir le personnage

response = requests.post(

"https://vip.apiyi.com/v1/sora/characters/create",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"images": [

"base64_front_view...",

"base64_side_view...",

"base64_full_body..."

],

"character_name": "protagonist_female",

"description": "20岁亚洲女性,黑色长发,温柔气质"

}

)

Application de la fonction Image-to-Video de Sora 2 dans la production de drames animés

La fonction Image-to-Video de Sora 2 permet de transformer des cases de BD statiques en vidéos dynamiques, une étape cruciale dans le flux de travail de production.

| Scénario Image-to-Video | Prérequis d'entrée | Résultat obtenu | Cas d'utilisation |

|---|---|---|---|

| Dynamisation d'image unique | Image statique HD | Vidéo dynamique de 6 à 15 s | Couvertures, transitions |

| Expressions et mouvements | Gros plan du personnage | Ajout de micro-expressions (clignement, sourire) | Scènes de dialogue |

| Extension de scène | Image partielle | Zoom/dézoom, extension de l'environnement | Établissement du plan |

| Conversion de style | N'importe quelle image | Passage au style animé/réaliste | Uniformisation du style |

Meilleures pratiques pour la génération de drames animés avec Sora 2

Modèle structuré d'invite :

[Description du sujet] + [Action/Comportement] + [Scène/Environnement] + [Langage cinématographique] + [Spécification du style]

Exemple :

"Une jeune fille aux cheveux noirs (character_id: char_001) assise au bord de la fenêtre d'un café,

remuant doucement sa tasse de café, la lumière du soleil entrant par la baie vitrée, tons chauds,

plan moyen-rapproché, faible profondeur de champ, style animé japonais, couleurs douces"

Paramètres de génération recommandés :

- Durée : 6 à 10 secondes par plan, pour faciliter le montage ultérieur.

- Résolution : 1080p en priorité, pour un bon équilibre entre qualité et coût.

- Préréglage de style : Utilisez le préréglage "Comic" pour obtenir un style manga plus stable.

🎯 Conseil pour l'appel API : Pour les appels en masse via l'API Sora 2, nous vous recommandons de passer par APIYI (apiyi.com). Le service prend en charge la gestion des files d'attente et les tentatives automatiques, augmentant ainsi le taux de succès de vos générations groupées.

L'utilisation centrale de Veo 3.1 dans la production de drames animés

Veo 3.1 est le dernier modèle de génération vidéo de Google DeepMind. Il présente des avantages uniques pour la production de masse de contenus narratifs visuels.

Sortie 4K et avantages de qualité d'image de Veo 3.1

Veo 3.1 apporte une amélioration significative de la qualité d'image et de la stabilité par rapport à la génération précédente, ce qui le rend idéal pour les projets de drames animés nécessitant une sortie haute définition.

| Version de Veo | Résolution max | Support Audio | Cohérence des personnages | Vitesse de génération |

|---|---|---|---|---|

| Veo 2 | 1080p | Non | Moyenne | Rapide |

| Veo 3 | 4K | Audio natif | Bonne | Moyenne |

| Veo 3.1 | 4K | Audio amélioré | Excellente | 30-60 secondes |

Les avantages clés de Veo 3.1 :

- Génération audio native : Peut générer simultanément des effets sonores, des sons d'ambiance et même des dialogues.

- Cohérence des personnages renforcée : La fonction de téléchargement de plusieurs images de référence améliore considérablement la stabilité visuelle.

- Support natif du format vertical : Génère directement des vidéos au format 9:16, parfaitement adaptées aux plateformes de vidéos courtes (TikTok, Reels).

- Contrôle précis du style : Contrôle exact du style de sortie via une image de référence ("style reference").

Application de la génération vidéo verticale de Veo 3.1

Les contenus de drames animés pour les réseaux sociaux nécessitent un format vertical. Le support natif de Veo 3.1 évite les pertes de qualité d'image liées au recadrage manuel.

Méthode de génération verticale :

# Déclenchement de la génération verticale via le téléchargement d'une image de référence verticale

response = requests.post(

"https://vip.apiyi.com/v1/veo/generate",

headers={"Authorization": "Bearer YOUR_API_KEY"},

json={

"prompt": "Style animé, jeune fille aux cheveux noirs sous un cerisier en fleurs, la brise fait bouger ses cheveux, atmosphère esthétique",

"reference_image": "vertical_reference_9_16.jpg",

"duration": 8,

"with_audio": True,

"audio_prompt": "Musique de fond douce au piano, bruissement des feuilles"

}

)

Technologie de contrôle des personnages par multi-références de Veo 3.1

Veo 3.1 permet de télécharger plusieurs images de référence pour guider la génération des personnages, des objets et des scènes, ce qui est crucial pour la cohérence d'une série animée.

Stratégie d'utilisation des images de référence :

- Images du personnage : 3 à 5 photos de référence du personnage sous différents angles.

- Images de la scène : 2 à 3 références pour le style des décors.

- Images de style : 1 à 2 images pour définir l'esthétique globale.

🎯 Conseil pour le choix du modèle : Optez pour Veo 3.1 lorsque vous avez besoin d'une qualité 4K et d'un audio natif. Choisissez Sora 2 pour une garantie de cohérence d'identité de personnage très poussée. La plateforme APIYI (apiyi.com) permet d'appeler ces deux modèles de manière unifiée, facilitant ainsi le passage de l'un à l'autre selon vos besoins.

Solution technique pour la production de masse de drames manga : Pratique de l'automatisation par API

L'automatisation du flux de production des drames manga est la clé pour booster votre productivité. Voici une solution technique complète pour mettre cela en œuvre.

Architecture du script d'automatisation pour la production de masse

import asyncio

from typing import List, Dict

class MangaDramaProducer:

"""Framework d'automatisation pour la production de masse de drames manga"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

async def batch_generate(

self,

scenes: List[Dict],

model: str = "sora-2"

) -> List[str]:

"""Génération par lots de vidéos de scènes"""

tasks = []

for scene in scenes:

task = self.generate_scene(scene, model)

tasks.append(task)

results = await asyncio.gather(*tasks)

return results

async def generate_scene(

self,

scene: Dict,

model: str

) -> str:

"""Génération d'une scène unique"""

# Construction de l'invite

prompt = self.build_prompt(scene)

# Appel de l'API

video_url = await self.call_api(prompt, model)

return video_url

Voir le code complet du script d’automatisation

import asyncio

import aiohttp

from typing import List, Dict, Optional

from dataclasses import dataclass

import json

@dataclass

class Scene:

"""Structure de données de la scène"""

scene_id: int

duration: int

setting: str

characters: List[str]

action: str

camera: str

dialogue: Optional[str] = None

@dataclass

class Character:

"""Structure de données du personnage"""

char_id: str

name: str

description: str

reference_images: List[str]

class MangaDramaProducer:

"""Framework complet de production de masse de drames manga"""

def __init__(self, api_key: str):

self.api_key = api_key

self.base_url = "https://vip.apiyi.com/v1"

self.characters: Dict[str, str] = {} # name -> character_id

async def create_character(

self,

character: Character

) -> str:

"""Créer un ID de personnage"""

async with aiohttp.ClientSession() as session:

async with session.post(

f"{self.base_url}/sora/characters/create",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"images": character.reference_images,

"character_name": character.char_id,

"description": character.description

}

) as resp:

result = await resp.json()

char_id = result["character_id"]

self.characters[character.name] = char_id

return char_id

def build_prompt(self, scene: Scene) -> str:

"""Construire l'invite de la scène"""

char_refs = []

for char_name in scene.characters:

if char_name in self.characters:

char_refs.append(

f"(character_id: {self.characters[char_name]})"

)

prompt_parts = [

scene.action,

f"Scène : {scene.setting}",

f"Plan : {scene.camera}",

"Style anime, haute qualité, riche en détails"

]

if char_refs:

prompt_parts.insert(0, " ".join(char_refs))

return ",".join(prompt_parts)

async def generate_scene(

self,

scene: Scene,

model: str = "sora-2",

with_audio: bool = False

) -> Dict:

"""Générer une seule scène"""

prompt = self.build_prompt(scene)

async with aiohttp.ClientSession() as session:

endpoint = "sora" if "sora" in model else "veo"

async with session.post(

f"{self.base_url}/{endpoint}/generate",

headers={"Authorization": f"Bearer {self.api_key}"},

json={

"prompt": prompt,

"duration": scene.duration,

"with_audio": with_audio

}

) as resp:

result = await resp.json()

return {

"scene_id": scene.scene_id,

"video_url": result.get("video_url"),

"status": result.get("status")

}

async def batch_generate(

self,

scenes: List[Scene],

model: str = "sora-2",

max_concurrent: int = 5

) -> List[Dict]:

"""Génération de scènes par lots"""

semaphore = asyncio.Semaphore(max_concurrent)

async def limited_generate(scene):

async with semaphore:

return await self.generate_scene(scene, model)

tasks = [limited_generate(s) for s in scenes]

results = await asyncio.gather(*tasks, return_exceptions=True)

# Gérer les tâches échouées

successful = []

failed = []

for i, result in enumerate(results):

if isinstance(result, Exception):

failed.append(scenes[i])

else:

successful.append(result)

# Réessayer les tâches échouées

if failed:

retry_results = await self.batch_generate(

failed, model, max_concurrent

)

successful.extend(retry_results)

return successful

# Exemple d'utilisation

async def main():

producer = MangaDramaProducer("votre_cle_api")

# Créer un personnage

protagonist = Character(

char_id="char_001",

name="Xiaoyu",

description="Femme de 20 ans, longs cheveux noirs, tempérament doux",

reference_images=["base64_img1", "base64_img2"]

)

await producer.create_character(protagonist)

# Définir les scènes

scenes = [

Scene(1, 8, "Rue de la ville au crépuscule", ["Xiaoyu"], "Marche seule en regardant son téléphone", "Plan moyen suivi"),

Scene(2, 6, "Intérieur d'un café", ["Xiaoyu"], "Assise près de la fenêtre en buvant un café", "Plan moyen-rapproché fixe"),

Scene(3, 10, "Banc de parc", ["Xiaoyu"], "Rêvasse devant le coucher du soleil", "Gros plan avec zoom lent")

]

# Génération par lots

results = await producer.batch_generate(scenes, model="sora-2")

print(json.dumps(results, indent=2, ensure_ascii=False))

if __name__ == "__main__":

asyncio.run(main())

Stratégies d'optimisation des coûts pour la production de masse

| Axe d'optimisation | Mesures concrètes | Économies prévues | Difficulté |

|---|---|---|---|

| Choix du modèle | Modèles low-cost pour les scènes simples | 30-50% | Faible |

| Contrôle de la résolution | Choisir 720p/1080p/4K selon le besoin | 20-40% | Faible |

| Remises sur volume | Utiliser une plateforme d'agrégation d'API | 10-20% | Faible |

| Réutilisation du cache | Réutiliser les résultats pour des scènes similaires | 15-25% | Moyenne |

| Optimisation de la durée | Contrôle précis de la durée de chaque plan | 10-15% | Moyenne |

🎯 Conseil pour le contrôle des coûts : APIYI (apiyi.com) propose une interface unifiée pour divers modèles vidéo, permettant de choisir différents niveaux de modèles selon les besoins. Combiné aux remises sur les tâches par lots, cela peut réduire efficacement le coût global de vos productions de drames manga.

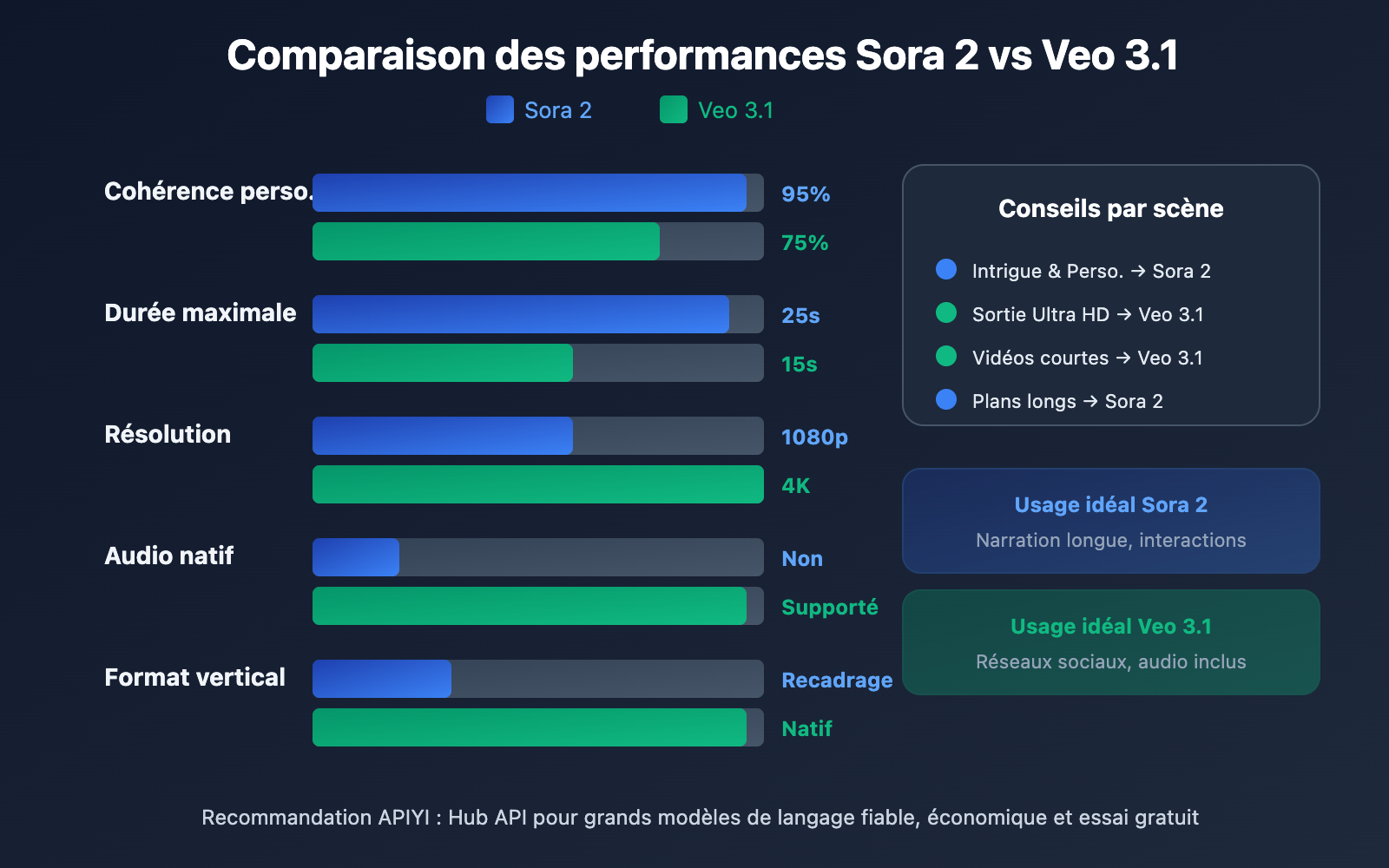

Sora 2 vs Veo 3.1 : Analyse comparative pour la production de drames manga

Choisir le bon modèle de génération vidéo est crucial pour le succès de votre production. Voici une comparaison détaillée des deux modèles phares.

Comparaison des capacités clés : Sora 2 vs Veo 3.1

| Dimension | Sora 2 | Veo 3.1 | Conseil de production |

|---|---|---|---|

| Durée max. | 15-25 s | 8-15 s | Sora 2 idéal pour les plans longs |

| Cohérence perso. | Support natif Character Cameo | Solution via images de réf. | Sora 2 est plus stable |

| Génération audio | Doublage séparé requis | Audio natif supporté | Veo 3.1 est plus efficace |

| Résolution | 1080p | 4K | Veo 3.1 offre une meilleure qualité |

| Format vertical | Post-recadrage requis | Support natif | Veo 3.1 mieux adapté aux mobiles |

| Styles préréglés | Préréglages Comic/Anime | Style Reference | Chacun ses avantages |

| Vitesse | Moyenne | 30-60s / clip | Veo 3.1 est légèrement plus rapide |

| Stabilité API | Haute | Haute | Tous deux prêts pour l'usage commercial |

Guide de sélection selon le type de scène

Quand choisir Sora 2 :

- Intrigues suivies nécessitant une cohérence stricte des personnages.

- Scènes narratives à plans longs (plus de 10 secondes).

- Interactions complexes entre les personnages.

- Si vous avez déjà un flux de travail de doublage mature.

Quand choisir Veo 3.1 :

- Recherche d'une qualité de sortie 4K Ultra HD.

- Contenus pour plateformes de vidéos courtes (TikTok, Reels, etc.).

- Besoin d'une sortie rapide incluant déjà l'audio natif.

- Projets principalement axés sur le format vertical.

Stratégie d'utilisation mixte :

Pour les grands projets de drames manga, il est recommandé de mixer les deux modèles selon les caractéristiques des scènes :

- Scènes de personnages clés → Sora 2 (pour garantir la cohérence).

- Plans d'ensemble et décors → Veo 3.1 (haute définition + effets sonores).

- Scènes de dialogue → Veo 3.1 (audio natif).

- Scènes d'action → Sora 2 (support des durées plus longues).

🎯 Conseil pour le basculement : Via l'interface unifiée d'APIYI (apiyi.com), vous pouvez passer de Sora 2 à Veo 3.1 au sein d'un même projet sans modifier la structure de votre code, simplement en changeant le paramètre du modèle.

Questions Fréquentes

Q1 : Lequel de Sora 2 ou Veo 3.1 est le plus adapté à la production en série de manga-dramas ?

Les deux présentent des avantages distincts. La fonction Character Cameo de Sora 2 est supérieure pour la cohérence des personnages, ce qui est idéal pour les intrigues suivies nécessitant des personnages fixes. De son côté, l'audio natif et la sortie 4K de Veo 3.1 sont plus adaptés aux projets de vidéos courtes privilégiant la qualité d'image et la rapidité de production. Il est conseillé de combiner les deux selon vos besoins spécifiques.

Q2 : Quel est le coût approximatif de la production en série de manga-dramas ?

En utilisant l'IA pour la production en série de manga-dramas, le coût d'un épisode (3 à 5 minutes) peut être maîtrisé dans une fourchette de 50 à 200 yuans, selon le nombre de scènes, la résolution choisie et la gamme du modèle. C'est une réduction de plus de 90 % par rapport à la production traditionnelle. En passant par des plateformes d'agrégation comme APIYI (apiyi.com), vous pouvez également bénéficier de remises supplémentaires sur les volumes.

Q3 : Comment démarrer rapidement la production en série de manga-dramas ?

Voici les étapes recommandées pour un démarrage rapide :

- Accédez à APIYI (apiyi.com) pour créer un compte et obtenir votre clé API.

- Préparez 2 ou 3 images de référence pour les personnages principaux.

- Rédigez un scénario de story-board structuré (commencez par 5 à 10 scènes).

- Utilisez les exemples de code fournis dans cet article pour effectuer des tests de génération.

- Ajustez vos invites et vos paramètres en fonction des résultats obtenus.

Q4 : Comment garantir la cohérence des personnages dans le flux de production ?

Les méthodes clés incluent : l'utilisation de Character Cameo sur Sora 2 pour créer un ID de personnage ; la préparation d'images de référence sous plusieurs angles pour chaque personnage ; le maintien d'une description de personnage constante dans vos invites ; et l'utilisation de préréglages de style fixes. Il est recommandé de générer 3 à 5 scènes de test pour vérifier la cohérence avant de lancer la production officielle.

Résumé

Points clés pour la production en série de manga-dramas :

- Standardisation du flux de travail : Établissez un flux complet, du scénario à la diffusion, avec des entrées et sorties claires pour chaque étape.

- Stratégie de sélection des modèles : Sora 2 pour la cohérence des personnages, Veo 3.1 pour la qualité d'image et l'audio ; basculez de l'un à l'autre selon la scène.

- Automatisation par lots : Soumettez vos tâches via API pour compresser le temps de génération de 50 scènes à moins d'une heure.

- Optimisation des coûts : Choisissez la résolution et la gamme de modèles selon vos besoins, et utilisez des plateformes d'agrégation pour obtenir des tarifs de gros.

La production de manga-dramas assistée par l'IA arrive rapidement à maturité. Maîtriser les capacités de Sora 2 et Veo 3.1 tout en instaurant un flux de production efficace est essentiel pour saisir cette opportunité de contenu.

Nous vous recommandons d'utiliser APIYI (apiyi.com) pour accéder à une interface API unifiée pour les modèles vidéo. La plateforme prend en charge les modèles phares comme Sora 2 et Veo 3.1, tout en offrant des crédits de test gratuits et un support technique.

Ressources

⚠️ Note sur le format des liens : Tous les liens externes utilisent le format

Nom de la ressource : domain.com, ce qui facilite le copier-coller tout en évitant les liens cliquables pour préserver le référencement (SEO).

-

Documentation officielle OpenAI Sora : Présentation des fonctionnalités de Sora 2 et guide d'utilisation de l'API

- Lien :

help.openai.com/en/articles/12593142-sora-release-notes - Description : Détails complets sur la fonctionnalité officielle "Character Cameo".

- Lien :

-

Page officielle Google Veo : Présentation du modèle Veo 3.1

- Lien :

deepmind.google/models/veo - Description : Explications sur la sortie 4K et les capacités de génération audio intégrées.

- Lien :

-

AI Comic Factory : Projet open-source de génération de bandes dessinées

- Lien :

github.com/jbilcke-hf/ai-comic-factory - Description : Référence pour l'implémentation de la génération de BD via le couplage LLM + SDXL.

- Lien :

-

Hugging Face AI Comic : Blog technique sur la génération de bandes dessinées

- Lien :

huggingface.co/blog/ai-comic-factory - Description : Détails techniques sur la génération par lots et l'intégration d'API.

- Lien :

Auteur : L'équipe technique

Échanges techniques : N'hésitez pas à partager vos retours d'expérience sur la production de BD/vidéos par lots dans la section commentaires. Pour plus de ressources sur la génération vidéo par IA, vous pouvez consulter la communauté technique APIYI sur apiyi.com.