站长注:全面指南:如何将OpenAI Codex CLI配置为使用API易中转站,享受多模型灵活调用和价格优势。

Codex CLI是OpenAI推出的一款强大的终端交互式开发助手工具,它让开发者能够直接在命令行中与AI模型对话,获取代码生成、解释和修改等帮助。本文将详细介绍如何将Codex CLI配置为使用API易中转站,帮助你享受多模型选择、稳定访问和成本优势。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Codex CLI全系列模型接入,让AI编程更简单高效

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

Codex CLI 和 API易中转站背景介绍

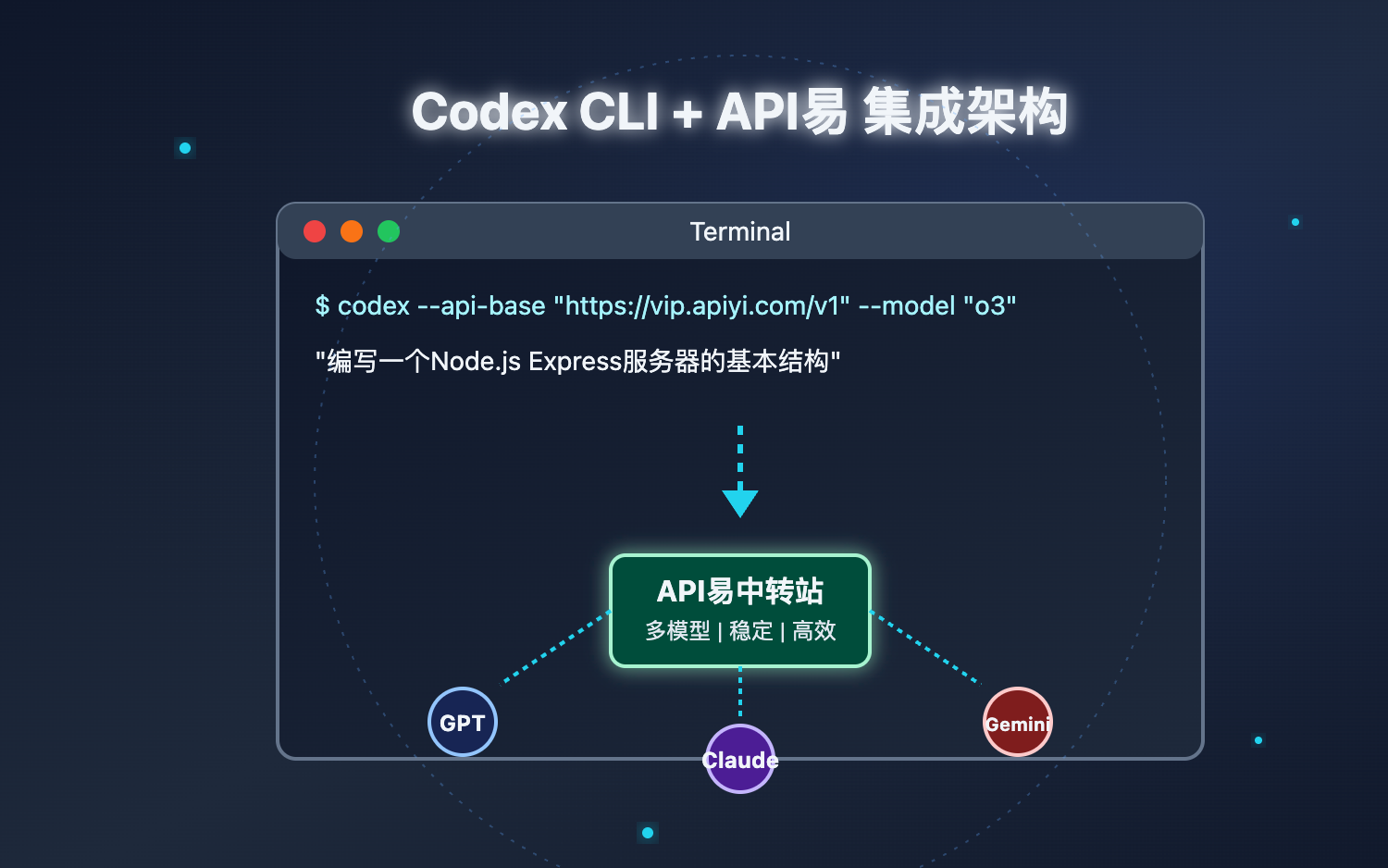

Codex CLI是一个基于命令行的交互式AI编程助手,它允许开发者直接在终端环境中与大语言模型进行交互。该工具支持多种模型提供商接入,除了OpenAI官方,还可以配置使用其他第三方API服务,包括API易中转站。

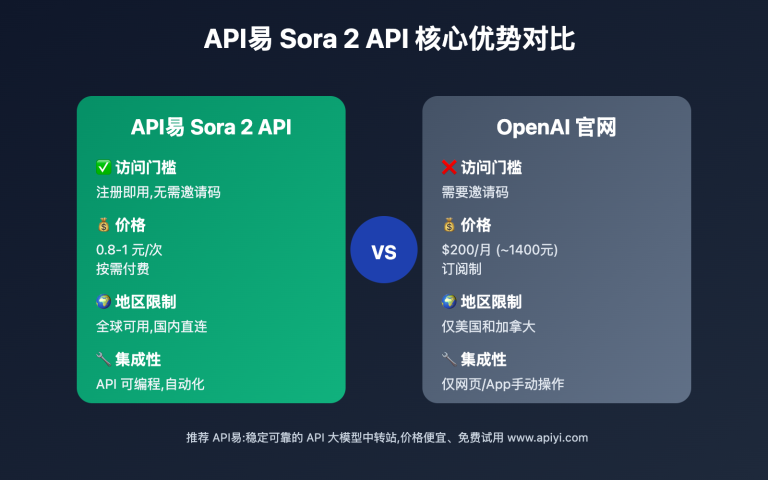

API易是国内领先的AI大模型API中转聚合平台,提供与OpenAI、Claude等多家模型服务商兼容的API接口,解决了访问不稳定、充值复杂以及价格昂贵等问题。通过API易,开发者可以获得稳定可靠的API调用体验,并且能够灵活切换不同的模型服务。

将Codex CLI与API易结合使用,开发者可以在享受强大的终端编程助手功能的同时,获得更稳定的API调用服务和更优惠的价格。

Codex CLI 接入 API易的优势

多模型支持与灵活切换

通过接入API易,Codex CLI用户可以轻松切换和使用多种不同的大语言模型,包括:

- OpenAI系列模型:o3、gpt-4o、gpt-4o-mini等各代模型

- Claude系列:Claude 3.5、Claude 3.7等高性能模型

- Gemini系列:Gemini 1.5 Pro、Flash等谷歌模型

- Deepseek系列:Deepseek v3、r1等专业领域模型

这种多模型支持允许开发者根据不同的编程需求和场景选择最适合的模型,既可以使用强大的旗舰模型处理复杂任务,也可以选择经济实惠的模型来处理日常开发中的简单问题。

稳定可靠的API访问

通过API易中转站接入,Codex CLI用户可以获得:

- 不限速访问:避免直接访问原生API时可能遇到的限流问题

- 稳定连接:多节点部署,确保API调用的稳定性

- 不受地区限制:解决某些地区无法直接访问原生API的问题

- 兼容性保证:与原生API完全兼容,无需调整代码结构

成本优势与灵活计费

使用API易中转站接入Codex CLI可以享受:

- 优惠价格:相比直接使用原生API有一定价格优势

- 按量计费:根据实际使用量付费,无需大额预付

- 免费额度:新用户赠送试用额度,降低尝试成本

- 多种充值方式:支持多种支付方式,更加便捷

Codex CLI 接入 API易配置教程

1. 安装 Codex CLI

首先,确保你已经安装了Node.js环境。然后,使用npm全局安装Codex CLI:

npm install -g @openai/codex

安装完成后,可以运行以下命令验证安装是否成功:

codex --version

2. 注册 API易 账号并获取API密钥

- 访问API易官网并注册账号

- 登录后,进入控制台界面

- 在左侧菜单中找到"API密钥"选项

- 点击"创建新密钥",并复制生成的API密钥

- 确保你的账户中有足够的余额,新用户可获得免费的体验额度

3. 配置 Codex CLI 使用 API易

Codex CLI支持多种配置方式,以下是几种将其配置为使用API易的方法:

方法一:使用环境变量

设置环境变量来配置Codex CLI使用API易:

# Linux/macOS

export OPENAI_API_KEY="你的API易API密钥"

export OPENAI_API_BASE="https://vip.apiyi.com/v1"

# Windows (CMD)

set OPENAI_API_KEY=你的API易API密钥

set OPENAI_API_BASE=https://vip.apiyi.com/v1

# Windows (PowerShell)

$env:OPENAI_API_KEY="你的API易API密钥"

$env:OPENAI_API_BASE="https://vip.apiyi.com/v1"

方法二:使用配置文件

创建或编辑Codex CLI的配置文件(通常位于~/.codex/config.yaml):

api_key: "你的API易API密钥"

api_base: "https://vip.apiyi.com/v1"

model: "o3" # 或其他可用模型

方法三:命令行参数指定

在每次运行Codex CLI时通过命令行参数指定API易作为提供商:

codex --api-key "你的API易API密钥" --api-base "https://vip.apiyi.com/v1" "你的问题或命令"

4. 选择合适的模型

通过API易,你可以选择多种模型。以下是如何在Codex CLI中指定模型的方法:

# 使用命令行参数

codex --model "o3" "解释这段代码的功能"

# 或在配置文件中设置默认模型

# 在 ~/.codex/config.yaml 中:

# model: "claude-3-7-sonnet-20250219"

Codex CLI 接入 API易开发指南

1. 模型选择

模型服务介绍

API易,行业领先的API中转站,均为官方源头转发,价格略有优势,聚合各种优秀大模型,使用起来很方便。

企业级专业稳定的OpenAI o3/Claude 3.7/Deepseek R1/Gemini 等全模型官方同源接口的中转分发。不限速,不过期,不惧封号,按量计费,长期可靠服务;让技术助力科研、公益事业!

当前模型推荐(均为稳定供给)

在与Codex CLI配合使用时,以下是我们推荐的模型:

-

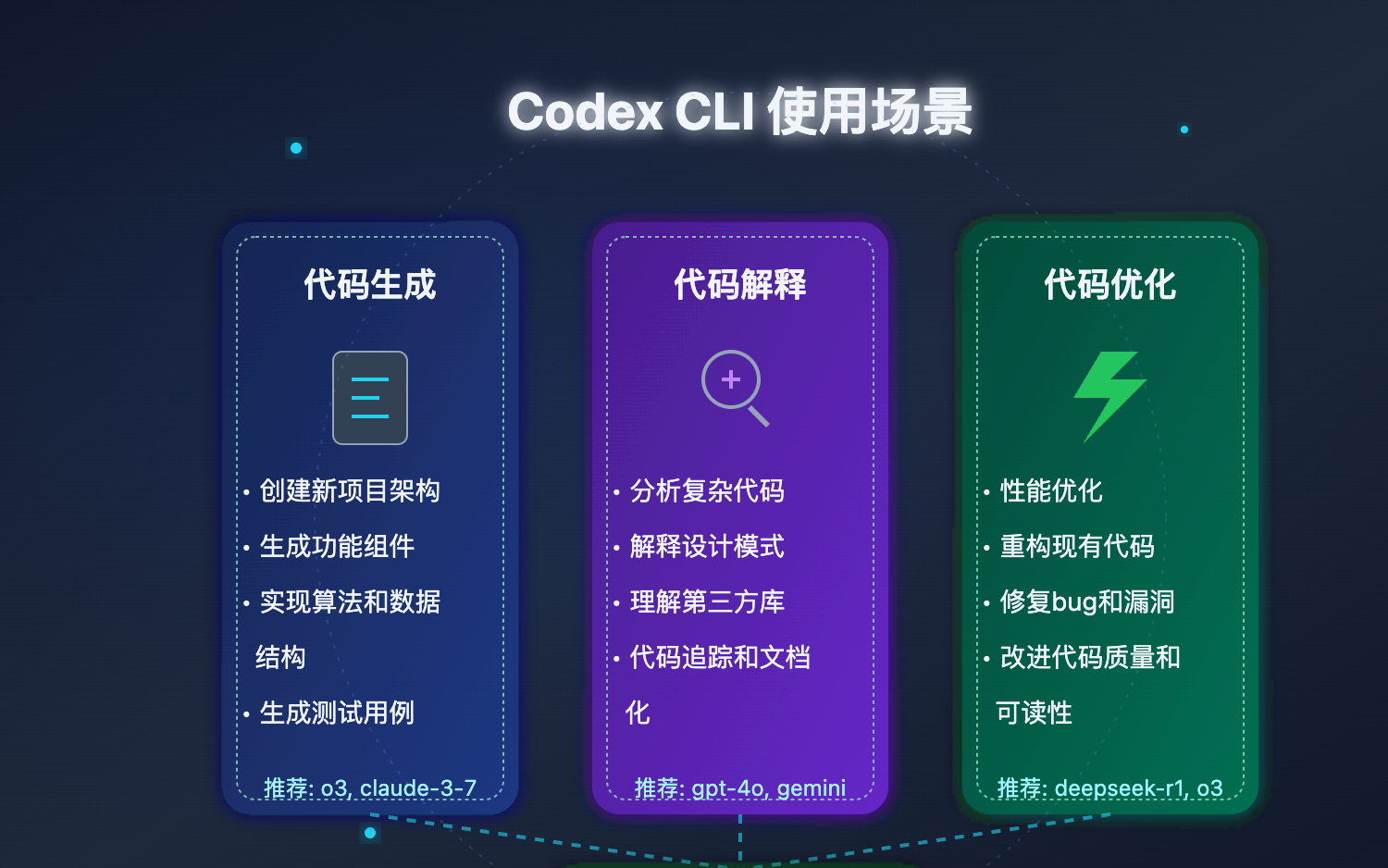

编程场景首选模型

o3:OpenAI最新旗舰模型,编程能力极强(推荐指数:⭐⭐⭐⭐⭐)o4-mini:适合编程的经济型选择claude-3-7-sonnet-20250219:Claude最新模型,编程能力突出deepseek-r1:开源模型中编程能力领先

-

文档生成与代码解释

gpt-4o:综合能力强,适合代码解释和文档生成gemini-2.5-pro-preview-05-06:谷歌模型,多语言支持好claude-3-5-sonnet-20241022:稳定可靠的编程助手

-

快速响应场景

gpt-4o-mini:快速高效的编程助手gemini-2.5-flash-preview:速度快,适合日常开发助手deepseek-v3:本地化支持好的快速模型

场景推荐

-

复杂代码开发场景

- 首选:

o3(强大的上下文理解和代码生成能力) - 备选:

claude-3-7-sonnet-20250219(代码质量高,解释详细) - 经济型:

o4-mini(性价比高,适合大多数编程任务)

- 首选:

-

代码调试与优化场景

- 首选:

gpt-4o(强大的代码分析能力) - 备选:

deepseek-r1(专业的推理能力,适合复杂调试) - 经济型:

gpt-4o-mini(适合常见bug修复)

- 首选:

-

文档生成与代码解释场景

- 首选:

claude-3-7-sonnet-20250219(解释详细全面) - 备选:

gemini-2.5-pro-preview-05-06(文档结构清晰) - 经济型:

deepseek-v3(中文文档支持好)

- 首选:

注意:具体价格请参考 API易价格页面

实践示例

示例1:使用Codex CLI生成代码

# 设置环境变量

export OPENAI_API_KEY="你的API易API密钥"

export OPENAI_API_BASE="https://vip.apiyi.com/v1"

# 使用Codex CLI生成一个Node.js Express服务器

codex --model o3 "创建一个基本的Express服务器,包含用户注册和登录的API端点"

示例2:代码解释

# 解释复杂代码

codex --model claude-3-7-sonnet-20250219 "解释这段React hooks代码的工作原理:

useEffect(() => {

const fetchData = async () => {

setLoading(true);

try {

const result = await api.getData();

setData(result);

} catch (error) {

setError(error);

} finally {

setLoading(false);

}

};

fetchData();

}, []);"

示例3:代码优化

# 优化代码性能

codex --model gpt-4o "优化这个排序算法的性能:

function bubbleSort(arr) {

for(let i = 0; i < arr.length; i++) {

for(let j = 0; j < arr.length - 1; j++) {

if(arr[j] > arr[j + 1]) {

let temp = arr[j];

arr[j] = arr[j + 1];

arr[j + 1] = temp;

}

}

}

return arr;

}"

Codex CLI 与 API易最佳实践

-

合理设置模型参数:在配置文件中添加模型参数设置,如温度(temperature)、最大令牌数(max_tokens)等,以获得最适合你需求的输出

# ~/.codex/config.yaml api_key: "你的API易API密钥" api_base: "https://vip.apiyi.com/v1" model: "o3" temperature: 0.7 max_tokens: 2000 -

利用流式输出:使用流式输出模式实时查看生成结果

codex --stream "编写一个快速排序算法" -

保存常用提示词:为频繁执行的任务创建提示词模板,提高效率

# 创建名为"debug"的提示词模板 codex --save debug "分析以下代码中的错误并提供修复方案:" # 使用保存的模板 codex --use debug "你的代码" -

结合版本控制:将Codex CLI与Git集成,获取代码历史或变更的帮助

git diff | codex "解释这些代码变更的目的和影响"

Codex CLI 接入 API易常见问题

配置不生效怎么办?

如果你的配置没有生效,请检查以下几点:

- 确认API密钥正确无误,没有多余的空格或引号

- 验证API基础URL是否正确设置为

https://vip.apiyi.com/v1 - 尝试使用命令行参数直接指定,排除配置文件问题

- 检查环境变量是否正确设置并生效

如何查看API调用消耗?

你可以通过以下步骤查看API调用消耗:

- 登录API易控制台

- 在左侧菜单中选择"使用统计"

- 查看详细的API调用记录、消耗的tokens和费用

如何在项目中共享Codex CLI配置?

对于团队协作,可以创建项目级别的Codex CLI配置:

- 在项目根目录创建

.codexrc文件 - 添加API易相关配置(但不包含API密钥)

- 指导团队成员分别设置个人API密钥作为环境变量

- 使用环境变量管理工具如

direnv或dotenv来自动加载项目特定的环境变量

不同模型的输出有何差异?

不同模型在以下方面会有差异:

- 代码质量:高级模型如o3和Claude 3.7通常生成更高质量的代码

- 响应速度:轻量级模型如gemini-2.5-flash-preview响应更快

- 上下文理解:高级模型对复杂上下文的理解更好

- 特殊领域能力:某些模型在特定编程语言或框架上表现更佳

建议针对不同任务测试不同模型,找到最适合你需求的选择。

为什么选择「API易」AI大模型API聚合平台

对于Codex CLI用户,API易平台提供了以下独特优势:

-

无缝集成

- 与Codex CLI完全兼容,配置简单

- 保持与原生API相同的接口规范

- 无需修改现有工作流程

-

灵活的模型选择

- 一次配置,多模型使用

- 随时切换不同模型进行对比

- 根据任务需求选择最佳模型

-

稳定的服务保障

- 多节点部署,确保服务稳定性

- 不受地域限制,全球可用

- 技术支持响应迅速

-

优化的开发体验

- 简化的API密钥管理

- 透明的使用统计和计费

- 丰富的文档和示例

提示:使用API易中转站接入Codex CLI时,你可以:

- 灵活尝试不同模型的编程表现

- 在不稳定的网络环境中也能获得可靠的服务

- 避免直接访问原生API可能遇到的各种限制

- 获得更具成本效益的大模型使用方案

总结

Codex CLI与API易的结合为开发者提供了一个强大而灵活的终端AI编程助手解决方案。通过本教程中介绍的配置步骤,你可以轻松将Codex CLI接入API易中转站,享受多模型支持、稳定可靠的API访问以及优惠的价格等多重优势。

这种配置不仅简化了大模型API的使用流程,还大大提升了开发效率和体验。无论是解释代码、生成新功能还是调试问题,Codex CLI结合API易都能为你提供强大的AI助力。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持Codex CLI与多种大模型无缝接入,让AI编程助手更智能高效

加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。