前言:这篇详细介绍如何使用 OpenAI Token 计算器估算 API 调用成本,帮助开发者更好地规划预算和优化使用。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 OpenAI、Claude 等全系列模型,让你的 AI 开发更轻松

Token 是什么?

在使用 AI 大模型 API 时,了解 Token 的概念至关重要。Token 是模型处理文本的基本单位,它们是从文本中提取的常见字符序列。简单来说:

- 对于英文文本,1 个 Token 约等于 4 个字符

- 大约 100 个 Token 对应 75 个英文单词

- 对于中文,一般 1 个汉字约等于 1-2 个 Token

OpenAI Token 计算器 Tokenizer 介绍

OpenAI 提供了一个非常实用的在线工具:Token 计算器。使用这个叫 Tokenizer 的工具,你可以:

- 直观查看分词:

- 输入任意文本

- 实时查看分词结果

- 了解总 Token 数量

- 特点优势:

- 完全免费使用

- 实时计算

- 支持多语言

实际应用示例

让我们通过一些具体例子来说明如何计算 API 调用成本。

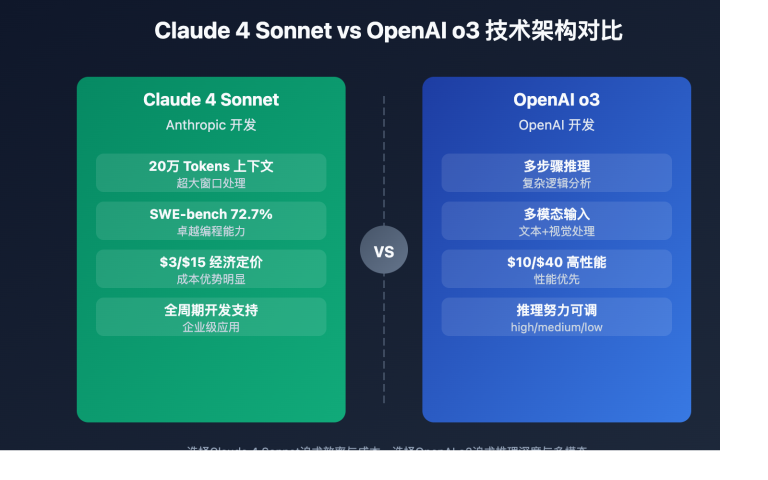

场景一:使用 Claude 3.5 Sonnet API

假设你有 10 美金的额度,Claude 3.5 Sonnet 的价格是:

- 输入:5 美金/1M Tokens

- 输出:15 美金/1M Tokens

这意味着你可以处理:

输入文本量:

10 美金 ÷ (5 美金/1M Tokens) = 2M Tokens(输入)

或

10 美金 ÷ (15 美金/1M Tokens) ≈ 0.67M Tokens(输出)

实际使用示例:

- 如果输入输出比例为 1:1,则可以处理:

10 美金 ÷ (5 + 15 美金/1M Tokens) = 0.5M Tokens 的对话

- 这大约相当于:

- 37.5 万个英文单词

- 或 25-50 万个汉字的处理量

场景二:日常对话估算

以一个典型的对话为例:

用户:请帮我写一篇关于人工智能的文章,800字左右。

(约 20 Tokens)

AI回复:一篇 800 字的文章

(约 1200 Tokens)

总计:1220 Tokens

预估成本:

- 输入:20 * (5/1M) = 0.0001 美金

- 输出:1200 * (15/1M) = 0.018 美金

- 总成本:约 0.0181 美金

成本优化建议

- 合理设计提示词

- 保持提示词简洁

- 避免不必要的重复

- 使用精确的指令

- 控制输出长度

- 设置合适的最大长度

- 分段处理长文本

- 使用流式响应

- 选择合适的模型

- 根据任务复杂度选择

- 考虑成本效益比

- 测试不同模型效果

编程接口

如果你需要在代码中计算 Token,可以使用以下官方和社区工具:

Python:使用 OpenAI 官方的 tiktoken 库

tiktoken 是 OpenAI 开发的官方分词库,专门用于 GPT 模型的 token 计算。它具有以下特点:

- 准确性高:与 OpenAI API 使用相同的分词算法

- 性能优秀:使用 Rust 编写核心代码,运行速度快

- 持续维护:OpenAI 官方团队定期更新

安装方法

# 使用 pip 安装

pip install tiktoken

# 或使用 conda 安装

conda install -c conda-forge tiktoken

使用示例

import tiktoken

def count_tokens(text, model="gpt-4"):

"""

计算文本的 token 数量

:param text: 要计算的文本

:param model: 使用的模型名称(不同模型可能使用不同的分词器)

:return: token 数量

"""

encoding = tiktoken.encoding_for_model(model)

return len(encoding.encode(text))

# 基础使用示例

text = "Hello, how are you?"

token_count = count_tokens(text)

print(f"Token count: {token_count}")

# 使用不同模型的分词器

models = ["gpt-4", "gpt-3.5-turbo", "text-davinci-003"]

for model in models:

count = count_tokens(text, model)

print(f"{model}: {count} tokens")

# 中文文本示例

chinese_text = "你好,最近怎么样?"

chinese_count = count_tokens(chinese_text)

print(f"Chinese text token count: {chinese_count}")

JavaScript:使用社区维护的 tiktoken 库

对于 JavaScript/TypeScript 开发者,可以使用社区维护的 @dqbd/tiktoken 包:

- 功能完整:支持所有 OpenAI 模型的分词

- 兼容性好:支持 Node.js 和浏览器环境

- 使用简单:API 设计直观

安装方法

# 使用 npm 安装

npm install @dqbd/tiktoken

# 或使用 yarn 安装

yarn add @dqbd/tiktoken

使用示例

import { Tiktoken } from '@dqbd/tiktoken';

// 创建编码器实例

const encoding = new Tiktoken('cl100k_base'); // GPT-4 使用的编码器

// 计算 token 数量

const text = "Hello, how are you?";

const tokens = encoding.encode(text);

console.log(`Token count: ${tokens.length}`);

// 释放资源

encoding.free();

// 异步使用示例

async function countTokens(text) {

const encoding = new Tiktoken('cl100k_base');

try {

const tokens = encoding.encode(text);

return tokens.length;

} finally {

encoding.free();

}

}

// 中文文本示例

const chineseText = "你好,最近怎么样?";

countTokens(chineseText).then(count => {

console.log(`Chinese text token count: ${count}`);

});

注意事项

- 选择正确的编码器

- 不同模型可能使用不同的分词器

- 确保使用与模型匹配的编码器

- 常用编码器:

- cl100k_base:用于 GPT-4、GPT-3.5-turbo

- p50k_base:用于较早的 GPT-3 模型

- 资源管理

- JavaScript 版本需要手动释放资源

- Python 版本会自动管理资源

- 大量文本处理时注意内存使用

- 性能优化

- 缓存编码器实例

- 批量处理大量文本

- 注意异常处理

实用小贴士

- 预算规划

- 预估月度使用量

- 设置用量警告

- 定期检查消耗

- 测试优化

- 先用小样本测试

- 记录 Token 使用情况

- 持续优化提示词

- 成本监控

- 使用日志记录

- 设置消费上限

- 定期分析使用模式

API易 平台优势

在 API易 平台使用 AI 模型 API 时,你可以获得:

- 透明的计费

- 清晰的使用明细

- 实时的余额查询

- 详细的消费记录

- 灵活的充值

- 最低 5 美金起充

- 支持多种支付方式

- 余额实时到账

- 专业的支持

- 技术咨询服务

- 使用优化建议

- 成本控制指导

总结

了解 Token 计算对于控制 API 使用成本至关重要。通过合理使用 Token 计算器和优化策略,你可以更好地规划预算,提高 API 使用效率。API易 平台为你提供了便捷的使用环境和专业的支持,让你的 AI 开发之旅更加顺畅。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

新用户注册即送 1 美金,助你轻松开启 AI 开发之旅

本文作者:API易团队

最后更新:2025-01-20

欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。