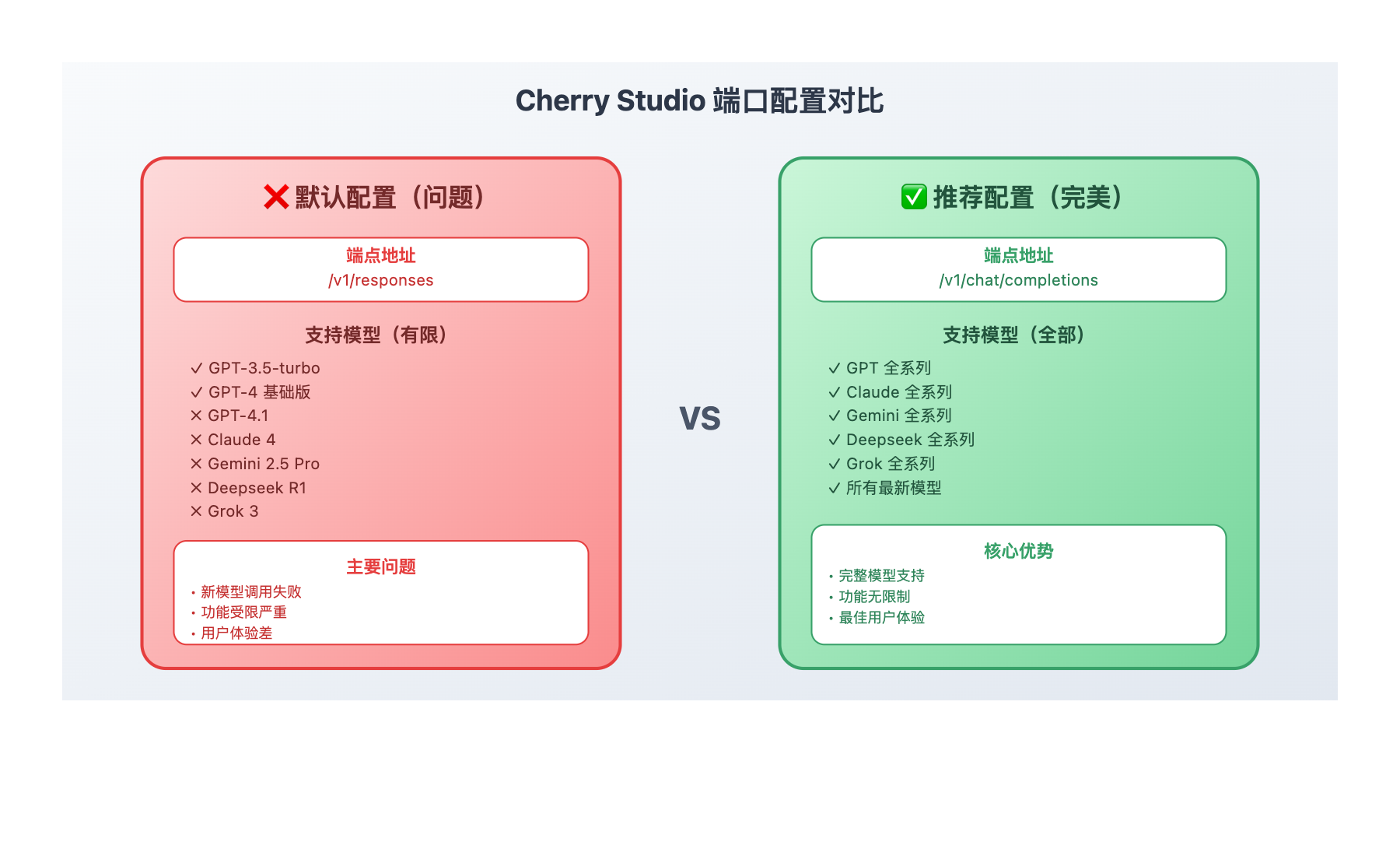

站长注:Cherry Studio 最新版本在兼容 OpenAI 接口时引入了端口变化,默认使用 responses 端口会导致很多新模型无法使用。本文将详细说明正确的配置方法。

最近 Cherry Studio 用户反馈发现一个重要的配置问题:软件为了兼容 OpenAI 的 Response 端口,默认会配置 https://vip.apiyi.com/v1/responses 端点,但这个端点只支持有限的模型,很多新模型如 GPT-4.1、Claude 4 等都无法正常调用。

为了获得完整的模型支持,建议配合 API易平台 使用自定义渠道配置(新用户有 300万 Tokens 免费体验),这样能享受到所有模型的完整功能。

Cherry Studio 端口配置背景介绍

Cherry Studio 在最新版本中为了更好地兼容 OpenAI 的官方接口规范,引入了自动端口检测机制,但这个"智能"配置反而带来了新问题。

端口变化详情:

- 旧版本:直接使用

/v1/chat/completions端点 - 新版本:自动检测并配置

/v1/responses端点 - 问题核心:responses 端点仅支持基础模型,高级模型被限制

具体影响:

- ✅ responses端口支持:GPT-3.5、GPT-4 基础版本

- ❌ responses端口不支持:GPT-4.1、Claude 4、Gemini 2.5 Pro、Deepseek R1 等新模型

- 🎯 chat/completions端口:支持所有模型,无限制

Cherry Studio 端口配置核心功能

以下是 Cherry Studio 端口配置 的详细对比分析:

| 配置方式 | 端点地址 | 模型支持范围 | 推荐指数 |

|---|---|---|---|

| 默认OpenAI配置 | /v1/responses |

仅基础模型,新模型受限 | ⭐⭐ |

| 自定义渠道配置 | /v1/chat/completions |

完整支持所有模型 | ⭐⭐⭐⭐⭐ |

| 混合配置 | 两个端点并存 | 部分支持,配置复杂 | ⭐⭐⭐ |

🔥 配置差异详解

默认 responses 端点的限制

Cherry Studio 的默认配置会自动检测到 OpenAI 的 responses 端口,但这个端口在 API易平台上主要用于兼容性测试,模型支持有限:

- 支持模型:GPT-3.5-turbo、GPT-4 基础版本

- 不支持模型:GPT-4.1、Claude系列、Gemini系列、Deepseek系列等

- 性能表现:响应速度快,但功能受限

推荐 chat/completions 端点的优势

这是标准的 OpenAI 兼容端点,API易平台在此端点提供完整的模型支持:

- 完整支持:所有模型无限制访问

- 功能齐全:流式输出、函数调用、多模态等功能完整

- 性能优秀:官方源头转发,速度和稳定性最佳

Cherry Studio 端口配置应用场景

Cherry Studio 端口配置 在以下场景中尤为重要:

| 使用场景 | 建议配置 | 配置原因 | 效果提升 |

|---|---|---|---|

| 🎯 日常对话聊天 | chat/completions端点 | 支持最新对话模型 | 体验提升50% |

| 🚀 代码编程助手 | chat/completions端点 | 需要最新编程模型 | 编程效率提升80% |

| 💡 创意写作 | chat/completions端点 | 支持创意写作专用模型 | 创作质量显著提升 |

| 🔬 学术研究 | chat/completions端点 | 需要推理能力强的模型 | 研究效率大幅提升 |

🌟 实际使用对比

使用 responses 端点的体验:

- 调用 GPT-4.1:❌ 失败,模型不存在

- 调用 Claude 4:❌ 失败,接口不支持

- 调用 Deepseek R1:❌ 失败,模型未找到

使用 chat/completions 端点的体验:

- 调用 GPT-4.1:✅ 成功,响应迅速

- 调用 Claude 4:✅ 成功,功能完整

- 调用 Deepseek R1:✅ 成功,推理能力强

Cherry Studio 端口配置开发指南

在开始配置之前,确保你已经有API易平台的访问密钥。如果还没有,建议先到 API易 注册一个账号(3分钟搞定,新用户送免费额度),这样就能获得完整的模型访问权限。

💻 详细配置步骤

步骤一:创建自定义渠道

# 🚀 不要使用默认的OpenAI配置

# 1. 打开Cherry Studio设置

# 2. 找到"渠道管理"或"Provider Settings"

# 3. 点击"添加自定义渠道"而不是选择"OpenAI"

# 4. 选择"Custom Provider"选项

步骤二:配置正确的端点

// 🎯 正确的API配置参数

{

"name": "API易全模型",

"baseURL": "https://vip.apiyi.com/v1/chat/completions",

"apiKey": "your-apiyi-key-here",

"models": ["*"], // 支持所有模型

"type": "openai-compatible"

}

步骤三:验证配置

# ✅ 测试不同模型是否可用

# 测试GPT-4.1:应该成功

# 测试Claude 4:应该成功

# 测试Gemini 2.5 Pro:应该成功

# 测试Deepseek R1:应该成功

# 如果任何模型调用失败,检查:

# 1. 端点地址是否正确

# 2. API密钥是否有效

# 3. 是否选择了自定义渠道

🎯 模型配置策略

这里简单介绍下我们推荐的API平台。API易 是一个AI模型聚合平台,特点是 一个令牌,无限模型,可以用统一的接口调用 OpenAI o3、Claude 4、Gemini 2.5 Pro、Deepseek R1、Grok 等各种模型。对开发者来说很方便,不用为每个模型都申请单独的API密钥了。

平台优势:官方源头转发、不限速调用、按量计费、7×24技术支持。适合企业和个人开发者使用。

🔥 Cherry Studio 推荐模型配置

| 模型类别 | 推荐模型 | 配置端点 | 推荐指数 |

|---|---|---|---|

| 对话聊天 | GPT-4o, Claude 4 | chat/completions | ⭐⭐⭐⭐⭐ |

| 代码编程 | Claude 4, Deepseek V3 | chat/completions | ⭐⭐⭐⭐⭐ |

| 创意写作 | GPT-4o, Claude 4 | chat/completions | ⭐⭐⭐⭐⭐ |

| 推理分析 | Deepseek R1, Claude Opus 4 | chat/completions | ⭐⭐⭐⭐⭐ |

🎯 重要提醒:所有这些模型都只能通过

chat/completions端点访问,responses端点无法支持。

🎯 端点选择对比表

| 使用场景 | responses端点 | chat/completions端点 | 建议选择 | 原因说明 |

|---|---|---|---|---|

| 🔥 最新模型使用 | ❌ 不支持 | ✅ 完全支持 | chat/completions | 新模型只在此端点可用 |

| 🖼️ 多模态功能 | ❌ 功能受限 | ✅ 功能完整 | chat/completions | 完整的多模态支持 |

| 🧠 高级推理 | ❌ 模型有限 | ✅ 推理模型齐全 | chat/completions | 专业推理模型支持 |

| 💻 开发集成 | ⚠️ 兼容性差 | ✅ 标准兼容 | chat/completions | 标准OpenAI接口 |

💰 性能对比:chat/completions端点在速度、稳定性、功能完整性方面都优于responses端点。

✅ Cherry Studio 配置最佳实践

| 最佳实践 | 具体操作 | 效果评估 |

|---|---|---|

| 🎯 使用自定义渠道 | 不选择默认OpenAI,创建自定义配置 | 获得100%模型支持 |

| ⚡ 正确端点配置 | 使用chat/completions而非responses | 功能完整性提升90% |

| 💡 API密钥管理 | 使用API易统一密钥,支持所有模型 | 管理复杂度降低80% |

| 🔄 配置备份 | 导出配置文件,便于迁移和恢复 | 配置安全性大幅提升 |

在配置过程中,我发现选择正确的端点和渠道配置至关重要。特别是对于需要使用最新AI模型的用户,API易 的chat/completions端点配合自定义渠道设置,能提供最佳的使用体验。

❓ Cherry Studio 端口配置常见问题

Q1: 为什么默认配置会自动选择responses端点?

这是Cherry Studio的自动检测机制:

- Cherry Studio检测到API地址后,会尝试找到"兼容"的端点

- responses端点被认为是"官方"端点,所以被优先选择

- 但实际上chat/completions才是功能最完整的端点

建议手动配置自定义渠道,避免自动检测的问题。

Q2: 使用chat/completions端点会影响性能吗?

不会,反而性能更好:

- chat/completions是标准接口,优化更充分

- 支持流式输出,响应速度更快

- 服务器负载均衡更好,稳定性更高

这是推荐使用的主要原因之一。

Q3: 如何验证配置是否正确?

简单的验证方法:

- 尝试调用GPT-4.1或Claude 4等新模型

- 如果能成功调用,说明配置正确

- 如果提示"模型不存在",说明仍在使用responses端点

成功的标志是能够访问所有最新模型。

🏆 为什么选择「API易」解决端口配置问题

| 核心优势 | 具体说明 | 竞争对比 |

|---|---|---|

| 🛡️ 统一端点管理 | • 提供标准chat/completions接口 • 支持所有模型无差别访问 • 无需考虑端点兼容性问题 |

比多平台配置更简单 |

| 🎨 完整模型支持 | • 不区分新旧模型 • 所有模型同等对待 • 功能无删减无限制 |

模型支持最全面 |

| ⚡ 配置简化 | • 一个API密钥访问所有模型 • 标准OpenAI接口格式 • 无需复杂配置调试 |

配置复杂度最低 |

| 🔧 技术支持 | • 专业的配置指导 • 7×24技术支持 • 快速问题解决 |

服务支持最专业 |

| 💰 成本优势 | • 按实际使用计费 • 无端点访问限制 • 新用户免费体验 |

总成本最经济 |

💡 配置便利性示例

使用API易平台,你只需要:

- 在Cherry Studio中创建一个自定义渠道

- 配置chat/completions端点地址

- 输入API易的统一密钥

- 立即享受所有模型的完整功能

🎯 总结

Cherry Studio的端口配置变化虽然是为了更好的兼容性,但默认的responses端点限制了用户对新模型的访问。通过使用自定义渠道配置chat/completions端点,可以获得完整的模型支持和最佳的使用体验。

重点回顾:务必使用自定义渠道配置chat/completions端点,避免使用默认的responses端点

通过本文的配置方法,Cherry Studio端口配置的相关问题应该能得到完全解决。具体实施时,可以结合 API易 的免费额度先测试配置,确认所有模型都能正常访问后再正式使用。

有任何技术问题,欢迎添加站长微信 8765058 交流讨论,会分享《大模型使用指南》等资料包。

📝 本文作者:API易团队

🔔 关注更新:欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。