作者注:深度解析 Nano Banana Pro API 返回 503 错误 The model is overloaded 的原因,提供 5 种有效解决方案,帮助开发者应对 Google 官方算力不足问题

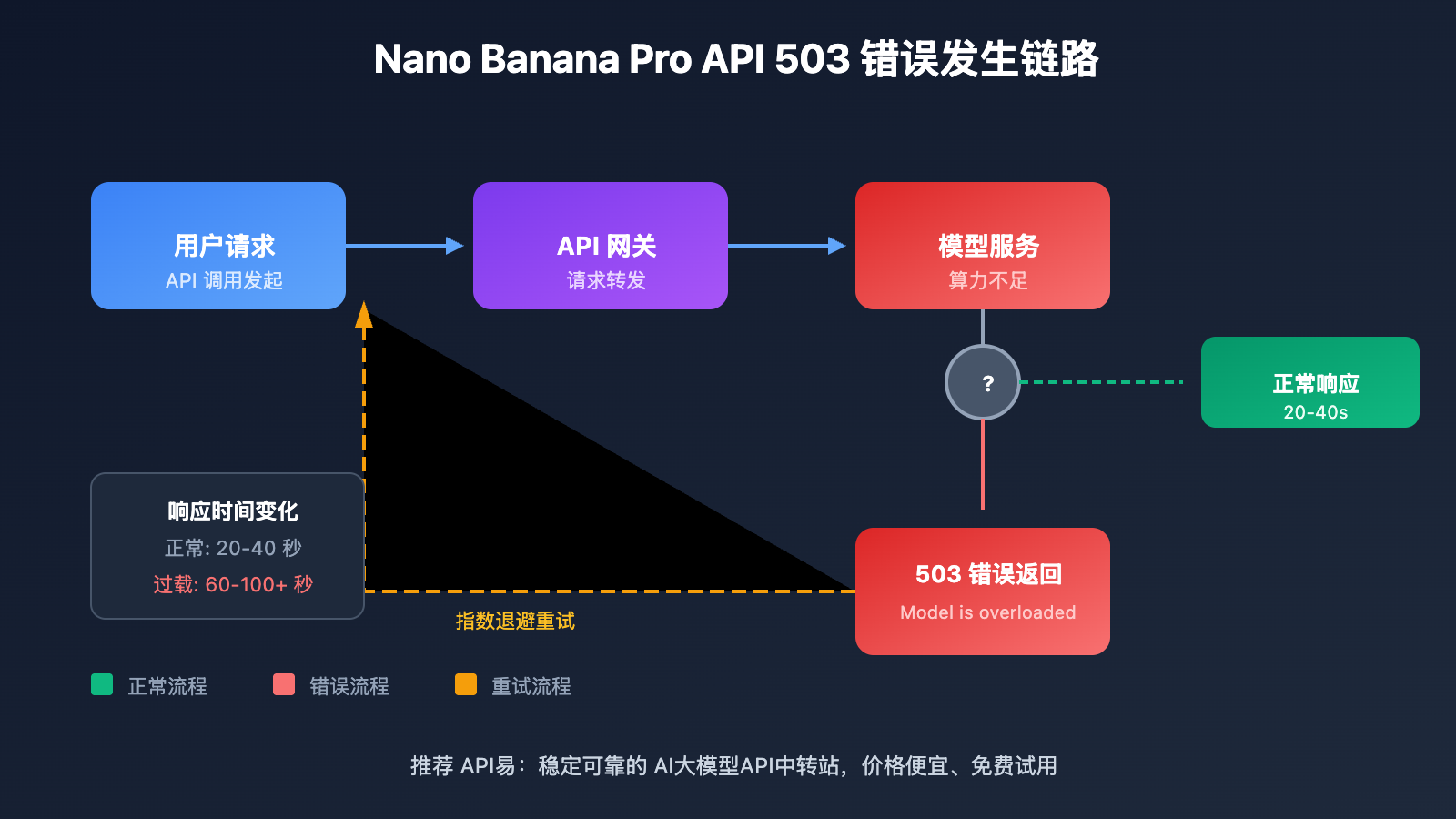

近期许多开发者反馈,调用 Nano Banana Pro API(gemini-2.0-flash-preview-image-generation)时频繁遇到 "The model is overloaded. Please try again later." 错误,响应时间从原来的 30 秒飙升至 60-100 秒甚至更长。本文将深入分析这一问题的根本原因,并提供 5 种经过验证的解决方案。

核心价值: 读完本文,你将了解 Nano Banana Pro API 过载错误的真正原因,掌握有效的应对策略,确保你的图像生成应用稳定运行。

Nano Banana Pro API 过载错误核心要点

| 要点 | 说明 | 影响 |

|---|---|---|

| 错误类型 | HTTP 503 UNAVAILABLE 服务端错误 | API 请求完全失败,需重试 |

| 根本原因 | Google 官方算力资源不足 | 影响所有使用该模型的开发者 |

| 响应时间 | 从 30 秒延长至 60-100+ 秒 | 用户体验严重下降 |

| 影响范围 | 全球所有 API 用户(含付费用户) | 不分层级普遍受影响 |

| 官方态度 | 状态页显示正常,无明确修复时间 | 开发者需自行应对 |

Nano Banana Pro API 过载问题详解

这个 503 错误并非开发者的代码问题,而是 Google 服务器端的算力容量瓶颈。根据 Google AI 开发者论坛的多个讨论帖,这一问题从 2025 年下半年开始频繁出现,至今仍未完全解决。

错误的完整返回格式如下:

{

"error": {

"code": 503,

"message": "The model is overloaded. Please try again later.",

"status": "UNAVAILABLE"

}

}

值得注意的是,即使是 Tier 3 付费用户(最高配额层级),在请求频率远低于配额限制的情况下,依然会遭遇这一错误。这表明问题出在 Google 的基础设施层面,而非个人账户限制。

Nano Banana Pro API 过载的 5 种解决方案

方案一:实现指数退避重试机制

由于 503 错误是可恢复的临时性故障,最有效的策略是实现智能重试:

import openai

import time

import random

def call_nano_banana_pro_with_retry(prompt: str, max_retries: int = 5):

"""

带指数退避的 Nano Banana Pro API 调用

"""

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

for attempt in range(max_retries):

try:

response = client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}]

)

return response

except Exception as e:

if "503" in str(e) or "overloaded" in str(e).lower():

wait_time = (2 ** attempt) + random.uniform(0, 1)

print(f"模型过载,{wait_time:.1f}秒后重试...")

time.sleep(wait_time)

else:

raise e

raise Exception("达到最大重试次数,请稍后再试")

查看完整实现代码(含异步版本)

import openai

import asyncio

import random

from typing import Optional

class NanoBananaProClient:

"""

Nano Banana Pro API 客户端封装

支持自动重试和错误处理

"""

def __init__(self, api_key: str, base_url: str = "https://vip.apiyi.com/v1"):

self.client = openai.OpenAI(api_key=api_key, base_url=base_url)

self.async_client = openai.AsyncOpenAI(api_key=api_key, base_url=base_url)

def generate_image(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""同步调用,带指数退避重试"""

for attempt in range(max_retries):

try:

response = self.client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120 # 延长超时时间

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

print(f"[重试 {attempt + 1}/{max_retries}] 等待 {delay:.1f}s")

time.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "达到最大重试次数"}

async def generate_image_async(

self,

prompt: str,

max_retries: int = 5,

base_delay: float = 2.0

) -> dict:

"""异步调用,带指数退避重试"""

for attempt in range(max_retries):

try:

response = await self.async_client.chat.completions.create(

model="gemini-2.0-flash-preview-image-generation",

messages=[{"role": "user", "content": prompt}],

timeout=120

)

return {"success": True, "data": response}

except Exception as e:

error_msg = str(e).lower()

if "503" in error_msg or "overloaded" in error_msg:

if attempt < max_retries - 1:

delay = (base_delay ** attempt) + random.uniform(0, 1)

await asyncio.sleep(delay)

continue

return {"success": False, "error": str(e)}

return {"success": False, "error": "达到最大重试次数"}

# 使用示例

client = NanoBananaProClient(api_key="YOUR_API_KEY")

result = client.generate_image("生成一只可爱的猫咪")

建议: 通过 API易 apiyi.com 调用 Nano Banana Pro API,平台已内置智能重试机制,可有效降低 503 错误对业务的影响。

方案二:选择低峰时段调用

根据社区反馈,Nano Banana Pro API 的过载问题存在明显的时段规律:

| 时段(UTC) | 负载情况 | 建议操作 |

|---|---|---|

| 00:00 – 06:00 | 较低 | 适合批量任务 |

| 06:00 – 12:00 | 中等 | 可正常使用 |

| 12:00 – 18:00 | 高峰 | 建议减少调用或增加重试 |

| 18:00 – 24:00 | 较高 | 需要耐心等待 |

方案三:使用可靠的 API 中转服务

直接调用 Google 官方 API 会直接暴露在算力不足的风险下。使用专业的 API 中转服务可以获得以下优势:

| 对比维度 | 直接调用官方 API | 使用 API易 中转服务 |

|---|---|---|

| 错误处理 | 需自行实现重试逻辑 | 平台内置智能重试 |

| 稳定性 | 受官方算力波动影响大 | 多节点负载均衡 |

| 响应速度 | 30-100+ 秒波动 | 相对稳定 |

| 技术支持 | 仅论坛社区 | 专业技术团队 |

| 成本 | 按官方价格 | 高性价比方案 |

实测体验: 通过 API易 apiyi.com 调用 Nano Banana Pro API,在高峰时段的成功率明显高于直连官方接口,平台会自动处理重试和降级策略。

方案四:配置合理的超时时间

由于响应时间显著延长,需要调整客户端的超时配置:

import openai

import httpx

# 配置更长的超时时间

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1",

timeout=httpx.Timeout(

connect=30.0, # 连接超时

read=180.0, # 读取超时(图像生成需要更长时间)

write=30.0, # 写入超时

pool=30.0 # 连接池超时

)

)

方案五:实现请求队列和限流

对于生产环境,建议实现请求队列避免并发请求过多:

from queue import Queue

from threading import Thread

import time

class RequestQueue:

"""简单的请求队列实现"""

def __init__(self, requests_per_minute: int = 10):

self.queue = Queue()

self.interval = 60 / requests_per_minute

self.running = True

self.worker = Thread(target=self._process_queue)

self.worker.start()

def add_request(self, request_func, callback):

self.queue.put((request_func, callback))

def _process_queue(self):

while self.running:

if not self.queue.empty():

request_func, callback = self.queue.get()

result = request_func()

callback(result)

time.sleep(self.interval)

else:

time.sleep(0.1)

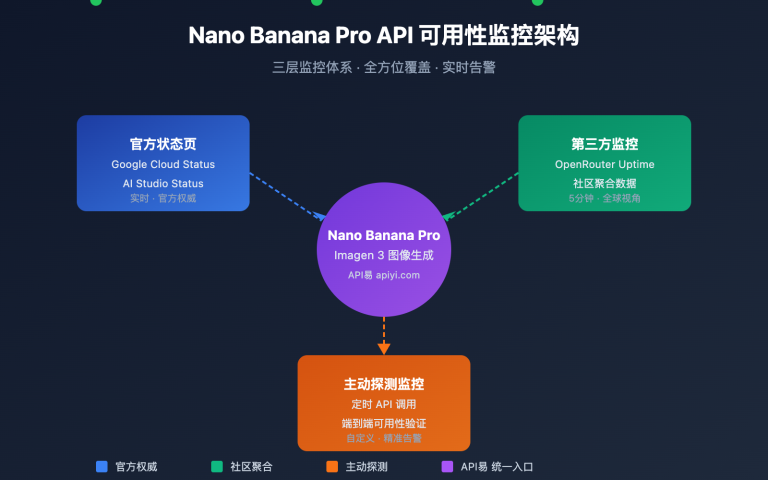

Nano Banana Pro API 官方状态监控

如何查看 Google 官方算力状态

虽然 Google 的状态页面经常显示"一切正常",但你仍可以通过以下渠道获取实时信息:

| 监控渠道 | 地址 | 说明 |

|---|---|---|

| Google AI Studio 状态页 | aistudio.google.com/status |

官方状态,但更新可能滞后 |

| Vertex AI 状态页 | status.cloud.google.com |

企业级状态监控 |

| Google AI 开发者论坛 | discuss.ai.google.dev |

社区实时反馈最及时 |

| StatusGator 第三方监控 | statusgator.com |

用户上报的真实状态 |

| GitHub Issues | github.com/google-gemini |

开发者问题汇总 |

重要提示: 根据社区反馈,即使状态页显示"0 issues",实际服务也可能存在严重的可用性问题。建议同时关注开发者论坛的实时讨论。

常见问题

Q1: 为什么付费用户也会遇到 503 错误?

503 错误表示服务端整体算力不足,这是 Google 基础设施层面的问题,与个人账户的付费层级无关。付费用户确实享有更高的请求配额(RPM/RPD),但当整体算力不足时,所有用户都会受到影响。付费用户的优势在于高峰时段的请求会被优先处理。

Q2: 响应时间从 30 秒变成 100 秒正常吗?

这不是正常现象,而是 Google 服务器过载的典型症状。正常情况下,Nano Banana Pro 的图像生成应在 20-40 秒内完成。响应时间大幅延长说明服务正在排队处理请求,建议实现更长的超时配置和重试机制来应对。

Q3: 如何降低 503 错误对业务的影响?

推荐综合使用以下策略:

- 使用可靠的 API 中转服务如 API易 apiyi.com,获得内置的重试和降级能力

- 实现本地缓存,避免重复生成相同内容

- 设计优雅降级方案,在 API 不可用时提供备选功能

- 配置告警监控,及时发现服务异常

总结

Nano Banana Pro API 过载错误的核心要点:

- 错误本质: 这是 Google 服务端算力不足导致的 503 错误,非开发者代码问题

- 应对策略: 实现指数退避重试机制是最有效的解决方案

- 推荐方案: 使用专业 API 中转服务可获得更稳定的调用体验

面对 Google 官方算力波动的问题,开发者需要做好充分的容错设计。通过合理的重试策略、超时配置和服务选择,可以有效降低过载错误对业务的影响。

推荐通过 API易 apiyi.com 调用 Nano Banana Pro API,平台提供稳定可靠的服务、智能重试机制和专业技术支持,帮助你的图像生成应用稳定运行。

📚 参考资料

⚠️ 链接格式说明: 所有外链使用

资料名: domain.com格式,方便复制但不可点击跳转,避免 SEO 权重流失。

-

Google AI 开发者论坛 – Model is overloaded 讨论: 官方社区关于 503 错误的讨论帖

- 链接:

discuss.ai.google.dev/t/model-is-overloaded-gemini-2-5-pro/108321 - 说明: 了解其他开发者的遭遇和解决经验

- 链接:

-

Google AI Studio 状态页: 官方服务状态监控

- 链接:

aistudio.google.com/status - 说明: 查看 Gemini API 的官方运行状态

- 链接:

-

GitHub gemini-cli Issues: 开发者问题汇总

- 链接:

github.com/google-gemini/gemini-cli/issues - 说明: 查看和上报 Gemini API 相关问题

- 链接:

-

Vertex AI Gemini 文档: 官方图像生成文档

- 链接:

cloud.google.com/vertex-ai/generative-ai/docs/multimodal/image-generation - 说明: 了解 Gemini 图像生成模型的官方用法

- 链接:

作者: 技术团队

技术交流: 欢迎在评论区讨论,更多资料可访问 API易 apiyi.com 技术社区