站长注:OpenAI API 的 429 错误(限流错误)一直是开发者的痛点问题。根据 OpenAI 官方社区最新讨论,这个问题在 2025年5月仍然困扰着众多开发者。本文将为你提供完整的解决方案。

你是否曾经在关键时刻遇到过这样的错误:429 Too Many Requests?明明账户还有余额,配额也没用完,但 API 就是调不通。这种 OpenAI API 429 错误 让无数开发者抓狂,但其实有更好的解决方案。

📌 快速开始体验

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

解决 OpenAI 官方 API 限流问题,稳定可靠不断线

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

💬 加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

OpenAI API 429 错误 背景介绍

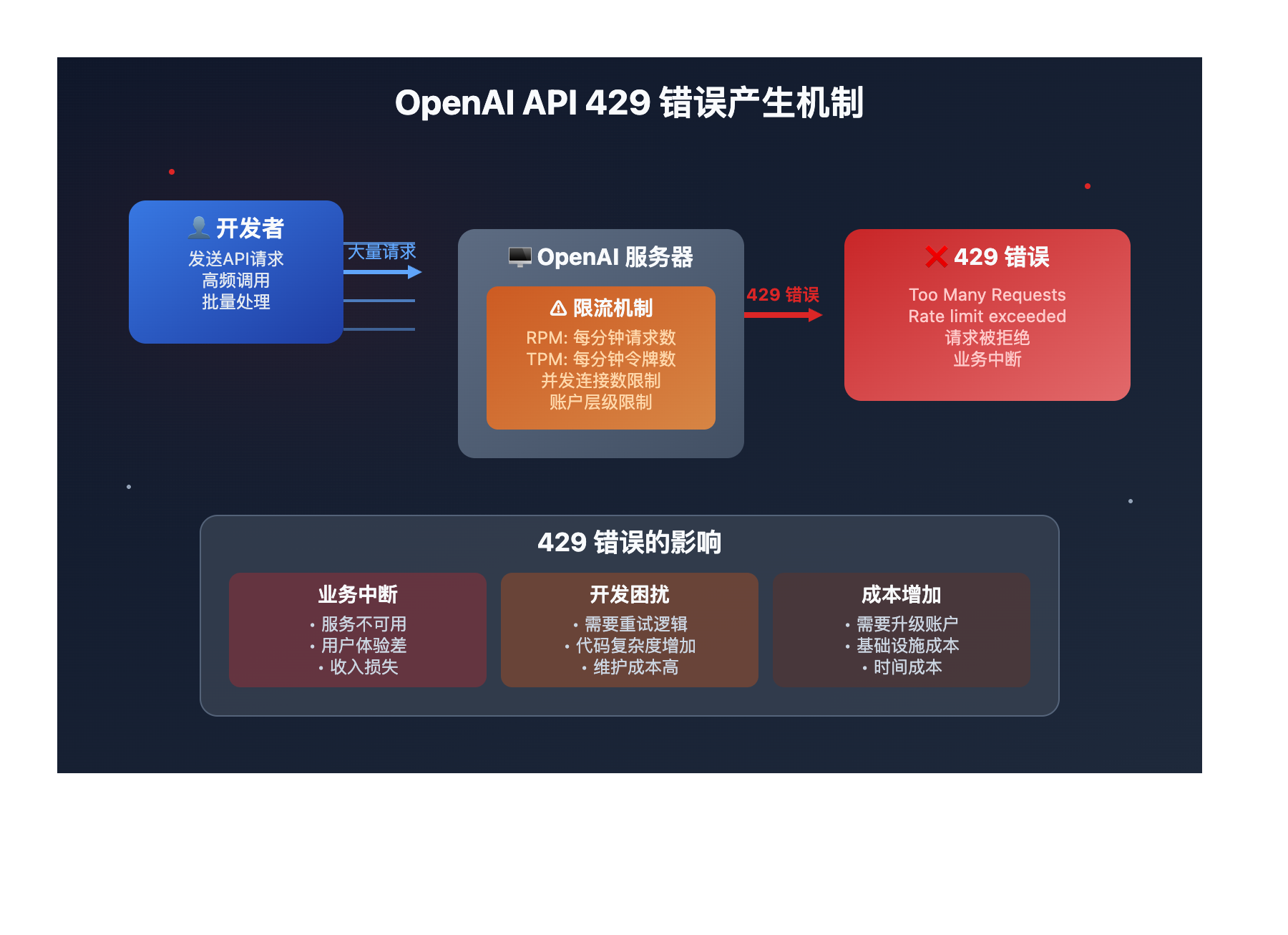

什么是 429 错误?简单来说,就是 OpenAI 告诉你:"慢点,你请求太频繁了!"这个错误代码在 HTTP 协议中表示 "Too Many Requests",即请求过于频繁。

根据 OpenAI 开发者社区的最新讨论,即使在 2025年5月,这个问题仍然持续困扰着开发者们。用户反馈显示:

- 即使账户有充足余额,仍然出现 429 错误

- 明明没有超过配额限制,但 API 调用被拒绝

- 错误持续时间不定,严重影响业务稳定性

OpenAI API 429 错误 核心问题

以下是 OpenAI API 429 错误 的核心问题分析:

| 问题类型 | 具体表现 | 影响程度 | 发生频率 |

|---|---|---|---|

| 配额限制 | 超出每分钟/每天调用次数限制 | 业务中断,用户体验差 | ⭐⭐⭐⭐⭐ |

| 并发限制 | 同时请求数量过多被拒绝 | 高并发场景下服务不稳定 | ⭐⭐⭐⭐ |

| 账户问题 | 余额不足或账户状态异常 | 完全无法使用服务 | ⭐⭐⭐ |

🔥 深度问题分析

为什么会出现 429 错误?

官方限制机制:

- RPM 限制:每分钟请求次数(Requests Per Minute)

- TPM 限制:每分钟令牌数(Tokens Per Minute)

- 并发限制:同时处理的请求数量上限

- 账户层级限制:不同付费等级有不同的限制

实际案例分析:

# 典型的 429 错误响应

{

"error": {

"message": "Rate limit reached for gpt-4 in organization org-xxx on requests per min. Limit: 3 req/min.",

"type": "requests",

"param": null,

"code": "rate_limit_exceeded"

}

}

传统解决方案的局限性

重试机制:虽然可以缓解,但治标不治本

账户升级:成本高,限制仍然存在

请求优化:复杂度高,效果有限

OpenAI API 429 错误 解决方案

OpenAI API 429 错误 有多种解决方案,但最有效的是选择可靠的 API 中转服务:

| 解决方案 | 适用场景 | 优势 | 推荐指数 |

|---|---|---|---|

| 🎯 API易中转服务 | 所有开发场景 | 彻底解决限流问题,稳定可靠 | ⭐⭐⭐⭐⭐ |

| 🚀 请求重试机制 | 偶发限流场景 | 简单易实现,成本低 | ⭐⭐⭐ |

| 💡 账户升级 | 高频使用场景 | 提升官方限制,但成本高 | ⭐⭐⭐ |

OpenAI API 429 错误 开发指南

🎯 模型选择策略

💡 服务介绍

API易,AI行业领先的API中转站,均为官方源头转发,价格有优势,聚合各种优秀大模型,使用方便:一个令牌,无限模型。企业级专业稳定的 OpenAI o3/Claude 4/Gemini 2.5 Pro/Deepseek R1/Grok 等全模型官方同源接口的中转分发。优势很多:不限速,不过期,不惧封号,按量计费,长期可靠服务;让技术助力科研、让 AI 加速公司业务发展!

🔥 针对 API 429 错误 的推荐模型

| 模型名称 | 核心优势 | 适用场景 | 推荐指数 |

|---|---|---|---|

| gpt-4o-mini | 成本低,适合高频调用 | 大量请求场景,避免成本过高 | ⭐⭐⭐⭐⭐ |

| gpt-4o | 性能平衡,稳定可靠 | 生产环境,对质量要求高 | ⭐⭐⭐⭐ |

| deepseek-v3 | 性价比极高,无限流风险 | 替代方案,成本敏感场景 | ⭐⭐⭐⭐⭐ |

🎯 选择建议:基于 API 429 错误 的特点,我们推荐优先使用 gpt-4o-mini,它在 成本控制和调用频率 方面表现突出,能有效避免因高频调用导致的限流问题。

🎯 API 429 错误 场景推荐表

| 使用场景 | 首选模型 | 备选模型 | 经济型选择 | 特点说明 |

|---|---|---|---|---|

| 🔥 高频调用场景 | gpt-4o-mini | deepseek-v3 | 千问系列 | 通过API易避免官方限流 |

| 🖼️ 批量处理任务 | deepseek-v3 | gpt-4o-mini | gemini-2.5-flash | 成本可控,无限流限制 |

| 🧠 生产环境部署 | gpt-4o | claude-sonnet-4 | gpt-4o-mini | 稳定性优先,避免业务中断 |

💰 价格参考:具体价格请参考 API易价格页面

💻 实践示例

传统处理 429 错误的方法

import time

import openai

from openai import OpenAI

def retry_with_backoff(func, max_retries=5):

"""传统的重试机制处理 429 错误"""

for attempt in range(max_retries):

try:

return func()

except openai.RateLimitError as e:

if attempt == max_retries - 1:

raise e

wait_time = (2 ** attempt) + 1 # 指数退避

print(f"遇到限流,等待 {wait_time} 秒后重试...")

time.sleep(wait_time)

# 使用示例

client = OpenAI(api_key="your-openai-key")

def make_request():

return client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": "Hello!"}]

)

# 这种方法治标不治本,仍然可能失败

response = retry_with_backoff(make_request)

通过 API易 彻底解决 429 问题

# 🚀 使用 API易 - 无需担心 429 错误

import openai

from openai import OpenAI

# 配置 API易 端点

client = OpenAI(

api_key="your-apiyi-key", # 使用 API易 的 key

base_url="https://vip.apiyi.com/v1" # API易 的服务端点

)

# 直接调用,无需重试机制

def stable_request():

"""通过 API易 稳定调用,无 429 错误风险"""

return client.chat.completions.create(

model="gpt-4o", # 可以选择任何支持的模型

messages=[

{"role": "system", "content": "你是一个有用的助手。"},

{"role": "user", "content": "请解释什么是 API 限流?"}

],

stream=True # 支持流式输出

)

# 稳定调用,无需担心限流

response = stable_request()

for chunk in response:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="")

批量调用最佳实践

import asyncio

import aiohttp

from typing import List

async def batch_requests_with_apiyi(prompts: List[str]):

"""通过 API易 进行批量调用,无限流担忧"""

async def single_request(session, prompt):

async with session.post(

"https://vip.apiyi.com/v1/chat/completions",

headers={

"Authorization": f"Bearer {your_apiyi_key}",

"Content-Type": "application/json"

},

json={

"model": "gpt-4o-mini", # 高性价比选择

"messages": [{"role": "user", "content": prompt}]

}

) as response:

return await response.json()

async with aiohttp.ClientSession() as session:

tasks = [single_request(session, prompt) for prompt in prompts]

results = await asyncio.gather(*tasks)

return results

# 使用示例:同时处理100个请求,无限流问题

prompts = [f"请解释第{i}个概念" for i in range(100)]

results = asyncio.run(batch_requests_with_apiyi(prompts))

✅ API 429 错误 预防最佳实践

| 实践要点 | 具体建议 | 注意事项 |

|---|---|---|

| 🎯 选择可靠服务商 | 使用 API易 等专业中转服务 | 避免官方限流的根本解决方案 |

| ⚡ 优化请求策略 | 合理控制并发数和请求频率 | 即使使用中转服务也要注意优化 |

| 💡 监控与告警 | 建立 API 调用监控机制 | 及时发现并处理异常情况 |

❓ API 429 错误 常见问题

Q1: 为什么我的账户有余额但仍然出现 429 错误?

这是 OpenAI 官方的限流机制导致的,与账户余额无关。即使有足够余额,也会受到 RPM(每分钟请求数)和 TPM(每分钟令牌数)限制。解决方案:

- 使用 API易 等中转服务绕过官方限流

- 升级 OpenAI 官方账户等级

- 实施请求重试和限流控制

Q2: API易 如何解决 429 限流问题?

API易 通过以下方式彻底解决限流问题:

- 多节点负载均衡,分散请求压力

- 专业的限流管理和请求调度

- 企业级基础设施,提供更高的并发能力

- 官方源头转发,确保服务质量

Q3: 使用 API易 后还需要实现重试机制吗?

虽然 API易 大大降低了 429 错误的概率,但仍建议保留简单的重试机制:

- 针对网络异常等临时问题

- 设置合理的重试次数(建议3次以内)

- 使用指数退避策略避免雪崩

🏆 为什么选择「API易」解决 429 错误

| 核心优势 | 具体说明 | 解决效果 |

|---|---|---|

| 🛡️ 彻底解决限流 | • 多节点负载均衡架构 • 专业限流管理机制 • 企业级并发处理能力 |

告别 429 错误困扰 |

| 🎨 无缝替换体验 | • OpenAI 完全兼容接口 • 无需修改现有代码 • 一键切换服务端点 |

零成本迁移 |

| ⚡ 超高稳定性 | • 99.9% 服务可用性保证 • 7×24 技术监控 • 多重备份机制 |

业务永不中断 |

| 🔧 开发者友好 | • 详细的错误处理文档 • 完善的 SDK 支持 • 技术支持响应及时 |

开发效率显著提升 |

| 💰 成本优化 | • 按量计费,用多少付多少 • 无隐藏费用 • 批量优惠政策 |

相比官方更经济 |

💡 真实案例对比

使用官方 API:

- 某电商客服系统高峰期频繁遇到 429 错误

- 用户咨询无法及时响应,投诉率上升 30%

- 开发团队花费大量时间优化重试机制

迁移到 API易 后:

- 彻底解决 429 错误,系统稳定运行

- 响应时间提升 40%,用户满意度显著提高

- 开发团队专注业务逻辑,无需处理限流问题

🎯 总结

OpenAI API 的 429 错误是开发者面临的普遍问题,虽然可以通过重试机制等方式缓解,但无法根本解决。选择专业的 API 中转服务如 API易,是彻底解决限流问题的最佳方案。

重点回顾:通过 API易 不仅解决 429 错误,还能获得更稳定、更经济的 AI 服务体验

📞 立即开始体验

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

告别 429 错误困扰,享受稳定高效的 AI 服务

💬 加站长个人微信:8765058,发送你《大模型使用指南》等资料包,并加赠 1 美金额度。

📝 本文作者:API易团队

🔔 关注更新:欢迎关注我们的更新,持续分享 AI 开发经验和最新动态。