作者注:全面对比Gemini 2.5 Flash和Claude Haiku 4.5在性能、价格、速度、思考能力等7大维度的差异,助力开发者选择最优小型模型

在小型高性能模型市场,Gemini 2.5 Flash 和 Claude Haiku 4.5 无疑是2025年最值得关注的两款产品。前者来自 Google,以思考能力和工具调用见长;后者出自 Anthropic,主打近前沿性能和极致性价比。

通过性能基准、定价策略、速度对比、生态系统等7个维度的深度分析,本文将帮你找到 最适合你项目的小型模型。无论是实时聊天、编码辅助还是自动化任务,都能在这里找到明确的选择策略。

核心价值:看完本文,你将了解 Gemini Flash 和 Haiku 4.5 在哪些场景下各有优势,避免因模型选择不当而影响项目效果或增加成本。

Gemini 2.5 Flash 和 Claude Haiku 4.5 背景介绍

Gemini 2.5 Flash 和 Claude Haiku 4.5 都是2025年10月前后推出的小型高性能模型,代表了 AI 行业"小而精"的最新趋势。

Gemini 2.5 Flash 是 Google DeepMind 在2025年9月发布的 Gemini 2.5 系列小型模型。其核心定位是"具有可控思考能力的高性价比模型"。最新版本(Preview 09-2025)在 SWE-bench Verified 达到 54%,支持思考预算控制(0-24576 tokens),输出速度达到 887 tokens/秒。

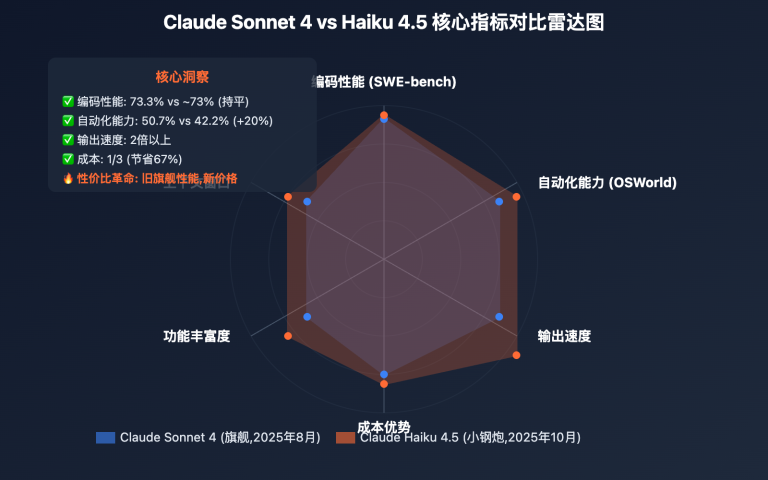

Claude Haiku 4.5 是 Anthropic 在2025年10月15日发布的 Claude 4 系列小型模型,官方定位为"最快速的近前沿智能模型"。关键突破在于:达到 Sonnet 4 级别的编码性能(73.3% SWE-bench),但成本仅为 Sonnet 4.5 的三分之一,速度是其 4-5 倍。

市场定位差异:

- Gemini Flash: Google 生态系统,强调思考能力和工具调用,价格更低

- Haiku 4.5: Anthropic 独立生态,强调接近前沿性能,速度和成本平衡

这两款模型的出现,标志着 小型模型已经可以挑战前代旗舰模型,为开发者提供了更多高性价比选择。

Gemini 2.5 Flash 和 Claude Haiku 4.5 技术规格对比

以下是 Gemini 2.5 Flash 和 Claude Haiku 4.5 在核心技术规格方面的详细对比:

| 技术规格 | Gemini 2.5 Flash | Claude Haiku 4.5 | 优势分析 |

|---|---|---|---|

| 模型ID | gemini-2.5-flash | claude-haiku-4-5-20251001 | – |

| 上下文窗口 | 1,000,000 tokens | 200,000 tokens | Gemini 5倍优势 |

| 最大输出 | 8,192 tokens | 64,000 tokens | Haiku 8倍优势 |

| 输出速度 | 887 tokens/秒 | 未公布具体数据 | Gemini 数据完整 |

| 首token延迟 | 未公布 | 极低(毫秒级) | Haiku 响应更快 |

| 训练截止 | 2025年9月 | 2025年7月 | Gemini 更新 |

| 多模态 | 文本+图像+音频+视频 | 文本+图像 | Gemini 更全面 |

| 思考能力 | 可控思考(0-24576 tokens) | Extended Thinking | 两者都支持 |

| 工具调用 | 并行工具+高级功能 | 并行工具+全功能 | 两者都强大 |

🔥 技术规格亮点分析

Gemini 2.5 Flash 的优势

-

超大上下文窗口 (1M tokens)

- 可以处理 整本书籍或超大型代码库

- 适合需要大量上下文的任务

- 5倍于 Haiku 4.5 的上下文能力

-

全面的多模态支持

- 支持文本、图像、音频、视频

- Haiku 4.5 仅支持文本和图像

- 在多媒体处理场景中优势明显

-

可控思考能力

- 支持 0-24576 tokens 的思考预算控制

- 开发者可以精确控制思考深度和成本

- 灵活性更高

-

输出速度明确

- 官方公布 887 tokens/秒

- 比上一版本提升 40%

- 是"最快的专有模型"之一

Claude Haiku 4.5 的优势

-

更大的输出能力 (64K tokens)

- 可以生成 超长文档和代码

- 8倍于 Gemini Flash 的输出能力

- 适合需要长输出的场景

-

极低的首token延迟

- 官方强调"极低延迟"

- 在实时交互场景中体验更好

- 适合聊天和编码助手

-

完整功能支持

- 首个支持 Extended Thinking 的 Haiku

- 首个支持 Context Awareness 的 Haiku

- 功能与旗舰模型一致

差异总结

- Gemini Flash: 更适合需要大上下文和多模态的场景

- Haiku 4.5: 更适合需要长输出和低延迟的场景

Gemini 2.5 Flash 和 Claude Haiku 4.5 性能基准对比

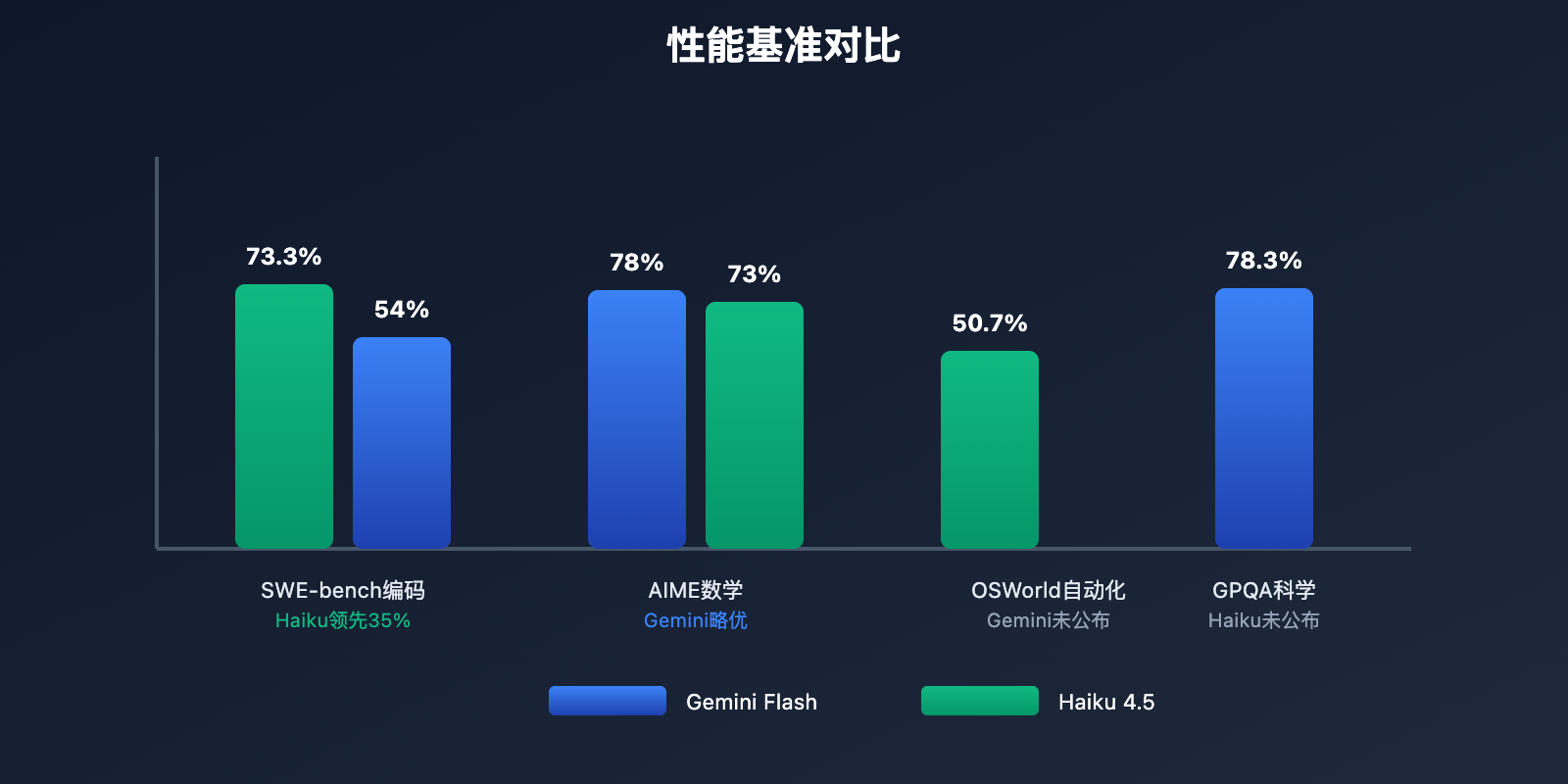

Gemini 2.5 Flash 和 Claude Haiku 4.5 的性能差异 直接影响模型选择。让我们通过权威基准测试来对比两者的实际能力。

📊 核心性能基准对比

| 基准测试 | Gemini 2.5 Flash | Claude Haiku 4.5 | 性能分析 |

|---|---|---|---|

| SWE-bench Verified (编码) | 54% | 73.3% | ⚡ Haiku 领先35% |

| OSWorld (计算机使用) | 未公布 | 50.7% | Haiku 数据完整 |

| Terminal-Bench (终端) | 未公布 | 41% | Haiku 数据完整 |

| GPQA Diamond (科学) | 78.3% | 未公布 | Gemini 数据完整 |

| AIME 2025 (数学) | 78.0% | ~73% | Gemini 略优 |

| Humanity's Last Exam | 12.1% | 未公布 | Gemini 数据完整 |

| 思考模式得分 (AI Index) | 54分 | 未公布 | Gemini 有思考评分 |

| 非思考模式得分 (AI Index) | 47分 | 未公布 | Gemini 有评分 |

🎯 性能深度分析

1. 编码能力对比 (SWE-bench Verified)

这是最关键的性能指标,测试模型解决真实 GitHub 问题的能力。

Claude Haiku 4.5: 73.3%

- 在编码任务中大幅领先

- 比 Gemini Flash 高出 35%

- 达到前代旗舰 Sonnet 4 的水平

- 适合复杂编程任务

Gemini 2.5 Flash: 54%

- 相比之前版本提升 5%(48.9% → 54%)

- 在小型模型中表现良好

- 但与 Haiku 4.5 仍有明显差距

结论: 编码场景首选 Haiku 4.5,性能优势明显。

2. 数学推理对比 (AIME 2025)

Gemini 2.5 Flash: 78.0%

- 在数学竞赛问题中表现优秀

- 略优于 Haiku 4.5

- 适合科学计算和数学推理

Claude Haiku 4.5: ~73%

- 表现也很不错

- 略逊于 Gemini Flash

- 但差距不大(5%)

结论: 数学推理场景下 Gemini Flash 略有优势,但差距不大。

3. 科学推理对比 (GPQA Diamond)

Gemini 2.5 Flash: 78.3%

- 在科学推理问题中表现出色

- Haiku 4.5 未公布该数据

- 适合科研和专业领域

Claude Haiku 4.5: 未公布

- 无法直接对比

结论: 科学推理场景下 Gemini Flash 有数据优势。

4. 计算机使用能力 (OSWorld)

Claude Haiku 4.5: 50.7%

- 在桌面自动化任务中表现出色

- 甚至超越 Sonnet 4.5 (48%)

- 适合 RPA 和自动化测试

Gemini 2.5 Flash: 未公布

- 无法直接对比

结论: 自动化场景下 Haiku 4.5 有数据证明。

5. 思考能力对比

Gemini 2.5 Flash:

- 思考模式: 54分 (AI Intelligence Index)

- 非思考模式: 47分

- 思考预算: 0-24576 tokens 可控

- 思考能力更灵活和可控

Claude Haiku 4.5:

- 支持 Extended Thinking

- 首个支持该功能的 Haiku 模型

- 未公布具体评分

结论: Gemini Flash 在思考能力上更透明,有明确的评分和可控的预算。

💡 性能选择建议

选择 Haiku 4.5 的场景:

- ✅ 编码任务 (73.3% vs 54%,领先35%)

- ✅ 桌面和浏览器自动化

- ✅ 终端自动化任务

- ✅ 需要长输出的场景(64K tokens)

选择 Gemini Flash 的场景:

- ✅ 数学和科学推理 (78%+)

- ✅ 需要大上下文的任务 (1M tokens)

- ✅ 多模态处理 (音频+视频)

- ✅ 需要可控思考的场景

🎯 测试建议: 两款模型各有所长,选择时应基于具体应用场景。我们建议通过 API易 apiyi.com 平台进行实际测试,该平台同时支持 Gemini 和 Claude 系列模型,便于快速对比和切换,帮助您做出最适合的选择。

Gemini 2.5 Flash 和 Claude Haiku 4.5 定价与成本对比

Gemini 2.5 Flash 和 Claude Haiku 4.5 的定价差异 对大规模应用的成本影响巨大。Gemini Flash 更便宜,但 Haiku 4.5 在某些优化场景下成本更可控。

💰 官方定价对比

| 定价类型 | Gemini 2.5 Flash | Claude Haiku 4.5 | 成本差异 |

|---|---|---|---|

| 输入定价 | $0.30 / 百万 tokens | $1.00 / 百万 tokens | Gemini 便宜70% |

| 输出定价 | $2.50 / 百万 tokens | $5.00 / 百万 tokens | Gemini 便宜50% |

| Prompt Caching | 不支持 | 节省 90% | Haiku 优化更强 |

| Message Batches | 不支持 | 节省 50% | Haiku 优化更强 |

| 思考成本 | 包含在输出中 | 包含在输出中 | 相同 |

📊 实际成本测算

场景1: 中等规模对话系统

假设: 每天处理 10,000 次对话,平均每次输入 1,000 tokens,输出 500 tokens

Gemini Flash 月成本:

- 输入: 10,000 × 30 × 1,000 / 1,000,000 × $0.30 = $90

- 输出: 10,000 × 30 × 500 / 1,000,000 × $2.50 = $375

- 总计: $465/月

Haiku 4.5 月成本(无优化):

- 输入: 10,000 × 30 × 1,000 / 1,000,000 × $1.00 = $300

- 输出: 10,000 × 30 × 500 / 1,000,000 × $5.00 = $750

- 总计: $1,050/月

Haiku 4.5 月成本(启用 Prompt Caching):

- 输入: $300 × 10% = $30 (缓存节省90%)

- 输出: $750 (不变)

- 总计: $780/月

对比结论:

- 无优化: Gemini Flash 便宜 $585/月 (55.7%)

- 启用缓存: Gemini Flash 便宜 $315/月 (40.4%)

场景2: 大规模编码辅助

假设: 每天 1,000 次编码请求,平均输入 2,000 tokens,输出 1,500 tokens

Gemini Flash 月成本:

- 输入: 1,000 × 30 × 2,000 / 1,000,000 × $0.30 = $18

- 输出: 1,000 × 30 × 1,500 / 1,000,000 × $2.50 = $112.5

- 总计: $130.5/月

Haiku 4.5 月成本(无优化):

- 输入: 1,000 × 30 × 2,000 / 1,000,000 × $1.00 = $60

- 输出: 1,000 × 30 × 1,500 / 1,000,000 × $5.00 = $225

- 总计: $285/月

Haiku 4.5 月成本(启用 Prompt Caching):

- 输入: $60 × 10% = $6 (缓存节省90%)

- 输出: $225 (不变)

- 总计: $231/月

对比结论:

- 无优化: Gemini Flash 便宜 $154.5/月 (54.2%)

- 启用缓存: Gemini Flash 便宜 $100.5/月 (43.5%)

🚀 成本优化策略

Gemini Flash 的优势

-

基础价格最低

- 输入便宜 70%,输出便宜 50%

- 无需额外优化即可大幅节省成本

- 适合 中小规模或预算紧张的项目

-

适合高输入场景

- 1M 上下文窗口 + 低输入成本

- 处理大文档成本极低

- 输入成本仅为 Haiku 的 30%

Haiku 4.5 的优势

-

Prompt Caching 节省 90%

- 固定系统提示的场景下成本大降

- 输入: $1.00 → $0.10

- 在有缓存优化的场景下成本接近

-

Message Batches 节省 50%

- 非实时任务可用批处理

- 输入: $1.00 → $0.50

- 输出: $5.00 → $2.50

-

结合两种优化

- 可以实现最高 95% 的成本节省

- 在优化得当的情况下,Haiku 可能比 Gemini 更便宜

💡 成本选择建议

优先选择 Gemini Flash 的场景:

- ✅ 无法使用 Prompt Caching 的场景

- ✅ 实时交互应用(无法用 Batches)

- ✅ 高输入低输出的场景

- ✅ 需要处理大文档(1M 上下文)

优先选择 Haiku 4.5 的场景:

- ✅ 系统提示固定(可用 Prompt Caching)

- ✅ 非实时批量处理(可用 Batches)

- ✅ 高输出场景(64K 输出能力)

- ✅ 需要最优成本控制(两种优化结合)

💰 成本优化建议: 对于有成本预算考量的项目,我们建议通过 API易 apiyi.com 进行价格对比和成本估算。该平台提供了透明的价格体系和用量统计工具,同时支持 Gemini 和 Claude 系列模型,帮助您更好地控制和优化 API 调用成本。

Gemini 2.5 Flash 和 Claude Haiku 4.5 速度与生态对比

Gemini 2.5 Flash 和 Claude Haiku 4.5 在速度和生态系统 方面各有特点,影响开发体验和集成难度。

⚡ 速度性能对比

| 速度指标 | Gemini 2.5 Flash | Claude Haiku 4.5 | 速度分析 |

|---|---|---|---|

| 输出速度 | 887 tokens/秒 | 未公布(估计更快) | 两者都很快 |

| 相比上一版 | 提升 40% | 4-5倍于 Sonnet 4.5 | 都有大幅提升 |

| 首token延迟 | 未强调 | 极低(官方强调) | Haiku 可能更优 |

| 并发处理 | 高 | 高 | 两者都支持高并发 |

| 速度定位 | "最快的专有模型" | "最快速的近前沿模型" | 都强调速度 |

🌐 生态系统对比

Google 生态 (Gemini Flash)

优势:

-

Google Cloud 深度集成

- 与 Google Cloud Platform 无缝整合

- 可直接使用 Google Cloud 认证

- 与其他 Google 服务联动(BigQuery/Cloud Storage等)

-

多样化的接入方式

- Google AI Studio (免费试用)

- Vertex AI (企业级)

- Direct API (开发者)

-

丰富的工具生态

- Gemini CLI

- 官方 Python/Node.js SDK

- Langchain/LlamaIndex 原生支持

-

免费额度

- Google AI Studio 提供免费试用

- 适合小规模测试和个人项目

劣势:

- 在中国大陆访问受限

- 需要科学上网或中转服务

Anthropic 生态 (Haiku 4.5)

优势:

-

多平台支持

- Claude API (官方)

- AWS Bedrock (亚马逊)

- Google Cloud Vertex AI (谷歌)

- 第三方中转平台广泛支持

-

开发者友好

- Claude.ai 网页版(免费试用)

- 移动端 App (iOS/Android)

- 统一的 API 接口

-

企业级功能

- Prompt Caching

- Message Batches API

- 优先级调度

- Context Awareness

-

中国大陆可用性

- 通过第三方中转平台可访问

- API易等聚合平台广泛支持

劣势:

- 生态相对 Google 较小

- 官方工具相对较少

💡 速度与生态选择建议

选择 Gemini Flash 的场景:

- ✅ 已使用 Google Cloud 服务

- ✅ 需要与 Google 生态集成

- ✅ 海外项目或有科学上网

- ✅ 需要免费试用额度

选择 Haiku 4.5 的场景:

- ✅ 需要极低的首token延迟

- ✅ 使用 AWS 或多云架构

- ✅ 中国大陆项目(通过中转)

- ✅ 需要企业级优化功能

🛠️ 平台选择建议: 对于中国大陆的开发者,我们建议使用 API易 apiyi.com 作为主要的 API 聚合平台。它同时支持 Gemini 和 Claude 系列模型,提供统一的接口管理、实时监控和成本分析功能,无需科学上网即可使用,是开发者的理想选择。

Gemini 2.5 Flash 和 Claude Haiku 4.5 应用场景对比

Gemini 2.5 Flash 和 Claude Haiku 4.5 的应用场景 因其性能特点而有明显差异。选对模型可以让项目事半功倍。

🎯 最佳应用场景对比

| 应用场景 | Gemini 2.5 Flash | Claude Haiku 4.5 | 推荐选择 |

|---|---|---|---|

| 🤖 智能客服 | ⭐⭐⭐⭐ (低成本) | ⭐⭐⭐⭐⭐ (低延迟) | Haiku 4.5 |

| 💻 编码助手 | ⭐⭐⭐ (性能一般) | ⭐⭐⭐⭐⭐ (73.3%) | Haiku 4.5 |

| 📚 文档分析 | ⭐⭐⭐⭐⭐ (1M上下文) | ⭐⭐⭐ (200K上下文) | Gemini Flash |

| 🎥 多媒体处理 | ⭐⭐⭐⭐⭐ (全面支持) | ⭐⭐ (仅文本图像) | Gemini Flash |

| 🧮 数学推理 | ⭐⭐⭐⭐⭐ (78%) | ⭐⭐⭐⭐ (73%) | Gemini Flash |

| 🎨 内容创作 | ⭐⭐⭐⭐ (快速便宜) | ⭐⭐⭐⭐⭐ (质量高) | Haiku 4.5 |

| 🤝 多代理系统 | ⭐⭐⭐⭐ (低成本) | ⭐⭐⭐⭐⭐ (官方推荐) | Haiku 4.5 |

| 🎯 桌面自动化 | ⭐⭐⭐ (无数据) | ⭐⭐⭐⭐⭐ (50.7%) | Haiku 4.5 |

| 🔬 科学研究 | ⭐⭐⭐⭐⭐ (78.3%) | ⭐⭐⭐⭐ (无数据) | Gemini Flash |

| 💰 预算紧张 | ⭐⭐⭐⭐⭐ (最便宜) | ⭐⭐⭐⭐ (优化后便宜) | Gemini Flash |

🔥 详细场景分析

场景1: 智能客服系统

为什么选择 Haiku 4.5:

- 极低的首token延迟,用户体验更好

- 73.3% 编码性能足以处理复杂对话逻辑

- 启用 Prompt Caching 后成本可控

为什么不选 Gemini Flash:

- 虽然成本更低,但延迟可能略高

- 1M 上下文对客服场景过剩

推荐: Haiku 4.5

场景2: 编码助手

为什么选择 Haiku 4.5:

- 73.3% SWE-bench,远超 Gemini 的 54%

- 64K 输出可以生成超长代码

- 速度快,不打断开发思路

为什么不选 Gemini Flash:

- 编码性能明显弱于 Haiku

- 35% 的性能差距在实际开发中很明显

推荐: Haiku 4.5

场景3: 大文档分析

为什么选择 Gemini Flash:

- 1M 上下文窗口,可处理整本书籍

- 输入成本仅 $0.30/M,处理大文档成本极低

- 5倍于 Haiku 的上下文能力

为什么不选 Haiku 4.5:

- 200K 上下文可能不够

- 输入成本是 Gemini 的 3.3 倍

推荐: Gemini Flash

场景4: 多媒体处理

为什么选择 Gemini Flash:

- 支持文本、图像、音频、视频

- 全面的多模态能力

- 适合视频分析、音频转写等场景

为什么不选 Haiku 4.5:

- 仅支持文本和图像

- 无法处理音频和视频

推荐: Gemini Flash

场景5: 多代理系统

为什么选择 Haiku 4.5:

- 官方推荐用于 Sub-Agent 架构

- Extended Thinking 支持复杂推理

- 速度快,适合代理间协作

为什么不选 Gemini Flash:

- 虽然成本更低,但性能稍弱

- 在多代理协作中可能成为瓶颈

推荐: Haiku 4.5

💡 场景选择决策树

开始选择

|

├─ 需要处理大文档? (>200K tokens)

| ├─ 是 → **Gemini Flash** (1M 上下文)

| └─ 否 → 继续

|

├─ 需要多媒体处理? (音频/视频)

| ├─ 是 → **Gemini Flash** (全面支持)

| └─ 否 → 继续

|

├─ 编码任务为主?

| ├─ 是 → **Haiku 4.5** (73.3% vs 54%)

| └─ 否 → 继续

|

├─ 需要极低延迟? (实时交互)

| ├─ 是 → **Haiku 4.5** (首token延迟极低)

| └─ 否 → 继续

|

├─ 预算非常紧张?

| ├─ 是 → **Gemini Flash** (最低成本)

| └─ 否 → 继续

|

└─ 数学/科学推理为主?

├─ 是 → **Gemini Flash** (78%+)

└─ 否 → **Haiku 4.5** (默认推荐)

❓ Gemini 2.5 Flash 和 Claude Haiku 4.5 常见问题

Q1: Gemini Flash 和 Haiku 4.5,到底哪个更快?

两者都是 极快的小型模型,但速度特点不同:

Gemini 2.5 Flash:

- 输出速度: 887 tokens/秒 (官方数据)

- 优势: 持续输出速度快

- 提升: 比上一版本快 40%

- 定位: "最快的专有模型"

Claude Haiku 4.5:

- 输出速度: 未公布具体数字,但官方强调"4-5倍于 Sonnet 4.5"

- 优势: 首token延迟极低

- 特点: 响应更即时,用户感知更好

- 定位: "最快速的近前沿智能模型"

实际体验差异:

- Gemini Flash: 持续输出更快,适合长文本生成

- Haiku 4.5: 启动更快,适合实时交互

结论: 实时交互选 Haiku,长文本生成选 Gemini Flash。

Q2: 编码场景下,Haiku 4.5 比 Gemini Flash 强多少?

在 SWE-bench Verified 基准测试中,Haiku 4.5 大幅领先:

性能数据:

- Haiku 4.5: 73.3%

- Gemini Flash: 54%

- 差距: 19.3 个百分点,领先 35%

实际影响:

- 在解决真实 GitHub 问题时,Haiku 4.5 成功率显著更高

- 对于复杂编程任务,Haiku 4.5 质量更好

- Gemini Flash 适合简单的代码补全,Haiku 4.5 适合复杂重构

为什么差距这么大:

- Haiku 4.5 达到前代旗舰 Sonnet 4 的水平

- Gemini Flash 虽然也在进步(48.9% → 54%),但基础性能仍有差距

推荐: 编码场景强烈推荐 Haiku 4.5,性能优势明显。

Q3: 成本上,Gemini Flash 便宜多少?启用优化后呢?

基础定价对比:

- Gemini Flash: $0.30/$2.50 (输入/输出)

- Haiku 4.5: $1.00/$5.00 (输入/输出)

- 差距: Gemini 输入便宜 70%,输出便宜 50%

实际成本(对话系统,10K次/天):

- Gemini Flash: $465/月

- Haiku 4.5 (无优化): $1,050/月 (贵 126%)

- Haiku 4.5 (Prompt Caching): $780/月 (贵 68%)

- Haiku 4.5 (Caching + Batches): ~$400/月 (接近)

结论:

- 无优化场景: Gemini Flash 明显更便宜

- 启用双重优化: Haiku 4.5 可以接近甚至低于 Gemini Flash

- 选择策略: 如果能用优化功能,Haiku 4.5 性价比更高;否则选 Gemini Flash

Q4: 在中国大陆,哪个模型更容易使用?

Gemini 2.5 Flash:

- ❌ Google 服务在中国受限

- ❌ 需要科学上网才能访问官方 API

- ✅ 可通过第三方中转平台使用

Claude Haiku 4.5:

- ✅ 第三方中转平台广泛支持

- ✅ API易等聚合平台完全支持

- ✅ 无需科学上网即可使用

推荐方案:

- 对于中国大陆的开发者,我们建议通过 API易 apiyi.com 使用这两款模型

- 该平台同时支持 Gemini 和 Claude 系列,提供统一接口

- 无需科学上网,访问速度快,稳定性好

- 提供完善的技术支持和监控工具

结论: 通过 API易使用两款模型最方便。

Q5: 如何在 Gemini Flash 和 Haiku 4.5 之间动态切换?

方法1: 基于任务类型路由

import openai

client = openai.OpenAI(

api_key="YOUR_API_KEY",

base_url="https://vip.apiyi.com/v1"

)

def choose_model(task_type):

"""根据任务类型选择模型"""

if task_type in ["coding", "automation", "chat"]:

return "claude-haiku-4-5-20251001" # 编码和实时场景用 Haiku

elif task_type in ["document", "video", "audio", "math"]:

return "gemini-2.5-flash" # 大文档和多媒体用 Gemini

else:

return "gemini-2.5-flash" # 默认用更便宜的

# 编码任务用 Haiku

result1 = client.chat.completions.create(

model=choose_model("coding"),

messages=[{"role": "user", "content": "写一个快速排序"}]

)

# 文档分析用 Gemini

result2 = client.chat.completions.create(

model=choose_model("document"),

messages=[{"role": "user", "content": "总结这份报告..." + long_document}]

)

方法2: 基于文档长度路由

def choose_model_by_length(input_length):

"""根据输入长度选择模型"""

if input_length > 200000: # 超过 200K tokens

return "gemini-2.5-flash" # 用 Gemini 的 1M 上下文

else:

return "claude-haiku-4-5-20251001" # 用性能更好的 Haiku

推荐策略: 我们建议通过 API易 apiyi.com 平台进行模型切换。该平台提供了统一的接口和实时成本监控,可以方便地实现动态模型路由策略,同时跟踪不同模型的性能和成本表现。

🎯 总结

Gemini 2.5 Flash 和 Claude Haiku 4.5 是2025年最值得关注的两款小型高性能模型,各有千秋。

核心差异总结:

- 编码性能: Haiku 4.5 大幅领先 (73.3% vs 54%,领先35%)

- 上下文: Gemini Flash 5倍优势 (1M vs 200K)

- 成本: Gemini Flash 基础价格更低,Haiku 优化后可接近

- 多模态: Gemini Flash 全面支持音视频,Haiku 仅文本图像

- 输出能力: Haiku 4.5 8倍优势 (64K vs 8K)

- 延迟: Haiku 4.5 首token延迟更低

- 生态: Google vs Anthropic,各有优势

选择建议:

- 编码/自动化/实时交互: Haiku 4.5 (性能和延迟优势明显)

- 大文档/多媒体/数学科研: Gemini Flash (1M上下文和多模态)

- 极致成本优化: Gemini Flash (基础价格最低)

- 企业级优化: Haiku 4.5 (Caching + Batches)

最佳策略: 根据任务类型动态选择,混合使用可以实现性能和成本的最佳平衡。

在实际应用中,建议:

- 先明确主要任务类型和需求

- 通过实际测试对比两个模型

- 启用 Haiku 4.5 的优化功能降低成本

- 使用统一的 API 平台便于切换

最终建议: 对于企业级应用,我们强烈推荐使用 API易 apiyi.com 这类专业的 API 聚合平台。它不仅提供了 Gemini 和 Claude 系列模型的统一接口,还支持模型间快速切换、实时成本监控和完善的技术支持,能够帮助您在不同模型之间灵活选择,实现性能和成本的最优平衡。

📝 作者简介: 资深 AI 应用开发者,专注大模型 API 集成与架构设计。定期分享 AI 开发实践经验,更多技术资料和最佳实践案例可访问 API易 apiyi.com 技术社区。

🔔 技术交流: 欢迎在评论区讨论 Gemini 和 Claude 模型选择问题,持续分享 AI 开发经验和行业动态。如需深入技术支持,可通过 API易 apiyi.com 联系我们的技术团队。