昨天,我第一时间体验了 Google 最新发布的 Gemini 2.0 Flash 预览模型。作为一个经常和各类模型打交道的开发者,我必须说:这次 Google 是真的有点东西。

欢迎免费试用我们的 API 服务产品:API易 https://www.apiyi.com/register/?aff_code=HDnF

API 易已上线了这个模型 gemini-2.0-flash-exp

为什么值得关注?

先说最吸引我的三点:

- 速度快得有点夸张

- 比 Gemini 1.5 Pro 快了整整一倍

- 同时性能反而更强了

- 延迟极低,体验流畅

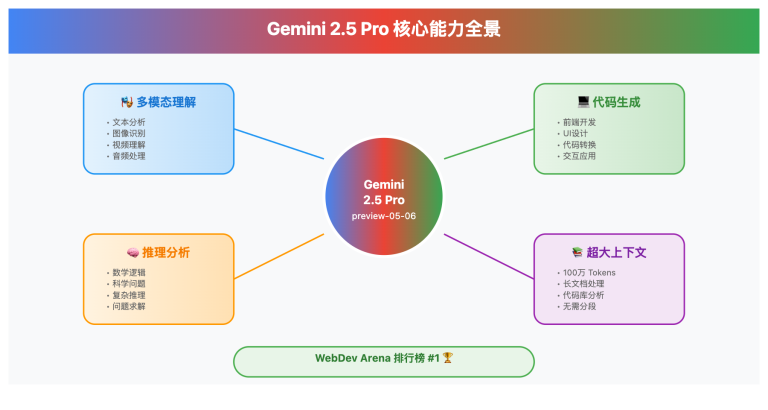

- 原生多模态真的强

- 支持图片、视频、音频输入

- 可以直接生成图片和语音

- 多模态混合输出(文字+图片)

- 工具调用能力全面升级

- 原生支持 Google 搜索

- 可以直接执行代码

- 支持自定义函数调用

开发者最关心的变化

对我们开发者来说,最值得关注的是这些特性:

1. API 接入更简单了

- 通过 Google AI Studio 可以直接调用

- Vertex AI 平台全面支持

- 提供了新的 Multimodal Live API

2. 多模态能力大升级

我们来看个具体例子:

输入:一张图片 + "帮我分析这段代码的问题"

输出:

- 直接理解代码截图

- 指出具体错误

- 给出修复建议

3. 工具集成更强大

- 可以直接调用搜索引擎

- 支持实时代码执行

- 可以串联多个工具调用

实用建议

基于我的测试经验,给大家几个实用建议:

- 选择合适的场景

- 需要快速响应的对话场景

- 多模态混合的应用场景

- 工具链路调用的场景

- 注意成本控制

- 目前是实验版本,价格待定

- 建议先在测试环境验证

- 关注具体的计费规则

- API 调用技巧

- 合理设置超时时间

- 做好错误重试机制

- 注意并发请求限制

未来展望

我认为 Gemini 2.0 Flash 的发布意味着:

- 多模态将成为标配

- 文本理解不再是唯一入口

- 混合输出会越来越普遍

- 交互形式更加丰富

- 工具调用更加重要

- 模型能力与外部工具深度融合

- 自定义函数将成为重点

- 生态建设会加速

结语

如果你正在考虑升级或者选择新的模型,我建议:

- 已经在用 Gemini 1.5 的,可以优先尝试升级

- 对响应速度要求高的场景,这是个不错的选择

- 需要多模态能力的,值得重点关注。

欢迎免费试用我们的 API 服务产品:API易 https://www.apiyi.com/register/?aff_code=HDnF