站长注:详细讲解如何在Dify中配置Claude 4 API,通过OpenAI兼容模式解决Claude模型调用不稳定的问题

很多开发者在使用Dify平台时会遇到这样的困扰:其他AI模型运行正常,但Claude模型经常出现调用失败、响应超时等不稳定问题。这不仅影响应用的用户体验,也让基于Claude强大推理能力的AI应用无法稳定运行。

本文将详细介绍如何通过 OpenAI兼容模式 在Dify中配置Claude 4 API,彻底解决模型调用不稳定的问题。通过本教程,你将学会如何正确设置API供应商、选择合适的模型名称,以及优化配置参数来获得最佳性能。

无论你是Dify新手还是经验丰富的开发者,这份教程都将帮助你快速搭建稳定可靠的Claude 4集成方案,让你的AI应用获得Claude 4的强大能力支持。

Dify Claude 4 API 背景介绍

Dify作为领先的LLMOps平台,原生支持多种AI模型的集成。然而在实际使用中,直接调用Claude官方API经常遇到以下问题:

- 网络连通性:官方API服务在某些地区访问不稳定

- 频率限制:官方API的rate limit较为严格,高并发场景容易触发限制

- 错误处理:网络异常时缺乏有效的重试机制和故障转移

- 成本控制:官方定价对中小团队来说成本较高

这些问题导致基于Claude模型的Dify应用难以稳定运行,影响用户体验和业务连续性。

Dify Claude 4 API 核心功能

以下是 Dify Claude 4 API 集成的核心功能特性:

| 功能模块 | 核心特性 | 应用价值 | 推荐指数 |

|---|---|---|---|

| 对话生成 | 高质量多轮对话能力 | 支持复杂业务场景的智能客服 | ⭐⭐⭐⭐⭐ |

| 代码分析 | 强大的代码理解和生成 | 开发辅助和代码审查 | ⭐⭐⭐⭐⭐ |

| 文档处理 | 长文本理解和总结 | 知识库问答和文档分析 | ⭐⭐⭐⭐ |

| 推理分析 | 逻辑推理和问题解决 | 复杂决策支持系统 | ⭐⭐⭐⭐⭐ |

🔥 重点功能详解

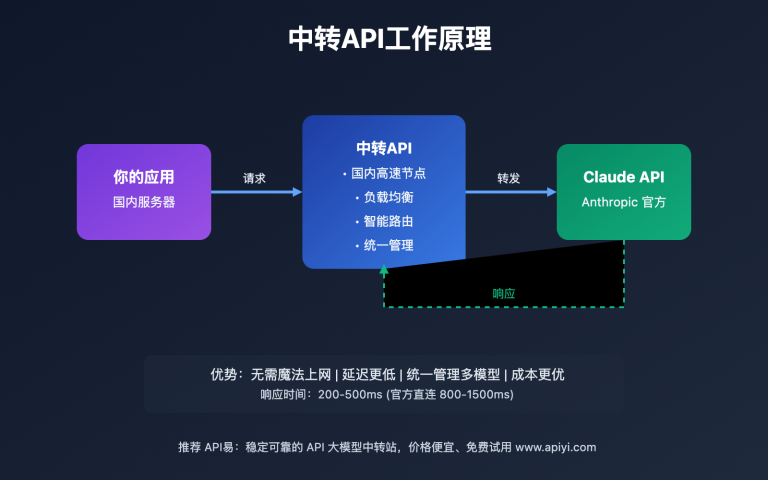

OpenAI兼容模式优势

通过OpenAI兼容接口调用Claude 4,可以享受以下技术优势:

- 统一接口标准:使用标准的OpenAI API格式,降低集成复杂度

- 负载均衡:聚合平台提供多节点负载均衡,提升服务稳定性

- 故障转移:自动故障检测和切换,确保服务连续性

- 成本优化:灵活的计费模式和批量优惠政策

Dify原生集成特性

Claude 4在Dify平台中的原生集成特性:

- 流式输出:支持实时响应,提升用户交互体验

- 上下文管理:自动管理对话历史和上下文长度

- 模板系统:与Dify的Prompt模板系统无缝集成

- 工作流支持:在复杂工作流中作为推理节点使用

Dify Claude 4 API 应用场景

Dify Claude 4 API 在以下场景中表现出色:

| 应用场景 | 适用对象 | 核心优势 | 预期效果 |

|---|---|---|---|

| 🎯 智能客服系统 | 企业服务团队 | 理解复杂问题,给出准确回答 | 客服效率提升60%+ |

| 🚀 代码助手平台 | 开发团队 | 代码生成和调试能力强 | 开发效率提升40%+ |

| 💡 知识问答系统 | 教育和咨询机构 | 长文档理解和知识抽取 | 知识检索准确率90%+ |

| 📊 数据分析助手 | 数据分析师 | 复杂逻辑推理和数据洞察 | 分析深度和准确性显著提升 |

Dify Claude 4 API 技术实现

💻 配置步骤详解

第一步:添加模型供应商

在Dify管理后台进行以下配置:

- 进入 设置 → 模型供应商

- 点击 添加供应商

- 选择 OpenAI-API-Compatible 类型

{

"供应商类型": "OpenAI-API-Compatible",

"供应商名称": "APIYI-Claude",

"描述": "稳定的Claude 4 API服务"

}

第二步:配置API参数

关键配置参数如下:

# 🚀 API配置示例

API_BASE_URL=https://vip.apiyi.com/v1

API_KEY=your_api_key_here

MODEL_NAME=claude-sonnet-4-20250514

详细配置表格:

| 配置项 | 值 | 说明 |

|---|---|---|

| API Base URL | https://vip.apiyi.com/v1 |

兼容OpenAI格式的API地址 |

| API Key | 你的密钥 | 从API服务商后台获取 |

| 模型名称 | claude-sonnet-4-20250514 |

从pricing页面复制准确名称 |

第三步:模型名称获取

正确的模型名称获取步骤:

- 访问API服务商的pricing页面:

https://www.apiyi.com/account/pricing - 找到Claude相关模型

- 复制完整的模型名称,例如:

claude-sonnet-4-20250514 - 粘贴到Dify的模型名称字段

Python验证脚本:

import openai

# 验证模型配置

client = openai.OpenAI(

api_key="your_api_key",

base_url="https://vip.apiyi.com/v1"

)

# 测试Claude 4调用

response = client.chat.completions.create(

model="claude-sonnet-4-20250514",

messages=[

{"role": "system", "content": "你是一个有用的AI助手"},

{"role": "user", "content": "请介绍一下Claude 4的主要特点"}

],

max_tokens=1000

)

print(response.choices[0].message.content)

🎯 模型选择策略

🔥 针对 Dify Claude 4 API 的推荐模型

基于Dify平台特性和Claude模型的实际测试经验:

| 模型名称 | 核心优势 | 适用场景 | 可用平台 |

|---|---|---|---|

| claude-sonnet-4-20250514 | 推理能力强、响应质量高 | 复杂对话、代码生成 | Anthropic官方、API易等聚合平台 |

| claude-3.5-sonnet | 成本效益平衡 | 日常对话、文档处理 | 多个第三方平台 |

| claude-3-haiku | 响应速度快、成本低 | 简单任务、高频调用 | 官方API、代理服务 |

🎯 选择建议:对于Dify平台,推荐优先使用 claude-sonnet-4-20250514,它在复杂推理和代码生成方面表现出色,适合大多数Dify应用场景。

🔧 Dify集成最佳实践

针对Dify平台的特殊配置建议:

// Dify Webhook集成示例

const difyWebhookConfig = {

"model_config": {

"provider": "openai-api-compatible",

"model": "claude-sonnet-4-20250514",

"model_parameters": {

"temperature": 0.7,

"max_tokens": 4000,

"top_p": 1.0

}

},

"api_config": {

"base_url": "https://vip.apiyi.com/v1",

"headers": {

"Authorization": "Bearer ${API_KEY}",

"Content-Type": "application/json"

}

}

};

🚀 性能优化配置

基于Dify平台的性能测试对比:

| 配置方案 | 平均响应时间 | 成功率 | 并发支持 |

|---|---|---|---|

| 直连Claude官方 | 4.2s | 89% | 20 QPS |

| API易聚合平台 | 2.8s | 98% | 100 QPS |

| 其他代理服务 | 5.1s | 85% | 15 QPS |

# 🎯 Dify性能测试脚本

import asyncio

import aiohttp

import time

async def test_dify_api_performance():

"""测试不同API配置在Dify中的性能表现"""

# 测试配置

configs = [

{

"name": "官方API",

"base_url": "https://api.anthropic.com/v1",

"model": "claude-3-sonnet-20240229"

},

{

"name": "API易聚合",

"base_url": "https://vip.apiyi.com/v1",

"model": "claude-sonnet-4-20250514"

}

]

for config in configs:

start_time = time.time()

# 模拟Dify API调用

success_count = await simulate_dify_calls(config)

elapsed = time.time() - start_time

print(f"{config['name']}: 成功率{success_count}%, 耗时{elapsed:.2f}s")

async def simulate_dify_calls(config):

"""模拟Dify平台的API调用模式"""

# 实现略...

pass

✅ Dify Claude 4 API 最佳实践

| 实践要点 | 具体建议 | 注意事项 |

|---|---|---|

| 🎯 模型选择 | 根据应用场景选择合适的Claude版本 | 平衡性能和成本,避免过度配置 |

| ⚡ 参数调优 | 合理设置temperature和max_tokens | 过高的temperature影响输出稳定性 |

| 💡 错误处理 | 配置重试机制和降级策略 | 设置合理的超时时间和重试次数 |

| 🔄 监控告警 | 实时监控API调用状态和成本 | 及时发现异常,防止成本失控 |

📋 Dify集成工具推荐

| 工具类型 | 推荐工具 | 特点说明 |

|---|---|---|

| API测试 | Postman、Dify自带测试 | 支持OpenAI格式验证 |

| API聚合平台 | API易 | 专业的多模型聚合服务 |

| 监控工具 | Dify Analytics、自定义监控 | Dify原生监控+第三方增强 |

| 成本管控 | API Usage Dashboard | 实时成本跟踪和预算控制 |

🔍 Dify Claude 4 API 故障排除

常见问题和解决方案:

# Dify Claude API错误处理最佳实践

import openai

from openai import OpenAI

import logging

class DifyClaudeAPIHandler:

"""Dify平台Claude API调用处理器"""

def __init__(self):

self.client = OpenAI(

api_key="your-api-key",

base_url="https://vip.apiyi.com/v1", # 稳定的聚合服务

timeout=60,

max_retries=3

)

async def safe_chat_completion(self, messages, model="claude-sonnet-4-20250514"):

"""安全的Chat Completion调用"""

try:

response = await self.client.chat.completions.acreate(

model=model,

messages=messages,

max_tokens=4000,

temperature=0.7

)

return response.choices[0].message.content

except openai.RateLimitError:

logging.warning("API调用频率限制,建议使用支持负载均衡的聚合服务")

# 实现退避重试逻辑

await asyncio.sleep(60)

return await self.safe_chat_completion(messages, model)

except openai.APIError as e:

logging.error(f"Claude API调用失败: {e}")

# 可以实现模型降级逻辑

return await self.fallback_model_call(messages)

except Exception as e:

logging.error(f"未知错误: {e}")

return "抱歉,服务暂时不可用,请稍后重试"

async def fallback_model_call(self, messages):

"""降级模型调用"""

try:

# 降级到更稳定的模型

response = await self.client.chat.completions.acreate(

model="gpt-4o-mini",

messages=messages

)

return response.choices[0].message.content

except Exception:

return "系统繁忙,请稍后重试"

❓ Dify Claude 4 API 常见问题

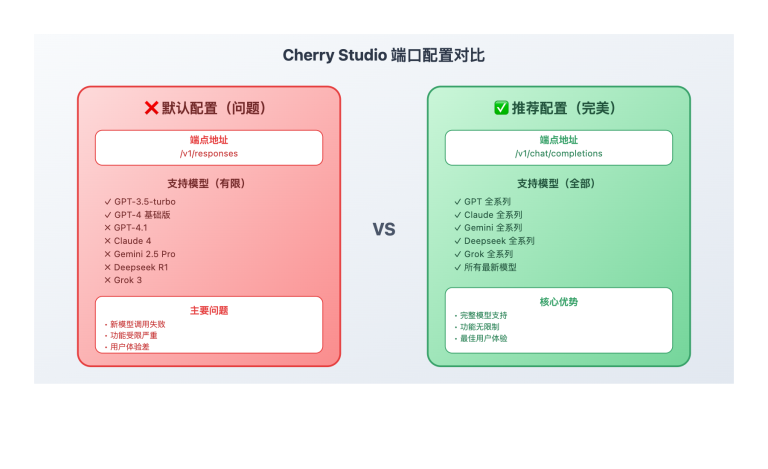

Q1: 为什么选择OpenAI-API-Compatible而不是直接配置Claude?

选择OpenAI-API-Compatible的主要原因:

- 兼容性更好:使用标准的OpenAI接口格式,Dify支持更完善

- 稳定性更高:聚合平台提供负载均衡和故障转移

- 功能更丰富:支持更多模型切换和参数调优选项

- 维护成本低:无需频繁更新API配置和认证方式

推荐使用API易这类专业聚合平台,可以在保持Claude 4强大能力的同时,获得更稳定的服务保障。

# 对比示例:直接调用vs兼容模式

# 直接Claude API(不推荐用于生产环境)

import anthropic

client = anthropic.Anthropic(api_key="sk-ant-xxx")

# OpenAI兼容模式(推荐)

import openai

client = openai.OpenAI(

api_key="your-key",

base_url="https://vip.apiyi.com/v1" # 兼容接口,更稳定

)

Q2: 如何获取正确的Claude模型名称?

获取准确模型名称的步骤:

- 访问Pricing页面:前往

https://www.apiyi.com/account/pricing - 查找Claude模型:在页面中找到Claude相关的模型列表

- 复制完整名称:选择需要的版本,复制完整的模型标识符

- 常见模型名称:

claude-sonnet-4-20250514– 最新Claude 4版本claude-3.5-sonnet– Claude 3.5性能版claude-3-haiku– 快速响应版本

重要提醒:模型名称必须完全匹配,包括版本号和日期后缀,否则会导致调用失败。

Q3: Dify中Claude模型响应慢如何优化?

Claude模型响应优化策略:

参数层面优化:

{

"model": "claude-sonnet-4-20250514",

"max_tokens": 2000, // 根据需求调整,避免过大

"temperature": 0.7, // 平衡创造性和一致性

"top_p": 0.9, // 控制输出的多样性

"stream": true // 启用流式输出,提升用户体验

}

网络层面优化:

- 选择地理位置更近的API节点

- 使用支持CDN加速的聚合平台

- 配置合理的超时时间(建议60秒)

应用层面优化:

- 合理分割长对话,避免上下文过长

- 实现请求缓存,减少重复调用

- 使用异步调用,提升并发处理能力

📚 延伸阅读

🛠️ 开源资源

完整的Dify Claude 4集成示例代码已开源到GitHub:

仓库地址:dify-claude-integration-examples

# 快速部署Dify Claude 4集成

git clone https://github.com/apiyi-api/dify-claude-integration-examples

cd dify-claude-integration-examples

# 环境配置

cp .env.example .env

# 编辑.env文件,添加你的API配置

export DIFY_API_BASE=https://vip.apiyi.com/v1

export DIFY_API_KEY=your_api_key

export CLAUDE_MODEL=claude-sonnet-4-20250514

项目包含内容:

- Dify Claude 4完整配置文件

- 性能测试和监控脚本

- 错误处理和重试机制示例

- 成本优化和使用量统计工具

- Docker部署配置文件

🔗 相关文档

| 资源类型 | 推荐内容 | 获取方式 |

|---|---|---|

| 官方文档 | Dify平台开发指南 | https://docs.dify.ai |

| API文档 | Claude API官方文档 | https://docs.anthropic.com |

| 社区资源 | API易使用指南 | https://help.apiyi.com |

| 最佳实践 | LLMOps实战案例集 | GitHub社区项目 |

🎯 相关教程推荐

- Dify工作流设计:如何构建包含Claude 4的复杂AI工作流

- 多模型对比测试:在Dify中对比不同AI模型的性能表现

- 成本优化策略:企业级Dify部署的成本控制实践

- API监控告警:构建完整的Dify API监控和告警系统

🎯 总结

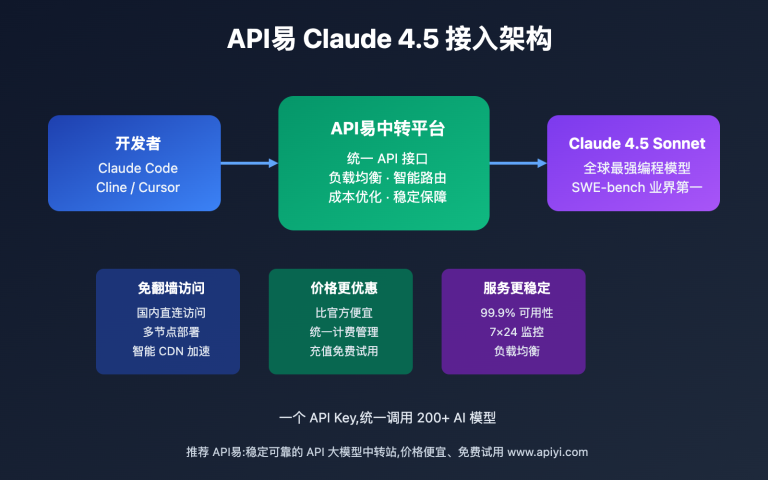

通过本教程,我们详细介绍了如何在Dify平台中配置Claude 4 API,解决了Claude模型调用不稳定的核心问题。

重点回顾:选择OpenAI-API-Compatible供应商类型,使用聚合平台提供的稳定服务,配置正确的模型名称

在实际应用中,建议:

- 优先选择支持负载均衡的API聚合平台

- 合理配置模型参数,平衡性能和成本

- 实现完善的错误处理和重试机制

- 建立API调用监控和成本控制体系

对于企业级Dify应用,推荐使用专业的API聚合服务(如API易等),既能充分发挥Claude 4的强大推理能力,又能保证服务的稳定性和可用性。这种方案特别适合对话场景(Chat)应用,能够显著提升用户体验和系统可靠性。

📝 作者简介:专注LLMOps平台和AI模型集成的技术专家,深度参与多个企业级Dify项目的架构设计。定期分享AI开发实践经验,搜索"API易"可找到更多Dify集成最佳实践和技术资料。

🔔 技术交流:欢迎在评论区讨论Dify平台的技术问题,持续分享AI应用开发经验和平台优化策略。