站长注:详细解析如何通过API实现大模型多轮对话功能,包含Python、JavaScript等多语言示例代码和最佳实践,帮助开发者轻松构建连贯对话体验。

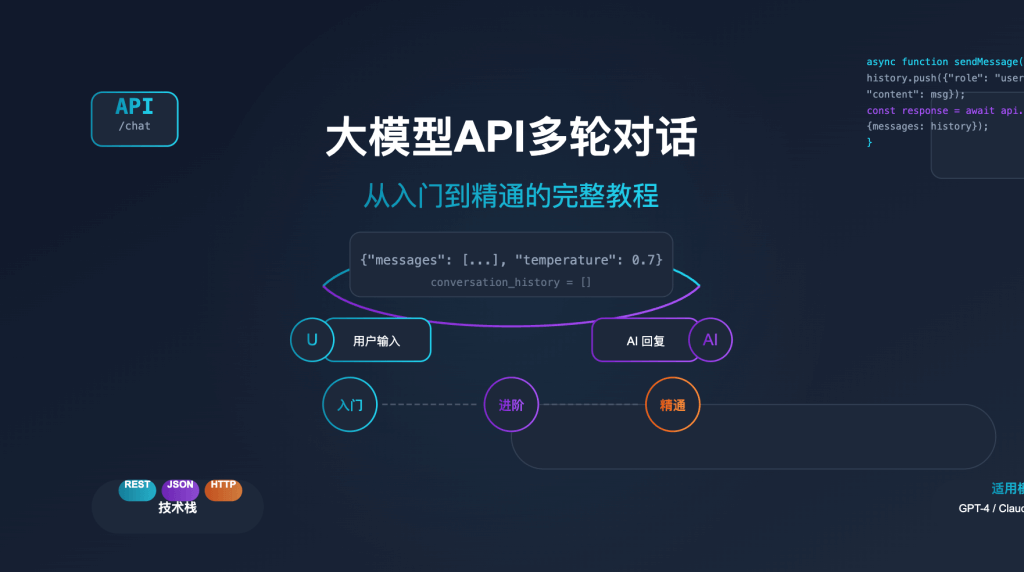

作为API易平台的技术顾问,我经常收到用户的这样的问题:”我现在通过API只能问一个问题,如果想要实现多次一问一答的对话,代码上需要怎么调整?“多轮对话是大模型应用中的基础需求,无论是开发聊天机器人、客服助手还是智能教学系统,都需要模型能够”记住”之前的对话内容。本文将深入浅出地解析如何通过各大模型的API实现流畅的多轮对话功能。

欢迎免费试用 API易,3 分钟跑通 API 调用 www.apiyi.com

支持 Claude、GPT、Gemini、QWQ 等全系列模型,支持多轮上下文对话

注册可送 1.1 美金额度起,约 300万 Tokens 额度体验。立即免费注册

加站长个人微信:8765058,发送你《大模型API开发指南》等资料包,并加赠 1 美金额度。

大模型API多轮对话基本概念

为什么需要特别处理多轮对话?

在深入代码实现之前,我们需要先理解一个核心概念:大模型API是无状态的。这意味着:

- 服务端不记忆:与网页版不同,API服务端不会自动记录您之前的对话历史

- 每次请求独立:每次API调用都是独立的,服务器不知道您之前问过什么

- 需客户端管理上下文:实现连贯对话需要客户端手动管理和传递完整的对话历史

这就像是与一个”失忆”的助手交谈——每次提问前,您都需要提醒他之前讨论过的所有内容。这种设计有助于提高API的可扩展性和灵活性,但需要开发者额外工作来实现多轮对话。

多轮对话的工作原理

实现多轮对话的核心思路非常简单:

- 维护对话历史:在客户端保存完整的对话记录,包括用户问题和AI回答

- 累积传递消息:每次请求时,将完整的对话历史作为消息列表发送给API

- 动态更新历史:收到回答后,将新的回答添加到对话历史中,用于下一轮对话

这个过程可以用以下流程图表示:

初始化空的对话历史(messages = [])

↓

用户发送问题

↓

将用户问题添加到对话历史

↓

发送完整对话历史到API

↓

获取AI回答

↓

将AI回答添加到对话历史

↓

展示回答给用户

↓

(重复上述过程)

大模型API多轮对话实现方法

下面,我们将使用不同编程语言展示如何实现多轮对话功能。

Python实现多轮对话

Python是实现大模型API调用最常用的语言之一,以下是使用OpenAI兼容接口实现多轮对话的示例:

from openai import OpenAI

import os

# 初始化客户端

client = OpenAI(

api_key=os.getenv("APIYI_API_KEY"),

base_url="https://vip.apiyi.com/v1" # API易的接口地址

)

# 初始化对话历史

messages = []

def chat_with_ai():

while True:

# 获取用户输入

user_input = input("您: ")

if user_input.lower() == 'exit':

break

# 将用户输入添加到对话历史

messages.append({"role": "user", "content": user_input})

# 调用API,传入完整对话历史

response = client.chat.completions.create(

model="gpt-4o", # 或其他支持的模型

messages=messages

)

# 获取AI回答

ai_response = response.choices.message.content

# 将AI回答添加到对话历史

messages.append({"role": "assistant", "content": ai_response})

# 打印AI回答

print(f"AI: {ai_response}")

# 可选:打印当前完整对话历史

# print(f"当前对话历史: {messages}")

# 开始对话

if __name__ == "__main__":

print("开始与AI对话,输入'exit'结束对话")

chat_with_ai()

JavaScript实现多轮对话

对于前端或Node.js开发者,以下是实现多轮对话的JavaScript示例:

import OpenAI from 'openai';

// 初始化客户端

const openai = new OpenAI({

apiKey: process.env.APIYI_API_KEY,

baseURL: 'https://vip.apiyi.com/v1' // API易的接口地址

});

// 初始化对话历史

const messages = [];

async function chatWithAI(userInput) {

try {

// 将用户输入添加到对话历史

messages.push({ role: 'user', content: userInput });

// 调用API,传入完整对话历史

const response = await openai.chat.completions.create({

model: 'gpt-4o', // 或其他支持的模型

messages: messages

});

// 获取AI回答

const aiResponse = response.choices.message.content;

// 将AI回答添加到对话历史

messages.push({ role: 'assistant', content: aiResponse });

// 返回AI回答

return aiResponse;

} catch (error) {

console.error('Error:', error);

return 'Sorry, something went wrong.';

}

}

// 示例使用 - 在实际应用中可能是事件监听器或API路由

async function demonstrateChat() {

console.log('User: Hello, who are you?');

let response = await chatWithAI('Hello, who are you?');

console.log(`AI: ${response}`);

console.log('User: What can you help me with?');

response = await chatWithAI('What can you help me with?');

console.log(`AI: ${response}`);

// 可选:打印当前对话历史

console.log('Current conversation history:', messages);

}

demonstrateChat();

使用curl命令实现多轮对话

对于喜欢使用命令行工具或需要测试API的开发者,以下是使用curl实现简单多轮对话的示例:

# 第一轮对话

curl https://vip.apiyi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $APIYI_API_KEY" \

-d '{

"model": "claude-3-5-sonnet-20241022",

"messages": [

{"role": "user", "content": "什么是人工智能?"}

]

}'

# 假设上面返回的回答是"人工智能是研究如何使计算机模拟人类智能的科学..."

# 第二轮对话需要包含第一轮的完整历史

curl https://vip.apiyi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $APIYI_API_KEY" \

-d '{

"model": "claude-3-5-sonnet-20241022",

"messages": [

{"role": "user", "content": "什么是人工智能?"},

{"role": "assistant", "content": "人工智能是研究如何使计算机模拟人类智能的科学..."},

{"role": "user", "content": "它有哪些应用领域?"}

]

}'

使用curl时,您需要手动构建和更新消息数组,这在实际应用中不太方便,但对于测试和理解API工作原理非常有用。

不同大模型API的多轮对话实现

各大模型的API在实现多轮对话时基本原理相同,但可能有一些细微差别。下面我们介绍几个主流模型的特点:

Claude API多轮对话

Claude API与OpenAI兼容接口类似,使用messages数组来维护对话历史:

from anthropic import Anthropic

# 初始化客户端

client = Anthropic(api_key="YOUR_API_KEY")

# 初始化对话历史

messages = []

# 第一轮对话

user_message = "Hello, who are you?"

messages.append({"role": "user", "content": user_message})

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=messages

)

assistant_message = response.content.text

messages.append({"role": "assistant", "content": assistant_message})

print(f"Claude: {assistant_message}")

# 第二轮对话

user_message = "What can you help me with?"

messages.append({"role": "user", "content": user_message})

response = client.messages.create(

model="claude-3-sonnet-20240229",

messages=messages

)

assistant_message = response.content.text

messages.append({"role": "assistant", "content": assistant_message})

print(f"Claude: {assistant_message}")

Gemini API多轮对话

Google的Gemini API使用稍微不同的格式,但概念相同:

import google.generativeai as genai

# 配置API密钥

genai.configure(api_key="YOUR_API_KEY")

# 初始化模型

model = genai.GenerativeModel('gemini-pro')

# 创建对话会话

chat = model.start_chat(history=[])

# 第一轮对话

response = chat.send_message("Hello, who are you?")

print(f"Gemini: {response.text}")

# 第二轮对话

response = chat.send_message("What can you help me with?")

print(f"Gemini: {response.text}")

# 对话历史会自动管理

print(chat.history)

DeepSeek API多轮对话

DeepSeek API与OpenAI兼容接口几乎完全相同:

from openai import OpenAI

# 初始化客户端

client = OpenAI(

api_key="YOUR_DEEPSEEK_API_KEY",

base_url="https://api.deepseek.com"

)

# 初始化对话历史

messages = []

# 第一轮对话

user_message = "What's the highest mountain in the world?"

messages.append({"role": "user", "content": user_message})

response = client.chat.completions.create(

model="deepseek-chat",

messages=messages

)

assistant_message = response.choices.message.content

messages.append({"role": "assistant", "content": assistant_message})

print(f"DeepSeek: {assistant_message}")

# 第二轮对话

user_message = "What is the second?"

messages.append({"role": "user", "content": user_message})

response = client.chat.completions.create(

model="deepseek-chat",

messages=messages

)

assistant_message = response.choices.message.content

messages.append({"role": "assistant", "content": assistant_message})

print(f"DeepSeek: {assistant_message}")

多轮对话的高级技巧与最佳实践

实现基本的多轮对话并不复杂,但要构建高质量的对话体验,还需要考虑以下高级技巧和最佳实践:

1. 有效管理对话长度

长时间对话会积累大量历史消息,可能导致以下问题:

- Token消耗增加:更多历史意味着更高的API调用成本

- 上下文窗口限制:所有模型都有最大上下文长度限制

- 性能下降:过长历史可能降低响应速度

解决方案:

# 设置最大对话轮数

MAX_TURNS = 10

# 添加新消息时,如果超过最大轮数,删除最早的一轮对话

def add_message(messages, role, content):

messages.append({"role": role, "content": content})

# 如果历史过长,删除最早的一轮对话(用户问题和AI回答)

if len(messages) > MAX_TURNS * 2:

# 删除最早的用户问题和AI回答

messages.pop(0)

messages.pop(0)

return messages

更复杂的方案包括:

- 摘要替换:使用模型生成对话摘要,替换早期详细历史

- 选择性保留:只保留关键对话,删除不重要的交流

- 混合策略:保留最近几轮完整对话,加上早期对话的摘要

2. 处理流式响应(Streaming)

流式响应可以提供更好的用户体验,特别是对于长回答:

# Python示例 - 流式响应

response = client.chat.completions.create(

model="gpt-4o",

messages=messages,

stream=True # 启用流式响应

)

assistant_message = ""

for chunk in response:

if chunk.choices.delta.content is not None:

content_chunk = chunk.choices.delta.content

assistant_message += content_chunk

print(content_chunk, end="", flush=True) # 实时打印

messages.append({"role": "assistant", "content": assistant_message})

3. 使用系统消息(System Message)设置对话基调

系统消息可以为多轮对话设置一致的基调和行为准则:

# 初始化对话历史,包含系统消息

messages = [

{

"role": "system",

"content": "你是一位专业的客服助手,回答简洁专业,语气友好。如果不确定答案,诚实承认并提供可能的解决方向。"

}

]

# 后续对话会受到系统消息的引导

4. 实现对话分支与回退

高级对话系统可以支持用户在对话树中导航:

# 存储对话历史的不同状态

conversation_states = []

# 保存当前状态

def save_state(messages):

# 深拷贝当前消息数组

import copy

conversation_states.append(copy.deepcopy(messages))

# 回到之前的状态

def rollback(steps=1):

global messages

if len(conversation_states) >= steps:

messages = conversation_states[-(steps+1)]

# 删除后续状态

for _ in range(steps):

conversation_states.pop()

5. 错误处理与重试机制

健壮的多轮对话系统需要妥善处理API错误:

import time

import random

def send_with_retry(messages, max_retries=3):

retries = 0

while retries < max_retries:

try:

response = client.chat.completions.create(

model="gpt-4o",

messages=messages

)

return response

except Exception as e:

retries += 1

if retries == max_retries:

raise e

# 指数退避策略

sleep_time = (2 ** retries) + random.random()

print(f"API调用失败,{sleep_time:.2f}秒后重试...")

time.sleep(sleep_time)

多轮对话常见问题与解决方案

问题1:对话突然”失忆”,模型不记得之前的信息

原因:可能是对话历史未正确传递,或超出模型上下文窗口限制。

解决方案:

- 检查对话历史是否正确累积和传递

- 监控消息总长度,确保未超出模型限制

- 实现历史压缩或摘要机制

问题2:多轮对话中的幻觉问题增加

原因:随着对话轮数增加,模型可能对早期信息产生混淆或遗忘。

解决方案:

- 定期在对话中添加事实性提醒或总结

- 对关键信息进行强调或重复

- 考虑在长对话中使用外部知识存储

问题3:Token使用量快速增长

原因:每轮对话都会增加历史长度,导致Token使用量呈指数级增长。

解决方案:

- 实现滑动窗口机制,只保留最近N轮对话

- 使用模型生成对话摘要,替换详细历史

- 设置合理的max_tokens参数限制回复长度

# 示例:使用滑动窗口管理历史

def manage_history(messages, window_size=5):

# 确保保留system消息

system_messages = [msg for msg in messages if msg["role"] == "system"]

# 提取非system消息

non_system = [msg for msg in messages if msg["role"] != "system"]

# 只保留最近的window_size轮对话(每轮包含user和assistant各一条)

if len(non_system) > window_size * 2:

recent_messages = non_system[-window_size * 2:]

else:

recent_messages = non_system

# 重建消息列表

return system_messages + recent_messages

API易平台多轮对话优势

在API易平台上实现多轮对话有以下独特优势:

1. 统一接口访问多种模型

API易平台支持Claude、GPT、Gemini、DeepSeek等多种模型,您可以使用统一的接口格式实现多轮对话,便于模型切换和比较:

# 不同模型的多轮对话示例

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("APIYI_API_KEY"),

base_url="https://vip.apiyi.com/v1"

)

# 初始化对话历史

messages = []

# 使用Claude模型

def chat_with_claude():

response = client.chat.completions.create(

model="claude-3-5-sonnet-20241022",

messages=messages

)

return response.choices.message.content

# 使用GPT模型

def chat_with_gpt():

response = client.chat.completions.create(

model="gpt-4o",

messages=messages

)

return response.choices.message.content

# 使用Gemini模型

def chat_with_gemini():

response = client.chat.completions.create(

model="gemini-1.5-pro",

messages=messages

)

return response.choices.message.content

2. 高性能多轮对话支持

API易平台针对多轮对话场景进行了优化:

- 优化的Token计算:精确计算对话历史Token,避免不必要的费用

- 智能缓存机制:提高频繁对话的响应速度

- 稳定的会话管理:确保长时间多轮对话的稳定性

3. 成本优化方案

API易平台提供多种成本优化方案,特别适合多轮对话场景:

- 模型智能切换:可以在对话不同阶段自动切换不同价格档位的模型

- 按量计费:精确到Token级别的计费,避免资源浪费

- 批量请求优惠:针对高频多轮对话场景的特别优惠

多轮对话应用场景与案例

客服助手应用

# 客服助手多轮对话示例

system_prompt = """你是一位专业的电子产品客服助手。请遵循以下准则:

1. 回答简洁专业,语气友好

2. 优先解决客户问题,而不是推销产品

3. 如果不确定答案,诚实承认并提供可能的解决方向

4. 遇到复杂技术问题,建议用户联系人工客服

"""

messages = [{"role": "system", "content": system_prompt}]

# 模拟客服对话

user_queries = [

"我的手机充电很慢,怎么办?",

"我试过了,还是很慢",

"手机是去年买的,还在保修期内吗?",

"我在哪里可以查看保修信息?"

]

for query in user_queries:

print(f"用户: {query}")

messages.append({"role": "user", "content": query})

response = client.chat.completions.create(

model="gpt-4o",

messages=messages

)

assistant_message = response.choices.message.content

messages.append({"role": "assistant", "content": assistant_message})

print(f"客服: {assistant_message}\n")

教育辅导应用

# 教育辅导多轮对话示例

system_prompt = """你是一位耐心的数学教师,专注于引导学生思考而不是直接给出答案。请遵循以下准则:

1. 使用苏格拉底式提问法引导学生

2. 当学生有进步时给予积极鼓励

3. 提供思路和方法,而不是完整解答

4. 根据学生的回答调整解释难度

"""

messages = [{"role": "system", "content": system_prompt}]

# 模拟教学对话

teaching_session = [

"老师,我不懂怎么解二次方程",

"比如x²+5x+6=0这个方程,我不知道怎么开始解",

"我可以试试因式分解吗?",

"所以我需要找到两个数,它们的和是5,积是6,对吗?"

]

for query in teaching_session:

print(f"学生: {query}")

messages.append({"role": "user", "content": query})

response = client.chat.completions.create(

model="claude-3-5-sonnet-20241022",

messages=messages

)

assistant_message = response.choices.message.content

messages.append({"role": "assistant", "content": assistant_message})

print(f"教师: {assistant_message}\n")

多轮对话总结

实现多轮对话的关键点:

- 客户端负责管理对话历史:将用户输入和AI回答累积存储

- 每次请求传递完整历史:确保AI理解完整上下文

- 妥善处理长对话:实现历史管理机制,避免超出上下文限制

- 注意Token使用量:随着对话长度增加,Token消耗会增长

- 利用系统消息设定基调:确保多轮对话中的一致性

- 实现错误处理机制:应对可能的API调用故障

多轮对话是构建智能对话应用的基础,掌握这一技术将帮助您创建更加自然、连贯的用户体验。通过API易平台,您可以轻松接入各种顶级大模型,实现高质量的多轮对话应用。

参考资料

- 附: Deepseek 的文档 https://api-docs.deepseek.com/zh-cn/guides/multi_round_chat

- 附:关于大模型是否联网搜索的参考 大模型 API 能联网吗?关于如何联网、实时数据获取的经验分享

欢迎免费试用 API易,体验流畅的多轮对话功能 www.apiyi.com

加站长个人微信:8765058,获取更多API开发技巧与优惠。

本文作者:API易团队

欢迎关注我们的更新,持续分享 AI API 使用经验和开发技巧。