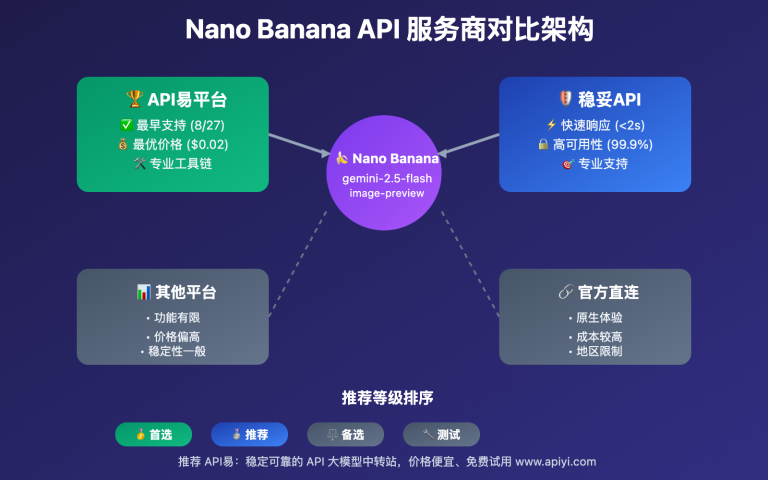

在信息爆炸的今天,处理大量PDF文件并快速提取关键信息变得日益困难。为此,自动化的摘要生成技术应运而生,其中OpenAI API凭借其强大的自然语言处理能力,能够高效地生成简明扼要的文本摘要。API易平台简化了对OpenAI API的访问,支持多种先进模型,如GPT-4o、GPT-o1和Claude 3.5 Sonnet,我们无需复杂配置即可轻松实现PDF到摘要的转换。本文将详细介绍如何利用API易平台,通过OpenAI API将PDF文件转换为高效摘要,从而简化信息处理流程,帮助我们快速获取有价值的信息。

1. 准备工作

在开始实现PDF文件摘要生成之前,我们需要完成一些必要的准备工作,包括获取API密钥和安装所需的Python库。这些准备将确保后续代码可以顺利运行,并能通过API易平台高效地调用OpenAI API进行文本处理和摘要生成。

1.1 获取API密钥

在启动PDF摘要生成流程前,我们需完成以下准备工作:

注册API易账号:访问 【API易官网】,按照页面提示进行注册。注册成功后,新用户将自动获得100,000额度,以便进行初次测试。

获取API密钥:登录API易账号后,进入个人中心的“令牌”页面,可以看到默认生成的API密钥。

1.2 安装Python库

接下来,我们需要安装一些用于文本处理和API请求的Python库:

PyMuPDF库:用于从PDF文件中提取文本内容。

OpenAI库:用于与OpenAI API交互。

安装上述库的命令如下:

pip install PyMuPDF openai

1.3 配置API密钥

在安装完所需库后,还需将获取的API密钥配置在代码中,以便每次请求时都能通过身份验证。可以直接在Python代码中设置API密钥:

import openai

# 设置API密钥

openai.api_key = ‘您的API易平台API密钥’

完成上述步骤后,即可开始从PDF中提取文本,并通过API易平台调用OpenAI API生成摘要。在下一部分中,我们将详细讲解如何从PDF文件中提取文本内容,并为后续调用API做准备。

2. 从PDF提取文本内容

在调用OpenAI API之前,需先从PDF中提取并预处理文本。我们使用PyMuPDF库(即fitz)来解析PDF并提取文本,然后对其进行清理以去除多余空格和格式字符。以下是详细步骤:

2.1 使用PyMuPDF库读取PDF文件

import fitz # PyMuPDF的导入名为fitz

# 从PDF文件中提取文本内容

def extract_text_from_pdf(pdf_path):

text = “”

with fitz.open(pdf_path) as pdf_file: # 打开PDF文件

for page_num in range(pdf_file.page_count): # 遍历每一页

page = pdf_file[page_num]

text += page.get_text() # 获取当前页的文本并添加到整体文本中

return text

批注:extract_text_from_pdf函数接收PDF文件的路径,逐页读取内容并将文本汇总到一个字符串中。最终返回的text字符串包含了PDF的完整文本信息。

2.2 文本清理与预处理

常见的预处理操作包括去除空行、删除多余空格以及处理特殊字符。以下是一个简单的预处理函数示例:

# 预处理文本,去除多余空行和格式字符

def preprocess_text(text):

# 替换多余空行,去除特殊符号

text = text.replace(‘\n’, ‘ ‘).replace(‘\r’, ”)

text = ‘ ‘.join(text.split()) # 去除多余空格

return text

批注:在这个函数中,我们将换行符和回车符替换为空格,并使用splitjoin方法去除多余空格,使文本结构更加紧凑、清晰。预处理后的文本将作为输入,传入API进行摘要生成。

2.3 完整代码示例

以下代码展示了从PDF文件提取文本并进行预处理的全过程:

import fitz # PyMuPDF # 从PDF文件中提取文本内容 def extract_text_from_pdf(pdf_path): text = "" with fitz.open(pdf_path) as pdf_file: for page_num in range(pdf_file.page_count): page = pdf_file[page_num] text += page.get_text() return text

# 预处理文本,去除多余空行和格式字符

def preprocess_text(text):

text = text.replace('\n', ' ').replace('\r', '')

text = ' '.join(text.split())

return text

# PDF文件路径

pdf_path = ‘您的PDF文件路径.pdf’

# 提取和预处理文本

pdf_text = extract_text_from_pdf(pdf_path)

processed_text = preprocess_text(pdf_text)

print(“提取并预处理的文本内容:”)

print(processed_text)

下一步,我们将讲解如何将该文本分割为适合API处理的块,以符合API的字符限制并生成高质量的摘要。

3. 将文本分割为适合处理的块

由于OpenAI API对输入文本长度有限制,我们需要将预处理后的长文本分割成多个小块,以确保每个块都能被API顺利处理。以下是实现文本分割的步骤:

3.1 理解OpenAI模型的上下文长度限制

输入文本的长度通常以“token”(令牌)为单位进行计算。一般情况下,单个字母、单词或短语可能占用一个或多个token。因此,当处理长篇文本时,将其划分为较小的块能够避免API拒绝请求或忽略超出长度的部分。

例如,GPT-4o支持处理32,000个token,合理分割文本可以提高摘要生成的准确性。

3.2 实现文本分割

为了确保每个文本块都能被API处理,通常可以将文本按段落或句子分割。一个有效的方式是基于最大字符长度(例如4000或5000字符)进行分割。以下是一个将长文本分割为小块的示例代码:

# 分割长文本为适合API处理的小块

def split_text(text, max_length=4000):

paragraphs = text.split('\n\n') # 将文本按段落分割

chunks = []

current_chunk = ""

for paragraph in paragraphs:

if len(current_chunk) + len(paragraph) <= max_length:

current_chunk += paragraph + "\n\n"

else:

chunks.append(current_chunk.strip())

current_chunk = paragraph + "\n\n"

if current_chunk:

chunks.append(current_chunk.strip())

return chunks

在这个函数中,我们先将文本按段落划分,然后逐段将文本填入current_chunk,直到其长度接近最大限制。这样,分割后的每个文本块都不会超过指定长度,能够保证在API调用时不会超出限制。

3.3 验证文本分割的效果

分割完成后,可以输出或查看每个块的长度,以确保其符合API的长度要求。通过以下示例代码可以快速查看分割效果:

# 示例:检查每个块的长度

pdf_chunks = split_text(processed_text)

for i, chunk in enumerate(pdf_chunks):

print(f"块 {i+1} 的长度: {len(chunk)} 字符")

如果发现某些块超出长度限制,可适当调整分割逻辑

3.4 分块处理的优势

通过分割文本,我们可以有效解决API处理长文本的瓶颈。接下来,我们将介绍如何将分割后的文本块逐段发送至OpenAI API并获取对应的摘要内容。

4. 使用API易平台的OpenAI API生成摘要

在文本预处理和分割完成后,我们可以通过API易平台调用OpenAI API逐段生成摘要。此过程包括设置API请求参数、调用API并处理响应。

4.1 设置API请求参数

关键参数包括:

API密钥:我们在API易平台注册后获得的密钥,用于身份验证。

模型选择:API易平台支持多种OpenAI和Claude模型,例如GPT-4o和Claude 3.5 Sonnet等。不同模型适合不同任务,根据需要选择。

提示设计:为生成准确的摘要,可在提示中加入指令,如“总结以下内容”。通过设计合适的提示,引导模型生成更贴合需求的输出。

摘要长度:通过 max_tokens 参数控制摘要的长度。

其他参数:可调整 temperature(影响输出随机性)和 top_p(概率采样范围)等参数,以进一步优化摘要的准确性和风格。

4.2 调用API生成摘要

以下代码展示了如何逐段将分割后的文本块发送至OpenAI API,并获取对应的摘要结果:

import openai

# 设置API密钥

openai.api_key = '您的API易平台API密钥'

# 使用API生成摘要

def summarize_text(text):

response = openai.Completion.create(

engine="text-davinci-003", # 可根据需求更换为其他模型

prompt=f"请总结以下内容:\n\n{text}",

max_tokens=150, # 控制摘要的长度

temperature=0.5, # 控制输出的随机性

top_p=0.3 # 控制采样的多样性

)

return response.choices[0].text.strip()

批注:在这个示例中,summarize_text函数将每个文本块发送至API,API根据设置的参数生成摘要。函数中使用了text-davinci-003模型,并将生成摘要的长度控制在150 tokens内(根据需要可调整该值)。

4.3 逐块生成摘要

# 对分割后的每个文本块生成摘要

def summarize_pdf_chunks(chunks):

summaries = []

for i, chunk in enumerate(chunks):

print(f"正在处理第 {i+1} 块文本...")

summary = summarize_text(chunk)

summaries.append(summary)

return summaries

批注:利用分块后的文本,可以通过循环调用 summarize_text 函数,将每个块的内容依次发送至API,并将返回的摘要存储在列表中。这样可以确保每个段落的摘要都得到处理。

4.4 处理API响应

# 分割预处理后的PDF文本

pdf_chunks = split_text(processed_text)

# 生成摘要

summaries = summarize_pdf_chunks(pdf_chunks)

# 输出每段摘要结果

for i, summary in enumerate(summaries):

print(f”段落 {i+1} 的摘要:\n{summary}\n”)

批注:API返回的每个摘要存储在summaries列表中,其中每个元素对应一段文本的摘要内容。通过调用summarize_pdf_chunks函数,我们可以依次获取各段落的摘要,并将其存储在一个集合中,便于后续整理。

在下一步中,我们将介绍如何将各段落的摘要合并为完整的文档概述,从而得到简明、结构良好的最终摘要。

5. 合并和优化摘要

在成功生成每个文本块的摘要后,下一步是将这些独立的摘要合并为一个连贯、全面的文档概述。不仅涉及简单的拼接,还需要对内容进行优化——即:保持摘要的准确性和原意,通过控制长度和格式规范,以提供高质量的文档概述。

5.1 合并分段摘要

将各个段落的摘要合并时,需注意以下几点:

顺序一致:按照原文档的顺序,将各段摘要依次排列,保持内容的连贯性。

去除冗余:在合并过程中,删除重复或多余的信息,确保摘要简洁明了。

连接过渡:在段落之间添加适当的过渡语句,使摘要更具连贯性。

以下是合并摘要的示例代码:

# 合并各段摘要为完整的文档摘要

def merge_summaries(summaries):

merged_summary = “\n\n”.join(summaries)

return merged_summary

批注:通过上述函数,可以将所有段落的摘要合并为一个完整的文本,形成初步的文档概述。

5.2 优化摘要内容

合并后的摘要可能存在逻辑不连贯或信息重复的问题。为提升摘要质量,建议进行以下优化:

逻辑梳理:如有必要,调整摘要段落顺序或修改句子结构。

语言精炼:使用简洁明了的语言表达核心内容。

一致性检查:确保摘要中的术语、名称和时间等信息前后一致。

以下是优化摘要的示例代码:

# 优化合并后的摘要内容

def optimize_summary(merged_summary):

# 示例:去除多余空行,修正常见语法错误等

optimized_summary = merged_summary.replace(‘\n\n’, ‘\n’)

# 其他优化操作…

return optimized_summary

批注:通过上述函数,可以对合并后的摘要进行进一步的优化处理,提升其可读性和专业性。

5.3 生成最终摘要

完成合并和优化后,即可生成最终的文档摘要。以下是完整的流程示例:

# 假设’summaries’是之前生成的各段摘要列表

merged_summary = merge_summaries(summaries)

final_summary = optimize_summary(merged_summary)

print(“最终的文档摘要:”)

print(final_summary)

6. 示例代码

为了更好地理解如何将PDF文件发送至OpenAI API并获取其摘要,以下提供一个完整的Python示例代码,涵盖了从PDF文本提取、预处理、分割、调用API生成摘要到合并最终摘要的全过程。

6.1 环境准备

确保已安装PyMuPDF和openai库:

pip install PyMuPDF openai

6.2 完整代码示例

import fitz # PyMuPDF

import openai

# 设置API密钥

openai.api_key = ‘我们的API易平台API密钥’

# 从PDF文件中提取文本内容

def extract_text_from_pdf(pdf_path):

text = “”

with fitz.open(pdf_path) as pdf_file:

for page_num in range(pdf_file.page_count):

page = pdf_file[page_num]

text += page.get_text()

return text

# 预处理文本,去除多余空行和格式字符

def preprocess_text(text):

text = text.replace(‘\n’, ‘ ‘).replace(‘\r’, ”)

text = ‘ ‘.join(text.split())

return text

# 分割长文本为适合API处理的小块

def split_text(text, max_length=4000):

paragraphs = text.split(‘\n\n’)

chunks = []

current_chunk = “”

for paragraph in paragraphs:

if len(current_chunk) + len(paragraph) <= max_length:

current_chunk += paragraph + “\n\n”

else:

chunks.append(current_chunk.strip())

current_chunk = paragraph + “\n\n”

if current_chunk:

chunks.append(current_chunk.strip())

return chunks

# 使用API生成摘要

def summarize_text(text):

response = openai.Completion.create(

engine=”text-davinci-003″,

prompt=f”请总结以下内容:\n\n{text}”,

max_tokens=150,

temperature=0.5,

top_p=0.3

)

return response.choices[0].text.strip()

# 对分割后的每个文本块生成摘要

def summarize_pdf_chunks(chunks):

summaries = []

for i, chunk in enumerate(chunks):

print(f”正在处理第 {i+1} 块文本…”)

summary = summarize_text(chunk)

summaries.append(summary)

return summaries

# 合并各段摘要为完整的文档摘要

def merge_summaries(summaries):

merged_summary = “\n\n”.join(summaries)

return merged_summary

# 优化合并后的摘要内容

def optimize_summary(merged_summary):

optimized_summary = merged_summary.replace(‘\n\n’, ‘\n’)

return optimized_summary

# 主函数

def main(pdf_path):

pdf_text = extract_text_from_pdf(pdf_path)

processed_text = preprocess_text(pdf_text)

pdf_chunks = split_text(processed_text)

summaries = summarize_pdf_chunks(pdf_chunks)

merged_summary = merge_summaries(summaries)

final_summary = optimize_summary(merged_summary)

print(“最终的文档摘要:”)

print(final_summary)

# 调用主函数,传入PDF文件路径

if __name__ == “__main__”:

pdf_path = ‘我们的PDF文件路径.pdf’

main(pdf_path)

6.3 代码说明

在这个示例代码中,使用了以下函数:

extract_text_from_pdf:从PDF文件中提取文本内容。

preprocess_text:预处理文本,去除多余空行和格式字符。

split_text:将长文本分割为适合API处理的小块。

summarize_text:调用OpenAI API生成摘要。

summarize_pdf_chunks:对分割后的每个文本块生成摘要。

merge_summaries:合并各段摘要为完整的文档摘要。

optimize_summary:优化合并后的摘要内容。

7. 总结:注意事项和最佳实践

在利用API易平台的OpenAI API对PDF文件进行摘要生成时,遵循以下注意事项和最佳实践,可确保生成的摘要准确、可靠,并符合相关法律法规。

7.1 处理特殊字符和格式

PDF文件中可能包含特殊字符或复杂格式,如表格、图片、脚注等。在提取和预处理文本时需注意这些字符,避免影响摘要质量。建议在预处理阶段对这些格式进行标记或说明,确保模型理解上下文。

特殊字符:PDF文件中可能包含特殊字符,如数学符号、表情符号或其他非标准字符。在提取和预处理文本时,需注意这些字符的处理,避免影响摘要质量。建议在预处理阶段使用正则表达式或其他方法清理或替换特殊字符。

格式问题:PDF中的表格、图片、脚注等格式信息在文本提取时可能丢失或被误解。为提高摘要的准确性,建议在预处理阶段对这些格式进行标记或说明,确保模型理解上下文。

7.2 确保摘要的准确性和一致性

多次验证:在生成摘要后,建议对结果进行多次验证,确保其准确性。可以通过人工校对或使用其他AI工具进行比对,确保摘要真实反映原文内容。

一致性检查:确保摘要中的术语、名称和时间等信息前后一致,避免读者产生混淆。在合并和优化摘要时,注意保持信息的一致性和连贯性。

通过本文,我们已掌握利用API易平台的OpenAl API生成PDF摘要的完整流程。遵循最佳实践,我们可以高效生成准确、连贯的摘要,满足科研、教育及企业等多种应用需求。

欢迎访问API易平台官网注册并获取API密钥,开启智能文档处理之旅。感谢您对API易平台的支持,期待与您共同探索AI在文档处理中的更多应用。

立即注册API易平台